Crea tabelle esterne Cloud Storage

BigQuery supporta l'esecuzione di query sui dati di Cloud Storage nei seguenti formati:

- Valori separati da virgola (CSV)

- JSON (delimitato da nuova riga)

- Avro

- ORC

- Parquet

- Esportazioni Datastore

- Esportazioni di Firestore

BigQuery supporta l'esecuzione di query sui dati di Cloud Storage da queste classi di archiviazione:

- Standard

- Nearline

- Coldline

- Archivia

Per eseguire query su una tabella esterna Cloud Storage, devi disporre delle autorizzazioni sia per la tabella esterna sia per i file Cloud Storage. Se possibile, ti consigliamo di utilizzare una tabella BigLake. Le tabelle BigLake forniscono la delega dell'accesso, in modo che ti servano solo le autorizzazioni per la tabella BigLake per eseguire query sui dati di Cloud Storage.

Assicurati di considerare la posizione del set di dati e del bucket Cloud Storage quando esegui query sui dati archiviati in Cloud Storage.

Prima di iniziare

Concedi i ruoli IAM (Identity and Access Management) che forniscono agli utenti le autorizzazioni necessarie per eseguire ogni attività descritta in questo documento. Le autorizzazioni richieste per eseguire un'attività (se presenti) sono elencate nella sezione "Autorizzazioni richieste" dell'attività.

Ruoli obbligatori

Per creare una tabella esterna, devi disporre dell'autorizzazione bigquery.tables.create

BigQuery Identity and Access Management (IAM).

Ciascuno dei seguenti ruoli Identity and Access Management predefiniti include questa autorizzazione:

- Editor dati BigQuery (

roles/bigquery.dataEditor) - BigQuery Data Owner (

roles/bigquery.dataOwner) - Amministratore BigQuery (

roles/bigquery.admin)

Devi disporre anche delle seguenti autorizzazioni per accedere al bucket Cloud Storage che contiene i tuoi dati:

storage.buckets.getstorage.objects.getstorage.objects.list(obbligatorio se utilizzi un carattere jolly URI)

Il ruolo IAM predefinito Amministratore Storage Cloud Storage (roles/storage.admin) include queste autorizzazioni.

Se non sei un principale in nessuno di questi ruoli, chiedi all'amministratore di concederti l'accesso o di creare la tabella esterna per te.

Per ulteriori informazioni su ruoli e autorizzazioni di Identity and Access Management in BigQuery, consulta Ruoli e autorizzazioni predefiniti.

Ambiti di accesso per le istanze Compute Engine

Se da un'istanza Compute Engine devi eseguire query su una tabella esterna

collegata a un'origine Cloud Storage, l'istanza deve disporre almeno dell'ambito di accesso

in sola lettura di Cloud Storage (https://www.googleapis.com/auth/devstorage.read_only).

Gli ambiti controllano l'accesso dell'istanza Compute Engine ai prodotti, incluso Cloud Storage. Google CloudLe applicazioni in esecuzione sull'istanza utilizzano ilaccount di serviziot collegato all'istanza per chiamare le API di Google Cloud .

Se configuri un'istanza di Compute Engine per l'esecuzione come

service account Compute Engine predefinito,

all'istanza vengono concessi per impostazione predefinita diversi ambiti predefiniti,

incluso l'ambito https://www.googleapis.com/auth/devstorage.read_only.

Se invece configuri l'istanza con un account di servizio personalizzato, assicurati di

concedere esplicitamente l'ambito https://www.googleapis.com/auth/devstorage.read_only

all'istanza.

Per informazioni sull'applicazione degli ambiti a un'istanza Compute Engine, consulta Modifica del account di servizio e degli ambiti di accesso per un'istanza. Per ulteriori informazioni sui service account di Compute Engine, consulta Service account.

Crea tabelle esterne su dati non partizionati

Puoi creare una tabella permanente collegata all'origine dati esterna:

- Utilizzo della console Google Cloud

- Utilizzo del comando

bq mk - Creazione di un

ExternalDataConfigurationquando utilizzi il metodo APItables.insert - Esecuzione dell'istruzione

CREATE EXTERNAL TABLEDDL (Data Definition Language). - Utilizzo delle librerie client

Seleziona una delle seguenti opzioni:

Console

Vai alla pagina BigQuery.

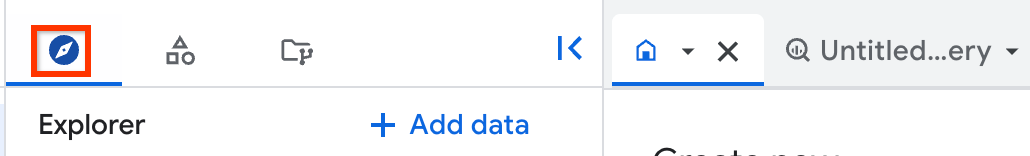

Nel riquadro a sinistra, fai clic su Explorer:

Se non vedi il riquadro a sinistra, fai clic su Espandi riquadro a sinistra per aprirlo.

Nel riquadro Explorer, espandi il progetto, fai clic su Set di dati e poi seleziona un set di dati.

Espandi l'opzione Azioni e fai clic su Crea tabella.

Nella sezione Origine, specifica i seguenti dettagli:

Per Crea tabella da, seleziona Google Cloud Storage.

Per Seleziona file dal bucket GCS o utilizza un pattern URI, sfoglia per selezionare un bucket e un file da utilizzare oppure digita il percorso nel formato

gs://bucket_name/[folder_name/]file_name.Non puoi specificare più URI nella console Google Cloud , ma puoi selezionare più file specificando un carattere jolly asterisco (

*). Ad esempio:gs://mybucket/file_name*. Per ulteriori informazioni, consulta Supporto dei caratteri jolly per gli URI Cloud Storage.Il bucket Cloud Storage deve trovarsi nella stessa località del set di dati che contiene la tabella che stai creando.

Per Formato file, seleziona il formato corrispondente al tuo file.

Nella sezione Destinazione, specifica i seguenti dettagli:

In Progetto, scegli il progetto in cui creare la tabella.

Per Set di dati, scegli il set di dati in cui creare la tabella.

In Tabella, inserisci il nome della tabella che stai creando.

Per Tipo di tabella, seleziona Tabella esterna.

Nella sezione Schema, puoi attivare il rilevamento automatico dello schema o specificare manualmente uno schema se hai un file di origine. Se non hai un file di origine, devi specificare manualmente uno schema.

Per attivare il rilevamento automatico dello schema, seleziona l'opzione Rilevamento automatico.

Per specificare manualmente uno schema, lascia deselezionata l'opzione Rilevamento automatico. Attiva Modifica come testo e inserisci lo schema della tabella come array JSON.

Per ignorare le righe con valori di colonna aggiuntivi che non corrispondono allo schema, espandi la sezione Opzioni avanzate e seleziona Valori sconosciuti.

Fai clic su Crea tabella.

Una volta creata la tabella permanente, puoi eseguire una query sulla tabella come se fosse una tabella BigQuery nativa. Al termine della query, puoi esportare i risultati come file CSV o JSON, salvarli come tabella o in Fogli Google.

SQL

Puoi creare una tabella esterna permanente eseguendo l'istruzione DDL CREATE EXTERNAL TABLE.

Puoi specificare lo schema in modo esplicito o utilizzare il

rilevamento automatico dello schema per dedurre lo schema

dai dati esterni.

Nella console Google Cloud , vai alla pagina BigQuery.

Nell'editor di query, inserisci la seguente istruzione:

CREATE EXTERNAL TABLE `PROJECT_ID.DATASET.EXTERNAL_TABLE_NAME` OPTIONS ( format ="TABLE_FORMAT", uris = ['BUCKET_PATH'[,...]] );

Sostituisci quanto segue:

PROJECT_ID: il nome del progetto in cui vuoi creare la tabella, ad esempiomyprojectDATASET: il nome del set di dati BigQuery in cui vuoi creare la tabella, ad esempiomydatasetEXTERNAL_TABLE_NAME: il nome della tabella che vuoi creare, ad esempiomytableTABLE_FORMAT: il formato della tabella che vuoi creare, ad esempioPARQUETBUCKET_PATH: il percorso del bucket Cloud Storage che contiene i dati per la tabella esterna, nel formato['gs://bucket_name/[folder_name/]file_name'].Puoi selezionare più file dal bucket specificando un carattere jolly asterisco (

*) nel percorso. Ad esempio,['gs://mybucket/file_name*']. Per ulteriori informazioni, consulta Supporto dei caratteri jolly per gli URI Cloud Storage.Puoi specificare più bucket per l'opzione

urisfornendo più percorsi.I seguenti esempi mostrano valori

urisvalidi:['gs://bucket/path1/myfile.csv']['gs://bucket/path1/*.csv']['gs://bucket/path1/*', 'gs://bucket/path2/file00*']

Quando specifichi valori

urische hanno come target più file, tutti questi file devono condividere uno schema compatibile.Per ulteriori informazioni sull'utilizzo degli URI Cloud Storage in BigQuery, consulta Percorso della risorsa Cloud Storage.

Fai clic su Esegui.

Per saperne di più su come eseguire le query, consulta Eseguire una query interattiva.

Esempi

L'esempio seguente utilizza il rilevamento automatico dello schema per creare una tabella esterna

denominata sales collegata a un file CSV archiviato in Cloud Storage:

CREATE OR REPLACE EXTERNAL TABLE mydataset.sales OPTIONS ( format = 'CSV', uris = ['gs://mybucket/sales.csv']);

L'esempio successivo specifica uno schema in modo esplicito e salta la prima riga del file CSV:

CREATE OR REPLACE EXTERNAL TABLE mydataset.sales ( Region STRING, Quarter STRING, Total_Sales INT64 ) OPTIONS ( format = 'CSV', uris = ['gs://mybucket/sales.csv'], skip_leading_rows = 1);

bq

Per creare una tabella esterna, utilizza il

comando bq mk con il

flag --external_table_definition. Questo flag contiene un percorso a un file di definizione della tabella o una definizione della tabella incorporata.

Opzione 1: file di definizione della tabella

Utilizza il comando bq mkdef

per creare un file di definizione della tabella, quindi passa il percorso del file al

comando bq mk come segue:

bq mkdef --source_format=SOURCE_FORMAT \ BUCKET_PATH > DEFINITION_FILE bq mk --table \ --external_table_definition=DEFINITION_FILE \ DATASET_NAME.TABLE_NAME \ SCHEMA

Sostituisci quanto segue:

SOURCE_FORMAT: il formato dell'origine dati esterna. Ad esempio,CSV.BUCKET_PATH: il percorso del bucket Cloud Storage che contiene i dati per la tabella, nel formatogs://bucket_name/[folder_name/]file_pattern.Puoi selezionare più file dal bucket specificando un carattere jolly asterisco (

*) infile_pattern. Ad esempio:gs://mybucket/file00*.parquet. Per ulteriori informazioni, consulta Supporto dei caratteri jolly per gli URI Cloud Storage.Puoi specificare più bucket per l'opzione

urisfornendo più percorsi.I seguenti esempi mostrano valori

urisvalidi:gs://bucket/path1/myfile.csvgs://bucket/path1/*.parquetgs://bucket/path1/file1*,gs://bucket1/path1/*

Quando specifichi valori

urische hanno come target più file, tutti questi file devono condividere uno schema compatibile.Per ulteriori informazioni sull'utilizzo degli URI Cloud Storage in BigQuery, consulta Percorso della risorsa Cloud Storage.

DEFINITION_FILE: il percorso del file di definizione della tabella sul computer locale.DATASET_NAME: il nome del set di dati che contiene la tabella.TABLE_NAME: il nome della tabella che stai creando.SCHEMA: specifica un percorso a un file di schema JSON, o specifica lo schema nel formatofield:data_type,field:data_type,....

Esempio:

bq mkdef --source_format=CSV gs://mybucket/sales.csv > mytable_def

bq mk --table --external_table_definition=mytable_def \

mydataset.mytable \

Region:STRING,Quarter:STRING,Total_sales:INTEGER

Per utilizzare il rilevamento automatico dello schema, imposta il flag --autodetect=true nel

comando mkdef e ometti lo schema:

bq mkdef --source_format=CSV --autodetect=true \

gs://mybucket/sales.csv > mytable_def

bq mk --table --external_table_definition=mytable_def \

mydataset.mytable

Opzione 2: definizione della tabella in linea

Anziché creare un file di definizione della tabella, puoi passare la definizione della tabella direttamente al comando bq mk:

bq mk --table \ --external_table_definition=@SOURCE_FORMAT=BUCKET_PATH \ DATASET_NAME.TABLE_NAME \ SCHEMA

Sostituisci quanto segue:

SOURCE_FORMAT: il formato dell'origine dati esternaAd esempio,

CSV.BUCKET_PATH: il percorso del bucket Cloud Storage che contiene i dati per la tabella, nel formatogs://bucket_name/[folder_name/]file_pattern.Puoi selezionare più file dal bucket specificando un carattere jolly asterisco (

*) infile_pattern. Ad esempio:gs://mybucket/file00*.parquet. Per ulteriori informazioni, consulta Supporto dei caratteri jolly per gli URI Cloud Storage.Puoi specificare più bucket per l'opzione

urisfornendo più percorsi.I seguenti esempi mostrano valori

urisvalidi:gs://bucket/path1/myfile.csvgs://bucket/path1/*.parquetgs://bucket/path1/file1*,gs://bucket1/path1/*

Quando specifichi valori

urische hanno come target più file, tutti questi file devono condividere uno schema compatibile.Per ulteriori informazioni sull'utilizzo degli URI Cloud Storage in BigQuery, consulta Percorso della risorsa Cloud Storage.

DATASET_NAME: il nome del set di dati che contiene la tabella.TABLE_NAME: il nome della tabella che stai creando.SCHEMA: specifica un percorso a un file di schema JSON, o specifica lo schema nel formatofield:data_type,field:data_type,.... Per utilizzare il rilevamento automatico dello schema, ometti questo argomento.

Esempio:

bq mkdef --source_format=CSV gs://mybucket/sales.csv > mytable_def

bq mk --table --external_table_definition=mytable_def \

mydataset.mytable \

Region:STRING,Quarter:STRING,Total_sales:INTEGER

API

Chiama il metodo API tables.insert e crea un ExternalDataConfiguration nella risorsa Table che trasmetti.

Specifica la proprietà schema o imposta la proprietà

autodetect su true per attivare il rilevamento automatico dello schema per le

origini dati supportate.

Java

Prima di provare questo esempio, segui le istruzioni di configurazione di Java nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Java.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Node.js

Prima di provare questo esempio, segui le istruzioni di configurazione di Node.js nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Node.js.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Python

Prima di provare questo esempio, segui le istruzioni di configurazione di Python nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Python.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Creare tabelle esterne sui dati partizionati

Puoi creare una tabella esterna per i dati partizionati di Hive che si trovano in Cloud Storage. Dopo aver creato una tabella partizionata esternamente, non puoi modificare la chiave di partizione. Per modificare la chiave di partizione, devi ricreare la tabella.

Per creare una tabella esterna per i dati partizionati Hive, scegli una delle seguenti opzioni:

Console

Nella Google Cloud console, vai a BigQuery.

- Nel riquadro a sinistra, fai clic su Esplora.

- Nel riquadro Explorer, espandi il progetto, fai clic su Set di dati e seleziona un set di dati.

- Fai clic su Azioni, e poi su Crea tabella. Si aprirà il riquadro Crea tabella.

- Nella sezione Origine, specifica i seguenti dettagli:

- Per Crea tabella da, seleziona Google Cloud Storage.

- Per Seleziona file dal bucket Cloud Storage, inserisci il percorso della cartella Cloud Storage utilizzando i caratteri jolly.

Ad esempio:

my_bucket/my_files*. Il bucket Cloud Storage deve trovarsi nella stessa posizione del set di dati che contiene la tabella che vuoi creare, aggiungere o sovrascrivere. - Nell'elenco Formato file, seleziona il tipo di file.

- Seleziona la casella di controllo Partizionamento dei dati di origine e poi, in Seleziona

il prefisso URI di origine, inserisci il prefisso URI Cloud Storage. Ad esempio,

gs://my_bucket/my_files. - Nella sezione Modalità di inferenza delle partizioni, seleziona una delle seguenti opzioni:

- Deduci automaticamente i tipi: imposta la modalità di rilevamento dello schema di partizionamento

su

AUTO. - Tutte le colonne sono stringhe: imposta la modalità di rilevamento dello schema di partizionamento su

STRINGS. - Fornisci il mio: imposta la modalità di rilevamento dello schema di partizionamento su

CUSTOMe inserisci manualmente le informazioni sullo schema per le chiavi di partizione. Per ulteriori informazioni, vedi Fornire uno schema di chiave di partizione personalizzato.

- Deduci automaticamente i tipi: imposta la modalità di rilevamento dello schema di partizionamento

su

- (Facoltativo) Per richiedere un filtro di partizione per tutte le query per questa tabella, seleziona la casella di controllo Richiedi filtro di partizione. Se il filtro di partizionamento è obbligatorio, i costi possono essere ridotti e le prestazioni migliorate. Per maggiori informazioni, consulta Richiesta di filtri predicativi sulle chiavi di partizione nelle query.

- Nella sezione Destinazione, specifica i seguenti dettagli:

- Per Progetto, seleziona il progetto in cui vuoi creare la tabella.

- Per Set di dati, seleziona il set di dati in cui vuoi creare la tabella.

- In Tabella, inserisci il nome della tabella che vuoi creare.

- Per Tipo di tabella, seleziona Tabella esterna.

- Nella sezione Schema, inserisci la definizione dello schema.

- Per attivare il rilevamento automatico dello schema, seleziona Rilevamento automatico.

- Per ignorare le righe con valori di colonna aggiuntivi che non corrispondono allo schema, espandi la sezione Opzioni avanzate e seleziona Valori sconosciuti.

- Fai clic su Crea tabella.

SQL

Utilizza l'istruzione DDL CREATE EXTERNAL TABLE.

L'esempio seguente utilizza il rilevamento automatico delle chiavi di partizione Hive:

CREATE EXTERNAL TABLE `PROJECT_ID.DATASET.EXTERNAL_TABLE_NAME` WITH PARTITION COLUMNS OPTIONS ( format = 'SOURCE_FORMAT', uris = ['GCS_URIS'], hive_partition_uri_prefix = 'GCS_URI_SHARED_PREFIX', require_hive_partition_filter = BOOLEAN);

Sostituisci quanto segue:

SOURCE_FORMAT: il formato dell'origine dati esterna, ad esempioPARQUETGCS_URIS: il percorso della cartella Cloud Storage, utilizzando il formato con caratteri jollyGCS_URI_SHARED_PREFIX: il prefisso URI di origine senza il carattere jollyBOOLEAN: se richiedere un filtro dei predicati al momento della query. Questo flag è facoltativo. Il valore predefinito èfalse.

L'esempio seguente utilizza tipi e chiavi di partizione Hive personalizzati elencandoli

nella clausola WITH PARTITION COLUMNS:

CREATE EXTERNAL TABLE `PROJECT_ID.DATASET.EXTERNAL_TABLE_NAME` WITH PARTITION COLUMNS (PARTITION_COLUMN_LIST) OPTIONS ( format = 'SOURCE_FORMAT', uris = ['GCS_URIS'], hive_partition_uri_prefix = 'GCS_URI_SHARED_PREFIX', require_hive_partition_filter = BOOLEAN);

Sostituisci quanto segue:

PARTITION_COLUMN_LIST: un elenco di colonne che seguono lo stesso ordine nel percorso della cartella Cloud Storage, nel formato:

KEY1 TYPE1, KEY2 TYPE2

L'esempio seguente crea una tabella partizionata esternamente. Utilizza il rilevamento automatico dello schema per rilevare sia lo schema del file sia il layout di partizionamento Hive. Se il percorso esterno è

gs://bucket/path/field_1=first/field_2=1/data.parquet, le colonne di partizione

vengono rilevate come field_1 (STRING) e field_2 (INT64).

CREATE EXTERNAL TABLE dataset.AutoHivePartitionedTable WITH PARTITION COLUMNS OPTIONS ( uris = ['gs://bucket/path/*'], format = 'PARQUET', hive_partition_uri_prefix = 'gs://bucket/path', require_hive_partition_filter = false);

L'esempio seguente crea una tabella partizionata esternamente specificando

esplicitamente le colonne di partizionamento. Questo esempio presuppone che il percorso del file esterno

abbia il pattern gs://bucket/path/field_1=first/field_2=1/data.parquet.

CREATE EXTERNAL TABLE dataset.CustomHivePartitionedTable WITH PARTITION COLUMNS ( field_1 STRING, -- column order must match the external path field_2 INT64) OPTIONS ( uris = ['gs://bucket/path/*'], format = 'PARQUET', hive_partition_uri_prefix = 'gs://bucket/path', require_hive_partition_filter = false);

bq

Innanzitutto, utilizza il

comando bq mkdef per

creare un file di definizione della tabella:

bq mkdef \ --source_format=SOURCE_FORMAT \ --hive_partitioning_mode=PARTITIONING_MODE \ --hive_partitioning_source_uri_prefix=GCS_URI_SHARED_PREFIX \ --require_hive_partition_filter=BOOLEAN \ GCS_URIS > DEFINITION_FILE

Sostituisci quanto segue:

SOURCE_FORMAT: il formato dell'origine dati esterna. Ad esempio,CSV.PARTITIONING_MODE: la modalità di partizionamento Hive. Utilizza uno dei seguenti valori:AUTO: rileva automaticamente i nomi e i tipi delle chiavi.STRINGS: converte automaticamente i nomi delle chiavi in stringhe.CUSTOM: codifica lo schema della chiave nel prefisso dell'URI di origine.

GCS_URI_SHARED_PREFIX: il prefisso URI di origine.BOOLEAN: specifica se richiedere un filtro dei predicati al momento della query. Questo flag è facoltativo. Il valore predefinito èfalse.GCS_URIS: il percorso della cartella Cloud Storage, utilizzando il formato con caratteri jolly.DEFINITION_FILE: il percorso del file di definizione della tabella sul tuo computer locale.

Se PARTITIONING_MODE è CUSTOM, includi lo schema della chiave di partizionamento

nel prefisso URI di origine, utilizzando il seguente formato:

--hive_partitioning_source_uri_prefix=GCS_URI_SHARED_PREFIX/{KEY1:TYPE1}/{KEY2:TYPE2}/...

Dopo aver creato il file di definizione della tabella, utilizza il comando

bq mk per

creare la tabella esterna:

bq mk --external_table_definition=DEFINITION_FILE \ DATASET_NAME.TABLE_NAME \ SCHEMA

Sostituisci quanto segue:

DEFINITION_FILE: il percorso del file di definizione della tabella.DATASET_NAME: il nome del set di dati che contiene la tabella.TABLE_NAME: il nome della tabella che stai creando.SCHEMA: specifica un percorso a un file di schema JSON, o specifica lo schema nel formatofield:data_type,field:data_type,.... Per utilizzare il rilevamento automatico dello schema, ometti questo argomento.

Esempi

L'esempio seguente utilizza la modalità di partizionamento Hive AUTO:

bq mkdef --source_format=CSV \

--hive_partitioning_mode=AUTO \

--hive_partitioning_source_uri_prefix=gs://myBucket/myTable \

gs://myBucket/myTable/* > mytable_def

bq mk --external_table_definition=mytable_def \

mydataset.mytable \

Region:STRING,Quarter:STRING,Total_sales:INTEGER

L'esempio seguente utilizza la modalità di partizionamento Hive STRING:

bq mkdef --source_format=CSV \

--hive_partitioning_mode=STRING \

--hive_partitioning_source_uri_prefix=gs://myBucket/myTable \

gs://myBucket/myTable/* > mytable_def

bq mk --external_table_definition=mytable_def \

mydataset.mytable \

Region:STRING,Quarter:STRING,Total_sales:INTEGER

L'esempio seguente utilizza la modalità di partizionamento Hive CUSTOM:

bq mkdef --source_format=CSV \

--hive_partitioning_mode=CUSTOM \

--hive_partitioning_source_uri_prefix=gs://myBucket/myTable/{dt:DATE}/{val:STRING} \

gs://myBucket/myTable/* > mytable_def

bq mk --external_table_definition=mytable_def \

mydataset.mytable \

Region:STRING,Quarter:STRING,Total_sales:INTEGER

API

Per impostare il partizionamento Hive utilizzando l'API BigQuery, includi un oggetto hivePartitioningOptions nell'oggetto ExternalDataConfiguration quando crei il file di definizione della tabella.

Se imposti il campo hivePartitioningOptions.mode su CUSTOM, devi codificare lo schema della chiave di partizione nel campo hivePartitioningOptions.sourceUriPrefix nel seguente modo:

gs://BUCKET/PATH_TO_TABLE/{KEY1:TYPE1}/{KEY2:TYPE2}/...

Per forzare l'utilizzo di un filtro predicato al momento della query, imposta il campo

hivePartitioningOptions.requirePartitionFilter su true.

Java

Prima di provare questo esempio, segui le istruzioni di configurazione di Java nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Java.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Eseguire query sulle tabelle esterne

Per maggiori informazioni, consulta Eseguire query sui dati di Cloud Storage in tabelle esterne.

Esegui l'upgrade delle tabelle esterne a BigLake

Puoi eseguire l'upgrade delle tabelle basate su Cloud Storage a tabelle BigLake associando la tabella esterna a una connessione. Se vuoi utilizzare la memorizzazione nella cache dei metadati con la tabella BigLake, puoi specificare le impostazioni per questa operazione contemporaneamente. Per ottenere i dettagli della tabella, come il formato e l'URI dell'origine, consulta Recuperare informazioni sulla tabella.

Per aggiornare una tabella esterna a una tabella BigLake, seleziona una delle seguenti opzioni:

SQL

Utilizza l'istruzione DDL CREATE OR REPLACE EXTERNAL TABLE per aggiornare una tabella:

Nella console Google Cloud , vai alla pagina BigQuery.

Nell'editor di query, inserisci la seguente istruzione:

CREATE OR REPLACE EXTERNAL TABLE `PROJECT_ID.DATASET.EXTERNAL_TABLE_NAME` WITH CONNECTION {`REGION.CONNECTION_ID` | DEFAULT} OPTIONS( format ="TABLE_FORMAT", uris = ['BUCKET_PATH'], max_staleness = STALENESS_INTERVAL, metadata_cache_mode = 'CACHE_MODE' );

Sostituisci quanto segue:

PROJECT_ID: il nome del progetto che contiene la tabellaDATASET: il nome del set di dati che contiene la tabellaEXTERNAL_TABLE_NAME: il nome della tabellaREGION: la regione che contiene la connessioneCONNECTION_ID: il nome della connessione da utilizzarePer utilizzare una connessione predefinita, specifica

DEFAULTanziché la stringa di connessione contenenteREGION.CONNECTION_ID.TABLE_FORMAT: il formato utilizzato dalla tabellaNon puoi modificare questa impostazione durante l'aggiornamento della tabella.

BUCKET_PATH: il percorso del bucket Cloud Storage che contiene i dati per la tabella esterna, nel formato['gs://bucket_name/[folder_name/]file_name'].Puoi selezionare più file dal bucket specificando un carattere jolly asterisco (

*) nel percorso. Ad esempio,['gs://mybucket/file_name*']. Per ulteriori informazioni, consulta Supporto dei caratteri jolly per gli URI Cloud Storage.Puoi specificare più bucket per l'opzione

urisfornendo più percorsi.I seguenti esempi mostrano valori

urisvalidi:['gs://bucket/path1/myfile.csv']['gs://bucket/path1/*.csv']['gs://bucket/path1/*', 'gs://bucket/path2/file00*']

Quando specifichi valori

urische hanno come target più file, tutti questi file devono condividere uno schema compatibile.Per ulteriori informazioni sull'utilizzo degli URI Cloud Storage in BigQuery, consulta Percorso della risorsa Cloud Storage.

STALENESS_INTERVAL: specifica se i metadati memorizzati nella cache vengono utilizzati dalle operazioni sulla tabella e quanto devono essere aggiornati i metadati memorizzati nella cache affinché l'operazione li utilizziPer ulteriori informazioni sulle considerazioni relative alla memorizzazione nella cache dei metadati, consulta Memorizzazione nella cache dei metadati per il rendimento.

Per disattivare la memorizzazione nella cache dei metadati, specifica 0. Questa è l'impostazione predefinita.

Per attivare la memorizzazione nella cache dei metadati, specifica un valore letterale di intervallo compreso tra 30 minuti e 7 giorni. Ad esempio, specifica

INTERVAL 4 HOURper un intervallo di obsolescenza di 4 ore. Con questo valore, le operazioni sulla tabella utilizzano i metadati memorizzati nella cache se sono stati aggiornati nelle ultime 4 ore. Se i metadati memorizzati nella cache sono più vecchi, l'operazione recupera i metadati da Cloud Storage.CACHE_MODE: specifica se la cache dei metadati viene aggiornata automaticamente o manualmentePer ulteriori informazioni sulle considerazioni relative alla memorizzazione nella cache dei metadati, consulta Memorizzazione nella cache dei metadati per il rendimento.

Imposta

AUTOMATICper l'aggiornamento della cache dei metadati a un intervallo definito dal sistema, in genere tra 30 e 60 minuti.Imposta su

MANUALse vuoi aggiornare la cache dei metadati in base a una pianificazione che determini. In questo caso, puoi chiamare la procedura di sistemaBQ.REFRESH_EXTERNAL_METADATA_CACHEper aggiornare la cache.Devi impostare

CACHE_MODEseSTALENESS_INTERVALè impostato su un valore maggiore di 0.

Fai clic su Esegui.

Per saperne di più su come eseguire le query, consulta Eseguire una query interattiva.

bq

Utilizza i comandi bq mkdef e

bq update

per aggiornare una tabella:

Genera una definizione di tabella esterna, che descrive gli aspetti della tabella da modificare:

bq mkdef --connection_id=PROJECT_ID.REGION.CONNECTION_ID \ --source_format=TABLE_FORMAT \ --metadata_cache_mode=CACHE_MODE \ "BUCKET_PATH" > /tmp/DEFINITION_FILE

Sostituisci quanto segue:

PROJECT_ID: il nome del progetto che contiene la connessioneREGION: la regione che contiene la connessioneCONNECTION_ID: il nome della connessione da utilizzareTABLE_FORMAT: il formato utilizzato dalla tabella. Non puoi modificare questa impostazione durante l'aggiornamento della tabella.CACHE_MODE: specifica se la cache dei metadati viene aggiornata automaticamente o manualmente. Per ulteriori informazioni sulle considerazioni relative alla memorizzazione nella cache dei metadati, consulta Memorizzazione nella cache dei metadati per il rendimento.Imposta

AUTOMATICper aggiornare la cache dei metadati a un intervallo definito dal sistema, in genere compreso tra 30 e 60 minuti.Imposta

MANUALse vuoi aggiornare la cache dei metadati in base a una pianificazione che determini. In questo caso, puoi chiamare la procedura di sistemaBQ.REFRESH_EXTERNAL_METADATA_CACHEper aggiornare la cache.Devi impostare

CACHE_MODEseSTALENESS_INTERVALè impostato su un valore maggiore di 0.BUCKET_PATH: il percorso del bucket Cloud Storage che contiene i dati per la tabella esterna, nel formatogs://bucket_name/[folder_name/]file_name.Puoi limitare i file selezionati dal bucket specificando un carattere jolly asterisco (

*) nel percorso. Ad esempio,gs://mybucket/file_name*. Per ulteriori informazioni, consulta Supporto dei caratteri jolly per gli URI Cloud Storage.Puoi specificare più bucket per l'opzione

urisfornendo più percorsi.I seguenti esempi mostrano valori

urisvalidi:gs://bucket/path1/myfile.csvgs://bucket/path1/*.csvgs://bucket/path1/*,gs://bucket/path2/file00*

Quando specifichi valori

urische hanno come target più file, tutti questi file devono condividere uno schema compatibile.Per ulteriori informazioni sull'utilizzo degli URI Cloud Storage in BigQuery, consulta Percorso della risorsa Cloud Storage.

DEFINITION_FILE: il nome del file di definizione della tabella che stai creando.

Aggiorna la tabella utilizzando la nuova definizione della tabella esterna:

bq update --max_staleness=STALENESS_INTERVAL \ --external_table_definition=/tmp/DEFINITION_FILE \ PROJECT_ID:DATASET.EXTERNAL_TABLE_NAME

Sostituisci quanto segue:

STALENESS_INTERVAL: specifica se i metadati memorizzati nella cache vengono utilizzati dalle operazioni sulla tabella e quanto devono essere aggiornati i metadati memorizzati nella cache affinché l'operazione possa utilizzarli. Per ulteriori informazioni sulle considerazioni sulla memorizzazione nella cache dei metadati, consulta Memorizzazione nella cache dei metadati per il rendimento.Per disattivare la memorizzazione nella cache dei metadati, specifica 0. Questa è l'impostazione predefinita.

Per attivare la memorizzazione nella cache dei metadati, specifica un valore di intervallo compreso tra 30 minuti e 7 giorni utilizzando il formato

Y-M D H:M:Sdescritto nella documentazione del tipo di datiINTERVAL. Ad esempio, specifica0-0 0 4:0:0per un intervallo di inattività di 4 ore. Con questo valore, le operazioni sulla tabella utilizzano i metadati memorizzati nella cache se sono stati aggiornati nelle ultime 4 ore. Se i metadati memorizzati nella cache sono più vecchi, l'operazione recupera i metadati da Cloud Storage.DEFINITION_FILE: il nome del file di definizione della tabella che hai creato o aggiornato.PROJECT_ID: il nome del progetto che contiene la tabellaDATASET: il nome del set di dati che contiene la tabellaEXTERNAL_TABLE_NAME: il nome della tabella

Percorso della risorsa Cloud Storage

Quando crei una tabella esterna basata su un'origine dati Cloud Storage, devi fornire il percorso dei dati.

Il percorso della risorsa Cloud Storage contiene il nome del bucket e

l'oggetto (nome file). Ad esempio, se il bucket Cloud Storage si chiama

mybucket e il file di dati si chiama myfile.csv, il percorso della risorsa sarà

gs://mybucket/myfile.csv.

BigQuery non supporta i percorsi delle risorse Cloud Storage

che includono più barre consecutive dopo la doppia barra iniziale.

I nomi degli oggetti Cloud Storage possono contenere più caratteri barra ("/")

consecutivi. Tuttavia, BigQuery converte più barre consecutive

in una singola barra. Ad esempio, il seguente percorso della risorsa, sebbene

valido in Cloud Storage, non funziona in BigQuery:

gs://bucket/my//object//name.

Per recuperare il percorso della risorsa Cloud Storage:

Apri la console Cloud Storage.

Sfoglia fino alla posizione dell'oggetto (file) che contiene i dati di origine.

Fai clic sul nome dell'oggetto.

Viene visualizzata la pagina Dettagli oggetto.

Copia il valore fornito nel campo URI gsutil, che inizia con

gs://.

Supporto dei caratteri jolly per gli URI Cloud Storage

Se i dati sono suddivisi in più file, puoi utilizzare un carattere jolly asterisco (*) per selezionare più file. L'utilizzo del carattere jolly asterisco deve rispettare le seguenti regole:

- L'asterisco può essere visualizzato all'interno del nome dell'oggetto o alla fine del nome dell'oggetto.

- L'utilizzo di più asterischi non è supportato. Ad esempio, il percorso

gs://mybucket/fed-*/temp/*.csvnon è valido. - L'utilizzo di un asterisco con il nome del bucket non è supportato.

Esempi:

L'esempio seguente mostra come selezionare tutti i file in tutte le cartelle che iniziano con il prefisso

gs://mybucket/fed-samples/fed-sample:gs://mybucket/fed-samples/fed-sample*L'esempio seguente mostra come selezionare solo i file con estensione

.csvnella cartella denominatafed-samplese in qualsiasi sottocartella difed-samples:gs://mybucket/fed-samples/*.csvL'esempio seguente mostra come selezionare i file con un pattern di denominazione

fed-sample*.csvnella cartella denominatafed-samples. Questo esempio non seleziona i file nelle sottocartelle difed-samples.gs://mybucket/fed-samples/fed-sample*.csv

Quando utilizzi lo strumento a riga di comando bq, potresti dover eseguire l'escape dell'asterisco su alcune piattaforme.

Non puoi utilizzare un carattere jolly asterisco quando crei tabelle esterne collegate a esportazioni Datastore o Firestore.

Prezzi

Alle richieste BigQuery si applicano le seguenti tariffe di recupero e trasferimento dati di Cloud Storage:

- Le tariffe di recupero per le classi Nearline, Coldline e Archive Storage vengono addebitate in base alla documentazione sui prezzi esistente e agli SKU di recupero.

- Le tariffe di trasferimento di dati di rete tra regioni vengono applicate quando un job BigQuery in una località legge i dati archiviati in un bucket Cloud Storage in una località diversa. Questi addebiti sono

coperti dai seguenti SKU:

- Google Cloud Trasferimento di dati di Storage tra continente 1 e continente 2. Ad esempio, vedi Trasferimento dati diGoogle Cloud Storage tra Nord America ed Europa per il trasferimento di dati da

us-central1aeurope-west1. - Trasferimento di dati di rete Google Cloud tra regioni all'interno di un continente. Ad esempio, consulta Trasferimento di dati di rete Google Cloud tra regioni all'interno del Nord America per il trasferimento di dati da

us-east4aUS.

- Google Cloud Trasferimento di dati di Storage tra continente 1 e continente 2. Ad esempio, vedi Trasferimento dati diGoogle Cloud Storage tra Nord America ed Europa per il trasferimento di dati da

Limitazioni

Per informazioni sulle limitazioni applicate alle tabelle esterne, vedi Limitazioni delle tabelle esterne.

Passaggi successivi

- Scopri di più sulle tabelle esterne.

- Scopri di più sulle tabelle BigLake.