Creare e utilizzare le tabelle

Questo documento descrive come creare e utilizzare tabelle standard (integrate) in BigQuery. Per informazioni sulla creazione di altri tipi di tabelle, consulta quanto segue:

Dopo aver creato una tabella, puoi:

- Controlla l'accesso ai dati delle tabelle.

- Visualizzare informazioni sulle tabelle.

- Elenca le tabelle in un set di dati.

- Recupera i metadati della tabella.

Per ulteriori informazioni sulla gestione delle tabelle, inclusi l'aggiornamento delle proprietà, la copia e l'eliminazione, consulta Gestione delle tabelle.

Prima di iniziare

Concedi ruoli IAM (Identity and Access Management) che forniscono agli utenti le autorizzazioni necessarie per eseguire ogni attività descritta in questo documento.

Ruoli obbligatori

Per ottenere le autorizzazioni necessarie per creare una tabella, chiedi all'amministratore di concederti i seguenti ruoli IAM:

-

Utente job BigQuery (

roles/bigquery.jobUser) sul progetto se stai creando una tabella caricando dati o salvando i risultati della query in una tabella. -

Editor dati BigQuery (

roles/bigquery.dataEditor) nel set di dati in cui stai creando la tabella.

Per ulteriori informazioni sulla concessione dei ruoli, consulta Gestisci l'accesso a progetti, cartelle e organizzazioni.

Questi ruoli predefiniti contengono le autorizzazioni necessarie per creare una tabella. Per vedere quali sono esattamente le autorizzazioni richieste, espandi la sezione Autorizzazioni obbligatorie:

Autorizzazioni obbligatorie

Per creare una tabella sono necessarie le seguenti autorizzazioni:

-

bigquery.tables.createnel set di dati in cui stai creando la tabella. -

bigquery.tables.getDatain tutte le tabelle e le viste a cui fa riferimento la query se salvi i risultati della query come tabella. -

bigquery.jobs.createsul progetto se crei la tabella caricando i dati o salvando i risultati della query in una tabella. -

bigquery.tables.updateDatanella tabella se stai aggiungendo o sovrascrivendo una tabella con i risultati della query.

Potresti anche ottenere queste autorizzazioni con ruoli personalizzati o altri ruoli predefiniti.

Denominazione delle tabelle

Quando crei una tabella in BigQuery, il nome della tabella deve essere univoco per ogni set di dati. Il nome della tabella può:

- Contenere caratteri con un totale massimo di 1024 byte UTF-8.

- Contenere caratteri Unicode nelle categorie L (lettera), M (segno), N (numero), Pc (connettore, incluso il trattino basso), Pd (trattino), Zs (spazio). Per ulteriori informazioni, consulta Categoria generale.

Di seguito sono riportati alcuni esempi di nomi di tabelle validi:

table 01, ग्राहक, 00_お客様, étudiant-01.

Avvertenze:

- I nomi delle tabelle sono sensibili alle maiuscole per impostazione predefinita.

mytableeMyTablepossono coesistere nello stesso set di dati, a meno che non facciano parte di un set di dati con distinzione tra maiuscole e minuscole disattivata. - Alcuni nomi di tabelle e prefissi dei nomi di tabelle sono riservati. Se ricevi un errore che indica che il nome o il prefisso della tabella è riservato, seleziona un nome diverso e riprova.

Se includi più operatori punto (

.) in una sequenza, gli operatori duplicati vengono rimossi implicitamente.Ad esempio:

project_name....dataset_name..table_nameDiventa:

project_name.dataset_name.table_name

Crea tabelle

Puoi creare una tabella in BigQuery nei seguenti modi:

- Manualmente utilizzando la Google Cloud console o lo strumento a riga di comando bq

bq mk. - In modo programmatico chiamando il metodo API

tables.insert. - Utilizzando le librerie client.

- Dai risultati della query.

- Definendo una tabella che fa riferimento a un'origine dati esterna.

- Quando carichi i dati.

- Utilizzando un'istruzione DDL (Data Definition Language)

CREATE TABLE.

Crea una tabella vuota con una definizione dello schema

Puoi creare una tabella vuota con una definizione dello schema nei seguenti modi:

- Inserisci lo schema utilizzando la console Google Cloud .

- Fornisci lo schema inline utilizzando lo strumento a riga di comando bq.

- Invia un file di schema JSON utilizzando lo strumento a riga di comando bq.

- Fornisci lo schema in una risorsa tabella

quando chiami il metodo

tables.insertdelle API.

Per ulteriori informazioni su come specificare uno schema di tabella, vedi Specifica di uno schema.

Dopo aver creato la tabella, puoi caricarvi i dati o popolarla scrivendo i risultati della query.

Per creare una tabella vuota con una definizione dello schema:

Console

Nella console Google Cloud , vai alla pagina BigQuery.

- Nel riquadro a sinistra, fai clic su Esplora.

- Nel riquadro Explorer, espandi il progetto, fai clic su Set di dati e seleziona un set di dati.

- Nella sezione Informazioni sul set di dati, fai clic su Crea tabella.

- Nel riquadro Crea tabella, specifica i seguenti dettagli:

- Nella sezione Origine, seleziona Tabella vuota nell'elenco Crea tabella da.

- Nella sezione Destinazione, specifica i seguenti dettagli:

- Per Set di dati, seleziona il set di dati in cui vuoi creare la tabella.

- Nel campo Table (Tabella), inserisci il nome della tabella che vuoi creare.

- Verifica che il campo Tipo di tabella sia impostato su Tabella nativa.

- Nella sezione Schema, inserisci la definizione dello schema.

Puoi inserire manualmente le informazioni sullo schema utilizzando uno dei seguenti metodi:

- Opzione 1: fai clic su Modifica come testo e incolla lo schema sotto forma di

array JSON. Quando utilizzi un array JSON, generi lo schema utilizzando lo stesso processo di creazione di un file schema JSON.

Per visualizzare lo schema di una tabella esistente in formato JSON, inserisci il seguente comando:

bq show --format=prettyjson dataset.table

- Opzione 2: fai clic su Aggiungi campo e inserisci lo schema della tabella. Specifica il nome, il tipo e la modalità di ogni campo.

- Opzione 1: fai clic su Modifica come testo e incolla lo schema sotto forma di

array JSON. Quando utilizzi un array JSON, generi lo schema utilizzando lo stesso processo di creazione di un file schema JSON.

Per visualizzare lo schema di una tabella esistente in formato JSON, inserisci il seguente comando:

- (Facoltativo) Specifica le impostazioni di partizionamento e clustering. Per ulteriori informazioni, vedi Creare tabelle partizionate e Creare e utilizzare tabelle in cluster.

- (Facoltativo) Nella sezione Opzioni avanzate, se vuoi utilizzare una chiave di crittografia gestita dal cliente, seleziona l'opzione Utilizza una chiave di crittografia gestita dal cliente (CMEK). Per impostazione predefinita, BigQuery cripta i contenuti dei clienti archiviati at-rest utilizzando un Google-owned and Google-managed encryption key.

- Fai clic su Crea tabella.

SQL

L'esempio seguente crea una tabella denominata newtable che scade il

1° gennaio 2023:

Nella console Google Cloud , vai alla pagina BigQuery.

Nell'editor di query, inserisci la seguente istruzione:

CREATE TABLE mydataset.newtable ( x INT64 OPTIONS (description = 'An optional INTEGER field'), y STRUCT < a ARRAY <STRING> OPTIONS (description = 'A repeated STRING field'), b BOOL > ) OPTIONS ( expiration_timestamp = TIMESTAMP '2023-01-01 00:00:00 UTC', description = 'a table that expires in 2023', labels = [('org_unit', 'development')]);

Fai clic su Esegui.

Per saperne di più su come eseguire le query, consulta Eseguire una query interattiva.

bq

-

In the Google Cloud console, activate Cloud Shell.

At the bottom of the Google Cloud console, a Cloud Shell session starts and displays a command-line prompt. Cloud Shell is a shell environment with the Google Cloud CLI already installed and with values already set for your current project. It can take a few seconds for the session to initialize.

Utilizza il comando

bq mkcon il flag--tableo-t. Puoi fornire le informazioni sullo schema della tabella inline o con un file di schema JSON. Per un elenco completo dei parametri, consulta il riferimentobq mk --table. Alcuni parametri facoltativi includono:--expiration--description--time_partitioning_field--time_partitioning_type--range_partitioning--clustering_fields--destination_kms_key--label

--time_partitioning_field,--time_partitioning_type,--range_partitioning,--clustering_fieldse--destination_kms_keynon sono dimostrati qui. Per saperne di più su questi parametri facoltativi, consulta i seguenti link:- Per maggiori informazioni su

--time_partitioning_field,--time_partitioning_typee--range_partitioning, consulta la sezione Tabelle partizionate. - Per maggiori informazioni su

--clustering_fields, consulta la sezione Tabelle in cluster. - Per saperne di più su

--destination_kms_key, consulta Chiavi di crittografia gestite dal cliente.

Se stai creando una tabella in un progetto diverso da quello predefinito, aggiungi l'ID progetto al set di dati nel seguente formato:

project_id:dataset.Per creare una tabella vuota in un set di dati esistente con una definizione dello schema, inserisci quanto segue:

bq mk \ --table \ --expiration=integer \ --description=description \ --label=key_1:value_1 \ --label=key_2:value_2 \ --add_tags=key_3:value_3[,...] \ project_id:dataset.table \ schema

Sostituisci quanto segue:

- integer è la durata predefinita (in secondi) della tabella. Il valore minimo è 3600 secondi (un'ora). La scadenza corrisponde all'ora UTC attuale più il valore intero. Se imposti il tempo di scadenza quando crei una tabella, l'impostazione di scadenza predefinita della tabella del set di dati viene ignorata.

- description è una descrizione della tabella tra virgolette.

- key_1:value_1 e key_2:value_2 sono coppie chiave-valore che specificano le etichette.

- key_3:value_3 sono coppie chiave-valore che specificano i tag. Aggiungi più tag con lo stesso flag separando le coppie chiave:valore con virgole.

- project_id è l'ID progetto.

- dataset è un set di dati nel tuo progetto.

- table è il nome della tabella che stai creando.

- schema è una definizione di schema incorporata nel formato field:data_type,field:data_type o il percorso del file di schema JSON sulla macchina locale.

Quando specifichi lo schema nella riga di comando, non puoi includere un tipo

RECORD(STRUCT), non puoi includere una descrizione della colonna e non puoi specificare la modalità della colonna. Tutte le modalità sono impostate suNULLABLEper impostazione predefinita. Per includere descrizioni, modalità e tipi diRECORD, fornisci un file di schema JSON.Esempi:

Inserisci il comando seguente per creare una tabella utilizzando una definizione dello schema incorporata. Questo comando crea una tabella denominata

mytableinmydatasetnel tuo progetto predefinito. La scadenza della tabella è impostata su 3600 secondi (1 ora), la descrizione è impostata suThis is my tablee l'etichetta suorganization:development. Il comando utilizza la scorciatoia-tanziché--table. Lo schema è specificato in linea come:qtr:STRING,sales:FLOAT,year:STRING.bq mk \ -t \ --expiration 3600 \ --description "This is my table" \ --label organization:development \ mydataset.mytable \ qtr:STRING,sales:FLOAT,year:STRING

Inserisci il seguente comando per creare una tabella utilizzando un file di schema JSON. Questo comando crea una tabella denominata

mytableinmydatasetnel tuo progetto predefinito. La scadenza della tabella è impostata su 3600 secondi (1 ora), la descrizione è impostata suThis is my tablee l'etichetta è impostata suorganization:development. Il percorso del file dello schema è/tmp/myschema.json.bq mk \ --table \ --expiration 3600 \ --description "This is my table" \ --label organization:development \ mydataset.mytable \ /tmp/myschema.json

Inserisci il seguente comando per creare una tabella utilizzando un file di schema JSON. Questo comando crea una tabella denominata

mytableinmydatasetinmyotherproject. La scadenza della tabella è impostata su 3600 secondi (1 ora), la descrizione è impostata suThis is my tablee l'etichetta è impostata suorganization:development. Il percorso del file dello schema è/tmp/myschema.json.bq mk \ --table \ --expiration 3600 \ --description "This is my table" \ --label organization:development \ myotherproject:mydataset.mytable \ /tmp/myschema.json

Una volta creata la tabella, puoi aggiornare la scadenza, la descrizione e le etichette. Puoi anche modificare la definizione dello schema.

- Avvia Cloud Shell.

-

Imposta il progetto Google Cloud predefinito in cui vuoi applicare le configurazioni Terraform.

Devi eseguire questo comando una sola volta per progetto e puoi eseguirlo in qualsiasi directory.

export GOOGLE_CLOUD_PROJECT=PROJECT_ID

Le variabili di ambiente vengono sostituite se imposti valori espliciti nel file di configurazione Terraform.

-

In Cloud Shell, crea una directory e un nuovo file al suo interno. Il nome file deve avere l'estensione

.tf, ad esempiomain.tf. In questo tutorial, il file viene denominatomain.tf.mkdir DIRECTORY && cd DIRECTORY && touch main.tf

-

Se stai seguendo un tutorial, puoi copiare il codice campione in ogni sezione o passaggio.

Copia il codice campione nel

main.tfappena creato.(Facoltativo) Copia il codice da GitHub. Questa operazione è consigliata quando lo snippet Terraform fa parte di una soluzione end-to-end.

- Rivedi e modifica i parametri di esempio da applicare al tuo ambiente.

- Salva le modifiche.

-

Inizializza Terraform. Devi effettuare questa operazione una sola volta per directory.

terraform init

(Facoltativo) Per utilizzare l'ultima versione del provider Google, includi l'opzione

-upgrade:terraform init -upgrade

-

Rivedi la configurazione e verifica che le risorse che Terraform creerà o

aggiornerà corrispondano alle tue aspettative:

terraform plan

Apporta le correzioni necessarie alla configurazione.

-

Applica la configurazione di Terraform eseguendo il comando seguente e inserendo

yesal prompt:terraform apply

Attendi che Terraform visualizzi il messaggio "Apply complete!".

- Apri il tuo Google Cloud progetto per visualizzare i risultati. Nella console Google Cloud , vai alle risorse nell'interfaccia utente per assicurarti che Terraform le abbia create o aggiornate.

Terraform

Utilizza la risorsa

google_bigquery_table.

Per eseguire l'autenticazione in BigQuery, configura le credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Creare una tabella

L'esempio seguente crea una tabella denominata mytable:

Creare una tabella e concedere l'accesso

L'esempio seguente crea una tabella denominata mytable, quindi utilizza la risorsa

google_bigquery_table_iam_policy per concedere

l'accesso. Esegui questo passaggio solo se vuoi concedere l'accesso

alla tabella alle entità che non hanno accesso al set di dati in cui

si trova la tabella.

Crea una tabella con una chiave di crittografia gestita dal cliente

L'esempio seguente crea una tabella denominata mytable e utilizza anche le risorse

google_kms_crypto_key

e

google_kms_key_ring

per specificare una

chiave Cloud Key Management Service per la

tabella. Prima di eseguire questo esempio, devi abilitare l'API Cloud Key Management Service.

Per applicare la configurazione di Terraform in un progetto Google Cloud , completa i passaggi nelle sezioni seguenti.

Prepara Cloud Shell

Prepara la directory

Ogni file di configurazione Terraform deve avere la propria directory (chiamata anche modulo radice).

Applica le modifiche

API

Chiama il metodo tables.insert con una risorsa tabella definita.

C#

Prima di provare questo esempio, segui le istruzioni di configurazione di C# nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery C#.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Vai

Prima di provare questo esempio, segui le istruzioni di configurazione di Go nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Go.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Java

Prima di provare questo esempio, segui le istruzioni di configurazione di Java nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Java.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Node.js

Prima di provare questo esempio, segui le istruzioni di configurazione di Node.js nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Node.js.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

PHP

Prima di provare questo esempio, segui le istruzioni di configurazione di PHP nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery PHP.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Python

Prima di provare questo esempio, segui le istruzioni di configurazione di Python nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Python.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Ruby

Prima di provare questo esempio, segui le istruzioni di configurazione di Ruby nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Ruby.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Crea una tabella vuota senza una definizione dello schema

Java

Prima di provare questo esempio, segui le istruzioni di configurazione di Java nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Java.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Creare una tabella da un risultato di query

Per creare una tabella da un risultato di query, scrivi i risultati in una tabella di destinazione.

Console

Apri la pagina BigQuery nella console Google Cloud .

Nel riquadro a sinistra, fai clic su Explorer:

Se non vedi il riquadro a sinistra, fai clic su Espandi riquadro a sinistra per aprirlo.

Nel riquadro Explorer, espandi il progetto, fai clic su Set di dati e poi seleziona un set di dati.

Nell'editor di query, inserisci una query SQL valida.

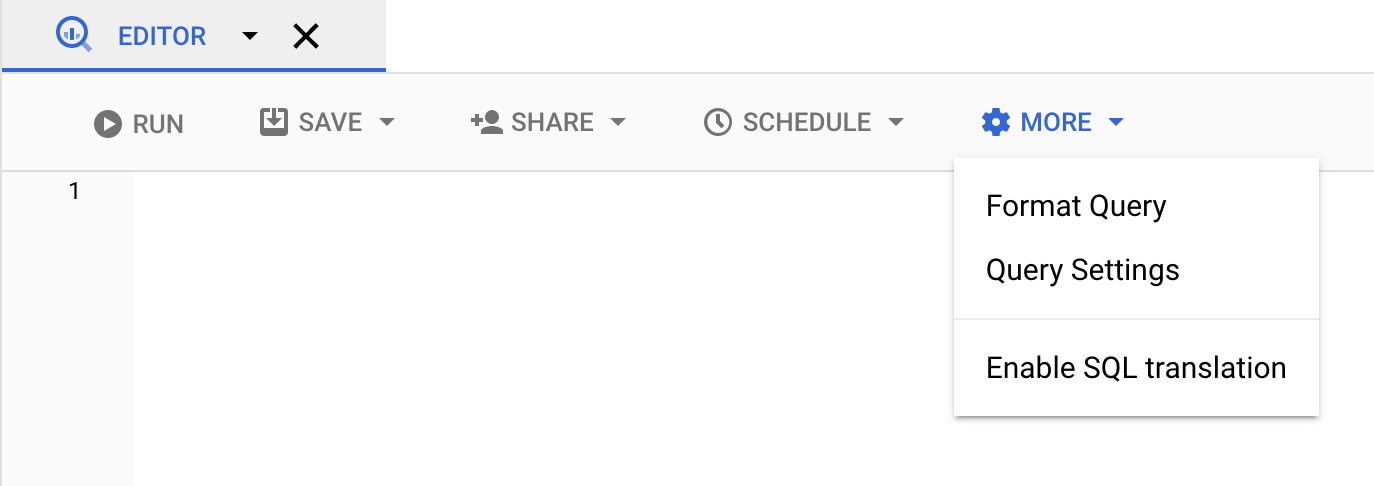

Fai clic su Altro e poi seleziona Impostazioni query.

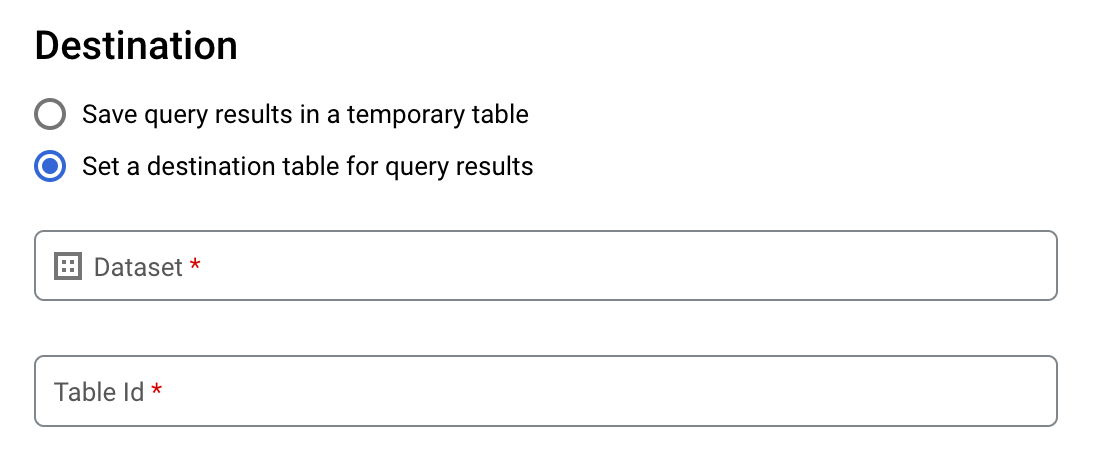

Seleziona l'opzione Imposta una tabella di destinazione per i risultati della query.

Nella sezione Destinazione, seleziona il set di dati in cui vuoi creare la tabella, quindi scegli un ID tabella.

Nella sezione Preferenza di scrittura per tabella di destinazione, scegli una delle seguenti opzioni:

- Scrivi se vuota: scrive i risultati della query nella tabella solo se è vuota.

- Aggiungi alla tabella: aggiunge i risultati della query a una tabella esistente.

- Sovrascrivi tabella: sovrascrive una tabella esistente con lo stesso nome utilizzando i risultati della query.

(Facoltativo) Per Località dei dati, scegli la tua località.

Per aggiornare le impostazioni della query, fai clic su Salva.

Fai clic su Esegui. Viene creato un job di query che scrive i risultati della query nella tabella specificata.

In alternativa, se dimentichi di specificare una tabella di destinazione prima di eseguire la query, puoi copiare la tabella dei risultati memorizzati nella cache in una tabella permanente facendo clic sul pulsante Salva risultati sopra l'editor.

SQL

L'esempio seguente utilizza l'istruzione

CREATE TABLE

per creare la tabella trips dai dati della tabella

bikeshare_trips pubblica:

Nella console Google Cloud , vai alla pagina BigQuery.

Nell'editor di query, inserisci la seguente istruzione:

CREATE TABLE mydataset.trips AS ( SELECT bike_id, start_time, duration_minutes FROM bigquery-public-data.austin_bikeshare.bikeshare_trips );

Fai clic su Esegui.

Per saperne di più su come eseguire le query, consulta Eseguire una query interattiva.

Per saperne di più, vedi Creazione di una nuova tabella da una tabella esistente.

bq

-

In the Google Cloud console, activate Cloud Shell.

At the bottom of the Google Cloud console, a Cloud Shell session starts and displays a command-line prompt. Cloud Shell is a shell environment with the Google Cloud CLI already installed and with values already set for your current project. It can take a few seconds for the session to initialize.

Inserisci il comando

bq querye specifica il flag--destination_tableper creare una tabella permanente in base ai risultati della query. Specifica il flaguse_legacy_sql=falseper utilizzare la sintassi GoogleSQL. Per scrivere i risultati della query in una tabella che non si trova nel tuo progetto predefinito, aggiungi l'ID progetto al nome del set di dati nel seguente formato:project_id:dataset.(Facoltativo) Fornisci il flag

--locatione imposta il valore sulla tua posizione.Per controllare la disposizione di scrittura per una tabella di destinazione esistente, specifica uno dei seguenti flag facoltativi:

--append_table: se la tabella di destinazione esiste, i risultati della query vengono aggiunti.--replace: se la tabella di destinazione esiste, viene sovrascritta con i risultati della query.bq --location=location query \ --destination_table project_id:dataset.table \ --use_legacy_sql=false 'query'

Sostituisci quanto segue:

locationè il nome della località utilizzata per elaborare la query. Il flag--locationè facoltativo. Ad esempio, se utilizzi BigQuery nella regione di Tokyo, puoi impostare il valore del flag suasia-northeast1. Puoi impostare un valore predefinito per la posizione utilizzando il file.bigqueryrc.project_idè l'ID progetto.datasetè il nome del set di dati che contiene la tabella in cui stai scrivendo i risultati della query.tableè il nome della tabella in cui vengono scritti i risultati della query.queryè una query nella sintassi GoogleSQL.Se non viene specificato alcun flag di disposizione di scrittura, il comportamento predefinito è scrivere i risultati nella tabella solo se è vuota. Se la tabella esiste e non è vuota, viene restituito il seguente errore:

BigQuery error in query operation: Error processing job project_id:bqjob_123abc456789_00000e1234f_1: Already Exists: Table project_id:dataset.table.Esempi:

Inserisci il comando seguente per scrivere i risultati della query in una tabella di destinazione denominata

mytableinmydataset. Il set di dati si trova nel tuo progetto predefinito. Poiché nel comando non è specificato alcun flag di disposizione di scrittura, la tabella deve essere nuova o vuota. In caso contrario, viene restituito un erroreAlready exists. La query recupera i dati dal set di dati pubblico USA Name Data.bq query \ --destination_table mydataset.mytable \ --use_legacy_sql=false \ 'SELECT name, number FROM `bigquery-public-data`.usa_names.usa_1910_current WHERE gender = "M" ORDER BY number DESC'

Inserisci il seguente comando per utilizzare i risultati della query per sovrascrivere una tabella di destinazione denominata

mytableinmydataset. Il set di dati si trova nel tuo progetto predefinito. Il comando utilizza il flag--replaceper sovrascrivere la tabella di destinazione.bq query \ --destination_table mydataset.mytable \ --replace \ --use_legacy_sql=false \ 'SELECT name, number FROM `bigquery-public-data`.usa_names.usa_1910_current WHERE gender = "M" ORDER BY number DESC'

Inserisci il seguente comando per aggiungere i risultati della query a una tabella di destinazione denominata

mytableinmydataset. Il set di dati si trova inmy-other-project, non nel tuo progetto predefinito. Il comando utilizza il flag--append_tableper aggiungere i risultati della query alla tabella di destinazione.bq query \ --append_table \ --use_legacy_sql=false \ --destination_table my-other-project:mydataset.mytable \ 'SELECT name, number FROM `bigquery-public-data`.usa_names.usa_1910_current WHERE gender = "M" ORDER BY number DESC'

L'output di ciascuno di questi esempi è simile al seguente. Per leggibilità, alcuni output sono troncati.

Waiting on bqjob_r123abc456_000001234567_1 ... (2s) Current status: DONE +---------+--------+ | name | number | +---------+--------+ | Robert | 10021 | | John | 9636 | | Robert | 9297 | | ... | +---------+--------+

API

Per salvare i risultati della query in una tabella permanente, chiama il metodo

jobs.insert,

configura un job query e includi un valore per la proprietà destinationTable. Per controllare la disposizione di scrittura per una tabella di destinazione esistente, configura la proprietà writeDisposition.

Per controllare la località di elaborazione del job di query, specifica la proprietà location

nella sezione jobReference della risorsa job.

Vai

Prima di provare questo esempio, segui le istruzioni di configurazione di Go nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Go.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Java

Prima di provare questo esempio, segui le istruzioni di configurazione di Java nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Java.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Per salvare i risultati della query in una tabella permanente, imposta la tabella di destinazione sul TableId desiderato in una QueryJobConfiguration.

Node.js

Prima di provare questo esempio, segui le istruzioni di configurazione di Node.js nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Node.js.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Python

Prima di provare questo esempio, segui le istruzioni di configurazione di Python nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Python.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Per salvare i risultati della query in una tabella permanente, crea un oggetto QueryJobConfig e imposta la destinazione sul valore TableReference desiderato. Trasferisci la configurazione del job al metodo query.Creare una tabella che fa riferimento a un'origine dati esterna

Un'origine dati esterna è un'origine dati in cui puoi eseguire query direttamente da BigQuery, anche se i dati non vengono archiviati in BigQuery. Ad esempio, potresti avere dati in un database Google Cloud diverso, in file in Cloud Storage o in un prodotto cloud diverso che vorresti analizzare in BigQuery, ma non avere ancora la possibilità di eseguire una migrazione.

Per saperne di più, consulta Introduzione alle origini dati esterne.

Creare una tabella durante il caricamento dei dati

Quando carichi i dati in BigQuery, puoi caricarli in una nuova tabella o partizione, puoi aggiungere dati a una tabella o partizione esistente oppure puoi sovrascrivere una tabella o una partizione. Non è necessario creare una tabella vuota prima di caricarvi i dati. Puoi creare la nuova tabella e caricare i dati contemporaneamente.

Quando carichi i dati in BigQuery, puoi fornire lo schema della tabella o della partizione oppure, per i formati di dati supportati, puoi utilizzare il rilevamento automatico dello schema.

Per ulteriori informazioni sul caricamento dei dati, vedi Caricare i dati in BigQuery.

Controllare l'accesso alle tabelle

Per configurare l'accesso a tabelle e viste, puoi concedere un ruolo IAM a un'entità ai seguenti livelli, elencati in ordine di intervallo di risorse consentite (dalla più grande alla più piccola):

- un livello elevato nella Google Cloud gerarchia delle risorse, ad esempio il livello di progetto, cartella o organizzazione

- il livello del set di dati

- a livello di tabella o visualizzazione

Puoi anche limitare l'accesso ai dati all'interno delle tabelle utilizzando i seguenti metodi:

L'accesso a qualsiasi risorsa protetta da IAM è cumulativo. Ad esempio, se un'entità non ha accesso a un livello elevato, ad esempio un progetto, puoi concederle l'accesso a livello di set di dati, in modo che possa accedere alle tabelle e alle viste nel set di dati. Allo stesso modo, se l'entità non ha accesso a livello di progetto o di set di dati, puoi concederle l'accesso a livello di tabella o vista.

La concessione di ruoli IAM a un livello superiore nella Google Cloud gerarchia delle risorse come il progetto, la cartella o il livello di organizzazione consente all'entità di accedere a un ampio insieme di risorse. Ad esempio, la concessione di un ruolo a un'entità a livello di progetto conferisce a questa entità autorizzazioni che si applicano a tutti i set di dati del progetto.

L'assegnazione di un ruolo a livello di set di dati specifica le operazioni che un'entità è autorizzata a eseguire su tabelle e viste in quel set di dati specifico, anche se l'entità non ha accesso a un livello superiore. Per informazioni sulla configurazione dei controlli dell'accesso a livello di set di dati, consulta Controllare l'accesso ai set di dati.

La concessione di un ruolo a livello di tabella o vista specifica le operazioni che un'entità è autorizzata a eseguire su tabelle e viste specifiche, anche se l'entità non ha accesso a un livello superiore. Per informazioni sulla configurazione dei controlli dell'accesso a livello di tabella, consulta Controllo dell'accesso a tabelle e viste.

Puoi anche creare ruoli personalizzati IAM. Se crei un ruolo personalizzato, le autorizzazioni che concedi dipendono dalle operazioni specifiche che vuoi che l'entità sia in grado di eseguire.

Non puoi impostare un'autorizzazione "Nega" su qualsiasi risorsa protetta da IAM.

Per saperne di più su ruoli e autorizzazioni, consulta Informazioni sui ruoli nella documentazione IAM e Ruoli e autorizzazioni IAM di BigQuery.

Ottenere informazioni sulle tabelle

Puoi ottenere informazioni o metadati sulle tabelle nei seguenti modi:

- Utilizzo della console Google Cloud .

- Utilizzo dello strumento a riga di comando bq

comando

bq show. - Chiamata del metodo API

tables.get. - Utilizzo delle librerie client.

- Query della vista

INFORMATION_SCHEMA.VIEWS.

Autorizzazioni obbligatorie

Come minimo, per ottenere informazioni sulle tabelle, devi disporre delle autorizzazioni

bigquery.tables.get. I seguenti ruoli IAM predefiniti includono le autorizzazioni bigquery.tables.get:

bigquery.metadataViewerbigquery.dataViewerbigquery.dataOwnerbigquery.dataEditorbigquery.admin

Inoltre, se un utente dispone delle autorizzazioni bigquery.datasets.create, quando crea un set di dati, gli viene concesso l'accesso bigquery.dataOwner.

L'accesso bigquery.dataOwner consente all'utente di recuperare i metadati della tabella.

Per saperne di più su ruoli e autorizzazioni IAM in BigQuery, consulta Controllo dell'accesso.

Recuperare informazioni sulla tabella

Per visualizzare informazioni sulle tabelle:

Console

Nel pannello di navigazione, nella sezione Risorse, espandi il progetto e seleziona un set di dati.

Fai clic sul nome del set di dati per espanderlo. Vengono visualizzate le tabelle e le visualizzazioni nel set di dati.

Fai clic sul nome della tabella.

Nel riquadro Dettagli, fai clic su Dettagli per visualizzare la descrizione e le informazioni della tabella.

Se vuoi, passa alla scheda Schema per visualizzare la definizione dello schema della tabella.

bq

-

In the Google Cloud console, activate Cloud Shell.

At the bottom of the Google Cloud console, a Cloud Shell session starts and displays a command-line prompt. Cloud Shell is a shell environment with the Google Cloud CLI already installed and with values already set for your current project. It can take a few seconds for the session to initialize.

Esegui il comando

bq showper visualizzare tutte le informazioni della tabella. Utilizza il flag--schemaper visualizzare solo le informazioni sullo schema della tabella. Il flag--formatpuò essere utilizzato per controllare l'output.Se stai recuperando informazioni su una tabella in un progetto diverso da quello predefinito, aggiungi l'ID progetto al set di dati nel seguente formato:

project_id:dataset.bq show \ --schema \ --format=prettyjson \ project_id:dataset.table

Dove:

- project_id è l'ID progetto.

- dataset è il nome del set di dati.

- table è il nome della tabella.

Esempi:

Inserisci il seguente comando per visualizzare tutte le informazioni su

mytableinmydataset.mydatasetsi trova nel tuo progetto predefinito.bq show --format=prettyjson mydataset.mytable

Inserisci il seguente comando per visualizzare tutte le informazioni su

mytableinmydataset.mydatasetsi trova inmyotherproject, non nel tuo progetto predefinito.bq show --format=prettyjson myotherproject:mydataset.mytable

Inserisci il seguente comando per visualizzare solo le informazioni sullo schema relative a

mytableinmydataset.mydatasetsi trova inmyotherproject, non nel tuo progetto predefinito.bq show --schema --format=prettyjson myotherproject:mydataset.mytable

API

Chiama il metodo tables.get e fornisci eventuali parametri pertinenti.

Vai

Prima di provare questo esempio, segui le istruzioni di configurazione di Go nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Go.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Java

Prima di provare questo esempio, segui le istruzioni di configurazione di Java nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Java.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Node.js

Prima di provare questo esempio, segui le istruzioni di configurazione di Node.js nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Node.js.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

PHP

Prima di provare questo esempio, segui le istruzioni di configurazione di PHP nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery PHP.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Python

Prima di provare questo esempio, segui le istruzioni di configurazione di Python nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Python.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Recuperare le informazioni sulla tabella utilizzando INFORMATION_SCHEMA

INFORMATION_SCHEMA è una serie di viste che forniscono l'accesso ai metadati

relativi a set di dati, routine, tabelle, viste, job, prenotazioni e dati di streaming.

Puoi eseguire query sulle seguenti viste per ottenere informazioni sulle tabelle:

- Utilizza le visualizzazioni

INFORMATION_SCHEMA.TABLESeINFORMATION_SCHEMA.TABLE_OPTIONSper recuperare i metadati relativi a tabelle e visualizzazioni in un progetto. - Utilizza le visualizzazioni

INFORMATION_SCHEMA.COLUMNSeINFORMATION_SCHEMA.COLUMN_FIELD_PATHSper recuperare i metadati relativi alle colonne (campi) di una tabella. - Utilizza le visualizzazioni

INFORMATION_SCHEMA.TABLE_STORAGEper recuperare i metadati relativi all'utilizzo attuale e storico dello spazio di archiviazione da parte di una tabella.

Le visualizzazioni TABLES e TABLE_OPTIONS contengono anche informazioni di alto livello sulle visualizzazioni. Per informazioni dettagliate, esegui una query sulla vista

INFORMATION_SCHEMA.VIEWS.

TABLES visualizzazione

Quando esegui una query sulla vista INFORMATION_SCHEMA.TABLES, i risultati della query contengono

una riga per ogni tabella o vista in un set di dati. Per informazioni dettagliate sulle visualizzazioni, esegui una query sulla visualizzazione INFORMATION_SCHEMA.VIEWS.

La vista INFORMATION_SCHEMA.TABLES ha lo schema seguente:

| Nome colonna | Tipo di dati | Valore |

|---|---|---|

table_catalog |

STRING |

L'ID progetto del progetto che contiene il set di dati. |

table_schema |

STRING |

Il nome del set di dati che contiene la tabella o la visualizzazione. Chiamato anche

datasetId. |

table_name |

STRING |

Il nome della tabella o della visualizzazione. Chiamato anche

tableId. |

table_type |

STRING |

Il tipo di tabella; uno dei seguenti:

|

managed_table_type |

STRING |

Questa colonna è in anteprima. Il tipo di tabella gestita; uno dei seguenti:

|

is_insertable_into |

STRING |

YES o NO a seconda che la tabella

supporti le istruzioni

DML INSERT |

is_fine_grained_mutations_enabled |

STRING |

YES o NO a seconda che

le mutazioni DML granulari

siano attive nella tabella

|

is_typed |

STRING |

Il valore è sempre NO |

is_change_history_enabled |

STRING |

YES o NO a seconda che la

cronologia delle modifiche

sia attivata |

creation_time |

TIMESTAMP |

L'ora di creazione della tabella |

base_table_catalog |

STRING |

Per i cloni di tabelle

e gli snapshot delle tabelle,

il progetto della tabella di base. Applicabile solo alle

tabelle con table_type impostato su CLONE o

SNAPSHOT.

|

base_table_schema |

STRING |

Per i cloni di tabelle

e le istantanee delle tabelle,

il set di dati della tabella di base. Applicabile solo alle tabelle con

table_type impostato su CLONE o

SNAPSHOT. |

base_table_name |

STRING |

Per i cloni di tabelle

e le istantanee delle tabelle,

il nome della tabella di base. Applicabile solo alle tabelle con

table_type impostato su CLONE o

SNAPSHOT. |

snapshot_time_ms |

TIMESTAMP |

Per i cloni di tabelle

e gli snapshot di tabelle,

l'ora in cui è stata eseguita l'operazione di clonazione

o di snapshot

sulla tabella di base per creare questa tabella. Se è stato utilizzato lo spostamento nel tempo, questo campo contiene il timestamp dello spostamento nel tempo. In caso contrario, il

campo snapshot_time_ms è uguale al

campo creation_time. Applicabile solo alle

tabelle con table_type impostato su CLONE o

SNAPSHOT.

|

replica_source_catalog |

STRING |

Per le repliche delle viste materializzate, il progetto della vista materializzata di base. |

replica_source_schema |

STRING |

Per le repliche della vista materializzata, il set di dati della vista materializzata di base. |

replica_source_name |

STRING |

Per le repliche della vista materializzata, il nome della vista materializzata di base. |

replication_status |

STRING |

Per le

repliche della vista materializzata,

lo stato della replica dalla vista materializzata di base alla

replica della vista materializzata; uno dei seguenti:

|

replication_error |

STRING |

Se replication_status indica un problema di replica per una

replica della vista materializzata,

replication_error fornisce ulteriori dettagli sul problema. |

ddl |

STRING |

L'istruzione DDL

che può essere utilizzata per ricreare la tabella, ad esempio

CREATE TABLE

o CREATE VIEW |

default_collation_name |

STRING |

Il nome della specifica di regole di confronto predefinita

se esiste; altrimenti, NULL.

|

upsert_stream_apply_watermark |

TIMESTAMP |

Per le tabelle che utilizzano Change Data Capture (CDC), l'ora in cui sono state applicate le ultime modifiche alle righe. Per saperne di più, consulta Monitorare l'avanzamento dell'operazione di upsert della tabella. |

Esempi

Esempio 1:

L'esempio seguente recupera i metadati della tabella per tutte le tabelle nel set di dati denominato mydataset. I metadati restituiti riguardano tutti i tipi di tabelle in mydataset nel tuo progetto predefinito.

mydataset contiene le seguenti tabelle:

mytable1: una tabella BigQuery standardmyview1: una vista BigQuery

Per eseguire la query su un progetto diverso da quello predefinito, aggiungi l'ID progetto al set di dati nel seguente formato:

`project_id`.dataset.INFORMATION_SCHEMA.view;

ad esempio, `myproject`.mydataset.INFORMATION_SCHEMA.TABLES.

SELECT table_catalog, table_schema, table_name, table_type, is_insertable_into, creation_time, ddl FROM mydataset.INFORMATION_SCHEMA.TABLES;

Il risultato è simile al seguente. Per facilitare la lettura, alcune colonne sono escluse dal risultato.

+----------------+---------------+----------------+------------+--------------------+---------------------+---------------------------------------------+ | table_catalog | table_schema | table_name | table_type | is_insertable_into | creation_time | ddl | +----------------+---------------+----------------+------------+--------------------+---------------------+---------------------------------------------+ | myproject | mydataset | mytable1 | BASE TABLE | YES | 2018-10-29 20:34:44 | CREATE TABLE `myproject.mydataset.mytable1` | | | | | | | | ( | | | | | | | | id INT64 | | | | | | | | ); | | myproject | mydataset | myview1 | VIEW | NO | 2018-12-29 00:19:20 | CREATE VIEW `myproject.mydataset.myview1` | | | | | | | | AS SELECT 100 as id; | +----------------+---------------+----------------+------------+--------------------+---------------------+---------------------------------------------+

Esempio 2:

L'esempio seguente recupera i metadati della tabella per tutte le tabelle di tipo CLONE

o SNAPSHOT dalla visualizzazione INFORMATION_SCHEMA.TABLES. I metadati restituiti

riguardano le tabelle in mydataset nel tuo progetto predefinito.

Per eseguire la query su un progetto diverso da quello predefinito, aggiungi l'ID progetto al set di dati nel seguente formato:

`project_id`.dataset.INFORMATION_SCHEMA.view;

ad esempio, `myproject`.mydataset.INFORMATION_SCHEMA.TABLES.

SELECT table_name, table_type, base_table_catalog, base_table_schema, base_table_name, snapshot_time_ms FROM mydataset.INFORMATION_SCHEMA.TABLES WHERE table_type = 'CLONE' OR table_type = 'SNAPSHOT';

Il risultato è simile al seguente. Per facilitare la lettura, alcune colonne sono escluse dal risultato.

+--------------+------------+--------------------+-------------------+-----------------+---------------------+ | table_name | table_type | base_table_catalog | base_table_schema | base_table_name | snapshot_time_ms | +--------------+------------+--------------------+-------------------+-----------------+---------------------+ | items_clone | CLONE | myproject | mydataset | items | 2018-10-31 22:40:05 | | orders_bk | SNAPSHOT | myproject | mydataset | orders | 2018-11-01 08:22:39 | +--------------+------------+--------------------+-------------------+-----------------+---------------------+

Esempio 3:

L'esempio seguente recupera le colonne table_name e ddl dalla visualizzazione INFORMATION_SCHEMA.TABLES

per la tabella population_by_zip_2010 nel

set di dati

census_bureau_usa. Questo set di dati fa parte del programma per i set di dati pubblici di BigQuery.

Poiché la tabella su cui stai eseguendo la query si trova in un altro progetto, aggiungi l'ID progetto al set di dati nel seguente formato:

`project_id`.dataset.INFORMATION_SCHEMA.view.

In questo esempio, il valore è

`bigquery-public-data`.census_bureau_usa.INFORMATION_SCHEMA.TABLES.

SELECT table_name, ddl FROM `bigquery-public-data`.census_bureau_usa.INFORMATION_SCHEMA.TABLES WHERE table_name = 'population_by_zip_2010';

Il risultato è simile al seguente:

+------------------------+----------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------+

| table_name | ddl |

+------------------------+----------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------+

| population_by_zip_2010 | CREATE TABLE `bigquery-public-data.census_bureau_usa.population_by_zip_2010` |

| | ( |

| | geo_id STRING OPTIONS(description="Geo code"), |

| | zipcode STRING NOT NULL OPTIONS(description="Five digit ZIP Code Tabulation Area Census Code"), |

| | population INT64 OPTIONS(description="The total count of the population for this segment."), |

| | minimum_age INT64 OPTIONS(description="The minimum age in the age range. If null, this indicates the row as a total for male, female, or overall population."), |

| | maximum_age INT64 OPTIONS(description="The maximum age in the age range. If null, this indicates the row as having no maximum (such as 85 and over) or the row is a total of the male, female, or overall population."), |

| | gender STRING OPTIONS(description="male or female. If empty, the row is a total population summary.") |

| | ) |

| | OPTIONS( |

| | labels=[("freebqcovid", "")] |

| | ); |

+------------------------+----------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------+

TABLE_OPTIONS visualizzazione

Quando esegui una query sulla visualizzazione INFORMATION_SCHEMA.TABLE_OPTIONS, i risultati della query

contengono una riga per ogni opzione, per ogni tabella o visualizzazione in un set di dati. Per

informazioni dettagliate

sulle visualizzazioni, esegui una query

sulla visualizzazione

INFORMATION_SCHEMA.VIEWS.

La vista INFORMATION_SCHEMA.TABLE_OPTIONS ha lo schema seguente:

| Nome colonna | Tipo di dati | Valore |

|---|---|---|

TABLE_CATALOG |

STRING |

L'ID del progetto contenente il set di dati |

TABLE_SCHEMA |

STRING |

Il nome del set di dati che contiene la tabella o la vista a cui si fa riferimento anche

come datasetId |

TABLE_NAME |

STRING |

Il nome della tabella o della visualizzazione, indicato anche come tableId |

OPTION_NAME |

STRING |

Uno dei valori del nome nella tabella delle opzioni |

OPTION_TYPE |

STRING |

Uno dei valori del tipo di dati nella tabella delle opzioni |

OPTION_VALUE |

STRING |

Una delle opzioni di valore nella tabella delle opzioni |

Tabella delle opzioni

|

|

|

|---|---|---|

|

|

Una descrizione della tabella. |

|

|

Se l'aggiornamento automatico è abilitato per una vista materializzata |

|

|

L'ora in cui questa tabella scade |

|

|

Il nome descrittivo della tabella |

|

|

Il nome della chiave Cloud KMS utilizzata per criptare la tabella |

|

|

Un array di STRUCT che rappresentano le etichette nella

tabella |

|

|

Il livello massimo di obsolescenza della tabella configurata per BigQuery upsert CDC (Change Data Capture) |

|

|

La durata predefinita, in giorni, di tutte le partizioni in una tabella partizionata |

|

|

La frequenza con cui viene aggiornata una vista materializzata |

|

|

Indica se le query sulla tabella richiedono un filtro di partizionamento. |

|

|

Tag collegati a una tabella in una sintassi <chiave, valore> con spazio dei nomi. Per ulteriori informazioni, vedi Tag e accesso condizionale. |

Per le tabelle esterne, sono possibili le seguenti opzioni:

| Opzioni | |

|---|---|

allow_jagged_rows |

Se Si applica ai dati CSV. |

allow_quoted_newlines |

Se Si applica ai dati CSV. |

bigtable_options |

Obbligatorio solo durante la creazione di una tabella esterna Bigtable. Specifica lo schema della tabella esterna Bigtable in formato JSON. Per un elenco delle opzioni di definizione delle tabelle Bigtable, consulta

|

column_name_character_map |

Definisce l'ambito dei caratteri supportati per i nomi colonna e la modalità di gestione dei caratteri non supportati. L'impostazione predefinita è

I valori supportati includono:

Si applica ai dati CSV e Parquet. |

compression |

Il tipo di compressione dell'origine dati. I valori supportati includono:

Si applica ai dati CSV e JSON. |

decimal_target_types |

Determina come convertire un tipo Esempio: |

description |

Una descrizione di questa tabella. |

enable_list_inference |

Se Si applica ai dati Parquet. |

enable_logical_types |

Se Si applica ai dati Avro. |

encoding |

La codifica dei caratteri dei dati. I valori supportati includono:

Si applica ai dati CSV. |

enum_as_string |

Se Si applica ai dati Parquet. |

expiration_timestamp |

L'ora in cui questa tabella scade. Se non specificato, la tabella non scade. Esempio: |

field_delimiter |

Il separatore dei campi in un file CSV. Si applica ai dati CSV. |

format |

Il formato dei dati esterni.

I valori supportati per

Valori supportati per

Il valore |

hive_partition_uri_prefix |

Un prefisso comune per tutti gli URI di origine prima dell'inizio della codifica della chiave di partizione. Si applica solo alle tabelle esterne partizionate in Hive. Si applica ai dati Avro, CSV, JSON, Parquet e ORC. Esempio: |

file_set_spec_type |

Specifica come interpretare gli URI di origine per i job di caricamento e le tabelle esterne. I valori supportati includono:

Ad esempio, se hai un URI di origine |

ignore_unknown_values |

Se Si applica ai dati CSV e JSON. |

json_extension |

Per i dati JSON, indica un particolare formato di scambio JSON. Se non specificato, BigQuery legge i dati come record JSON generici. I valori supportati includono: |

max_bad_records |

Il numero massimo di record non validi da ignorare durante la lettura dei dati. Si applica a: dati CSV, JSON e Fogli Google. |

max_staleness |

Applicabile a tabelle BigLake e tabelle degli oggetti. Specifica se i metadati memorizzati nella cache vengono utilizzati dalle operazioni sulla tabella e quanto devono essere aggiornati i metadati memorizzati nella cache affinché l'operazione possa utilizzarli. Per disattivare la memorizzazione nella cache dei metadati, specifica 0. Questa è l'impostazione predefinita. Per attivare la memorizzazione nella cache dei metadati, specifica un valore

letterale di intervallo

compreso tra 30 minuti e 7 giorni. Ad esempio, specifica

|

null_marker |

La stringa che rappresenta i valori Si applica ai dati CSV. |

null_markers |

L'elenco di stringhe che rappresentano i valori di Questa opzione non può essere utilizzata con l'opzione Si applica ai dati CSV. |

object_metadata |

Obbligatorio solo quando viene creata una tabella degli oggetti. Imposta il valore di questa opzione su |

preserve_ascii_control_characters |

Se Si applica ai dati CSV. |

projection_fields |

Un elenco di proprietà dell'entità da caricare. Si applica ai dati Datastore. |

quote |

La stringa utilizzata per citare le sezioni di dati in un file CSV. Se i dati

contengono caratteri di nuova riga tra virgolette, imposta anche la

proprietà Si applica ai dati CSV. |

reference_file_schema_uri |

File di riferimento fornito dall'utente con lo schema della tabella. Si applica ai dati Parquet/ORC/AVRO. Esempio: |

require_hive_partition_filter |

Se Si applica ai dati Avro, CSV, JSON, Parquet e ORC. |

sheet_range |

Intervallo di un foglio di lavoro Google Sheets da cui eseguire la query. Si applica ai dati di Fogli Google. Esempio: |

skip_leading_rows |

Il numero di righe all'inizio di un file da saltare durante la lettura dei dati. Si applica ai dati CSV e Fogli Google. |

source_column_match |

Controlla la strategia utilizzata per abbinare le colonne caricate allo schema. Se questo valore non è specificato, il valore predefinito dipende da come viene fornito lo schema. Se il rilevamento automatico è abilitato, il comportamento predefinito è di abbinare le colonne per nome. In caso contrario, per impostazione predefinita le colonne vengono abbinate in base alla posizione. Questa operazione viene eseguita per mantenere la compatibilità con le versioni precedenti. I valori supportati includono:

|

tags |

<ARRAY<STRUCT<STRING, STRING>>>

Un array di tag IAM per la tabella, espressi come coppie chiave-valore. La chiave deve essere il nome della chiave con spazio dei nomi e il valore deve essere il nome breve. |

time_zone |

Fuso orario predefinito che verrà applicato durante l'analisi dei valori timestamp che non hanno un fuso orario specifico. Controlla i nomi dei fusi orari validi. Se questo valore non è presente, i valori timestamp senza un fuso orario specifico vengono analizzati utilizzando il fuso orario UTC predefinito. Si applica ai dati CSV e JSON. |

date_format |

Elementi di formato

che definiscono come vengono formattati i valori DATE nei file di input (ad esempio, Se questo valore è presente, questo formato è l'unico formato DATE compatibile. La rilevamento automatico dello schema determinerà anche il tipo di colonna DATE in base a questo formato anziché a quello esistente. Se questo valore non è presente, il campo DATE viene analizzato con i formati predefiniti. Si applica ai dati CSV e JSON. |

datetime_format |

Elementi di formato

che definiscono come vengono formattati i valori DATETIME nei file di input

(ad esempio, Se questo valore è presente, questo formato è l'unico DATETIME compatibile. Il rilevamento automatico dello schema determinerà anche il tipo di colonna DATETIME in base a questo formato anziché al formato esistente. Se questo valore non è presente, il campo DATETIME viene analizzato con i formati predefiniti. Si applica ai dati CSV e JSON. |

time_format |

Elementi di formato

che definiscono come vengono formattati i valori TIME nei file di input (ad esempio, Se questo valore è presente, questo formato è l'unico formato TIME compatibile. Il rilevamento automatico dello schema determinerà anche il tipo di colonna TIME in base a questo formato anziché a quello esistente. Se questo valore non è presente, il campo TIME viene analizzato con i formati predefiniti. Si applica ai dati CSV e JSON. |

timestamp_format |

Elementi di formato

che definiscono come vengono formattati i valori TIMESTAMP nei file di input

(ad esempio, Se questo valore è presente, questo formato è l'unico formato TIMESTAMP compatibile. Il rilevamento automatico dello schema determinerà anche il tipo di colonna TIMESTAMP in base a questo formato anziché al formato esistente. Se questo valore non è presente, il campo TIMESTAMP viene analizzato con i formati predefiniti. Si applica ai dati CSV e JSON. |

uris |

Per le tabelle esterne, incluse le tabelle di oggetti, che non sono tabelle Bigtable:

Un array di URI completi per le posizioni dei dati esterni.

Ogni URI può contenere un

asterisco ( I seguenti esempi mostrano valori

Per le tabelle Bigtable:

L'URI che identifica la tabella Bigtable da utilizzare come origine dati. Puoi specificare un solo URI Bigtable. Esempio:

Per saperne di più sulla creazione di un URI Bigtable, consulta Recuperare l'URI Bigtable. |

Esempi

Esempio 1:

L'esempio seguente recupera i tempi di scadenza predefiniti delle tabelle per tutte le

tabelle in mydataset nel tuo progetto predefinito (myproject) eseguendo una query sulla

visualizzazione INFORMATION_SCHEMA.TABLE_OPTIONS.

Per eseguire la query su un progetto diverso da quello predefinito, aggiungi l'ID progetto al set di dati nel seguente formato:

`project_id`.dataset.INFORMATION_SCHEMA.view;

ad esempio, `myproject`.mydataset.INFORMATION_SCHEMA.TABLE_OPTIONS.

SELECT * FROM mydataset.INFORMATION_SCHEMA.TABLE_OPTIONS WHERE option_name = 'expiration_timestamp';

Il risultato è simile al seguente:

+----------------+---------------+------------+----------------------+-------------+--------------------------------------+ | table_catalog | table_schema | table_name | option_name | option_type | option_value | +----------------+---------------+------------+----------------------+-------------+--------------------------------------+ | myproject | mydataset | mytable1 | expiration_timestamp | TIMESTAMP | TIMESTAMP "2020-01-16T21:12:28.000Z" | | myproject | mydataset | mytable2 | expiration_timestamp | TIMESTAMP | TIMESTAMP "2021-01-01T21:12:28.000Z" | +----------------+---------------+------------+----------------------+-------------+--------------------------------------+

Esempio 2:

L'esempio seguente recupera i metadati di tutte le tabelle in mydataset che

contengono dati di test. La query utilizza i valori nell'opzione description per trovare

tabelle che contengono "test" in qualsiasi punto della descrizione. mydataset si trova nel tuo

progetto predefinito: myproject.

Per eseguire la query su un progetto diverso da quello predefinito, aggiungi l'ID progetto al set di dati nel seguente formato:

`project_id`.dataset.INFORMATION_SCHEMA.view;

ad esempio,

`myproject`.mydataset.INFORMATION_SCHEMA.TABLE_OPTIONS.

SELECT * FROM mydataset.INFORMATION_SCHEMA.TABLE_OPTIONS WHERE option_name = 'description' AND option_value LIKE '%test%';

Il risultato è simile al seguente:

+----------------+---------------+------------+-------------+-------------+--------------+ | table_catalog | table_schema | table_name | option_name | option_type | option_value | +----------------+---------------+------------+-------------+-------------+--------------+ | myproject | mydataset | mytable1 | description | STRING | "test data" | | myproject | mydataset | mytable2 | description | STRING | "test data" | +----------------+---------------+------------+-------------+-------------+--------------+

COLUMNS visualizzazione

Quando esegui una query sulla visualizzazione INFORMATION_SCHEMA.COLUMNS, i risultati della query contengono

una riga per ogni colonna (campo) di una tabella.

La vista INFORMATION_SCHEMA.COLUMNS ha lo schema seguente:

| Nome colonna | Tipo di dati | Valore |

|---|---|---|

TABLE_CATALOG |

STRING |

L'ID del progetto contenente il set di dati |

TABLE_SCHEMA |

STRING |

Il nome del set di dati che contiene la tabella, noto anche come

datasetId |

TABLE_NAME |

STRING |

Il nome della tabella o della visualizzazione, indicato anche come tableId |

COLUMN_NAME |

STRING |

Il nome della colonna |

ORDINAL_POSITION |

INT64 |

L'offset in base 1 della colonna all'interno della tabella. Se si tratta di una pseudo

colonna come _PARTITIONTIME o _PARTITIONDATE, il valore è

NULL |

IS_NULLABLE |

STRING |

YES o NO a seconda che la modalità della colonna

consenta valori NULL |

DATA_TYPE |

STRING |

Il tipo di dati GoogleSQL della colonna |

IS_GENERATED |

STRING |

Il valore è sempre NEVER |

GENERATION_EXPRESSION |

STRING |

Il valore è sempre NULL |

IS_STORED |

STRING |

Il valore è sempre NULL |

IS_HIDDEN |

STRING |

YES o NO a seconda che la colonna sia

una pseudocolonna come _PARTITIONTIME o _PARTITIONDATE |

IS_UPDATABLE |

STRING |

Il valore è sempre NULL |

IS_SYSTEM_DEFINED |

STRING |

YES o NO a seconda che la colonna sia

una pseudocolonna come _PARTITIONTIME o _PARTITIONDATE |

IS_PARTITIONING_COLUMN |

STRING |

YES o NO a seconda che la colonna sia

una colonna di partizionamento |

CLUSTERING_ORDINAL_POSITION |

INT64 |

L'offset in base 1 della colonna all'interno delle colonne di clustering della tabella; il valore è NULL se la tabella non è una tabella di clustering |

COLLATION_NAME |

STRING |

Il nome della specifica di confronto

se esiste; altrimenti, NULLSe viene passato un STRING o un ARRAY<STRING>, la specifica di confronto viene restituita se esiste; altrimenti

viene restituito NULL

|

COLUMN_DEFAULT |

STRING |

Il valore predefinito della

colonna, se esiste; altrimenti, il valore è NULL

|

ROUNDING_MODE |

STRING |

La modalità di arrotondamento utilizzata per i valori scritti nel campo se il relativo

tipo è NUMERIC o BIGNUMERIC parametrizzato;

in caso contrario, il valore è NULL

|

POLICY_TAGS |

ARRAY<STRING> |

L'elenco dei tag delle norme allegati alla colonna |

Esempi

L'esempio seguente recupera i metadati dalla visualizzazione INFORMATION_SCHEMA.COLUMNS per la tabella population_by_zip_2010 nel set di dati census_bureau_usa. Questo set di dati fa parte del programma per i set di dati pubblici di BigQuery.

Poiché la tabella che stai interrogando si trova in un altro progetto, il progetto bigquery-public-data, aggiungi l'ID progetto al set di dati nel seguente formato: `project_id`.dataset.INFORMATION_SCHEMA.view; ad esempio, `bigquery-public-data`.census_bureau_usa.INFORMATION_SCHEMA.TABLES.

Le seguenti colonne sono escluse dai risultati della query perché sono attualmente riservate per un uso futuro:

IS_GENERATEDGENERATION_EXPRESSIONIS_STOREDIS_UPDATABLE

SELECT * EXCEPT(is_generated, generation_expression, is_stored, is_updatable) FROM `bigquery-public-data`.census_bureau_usa.INFORMATION_SCHEMA.COLUMNS WHERE table_name = 'population_by_zip_2010';

Il risultato è simile al seguente. Per facilitare la lettura, alcune colonne sono escluse dal risultato.

+------------------------+-------------+------------------+-------------+-----------+-----------+-------------------+------------------------+-----------------------------+-------------+ | table_name | column_name | ordinal_position | is_nullable | data_type | is_hidden | is_system_defined | is_partitioning_column | clustering_ordinal_position | policy_tags | +------------------------+-------------+------------------+-------------+-----------+-----------+-------------------+------------------------+-----------------------------+-------------+ | population_by_zip_2010 | zipcode | 1 | NO | STRING | NO | NO | NO | NULL | 0 rows | | population_by_zip_2010 | geo_id | 2 | YES | STRING | NO | NO | NO | NULL | 0 rows | | population_by_zip_2010 | minimum_age | 3 | YES | INT64 | NO | NO | NO | NULL | 0 rows | | population_by_zip_2010 | maximum_age | 4 | YES | INT64 | NO | NO | NO | NULL | 0 rows | | population_by_zip_2010 | gender | 5 | YES | STRING | NO | NO | NO | NULL | 0 rows | | population_by_zip_2010 | population | 6 | YES | INT64 | NO | NO | NO | NULL | 0 rows | +------------------------+-------------+------------------+-------------+-----------+-----------+-------------------+------------------------+-----------------------------+-------------+

COLUMN_FIELD_PATHS visualizzazione

Quando esegui una query sulla visualizzazione INFORMATION_SCHEMA.COLUMN_FIELD_PATHS, i risultati della query contengono una riga per ogni colonna nidificata all'interno di una colonna RECORD (o STRUCT).

La vista INFORMATION_SCHEMA.COLUMN_FIELD_PATHS ha lo schema seguente:

| Nome colonna | Tipo di dati | Valore |

|---|---|---|

TABLE_CATALOG |

STRING |

L'ID del progetto contenente il set di dati |

TABLE_SCHEMA |

STRING |

Il nome del set di dati che contiene la tabella, noto anche come

datasetId |

TABLE_NAME |

STRING |

Il nome della tabella o della visualizzazione, indicato anche come tableId |

COLUMN_NAME |

STRING |

Il nome della colonna |

FIELD_PATH |

STRING |

Il percorso di una colonna nidificata all'interno di una colonna `RECORD` o `STRUCT` |

DATA_TYPE |

STRING |

Il tipo di dati GoogleSQL della colonna |

DESCRIPTION |

STRING |

La descrizione della colonna |

COLLATION_NAME |

STRING |

Il nome della specifica di confronto

se esiste; altrimenti, NULLSe viene passato un campo STRING, ARRAY<STRING> o

STRING in un STRUCT, la

specifica di confronto viene restituita se esiste; altrimenti,

viene restituito NULL

|

ROUNDING_MODE |

STRING |

La modalità di arrotondamento utilizzata quando si applicano precisione e scala ai valori

parametrizzati NUMERIC o BIGNUMERIC; altrimenti, il valore è NULL

|

POLICY_TAGS |

ARRAY<STRING> |

L'elenco dei tag delle norme allegati alla colonna |

Esempi

L'esempio seguente recupera i metadati dalla vista INFORMATION_SCHEMA.COLUMN_FIELD_PATHS per la tabella commits nel set di dati github_repos.

Questo set di dati fa parte del programma per i set di dati pubblici di BigQuery.

Poiché la tabella che stai interrogando si trova in un altro progetto, il progetto bigquery-public-data, aggiungi l'ID progetto al set di dati nel seguente formato: `project_id`.dataset.INFORMATION_SCHEMA.view; ad esempio, `bigquery-public-data`.github_repos.INFORMATION_SCHEMA.COLUMN_FIELD_PATHS.

La tabella commits contiene le seguenti colonne nidificate e ripetute:

author: colonna nidificataRECORDcommitter: colonna nidificataRECORDtrailer: colonnaRECORDnidificata e ripetutadifference: colonnaRECORDnidificata e ripetuta

Per visualizzare i metadati relativi alle colonne author e difference, esegui la seguente query.

SELECT * FROM `bigquery-public-data`.github_repos.INFORMATION_SCHEMA.COLUMN_FIELD_PATHS WHERE table_name = 'commits' AND (column_name = 'author' OR column_name = 'difference');

Il risultato è simile al seguente. Per facilitare la lettura, alcune colonne sono escluse dal risultato.

+------------+-------------+---------------------+-----------------------------------------------------------------------------------------------------------------------------------------------------+-------------+-------------+ | table_name | column_name | field_path | data_type | description | policy_tags | +------------+-------------+---------------------+-----------------------------------------------------------------------------------------------------------------------------------------------------+-------------+-------------+ | commits | author | author | STRUCT<name STRING, email STRING, time_sec INT64, tz_offset INT64, date TIMESTAMP> | NULL | 0 rows | | commits | author | author.name | STRING | NULL | 0 rows | | commits | author | author.email | STRING | NULL | 0 rows | | commits | author | author.time_sec | INT64 | NULL | 0 rows | | commits | author | author.tz_offset | INT64 | NULL | 0 rows | | commits | author | author.date | TIMESTAMP | NULL | 0 rows | | commits | difference | difference | ARRAY<STRUCT<old_mode INT64, new_mode INT64, old_path STRING, new_path STRING, old_sha1 STRING, new_sha1 STRING, old_repo STRING, new_repo STRING>> | NULL | 0 rows | | commits | difference | difference.old_mode | INT64 | NULL | 0 rows | | commits | difference | difference.new_mode | INT64 | NULL | 0 rows | | commits | difference | difference.old_path | STRING | NULL | 0 rows | | commits | difference | difference.new_path | STRING | NULL | 0 rows | | commits | difference | difference.old_sha1 | STRING | NULL | 0 rows | | commits | difference | difference.new_sha1 | STRING | NULL | 0 rows | | commits | difference | difference.old_repo | STRING | NULL | 0 rows | | commits | difference | difference.new_repo | STRING | NULL | 0 rows | +------------+-------------+---------------------+-----------------------------------------------------------------------------------------------------------------------------------------------------+-------------+-------------+

TABLE_STORAGE visualizzazione

Le viste TABLE_STORAGE e TABLE_STORAGE_BY_ORGANIZATION hanno lo schema seguente:

| Nome colonna | Tipo di dati | Valore |

|---|---|---|

PROJECT_ID |

STRING |

L'ID progetto del progetto che contiene il set di dati. |

PROJECT_NUMBER |

INT64 |

Il numero del progetto contenente il set di dati. |

TABLE_CATALOG |

STRING |

L'ID progetto del progetto che contiene il set di dati. |

TABLE_SCHEMA |

STRING |

Il nome del set di dati che contiene la tabella o la vista materializzata,

chiamato anche datasetId. |

TABLE_NAME |

STRING |

Il nome della tabella o della vista materializzata, chiamato anche

tableId. |

CREATION_TIME |

TIMESTAMP |

L'ora di creazione della tabella. |

TOTAL_ROWS |

INT64 |

Il numero totale di righe nella tabella o nella vista materializzata. |

TOTAL_PARTITIONS |

INT64 |

Il numero di partizioni presenti nella tabella o nella vista materializzata. Le tabelle non partizionate restituiscono 0. |

TOTAL_LOGICAL_BYTES |

INT64 |

Numero totale di byte logici (non compressi) nella tabella o nella vista materializzata. |

ACTIVE_LOGICAL_BYTES |

INT64 |

Numero di byte logici (non compressi) risalenti a meno di 90 giorni fa. |

LONG_TERM_LOGICAL_BYTES |

INT64 |

Numero di byte logici (non compressi) risalenti a più di 90 giorni fa. |

CURRENT_PHYSICAL_BYTES |

INT64 |

Numero totale di byte fisici per l'archiviazione attuale della tabella in tutte le partizioni. |

TOTAL_PHYSICAL_BYTES |

INT64 |

Numero totale di byte fisici (compressi) utilizzati per l'archiviazione, inclusi i byte attivi, a lungo termine e time travel (dati eliminati o modificati). I byte fail-safe (dati eliminati o modificati conservati dopo il periodo di time travel) non sono inclusi. |

ACTIVE_PHYSICAL_BYTES |

INT64 |

Numero di byte fisici (compressi) più recenti di 90 giorni, inclusi i byte con spostamento cronologico (dati eliminati o modificati). |

LONG_TERM_PHYSICAL_BYTES |

INT64 |

Numero di byte fisici (compressi) risalenti a più di 90 giorni fa. |

TIME_TRAVEL_PHYSICAL_BYTES |

INT64 |

Numero di byte fisici (compressi) utilizzati dallo spazio di archiviazione Time Travel (dati eliminati o modificati). |

STORAGE_LAST_MODIFIED_TIME |

TIMESTAMP |

L'ultima volta che i dati sono stati scritti nella tabella. |

DELETED |

BOOLEAN |

Indica se la tabella è stata eliminata o meno. |

TABLE_TYPE |

STRING |

Il tipo di tabella. Ad esempio, BASE TABLE.

|

MANAGED_TABLE_TYPE |

STRING |

Questa colonna è in anteprima. Il tipo gestito della tabella. Ad esempio,

NATIVE o BIGLAKE.

|

FAIL_SAFE_PHYSICAL_BYTES |

INT64 |

Numero di byte fisici (compressi) utilizzati dallo spazio di archiviazione fail-safe (dati eliminati o modificati). |

LAST_METADATA_INDEX_REFRESH_TIME |

TIMESTAMP |

L'ora dell'ultimo aggiornamento dell'indice dei metadati della tabella. |

TABLE_DELETION_REASON |

STRING |

Motivo dell'eliminazione della tabella se il campo DELETED è true. I valori possibili sono:

|

TABLE_DELETION_TIME |

TIMESTAMP |

L'ora di eliminazione della tabella. |

Esempi

Esempio 1:

Il seguente esempio mostra i byte logici totali fatturati per il progetto corrente.

SELECT SUM(total_logical_bytes) AS total_logical_bytes FROM `region-REGION`.INFORMATION_SCHEMA.TABLE_STORAGE;

Il risultato è simile al seguente:

+---------------------+ | total_logical_bytes | +---------------------+ | 971329178274633 | +---------------------+

Esempio 2:

L'esempio seguente mostra diversi byte di spazio di archiviazione in GiB a livello di set di dati per il progetto corrente.

SELECT table_schema AS dataset_name, -- Logical SUM(total_logical_bytes) / power(1024, 3) AS total_logical_gib, SUM(active_logical_bytes) / power(1024, 3) AS active_logical_gib, SUM(long_term_logical_bytes) / power(1024, 3) AS long_term_logical_gib, -- Physical SUM(total_physical_bytes) / power(1024, 3) AS total_physical_gib, SUM(active_physical_bytes) / power(1024, 3) AS active_physical_gib, SUM(active_physical_bytes - time_travel_physical_bytes) / power(1024, 3) AS active_no_tt_physical_gib, SUM(long_term_physical_bytes) / power(1024, 3) AS long_term_physical_gib, SUM(time_travel_physical_bytes) / power(1024, 3) AS time_travel_physical_gib, SUM(fail_safe_physical_bytes) / power(1024, 3) AS fail_safe_physical_gib FROM `region-REGION`.INFORMATION_SCHEMA.TABLE_STORAGE WHERE table_type ='BASE TABLE' GROUP BY table_schema ORDER BY dataset_name

Esempio 3:

Il seguente esempio mostra come prevedere la differenza di prezzo per dataset tra i modelli di fatturazione logica e fisica per i prossimi 30 giorni. Questo esempio presuppone che l'utilizzo futuro dello spazio di archiviazione sia costante nei 30 giorni successivi al momento dell'esecuzione della query. Tieni presente che la previsione è limitata alle tabelle di base ed esclude tutti gli altri tipi di tabelle all'interno di un set di dati.

I prezzi utilizzati nelle variabili di prezzo per questa query si riferiscono alla regione us-central1. Se vuoi eseguire questa query per una regione diversa,

aggiorna le variabili di prezzo in modo appropriato. Per informazioni sui prezzi, vedi

Prezzi di archiviazione.

Apri la pagina BigQuery nella console Google Cloud .

Inserisci la seguente query GoogleSQL nella casella Editor di query.