ML.TRANSCRIBE 함수를 사용하여 오디오 파일 텍스트 변환

이 문서에서는 원격 모델에서 ML.TRANSCRIBE 함수를 사용하여 객체 테이블에서 오디오 파일을 텍스트로 변환하는 방법을 설명합니다.

지원되는 위치

다음 위치 중 하나에서 이 절차에 사용되는 원격 모델을 만들어야 합니다.

asia-northeast1asia-south1asia-southeast1australia-southeast1eueurope-west1europe-west2europe-west3europe-west4northamerica-northeast1usus-central1us-east1us-east4us-west1

원격 모델과 같은 리전에서 ML.TRANSCRIBE 함수를 실행해야 합니다.

필요한 역할

원격 모델을 만들고 오디오 파일을 트랜스크립션하려면 프로젝트 수준에서 다음 Identity and Access Management (IAM) 역할이 필요합니다.

- 음성 인식기 만들기: Cloud Speech 편집자(

roles/speech.editor) - BigQuery 데이터 세트, 테이블, 모델 만들기 및 사용: BigQuery 데이터 편집자(

roles/bigquery.dataEditor) BigQuery 연결 생성, 위임, 사용: BigQuery 연결 관리자(

roles/bigquery.connectionsAdmin)구성된 기본 연결이 없는 경우

CREATE MODEL문을 실행하는 과정에서 연결을 만들고 설정할 수 있습니다. 이렇게 하려면 프로젝트에 BigQuery 관리자(roles/bigquery.admin)가 있어야 합니다. 자세한 내용은 기본 연결 구성을 참조하세요.연결의 서비스 계정에 권한 부여: 프로젝트 IAM 관리자(

roles/resourcemanager.projectIamAdmin)BigQuery 작업 만들기: BigQuery 작업 사용자(

roles/bigquery.jobUser)

이러한 사전 정의된 역할에는 이 문서의 작업을 수행하는 데 필요한 권한이 포함되어 있습니다. 필요한 정확한 권한을 보려면 필수 권한 섹션을 확장하세요.

필수 권한

- 데이터 세트 만들기:

bigquery.datasets.create - 연결을 만들고, 위임하고, 사용하기:

bigquery.connections.* - 서비스 계정 권한 설정:

resourcemanager.projects.getIamPolicy및resourcemanager.projects.setIamPolicy - 모델을 만들고 추론을 실행하기:

bigquery.jobs.createbigquery.models.createbigquery.models.getDatabigquery.models.updateDatabigquery.models.updateMetadata

- 객체 테이블 만들기:

bigquery.tables.create및bigquery.tables.update - 음성 인식기 만들기:

speech.recognizers.createspeech.recognizers.getspeech.recognizers.recognizespeech.recognizers.update

커스텀 역할이나 다른 사전 정의된 역할을 사용하여 이 권한을 부여받을 수도 있습니다.

시작하기 전에

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the BigQuery, BigQuery Connection API, and Speech-to-Text APIs.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. -

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the BigQuery, BigQuery Connection API, and Speech-to-Text APIs.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. Google Cloud 콘솔에서 BigQuery 페이지로 이동합니다.

왼쪽 창에서 탐색기를 클릭합니다.

왼쪽 창이 표시되지 않으면 왼쪽 창 펼치기를 클릭하여 창을 엽니다.

탐색기 창에서 프로젝트 이름을 클릭합니다.

작업 보기 > 데이터 세트 만들기를 클릭합니다.

데이터 세트 만들기 페이지에서 다음을 수행합니다.

데이터 세트 ID에 데이터 세트 이름을 입력합니다.

위치 유형으로 리전 또는 멀티 리전을 선택합니다.

- 리전을 선택한 경우 리전 목록에서 위치를 선택합니다.

- 멀티 리전을 선택한 경우 멀티 리전 목록에서 미국 또는 유럽을 선택합니다.

데이터 세트 만들기를 클릭합니다.

BigQuery 페이지로 이동합니다.

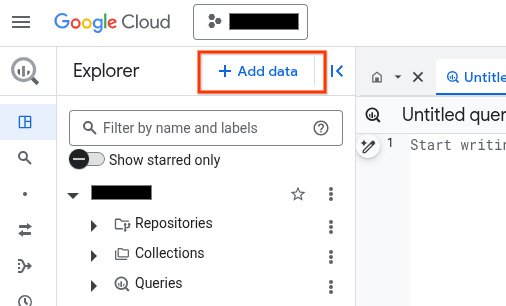

탐색기 창에서 데이터 추가를 클릭합니다.

데이터 추가 대화상자가 열립니다.

필터링 기준 창의 데이터 소스 유형 섹션에서 비즈니스 애플리케이션을 선택합니다.

또는 데이터 소스 검색 필드에

Vertex AI을 입력할 수 있습니다.추천 데이터 소스 섹션에서 Vertex AI를 클릭합니다.

Vertex AI 모델: BigQuery 제휴 솔루션 카드를 클릭합니다.

연결 유형 목록에서 Vertex AI 원격 모델, 원격 함수, BigLake, Spanner (Cloud 리소스)를 선택합니다.

연결 ID 필드에 연결 이름을 입력합니다.

연결 만들기를 클릭합니다.

연결로 이동을 클릭합니다.

연결 정보 창에서 나중의 단계에 사용할 서비스 계정 ID를 복사합니다.

명령줄 환경에서 연결을 만듭니다.

bq mk --connection --location=REGION --project_id=PROJECT_ID \ --connection_type=CLOUD_RESOURCE CONNECTION_ID

--project_id매개변수는 기본 프로젝트를 재정의합니다.다음을 바꿉니다.

REGION: 연결 리전PROJECT_ID: Google Cloud 프로젝트 IDCONNECTION_ID: 연결의 ID

연결 리소스를 만들면 BigQuery가 고유한 시스템 서비스 계정을 만들고 이를 연결에 연계합니다.

문제 해결: 다음 연결 오류가 발생하면 Google Cloud SDK를 업데이트하세요.

Flags parsing error: flag --connection_type=CLOUD_RESOURCE: value should be one of...

이후 단계에서 사용할 수 있도록 서비스 계정 ID를 가져와 복사합니다.

bq show --connection PROJECT_ID.REGION.CONNECTION_ID

출력은 다음과 유사합니다.

name properties 1234.REGION.CONNECTION_ID {"serviceAccountId": "connection-1234-9u56h9@gcp-sa-bigquery-condel.iam.gserviceaccount.com"}- Cloud Shell을 실행합니다.

-

Terraform 구성을 적용할 기본 Google Cloud 프로젝트를 설정합니다.

이 명령어는 프로젝트당 한 번만 실행하면 되며 어떤 디렉터리에서도 실행할 수 있습니다.

export GOOGLE_CLOUD_PROJECT=PROJECT_ID

Terraform 구성 파일에서 명시적 값을 설정하면 환경 변수가 재정의됩니다.

-

Cloud Shell에서 디렉터리를 만들고 해당 디렉터리 내에 새 파일을 만드세요. 파일 이름에는

.tf확장자가 있어야 합니다(예:main.tf). 이 튜토리얼에서는 파일을main.tf라고 합니다.mkdir DIRECTORY && cd DIRECTORY && touch main.tf

-

튜토리얼을 따라 하는 경우 각 섹션이나 단계에서 샘플 코드를 복사할 수 있습니다.

샘플 코드를 새로 만든

main.tf에 복사합니다.필요한 경우 GitHub에서 코드를 복사합니다. 이는 Terraform 스니펫이 엔드 투 엔드 솔루션의 일부인 경우에 권장됩니다.

- 환경에 적용할 샘플 파라미터를 검토하고 수정합니다.

- 변경사항을 저장합니다.

-

Terraform을 초기화합니다. 이 작업은 디렉터리당 한 번만 수행하면 됩니다.

terraform init

원하는 경우 최신 Google 공급업체 버전을 사용하려면

-upgrade옵션을 포함합니다.terraform init -upgrade

-

구성을 검토하고 Terraform에서 만들거나 업데이트할 리소스가 예상과 일치하는지 확인합니다.

terraform plan

필요에 따라 구성을 수정합니다.

-

다음 명령어를 실행하고 프롬프트에

yes를 입력하여 Terraform 구성을 적용합니다.terraform apply

Terraform에 '적용 완료' 메시지가 표시될 때까지 기다립니다.

- 결과를 보려면 Google Cloud 프로젝트를 엽니다. Google Cloud 콘솔에서 UI의 리소스로 이동하여 Terraform이 리소스를 만들었거나 업데이트했는지 확인합니다.

IAM 및 관리자 페이지로 이동합니다.

액세스 권한 부여를 클릭합니다.

주 구성원 추가 대화상자가 열립니다.

새 주 구성원 필드에 앞에서 복사한 서비스 계정 ID를 입력합니다.

역할 선택 필드를 클릭한 후 필터에

Cloud Speech Client를 입력합니다.다른 역할 추가를 클릭합니다.

역할 선택 필드에서 Cloud Storage를 선택한 후 스토리지 객체 뷰어를 선택합니다.

저장을 클릭합니다.

PROJECT_NUMBER: 프로젝트 번호MEMBER: 이전에 복사한 서비스 계정 ID입니다.PROJECT_ID: 프로젝트 IDDATASET_ID: 모델을 포함할 데이터 세트의 IDMODEL_NAME: 모델의 이름REGION: 연결에 사용되는 리전입니다.CONNECTION_ID: 연결 ID입니다(예:myconnection).Google Cloud 콘솔에서 연결 세부정보를 볼 때 연결 ID는 연결 ID에 표시되는 정규화된 연결 ID의 마지막 섹션에 있는 값입니다(예:

projects/myproject/locations/connection_location/connections/myconnection).PROJECT_NUMBER: 음성 인식기가 포함된 프로젝트의 프로젝트 번호입니다. Google Cloud 콘솔의 대시보드 페이지에 있는 프로젝트 정보 카드에서 이 값을 찾을 수 있습니다.LOCATION: 음성 인식기에서 사용하는 위치입니다. Google Cloud 콘솔의 인식기 나열 페이지에 있는 위치 필드에서 이 값을 찾을 수 있습니다.RECOGNIZER_ID: 음성 인식기 ID입니다. Google Cloud 콘솔의 인식기 나열 페이지에 있는 ID 필드에서 이 값을 찾을 수 있습니다.이 옵션은 필수가 아닙니다. 값을 지정하지 않으면 기본 인식기가 사용됩니다. 이 경우 기본 인식기에 구성을 제공하려면

ML.TRANSCRIBE함수의recognition_config파라미터 값을 지정해야 합니다.제공하는

recognition_config값에서만chirp스크립트 작성 모델을 사용할 수 있습니다.PROJECT_ID: 프로젝트 IDDATASET_ID: 모델이 포함된 데이터 세트의 IDMODEL_NAME: 모델의 이름OBJECT_TABLE_NAME: 처리할 오디오 파일의 URI가 포함된 객체 테이블의 이름recognition_config: JSON 형식의RecognitionConfig리소스인식기가

SPEECH_RECOGNIZER옵션을 사용하여 원격 모델에 지정된 경우recognition_config값을 지정할 수 없습니다.SPEECH_RECOGNIZER옵션을 사용하여 원격 모델에 인식기가 지정되지 않은 경우recognition_config값을 지정해야 합니다. 이 값은 기본 인식기에 구성을 제공하는 데 사용됩니다.제공하는

recognition_config값에서만chirp스크립트 작성 모델을 사용할 수 있습니다.- BigQuery ML의 모델 추론에 대한 자세한 내용은 모델 추론 개요를 참고하세요.

- Cloud AI API를 사용하여 AI 태스크를 수행하는 방법에 대한 자세한 내용은 AI 애플리케이션 개요를 참조하세요.

- 생성형 AI 모델에 지원되는 SQL 문과 함수에 대한 자세한 내용은 생성형 AI 모델의 엔드 투 엔드 사용자 경험을 참고하세요.

인식기 만들기

Speech-to-Text는 인식기라는 리소스를 지원합니다. 인식기는 저장되고 재사용 가능한 인식 구성을 나타냅니다. 인식기를 만들어 애플리케이션의 스크립트 작성 또는 트래픽을 논리적으로 그룹화할 수 있습니다.

음성 인식기를 만드는 것은 선택사항입니다. 음성 인식기를 만들 경우 SPEECH_RECOGNIZER에 설명된 대로 CREATE MODEL 문에서 사용할 인식기의 프로젝트 ID, 위치, 인식기 ID를 기록해 둡니다.

음성 인식기를 만들지 않도록 선택한 경우 ML.TRANSCRIBE 함수의 recognition_config 인수 값을 지정해야 합니다.

음성 인식기 또는 제공한 recognition_config 값에서만 chirp 스크립트 작성 모델을 사용할 수 있습니다.

데이터 세트 만들기

리소스를 포함할 BigQuery 데이터 세트를 만듭니다.

콘솔

bq

연결 만들기

기본 연결이 구성되어 있거나 BigQuery 관리자 역할이 있는 경우 이 단계를 건너뛸 수 있습니다.

원격 모델이 사용할 클라우드 리소스 연결을 만들고 연결의 서비스 계정을 가져옵니다. 이전 단계에서 만든 데이터 세트와 동일한 위치에 연결을 만듭니다.

다음 옵션 중 하나를 선택합니다.

콘솔

bq

Terraform

google_bigquery_connection 리소스를 사용합니다.

BigQuery에 인증하려면 애플리케이션 기본 사용자 인증 정보를 설정합니다. 자세한 내용은 클라이언트 라이브러리의 인증 설정을 참조하세요.

다음 예시에서는 US 리전에 my_cloud_resource_connection이라는 Cloud 리소스 연결을 만듭니다.

Google Cloud 프로젝트에 Terraform 구성을 적용하려면 다음 섹션의 단계를 완료하세요.

Cloud Shell 준비

디렉터리 준비

각 Terraform 구성 파일에는 자체 디렉터리(루트 모듈이라고도 함)가 있어야 합니다.

변경사항 적용

서비스 계정에 액세스 권한 부여

다음 옵션 중 하나를 선택합니다.

콘솔

gcloud

gcloud projects add-iam-policy-binding 명령어를 사용합니다.

gcloud projects add-iam-policy-binding 'PROJECT_NUMBER' --member='serviceAccount:MEMBER' --role='roles/speech.client' --condition=None gcloud projects add-iam-policy-binding 'PROJECT_NUMBER' --member='serviceAccount:MEMBER' --role='roles/storage.objectViewer' --condition=None

다음을 바꿉니다.

권한을 부여할 수 없으면 Permission denied 오류가 발생합니다.

객체 테이블 만들기

Cloud Storage의 오디오 파일 세트를 대상으로 객체 테이블을 만듭니다. 객체 테이블의 오디오 파일은 지원되는 유형이어야 합니다.

객체 테이블에서 사용하는 Cloud Storage 버킷은 모델을 만들고 ML.TRANSCRIBE 함수를 호출하려는 동일한 프로젝트에 있어야 합니다. 객체 테이블에서 사용하는 Cloud Storage 버킷이 포함된 프로젝트가 아닌 다른 프로젝트에서 ML.TRANSCRIBE 함수를 호출하려면 service-A@gcp-sa-aiplatform.iam.gserviceaccount.com 서비스 계정에 버킷 수준에서 스토리지 관리자 역할을 부여해야 합니다.

모델 만들기

CLOUD_AI_SPEECH_TO_TEXT_V2의 REMOTE_SERVICE_TYPE을 사용하여 원격 모델을 만듭니다.

CREATE OR REPLACE MODEL `PROJECT_ID.DATASET_ID.MODEL_NAME` REMOTE WITH CONNECTION {DEFAULT | `PROJECT_ID.REGION.CONNECTION_ID`} OPTIONS ( REMOTE_SERVICE_TYPE = 'CLOUD_AI_SPEECH_TO_TEXT_V2', SPEECH_RECOGNIZER = 'projects/PROJECT_NUMBER/locations/LOCATION/recognizers/RECOGNIZER_ID' );

다음을 바꿉니다.

오디오 파일 텍스트 변환

ML.TRANSCRIBE 함수를 사용하여 오디오 파일을 텍스트로 변환합니다.

SELECT * FROM ML.TRANSCRIBE( MODEL `PROJECT_ID.DATASET_ID.MODEL_NAME`, TABLE `PROJECT_ID.DATASET_ID.OBJECT_TABLE_NAME`, RECOGNITION_CONFIG => ( JSON 'recognition_config') );

다음을 바꿉니다.

예시

예시 1

다음 예시에서는 인식기의 기본 구성을 재정의하지 않고 audio 테이블로 표시되는 오디오 파일을 텍스트로 변환합니다.

SELECT * FROM ML.TRANSCRIBE( MODEL `myproject.mydataset.transcribe_model`, TABLE `myproject.mydataset.audio` );

다음 예시에서는 audio 테이블로 표시되는 오디오 파일을 텍스트로 변환하고 기본 인식기의 구성을 제공합니다.

SELECT * FROM ML.TRANSCRIBE( MODEL `myproject.mydataset.transcribe_model`, TABLE `myproject.mydataset.audio`, recognition_config => ( JSON '{"language_codes": ["en-US" ],"model": "chirp","auto_decoding_config": {}}') );