Elabora i documenti con la funzione ML.PROCESS_DOCUMENT

Questo documento descrive come utilizzare la

funzione ML.PROCESS_DOCUMENT

con un

modello remoto

per estrarre informazioni utili dai documenti in una

tabella degli oggetti.

Località supportate

Devi creare il modello remoto utilizzato in questa procedura nella US

o nella EU multiregione. Devi eseguire

la funzione ML.PROCESS_DOCUMENT nella stessa regione del modello remoto.

Ruoli obbligatori

Per creare un modello remoto ed elaborare i documenti, devi disporre dei seguenti ruoli Identity and Access Management (IAM) a livello di progetto:

- Crea un processore di documenti: Document AI Editor

(

roles/documentai.editor) - Crea e utilizza set di dati, tabelle e modelli BigQuery:

BigQuery Data Editor (

roles/bigquery.dataEditor) Crea, delega e utilizza le connessioni BigQuery: Amministratore connessioni BigQuery (

roles/bigquery.connectionsAdmin)Se non hai configurato una connessione predefinita, puoi crearne e impostarne una durante l'esecuzione dell'istruzione

CREATE MODEL. Per farlo, devi disporre del ruolo Amministratore BigQuery (roles/bigquery.admin) nel tuo progetto. Per saperne di più, vedi Configurare la connessione predefinita.Concedi le autorizzazioni al account di servizio della connessione: Project IAM Admin (

roles/resourcemanager.projectIamAdmin)Crea job BigQuery: utente job BigQuery (

roles/bigquery.jobUser)

Questi ruoli predefiniti contengono le autorizzazioni necessarie per eseguire le attività descritte in questo documento. Per vedere quali sono esattamente le autorizzazioni richieste, espandi la sezione Autorizzazioni obbligatorie:

Autorizzazioni obbligatorie

- Crea un set di dati:

bigquery.datasets.create - Crea, delega e utilizza una connessione:

bigquery.connections.* - Imposta le autorizzazioni del account di servizio:

resourcemanager.projects.getIamPolicyeresourcemanager.projects.setIamPolicy - Crea un modello ed esegui l'inferenza:

bigquery.jobs.createbigquery.models.createbigquery.models.getDatabigquery.models.updateDatabigquery.models.updateMetadata

- Crea una tabella degli oggetti:

bigquery.tables.createebigquery.tables.update - Crea un processore di documenti:

documentai.processors.createdocumentai.processors.updatedocumentai.processors.delete

Potresti anche ottenere queste autorizzazioni con ruoli personalizzati o altri ruoli predefiniti.

Prima di iniziare

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the BigQuery, BigQuery Connection API, and Document AI APIs.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. -

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the BigQuery, BigQuery Connection API, and Document AI APIs.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. Nella console Google Cloud , vai alla pagina BigQuery.

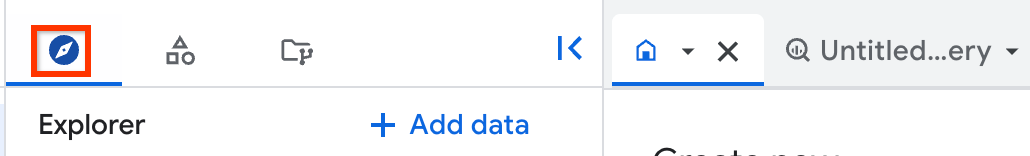

Nel riquadro a sinistra, fai clic su Explorer:

Se non vedi il riquadro a sinistra, fai clic su Espandi riquadro a sinistra per aprirlo.

Nel riquadro Explorer, fai clic sul nome del progetto.

Fai clic su Visualizza azioni > Crea set di dati.

Nella pagina Crea set di dati:

In ID set di dati, digita un nome per il set di dati.

Per Tipo di località, seleziona Regione o Più regioni.

- Se hai selezionato Regione, seleziona una località dall'elenco Regione.

- Se hai selezionato Più regioni, seleziona Stati Uniti o Europa dall'elenco Più regioni.

Fai clic su Crea set di dati.

Per creare un nuovo set di dati, utilizza il comando

bq mkcon il flag--location:bq --location=LOCATION mk -d DATASET_ID

Sostituisci quanto segue:

LOCATION: la posizione del set di dati.DATASET_IDè l'ID del set di dati che stai creando.

Verifica che il set di dati sia stato creato:

bq lsVai alla pagina BigQuery.

Nel riquadro Explorer, fai clic su Aggiungi dati:

Si apre la finestra di dialogo Aggiungi dati.

Nel riquadro Filtra per, nella sezione Tipo di origine dati, seleziona Applicazioni aziendali.

In alternativa, nel campo Cerca origini dati, puoi inserire

Vertex AI.Nella sezione Origini dati in evidenza, fai clic su Vertex AI.

Fai clic sulla scheda della soluzione Vertex AI Models: BigQuery Federation.

Nell'elenco Tipo di connessione, seleziona Modelli remoti di Vertex AI, funzioni remote, BigLake e Spanner (risorsa Cloud).

Nel campo ID connessione, inserisci un nome per la connessione.

Fai clic su Crea connessione.

Fai clic su Vai alla connessione.

Nel riquadro Informazioni sulla connessione, copia l'ID del account di servizio da utilizzare in un passaggio successivo.

In un ambiente a riga di comando, crea una connessione:

bq mk --connection --location=REGION --project_id=PROJECT_ID \ --connection_type=CLOUD_RESOURCE CONNECTION_ID

Il parametro

--project_idsostituisce il progetto predefinito.Sostituisci quanto segue:

REGION: la tua regione di connessionePROJECT_ID: il tuo ID progetto Google CloudCONNECTION_ID: un ID per la tua connessione

Quando crei una risorsa di connessione, BigQuery crea un account di serviziot di sistema univoco e lo associa alla connessione.

Risoluzione dei problemi: se viene visualizzato il seguente errore di connessione, aggiorna Google Cloud SDK:

Flags parsing error: flag --connection_type=CLOUD_RESOURCE: value should be one of...

Recupera e copia l'ID account di servizio da utilizzare in un passaggio successivo:

bq show --connection PROJECT_ID.REGION.CONNECTION_ID

L'output è simile al seguente:

name properties 1234.REGION.CONNECTION_ID {"serviceAccountId": "connection-1234-9u56h9@gcp-sa-bigquery-condel.iam.gserviceaccount.com"}- Avvia Cloud Shell.

-

Imposta il progetto Google Cloud predefinito in cui vuoi applicare le configurazioni Terraform.

Devi eseguire questo comando una sola volta per progetto e puoi eseguirlo in qualsiasi directory.

export GOOGLE_CLOUD_PROJECT=PROJECT_ID

Le variabili di ambiente vengono sostituite se imposti valori espliciti nel file di configurazione Terraform.

-

In Cloud Shell, crea una directory e un nuovo file al suo interno. Il nome file deve avere l'estensione

.tf, ad esempiomain.tf. In questo tutorial, il file viene denominatomain.tf.mkdir DIRECTORY && cd DIRECTORY && touch main.tf

-

Se stai seguendo un tutorial, puoi copiare il codice campione in ogni sezione o passaggio.

Copia il codice campione nel

main.tfappena creato.(Facoltativo) Copia il codice da GitHub. Questa operazione è consigliata quando lo snippet Terraform fa parte di una soluzione end-to-end.

- Rivedi e modifica i parametri di esempio da applicare al tuo ambiente.

- Salva le modifiche.

-

Inizializza Terraform. Devi effettuare questa operazione una sola volta per directory.

terraform init

(Facoltativo) Per utilizzare l'ultima versione del provider Google, includi l'opzione

-upgrade:terraform init -upgrade

-

Rivedi la configurazione e verifica che le risorse che Terraform creerà o

aggiornerà corrispondano alle tue aspettative:

terraform plan

Apporta le correzioni necessarie alla configurazione.

-

Applica la configurazione di Terraform eseguendo il comando seguente e inserendo

yesal prompt:terraform apply

Attendi che Terraform visualizzi il messaggio "Apply complete!".

- Apri il tuo Google Cloud progetto per visualizzare i risultati. Nella console Google Cloud , vai alle risorse nell'interfaccia utente per assicurarti che Terraform le abbia create o aggiornate.

Vai alla pagina IAM e amministrazione.

Fai clic su Concedi l'accesso.

Si apre la finestra di dialogo Aggiungi entità.

Nel campo Nuove entità, inserisci l'ID account di servizio che hai copiato in precedenza.

Nel campo Seleziona un ruolo, seleziona Document AI e poi Visualizzatore Document AI.

Fai clic su Aggiungi un altro ruolo.

Nel campo Seleziona un ruolo, seleziona Cloud Storage e poi Visualizzatore oggetti Storage.

Fai clic su Salva.

PROJECT_NUMBER: il numero di progetto.MEMBER: l'ID account di servizio che hai copiato in precedenza.PROJECT_ID: il tuo ID progetto.DATASET_ID: l'ID del set di dati che deve contenere il modello.MODEL_NAME: il nome del modello.REGION: la regione utilizzata dalla connessione.CONNECTION_ID: l'ID connessione, ad esempiomyconnection.Quando visualizzi i dettagli della connessione nella console Google Cloud , l'ID connessione è il valore nell'ultima sezione dell'ID connessione completo visualizzato in ID connessione, ad esempio

projects/myproject/locations/connection_location/connections/myconnection.PROCESSOR_ID: l'ID del processore di documenti. Per trovare questo valore, visualizza i dettagli del processore e poi guarda la riga ID nella sezione Informazioni di base.PROJECT_ID: il tuo ID progetto.DATASET_ID: l'ID del set di dati che contiene il modello.MODEL_NAME: il nome del modello.OBJECT_TABLE_NAME: il nome della tabella degli oggetti che contiene gli URI dei documenti da elaborare.PROCESS_OPTIONS: la configurazione JSON che specifica come elaborare i documenti. Ad esempio, lo utilizzi per specificare la suddivisione dei documenti per il parser del layoutPROJECT_ID: il tuo ID progetto.DATASET_ID: l'ID del set di dati che contiene il modello.MODEL_NAME: il nome del modello.OBJECT_TABLE_NAME: il nome della tabella degli oggetti che contiene gli URI dei documenti da elaborare.FILTERS: condizioni per filtrare i documenti che vuoi elaborare nelle colonne della tabella degli oggetti.NUM_DOCUMENTS: il numero massimo di documenti che vuoi elaborare.PROCESS_OPTIONS: la configurazione JSON che definisce la configurazione, ad esempio la configurazione di suddivisione in blocchi per il parser di layout- Per saperne di più sull'inferenza del modello in BigQuery ML, consulta Panoramica dell'inferenza del modello.

- Per saperne di più sull'utilizzo delle API Cloud AI per eseguire attività di AI, consulta Panoramica dell'applicazione AI.

- Per ulteriori informazioni sulle istruzioni e sulle funzioni SQL supportate per i modelli di AI generativa, consulta Percorsi utente end-to-end per i modelli di AI generativa.

Crea un processore

Crea un processore in Document AI per elaborare i documenti. Il processore deve essere di un tipo supportato.

Crea un set di dati

Devi creare il set di dati, la connessione e il processore di documenti nella stessa regione.

Crea un set di dati BigQuery che contenga le tue risorse:

Console

bq

Crea una connessione

Puoi saltare questo passaggio se hai configurato una connessione predefinita o se disponi del ruolo Amministratore BigQuery.

Crea una connessione a una risorsa Cloud da utilizzare per il modello remoto e recupera il account di servizio della connessione. Crea la connessione nella stessa posizione del set di dati creato nel passaggio precedente.

Seleziona una delle seguenti opzioni:

Console

bq

Terraform

Utilizza la risorsa

google_bigquery_connection.

Per eseguire l'autenticazione in BigQuery, configura le credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

L'esempio seguente crea una connessione di risorsa Cloud denominata

my_cloud_resource_connection nella regione US:

Per applicare la configurazione di Terraform in un progetto Google Cloud , completa i passaggi nelle sezioni seguenti.

Prepara Cloud Shell

Prepara la directory

Ogni file di configurazione Terraform deve avere la propria directory (chiamata anche modulo radice).

Applica le modifiche

Concedi l'accesso al service account

Seleziona una delle seguenti opzioni:

Console

gcloud

Utilizza il

comando gcloud projects add-iam-policy-binding:

gcloud projects add-iam-policy-binding 'PROJECT_NUMBER' --member='serviceAccount:MEMBER' --role='roles/documentai.viewer' --condition=None gcloud projects add-iam-policy-binding 'PROJECT_NUMBER' --member='serviceAccount:MEMBER' --role='roles/storage.objectViewer' --condition=None

Sostituisci quanto segue:

La mancata concessione dell'autorizzazione comporta un errore Permission denied.

crea un modello

Crea un modello remoto con un

REMOTE_SERVICE_TYPE di

CLOUD_AI_DOCUMENT_V1:

CREATE OR REPLACE MODEL `PROJECT_ID.DATASET_ID.MODEL_NAME` REMOTE WITH CONNECTION {DEFAULT | `PROJECT_ID.REGION.CONNECTION_ID`} OPTIONS ( REMOTE_SERVICE_TYPE = 'CLOUD_AI_DOCUMENT_V1', DOCUMENT_PROCESSOR = 'PROCESSOR_ID' );

Sostituisci quanto segue:

Per visualizzare le colonne di output del modello, fai clic su Vai al modello nel risultato della query dopo la creazione del modello. Le colonne di output vengono visualizzate nella sezione Etichette della scheda Schema.

Creare una tabella degli oggetti

Crea una tabella di oggetti su un insieme di documenti in Cloud Storage. I documenti nella tabella degli oggetti devono essere di un tipo supportato.

Elaborare documenti

Elabora tutti i documenti con ML.PROCESS_DOCUMENT:

SELECT * FROM ML.PROCESS_DOCUMENT( MODEL `PROJECT_ID.DATASET_ID.MODEL_NAME`, TABLE `PROJECT_ID.DATASET_ID.OBJECT_TABLE_NAME` [, PROCESS_OPTIONS => ( JSON 'PROCESS_OPTIONS')] );

Sostituisci quanto segue:

In alternativa, elabora alcuni documenti con ML.PROCESS_DOCUMENT:

SELECT * FROM ML.PROCESS_DOCUMENT( MODEL `PROJECT_ID.DATASET_ID.MODEL_NAME`, (SELECT * FROM `PROJECT_ID.DATASET_ID.OBJECT_TABLE_NAME` WHERE FILTERS LIMIT NUM_DOCUMENTS ) [, PROCESS_OPTIONS => ( JSON 'PROCESS_OPTIONS')] );

Sostituisci quanto segue:

Esempi

Esempio 1

L'esempio seguente utilizza il

parser delle spese

per elaborare i documenti rappresentati dalla tabella documents:

SELECT * FROM ML.PROCESS_DOCUMENT( MODEL `myproject.mydataset.expense_parser`, TABLE `myproject.mydataset.documents` );

Questa query restituisce le note spese analizzate, inclusi valuta,

importo totale, data della ricevuta e voci nelle note spese. La colonna

ml_process_document_result contiene l'output non elaborato del parser delle spese, mentre la colonna ml_process_document_status contiene gli eventuali errori restituiti dall'elaborazione del documento.

Esempio 2

L'esempio seguente mostra come filtrare la tabella degli oggetti per scegliere quali documenti elaborare e poi scrivere i risultati in una nuova tabella:

CREATE TABLE `myproject.mydataset.expense_details` AS SELECT uri, content_type, receipt_date, purchase_time, total_amount, currency FROM ML.PROCESS_DOCUMENT( MODEL `myproject.mydataset.expense_parser`, (SELECT * FROM `myproject.mydataset.expense_reports` WHERE uri LIKE '%restaurant%'));