Generative KI – Übersicht

In diesem Dokument werden die von BigQuery ML unterstützten Features für generative künstliche Intelligenz (KI) beschrieben. Mit diesen Features können Sie KI-Aufgaben in BigQuery ML mithilfe von vortrainierten Vertex AI-Modellen und integrierten BigQuery ML-Modellen ausführen.

Zu den unterstützten Aufgaben gehören folgende:

- Text generieren

- Strukturierte Daten generieren

- Werte eines bestimmten Typs zeilenweise generieren

- Einbettungen generieren

- Zeitreihenprognose

Wenn Sie auf ein Vertex AI-Modell zugreifen, um eine dieser Funktionen auszuführen, erstellen Sie in BigQuery ML ein Remote-Modell, das den Endpunkt des Vertex AI-Modells darstellt. Nachdem Sie ein Remote-Modell für das Vertex AI-Modell erstellt haben, das Sie verwenden möchten, können Sie die Funktionalität dieses Modells nutzen. Dazu führen Sie eine BigQuery ML-Funktion für das Remote-Modell aus.

Mit diesem Ansatz können Sie die Funktionen dieser Vertex AI-Modelle in SQL-Abfragen verwenden, um BigQuery-Daten zu analysieren.

Workflow

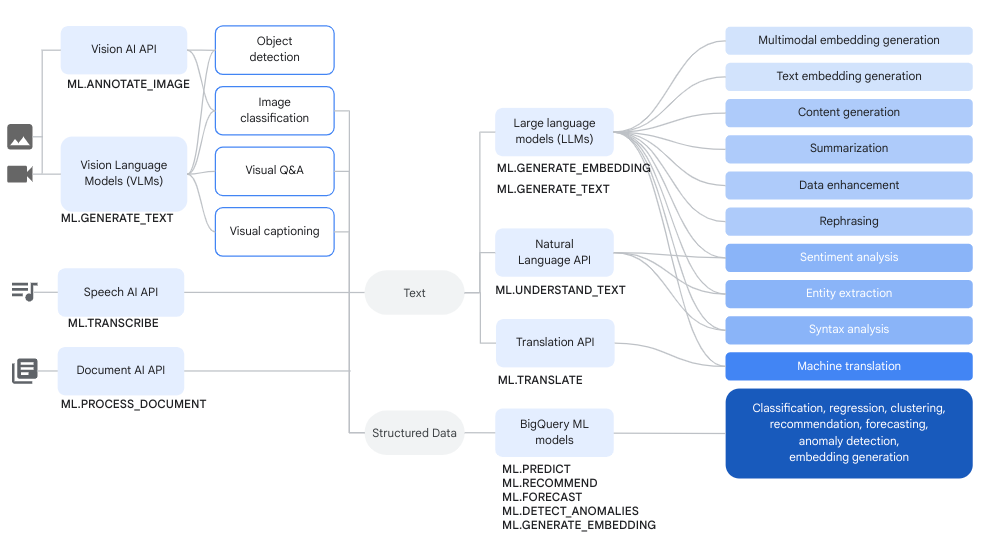

Sie können Remote-Modelle über Vertex AI-Modelle und Remote-Modelle über Cloud AI-Dienste zusammen mit BigQuery ML-Funktionen zum Ausführen komplexer Datenanalyse- und generativer KI-Aufgaben verwenden.

Das folgende Diagramm zeigt einige typische Workflows, in denen Sie diese Funktionen zusammen verwenden können:

Text generieren

Die Textgenerierung ist eine Form der generativen KI, bei der Text basierend auf einem Prompt oder einer Datenanalyse generiert wird. Sie können Text sowohl mit Text- als auch mit multimodalen Daten generieren.

Typische Anwendungsfälle für die Texterstellung:

- Kreative Inhalte generieren

- Code wird generiert.

- Chat- oder E‑Mail-Antworten generieren

- Brainstorming, z. B. Vorschläge für zukünftige Produkte oder Dienstleistungen

- Personalisierung von Inhalten, z. B. Produktvorschläge

- Daten klassifizieren, indem Sie dem Inhalt ein oder mehrere Labels zuweisen, um ihn in Kategorien zu sortieren.

- Die wichtigsten in den Inhalten ausgedrückten Stimmungen identifizieren.

- Die wichtigsten Ideen oder Eindrücke zusammenfassen, die durch die Inhalte vermittelt werden.

- Eine oder mehrere wichtige Entitäten in Text- oder visuellen Daten identifizieren.

- Übersetzung von Text- oder Audioinhalten in eine andere Sprache.

- Text generieren, der mit den verbalen Inhalten in Audiodaten übereinstimmt.

- Untertitelung oder Durchführung von Fragen und Antworten zu visuellen Daten.

Die Datenanreicherung ist ein häufiger nächster Schritt nach der Textgenerierung. Dabei werden die Erkenntnisse aus der ersten Analyse mit zusätzlichen Daten kombiniert. Sie können beispielsweise Bilder von Einrichtungsgegenständen analysieren, um Text für eine design_type-Spalte zu generieren. So erhält die SKU des Einrichtungsgegenstands eine zugehörige Beschreibung wie mid-century modern oder farmhouse.

Unterstützte Modelle

Für generative KI-Aufgaben können Sie Remote-Modelle in BigQuery ML verwenden, um auf Modelle zu verweisen, die in Vertex AI bereitgestellt oder gehostet werden. Sie können die folgenden Arten von Remote-Modellen erstellen:

- Remote-Modelle für alle allgemein verfügbaren oder Vorschau-Gemini-Modelle.

Remote-Modelle über den folgenden Partnermodellen:

Modelle zur Textgenerierung verwenden

Nachdem Sie ein Remote-Modell erstellt haben, können Sie über die Funktion ML.GENERATE_TEXT mit diesem Modell interagieren.

Für Remote-Modelle, die auf Gemini-Modellen basieren, können Sie Folgendes tun:

Mit der Funktion

ML.GENERATE_TEXTkönnen Sie Text aus einem Prompt generieren, den Sie in einer Abfrage angeben oder aus einer Spalte in einer Standardtabelle abrufen. Wenn Sie den Prompt in einer Abfrage angeben, können Sie im Prompt auf die folgenden Arten von Tabellenspalten verweisen:STRING-Spalten für Textdaten.STRUCT-Spalten, in denen unstrukturierte Daten imObjectRef-Format angegeben werden. Sie müssen dieOBJ.GET_ACCESS_URL-Funktion im Prompt verwenden, um dieObjectRef-Werte inObjectRefRuntime-Werte zu konvertieren.

Mit der Funktion

ML.GENERATE_TEXTkönnen Sie Text-, Bild-, Audio-, Video- oder PDF-Inhalte aus einer Objekttabelle mit einem Prompt analysieren, den Sie als Funktionsargument angeben.

Bei allen anderen Arten von Remote-Modellen können Sie die

ML.GENERATE_TEXT-Funktion mit einem Prompt verwenden, den Sie in einer Abfrage oder aus einer Spalte in einer Standardtabelle angeben.

In den folgenden Themen erfahren Sie, wie Sie die Textgenerierung in BigQuery ML ausprobieren können:

- Text mit einem Gemini-Modell und der Funktion

ML.GENERATE_TEXTgenerieren - Text mit einem Gemma-Modell und der Funktion

ML.GENERATE_TEXTgenerieren - Bilder mit einem Gemini-Modell analysieren

- Text mit der Funktion

ML.GENERATE_TEXTund Ihren Daten generieren - Modell mit Ihren Daten abstimmen

Fundierung und Sicherheitsattribute

Sie können Fundierung und Sicherheitsattribute verwenden, wenn Sie Gemini-Modelle mit der Funktion ML.GENERATE_TEXT verwenden, wenn Sie eine Standardtabelle als Eingabe verwenden. Mit der Fundierung kann das Gemini-Modell beim Generieren einer Antwort zusätzliche Informationen aus dem Internet verwenden, um spezifischere und faktischere Antworten zu erstellen. Mit Sicherheitsattributen kann das Gemini-Modell die zurückgegebenen Antworten anhand der von Ihnen angegebenen Attribute filtern.

Überwachte Abstimmung

Wenn Sie ein Remote-Modell erstellen, das auf eines der folgenden Modelle verweist, können Sie optional gleichzeitig die überwachte Abstimmung konfigurieren:

gemini-2.5-progemini-2.5-flash-litegemini-2.0-flash-001gemini-2.0-flash-lite-001

Alle Inferenzen treten in Vertex AI auf. Die Ergebnisse werden in BigQuery gespeichert.

Vertex AI Provisioned Throughput

Für unterstützte Gemini-Modelle können Sie Vertex AI Provisioned Throughput mit der Funktion ML.GENERATE_TEXT verwenden, um einen gleichbleibend hohen Durchsatz für Anfragen zu erzielen. Weitere Informationen finden Sie unter Vertex AI Provisioned Throughput verwenden.

Strukturierte Daten generieren

Die Generierung strukturierter Daten ähnelt der Textgenerierung. Sie können die Antwort des Modells jedoch zusätzlich formatieren, indem Sie ein SQL-Schema angeben.

Wenn Sie strukturierte Daten generieren möchten, erstellen Sie ein Remote-Modell für eines der allgemein verfügbaren oder in der Vorschau verfügbaren Gemini-Modelle. Sie können dann mit der Funktion AI.GENERATE_TABLE mit diesem Modell interagieren. Informationen zum Erstellen strukturierter Daten finden Sie unter Strukturierte Daten mit der Funktion AI.GENERATE_TABLE generieren.

Sie können Sicherheitsattribute angeben, wenn Sie Gemini-Modelle mit der Funktion AI.GENERATE_TABLE verwenden, um die Antworten des Modells zu filtern.

Werte eines bestimmten Typs zeilenweise generieren

Sie können skalare generative KI-Funktionen mit Gemini-Modellen verwenden, um Daten in BigQuery-Standardtabellen zu analysieren. Die Daten enthalten sowohl Textdaten als auch unstrukturierte Daten aus Spalten mit ObjectRef-Werten.

Für jede Zeile in der Tabelle wird mit diesen Funktionen eine Ausgabe mit einem bestimmten Typ generiert.

Die folgenden KI-Funktionen sind verfügbar:

AI.GENERATE, wodurch einSTRING-Wert generiert wirdAI.GENERATE_BOOLAI.GENERATE_DOUBLEAI.GENERATE_INT

Wenn Sie die Funktion AI.GENERATE mit unterstützten Gemini-Modellen verwenden, können Sie Vertex AI Provisioned Throughput verwenden, um einen gleichbleibend hohen Durchsatz für Anfragen zu erzielen. Weitere Informationen finden Sie unter Vertex AI Provisioned Throughput verwenden.

Einbettungen generieren

Eine Einbettung ist ein hochdimensionaler numerischer Vektor, der eine bestimmte Entität darstellt, z. B. einen Text oder eine Audiodatei. Durch das Generieren von Einbettungen können Sie die Semantik Ihrer Daten so erfassen, dass sie leichter zu analysieren und zu vergleichen sind.

Im Folgenden sind einige gängige Anwendungsfälle für die Generierung von Einbettungen aufgeführt:

- Retrieval-Augmented Generation (RAG) verwenden, um Modellantworten auf Nutzeranfragen durch Verweisen auf zusätzliche Daten aus einer vertrauenswürdigen Quelle zu ergänzen. RAG bietet eine bessere faktische Richtigkeit und Konsistenz der Antworten und ermöglicht auch den Zugriff auf Daten, die neuer sind als die Trainingsdaten des Modells.

- Multimodale Suche durchführen Zum Beispiel, wenn Sie mit Texteingabe nach Bildern suchen.

- Semantische Suche nach ähnlichen Elementen für Empfehlungen, Ersetzungen und die Deduplizierung von Datensätzen.

- Einbettungen erstellen, die mit einem k-Means-Modell für das Clustering verwendet werden.

Unterstützte Modelle

Die folgenden Modelle werden unterstützt:

Für Texteinbettungen können Sie die folgenden Vertex AI-Modelle verwenden:

gemini-embedding-001(Vorschau)text-embeddingtext-multilingual-embedding- Unterstützte offene Modelle (Vorschau)

Für multimodale Einbettungen, die Text, Bilder und Videos in denselben semantischen Bereich einbetten können, können Sie das Vertex AI-Modell

multimodalembeddingverwenden.Zum Erstellen von Einbettungen für strukturierte Daten aus unabhängigen und identisch verteilten Zufallsvariablen (IID) können Sie ein BigQuery ML-Hauptkomponentenanalyse (PCA)-Modell oder ein Autoencoder-Modell verwenden.

Um Einbettungen für Nutzer- oder Artikeldaten zu erstellen, können Sie ein BigQuery ML-Modell zur Matrixfaktorisierung verwenden.

Für eine kleinere, schlanke Texteinbettung sollten Sie ein vortrainiertes TensorFlow-Modell verwenden, z. B. NNLM, SWIVEL oder BERT.

Modelle zur Generierung von Einbettungen verwenden

Nachdem Sie das Modell erstellt haben, können Sie über die Funktion ML.GENERATE_EMBEDDING mit diesem Modell interagieren. Bei allen Arten von unterstützten Modellen funktioniert ML.GENERATE_EMBEDDING mit strukturierten Daten in Standardtabellen. Bei multimodalen Einbettungsmodellen funktioniert ML.GENERATE_EMBEDDING auch mit visuellen Inhalten aus entweder Standardtabellenspalten, die ObjectRef-Werte enthalten, oder aus Objekttabellen.

Bei Remote-Modellen erfolgt die gesamte Inferenz in Vertex AI. Bei anderen Modelltypen erfolgt die gesamte Inferenz in BigQuery. Die Ergebnisse werden in BigQuery gespeichert.

In den folgenden Themen erfahren Sie, wie Sie die Textgenerierung in BigQuery ML ausprobieren können:

- Texteinbettungen mit der Funktion

ML.GENERATE_EMBEDDINGgenerieren - Bildeinbettungen mit der Funktion

ML.GENERATE_EMBEDDINGgenerieren - Videoeinbettungen mit der Funktion

ML.GENERATE_EMBEDDINGgenerieren - Multimodale Einbettungen generieren und suchen

- Semantische Suche und Retrieval Augmented Generation durchführen

Vorhersage

Bei der Prognose werden Verlaufsdaten analysiert, um fundierte Vorhersagen über zukünftige Trends zu treffen. Sie können das integrierte TimesFM-Zeitreihenmodell von BigQuery ML (Vorabversion) verwenden, um Prognosen zu erstellen, ohne ein eigenes Modell erstellen zu müssen. Das integrierte TimesFM-Modell verwendet die Funktion AI.FORECAST, um Prognosen auf Grundlage Ihrer Daten zu erstellen.

Standorte

Die unterstützten Standorte für Textgenerierungs- und Einbettungsmodelle variieren je nach Modelltyp und ‑version. Weitere Informationen finden Sie unter Standorte. Im Gegensatz zu anderen generativen KI-Modellen gilt die Unterstützung von Standorten nicht für das integrierte Zeitreihenmodell TimesFM. Das TimesFM-Modell ist in allen von BigQuery unterstützten Regionen verfügbar.

Preise

Ihnen werden die Rechenressourcen in Rechnung gestellt, die Sie zum Ausführen von Abfragen für Modelle verwenden. Remote-Modelle rufen Vertex AI-Modelle auf. Daher fallen für Anfragen an Remote-Modelle auch Gebühren von Vertex AI an.

Weitere Informationen finden Sie unter BigQuery ML-Preise.

Nächste Schritte

- Eine Einführung in KI und ML in BigQuery finden Sie unter Einführung in KI und ML in BigQuery.

- Weitere Informationen zum Ausführen von Inferenzen für Modelle von maschinellem Lernen finden Sie unter Modellinferenz – Übersicht.

- Weitere Informationen zu den unterstützten SQL-Anweisungen und -Funktionen für generative KI-Modelle finden Sie unter End-to-End-Nutzerpfade für generative KI-Modelle.