Modell mit Ihren Daten abstimmen

In diesem Dokument erfahren Sie, wie Sie ein BigQuery ML-Remote-Modell erstellen, das auf ein Vertex AI-Modell verweist, und das Modell dann für die überwachte Abstimmung konfigurieren. Das Vertex AI-Modell muss eines der folgenden sein:

gemini-2.5-progemini-2.5-flash-litegemini-2.0-flash-001gemini-2.0-flash-lite-001

Nachdem Sie das Remote-Modell erstellt haben, verwenden Sie die ML.EVALUATE-Funktion, um das Modell zu bewerten und zu bestätigen, dass die Leistung des Modells zu Ihrem Anwendungsfall passt. Sie können das Modell dann in Verbindung mit der ML.GENERATE_TEXT-Funktion verwenden, um Text in einer BigQuery-Tabelle zu analysieren.

Weitere Informationen finden Sie unter Überwachte Abstimmung der Vertex AI Gemini API.

Erforderliche Rollen

Zum Erstellen und Bewerten eines optimierten Modells benötigen Sie die folgenden IAM-Rollen (Identity and Access Management):

- BigQuery-Datasets, -Tabellen und -Modelle erstellen und verwenden: BigQuery-Dateneditor (

roles/bigquery.dataEditor) für Ihr Projekt. BigQuery-Verbindungen erstellen, delegieren und verwenden: BigQuery-Verbindungsadministrator (

roles/bigquery.connectionsAdmin) für Ihr Projekt.Wenn Sie keine Standardverbindung konfiguriert haben, können Sie eine erstellen und festlegen, wenn Sie die

CREATE MODEL-Anweisung ausführen. Dazu benötigen Sie die Rolle „BigQuery Admin“ (roles/bigquery.admin) für Ihr Projekt. Weitere Informationen finden Sie unter Standardverbindung konfigurieren.Gewähren Sie dem Dienstkonto der Verbindung die Berechtigungen „Projekt-IAM-Administrator“ (

roles/resourcemanager.projectIamAdmin) für das Projekt, das den Vertex AI-Endpunkt enthält. Dies ist das aktuelle Projekt für Remote-Modelle, die Sie erstellen, indem Sie den Modellnamen als Endpunkt angeben. Dies ist das Projekt, das in der URL für Remote-Modelle angegeben ist, die Sie durch Angabe einer URL als Endpunkt erstellen.BigQuery-Jobs erstellen: Rolle „BigQuery Job User“ (

roles/bigquery.jobUser) für Ihr Projekt.

Diese vordefinierten Rollen enthalten die Berechtigungen, die zum Ausführen der Aufgaben in diesem Dokument erforderlich sind. Erweitern Sie den Abschnitt Erforderliche Berechtigungen, um die erforderlichen Berechtigungen anzuzeigen:

Erforderliche Berechtigungen

- Dataset erstellen:

bigquery.datasets.create - Verbindung erstellen, delegieren und verwenden:

bigquery.connections.* - Dienstkontoberechtigungen festlegen:

resourcemanager.projects.getIamPolicyundresourcemanager.projects.setIamPolicy - Modell erstellen und Inferenz ausführen:

bigquery.jobs.createbigquery.models.createbigquery.models.getDatabigquery.models.updateDatabigquery.models.updateMetadata

Sie können diese Berechtigungen auch mit benutzerdefinierten Rollen oder anderen vordefinierten Rollen erhalten.

Hinweise

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the BigQuery, BigQuery Connection,Vertex AI, and Compute Engine APIs.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles.

Dataset erstellen

Erstellen Sie ein BigQuery-Dataset, das Ihre Ressourcen enthält:

Console

Öffnen Sie in der Google Cloud Console die Seite BigQuery.

Klicken Sie im Bereich Explorer auf den Namen Ihres Projekts.

Klicken Sie auf Aktionen ansehen > Dataset erstellen.

Führen Sie auf der Seite Dataset erstellen die folgenden Schritte aus:

Geben Sie für Dataset-ID einen Namen für das Dataset ein.

Wählen Sie unter Standorttyp einen Standort für das Dataset aus.

Klicken Sie auf Dataset erstellen.

bq

Wenn Sie ein neues Dataset erstellen möchten, verwenden Sie den Befehl

bq mkmit dem Flag--location:bq --location=LOCATION mk -d DATASET_ID

Ersetzen Sie Folgendes:

LOCATION: Speicherort des Datasets.DATASET_ID: der Name des zu erstellenden Datasets.

Prüfen Sie, ob das Dataset erstellt wurde:

bq ls

Verbindung herstellen

Sie können diesen Schritt überspringen, wenn Sie entweder eine Standardverbindung konfiguriert haben oder die Rolle „BigQuery-Administrator“ haben.

Erstellen Sie eine Cloud-Ressourcenverbindung, die vom Remote-Modell verwendet werden soll, und rufen Sie das Dienstkonto der Verbindung ab. Erstellen Sie die Verbindung am selben Speicherort wie das Dataset, das Sie im vorherigen Schritt erstellt haben.

Wählen Sie eine der folgenden Optionen aus:

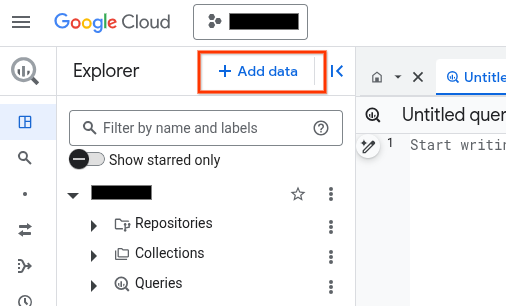

Console

Rufen Sie die Seite BigQuery auf.

Klicken Sie im Bereich Explorer auf Daten hinzufügen:

Das Dialogfeld Daten hinzufügen wird geöffnet.

Wählen Sie im Bereich Filtern nach im Abschnitt Datenquellentyp die Option Geschäftsanwendungen aus.

Alternativ können Sie im Feld Nach Datenquellen suchen

Vertex AIeingeben.Klicken Sie im Abschnitt Empfohlene Datenquellen auf Vertex AI.

Klicken Sie auf die Lösungsübersichtskarte Vertex AI-Modelle: BigQuery Federation.

Wählen Sie in der Liste Verbindungstyp die Option Remote-Modelle in Vertex AI, Remote-Funktionen und BigLake (Cloud-Ressource) aus.

Geben Sie im Feld Verbindungs-ID einen Namen für die Verbindung ein.

Klicken Sie auf Verbindung erstellen.

Klicken Sie auf Zur Verbindung.

Kopieren Sie im Bereich Verbindungsinformationen die Dienstkonto-ID zur Verwendung in einem späteren Schritt.

bq

Erstellen Sie in einer Befehlszeilenumgebung eine Verbindung:

bq mk --connection --location=REGION --project_id=PROJECT_ID \ --connection_type=CLOUD_RESOURCE CONNECTION_ID

Der Parameter

--project_idüberschreibt das Standardprojekt.Ersetzen Sie dabei Folgendes:

REGION: Ihre VerbindungsregionPROJECT_ID: Ihre Google Cloud Projekt-IDCONNECTION_ID: eine ID für Ihre Verbindung

Wenn Sie eine Verbindungsressource herstellen, erstellt BigQuery ein eindeutiges Systemdienstkonto und ordnet es der Verbindung zu.

Fehlerbehebung:Wird der folgende Verbindungsfehler angezeigt, aktualisieren Sie das Google Cloud SDK:

Flags parsing error: flag --connection_type=CLOUD_RESOURCE: value should be one of...

Rufen Sie die Dienstkonto-ID ab und kopieren Sie sie zur Verwendung in einem späteren Schritt:

bq show --connection PROJECT_ID.REGION.CONNECTION_ID

Die Ausgabe sieht in etwa so aus:

name properties 1234.REGION.CONNECTION_ID {"serviceAccountId": "connection-1234-9u56h9@gcp-sa-bigquery-condel.iam.gserviceaccount.com"}

Terraform

Verwenden Sie die Ressource google_bigquery_connection:

Richten Sie zur Authentifizierung bei BigQuery die Standardanmeldedaten für Anwendungen ein. Weitere Informationen finden Sie unter Authentifizierung für Clientbibliotheken einrichten.

Im folgenden Beispiel wird eine Cloud-Ressourcenverbindung mit dem Namen my_cloud_resource_connection in der Region US erstellt:

Führen Sie die Schritte in den folgenden Abschnitten aus, um Ihre Terraform-Konfiguration auf ein Google Cloud -Projekt anzuwenden.

Cloud Shell vorbereiten

- Rufen Sie Cloud Shell auf.

-

Legen Sie das Standardprojekt Google Cloud fest, auf das Sie Ihre Terraform-Konfigurationen anwenden möchten.

Sie müssen diesen Befehl nur einmal pro Projekt und in jedem beliebigen Verzeichnis ausführen.

export GOOGLE_CLOUD_PROJECT=PROJECT_ID

Umgebungsvariablen werden überschrieben, wenn Sie in der Terraform-Konfigurationsdatei explizite Werte festlegen.

Verzeichnis vorbereiten

Jede Terraform-Konfigurationsdatei muss ein eigenes Verzeichnis haben (auch als Stammmodul bezeichnet).

-

Erstellen Sie in Cloud Shell ein Verzeichnis und eine neue Datei in diesem Verzeichnis. Der Dateiname muss die Erweiterung

.tfhaben, z. B.main.tf. In dieser Anleitung wird die Datei alsmain.tfbezeichnet.mkdir DIRECTORY && cd DIRECTORY && touch main.tf

-

Wenn Sie einer Anleitung folgen, können Sie den Beispielcode in jedem Abschnitt oder Schritt kopieren.

Kopieren Sie den Beispielcode in das neu erstellte

main.tf.Kopieren Sie optional den Code aus GitHub. Dies wird empfohlen, wenn das Terraform-Snippet Teil einer End-to-End-Lösung ist.

- Prüfen und ändern Sie die Beispielparameter, die auf Ihre Umgebung angewendet werden sollen.

- Speichern Sie die Änderungen.

-

Initialisieren Sie Terraform. Dies ist nur einmal für jedes Verzeichnis erforderlich.

terraform init

Fügen Sie optional die Option

-upgradeein, um die neueste Google-Anbieterversion zu verwenden:terraform init -upgrade

Änderungen anwenden

-

Prüfen Sie die Konfiguration und prüfen Sie, ob die Ressourcen, die Terraform erstellen oder aktualisieren wird, Ihren Erwartungen entsprechen:

terraform plan

Korrigieren Sie die Konfiguration nach Bedarf.

-

Wenden Sie die Terraform-Konfiguration an. Führen Sie dazu den folgenden Befehl aus und geben Sie

yesan der Eingabeaufforderung ein:terraform apply

Warten Sie, bis Terraform die Meldung „Apply complete“ anzeigt.

- Öffnen Sie Ihr Google Cloud Projekt, um die Ergebnisse aufzurufen. Rufen Sie in der Google Cloud Console Ihre Ressourcen in der Benutzeroberfläche auf, um sicherzustellen, dass Terraform sie erstellt oder aktualisiert hat.

Dem Dienstkonto der Verbindung Zugriff gewähren

Weisen Sie dem Dienstkonto der Verbindung die Rolle „Vertex AI Service Agent“ zu.

Wenn Sie den Endpunkt beim Erstellen des Remote-Modells als URL angeben möchten, z. B. endpoint = 'https://us-central1-aiplatform.googleapis.com/v1/projects/myproject/locations/us-central1/publishers/google/models/gemini-2.0-flash', gewähren Sie diese Rolle in demselben Projekt, das Sie in der URL angeben.

Wenn Sie beim Erstellen des Remote-Modells den Endpunkt mit dem Modellnamen angeben möchten, z. B. endpoint = 'gemini-2.0-flash', gewähren Sie diese Rolle in demselben Projekt, in dem Sie das Remote-Modell erstellen möchten.

Die Zuweisung der Rolle in einem anderen Projekt führt zu dem Fehler bqcx-1234567890-wxyz@gcp-sa-bigquery-condel.iam.gserviceaccount.com does not have the permission to access resource.

So weisen Sie die Rolle zu:

Console

Zur Seite IAM & Verwaltung.

Klicken Sie auf Zugriff gewähren.

Geben Sie unter Neue Hauptkonten die Dienstkonto-ID ein, die Sie zuvor kopiert haben.

Klicken Sie auf Rolle auswählen.

Geben Sie unter Filter

Vertex AI Service Agentein und wählen Sie diese Rolle aus.Klicken Sie auf Speichern.

gcloud

Führen Sie den Befehl gcloud projects add-iam-policy-binding aus:

gcloud projects add-iam-policy-binding 'PROJECT_NUMBER' --member='serviceAccount:MEMBER' --role='roles/aiplatform.serviceAgent' --condition=None

Dabei gilt:

PROJECT_NUMBER: Ihre Projektnummer.MEMBER: Die Dienstkonto-ID, die Sie zuvor kopiert haben.

Das mit Ihrer Verbindung verknüpfte Dienstkonto ist eine Instanz des Dienst-Agent für BigQuery Connection Delegation, daher ist es in Ordnung, ihm eine Dienst-Agent-Rolle zuzuweisen.

Modell mit überwachter Feinabstimmung erstellen

Öffnen Sie in der Google Cloud Console die Seite BigQuery.

Führen Sie im Query Editor die folgende Abfrage aus, um ein Remote-Modell zu erstellen:

CREATE OR REPLACE MODEL `PROJECT_ID.DATASET_ID.MODEL_NAME` REMOTE WITH CONNECTION {DEFAULT | `PROJECT_ID.REGION.CONNECTION_ID`} OPTIONS ( ENDPOINT = 'ENDPOINT', MAX_ITERATIONS = MAX_ITERATIONS, LEARNING_RATE_MULTIPLIER = LEARNING_RATE_MULTIPLIER, DATA_SPLIT_METHOD = 'DATA_SPLIT_METHOD', DATA_SPLIT_EVAL_FRACTION = DATA_SPLIT_EVAL_FRACTION, DATA_SPLIT_COL = 'DATA_SPLIT_COL', EVALUATION_TASK = 'EVALUATION_TASK', PROMPT_COL = 'INPUT_PROMPT_COL', INPUT_LABEL_COLS = INPUT_LABEL_COLS) AS SELECT PROMPT_COLUMN, LABEL_COLUMN FROM `TABLE_PROJECT_ID.TABLE_DATASET.TABLE_NAME`;

Ersetzen Sie Folgendes:

PROJECT_IDist die Projekt-ID des Projekts, in dem das Modell erstellt werden soll.DATASET_IDist die ID des Datasets, das das Modell enthalten soll. Dieses Dataset muss sich in einer unterstützten Vertex AI-Region befinden.MODEL_NAMEist der Name des Modells.REGIONist die Region, die von der Verbindung verwendet wird.CONNECTION_IDist die ID Ihrer BigQuery-Verbindung. Diese Verbindung muss sich am selben Standort wie das von Ihnen verwendete Dataset befinden.Wenn Sie sich Verbindungsdetails in der Google Cloud Console ansehen, ist dies der Wert im letzten Abschnitt der voll qualifizierten Verbindungs-ID, der unter Verbindungs-ID angezeigt wird, z. B.

projects/myproject/locations/connection_location/connections/myconnection.ENDPOINT: einSTRING-Wert, der den Namen des zu verwendenden Modells angibt.MAX_ITERATIONS: einINT64-Wert, der die Anzahl der Schritte angibt, die für die überwachte Abstimmung ausgeführt werden sollen. Der WertMAX_ITERATIONSmuss zwischen1und∞liegen.Gemini-Modelle werden mit Epochen anstelle von Schritten trainiert. BigQuery ML wandelt den Wert

MAX_ITERATIONSdaher in Epochen um. Der Standardwert fürMAX_ITERATIONSist die Anzahl der Zeilen in den Eingabedaten, die einer Epoche entspricht. Falls Sie mehrere Epochen verwenden möchten, geben Sie ein Vielfaches der Anzahl an Zeilen in Ihren Trainingsdaten an. Wenn Sie beispielsweise 100 Zeilen mit Eingabedaten haben und zwei Epochen verwenden möchten, geben Sie200für den Argumentwert an. Wenn Sie einen Wert angeben, der kein Vielfaches der Anzahl der Zeilen in den Eingabedaten ist, rundet BigQuery ML auf die nächste Epoche auf. Wenn Sie beispielsweise 100 Zeilen mit Eingabedaten haben und den Wert101für den WertMAX_ITERATIONSangeben, wird das Training in zwei Epochen ausgeführt.Weitere Informationen zu den Parametern, die zum Optimieren von Gemini-Modellen verwendet werden, finden Sie unter Abstimmungsjob erstellen.

DATA_SPLIT_METHOD: einSTRING-Wert, der die Methode zum Aufteilen von Eingabedaten in Trainings- und Bewertungs-Datasets angibt. Gültige Optionen sind:AUTO_SPLIT: BigQuery ML teilt die Daten automatisch auf. Die Art und Weise, wie die Daten aufgeteilt werden, hängt von der Anzahl der Zeilen in der Eingabetabelle ab. Dies ist der Standardwert.RANDOM: Die Daten werden randomisiert, bevor sie in Datasets aufgeteilt werden. Wenn Sie die Datenaufteilung anpassen möchten, können Sie diese Option mit der OptionDATA_SPLIT_EVAL_FRACTIONverwenden.CUSTOM: Daten werden anhand der Spalte aufgeteilt, die in der OptionDATA_SPLIT_COLangegeben ist. Der WertDATA_SPLIT_COLmuss der Name einer Spalte vom TypBOOLsein. Zeilen mit einem der WerteTRUEoderNULLwerden als Bewertungsdaten, Zeilen mit dem WertFALSEwerden als Trainingsdaten verwendet.SEQ: Daten anhand der in der OptionDATA_SPLIT_COLangegebenen Spalte aufteilen. Der WertDATA_SPLIT_COLmuss der Name einer Spalte eines der folgenden Typen sein:NUMERICBIGNUMERICSTRINGTIMESTAMP

Die Daten werden anhand der angegebenen Spalte vom kleinsten zum größten Wert sortiert.

Die ersten n Zeilen werden als Bewertungsdaten verwendet, wobei n der für

DATA_SPLIT_EVAL_FRACTIONangegebene Wert ist. Die restlichen Zeilen werden als Trainingsdaten verwendet.NO_SPLIT: keine Datenaufteilung. Alle Eingabedaten werden als Trainingsdaten verwendet.

Weitere Informationen zu diesen Optionen für die Datenaufteilung finden Sie unter

DATA_SPLIT_METHOD.DATA_SPLIT_EVAL_FRACTION: einFLOAT64-Wert, der den Anteil der Daten angibt, der als Bewertungsdaten verwendet werden soll, wenn eine überwachte Abstimmung durchgeführt wird. Muss ein Wert im Bereich[0, 1.0]sein. Der Standardwert ist0.2.Verwenden Sie diese Option, wenn Sie

RANDOModerSEQals Wert für die OptionDATA_SPLIT_METHODangeben. Wenn Sie die Datenaufteilung anpassen möchten, können Sie die OptionDATA_SPLIT_METHODmit der OptionDATA_SPLIT_EVAL_FRACTIONverwenden.DATA_SPLIT_COL: einSTRING-Wert, der den Namen der Spalte angibt, die zum Sortieren von Eingabedaten in die Trainings- oder Bewertungs-Datasets verwendet werden soll. Verwenden Sie diese Option, wenn SieCUSTOModerSEQals Wert für die OptionDATA_SPLIT_METHODangeben.EVALUATION_TASK: einSTRING-Wert, der die Art der Aufgabe angibt, für die das Modell optimiert werden soll. Gültige Optionen sind:TEXT_GENERATIONCLASSIFICATIONSUMMARIZATIONQUESTION_ANSWERINGUNSPECIFIED

Der Standardwert ist

UNSPECIFIED.INPUT_PROMPT_COL: einSTRING-Wert, der den Namen der Prompt-Spalte in der Trainingsdatentabelle enthält, die für die überwachte Abstimmung verwendet werden soll. Der Standardwert istprompt.INPUT_LABEL_COLS: einARRAY<<STRING>-Wert, der den Namen der Labelspalte in der Trainingsdatentabelle enthält, die für die überwachte Abstimmung verwendet werden soll. Sie können nur ein Element im Array angeben. Der Standardwert ist ein leerer String. Dadurch istlabelder Standardwert des ArgumentsLABEL_COLUMN.PROMPT_COLUMN: Die Spalte in der Trainingsdatentabelle, die den Prompt zum Bewerten des Inhalts in der SpalteLABEL_COLUMNenthält. Diese Spalte muss vom TypSTRINGsein oder inSTRINGübertragen worden sein. Wenn Sie einen Wert für die OptionINPUT_PROMPT_COLangeben, müssen Sie denselben Wert fürPROMPT_COLUMNangeben. Andernfalls muss dieser Wertpromptsein. Wenn die Tabelle keineprompt-Spalte enthält, verwenden Sie einen Alias, um eine vorhandene Tabellenspalte anzugeben. Beispiel:AS SELECT hint AS prompt, label FROM mydataset.mytable.LABEL_COLUMN: Die Spalte in der Tabelle mit Trainingsdaten, die die Beispiele enthält, mit denen das Modell trainiert werden soll. Diese Spalte muss vom TypSTRINGsein oder inSTRINGübertragen worden sein. Wenn Sie einen Wert für die OptionINPUT_LABEL_COLSangeben, müssen Sie denselben Wert fürLABEL_COLUMNangeben. Andernfalls muss dieser Wertlabelsein. Wenn die Tabelle keinelabel-Spalte enthält, verwenden Sie einen Alias, um eine vorhandene Tabellenspalte anzugeben. Beispiel:AS SELECT prompt, feature AS label FROM mydataset.mytable.TABLE_PROJECT_ID: die Projekt-ID des Projekts, das die Tabelle mit den Trainingsdaten enthält.TABLE_DATASET: der Name des Datasets, das die Tabelle mit den Trainingsdaten enthält.TABLE_NAME: Der Name der Tabelle, die die Daten enthält, die zum Trainieren des Modells verwendet werden sollen.

Abgestimmtes Modell bewerten

Öffnen Sie in der Google Cloud Console die Seite BigQuery.

Führen Sie im Abfrageeditor die folgende Abfrage aus, um das optimierte Modell zu bewerten:

SELECT * FROM ML.EVALUATE( MODEL `PROJECT_ID.DATASET_ID.MODEL_NAME`, TABLE `TABLE_PROJECT_ID.TABLE_DATASET.TABLE_NAME`, STRUCT('TASK_TYPE' AS task_type, TOKENS AS max_output_tokens, TEMPERATURE AS temperature, TOP_K AS top_k, TOP_P AS top_p));

Ersetzen Sie Folgendes:

PROJECT_ID: die ID des Projekts, das das Modell enthältDATASET_IDist die ID des Datasets, das das Modell enthält.MODEL_NAMEist der Name des Modells.TABLE_PROJECT_ID: die Projekt-ID des Projekts, das die Tabelle mit den Auswertungsdaten enthält.TABLE_DATASET: der Name des Datasets, das die Tabelle mit den Auswertungsdaten enthält.TABLE_NAME: der Name der Tabelle, die die Bewertungsdaten enthält.Die Tabelle muss eine Spalte enthalten, deren Name mit dem Namen der Prompt-Spalte übereinstimmt, die während des Modelltrainings angegeben wurde. Sie können diesen Wert während des Modelltrainings mit der Option

prompt_colangeben. Wennprompt_colnicht angegeben ist, wird in den Trainingsdaten die Spaltepromptverwendet. Wenn keine Spalte mit dem Namenpromptvorhanden ist, wird ein Fehler zurückgegeben.Die Tabelle muss eine Spalte enthalten, deren Name mit dem Namen der Labelspalte übereinstimmt, der während des Modelltrainings angegeben wird. Sie können diesen Wert während des Modelltrainings mit der Option

input_label_colsangeben. Wenninput_label_colsnicht angegeben ist, wird in den Trainingsdaten die Spalte mit dem Namenlabelverwendet. Ein Fehler wird zurückgegeben, wenn keine Spalte mit dem Namenlabelvorhanden ist.TASK_TYPE: einSTRING-Wert, der die Art der Aufgabe angibt, für die das Modell bewertet werden soll. Gültige Optionen sind:TEXT_GENERATIONCLASSIFICATIONSUMMARIZATIONQUESTION_ANSWERINGUNSPECIFIED

TOKENSist einINT64-Wert, der die maximale Anzahl an Tokens festlegt, die in der Antwort generiert werden können. Dieser Wert muss im Bereich[1,1024]liegen. Geben Sie kürzere Werte für kürzere Antworten und höhere Werte für längere Antworten an. Der Standardwert ist128.TEMPERATURE: einFLOAT64-Wert im Bereich[0.0,1.0], der den Grad der Zufälligkeit in der Tokenauswahl steuert. Der Standardwert ist0.Niedrigere Werte für

temperatureeignen sich für Prompts, die deterministischere und weniger offene oder kreative Reaktionen erfordern, während höhere Werte fürtemperaturezu vielfältigeren oder kreativen Ergebnissen führen können. Ein Wert von0fürtemperatureist deterministisch, d. h. die Antwort mit der höchsten Wahrscheinlichkeit wird immer ausgewählt.TOP_K: einINT64-Wert im Bereich[1,40], der den anfänglichen Pool von Tokens bestimmt, die das Modell zur Auswahl berücksichtigt. Geben Sie einen niedrigeren Wert für weniger zufällige Antworten und einen höheren Wert für zufälligere Antworten an. Der Standardwert ist40.TOP_P: einFLOAT64-Wert im Bereich[0.0,1.0]hilft dabei, zu ermitteln, welche Token aus dem durchTOP_Kbestimmten Pool ausgewählt werden. Geben Sie einen niedrigeren Wert für weniger zufällige Antworten und einen höheren Wert für zufälligere Antworten an. Der Standardwert ist0.95.

Text generieren

Generieren Sie Text mit der Funktion ML.GENERATE_TEXT:

Prompt-Spalte

Generieren Sie Text mithilfe einer Tabellenspalte, um den Prompt bereitzustellen.

SELECT * FROM ML.GENERATE_TEXT( MODEL `PROJECT_ID.DATASET_ID.MODEL_NAME`, TABLE PROJECT_ID.DATASET_ID.TABLE_NAME, STRUCT(TOKENS AS max_output_tokens, TEMPERATURE AS temperature, TOP_P AS top_p, FLATTEN_JSON AS flatten_json_output, STOP_SEQUENCES AS stop_sequences) );

Ersetzen Sie Folgendes:

PROJECT_ID: Ihre Projekt-ID.DATASET_IDist die ID des Datasets, das das Modell enthält.MODEL_NAMEist der Name des Modells.TABLE_NAME: der Name der Tabelle, die den Prompt enthält. Diese Tabelle muss eine Spalte enthalten, deren Name mit dem Namen der Feature-Spalte im optimierten Modell übereinstimmt. Der Name der Spalte mit den Merkmalen im Modell kann beim Erstellen des Modells mit der OptionPROMPT_COLfestgelegt werden. Andernfalls lautet der Name der Featurespalte im Modell standardmäßigprompt. Sie können auch einen Alias verwenden, um eine Spalte mit einem anderen Namen zu verwenden.TOKENSist einINT64-Wert, der die maximale Anzahl an Tokens festlegt, die in der Antwort generiert werden können. Dieser Wert muss im Bereich[1,8192]liegen. Geben Sie kürzere Werte für kürzere Antworten und höhere Werte für längere Antworten an. Der Standardwert ist128.TEMPERATURE: einFLOAT64-Wert im Bereich[0.0,1.0], der den Grad der Zufälligkeit in der Tokenauswahl steuert. Der Standardwert ist0.Niedrigere Werte für

temperatureeignen sich für Prompts, die deterministischere und weniger offene oder kreative Reaktionen erfordern, während höhere Werte fürtemperaturezu vielfältigeren oder kreativen Ergebnissen führen können. Ein Wert von0fürtemperatureist deterministisch, d. h. die Antwort mit der höchsten Wahrscheinlichkeit wird immer ausgewählt.TOP_P: einFLOAT64-Wert im Bereich[0.0,1.0], der die Wahrscheinlichkeit der ausgewählten Tokens bestimmt. Geben Sie einen niedrigeren Wert für weniger zufällige Antworten und einen höheren Wert für zufälligere Antworten an. Der Standardwert ist0.95.FLATTEN_JSON: einBOOL-Wert, der bestimmt, ob der generierte Text und die Sicherheitsattribute in separaten Spalten zurückgegeben werden. Der Standardwert istFALSE.STOP_SEQUENCESist einARRAY<STRING>-Wert, der die angegebenen Strings entfernt, wenn sie in Antworten des Modells enthalten sind. Strings werden genau abgeglichen, einschließlich Groß-/Kleinschreibung. Der Standardwert ist ein leeres Array.GROUND_WITH_GOOGLE_SEARCH: EinBOOL-Wert, der bestimmt, ob das Vertex AI-Modell beim Generieren von Antworten die Fundierung mit der Google Suche verwendet. Mit der Fundierung kann das Modell beim Generieren einer Antwort zusätzliche Informationen aus dem Internet verwenden, um Modellantworten spezifischer und faktischer zu machen. Wenn sowohlflatten_json_outputals auch dieses Feld aufTruefestgelegt sind, wird den Ergebnissen eine zusätzliche Spalteml_generate_text_grounding_resulthinzugefügt, in der die Quellen angegeben sind, die das Modell zum Sammeln zusätzlicher Informationen verwendet hat. Der Standardwert istFALSE.SAFETY_SETTINGS: einARRAY<STRUCT<STRING AS category, STRING AS threshold>>-Wert, der Sicherheitsgrenzwerte für Inhalte konfiguriert, um Antworten zu filtern. Das erste Element in der Struktur gibt eine Schadenskategorie und das zweite Element in der Struktur einen entsprechenden Grenzwert für „Blockiert“ an. Das Modell filtert Inhalte heraus, die gegen diese Einstellungen verstoßen. Sie können jede Kategorie nur einmal angeben. Sie können beispielsweise nicht sowohlSTRUCT('HARM_CATEGORY_DANGEROUS_CONTENT' AS category, 'BLOCK_MEDIUM_AND_ABOVE' AS threshold)als auchSTRUCT('HARM_CATEGORY_DANGEROUS_CONTENT' AS category, 'BLOCK_ONLY_HIGH' AS threshold)angeben. Wenn es für eine bestimmte Kategorie keine Sicherheitseinstellung gibt, wird die SicherheitseinstellungBLOCK_MEDIUM_AND_ABOVEverwendet.Die folgenden Kategorien werden unterstützt:

HARM_CATEGORY_HATE_SPEECHHARM_CATEGORY_DANGEROUS_CONTENTHARM_CATEGORY_HARASSMENTHARM_CATEGORY_SEXUALLY_EXPLICIT

Folgende Grenzwerte werden unterstützt:

BLOCK_NONE(Eingeschränkt)BLOCK_LOW_AND_ABOVEBLOCK_MEDIUM_AND_ABOVE(Standard)BLOCK_ONLY_HIGHHARM_BLOCK_THRESHOLD_UNSPECIFIED

Weitere Informationen finden Sie in der Definition der Sicherheitskategorie und des Grenzwerts für „Blockiert“.

REQUEST_TYPE: einSTRING-Wert, der den Typ der Inferenzanfrage angibt, die an das Gemini-Modell gesendet werden soll. Der Anfragetyp bestimmt, welches Kontingent für die Anfrage verwendet wird. Gültige Werte:DEDICATED: Die FunktionML.GENERATE_TEXTverwendet nur das Kontingent für Provisioned Throughput. DieML.GENERATE_TEXT-Funktion gibt den FehlerProvisioned throughput is not purchased or is not activezurück, wenn das Kontingent für bereitgestellten Durchsatz nicht verfügbar ist.SHARED: Die FunktionML.GENERATE_TEXTverwendet nur dynamisches gemeinsames Kontingent (Dynamic Shared Quota, DSQ), auch wenn Sie Kontingent für bereitgestellten Durchsatz erworben haben.UNSPECIFIED: DieML.GENERATE_TEXT-Funktion verwendet Kontingente so:- Wenn Sie kein Kontingent für bereitgestellten Durchsatz erworben haben, verwendet die Funktion

ML.GENERATE_TEXTdas DSQ-Kontingent. - Wenn Sie ein Kontingent für bereitgestellten Durchsatz erworben haben, wird dieses zuerst von der Funktion

ML.GENERATE_TEXTverwendet. Wenn Anfragen das Kontingent für Provisioned Throughput überschreiten, wird für den Overflow-Traffic das DSQ-Kontingent verwendet.

- Wenn Sie kein Kontingent für bereitgestellten Durchsatz erworben haben, verwendet die Funktion

Der Standardwert ist

UNSPECIFIED.Weitere Informationen finden Sie unter Vertex AI Provisioned Throughput verwenden.

Das folgende Beispiel zeigt eine Anfrage mit diesen Merkmalen:

- Verwendet die Spalte

promptder Tabellepromptsfür den Prompt. - Gibt eine kurze und moderat wahrscheinliche Antwort zurück.

- Gibt den generierten Text und die Sicherheitsattribute in separaten Spalten zurück.

SELECT * FROM ML.GENERATE_TEXT( MODEL `mydataset.mymodel`, TABLE mydataset.prompts, STRUCT( 0.4 AS temperature, 100 AS max_output_tokens, 0.5 AS top_p, TRUE AS flatten_json_output));

Abfrage eingeben

Generieren Sie Text mithilfe einer Abfrage, um den Prompt bereitzustellen.

SELECT * FROM ML.GENERATE_TEXT( MODEL `PROJECT_ID.DATASET_ID.MODEL_NAME`, (PROMPT_QUERY), STRUCT(TOKENS AS max_output_tokens, TEMPERATURE AS temperature, TOP_P AS top_p, FLATTEN_JSON AS flatten_json_output, STOP_SEQUENCES AS stop_sequences) );

Ersetzen Sie Folgendes:

PROJECT_ID: Ihre Projekt-ID.DATASET_IDist die ID des Datasets, das das Modell enthält.MODEL_NAMEist der Name des Modells.PROMPT_QUERY: eine Abfrage, die die Prompt-Daten bereitstellt.TOKENSist einINT64-Wert, der die maximale Anzahl an Tokens festlegt, die in der Antwort generiert werden können. Dieser Wert muss im Bereich[1,8192]liegen. Geben Sie kürzere Werte für kürzere Antworten und höhere Werte für längere Antworten an. Der Standardwert ist128.TEMPERATURE: einFLOAT64-Wert im Bereich[0.0,1.0], der den Grad der Zufälligkeit in der Tokenauswahl steuert. Der Standardwert ist0.Niedrigere Werte für

temperatureeignen sich für Prompts, die deterministischere und weniger offene oder kreative Reaktionen erfordern, während höhere Werte fürtemperaturezu vielfältigeren oder kreativen Ergebnissen führen können. Ein Wert von0fürtemperatureist deterministisch, d. h. die Antwort mit der höchsten Wahrscheinlichkeit wird immer ausgewählt.TOP_P: einFLOAT64-Wert im Bereich[0.0,1.0], der die Wahrscheinlichkeit der ausgewählten Tokens bestimmt. Geben Sie einen niedrigeren Wert für weniger zufällige Antworten und einen höheren Wert für zufälligere Antworten an. Der Standardwert ist0.95.FLATTEN_JSON: einBOOL-Wert, der bestimmt, ob der generierte Text und die Sicherheitsattribute in separaten Spalten zurückgegeben werden. Der Standardwert istFALSE.STOP_SEQUENCESist einARRAY<STRING>-Wert, der die angegebenen Strings entfernt, wenn sie in Antworten des Modells enthalten sind. Strings werden genau abgeglichen, einschließlich Groß-/Kleinschreibung. Der Standardwert ist ein leeres Array.GROUND_WITH_GOOGLE_SEARCH: EinBOOL-Wert, der bestimmt, ob das Vertex AI-Modell beim Generieren von Antworten die Fundierung mit der Google Suche verwendet. Mit der Fundierung kann das Modell beim Generieren einer Antwort zusätzliche Informationen aus dem Internet verwenden, um Modellantworten spezifischer und faktischer zu machen. Wenn sowohlflatten_json_outputals auch dieses Feld aufTruefestgelegt sind, wird den Ergebnissen eine zusätzliche Spalteml_generate_text_grounding_resulthinzugefügt, in der die Quellen angegeben sind, die das Modell zum Sammeln zusätzlicher Informationen verwendet hat. Der Standardwert istFALSE.SAFETY_SETTINGS: einARRAY<STRUCT<STRING AS category, STRING AS threshold>>-Wert, der Sicherheitsgrenzwerte für Inhalte konfiguriert, um Antworten zu filtern. Das erste Element in der Struktur gibt eine Schadenskategorie und das zweite Element in der Struktur einen entsprechenden Grenzwert für „Blockiert“ an. Das Modell filtert Inhalte heraus, die gegen diese Einstellungen verstoßen. Sie können jede Kategorie nur einmal angeben. Sie können beispielsweise nicht sowohlSTRUCT('HARM_CATEGORY_DANGEROUS_CONTENT' AS category, 'BLOCK_MEDIUM_AND_ABOVE' AS threshold)als auchSTRUCT('HARM_CATEGORY_DANGEROUS_CONTENT' AS category, 'BLOCK_ONLY_HIGH' AS threshold)angeben. Wenn es für eine bestimmte Kategorie keine Sicherheitseinstellung gibt, wird die SicherheitseinstellungBLOCK_MEDIUM_AND_ABOVEverwendet.Die folgenden Kategorien werden unterstützt:

HARM_CATEGORY_HATE_SPEECHHARM_CATEGORY_DANGEROUS_CONTENTHARM_CATEGORY_HARASSMENTHARM_CATEGORY_SEXUALLY_EXPLICIT

Folgende Grenzwerte werden unterstützt:

BLOCK_NONE(Eingeschränkt)BLOCK_LOW_AND_ABOVEBLOCK_MEDIUM_AND_ABOVE(Standard)BLOCK_ONLY_HIGHHARM_BLOCK_THRESHOLD_UNSPECIFIED

Weitere Informationen finden Sie in der Definition der Sicherheitskategorie und des Grenzwerts für „Blockiert“.

REQUEST_TYPE: einSTRING-Wert, der den Typ der Inferenzanfrage angibt, die an das Gemini-Modell gesendet werden soll. Der Anfragetyp bestimmt, welches Kontingent für die Anfrage verwendet wird. Gültige Werte:DEDICATED: Die FunktionML.GENERATE_TEXTverwendet nur das Kontingent für Provisioned Throughput. DieML.GENERATE_TEXT-Funktion gibt den FehlerProvisioned throughput is not purchased or is not activezurück, wenn das Kontingent für bereitgestellten Durchsatz nicht verfügbar ist.SHARED: Die FunktionML.GENERATE_TEXTverwendet nur dynamisches gemeinsames Kontingent (Dynamic Shared Quota, DSQ), auch wenn Sie Kontingent für bereitgestellten Durchsatz erworben haben.UNSPECIFIED: DieML.GENERATE_TEXT-Funktion verwendet Kontingente so:- Wenn Sie kein Kontingent für bereitgestellten Durchsatz erworben haben, verwendet die Funktion

ML.GENERATE_TEXTdas DSQ-Kontingent. - Wenn Sie ein Kontingent für bereitgestellten Durchsatz erworben haben, wird dieses zuerst von der Funktion

ML.GENERATE_TEXTverwendet. Wenn Anfragen das Kontingent für Provisioned Throughput überschreiten, wird für den Overflow-Traffic das DSQ-Kontingent verwendet.

- Wenn Sie kein Kontingent für bereitgestellten Durchsatz erworben haben, verwendet die Funktion

Der Standardwert ist

UNSPECIFIED.Weitere Informationen finden Sie unter Vertex AI Provisioned Throughput verwenden.

Beispiel 1

Das folgende Beispiel zeigt eine Anfrage mit diesen Merkmalen:

- Aufforderungen für eine Zusammenfassung des Texts in der Spalte

bodyder Tabellearticles. - Gibt eine relativ lange und wahrscheinlichere Antwort zurück.

- Gibt den generierten Text und die Sicherheitsattribute in separaten Spalten zurück.

SELECT * FROM ML.GENERATE_TEXT( MODEL `mydataset.mymodel`, ( SELECT CONCAT('Summarize this text', body) AS prompt FROM mydataset.articles ), STRUCT( 0.2 AS temperature, 650 AS max_output_tokens, 0.2 AS top_p, TRUE AS flatten_json_output));

Beispiel 2

Das folgende Beispiel zeigt eine Anfrage mit diesen Merkmalen:

- Verwendet eine Abfrage, um die Eingabedaten zu erstellen. Verkettet werden Strings, die Tabellenpräfixe mit Tabellenspalten bereitstellen.

- Gibt eine kurze und moderat wahrscheinliche Antwort zurück.

- Gibt den generierten Text und die Sicherheitsattribute in separaten Spalten nicht zurück.

SELECT * FROM ML.GENERATE_TEXT( MODEL `mydataset.mytuned_model`, ( SELECT CONCAT(question, 'Text:', description, 'Category') AS prompt FROM mydataset.input_table ), STRUCT( 0.4 AS temperature, 100 AS max_output_tokens, 0.5 AS top_p, FALSE AS flatten_json_output));