Multimodale Einbettungen generieren und suchen

In dieser Anleitung wird gezeigt, wie Sie mit BigQuery und Vertex AI multimodale Einbettungen für Bilder und Text generieren und diese Einbettungen dann für eine semantische Text-zu-Bild-Suche verwenden.

In dieser Anleitung werden die folgenden Aufgaben behandelt:

- Erstellen einer BigQuery-Objekttabelle für Bilddaten in einem Cloud Storage-Bucket.

- Bilddaten mit einem Colab Enterprise-Notebook in BigQuery untersuchen.

- BigQuery ML-Remote-Modell erstellen, das auf das

Vertex AI-Basismodell

multimodalembeddingabzielt. - Mit dem Remote-Modell und der Funktion

ML.GENERATE_EMBEDDINGEinbettungen aus den Bildern in der Objekttabelle generieren. - Beheben Sie alle Fehler bei der Einbettungserstellung.

- Optional: Vektorindex erstellen, um die Bildeinbettungen zu indexieren.

- Erstellen einer Texteinbettung für einen bestimmten Suchstring.

- Mit der Funktion

VECTOR_SEARCHeine semantische Suche nach Bildeinbettungen durchführen, die der Texteinbettung ähneln - Ergebnisse in einem Notebook visualisieren

In dieser Anleitung werden die öffentlichen Kunstbilder aus dem The Metropolitan Museum of Art verwendet, die im öffentlichen Cloud Storage gcs-public-data--met-Bucket verfügbar sind.

Erforderliche Rollen

Zum Ausführen dieser Anleitung benötigen Sie die folgenden IAM-Rollen (Identity and Access Management):

- BigQuery-Datasets, ‑Verbindungen, ‑Modelle und ‑Notebooks erstellen und verwenden: BigQuery Studio Admin (

roles/bigquery.studioAdmin). - Gewähren Sie dem Dienstkonto der Verbindung Berechtigungen: Projekt-IAM-Administrator (

roles/resourcemanager.projectIamAdmin).

Diese vordefinierten Rollen enthalten die Berechtigungen, die zum Ausführen der Aufgaben in diesem Dokument erforderlich sind. Erweitern Sie den Abschnitt Erforderliche Berechtigungen, um die erforderlichen Berechtigungen anzuzeigen:

Erforderliche Berechtigungen

- Dataset erstellen:

bigquery.datasets.create - Verbindung erstellen, delegieren und verwenden:

bigquery.connections.* - Standardverbindung festlegen:

bigquery.config.* - Dienstkontoberechtigungen festlegen:

resourcemanager.projects.getIamPolicyundresourcemanager.projects.setIamPolicy - Objekttabelle erstellen:

bigquery.tables.createundbigquery.tables.update - Modell erstellen und Inferenz ausführen:

bigquery.jobs.createbigquery.models.createbigquery.models.getDatabigquery.models.updateDatabigquery.models.updateMetadata

- Notebooks erstellen und verwenden:

resourcemanager.projects.getresourcemanager.projects.listbigquery.config.getbigquery.jobs.createbigquery.readsessions.createbigquery.readsessions.getDatabigquery.readsessions.updatedataform.locations.getdataform.locations.listdataform.repositories.create

.dataform.repositories.listdataform.collections.createdataform.collections.listaiplatform.notebookRuntimeTemplates.applyaiplatform.notebookRuntimeTemplates.getaiplatform.notebookRuntimeTemplates.listaiplatform.notebookRuntimeTemplates.getIamPolicyaiplatform.notebookRuntimes.assignaiplatform.notebookRuntimes.getaiplatform.notebookRuntimes.listaiplatform.operations.listaiplatform.notebookRuntimeTemplates.apply

Sie können diese Berechtigungen auch mit benutzerdefinierten Rollen oder anderen vordefinierten Rollen erhalten.

Kosten

In diesem Dokument verwenden Sie die folgenden kostenpflichtigen Komponenten von Google Cloud:

- BigQuery ML: You incur costs for the data that you process in BigQuery.

- Vertex AI: You incur costs for calls to the Vertex AI service that's represented by the remote model.

Mit dem Preisrechner können Sie eine Kostenschätzung für Ihre voraussichtliche Nutzung vornehmen.

Weitere Informationen zu den Preisen von BigQuery finden Sie unter BigQuery: Preise in der BigQuery-Dokumentation.

Weitere Informationen zu den Preisen für Vertex AI finden Sie auf der Seite Vertex AI: Preise.

Hinweise

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the BigQuery, BigQuery Connection, and Vertex AI APIs.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles.

Dataset erstellen

Erstellen Sie ein BigQuery-Dataset zum Speichern Ihres ML-Modells.

Konsole

Öffnen Sie in der Google Cloud Console die Seite BigQuery.

Klicken Sie im Bereich Explorer auf den Namen Ihres Projekts.

Klicken Sie auf Aktionen ansehen > Dataset erstellen.

Führen Sie auf der Seite Dataset erstellen die folgenden Schritte aus:

Geben Sie unter Dataset-ID

bqml_tutorialein.Wählen Sie als Standorttyp die Option Mehrere Regionen und dann USA (mehrere Regionen in den USA) aus.

Übernehmen Sie die verbleibenden Standardeinstellungen unverändert und klicken Sie auf Dataset erstellen.

bq

Wenn Sie ein neues Dataset erstellen möchten, verwenden Sie den Befehl bq mk mit dem Flag --location. Eine vollständige Liste der möglichen Parameter finden Sie in der bq mk --dataset-Befehlsreferenz.

Erstellen Sie ein Dataset mit dem Namen

bqml_tutorial, wobei der Datenspeicherort aufUSund die Beschreibung aufBigQuery ML tutorial datasetfestgelegt ist:bq --location=US mk -d \ --description "BigQuery ML tutorial dataset." \ bqml_tutorial

Anstelle des Flags

--datasetverwendet der Befehl die verkürzte Form-d. Wenn Sie-dund--datasetauslassen, wird standardmäßig ein Dataset erstellt.Prüfen Sie, ob das Dataset erstellt wurde:

bq ls

API

Rufen Sie die Methode datasets.insert mit einer definierten Dataset-Ressource auf.

{ "datasetReference": { "datasetId": "bqml_tutorial" } }

BigQuery DataFrames

Bevor Sie dieses Beispiel ausprobieren, folgen Sie den Schritten zur Einrichtung von BigQuery DataFrames in der BigQuery-Kurzanleitung: BigQuery DataFrames verwenden. Weitere Informationen finden Sie in der Referenzdokumentation zu BigQuery DataFrames.

Richten Sie zur Authentifizierung bei BigQuery die Standardanmeldedaten für Anwendungen ein. Weitere Informationen finden Sie unter ADC für eine lokale Entwicklungsumgebung einrichten.

Objekttabelle erstellen

Erstellen Sie eine Objekttabelle für die Kunstbilder im öffentlichen Cloud Storage-gcs-public-data--met-Bucket.

Mit der Objekttabelle können Sie die Bilder analysieren, ohne sie aus Cloud Storage zu verschieben.

Öffnen Sie in der Google Cloud Console die Seite BigQuery.

Führen Sie im Abfrageeditor folgende Abfrage aus:

CREATE OR REPLACE EXTERNAL TABLE `bqml_tutorial.met_images` WITH CONNECTION DEFAULT OPTIONS ( object_metadata = 'SIMPLE', uris = ['gs://gcs-public-data--met/*'] );

Bilddaten analysieren

Erstellen Sie ein Colab Enterprise-Notebook in BigQuery, um die Bilddaten zu analysieren.

Öffnen Sie in der Google Cloud Console die Seite BigQuery.

Notebook einrichten:

- Fügen Sie dem Notebook eine Codezelle hinzu.

Kopieren Sie den folgenden Code in die Codezelle:

#@title Set up credentials from google.colab import auth auth.authenticate_user() print('Authenticated') PROJECT_ID='PROJECT_ID' from google.cloud import bigquery client = bigquery.Client(PROJECT_ID)Ersetzen Sie

PROJECT_IDdurch den Namen des Projekts, das Sie für diese Anleitung verwenden.Führen Sie die Codezelle aus.

Tabellendarstellung aktivieren:

- Fügen Sie dem Notebook eine Codezelle hinzu.

Kopieren Sie den folgenden Code in die Codezelle:

#@title Enable data table display %load_ext google.colab.data_tableFühren Sie die Codezelle aus.

Funktion zum Anzeigen der Bilder erstellen:

- Fügen Sie dem Notebook eine Codezelle hinzu.

Kopieren Sie den folgenden Code in die Codezelle:

#@title Util function to display images import io from PIL import Image import matplotlib.pyplot as plt import tensorflow as tf def printImages(results): image_results_list = list(results) amt_of_images = len(image_results_list) fig, axes = plt.subplots(nrows=amt_of_images, ncols=2, figsize=(20, 20)) fig.tight_layout() fig.subplots_adjust(hspace=0.5) for i in range(amt_of_images): gcs_uri = image_results_list[i][0] text = image_results_list[i][1] f = tf.io.gfile.GFile(gcs_uri, 'rb') stream = io.BytesIO(f.read()) img = Image.open(stream) axes[i, 0].axis('off') axes[i, 0].imshow(img) axes[i, 1].axis('off') axes[i, 1].text(0, 0, text, fontsize=10) plt.show()Führen Sie die Codezelle aus.

Bilder anzeigen:

- Fügen Sie dem Notebook eine Codezelle hinzu.

Kopieren Sie den folgenden Code in die Codezelle:

#@title Display Met images inspect_obj_table_query = """ SELECT uri, content_type FROM bqml_tutorial.met_images WHERE content_type = 'image/jpeg' Order by uri LIMIT 10; """ printImages(client.query(inspect_obj_table_query))Führen Sie die Codezelle aus.

Die Antwort sollte in etwa so aussehen:

Speichern Sie das Notebook als

met-image-analysis.

Remote-Modell erstellen

Erstellen Sie ein Remote-Modell, das ein gehostetes multimodales Einbettungsmodell von Vertex AI darstellt:

Öffnen Sie in der Google Cloud Console die Seite BigQuery.

Führen Sie im Abfrageeditor folgende Abfrage aus:

CREATE OR REPLACE MODEL `bqml_tutorial.multimodal_embedding_model` REMOTE WITH CONNECTION DEFAULT OPTIONS (ENDPOINT = 'multimodalembedding@001');

Die Abfrage dauert mehrere Sekunden. Anschließend wird das Modell

multimodal_embedding_modelimbqml_tutorial-Dataset des Bereichs Explorer angezeigt. Da die Abfrage eineCREATE MODEL-Anweisung zum Erstellen eines Modells verwendet, gibt es keine Abfrageergebnisse.

Bildeinbettungen generieren

Generieren Sie mit der Funktion ML.GENERATE_EMBEDDING Einbettungen aus den Bildern in der Objekttabelle. Schreiben Sie sie in einem folgenden Schritt dann zur Verwendung in eine Tabelle. Die Generierung der Einbettung ist ein teurer Vorgang. Daher verwendet die Abfrage eine Unterabfrage, einschließlich der LIMIT-Klausel, um die Generierung der Einbettung auf 10.000 Bilder zu beschränken, anstatt das vollständige Dataset von 601.294 Bildern einzubetten. Dies trägt auch dazu bei, die Anzahl der Bilder unter dem Limit von 25.000 für die ML.GENERATE_EMBEDDING-Funktion zu halten. Diese Abfrage dauert ca. 40 Minuten.

Öffnen Sie in der Google Cloud Console die Seite BigQuery.

Führen Sie im Abfrageeditor folgende Abfrage aus:

CREATE OR REPLACE TABLE `bqml_tutorial.met_image_embeddings` AS SELECT * FROM ML.GENERATE_EMBEDDING( MODEL `bqml_tutorial.multimodal_embedding_model`, (SELECT * FROM `bqml_tutorial.met_images` WHERE content_type = 'image/jpeg' LIMIT 10000))

Fehler bei der Generierung von Einbettungen beheben

Prüfen Sie, ob Fehler bei der Generierung von Einbettungen aufgetreten sind, und beheben Sie sie. Die Generierung von Einbettungen kann aufgrund von Kontingenten für generative KI in Vertex AI oder der Nichtverfügbarkeit von Diensten fehlschlagen.

Die Funktion ML.GENERATE_EMBEDDING gibt Fehlerdetails in der Spalte ml_generate_embedding_status zurück. Diese Spalte ist leer, wenn die Einbettungsgenerierung erfolgreich war, oder enthält eine Fehlermeldung, wenn die Einbettungsgenerierung fehlgeschlagen ist.

Öffnen Sie in der Google Cloud Console die Seite BigQuery.

Führen Sie im Abfrageeditor die folgende Abfrage aus, um zu prüfen, ob Fehler bei der Generierung von Einbettungen aufgetreten sind:

SELECT DISTINCT(ml_generate_embedding_status), COUNT(uri) AS num_rows FROM bqml_tutorial.met_image_embeddings GROUP BY 1;

Wenn Zeilen mit Fehlern zurückgegeben werden, entfernen Sie alle Zeilen, in denen die Einbettungserstellung fehlgeschlagen ist:

DELETE FROM `bqml_tutorial.met_image_embeddings` WHERE ml_generate_embedding_status = 'A retryable error occurred: RESOURCE_EXHAUSTED error from remote service/endpoint.';

Vektorindex erstellen

Optional können Sie die Anweisung CREATE VECTOR INDEX verwenden, um den Vektorindex met_images_index für die Spalte ml_generate_embedding_result der Tabelle met_images_embeddings zu erstellen.

Mit einem Vektorindex können Sie eine Vektorsuche schneller durchführen. Das hat jedoch den Nachteil, dass der Recall reduziert wird und somit ungefähre Ergebnisse zurückgegeben werden.

Öffnen Sie in der Google Cloud Console die Seite BigQuery.

Führen Sie im Abfrageeditor folgende Abfrage aus:

CREATE OR REPLACE VECTOR INDEX `met_images_index` ON bqml_tutorial.met_image_embeddings(ml_generate_embedding_result) OPTIONS ( index_type = 'IVF', distance_type = 'COSINE');

Der Vektorindex wird asynchron erstellt. Um zu prüfen, ob der Vektorindex erstellt wurde, fragen Sie die Ansicht

INFORMATION_SCHEMA.VECTOR_INDEXESab und bestätigen, dass der Wertcoverage_percentagegrößer als0ist und der Wertlast_refresh_timenichtNULList:SELECT table_name, index_name, index_status, coverage_percentage, last_refresh_time, disable_reason FROM bqml_tutorial.INFORMATION_SCHEMA.VECTOR_INDEXES WHERE index_name = 'met_images_index';

Einbettung für den Suchtext generieren

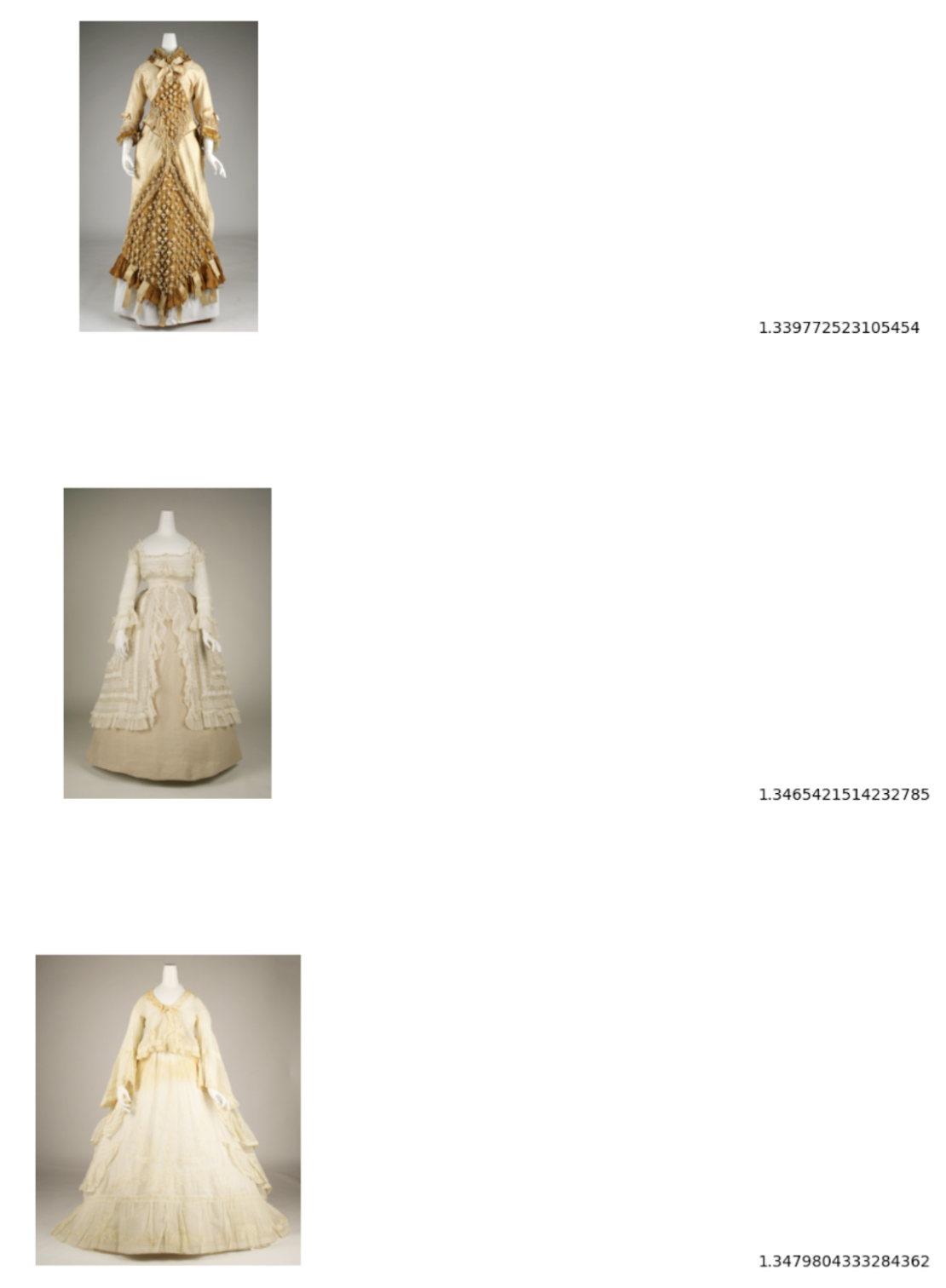

Wenn Sie nach Bildern suchen möchten, die einem bestimmten Textsuchstring entsprechen, müssen Sie zuerst eine Texteinbettung für diesen String erstellen. Verwenden Sie dasselbe Remote-Modell, um die Texteinbettung zu erstellen, die Sie zum Erstellen der Bildeinbettungen verwendet haben, und schreiben Sie die Texteinbettung dann zur Verwendung in einem folgenden Schritt in eine Tabelle. Der Suchstring ist pictures of white or cream colored dress from victorian era.

Öffnen Sie in der Google Cloud Console die Seite BigQuery.

Führen Sie im Abfrageeditor folgende Abfrage aus:

CREATE OR REPLACE TABLE `bqml_tutorial.search_embedding` AS SELECT * FROM ML.GENERATE_EMBEDDING( MODEL `bqml_tutorial.multimodal_embedding_model`, ( SELECT 'pictures of white or cream colored dress from victorian era' AS content ) );

Semantische Text-zu-Bild-Suche durchführen

Verwenden Sie die VECTOR_SEARCH-Funktion, um eine semantische Suche nach Bildern durchzuführen, die am besten dem durch die Texteinbettung repräsentierten Suchstring entsprechen.

Öffnen Sie in der Google Cloud Console die Seite BigQuery.

Führen Sie im Abfrageeditor die folgende Abfrage aus, um eine semantische Suche durchzuführen und die Ergebnisse in eine Tabelle zu schreiben:

CREATE OR REPLACE TABLE `bqml_tutorial.vector_search_results` AS SELECT base.uri AS gcs_uri, distance FROM VECTOR_SEARCH( TABLE `bqml_tutorial.met_image_embeddings`, 'ml_generate_embedding_result', TABLE `bqml_tutorial.search_embedding`, 'ml_generate_embedding_result', top_k => 3);

Semantische Suchergebnisse visualisieren

Die Ergebnisse der semantischen Suche in einem Notebook visualisieren

Öffnen Sie in der Google Cloud Console die Seite BigQuery.

Öffnen Sie das Notebook

met-image-analysis, das Sie zuvor erstellt haben.Vektorsuchergebnisse visualisieren:

- Fügen Sie dem Notebook eine Codezelle hinzu.

Kopieren Sie den folgenden Code in die Codezelle:

query = """ SELECT * FROM `bqml_tutorial.vector_search_results` ORDER BY distance; """ printImages(client.query(query))Führen Sie die Codezelle aus.

Die Antwort sollte in etwa so aussehen:

Bereinigen

- In the Google Cloud console, go to the Manage resources page.

- In the project list, select the project that you want to delete, and then click Delete.

- In the dialog, type the project ID, and then click Shut down to delete the project.