ML.GENERATE_EMBEDDING 関数を使用してテキスト エンベディングを生成する

このドキュメントでは、エンベディング モデルを参照する BigQuery ML リモートモデルを作成する方法について説明します。次に、そのモデルを ML.GENERATE_EMBEDDING 関数で使用し、BigQuery の標準テーブルのデータを使用してテキスト エンベディングを作成します。

対応しているリモートモデルのタイプは次のとおりです。

必要なロール

リモートモデルを作成して ML.GENERATE_EMBEDDING 関数を使用するには、次の Identity and Access Management(IAM)ロールが必要です。

- BigQuery データセット、テーブル、モデルの作成と使用: プロジェクトに対する BigQuery データ編集者(

roles/bigquery.dataEditor)。 BigQuery 接続の作成、委任、使用: プロジェクトに対する BigQuery 接続管理者(

roles/bigquery.connectionsAdmin)。デフォルト接続が構成されていない場合は、

CREATE MODELステートメントの実行時に作成して設定できます。これを行うには、プロジェクトに対する BigQuery 管理者(roles/bigquery.admin)が必要です。詳細については、デフォルト接続を構成するをご覧ください。接続のサービス アカウントに権限を付与する: Vertex AI エンドポイントを含むプロジェクトに対するプロジェクト IAM 管理者(

roles/resourcemanager.projectIamAdmin)。これは、モデル名をエンドポイントとして指定して作成するリモートモデルの現在のプロジェクトです。これは、エンドポイントとして URL を指定して作成したリモートモデルの URL で識別されるプロジェクトです。BigQuery ジョブを作成する: プロジェクトに対する BigQuery ジョブユーザー(

roles/bigquery.jobUser)。

これらの事前定義ロールには、このドキュメントのタスクを実行するために必要な権限が含まれています。必要とされる正確な権限については、「必要な権限」セクションを開いてご確認ください。

必要な権限

- データセットを作成する:

bigquery.datasets.create - 接続を作成、委任、使用する:

bigquery.connections.* - サービス アカウントの権限を設定する:

resourcemanager.projects.getIamPolicyとresourcemanager.projects.setIamPolicy - モデルを作成して推論を実行する:

bigquery.jobs.createbigquery.models.createbigquery.models.getDatabigquery.models.updateDatabigquery.models.updateMetadata

- テーブルデータをクエリする:

bigquery.tables.getData

カスタムロールや他の事前定義ロールを使用して、これらの権限を取得することもできます。

始める前に

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the BigQuery, BigQuery Connection, and Vertex AI APIs.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles.

データセットを作成する

リソースを格納する BigQuery データセットを作成します。

コンソール

Google Cloud コンソールで、[BigQuery] ページに移動します。

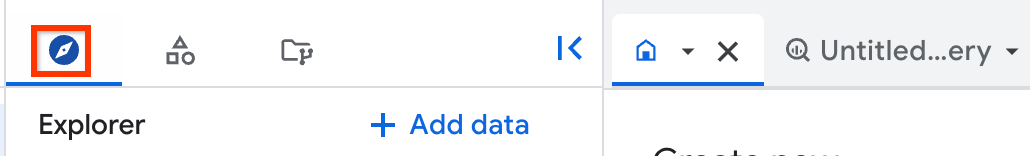

左側のペインで、 [エクスプローラ] をクリックします。

左側のペインが表示されていない場合は、 左側のペインを開くをクリックしてペインを開きます。

[エクスプローラ] ペインで、プロジェクト名をクリックします。

[アクションを表示] > [データセットを作成] をクリックします。

[データセットを作成する] ページで、次の操作を行います。

[データセット ID] に、データセットの名前を入力します。

[ロケーション タイプ] で、[リージョン] または [マルチリージョン] を選択します。

- [リージョン] を選択した場合は、[リージョン] リストからロケーションを選択します。

- [マルチリージョン] を選択した場合は、[マルチリージョン] リストから [US] または [ヨーロッパ] を選択します。

[データセットを作成] をクリックします。

bq

接続を作成する

デフォルトの接続が構成されているか、BigQuery 管理者ロールが付与されている場合は、この手順をスキップできます。

リモートモデルが使用する Cloud リソース接続を作成し、接続のサービス アカウントを取得します。前の手順で作成したデータセットと同じロケーションに接続を作成します。

次のオプションのいずれかを選択します。

コンソール

[BigQuery] ページに移動します。

[エクスプローラ] ペインで、[ データを追加] をクリックします。

![[データを追加] の UI 要素。](https://cloud-dot-devsite-v2-prod.appspot.com/static/bigquery/images/add-data.png?hl=ja)

[データを追加] ダイアログが開きます。

[フィルタ条件] ペインの [データソースのタイプ] セクションで、[ビジネス アプリケーション] を選択します。

または、[データソースを検索] フィールドに「

Vertex AI」と入力します。[特徴量データソース] セクションで、[Vertex AI] をクリックします。

[Vertex AI モデル: BigQuery フェデレーション] ソリューション カードをクリックします。

[接続タイプ] リストで、[Vertex AI リモートモデル、リモート関数、BigLake、Spanner(Cloud リソース)] を選択します。

[接続 ID] フィールドに接続の名前を入力します。

[接続を作成] をクリックします。

[接続へ移動] をクリックします。

[接続情報] ペインで、次の手順で使用するサービス アカウント ID をコピーします。

bq

コマンドライン環境で接続を作成します。

bq mk --connection --location=REGION --project_id=PROJECT_ID \ --connection_type=CLOUD_RESOURCE CONNECTION_ID

--project_idパラメータは、デフォルト プロジェクトをオーバーライドします。次のように置き換えます。

REGION: 接続のリージョンPROJECT_ID: 実際の Google Cloud プロジェクト IDCONNECTION_ID: 接続の ID

接続リソースを作成すると、BigQuery は、一意のシステム サービス アカウントを作成し、それを接続に関連付けます。

トラブルシューティング: 次の接続エラーが発生した場合は、Google Cloud SDK を更新します。

Flags parsing error: flag --connection_type=CLOUD_RESOURCE: value should be one of...

後の手順で使用するため、サービス アカウント ID を取得してコピーします。

bq show --connection PROJECT_ID.REGION.CONNECTION_ID

出力は次のようになります。

name properties 1234.REGION.CONNECTION_ID {"serviceAccountId": "connection-1234-9u56h9@gcp-sa-bigquery-condel.iam.gserviceaccount.com"}

Terraform

google_bigquery_connection リソースを使用します。

BigQuery に対する認証を行うには、アプリケーションのデフォルト認証情報を設定します。詳細については、クライアント ライブラリの認証を設定するをご覧ください。

次の例では、US リージョンに my_cloud_resource_connection という名前の Cloud リソース接続を作成します。

Google Cloud プロジェクトで Terraform 構成を適用するには、次のセクションの手順を完了します。

Cloud Shell を準備する

- Cloud Shell を起動します。

-

Terraform 構成を適用するデフォルトの Google Cloud プロジェクトを設定します。

このコマンドは、プロジェクトごとに 1 回だけ実行する必要があります。これは任意のディレクトリで実行できます。

export GOOGLE_CLOUD_PROJECT=PROJECT_ID

Terraform 構成ファイルに明示的な値を設定すると、環境変数がオーバーライドされます。

ディレクトリを準備する

Terraform 構成ファイルには独自のディレクトリ(ルート モジュールとも呼ばれます)が必要です。

-

Cloud Shell で、ディレクトリを作成し、そのディレクトリ内に新しいファイルを作成します。ファイルの拡張子は

.tfにする必要があります(例:main.tf)。このチュートリアルでは、このファイルをmain.tfとします。mkdir DIRECTORY && cd DIRECTORY && touch main.tf

-

チュートリアルを使用している場合は、各セクションまたはステップのサンプルコードをコピーできます。

新しく作成した

main.tfにサンプルコードをコピーします。必要に応じて、GitHub からコードをコピーします。Terraform スニペットがエンドツーエンドのソリューションの一部である場合は、この方法をおすすめします。

- 環境に適用するサンプル パラメータを確認し、変更します。

- 変更を保存します。

-

Terraform を初期化します。これは、ディレクトリごとに 1 回だけ行います。

terraform init

最新バージョンの Google プロバイダを使用する場合は、

-upgradeオプションを使用します。terraform init -upgrade

変更を適用する

-

構成を確認して、Terraform が作成または更新するリソースが想定どおりであることを確認します。

terraform plan

必要に応じて構成を修正します。

-

次のコマンドを実行します。プロンプトで「

yes」と入力して、Terraform 構成を適用します。terraform apply

Terraform に「Apply complete!」というメッセージが表示されるまで待ちます。

- Google Cloud プロジェクトを開いて結果を表示します。 Google Cloud コンソールの UI でリソースに移動して、Terraform によって作成または更新されたことを確認します。

リモートモデル接続のサービス アカウントにロールを付与する

接続のサービス アカウントに Vertex AI ユーザーロールを付与する必要があります。

リモートモデルの作成時にエンドポイントを URL(endpoint = 'https://us-central1-aiplatform.googleapis.com/v1/projects/myproject/locations/us-central1/publishers/google/models/text-embedding-005' など)として指定する場合は、URL に指定する同じプロジェクト内でこのロールを付与してください。

リモートモデルの作成時にモデル名(endpoint = 'text-embedding-005' など)を使用してエンドポイントを指定する場合は、リモートモデルを作成するプロジェクト内でこのロールを付与してください。

別のプロジェクトでロールを付与すると、「bqcx-1234567890-wxyz@gcp-sa-bigquery-condel.iam.gserviceaccount.com does not have the permission to access resource」というエラーが発生します。

ロールを付与する手順は次のとおりです。

コンソール

[IAM と管理] ページに移動します。

[アクセスを許可] をクリックします。

[プリンシパルを追加] ダイアログが開きます。

[新しいプリンシパル] フィールドに、前の手順でコピーしたサービス アカウント ID を入力します。

[ロールを選択] フィールドで、[Vertex AI] を選択し、[Vertex AI ユーザー] を選択します。

[保存] をクリックします。

gcloud

gcloud projects add-iam-policy-binding コマンドを実行します。

gcloud projects add-iam-policy-binding 'PROJECT_NUMBER' --member='serviceAccount:MEMBER' --role='roles/aiplatform.user' --condition=None

次のように置き換えます。

PROJECT_NUMBER: プロジェクトの番号MEMBER: 先ほどコピーしたサービス アカウント ID

オープンモデルのデプロイ方法を選択する

サポートされているオープンモデルでリモートモデルを作成する場合は、CREATE MODEL ステートメントで Vertex AI Model Garden または Hugging Face モデル ID を指定することで、リモートモデルの作成と同時にオープンモデルを自動的にデプロイできます。または、最初にオープンモデルを手動でデプロイし、CREATE MODEL ステートメントでモデル エンドポイントを指定して、そのオープンモデルをリモートモデルで使用することもできます。詳細については、オープンモデルをデプロイするをご覧ください。

BigQuery ML リモートモデルを作成する

リモートモデルを作成します。

新しいオープンモデル

Google Cloud コンソールで、[BigQuery] ページに移動します。

SQL エディタを使用してリモートモデルを作成します。

CREATE OR REPLACE MODEL `PROJECT_ID.DATASET_ID.MODEL_NAME` REMOTE WITH CONNECTION {DEFAULT | `PROJECT_ID.REGION.CONNECTION_ID`} OPTIONS ( {HUGGING_FACE_MODEL_ID = 'HUGGING_FACE_MODEL_ID' | MODEL_GARDEN_MODEL_NAME = 'MODEL_GARDEN_MODEL_NAME'} [, HUGGING_FACE_TOKEN = 'HUGGING_FACE_TOKEN' ] [, MACHINE_TYPE = 'MACHINE_TYPE' ] [, MIN_REPLICA_COUNT = MIN_REPLICA_COUNT ] [, MAX_REPLICA_COUNT = MAX_REPLICA_COUNT ] [, RESERVATION_AFFINITY_TYPE = {'NO_RESERVATION' | 'ANY_RESERVATION' | 'SPECIFIC_RESERVATION'} ] [, RESERVATION_AFFINITY_KEY = 'compute.googleapis.com/reservation-name' ] [, RESERVATION_AFFINITY_VALUES = RESERVATION_AFFINITY_VALUES ] [, ENDPOINT_IDLE_TTL = ENDPOINT_IDLE_TTL ] );

次のように置き換えます。

PROJECT_ID: プロジェクト ID。DATASET_ID: モデルを保存するデータセットの ID。このデータセットは、使用している接続と同じロケーションに存在する必要があります。MODEL_NAME: モデルの名前。REGION: 接続で使用されるリージョン。CONNECTION_ID: BigQuery 接続の ID。この値は、 Google Cloud コンソールで接続の詳細を表示し、[接続 ID] に表示される完全修飾された接続 ID の最後のセクションの値をコピーすることで取得できます。例:

projects/myproject/locations/connection_location/connections/myconnection。HUGGING_FACE_MODEL_ID: サポートされている Hugging Face モデルのモデル ID をprovider_name/model_name形式で指定するSTRING値。例:deepseek-ai/DeepSeek-R1。モデル ID を取得するには、Hugging Face Model Hub でモデル名をクリックし、モデルカードの上部からモデル ID をコピーします。MODEL_GARDEN_MODEL_NAME:STRING値。サポートされている Vertex AI Model Garden モデルのモデル ID とモデル バージョンをpublishers/publisher/models/model_name@model_version形式で指定します。例:publishers/openai/models/gpt-oss@gpt-oss-120b。モデル ID を取得するには、Vertex AI Model Garden でモデルカードをクリックし、[モデル ID] フィールドからモデル ID をコピーします。デフォルトのモデル バージョンを取得するには、モデルカードの [バージョン] フィールドからコピーします。使用できる他のモデル バージョンを確認するには、[モデルをデプロイ] をクリックし、[リソース ID] フィールドをクリックします。HUGGING_FACE_TOKEN: 使用する Hugging Face ユーザー アクセス トークンを指定するSTRING値。このオプションの値を指定できるのは、HUGGING_FACE_MODEL_IDオプションの値も指定した場合のみです。トークンには少なくとも

readロールが必要です。より広範なスコープを持つトークンも使用できます。このオプションは、HUGGING_FACE_MODEL_ID値で識別されるモデルが Hugging Face のゲート付きモデルまたは非公開モデルの場合に必要です。一部のゲート付きモデルでは、アクセス権が付与される前に、利用規約への明示的な同意が必要です。これらの条件に同意する手順は次のとおりです。

- Hugging Face ウェブサイトでモデルのページに移動します。

- モデルの利用規約を確認します。サービス契約へのリンクは通常、モデルカードにあります。

- ページに表示される指示に沿って利用規約に同意します。

MACHINE_TYPE: モデルを Vertex AI にデプロイするときに使用するマシンタイプを指定するSTRING値。サポートされているマシンタイプについては、マシンタイプをご覧ください。MACHINE_TYPEオプションの値を指定しない場合、モデルの Vertex AI Model Garden のデフォルトのマシンタイプが使用されます。MIN_REPLICA_COUNT: Vertex AI エンドポイントにモデルをデプロイするときに使用されるマシンレプリカの最小数を指定するINT64値。このサービスは、エンドポイントの推論負荷に応じてレプリカ数を増減します。使用されるレプリカの数は、MIN_REPLICA_COUNTの値より小さくなることも、MAX_REPLICA_COUNTの値より大きくなることもありません。MIN_REPLICA_COUNT値は[1, 4096]の範囲内である必要があります。デフォルト値は1です。MAX_REPLICA_COUNT: Vertex AI エンドポイントにモデルをデプロイするときに使用されるマシンレプリカの最大数を指定するINT64値。このサービスは、エンドポイントの推論負荷に応じてレプリカ数を増減します。使用されるレプリカの数は、MIN_REPLICA_COUNTの値より小さくなることも、MAX_REPLICA_COUNTの値より大きくなることもありません。MAX_REPLICA_COUNT値は[1, 4096]の範囲内である必要があります。デフォルト値はMIN_REPLICA_COUNT値です。RESERVATION_AFFINITY_TYPE: デプロイされたモデルが Compute Engine の予約を使用して、予測の提供時に仮想マシン(VM)の可用性を保証するかどうかを決定します。また、モデルが使用可能なすべての予約の VM を使用するか、特定の予約の VM のみを使用するかを指定します。詳細については、Compute Engine の予約アフィニティをご覧ください。Vertex AI と共有されている Compute Engine 予約のみを使用できます。詳細については、予約の使用を許可するをご覧ください。

サポートされている値は次のとおりです。

NO_RESERVATION: モデルが Vertex AI エンドポイントにデプロイされている場合、予約は消費されません。NO_RESERVATIONを指定すると、予約アフィニティを指定しない場合と同じ効果があります。ANY_RESERVATION: Vertex AI モデルのデプロイでは、現在のプロジェクト内にあるか、プロジェクトと共有されている、自動使用用に構成されている Compute Engine 予約から仮想マシン(VM)が使用されます。次の条件を満たす VM のみが使用されます。MACHINE_TYPE値で指定されたマシンタイプを使用します。- リモートモデルを作成する BigQuery データセットが単一リージョンにある場合は、予約も同じリージョンに存在する必要があります。データセットが

USマルチリージョンにある場合、予約はus-central1リージョンに存在する必要があります。データセットがEUマルチリージョンにある場合、予約はeurope-west4リージョンに存在する必要があります。

使用可能な予約に十分な容量がない場合、または適切な予約が見つからない場合、システムはリソース要件を満たすオンデマンドの Compute Engine VM をプロビジョニングします。

SPECIFIC_RESERVATION: Vertex AI モデルのデプロイでは、RESERVATION_AFFINITY_VALUES値で指定した予約の VM のみが使用されます。この予約は、特定の使用量を対象とするように構成する必要があります。指定された予約に十分な容量がない場合、デプロイは失敗します。

RESERVATION_AFFINITY_KEY: 文字列compute.googleapis.com/reservation-name。RESERVATION_AFFINITY_TYPE値がSPECIFIC_RESERVATIONの場合は、このオプションを指定する必要があります。RESERVATION_AFFINITY_VALUES: Compute Engine 予約の完全なリソース名を指定するARRAY<STRING>値。形式は

projects/myproject/zones/reservation_zone/reservations/reservation_nameです。例:

RESERVATION_AFFINITY_values = ['projects/myProject/zones/us-central1-a/reservations/myReservationName']予約名とゾーンは、 Google Cloud コンソールの [予約] ページで取得できます。詳細については、予約を表示するをご覧ください。

RESERVATION_AFFINITY_TYPE値がSPECIFIC_RESERVATIONの場合は、このオプションを指定する必要があります。ENDPOINT_IDLE_TTL: オープンモデルが Vertex AI エンドポイントから自動的にデプロイ解除されるまでの非アクティブ期間を指定するINTERVAL値。自動デプロイ解除を有効にするには、390 分(6.5 時間)から 7 日の間で間隔リテラルの値を指定します。たとえば、8 時間アイドル状態になった後にモデルをデプロイ解除するには、

INTERVAL 8 HOURを指定します。デフォルト値は 390 分(6.5 時間)です。モデルの非アクティブ状態とは、モデルに対して次のいずれかのオペレーションが実行されてから経過した時間です。

CREATE MODELステートメントを実行します。DEPLOY_MODEL引数をTRUEに設定してALTER MODELステートメントを実行します。- モデル エンドポイントに推論リクエストを送信する。たとえば、

ML.GENERATE_EMBEDDING関数またはML.GENERATE_TEXT関数を実行します。

これらのオペレーションを行うと、非アクティブ タイマーがゼロにリセットされます。リセットは、オペレーションを実行する BigQuery ジョブの開始時にトリガーされます。

モデルがデプロイ解除されると、モデルに送信された推論リクエストはエラーを返します。BigQuery モデル オブジェクトは、モデル メタデータを含め、変更されません。推論にモデルを再度使用するには、モデルで

ALTER MODELステートメントを実行し、DEPLOY_MODELオプションをTRUEに設定して、モデルを再デプロイする必要があります。

デプロイされたオープンモデル

Google Cloud コンソールで、[BigQuery] ページに移動します。

SQL エディタを使用してリモートモデルを作成します。

CREATE OR REPLACE MODEL `PROJECT_ID.DATASET_ID.MODEL_NAME` REMOTE WITH CONNECTION {DEFAULT | `PROJECT_ID.REGION.CONNECTION_ID`} OPTIONS ( ENDPOINT = 'https://ENDPOINT_REGION-aiplatform.googleapis.com/v1/projects/ENDPOINT_PROJECT_ID/locations/ENDPOINT_REGION/endpoints/ENDPOINT_ID' );

次のように置き換えます。

PROJECT_ID: プロジェクト ID。DATASET_ID: モデルを保存するデータセットの ID。このデータセットは、使用している接続と同じロケーションに存在する必要があります。MODEL_NAME: モデルの名前。REGION: 接続で使用されるリージョン。CONNECTION_ID: BigQuery 接続の ID。この値は、 Google Cloud コンソールで接続の詳細を表示し、[接続 ID] に表示される完全修飾された接続 ID の最後のセクションの値をコピーすることで取得できます。例:

projects/myproject/locations/connection_location/connections/myconnection。ENDPOINT_REGION: オープンモデルがデプロイされているリージョン。ENDPOINT_PROJECT_ID: オープンモデルがデプロイされているプロジェクト。ENDPOINT_ID: オープンモデルで使用される HTTPS エンドポイントの ID。エンドポイント ID は、[オンライン予測] ページでオープンモデルを探して、その [ID] フィールドの値をコピーすることで取得できます。

その他のすべてのモデル

Google Cloud コンソールで、[BigQuery] ページに移動します。

SQL エディタを使用してリモートモデルを作成します。

CREATE OR REPLACE MODEL `PROJECT_ID.DATASET_ID.MODEL_NAME` REMOTE WITH CONNECTION {DEFAULT | `PROJECT_ID.REGION.CONNECTION_ID`} OPTIONS (ENDPOINT = 'ENDPOINT');

次のように置き換えます。

PROJECT_ID: プロジェクト ID。DATASET_ID: モデルを保存するデータセットの ID。このデータセットは、使用している接続と同じロケーションに存在する必要があります。MODEL_NAME: モデルの名前。REGION: 接続で使用されるリージョン。CONNECTION_ID: BigQuery 接続の ID。この値は、 Google Cloud コンソールで接続の詳細を表示し、[接続 ID] に表示される完全修飾された接続 ID の最後のセクションの値をコピーすることで取得できます。例:

projects/myproject/locations/connection_location/connections/myconnection。ENDPOINT: 使用するエンベディング モデルの名前。詳細については、ENDPOINTをご覧ください。指定する Vertex AI モデルは、リモートモデルを作成するロケーションで使用できる必要があります。詳細については、ロケーションをご覧ください。

テキスト エンベディングを生成する

テーブル列またはクエリのテキストデータを使用して、ML.GENERATE_EMBEDDING 関数でテキスト エンベディングを生成します。

通常、テキストのみのユースケースにはテキスト エンベディング モデルを使用し、クロスモーダル検索のユースケースにはマルチモーダル エンベディング モデルを使用します。ここで、テキストとビジュアル コンテンツのエンベディングは、同じセマンティック空間に生成されます。

Vertex AI テキスト

Vertex AI テキスト エンベディング モデルでリモートモデルを使用してテキスト エンベディングを生成します。

SELECT * FROM ML.GENERATE_EMBEDDING( MODEL `PROJECT_ID.DATASET_ID.MODEL_NAME`, {TABLE PROJECT_ID.DATASET_ID.TABLE_NAME | (CONTENT_QUERY)}, STRUCT(FLATTEN_JSON AS flatten_json_output, TASK_TYPE AS task_type, OUTPUT_DIMENSIONALITY AS output_dimensionality) );

次のように置き換えます。

PROJECT_ID: プロジェクト ID。DATASET_ID: モデルを保存するデータセットの ID。MODEL_NAME: エンベディング モデルのリモートモデルの名前。TABLE_NAME: 埋め込むテキストを含むテーブルの名前。このテーブルには、contentという名前の列が必要です。または、エイリアスを使用して別の名前の列を使用することもできます。CONTENT_QUERY: 結果にcontentというSTRING列が含まれるクエリ。FLATTEN_JSON: エンベディングを別の列にパースするかどうかを示すBOOL値。デフォルト値はTRUEです。TASK_TYPE: モデルが質の高いエンベディングを生成できるように、対象のダウンストリーム アプリケーションを指定するSTRINGリテラル。TASK_TYPEには、次の値を使用できます。RETRIEVAL_QUERY: 指定したテキストが検索または取得設定のクエリであることを指定します。RETRIEVAL_DOCUMENT: 指定したテキストが検索または取得設定のドキュメントであることを指定します。このタスクタイプを使用する場合は、エンベディングの品質を改善するために、クエリ ステートメントにドキュメントのタイトルを含めることをおすすめします。ドキュメントのタイトルは、

titleという名前の列か、titleというエイリアスの列に含まれている必要があります。次に例を示します。SELECT * FROM ML.GENERATE_EMBEDDING( MODEL

mydataset.embedding_model, (SELECT abstract as content, header as title, publication_number FROMmydataset.publications), STRUCT(TRUE AS flatten_json_output, 'RETRIEVAL_DOCUMENT' as task_type) );入力クエリで title 列を指定すると、モデルに送信されるリクエスト本文の

titleフィールドに値が入力されます。他のタスクタイプを使用しているときにtitle値を指定すると、その入力は無視され、エンベディング結果には影響しません。SEMANTIC_SIMILARITY: 指定したテキストが意味論的テキスト類似性(STS)で使用されることを指定します。CLASSIFICATION: エンベディングを分類に使用することを指定します。CLUSTERING: エンベディングをクラスタ化に使用することを指定します。QUESTION_ANSWERING: エンベディングを質問応答に使用することを指定します。FACT_VERIFICATION: エンベディングを事実確認に使用することを指定します。CODE_RETRIEVAL_QUERY: エンベディングをコード取得に使用することを指定します。

OUTPUT_DIMENSIONALITY: エンベディングの生成時に使用する次元の数を指定するINT64値。たとえば、256 AS output_dimensionalityを指定すると、ml_generate_embedding_result出力列には、入力値ごとに 256 個のエンベディングが含まれます。gemini-embedding-001モデルのリモートモデルの場合、OUTPUT_DIMENSIONALITYの値は[1, 3072]の範囲内である必要があります。デフォルト値は3072です。text-embeddingモデルまたはtext-multilingual-embeddingモデルのリモートモデルの場合、OUTPUT_DIMENSIONALITYの値は[1, 768]の範囲内である必要があります。デフォルト値は768です。text-embeddingモデルでリモートモデルを使用している場合、text-embeddingモデルのバージョンはtext-embedding-004以降である必要があります。text-multilingual-embeddingモデルでリモートモデルを使用している場合、text-multilingual-embeddingモデルのバージョンはtext-multilingual-embedding-002以降である必要があります。

例: テーブルにテキストを埋め込む

次の例は、text_data テーブルの content 列への埋め込みリクエストを示しています。

SELECT * FROM ML.GENERATE_EMBEDDING( MODEL `mydataset.embedding_model`, TABLE mydataset.text_data, STRUCT(TRUE AS flatten_json_output, 'CLASSIFICATION' AS task_type) );

自由回答

オープン エンベディング モデルでリモートモデルを使用してテキスト エンベディングを生成します。

SELECT * FROM ML.GENERATE_EMBEDDING( MODEL `PROJECT_ID.DATASET_ID.MODEL_NAME`, {TABLE PROJECT_ID.DATASET_ID.TABLE_NAME | (CONTENT_QUERY)}, STRUCT(FLATTEN_JSON AS flatten_json_output) );

次のように置き換えます。

PROJECT_ID: プロジェクト ID。DATASET_ID: モデルを保存するデータセットの ID。MODEL_NAME: エンベディング モデルのリモートモデルの名前。TABLE_NAME: 埋め込むテキストを含むテーブルの名前。このテーブルには、contentという名前の列が必要です。または、エイリアスを使用して別の名前の列を使用することもできます。CONTENT_QUERY: 結果にcontentというSTRING列が含まれるクエリ。FLATTEN_JSON: エンベディングを別の列にパースするかどうかを示すBOOL値。デフォルト値はTRUEです。

Vertex AI マルチモーダル

Vertex AI マルチモーダル エンベディング モデルでリモートモデルを使用してテキスト エンベディングを生成します。

SELECT * FROM ML.GENERATE_EMBEDDING( MODEL `PROJECT_ID.DATASET_ID.MODEL_NAME`, {TABLE PROJECT_ID.DATASET_ID.TABLE_NAME | (CONTENT_QUERY)}, STRUCT(FLATTEN_JSON AS flatten_json_output, OUTPUT_DIMENSIONALITY AS output_dimensionality) );

次のように置き換えます。

PROJECT_ID: プロジェクト ID。DATASET_ID: モデルを保存するデータセットの ID。MODEL_NAME:multimodalembedding@001モデルのリモートモデルの名前。TABLE_NAME: 埋め込むテキストを含むテーブルの名前。このテーブルには、contentという名前の列が必要です。または、エイリアスを使用して別の名前の列を使用することもできます。CONTENT_QUERY: 結果にcontentというSTRING列が含まれるクエリ。FLATTEN_JSON: 埋め込みを解析して別の列に変換するかどうかを示すBOOL。デフォルト値はTRUEです。OUTPUT_DIMENSIONALITY: エンベディングの生成時に使用する次元の数を指定するINT64値。有効な値は128、256、512、1408です。デフォルト値は1408です。たとえば、256 AS output_dimensionalityを指定すると、ml_generate_embedding_result出力列には、入力値ごとに 256 個のエンベディングが含まれます。

例: エンベディングを使用して意味的類似度をランク付けする

次の例では、映画レビューのコレクションを埋め込み、VECTOR_SEARCH 関数を使用してレビュー「This movie was average」へのコサイン距離順にそれらを並べ替えます。距離が短いほど、意味的類似性が高くなります。

ベクトル検索とベクトル インデックスの詳細については、ベクトル検索の概要をご覧ください。

CREATE TEMPORARY TABLE movie_review_embeddings AS ( SELECT * FROM ML.GENERATE_EMBEDDING( MODEL `bqml_tutorial.embedding_model`, ( SELECT "This movie was fantastic" AS content UNION ALL SELECT "This was the best movie I've ever seen!!" AS content UNION ALL SELECT "This movie was just okay..." AS content UNION ALL SELECT "This movie was terrible." AS content ), STRUCT(TRUE AS flatten_json_output) ) ); WITH average_review_embedding AS ( SELECT ml_generate_embedding_result FROM ML.GENERATE_EMBEDDING( MODEL `bqml_tutorial.embedding_model`, (SELECT "This movie was average" AS content), STRUCT(TRUE AS flatten_json_output) ) ) SELECT base.content AS content, distance AS distance_to_average_review FROM VECTOR_SEARCH( TABLE movie_review_embeddings, "ml_generate_embedding_result", (SELECT ml_generate_embedding_result FROM average_review_embedding), distance_type=>"COSINE", top_k=>-1 ) ORDER BY distance_to_average_review;

結果は次のようになります。

+------------------------------------------+----------------------------+ | content | distance_to_average_review | +------------------------------------------+----------------------------+ | This movie was just okay... | 0.062789813467745592 | | This movie was fantastic | 0.18579561313064263 | | This movie was terrible. | 0.35707466240930985 | | This was the best movie I've ever seen!! | 0.41844932504542975 | +------------------------------------------+----------------------------+

次のステップ

- テキストと画像のエンベディングを使用してテキストから画像へのセマンティック検索を行う方法について学習する。

- セマンティック検索と検索拡張生成(RAG)にテキスト エンベディングを使用する方法について学習する。