In diesem Planungsleitfaden finden SAP- und Google Cloud Administratoren die erforderlichen Informationen, um Replikationen von SAP-Daten in BigQuery mit der Version 2.9 (neueste) des BigQuery-Connector für SAP und SAP LT Replication Server zu planen.

In dieser Anleitung werden folgende Themen behandelt:

- Softwareanforderungen

- Sicherheit

- Netzwerk

- Leistungsplanung

- Optionen für Tabellen- und Feldzuordnung

- Supportlebenszyklus

Informationen zu Lösungsbeschleunigern für die SAP-Datenmodellierung in BigQuery finden Sie unter Google Cloud Cortex Framework.

Softwareanforderungen

In diesem Abschnitt werden die Softwareanforderungen für BigQuery-Connector für SAP beschrieben.

Sie können BigQuery-Connector für SAP in SAP LT Replication Server auf Google Cloud, lokal oder in öffentlichen Clouds wie AWS, Azure usw. installieren.

Anforderungen an die Version der SAP-Software

Die erforderlichen Versionen von SAP LT Replication Server und die SAP-Quellsysteme unterscheiden sich je nachdem, ob Sie SAP LT Replication Server auf seinem eigenen Server in einer eigenständigen Architektur oder im Quellsystem der ABAP-Anwendung in einer eingebetteten Architektur installieren.

Die SAP-Softwareanforderungen unterscheiden sich auch je nach dem SAP-System, das Sie als Datenquelle verwenden: SAP S/4HANA oder SAP ECC.

Wählen Sie den Tab aus, der Ihrem SAP-Quellsystem entspricht, um die SAP-Softwareversionen aufzurufen, mit denen Google Cloud BigQuery-Connector für SAP unterstützt:

S/4HANA

| Installationsarchitektur | System | Unterstützte Versionen | UI-Add-on (User Interface, Benutzeroberfläche) |

|---|---|---|---|

| Eigenständig | Quellsystem |

|

Achten Sie darauf, dass das UI-Add-on die neueste Version ist, die mit Ihrer SAP NetWeaver-Version kompatibel ist, wie von SAP empfohlen. /UI2/CL_JSON: PL12 oder höher. Informationen zur erforderlichen Mindestversion des UI-Add-ons finden Sie im Abschnitt „Support Package“ des SAP-Hinweises 22798102 – /UI2/CL_JSON corrections – PL12. Informationen zur Kompatibilität des UI-Add-ons mit SAP NetWeaver finden Sie unter: |

| SAP LT Replication Server-System |

|

||

| Eingebettet | Quellsystem |

|

ECC

| Installationsarchitektur | System | Unterstützte Versionen | UI-Add-on (User Interface, Benutzeroberfläche) |

|---|---|---|---|

| Eigenständig | Quellsystem |

|

Achten Sie darauf, dass das UI-Add-on die neueste Version ist, die mit Ihrer SAP NetWeaver-Version kompatibel ist, wie von SAP empfohlen. /UI2/CL_JSON: PL12 oder höher. Informationen zur erforderlichen Mindestversion des UI-Add-ons finden Sie im Abschnitt „Support Package“ des SAP-Hinweises 22798102 – /UI2/CL_JSON corrections – PL12. Informationen zur Kompatibilität des UI-Add-ons mit SAP NetWeaver finden Sie unter: |

| SAP LT Replication Server-System |

|

||

| Eingebettet | Quellsystem |

|

Anforderungen an das Betriebssystem

BigQuery-Connector für SAP unterstützt jedes Betriebssystem, das von SAP LT Replication Server unterstützt wird.

Welche Betriebssysteme von SAP LT Replication Server unterstützt werden, finden Sie in der SAP-Produktverfügbarkeitsmatrix.

Cloud-Rechnungskonto erforderlich

Obwohl BigQuery-Connector für SAP kostenlos angeboten wird, benötigen Sie ein Cloud-Rechnungskonto, um das Installationspaket zu erhalten.

Skalierbarkeit

Für sehr große Mengen, wie z. B. Milliarden von Datensätzen mit Millionen von Deltas, verwendet BigQuery-Connector für SAP Skalierungs- und Partitionierungsfunktionen von SAP LT Replication Server, um die Datenextraktion im großen Umfang zu parallelisieren. Weitere Informationen finden Sie im Leitfaden zur Größenbemessung für Ihre Version von SAP LT Replication Server im SAP-Hilfeportal.

Auf der Google Cloud Seite verwendet der BigQuery-Connector für SAP je nach Replikationspfad verschiedene Google Cloud -Dienste, um das Laden von Daten zu skalieren:

- Für die CDC-Replikation über Pub/Sub verwendet BigQuery-Connector für SAP die Pub/Sub API und die Storage Write API.

- Für die Replikation von Streamingdaten verwendet BigQuery-Connector für SAP die BigQuery Streaming API.

Unterstützte Replikationsquellen

BigQuery Connector für SAP unterstützt die meisten häufig verwendeten Anwendungs- und Datenbankquellsysteme, die von SAP LT Replication Server unterstützt werden.

Unterstützte SAP-Anwendungsquellen

Sie können Daten aus den von SAP LT Replication Server unterstützten SAP-Anwendungsquellen replizieren. BigQuery-Connector für SAP unterstützt die Hauptversionen wartungsgebundener Unternehmensanwendungen als Datenquellen sowie frühere Legacy-Anwendungen. Folgende SAP-Anwendungen werden unterstützt:

- SAP Business Suite 7

- S/4HANA

- In SAP NetWeaver ausgeführte SAP-Anwendungen

Zum Replizieren von Daten aus SAP Business Warehouse wird davon abgeraten, SAP LT Replication Server zu verwenden. Weitere Informationen von SAP finden Sie im SAP-Hinweis 2525755.

SAP Cloud-Anwendungen wie S/4HANA Cloud, SAP Ariba, SAP SuccessFactors und andere werden nicht unterstützt.

Unterstützte Datenquellen

Sie können nur transparente oder Clustertabellen replizieren.

BigQuery Connector für SAP unterstützt nicht die Replikations-Ansichten (SAP Core Data Services, CDS).

Im Information Design Tool wird BigQuery ab SAP BusinessObjects Business Intelligence 4.3 als Datenquelle unterstützt. Sie können gespeicherte Daten in BigQuery über die SAP BusinessObjects-Berichterstellungstools wie SAP BusinessObjects Web Intelligence und SAP Crystal Reports for Enterprise abfragen.

Weitere Informationen zum Kompatibilitätscheck finden Sie im SAP-Hinweis 2750723 – Support of Google BigQuery in SAP BI platform products.

Sicherheit

Wenn Sie die Sicherheit der Datenreplikation über SAP LT Replication Server in BigQuery implementieren, müssen Sie Sicherheitskontrollen in SAP LT Replication Server, dem SAP LT Replication Server-Hostbetriebssystem und inGoogle Cloudimplementieren.

Für die Kommunikation zwischen BigQuery-Connector für SAP und BigQuery verwendet BigQuery-Connector für SAP die End-to-End-HTTPS-Kommunikation und SSL.

SAP-Sicherheit

Mit der standardmäßigen rollenbasierten SAP-Autorisierung können Sie steuern, wer mit BigQuery-Connector für SAP in SAP LT Replication Server konfigurieren und arbeiten kann.

BigQuery-Connector für SAP stellt das Autorisierungsobjekt ZGOOG_MTID im Rahmen der Transportinstallation bereit.

Zum Konfigurieren und Ausführen von Datenreplikationsjobs, die BigQuery-Connector für SAP verwenden, können Sie eine Rolle definieren, die Administratorzugriff auf SAP LT Replication Server hat, wie unter SAP-Rollen und -Autorisierungen für BigQuery-Connector für SAP erstellen beschrieben.

Sie können beispielsweise eine Rolle mit dem Namen ZGOOGLE_BIGQUERY_ADMIN definieren, die alle SAP-Autorisierungen und die ZGOOG_MTID-Autorisierungen enthält, die zum Konfigurieren und Ausführen der Datenreplikation in BigQuery erforderlich sind. Verwenden Sie dazu BigQuery-Connector für SAP.

Weitere Informationen von SAP zu Rollen und Autorisierung finden Sie im Sicherheitsleitfaden für Ihre Version von SAP LT Replication Server im SAP-Hilfeportal.

Google Cloud Sicherheit

Die Implementierung von Sicherheit in Google Cloud für BigQuery-Connector für SAP kann die folgenden Sicherheitskontrollen umfassen:

- IAM-Berechtigungen (Identity and Access Management), Rollen, Dienstkonten und Schlüssel.

- BigQuery-Steuerelemente, die auf Dataset- oder Tabellenebene festgelegt werden.

- Virtual Private Cloud (VPC) Service Controls für API-basierte Dienste wie BigQuery

- Private Service Connect-Endpunkte, die einen privaten Verbrauch von Diensten wie BigQuery über VPC-Netzwerken hinweg ermöglichen.

Google Cloud Identitäts- und Zugriffsverwaltung

Zur Authentifizierung und Autorisierung von BigQuery-Connector für SAP benötigen Sie ein IAM-Dienstkonto für dasGoogle Cloud -Projekt mit dem BigQuery-Dataset.

Um mit Google Cloud -Ressourcen interagieren zu können, müssen Sie dem Dienstkonto Rollen zuweisen, die Berechtigungen zum Interagieren mit BigQuery- und Pub/Sub-Diensten umfassen.

Für die Replikation von Streamingdaten (nur Einfügen) sind die Berechtigungen, die BigQuery-Connector für SAP zum Zugreifen auf BigQuery benötigt, in den folgenden IAM-Rollen enthalten:

Für die CDC-Replikation (Change Data Capture) sind die Berechtigungen, die BigQuery-Connector für SAP zum Zugreifen auf Pub/Sub und BigQuery benötigt, in den folgenden IAM-Rollen enthalten:

Wenn SAP LT Replication Server auf einer Compute Engine-VM ausgeführt wird, müssen Sie dem Dienstkonto der Host-VM auch die Rolle Ersteller von Dienstkonto-Tokens zuweisen.

Wenn SAP LT Replication Server lokal oder auf einer anderen Cloud-Plattform ausgeführt wird, müssen Sie nicht nur ein Dienstkonto, sondern auch einen Dienstkontoschlüssel für BigQuery Connector für SAP erstellen. Ihr SAP-Administrator installiert den Schlüssel auf dem SAP LT Replication Server-Host. Wenn BigQuery-Connector für SAP eine Verbindung zu Pub/Sub oder BigQuery herstellt, verwendet SAP LT Replication Server den Dienstkontoschlüssel zur Authentifizierung inGoogle Cloud.

Wenn SAP LT Replication Server auf Google Cloudausgeführt wird, ist kein Dienstkontoschlüssel erforderlich.

Weitere Informationen zu IAM, Dienstkonten, Rollen und Berechtigungen finden Sie unter:

- Dienstkonten

- Als Dienstkonto authentifizieren

- Best Practices für Dienstkonten

- BigQuery API – Einführung in die Authentifizierung

Zugriffssteuerung für BigQuery-Datasets und -Tabellen

Zusätzlich zu IAM-Steuerelementen können Sie den Zugriff auch mit BigQuery steuern. Für BigQuery-Connector für SAP können Sie Zugriffssteuerungen für Datasets und Tabellen festlegen.

Weitere Informationen finden Sie unter:

VPC Service Controls

In Google Cloudgelten die VPC-Firewallregeln nicht für API-basierte Interaktionen mit BigQuery. Stattdessen können Sie den Traffic mithilfe von VPC Service Controls (Virtual Private Cloud) einschränken.

Wenn Ihre SAP-Arbeitslast in Google Cloudausgeführt wird, können Sie VPC Service Controls implementieren, indem Sie Dienstperimeter definieren. Weitere Informationen finden Sie unter Dienstperimeter.

Wenn Ihre SAP-Arbeitslast nicht auf Google Cloudausgeführt wird, können Sie VPC Service Controls im Rahmen der Einrichtung des privaten Google-Zugriffs für lokale Hosts implementieren.

Weitere Informationen zur Netzwerksicherheit für BigQuery finden Sie unter Netzwerksicherheit.

Private Service Connect-Endpunkte

Wenn Sie Endpunkte in Ihrem VPC-Netzwerk einrichten möchten, die eine private Nutzung von Google-verwalteten Diensten wie BigQuery ermöglichen, können Sie Private Service Connect verwenden.

Mit Private Service Connect können Sie private Endpunkte erstellen, die interne IP-Adressen aus einem VPC-CIDR-Bereich verwenden, um auf Google APIs und Dienste zuzugreifen. Sie können Private Service Connect auch verwenden, um einen benutzerdefinierten privaten DNS-Namen für die BigQuery Streaming API zu erstellen. Weitere Informationen finden Sie unter Private Service Connect.

Für BigQuery-Connector für SAP, der auf einem Host außerhalb vonGoogle Cloudausgeführt wird, wird Private Service Connect nicht unterstützt.

Weitere Informationen zur Sicherheit von Google Cloud

Weitere Informationen zu Sicherheitskonten, Rollen und Berechtigungen finden Sie unter:

- Dienstkonten

- Dienstkonten für Instanzen erstellen und aktivieren

- Datensicherheit und Data Governance

- BigQuery-Authentifizierung und -Autorisierung

Netzwerk

Beachten Sie bei der Planung des Netzwerkpfads für die Replikation in BigQuery Folgendes:

- Bandbreite

- Latenz und Auswirkungen auf den Ressourcenverbrauch auf dem SAP LT Replication Server-Host

- Datenvolumen und Auswirkungen auf die vorhandene Netzwerklast

- Wenn Ihre SAP-Arbeitslast nicht in Google Cloudausgeführt wird, welcher Verbindungstyp verwendet werden soll: Cloud Interconnect oder Cloud VPN

Verbindung zu Google Cloudwird hergestellt

Wenn Ihre SAP-Systeme nicht in Google Cloud ausgeführt werden und noch keine Verbindung von Ihren SAP-Systemen zu Google Cloudbesteht, müssen Sie eine Verbindung herstellen und den privaten Zugriff auf die Google Cloud APIs konfigurieren.

Sie können eine Verbindung zu Google Cloud über Cloud Interconnect oder Cloud VPN herstellen.

Cloud Interconnect bietet in der Regel eine höhere Bandbreite, eine geringere Latenz und weniger Netzwerkkonflikte als Cloud VPN. Für leistungsempfindliche Replikationsjobs mit hohem Volumen empfiehlt Google CloudCloud Interconnect für BigQuery-Connector für SAP.

Mit Cloud VPN werden die Replikationsdaten über das öffentliche Internet übertragen, sodass Netzwerkkonflikte weniger vorhersehbar und Latenzen in der Regel höher sind.

Unabhängig von der gewählten Verbindungsoption müssen Sie den gesamten Traffic prüfen, den die Verbindung voraussichtlich unterstützen muss. Prüfen Sie, ob die Verbindung über eine ausreichende Bandbreite und Netzwerkgeschwindigkeit verfügt, um die Replikationsjobs und andere Arbeitslasten ohne negative Auswirkungen auf die Leistung ausführen zu können.

Langsame Verbindungen können den Ressourcenverbrauch sowohl auf dem SAP-Quellserver als auch auf dem SAP LT Replication Server-Host erhöhen. Dies liegt daran, dass die Ausführung von Ressourcenjobs länger dauert, wodurch die für Replikationen erforderlichen Ressourcen für längere Zeiträume gebunden sind.

Weitere Informationen zu Verbindungsoptionen finden Sie hier:

Wenn Sie einen Proxyserver zum Senden der HTTP-Anfragen an Google Cloudverwenden möchten, empfehlen wir, RFC-Ziele zu verwenden, die in der Transaktion SM59 definiert sind.

RFC-Ziele

Die Transportdateien des BigQuery-Connector für SAP enthalten die folgenden Beispiel-RFC-Ziele in der Transaktion SM59. Diese RFC-Ziele sind HTTP-Verbindungen zu externen Servern (Typ G) und stellen eine Verbindung zum öffentlichen API-Endpunkt des jeweiligen Dienstes her.

| Beispielname für ein RFC-Ziel | Zielhost (API-Endpunkt) | Hinweise |

|---|---|---|

GOOG_BIGQUERY |

https://bigquery.googleapis.com |

Dieses RFC-Ziel zielt auf die BigQuery API ab. |

GOOG_PUBSUB |

https://pubsub.googleapis.com |

Dieses RFC-Ziel ist auf die Pub/Sub API ausgerichtet. |

GOOG_IAMCREDENTIALS |

https://iamcredentials.googleapis.com |

Dieses RFC-Ziel zielt auf die IAM API ab. |

GOOG_OAUTH2_TOKEN |

https://googleapis.com/oauth2 |

Dieses RFC-Ziel zielt auf den Google Cloud -Endpunkt für die OAuth 2.0-basierte Authentifizierung ab. Sie verwenden diese Option für SAP-Arbeitslasten, die außerhalb von Google Cloud ausgeführt werden, und nur, wenn Sie sich mit einem JSON-Web-Token (JWT) bei Google Cloud authentifizieren möchten. |

Die Verwendung von RFC-Zielen für die Verbindung zu Google Cloud bietet folgende Vorteile:

Wenn Sie in Ihrer SAP-Umgebung einen Proxyserver verwenden und damit HTTP-Anfragen an Google Cloudsenden möchten, können Sie den Proxyserver im RFC-Ziel konfigurieren.

Wenn Sie den Zugriff auf Google Cloud APIs und -Dienste über Private Service Connect-Endpunkte aktivieren möchten, können Sie diese Endpunkte in IhremGoogle Cloud -Projekt erstellen und dann die Endpunkte in Ihren RFC-Zielen angeben.

Sie können die HTTP-Komprimierung verwenden, die vonGoogle Cloud für regionenübergreifende Replikationen empfohlen wird, wobei Ihr SAP-Quellsystem und Ihr BigQuery-Dataset in verschiedenen Compute Engine-Regionen platziert werden.

Wenn Sie RFC-Ziele für die Verbindung mit Google Cloud APIs oder ‑Diensten verwenden möchten, müssen Sie Einträge in der Tabelle /GOOG/SERVIC_MAP erstellen, die die RFC-Ziele der Tabelle /GOOG/CLIENT_KEY zuordnen. Konfigurationsschritte finden Sie in der Installations- und Konfigurationsanleitung für BigQuery-Connector für SAP für Ihr Szenario.

HTTP-Komprimierung

Wenn Sie die Verbindung zwischen BigQuery-Connector für SAP und Google Cloud -APIs mit RFC-Zielen einrichten, können Sie das HTTP-Anfragetext mit der Option Komprimierung komprimieren. Die HTTP-Komprimierung ist nur verfügbar, wenn Sie Ihre RFC-Ziele für die Verwendung von HTTP 1.1 konfigurieren.

Bevor Sie die HTTP-Komprimierung in Ihrer Produktionsumgebung aktivieren, sollten Sie die Profilparameter, die sich auf die HTTP-Komprimierung auswirken, in einer Testumgebung analysieren. Weitere Informationen von SAP finden Sie im SAP-Hinweis 1037677 – HTTP-Komprimierung komprimiert nur bestimmte Dokumente.

Bandbreite

Achten Sie darauf, dass Ihre Netzwerkverbindung zwischen SAP LT Replication Server undGoogle Cloud über ausreichend Bandbreite verfügt, um Ihr Datenvolumen mit der erforderlichen Geschwindigkeit bewältigen zu können.

Langsame Netzwerkverbindungen erhöhen die Latenz der Datenreplikation, wodurch auch mehr Ressourcen bei der Replikation im SAP-Quellsystem verwendet werden.

Für produktive Installationen empfiehlt Google Cloud eine Cloud Interconnect-Verbindung. Sie können auch Cloud VPN verwenden.

Latenz

Um die Latenz über Ihre Netzwerkverbindung zu reduzieren, erstellen Sie das BigQuery-Ziel-Dataset so nah wie möglich am SAP LT Replication Server-System und dem SAP-Quellsystem. Wenn das SAP-Quellsystem auf Google Cloudausgeführt wird, erstellen Sie das BigQuery-Dataset in derselben Google Cloud Region wie das SAP-Quellsystem.

Testen Sie die Latenz, bevor Sie die Installation in eine Produktionsumgebung migrieren.

Weitere Informationen zur Netzwerkleistung finden Sie unter Leistung der Netzwerkverbindung.

Netzwerkzugriffssteuerung

Sie können Netzwerkzugriffssteuerung auf beiden Seiten der Verbindung zwischen SAP LT Replication Server und Google Cloudimplementieren.

Google Cloud Netzwerkzugriffssteuerung

BigQuery-Connector für SAP kommuniziert mit BigQuery über einen API-Endpunkt, der nicht den VPC-Firewallregeln von Google Cloudunterliegt.

Verwenden Sie stattdessen VPC Service Controls, um den Traffic zu beschränken.

Weitere Informationen zur Netzwerksicherheit für BigQuery finden Sie unter Netzwerksicherheit.

Netzwerkzugriffssteuerung für SAP LT Replication Server-Host

Auf dem SAP LT Replication Server-Host müssen Sie dafür sorgen, dass alle Firewalls oder Proxys ausgehenden Traffic vom Server zu den BigQuery- und Pub/Sub API-Endpunkten zulassen. Prüfen Sie insbesondere, ob Ihr SAP LT Replication Server auf die folgenden Google Cloud APIs zugreifen kann:

https://bigquery.googleapis.comhttps://pubsub.googleapis.comhttps://iamcredentials.googleapis.com

Wenn Sie über Private Service Connect-Endpunkte auf die BigQuery und Pub/Sub APIs zugreifen möchten, müssen Sie die Private Service Connect-Endpunkte in der Tabelle /GOOG/SERVIC_MAP konfigurieren.

Leistungsplanung

Die Leistung von anfänglichen Ladevorgängen und Replikationsjobs zwischen SAP LT Replication Server und BigQuery wird von mehreren Faktoren an verschiedenen Punkten im Replikationspfad beeinflusst.

Bestimmte grundlegende Faktoren wie die Entfernung zwischen SAP LT Replication Server und Ihrem BigQuery-Dataset oder die Bandbreite Ihrer Verbindung zu Google Cloudhaben jedoch einen größeren Einfluss auf die Leistung als die meisten anderen Faktoren.

Best Practices für Gesamtleistung

Beachten Sie die folgenden Empfehlungen bei der Konfiguration von SAP LT Replication Server, um eine optimale Leistung zu erzielen:

- Führen Sie Ihre SAP-Arbeitslast in Google Cloudaus, darunter das SAP-Quellsystem und SAP LT Replication Server.

- Wenn sich Ihre SAP-Arbeitslast in Google Cloudbefindet, erstellen Sie Ihr BigQuery-Dataset in derselben Region wie die SAP-Arbeitslast.

- Wenn Sie Ihre SAP-Arbeitslast nicht in Google Cloudausführen können:

- Erstellen Sie das BigQuery-Dataset in der Region Google Cloud, die der SAP-Arbeitslast am nächsten ist.

- Stellen Sie über Cloud Interconnect eine Verbindung zu Google Cloud her.

- Um Konflikte bei Ressourcen zu vermeiden, verwenden Sie separate dedizierte Hosts für das SAP-Quellsystem und SAP LT Replication Server.

- Passen Sie die Größe des SAP LT Replication Server-Systems für Ihre Arbeitslast optimal an. Folgen Sie dazu der Anleitung zur Größenbemessung Ihrer Version von SAP LT Replication Server im SAP-Hilfeportal.

- Verwenden Sie die folgenden Replikationseinstellungen für SAP LT Replication Server:

- Parallele Jobs.

- Lesetyp 1, sofern möglich. Weitere Informationen finden Sie unter Leistung und erweiterte LTRS-Replikationseinstellungen.

- Konfigurieren Sie BigQuery-Connector für SAP mit:

- Standardmäßiger Komprimierung von Datensätzen.

- Standard Block-Größe

- Vermeiden Sie nach Möglichkeit die Zuordnung von Feldern zu Ihrer BigQuery-Tabelle.

Weitere Informationen finden Sie unter:

- Leistungsaspekte von SAP LT Replication Server

- Leistung der Netzwerkverbindung

- Datenübertragung

- Datensatzkomprimierung

Weitere Merkmale, die sich auf die Leistung auswirken können

Viele Merkmale Ihrer Konfiguration und Daten können die Leistung beeinträchtigen. Einige dieser Merkmale können Sie möglicherweise nicht ändern. Dazu gehören:

- Auf dem Quellserver:

- Die Anzahl der CPUs.

- Die Menge an Arbeitsspeicher

- Die verwendete Datenbank, z. B. SAP HANA, SAP ASE oder IBM Db2.

- Die Anzahl der Spalten in der Quelltabelle

- Die Datenmenge, die in jedem Datensatz enthalten ist.

- Die Metadaten der Tabelle, z. B. die Länge der Feldnamen.

- Die Anzahl der Dialogarbeitsprozesse

- In SAP LT Replication Server:

- Die Anzahl der CPUs.

- Die Menge an Arbeitsspeicher

- Andere vom Host ausgeführte Arbeitslasten.

- SAP-Dialog und Arbeitsprozesse im Hintergrund.

- Die Art der Installationsarchitektur von SAP LT Replication Server. Weitere Informationen finden Sie unter Eigenständig (empfohlen) oder eingebettete Installation von SAP LT Replication Server.

- Die Anzahl der Hintergrundjobs, die auf dem SAP LT Replication Server-System ausgeführt werden.

- Die Anzahl der Hintergrundjobs, die der Massenübertragung auf dem Tab Verwaltung der

LTRC-Transaktion zugeordnet werden. - Die Einstellungen für die Transaktionsleistung

LTRS, einschließlich Lesetyp und Teilgröße.

- In der Konfiguration der BigQuery-Replikation (Transaktion

/GOOG/SLT_SETTINGS):- Gibt an, ob benutzerdefinierte Namen für die Zielfelder angegeben werden. Die Verarbeitung der BigQuery-Zielfeldnamen kann sich geringfügig auf die Leistung auswirken.

- Gibt an, ob die Datensatzkomprimierung aktiviert ist

- Blockgröße, die sich auf die Gesamtzahl der gesendeten HTTP-Anfragen auswirken kann.

Leistungsaspekte von SAP LT Replication Server

In den folgenden Abschnitten werden die Leistungsoptionen in Zusammenhang mit der Konfiguration von SAP LT Replication Server erläutert.

Leistung und Installationsarchitektur von SAP LT Replication Server

Eine eigenständige Architektur, in der SAP LT Replication Server auf einem eigenen dedizierten Server installiert ist, bietet in der Regel eine bessere Leistung als eine eingebettete Architektur, in der SAP LT Replication Server auf demselben Server wie das Quellsystem installiert ist.

In einer eingebetteten Architektur muss SAP LT Replication Server die Serverressourcen für das SAP-Quellsystem freigeben.

Selbst bei einer eigenständigen Architektur können die CPU und der Arbeitsspeicher des Hosts sowie alle anderen Arbeitslasten, die möglicherweise auf dem Server ausgeführt werden, die Leistung einer SAP LT Replication Server-Instanz beeinträchtigen.

Leistung und die erweiterten LTRS-Replikationseinstellungen

Die Leistung bei anfänglichen Ladevorgängen und bei der Replikation wird von den Einstellungen beeinflusst, die Sie für die Quelltabelle in der LTRS-Transaktion unter Erweiterte Replikationseinstellungen angeben.

Anleitungen zur Leistungsoptimierung, insbesondere zur Optimierung der anfänglichen Ladevorgänge oder der Replikation, finden Sie im Leitfaden zur Leistungsoptimierung von SAP LT Replication Server im SAP-Hilfeportal.

Google Cloud empfiehlt die folgenden Angaben im Abschnitt Erweiterte Replikationseinstellungen > Gesamtleistung der LTRS-Transaktion:

Für anfängliche Ladevorgänge der meisten Tabellentypen geben Sie 1 Bereichsberechnung als Lesetyp an. Geben Sie für Tabellen, die zu groß für 1 Bereichsberechnung sind, Lesetyp 5 an.

Legen Sie unter Aktive Einstellungen folgende Replikationseinstellungen fest:

- Für möglichst schnelle Replikationen geben Sie Automatische Bereiche an.

- Für zuverlässige Replikationen geben Sie Keine Bereiche an.

In der folgenden Tabelle werden Einstellungen für einige gängige Szenarien vorgeschlagen.

| Tabellentyp | Empfohlener Lesetyp |

|---|---|

| Transparent (klein bis mittel) | Lesetyp 1 – Bereichsberechnung |

| Transparent (groß) | Nur wenn Lesetyp 1 nicht funktioniert, Lesetyp 5 – Bereichsberechnung |

| Clustertabelle | Lesetyp 4 – Senderwarteschlange |

Leistung der Netzwerkverbindung

Die Bandbreite und die Latenz der Verbindung zwischen dem SAP LT Replication Server-System und Google Cloud können sich auf die Gesamtleistung der Replikation in BigQuery auswirken.

Die Auswirkungen betreffen nicht nur die Replikationsgeschwindigkeit, sondern auch die Menge der von SAP LT Replication Server und dem Quellsystem verbrauchten Ressourcen: Je länger es dauert, bis die Bestätigung der Replikation von BigQuery eingeht, desto länger verbleiben die Hostressourcen in SAP LT Replication Server und im Quellsystem.

Wenn Ihre SAP-Arbeitslast lokal oder bei einem anderen Cloud-Anbieter ausgeführt wird, empfiehltGoogle Cloud die Verwendung einer Cloud Interconnect-Verbindung, die eine hohe Bandbreite und eine niedrige Latenz bietet, ohne mit dem Traffic im öffentlichen Internet zu konkurrieren.

Sie können Cloud VPN verwenden, um eine Verbindung zu Google Cloud und BigQuery herzustellen. Bei einer VPN-Verbindung müssen die Replikationen jedoch mit dem allgemeinen Internettraffic konkurrieren.

Wenn Ihre SAP-Arbeitslast auf Google Cloudausgeführt wird, empfiehlt Google Cloud, SAP LT Replication Server und Ihr BigQuery-Dataset in derselben Region zu platzieren. Wenn sich SAP LT Replication Server und BigQuery in verschiedenen Regionen befinden, ist die Latenz in der Regel höher und die Leistung ist in der Regel schlechter. Weitere Informationen zur Auswahl einer Region finden Sie unter Region und Zone auswählen.

Datenübertragung

Im Allgemeinen sollten Sie so viele Daten wie möglich in jeder HTTP-Anfrage senden, um die Gesamtzahl der HTTP-Anfragen und den zugehörigen Verarbeitungsaufwand zu reduzieren.

In einigen Fällen müssen Sie jedoch die gesendete Datenmenge reduzieren, entweder aufgrund der Größe der Datensätze in einer bestimmten Tabelle oder weil Sie eine Kontingentgrenze oder ein anderes Limit in Pub/Sub oder BigQuery erreichen.

Sie können die bei jeder Anfrage gesendete Datenmenge so steuern:

- Passen Sie die Datenmenge (die Teilgröße) an, die SAP LT Replication Server an BigQuery-Connector für SAP sendet.

- Passen Sie die Datenmenge (die Blockgröße) an, die BigQuery-Connector für SAP an BigQuery sendet.

- Passen Sie die Kontingente für Streaming-Insert-Anweisungen in Ihrem BigQuery-Projekt an.

Von SAP LT Replication Server gesendete Datenmenge anpassen

SAP LT Replication Server sendet Datensätze vom Quellsystem an BigQuery-Connector für SAP in Teilen. Jeder Teil wird als separater Lade- oder Replikationsjob behandelt, der Serverressourcen bis zu seiner Fertigstellung verbraucht.

Wenn Sie die Teilgröße von SAP LT Replication Server anpassen möchten, verringern Sie die Anzahl der SAP LT Replication Server-Prozesse sowie den damit verbundenen Aufwand.

Teilgröße und Blockgröße

Teile von SAP LT Replication Servers sind in Byte oder als Produkt aus Byte und Datensätzen dimensioniert. Die Größe von BigQuery-Connector für SAP-Blöcke wird anhand der Anzahl der darin enthaltenen Datensätze bestimmt. Die Bytegröße eines Blocks hängt von verschiedenen Faktoren ab, einschließlich der Anzahl der Felder und der Datenmenge in jedem Datensatz.

Wenn die Größe des SAP LT Replication Server-Teils größer ist als die Größe des BigQuery-Connector für SAP-Teils, sendet BigQuery-Connector für SAP mehrere Blöcke für jeden Teil, bis alle Datensätze aus dem Teil gesendet wurden.

Wenn die Größe des Teils kleiner als die Blockgröße ist, sendet BigQuery-Connector für SAP nur einen Block pro Teil. Jeder Block enthält nur die Anzahl der Datensätze, die in jedem Teil gesendet werden, unabhängig von der Größe, die in BigQuery-Connector für SAP festgelegt ist.

Legen Sie idealerweise eine Teilgröße in SAP LT Replication Server fest, mit der BigQuery-Connector für SAP möglichst große Blöcke erstellen kann, ohne das Pub/Sub- oder BigQuery-Limit für die Anzahl der Byte in den einzelnen HTTP-Anfragen zu überschreiten.

Eine Anleitung zur Festlegung der Blockgröße finden Sie unter Blockgröße in BigQuery-Connector für SAP.

Teilgröße in SAP LT Replication Server

Führen Sie die LTRS-Transaktion aus, um die von SAP LT Replication Server verwendete Standardgröße zu ändern, und passen Sie den Wert im Feld Paketgröße in Erweiterte Replikationseinstellungen unter Leistungsoptionen an.

Weitere Informationen finden Sie im Leitfaden zur Leistungsoptimierung von SAP LT Replication Server im SAP-Hilfeportal.

Blockgröße in BigQuery-Connector für SAP

BigQuery-Connector für SAP sendet Daten als Datensatzblöcke an BigQuery.

Für die CDC-Replikation über Pub/Sub empfehlen wir, die standardmäßige Blockgröße mit BigQuery-Connector für SAP zu verwenden, also 1.000 Datensätze. Dies ist die maximale Anzahl von Datensätzen, die von Pub/Sub zugelassen werden.

Für die Streaming-Datenreplikation empfehlen wir, die standardmäßige Blockgröße mit BigQuery-Connector für SAP zu verwenden, also 10.000 Einträge. Wenn die Datensätze in einer Quelltabelle jedoch sehr wenige Felder enthalten oder die Felder sehr kleine Datenwerte enthalten, können Sie eine größere Blockgröße bis zur maximalen Blockgröße verwenden, die BigQuery zulässt, also 50.000 Datensätze.

Wenn die Anzahl der Datensätze in einem bestimmten Block in eine Bytegröße aufgelöst wird, die das zulässige Limit für die Bytegröße für HTTP-Anfragen überschreitet, erhalten Sie entweder den Fehler quotaExceeded oder invalid.

Dies kann passieren, wenn die Datensätze in einer Quelltabelle viele Felder enthalten oder die Felder viele Daten enthalten.

Wenn ein Fehler im Zusammenhang mit der Blockgröße auftritt, reduzieren Sie die Blockgröße, die in der Konfiguration der Massenübertragung für diese Tabelle angegeben ist. Alternativ können Sie die dynamische Blockgröße für diese Tabelle aktivieren, um die Blockgröße automatisch anpassen zu lassen. Weitere Informationen finden Sie unter Dynamische Blockgröße.

Wenn Sie die dynamische Blockgröße nicht aktiviert haben, müssen Sie für SAP-Quelltabellen wie MSEG, ACDOCA und MATDOC, die große Datensätze mit vielen Feldern pro Datensatz enthalten können, eventuell eine niedrigere Blockgröße angeben.

Führen Sie die /GOOG/SLT_SETTINGS-Transaktion aus, um eine Blockgröße anzugeben. Die Blockgröße wird im Feld Blockgröße auf dem Bildschirm der Tabellenattribute angegeben.

Weitere Informationen zum Festlegen der Blockgröße finden Sie unter:

- Informationen zur CDC-Replikation über Pub/Sub finden Sie unter Tabellenerstellung und andere allgemeine Attribute angeben.

- Informationen zur Streamingdatenreplikation finden Sie unter Tabellenerstellung und andere allgemeine Attribute angeben.

Weitere Informationen zu BigQuery-Fehlermeldungen finden Sie unter Fehlermeldungen.

Mit dem Senden von Teilen verbundener Verarbeitungsaufwand

Jeder gesendete Teil löst die folgenden Aktionen aus, von denen jede einen gewissen Verarbeitungsaufwand oder Ressourcenverbrauch verursacht:

- Eine Sammlung geänderter Datensätze in der Logging-Tabelle im Quellsystem wird in einem einzigen Teil an SAP LT Replication Server gesendet. Die geänderten Datensätze werden noch nicht aus der Logging-Tabelle gelöscht.

- SAP LT Replication Server fordert ein neues Zugriffstoken von Google Cloudan.

- BigQuery-Connector für SAP sendet eine HTTP-Anfrage an Google Cloud, um die Struktur der Zieltabelle zu prüfen.

- BigQuery-Connector für SAP sendet die Datensätze in so vielen Blöcken an Google Cloud, wie erforderlich sind, um alle Datensätze zu senden, die es im einzelnen Teil empfangen hat. Jeder Block wird in einer separaten HTTP-Anfrage gesendet.

- Google Cloud verarbeitet jeden empfangenen Teil.

- Für jeden Block wird ein HTTP-

OK-Statuscode an SAP LT Replication Server zurückgegeben. - Nachdem Google Cloud alle Datensätze erhalten hat, löscht SAP LT Replication Server die gesendeten Datensätze aus der Logging-Tabelle und die Ressourcen werden im Quellsystem freigegeben.

Weitere Informationen zu Teilen und zum Konfigurieren der Leistung von SAP LT Replication Server finden Sie im Leitfaden zur Leistungsoptimierung von SAP LT Replication Server im SAP-Hilfeportal.

BigQuery-Kontingente

Die für Ihr Projekt geltenden Kontingente der BigQuery Streaming API begrenzen die Menge an Daten, die Sie im Laufe der Zeit und in einer einzelnen HTTP-Anfrage an BigQuery streamen können.

BigQuery legt beispielsweise Limits für folgende Messwerte fest:

- Die Byte pro Sekunde und Projekt, die Sie senden können

- Die maximale Anzahl von Datensätzen oder Zeilen, die Sie in einer einzelnen HTTP-Anfrage senden können.

- Die maximale Größe einer HTTP-Anfrage, die Sie senden können

Bei Streaming-Insert-Anweisungen korrigiert BigQuery die Größe der HTTP-Anfragen auf 10 MB und die Anzahl der Datensätze, die Sie in einer einzelnen HTTP-Anfrage senden können, auf 50.000.

In den meisten Fällen können Sie Kontingente ändern, aber keine Limits.

Die für Ihr Projekt geltenden Kontingente können Sie in derGoogle Cloud Console auf der Seite Kontingente ansehen und bearbeiten.

Weitere Informationen zu den BigQuery-Kontingenten und -Limits für Streaming-Insert-Anweisungen finden Sie unter:

Pub/Sub Kontingente

Die für Ihr Projekt geltenden Pub/Sub API-Kontingente begrenzen die Menge an Daten, die Sie im Laufe der Zeit und in einer einzelnen HTTP-Anfrage an BigQuery streamen können.

Pub/Sub legt beispielsweise Limits für folgende Messwerte fest:

- Die Byte pro Sekunde und Projekt, die Sie senden können

- Die maximale Anzahl von Datensätzen oder Zeilen, die Sie in einer einzelnen HTTP-Anfrage senden können.

- Die maximale Größe einer HTTP-Anfrage, die Sie senden können

Bei CDC-Daten korrigiert Pub/Sub die Größe der HTTP-Anfragen auf 10 MB und die Anzahl der Datensätze, die Sie in einer einzelnen HTTP-Anfrage senden können,auf 1.000.

In den meisten Fällen können Sie Kontingente ändern, aber keine Limits.

Die für Ihr Projekt geltenden Kontingente können Sie in derGoogle Cloud Console auf der Seite Kontingente ansehen und bearbeiten.

Weitere Informationen zu den Pub/Sub-Kontingenten und Ressourcenlimits finden Sie unter:

Datensatzkomprimierung

Für die CDC-Replikation über Pub/Sub wird die Funktion zur Datensatzkomprimierung nicht unterstützt.

Bei der Replikation von Streamingdaten verbessert BigQuery-Connector für SAP standardmäßig die Replikationsleistung, indem die an BigQuery gesendeten Datensätze komprimiert werden. Ab Version 2.8 von BigQuery-Connector für SAP ist die Option zur Datensatzkomprimierung sowohl auf Tabellen- als auch auf Feldebene verfügbar.

Wenn die Datensatzkomprimierung auf Tabellenebene aktiviert ist (Standardeinstellung), verwirft BigQuery-Connector für SAP alle Felder, die im Quelldatensatz leer sind, aus den Einträgen, die an BigQuery gesendet werden. Wenn der Datensatz in BigQuery eingefügt wird, werden die Felder, die in den gesendeten Daten weggelassen wurden, mit null in der Zieltabelle in BigQuery initialisiert.

Wenn Sie jedoch einige leere Felder mit ihren Anfangswerten in BigQuery replizieren müssen und weiterhin die Datensatzkomprimierung auf Tabellenebene verwenden möchten, können Sie die Einstellung für die Datensatzkomprimierung für diese Felder ändern. Das bedeutet, dass die leeren Werte in den angegebenen Feldern nicht aus den gesendeten Daten entfernt werden und den Wert beibehalten, mit dem sie in der Quelltabelle initialisiert wurden.

Sie können das Verhalten bei der Datensatzkomprimierung mit der Einstellung Flag „Unkomprimiert senden“ steuern, die auf Tabellen- und Feldebene verfügbar ist. In der folgenden Tabelle ist das Verhalten bei der Datensatzkomprimierung zusammengefasst:

| Flag „Unkomprimiert senden“ auf Tabellenebene | Flag „Unkomprimiert senden“ auf Feldebene | Verhalten bei der Datensatzkomprimierung |

|---|---|---|

| Ja | Nein | Alle Felder werden unkomprimiert gesendet. |

| Ja | Ja | Alle Felder werden unkomprimiert gesendet. |

| Nein | Ja | Nur die ausgewählten Felder auf Feldebene werden unkomprimiert gesendet. |

| Nein | Nein | Alle Felder werden komprimiert gesendet. |

Wenn die unkomprimierten Daten zur Replikation gesendet werden, behalten die leeren Felder den Wert bei, mit dem sie in der Quelltabelle initialisiert wurden. Das gilt nicht für Datums- und Zeitstempelfelder. Der initialisierte Wert für die Datums- und Zeitstempelfelder erhält die folgenden Werte:

- Initialisierungswert des Datumsfelds:

DATE 1970-01-01 - Initialisierungswert des Zeitstempelfelds:

TIMESTAMP 1970-01-01 00:00:00 UTC

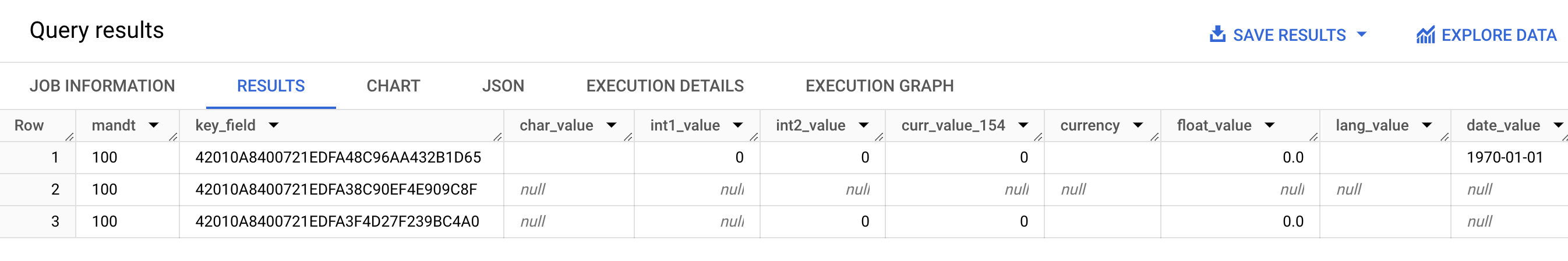

Der folgende Screenshot zeigt ein Beispiel für die Datensatzkomprimierung:

- Zeile 1: Alle Felder sind unkomprimiert. Das Flag „Unkomprimiert senden“ ist auf Tabellenebene ausgewählt.

- Zeile 2: Alle Felder sind komprimiert. Das Flag „Unkomprimiert senden“ ist auf Tabellenebene deaktiviert.

- Zeile 3: Die folgenden Felder sind nicht komprimiert:

int2_value,curr_value_154,currency,float_valueundlang_value. Für diese Felder ist Flag „Unkomprimiert senden“ auf Feldebene ausgewählt.

Um eine bessere Leistung zu erzielen, sollten Sie die Datensatzkomprimierung nicht deaktivieren, indem Sie Unkomprimiertes Flag senden auf Tabellenebene auswählen. Dies kann sich negativ auf die Replikationsleistung auswirken. Wenn Sie unkomprimierte Daten nur für bestimmte Felder senden müssen, wählen Sie das Flag „Unkomprimiert senden“ auf Feldebene für diese Felder aus. Weitere Informationen dazu, wie sich die Datensatzkomprimierung auf Ihre Daten auswirkt, die von SAP LT Replication Server an BigQuery übertragen werden, finden Sie unter Hintergrundinformationen zum Komprimierungsfeature von BigQuery-Connector für SAP.

Konfiguration der BigQuery-Replikation

Zum Konfigurieren der Replikation mit BigQuery-Connector für SAP verwenden Sie verschiedene SAP-Transaktionen, einschließlich einer benutzerdefinierten Transaktion, die von Google Cloudbereitgestellt wird:

SM30: Definiert Attribute für die Verbindung mit Google Cloud, die als Datensatz in der benutzerdefinierten Konfigurationstabelle/GOOG/CLIENT_KEYgespeichert werden. Wenn Sie RFC-Ziele für die Verbindung mitGoogle Cloud APIs und -Diensten verwenden, werden einige Verbindungseigenschaften optional in der benutzerdefinierten Konfigurationstabelle/GOOG/SERVIC_MAPgespeichert.LTRC: Definiert verschiedene BigQuery-Connector for SAP-Attribute, darunter Replikationsanwendung und Massenübertragungs-ID.SM59: Definiert RFC-Ziele, die die Verbindung zu APIs und Diensten wie BigQuery und IAM ermöglichen. Google Cloud/GOOG/SLT_SETTINGS: Definiert Attribute für das BigQuery-Ziel-Dataset, die Zieltabelle und die Zielfelder. Wenn Sie/GOOG/SLT_SETTINGSin SAP LT Replication Server eingeben, müssen Sie/nhinzufügen, um den ersten Schrägstrich im Transaktionsnamen zu maskieren.

Sprachunterstützung

BigQuery-Connector für SAP unterstützt nur Replikationskonfigurationen auf Englisch. Wenn Sie die Replikation mit den SAP-Transaktionen und der von Google Cloudbereitgestellten benutzerdefinierten Transaktion konfigurieren, verwenden Sie Englisch als Anmeldesprache auf dem SAP-Anmeldebildschirm.

BigQuery-Connector für SAP unterstützt jedoch die Ausführung von Hintergrundjobs, die auf dem SAP LT Replication Server in allen von SAP SLT unterstützten Sprachen ausgeführt werden.

Alle Fehlermeldungen, die bei der Arbeit mit BigQuery-Connector für SAP auftreten können, werden unabhängig von der Sprache der Hintergrundjobausführung in Englisch generiert.

Attribute von Zieltabellen

Wenn Sie die Replikation in SAP LT Replication Server durch Ausführen der Transaktion /GOOG/SLT_SETTINGS konfigurieren, können Sie Einstellungen festlegen, die gelten, wenn BigQuery-Connector für SAP die Zieltabelle in BigQuery erstellt.

Sie können für eine BigQuery-Zieltabelle beispielsweise die folgenden Attribute angeben:

- Tabellenname

- Die Standardoption zur Benennung von Feldern

- Zusätzliche Felder zum Erfassen von Datensatzänderungen und zum Aktivieren von Abfragen nach Datensatzanzahl

- Tabellenpartitionierung

Standardoptionen zur Benennung von Feldern

Sie können BigQuery-Connector für SAP so konfigurieren, dass die Namen für die Felder in der BigQuery-Zieltabelle entweder aus den Namen der Quellfelder oder aus den Labels und Beschreibungen der Quellfelder erstellt werden. Die Labels und Beschreibungen sind in der Regel informativer als der Inhalt des Felds.

BigQuery-Connector für SAP verwendet standardmäßig die Namen der Quellfelder.

Sie können den Standardwert ändern, indem Sie bei der Tabellenerstellung in der Massenübertragungskonfiguration der Transaktion /GOOG/SLT_SETTINGS die Option Benutzerdefinierte Namen festlegen. Diese Angabe wird in der Konfigurationstabelle /GOOG/BQ_MASTR gespeichert.

BigQuery-Connector für SAP ändert die Namen so, dass sie der BigQuery-Namenskonvention entsprechen.

Bevor eine Tabelle erstellt wird, können Sie die Feldnamen im Bildschirm zur Feldzuordnung der Transaktion /GOOG/SLT_SETTINGS bearbeiten.

Wenn das Flag Benutzerdefinierte Namen angegeben ist, werden die Namen, die der BigQuery-Connector für SAP-Connector beim Erstellen der Zieltabelle verwendet, in der Spalte Name des externen Felds im Bildschirm zur Feldzuordnung angezeigt.

BigQuery-Connector für SAP erstellt die Namen in der Spalte Externer Feldname aus dem Feldlabel medium jedes Quellfelds. Wenn in der Definition des Quellfelds kein Label für ein mittleres Feld angegeben ist, wird die kurze Beschreibung des Felds verwendet. Wenn die kurze Beschreibung ebenfalls nicht angegeben ist, wird das kürzeste angegebene Label verwendet. Wenn nichts angegeben ist, wird der Name des Quellfelds verwendet.

Weitere Informationen zum Anpassen von Zielfeldnamen finden Sie unter Zielfeldnamen anpassen.

Datensatzänderungen erfassen und Datensatzanzahl aktivieren

Geben Sie die Option Flag für zusätzliche Felder in der Transaktion /GOOG/SLT_SETTINGS an, wenn Sie die Replikation konfigurieren, um den Typ der Änderung in der Quelltabelle zu erfassen, die die Replikation ausgelöst hat, und die Anzahl der Datensätze in der BigQuery-Tabelle zum Vergleich mit SAP LT Replication Server oder die Anzahl der Datensätze in der Quelltabelle abzufragen.

Wenn die Option Flag für zusätzliche Felder angegeben ist, werden dem Schema die folgenden Spalten für die BigQuery-Zieltabelle hinzugefügt:

| Feldname | Datentyp | Beschreibung |

|---|---|---|

operation_flag

|

STRING

|

Gibt die Art der Änderung in der Quelltabelle an, die das Laden oder die Replikation des Datensatzes in BigQuery ausgelöst hat.

Zum Zählen von Einträgen, die im Replikationsmodus eingefügt wurden, können Sie abgefragte Datensätze mit dem Wert

Wenn Sie Datensätze zählen möchten, die im anfänglichen Lademodus eingefügt wurden, können Sie abgefragten Datensätze mit dem Wert |

is_deleted

|

BOOLEAN

|

Bei true wird der Quelldatensatz aus der Quelltabelle gelöscht.

Schließen Sie gelöschte Quelldatensätze mit dem Feld |

recordstamp

|

TIMESTAMP

|

Der Zeitpunkt, an dem SAP LT Replication Server den Eintrag an BigQuery gesendet hat. Wenn Sie die Anzahl der eindeutigen Datensätze in einer BigQuery-Tabelle zählen möchten, können Sie nur die zuletzt eingefügte Instanz jedes Eintrags abfragen. Eine Beispielabfrage finden Sie unter Gesamtanzahl der Datensätze in einer BigQuery-Tabelle abfragen. |

Die aktuelle Einstellung der Option Flag für zusätzliche Felder wird in der Konfigurationstabelle /GOOG/BQ_MASTR gespeichert.

Weitere Informationen zum Angeben des Flags für zusätzliche Felder finden Sie unter:

- Informationen zur CDC-Replikation über Pub/Sub finden Sie unter Tabellenerstellung und andere allgemeine Attribute angeben.

- Informationen zur Streamingdatenreplikation finden Sie unter Tabellenerstellung und andere allgemeine Attribute angeben.

Tabellenpartitionierung

Sie können BigQuery-Tabellen erstellen, die nach einem Zeitstempelfeld in der Quelltabelle partitioniert sind, wodurch eine nach Zeiteinheitspalte partitionierte Tabelle erstellt wird. Sie können aber auch BigQuery-Tabellen erstellen, die nach dem Zeitpunkt partitioniert werden, zu dem die Datensätze in BigQuery eingefügt werden, wodurch eine nach Aufnahmezeit partitionierte Tabelle erstellt wird.

Zum Aktivieren der Partitionierung geben Sie beim Konfigurieren der Replikationsattribute im Feld /GOOG/BQ_TABLEPartitionierungstyp einen Partitionstyp an.

Mit den verfügbaren Partitionstypen können Sie die Granularität der Partitionierung nach Stunde, Tag, Monat oder Jahr anpassen.

Wenn Sie einen Zeitstempel aus der Quelltabelle für die Partitionierung nach Zeiteinheiten verwenden möchten, geben Sie den Namen des Quellfelds im Feld Partitionsfeld an.

Wenn Sie eine BigQuery-Einfügungszeit für die Partitionierung nach Aufnahmezeit verwenden möchten, können Sie das Partitionierungsfeld leer lassen. BigQuery-Connector für SAP erstellt in der Zieltabelle ein Feld zum Speichern der Einfügungszeit.

Zielfeldattribute

BigQuery-Connector für SAP verwendet standardmäßig die Feldnamen und Datentypen in der SAP-Quelltabelle als Feldnamen und Datentypen in der BigQuery-Zieltabelle.

Optional können Sie vor dem Erstellen der Zieltabelle die Feldnamen anpassen oder den BigQuery-Datentyp ändern.

Zielfeldnamen anpassen

Bevor eine Tabelle erstellt wird, können Sie die Zielfeldnamen anpassen.

Bei Bedarf ändert BigQuery-Connector for SAP die von Ihnen angegebenen benutzerdefinierten Namen so, dass sie der BigQuery-Namenskonvention entsprechen.

Beim Konfigurieren der Replikation können Sie die Feldnamen im Bildschirm für die Feldzuordnung der Transaktion /GOOG/SLT_SETTINGS aufrufen. BigQuery-Connector für SAP speichert Ihre Einstellungen in der Konfigurationstabelle /GOOG/BQ_FIELD.

Bevor Sie eine Tabelle erstellen, können Sie einen benutzerdefinierten Feldnamen angeben. Bearbeiten Sie dazu den generierten Namen in der Spalte Temporärer Feldname des Bildschirms zur Feldzuordnung. Wenn Sie einen Wert löschen und das Feld Temporärer Feldname leer lassen, verwendet BigQuery Connector für SAP den Namen des Quellfelds für den Namen dieses Zielfelds.

Nachdem Sie Änderungen am Feld Temporärer Feldname vorgenommen haben, validiert BigQuery-Connector für SAP den Wert, wenn Sie auf Speichern klicken, wendet die BigQuery-Namenskonventionen nach Bedarf an und speichert die Änderungen. Drücken Sie die Eingabetaste, um einen Wert zu validieren, ohne ihn zu speichern

Informationen zum Festlegen der Standardmethode zur Benennung von Zielfeldern finden Sie unter Standardoptionen zur Benennung von Feldern.

BigQuery-Feldzuordnung mithilfe einer Tabelle oder Textdatei bearbeiten

Bevor Sie eine BigQuery-Zieltabelle erstellen, können Sie die Standarddatentypen, -namen und -beschreibungen der Zielfelder optional in einer Tabelle oder Textdatei speichern, damit BigQuery-Data Engineers oder -Administratoren die Werte bearbeiten können, ohne Zugriff auf SAP LT Replication Server zu benötigen.

Nachdem die Werte bearbeitet wurden, müssen Sie die Datei und deren Inhalt in das CSV-Format konvertieren. Anschließend können Sie die Updates auf die Einstellungen zur Massenübertragung anwenden, indem Sie die CSV-Datei mithilfe der benutzerdefinierten Transaktion /GOOG/SLT_SETTINGS hochladen.

Die Bearbeitung der BigQuery-Feldzuordnung mithilfe einer CSV-Datei umfasst die folgenden Schritte:

- Tabelle oder Textdatei mit den Standardfeldzuordnungen erstellen

- Die Werte bearbeiten

- Die Tabelle oder Textdatei in das CSV-Format konvertieren

- Die CSV-Datei hochladen

Eine ausführliche Anleitung zu den einzelnen Schritten finden Sie unter BigQuery-Feldzuordnung in einer CSV-Datei bearbeiten.

BigQuery-Namenskonvention für Felder

Die BigQuery-Namenskonvention verwendet nur Kleinbuchstaben, Ziffern und Unterstriche.

BigQuery-Connector für SAP wendet die BigQuery-Namenskonventionen auf jeden Eingabewert an, der für den Namen eines Zielfelds verwendet werden soll.

Wenn Sie beispielsweise FIELD-@#!*123 als benutzerdefinierten Feldnamen eingeben, ändert BigQuery-Connector für SAP den Namen in field_123.

Weitere Informationen zur BigQuery-Namenskonvention für Felder finden Sie unter Spaltennamen.

Datentypzuordnung

Standardmäßig weist BigQuery-Connector für SAP den BigQuery-Zielfeldern anhand der SAP-Typart oder des SAP-Datentyps des SAP-Quelltyps Datentypen zu.

Bei der CDC-Replikation über Pub/Sub ist ein Zwischenschritt beim Zuordnen von Datentypen erforderlich:

BigQuery-Connector für SAP zu Pub/Sub: Wenn BigQuery-Connector für SAP Daten an ein Pub/Sub-Thema sendet, werden SAP-Datentypen zuerst in Pub/Sub-Avro-Datentypen konvertiert.

Pub/Sub zu BigQuery: Die im Avro-Format vorliegenden Pub/Sub-Daten werden dann über ein BigQuery-Abo in BigQuery gestreamt. An diesem Punkt weist Pub/Sub die endgültigen BigQuery-Datentypen zu.

Damit der Datenfluss reibungslos funktioniert und die Daten korrekt interpretiert werden, müssen die Pub/Sub-Avro-Datentypen und die endgültigen BigQuery-Datentypen kompatibel sein. Informationen zur Schemakompatibilität zwischen einem Pub/Sub-Thema und einer BigQuery-Tabelle finden Sie unter Schemakompatibilität.

Beim Konfigurieren der Replikation können Sie die Datentypen im Bildschirm für die Feldzuordnung der Transaktion /GOOG/SLT_SETTINGS aufrufen. BigQuery-Connector für SAP speichert Ihre Einstellungen in der Konfigurationstabelle /GOOG/BQ_FIELD.

Bevor eine Tabelle erstellt wird, können Sie die Spezifikation des Standarddatentyps in einen anderen BigQuery-Datentyp und Pub/Sub-Avro-Datentyp ändern.

Datentypen mit besonderer Handhabung

Mehrere SAP-Datentypen erfordern eine besondere Handhabung, damit sie in der BigQuery-Zieltabelle genau dargestellt werden.

Einige dieser Datentypen müssen Sie manuell bearbeiten. Andere werden von BigQuery-Connector für SAP bearbeitet.

Boolesche Werte

Für boolesche Werte verwendet SAP den Datentyp CHAR, der standardmäßig von BigQuery-Connector für SAP dem Datentyp STRING in der BigQuery-Zieltabelle zugeordnet wird.

Wenn Sie die Replikation mit der Transaktion /GOOG/SLT_SETTINGS konfigurieren, müssen Sie demzufolge für boolesche Werte die Standardzuweisung des Datentyps für boolesche Felder im Bildschirm für die Feldzuordnung von STRING in BOOLEAN ändern.

Zeitstempel

Für Zeitstempel verwendet SAP die Datentypen P (verpackte Dezimalzahl) oder DEC (Dezimalzahl), die BigQuery-Connector für SAP in der BigQuery-Zieltabelle standardmäßig NUMERIC zuordnet.

Wenn Sie die Replikation mit der Transaktion /GOOG/SLT_SETTINGS konfigurieren, müssen Sie demzufolge für Zeitstempel die Standardzuweisung des Datentyps für Zeitstempelfelder im Bildschirm für die Feldzuordnung von NUMERIC in TIMESTAMP oder TIMESTAMP (LONG) ändern.

SAP-Typart X

Die SAP-Typart X ist ein Hexadezimalwert und wird durch die SAP-Datentypen RAW, RAWSTRING und LRAW dargestellt. BigQuery-Connector für SAP ordnet diese Datentypen in der BigQuery-Quelltabelle standardmäßig STRING zu.

Wenn Sie stattdessen ein Quellfeld mit der SAP-Typart X für die Zuordnung BYTES benötigen, müssen Sie die Standardzuweisung des Datentyps für das Feld im Bildschirm für die Feldzuordnung der Transaktion /GOOG/SLT_SETTINGS ändern.

Die SAP-Typart X wird manchmal auch in SAP zur Darstellung von Ganzzahlen verwendet.

In diesem Fall prüft BigQuery-Connector für SAP den Datentyp des Quellfelds auf einen der SAP-Datentypen für Ganzzahlen, INT1, INT2, INT4, INT8 und weist den Datentyp INTEGER in der BigQuery-Zieltabelle zu.

SAP-Typart y

Die SAP-Typart y ist ein Bytestring und wird durch die SAP-Datentypen RAW, RAWSTRING und LRAW dargestellt. BigQuery-Connector für SAP ordnet diese Datentypen in der BigQuery-Quelltabelle standardmäßig STRING zu.

Wenn Sie stattdessen ein Quellfeld mit der SAP-Typart y für die Zuordnung BYTES benötigen, müssen Sie die Standardzuweisung des Datentyps für das Feld im Bildschirm für die Feldzuordnung der Transaktion /GOOG/SLT_SETTINGS ändern.

SAP-Datentyp LRAW

BigQuery-Connector für SAP speichert LRAW-Datentypen in BigQuery als Base64-codierte Strings.

Wenn Sie die CDC-Replikation über Pub/Sub verwenden, konvertiert der Connector LRAW-Felder in die UTF-8-Codierung, bevor er sie an Pub/Sub sendet. Trotz dieser Konvertierung werden die Daten vom Connector weiterhin als Base64 in BigQuery gespeichert.

Bei der UTF-8-Konvertierung des Werts eines LRAW-Felds durch den Connector werden nur die ersten Bytes berücksichtigt, die in der vorangehenden Längenspalte angegeben sind. Dies entspricht den SAP-Standards, bei denen das vorangehende Längenfeld (ein INT2- oder INT4-Typ) die gültige Länge des LRAW-Inhalts definiert.

Standardzuordnung des Datentyps

Die folgende Tabelle zeigt die Standardkonvertierung des Datentyps für BigQuery-Connector für SAP:

| SAP-Typart | SAP-Datentyp | BigQuery-Datentyp | Pub/Sub-Avro-Datentyp | Hinweise |

|---|---|---|---|---|

b (1-Byte-Ganzzahl)s (2-Byte-Ganzzahl)I (4-Byte-Ganzzahl)8 (8-Byte-Ganzzahl)

|

INT1INT2INT4INT8

|

INTEGER |

INT |

|

F (Gleitkommazahl) |

FLTP

|

FLOAT |

FLOAT |

|

P (verpackt)

|

CURRDECQUAN

|

NUMERIC |

DOUBLE |

Standardmäßig wird die SAP-Typart P dem BigQuery-Datentyp NUMERIC zugeordnet und in eine Zahl im externen Format konvertiert. |

a (Gleitkommazahl mit 16 Dezimalstellen)

|

DECFLOAT16 |

NUMERIC |

DOUBLE |

|

e (Gleitkommazahl mit 16 Dezimalstellen)

|

DECFLOAT34 |

NUMERIC |

DOUBLE |

|

N (numerisch) |

NUMC |

STRING |

STRING |

|

X (hexadezimal)y (Bytestring)

|

RAWRAWSTRINGLRAW

|

STRING |

STRING |

Wenn die SAP-Typart X ist, der Datentypname jedoch das Muster 'INT*' (INT1, INT2, INT4) abdeckt, wird ein Quelldatenelement durch ein neues Datenelement TYPINT8 mit TYPEKIND '8' ersetzt, das dem BigQuery-Datentyp INTEGER zugeordnet ist. |

C (Zeichen)g (Zeichenstring)? (csequence)& (clike)

|

CHARSTRING |

STRING |

STRING |

|

D (Datum) |

DATS |

DATE |

STRING |

|

T (Uhrzeit) |

TIMS |

TIME |

STRING |

Lizenzierung

BigQuery-Connector für SAP wird im Rahmen der Vereinbarung, die Ihre Nutzung der Google Cloud -Plattform regelt, als „Software“ zur Verfügung gestellt, einschließlich der dienstspezifischen Nutzungsbedingungen unter https://cloud.google.com/terms/service-terms. Ohne Einschränkung der vorhergehenden Bedingungen dürfen Sie BigQuery-Connector für SAP nur mit ausdrücklicher schriftlicher Genehmigung von Google ändern oder verbreiten.

Die Software BigQuery-Connector für SAP wird kostenlos angeboten. Zur Klarstellung wird darauf hingewiesen, dass die Nutzung anderer „Software“ und „Dienste“ im Rahmen der Vereinbarung bezüglich Ihrer Nutzung der Google Cloud -Plattform, wie z. B. BigQuery, Pub/Sub, Pub/Sub API, Storage Write API und BigQuery Streaming API, Kosten verursachen kann.

BigQuery-Connector für SAP beinhaltet keine Lizenz für SAP-Software, einschließlich SAP LT Replication Server. Erwerben Sie jeweils eine entsprechende Lizenz für die SAP-Software.

Supportlebenszyklus

Google Cloud unterstützt und verwaltet die aktuelle Hauptversion von BigQuery-Connector für SAP für mindestens 12 Monate, nachdem die Einstellung der Version auf der Seite „Versionshinweise für SAP in Google Cloud“ angekündigt wurde, die vorherige Hauptversion.

Nächste Schritte

Informationen zur Installation von BigQuery-Connector für SAP finden Sie unter BigQuery-Connector für SAP installieren.