Text mit der Funktion ML.underStand_TEXT verstehen

In diesem Dokument wird beschrieben, wie Sie die Funktion ML.UNDERSTAND_TEXT mit einem Remote-Modell verwenden, um für Text aus einer BigQuery-Standardtabelle eine Natural Language Text-Analysefunktion auszuführen.

Erforderliche Rollen

Zum Erstellen eines Remote-Modells und Analysieren von Text benötigen Sie die folgenden IAM-Rollen (Identity and Access Management) auf Projektebene:

- BigQuery-Datasets, ‑Tabellen und ‑Modelle erstellen und verwenden: BigQuery-Dateneditor (

roles/bigquery.dataEditor) BigQuery-Verbindungen erstellen, delegieren und verwenden: BigQuery-Verbindungsadministrator (

roles/bigquery.connectionsAdmin)Wenn Sie keine Standardverbindung konfiguriert haben, können Sie eine erstellen und festlegen, wenn Sie die

CREATE MODEL-Anweisung ausführen. Dazu benötigen Sie die Rolle „BigQuery Admin“ (roles/bigquery.admin) für Ihr Projekt. Weitere Informationen finden Sie unter Standardverbindung konfigurieren.Dem Dienstkonto der Verbindung Berechtigungen erteilen: Projekt-IAM-Administrator (

roles/resourcemanager.projectIamAdmin)BigQuery-Jobs erstellen: BigQuery-Jobnutzer (

roles/bigquery.jobUser)

Diese vordefinierten Rollen enthalten die Berechtigungen, die zum Ausführen der Aufgaben in diesem Dokument erforderlich sind. Erweitern Sie den Abschnitt Erforderliche Berechtigungen, um die erforderlichen Berechtigungen anzuzeigen:

Erforderliche Berechtigungen

- Dataset erstellen:

bigquery.datasets.create - Verbindung erstellen, delegieren und verwenden:

bigquery.connections.* - Dienstkontoberechtigungen festlegen:

resourcemanager.projects.getIamPolicyundresourcemanager.projects.setIamPolicy - Modell erstellen und Inferenz ausführen:

bigquery.jobs.createbigquery.models.createbigquery.models.getDatabigquery.models.updateDatabigquery.models.updateMetadata

Sie können diese Berechtigungen auch mit benutzerdefinierten Rollen oder anderen vordefinierten Rollen erhalten.

Hinweise

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the BigQuery, BigQuery Connection API, and Cloud Natural Language API APIs.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. -

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the BigQuery, BigQuery Connection API, and Cloud Natural Language API APIs.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. Öffnen Sie in der Google Cloud Console die Seite BigQuery.

Klicken Sie im Bereich Explorer auf den Namen Ihres Projekts.

Klicken Sie auf Aktionen ansehen > Dataset erstellen.

Führen Sie auf der Seite Dataset erstellen die folgenden Schritte aus:

Geben Sie für Dataset-ID einen Namen für das Dataset ein.

Wählen Sie unter Standorttyp einen Standort für das Dataset aus.

Klicken Sie auf Dataset erstellen.

Wenn Sie ein neues Dataset erstellen möchten, verwenden Sie den Befehl

bq mkmit dem Flag--location:bq --location=LOCATION mk -d DATASET_ID

Ersetzen Sie Folgendes:

LOCATION: Speicherort des Datasets.DATASET_ID: der Name des zu erstellenden Datasets.

Prüfen Sie, ob das Dataset erstellt wurde:

bq lsRufen Sie die Seite BigQuery auf.

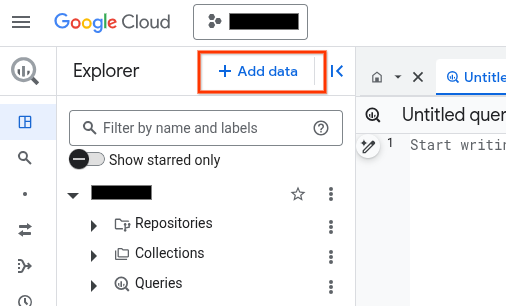

Klicken Sie im Bereich Explorer auf Daten hinzufügen:

Das Dialogfeld Daten hinzufügen wird geöffnet.

Wählen Sie im Bereich Filtern nach im Abschnitt Datenquellentyp die Option Geschäftsanwendungen aus.

Alternativ können Sie im Feld Nach Datenquellen suchen

Vertex AIeingeben.Klicken Sie im Abschnitt Empfohlene Datenquellen auf Vertex AI.

Klicken Sie auf die Lösungsübersichtskarte Vertex AI-Modelle: BigQuery Federation.

Wählen Sie in der Liste Verbindungstyp die Option Remote-Modelle in Vertex AI, Remote-Funktionen und BigLake (Cloud-Ressource) aus.

Geben Sie im Feld Verbindungs-ID einen Namen für die Verbindung ein.

Klicken Sie auf Verbindung erstellen.

Klicken Sie auf Zur Verbindung.

Kopieren Sie im Bereich Verbindungsinformationen die Dienstkonto-ID zur Verwendung in einem späteren Schritt.

Erstellen Sie in einer Befehlszeilenumgebung eine Verbindung:

bq mk --connection --location=REGION --project_id=PROJECT_ID \ --connection_type=CLOUD_RESOURCE CONNECTION_ID

Der Parameter

--project_idüberschreibt das Standardprojekt.Ersetzen Sie dabei Folgendes:

REGION: Ihre VerbindungsregionPROJECT_ID: Ihre Google Cloud -Projekt-IDCONNECTION_ID: eine ID für Ihre Verbindung

Wenn Sie eine Verbindungsressource herstellen, erstellt BigQuery ein eindeutiges Systemdienstkonto und ordnet es der Verbindung zu.

Fehlerbehebung:Wird der folgende Verbindungsfehler angezeigt, aktualisieren Sie das Google Cloud SDK:

Flags parsing error: flag --connection_type=CLOUD_RESOURCE: value should be one of...

Rufen Sie die Dienstkonto-ID ab und kopieren Sie sie zur Verwendung in einem späteren Schritt:

bq show --connection PROJECT_ID.REGION.CONNECTION_ID

Die Ausgabe sieht in etwa so aus:

name properties 1234.REGION.CONNECTION_ID {"serviceAccountId": "connection-1234-9u56h9@gcp-sa-bigquery-condel.iam.gserviceaccount.com"}- Rufen Sie Cloud Shell auf.

-

Legen Sie das Standardprojekt Google Cloud fest, auf das Sie Ihre Terraform-Konfigurationen anwenden möchten.

Sie müssen diesen Befehl nur einmal pro Projekt und in jedem beliebigen Verzeichnis ausführen.

export GOOGLE_CLOUD_PROJECT=PROJECT_ID

Umgebungsvariablen werden überschrieben, wenn Sie in der Terraform-Konfigurationsdatei explizite Werte festlegen.

-

Erstellen Sie in Cloud Shell ein Verzeichnis und eine neue Datei in diesem Verzeichnis. Der Dateiname muss die Erweiterung

.tfhaben, z. B.main.tf. In dieser Anleitung wird die Datei alsmain.tfbezeichnet.mkdir DIRECTORY && cd DIRECTORY && touch main.tf

-

Wenn Sie einer Anleitung folgen, können Sie den Beispielcode in jedem Abschnitt oder Schritt kopieren.

Kopieren Sie den Beispielcode in das neu erstellte

main.tf.Kopieren Sie optional den Code aus GitHub. Dies wird empfohlen, wenn das Terraform-Snippet Teil einer End-to-End-Lösung ist.

- Prüfen und ändern Sie die Beispielparameter, die auf Ihre Umgebung angewendet werden sollen.

- Speichern Sie die Änderungen.

-

Initialisieren Sie Terraform. Dies ist nur einmal für jedes Verzeichnis erforderlich.

terraform init

Fügen Sie optional die Option

-upgradeein, um die neueste Google-Anbieterversion zu verwenden:terraform init -upgrade

-

Prüfen Sie die Konfiguration und prüfen Sie, ob die Ressourcen, die Terraform erstellen oder aktualisieren wird, Ihren Erwartungen entsprechen:

terraform plan

Korrigieren Sie die Konfiguration nach Bedarf.

-

Wenden Sie die Terraform-Konfiguration an. Führen Sie dazu den folgenden Befehl aus und geben Sie

yesan der Eingabeaufforderung ein:terraform apply

Warten Sie, bis Terraform die Meldung „Apply complete“ anzeigt.

- Öffnen Sie Ihr Google Cloud Projekt, um die Ergebnisse aufzurufen. Rufen Sie in der Google Cloud Console Ihre Ressourcen in der Benutzeroberfläche auf, um sicherzustellen, dass Terraform sie erstellt oder aktualisiert hat.

Zur Seite IAM & Verwaltung.

Klicken Sie auf Hinzufügen.

Das Dialogfeld Principals hinzufügen wird geöffnet.

Geben Sie im Feld Neue Hauptkonten die Dienstkonto-ID ein, die Sie zuvor kopiert haben.

Wählen Sie im Feld Rolle auswählen die Option Dienstnutzung und dann Nutzer der Dienstnutzung aus.

Klicken Sie auf Weitere Rolle hinzufügen.

Wählen Sie im Feld Rolle auswählen die Option BigQuery aus und wählen Sie dann BigQuery Connection User aus.

Klicken Sie auf Speichern.

PROJECT_NUMBER: Ihre Projektnummer.MEMBER: Die Dienstkonto-ID, die Sie zuvor kopiert haben.PROJECT_ID: Ihre Projekt-ID.DATASET_IDist die ID des Datasets, das das Modell enthalten soll. Dieses Dataset muss sich am selben Standort wie die von Ihnen verwendete Verbindung befinden.MODEL_NAMEist der Name des Modells.REGIONist die Region, die von der Verbindung verwendet wird.CONNECTION_ID: die Verbindungs-ID, z. B.myconnection.Wenn Sie sich Verbindungsdetails in der Google Cloud Console ansehen, ist die Verbindungs-ID der Wert im letzten Abschnitt der voll qualifizierten Verbindungs-ID, der unter Verbindungs-ID angezeigt wird, z. B.

projects/myproject/locations/connection_location/connections/myconnection.PROJECT_ID: Ihre Projekt-ID.DATASET_IDist die ID des Datasets, das das Modell enthält.MODEL_NAMEist der Name des Modells.TABLE_NAMEist der Name der Tabelle, die den zu analysierenden Text in einer Spalte mit dem Namentext_contententhält. Wenn sich der Text in einer Spalte mit einem anderen Namen befindet, geben Sietext_contentals Alias für diese Spalte an.QUERY: eine Abfrage, die den zu beschreibenden Text in einer Spalte namenstext_contententhält. Wenn sich der Text in einer Spalte mit einem anderen Namen befindet, geben Sietext_contentals Alias für diese Spalte an.FEATURE_NAMEist der Name eines unterstützten Natural Language API-Features.FLATTEN_JSON_OUTPUT: einBOOL-Wert, der bestimmt, ob der von der Funktion zurückgegebene JSON-Inhalt in separate Spalten geparst wird.ENCODING_TYPE: EinSTRING-Wert, der die Codierung angibt, die von der Cloud Natural Language API verwendet wird, um codierungsabhängige Informationen wie denbeginOffset-Wert zu bestimmen. Weitere Informationen finden Sie unterEncodingType.- Weitere Informationen zur Modellinferenz in BigQuery ML finden Sie unter Modellinferenz.

- Weitere Informationen zu den unterstützten SQL-Anweisungen und -Funktionen für generative KI-Modelle finden Sie unter End-to-End-Nutzerpfade für generative KI-Modelle.

- Testen Sie das Notebook Unstrukturierte Datenanalysen mit BigQuery ML und vortrainierten Vertex AI-Modellen.

Dataset erstellen

Erstellen Sie ein BigQuery-Dataset, das Ihre Ressourcen enthält:

Konsole

bq

Verbindung herstellen

Sie können diesen Schritt überspringen, wenn Sie entweder eine Standardverbindung konfiguriert haben oder die Rolle „BigQuery-Administrator“ haben.

Erstellen Sie eine Cloud-Ressourcenverbindung, die vom Remote-Modell verwendet werden soll, und rufen Sie das Dienstkonto der Verbindung ab. Erstellen Sie die Verbindung am selben Speicherort wie das Dataset, das Sie im vorherigen Schritt erstellt haben.

Wählen Sie eine der folgenden Optionen aus:

Console

bq

Terraform

Verwenden Sie die Ressource google_bigquery_connection:

Richten Sie zur Authentifizierung bei BigQuery die Standardanmeldedaten für Anwendungen ein. Weitere Informationen finden Sie unter Authentifizierung für Clientbibliotheken einrichten.

Im folgenden Beispiel wird eine Cloud-Ressourcenverbindung mit dem Namen my_cloud_resource_connection in der Region US erstellt:

Führen Sie die Schritte in den folgenden Abschnitten aus, um Ihre Terraform-Konfiguration auf ein Google Cloud -Projekt anzuwenden.

Cloud Shell vorbereiten

Verzeichnis vorbereiten

Jede Terraform-Konfigurationsdatei muss ein eigenes Verzeichnis haben (auch als Stammmodul bezeichnet).

Änderungen anwenden

Zugriff auf das Dienstkonto gewähren

Wählen Sie eine der folgenden Optionen aus:

Console

gcloud

Führen Sie den Befehl gcloud projects add-iam-policy-binding aus:

gcloud projects add-iam-policy-binding 'PROJECT_NUMBER' --member='serviceAccount:MEMBER' --role='roles/serviceusage.serviceUsageConsumer' --condition=None gcloud projects add-iam-policy-binding 'PROJECT_NUMBER' --member='serviceAccount:MEMBER' --role='roles/bigquery.connectionUser' --condition=None

Dabei gilt:

Wird die Berechtigung nicht erteilt, wird ein Fehler ausgegeben.

Modell erstellen

Erstellen Sie ein Remote-Modell mit einem REMOTE_SERVICE_TYPE von CLOUD_AI_NATURAL_LANGUAGE_V1:

CREATE OR REPLACE MODEL `PROJECT_ID.DATASET_ID.MODEL_NAME` REMOTE WITH CONNECTION {DEFAULT | `PROJECT_ID.REGION.CONNECTION_ID`} OPTIONS (REMOTE_SERVICE_TYPE = 'CLOUD_AI_NATURAL_LANGUAGE_V1');

Dabei gilt:

Text verstehen

Text mit der ML.UNDERSTAND_TEXT-Funktion verstehen:

SELECT * FROM ML.UNDERSTAND_TEXT( MODEL `PROJECT_ID.DATASET_ID.MODEL_NAME`, { TABLE PROJECT_ID.DATASET_ID.TABLE_NAME | (QUERY) }, STRUCT('FEATURE_NAME' AS nlu_option [, 'FLATTEN_JSON_OUTPUT' AS flatten_json_output] [, ENCODING_TYPE AS encoding_type]) );

Ersetzen Sie Folgendes:

Beispiel 1

Im folgenden Beispiel wird der Text in der Spalte text_content der Tabelle geprüft und die vorherrschende Stimmung im Text ermittelt:

SELECT * FROM ML.UNDERSTAND_TEXT( MODEL `mydataset.mynlpmodel`, TABLE mydataset.mytable, STRUCT('analyze_sentiment' AS nlu_option) );

Beispiel 2

Im folgenden Beispiel wird der Text in der Spalte comment der Tabelle geprüft und es werden syntaktische Informationen zum Text bereitgestellt:

SELECT * FROM ML.UNDERSTAND_TEXT( MODEL `mydataset.mynlpmodel`, (SELECT comment AS text_content from mydataset.mytable), STRUCT('analyze_syntax' AS nlu_option) );