PDFs in einer Retrieval-Augmented-Generation-Pipeline parsen

In dieser Anleitung wird beschrieben, wie Sie eine RAG-Pipeline (Retrieval Augmented Generation) auf Grundlage von geparsten PDF-Inhalten erstellen.

PDF-Dateien, z. B. Finanzdokumente, können aufgrund ihrer komplexen Struktur und der Mischung aus Text, Abbildungen und Tabellen in RAG-Pipelines schwierig zu verwenden sein. In dieser Anleitung erfahren Sie, wie Sie BigQuery ML-Funktionen in Kombination mit dem Layout Parser von Document AI verwenden, um eine RAG-Pipeline (Retrieval-Augmented Generation) zu erstellen, die auf Schlüsselinformationen basiert, die aus einer PDF-Datei extrahiert wurden.

Alternativ können Sie diese Anleitung auch mit einem Colab Enterprise-Notebook durchführen.

Ziele

In dieser Anleitung werden die folgenden Aufgaben behandelt:

- Cloud Storage-Bucket erstellen und eine Beispiel-PDF-Datei hochladen

- Erstellen Sie eine Cloud-Ressourcenverbindung, damit Sie von BigQuery aus eine Verbindung zu Cloud Storage und Vertex AI herstellen können.

- Erstellen einer Objekttabelle für die PDF-Datei, um die PDF-Datei in BigQuery verfügbar zu machen.

- Document AI-Prozessor erstellen, mit dem die PDF-Datei geparst werden kann.

- Erstellen eines Remote-Modells, mit dem Sie über die Document AI API von BigQuery aus auf den Dokumentprozessor zugreifen können.

- Mit dem Remote-Modell und der Funktion

ML.PROCESS_DOCUMENTdie PDF-Inhalte in Chunks parsen und dann in eine BigQuery-Tabelle schreiben. - PDF-Inhalte aus den JSON-Daten extrahieren, die von der

ML.PROCESS_DOCUMENT-Funktion zurückgegeben werden, und diese Inhalte dann in eine BigQuery-Tabelle schreiben. - Erstellen eines Remote-Modells, mit dem Sie das Vertex AI-Modell

text-embedding-004zum Generieren von Einbettungen aus BigQuery verwenden können. - Mit dem Remote-Modell und der Funktion

ML.GENERATE_EMBEDDINGEinbettungen aus dem geparsten PDF-Inhalt generieren und diese Einbettungen dann in eine BigQuery-Tabelle schreiben. Einbettungen sind numerische Darstellungen des PDF-Inhalts, mit denen Sie eine semantische Suche und den Abruf von PDF-Inhalten durchführen können. - Durch Verwenden der Funktion

VECTOR_SEARCHfür die Einbettungen, um semantisch ähnliche PDF-Inhalte zu ermitteln - Ein Remote-Modell erstellen, mit dem Sie ein Gemini-Modell zur Textgenerierung in BigQuery verwenden können.

- Führen Sie RAG (Retrieval Augmented Generation) durch, indem Sie das Remote-Modell mit der Funktion

ML.GENERATE_TEXTverwenden, um Text zu generieren. Dabei werden Vektorsuchergebnisse verwendet, um die Prompt-Eingabe zu erweitern und die Ergebnisse zu verbessern.

Kosten

In diesem Dokument verwenden Sie die folgenden kostenpflichtigen Komponenten von Google Cloud:

- BigQuery: You incur costs for the data that you process in BigQuery.

- Vertex AI: You incur costs for calls to Vertex AI models.

- Document AI: You incur costs for calls to the Document AI API.

- Cloud Storage: You incur costs for object storage in Cloud Storage.

Mit dem Preisrechner können Sie eine Kostenschätzung für Ihre voraussichtliche Nutzung vornehmen.

Weitere Informationen finden Sie auf den folgenden Preisseiten:

Hinweise

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the BigQuery, BigQuery Connection, Vertex AI, Document AI, and Cloud Storage APIs.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles.

Erforderliche Rollen

Zum Ausführen dieser Anleitung benötigen Sie die folgenden IAM-Rollen (Identity and Access Management):

- Cloud Storage-Buckets und -Objekte erstellen: Storage-Administrator (

roles/storage.storageAdmin) - Dokumentprozessor erstellen: Document AI Editor (

roles/documentai.editor) - BigQuery-Datasets, ‑Verbindungen und ‑Modelle erstellen und verwenden: BigQuery-Administrator (

roles/bigquery.admin) - Dem Dienstkonto der Verbindung Berechtigungen erteilen: Projekt-IAM-Administrator (

roles/resourcemanager.projectIamAdmin)

Diese vordefinierten Rollen enthalten die Berechtigungen, die zum Ausführen der Aufgaben in diesem Dokument erforderlich sind. Erweitern Sie den Abschnitt Erforderliche Berechtigungen, um die erforderlichen Berechtigungen anzuzeigen:

Erforderliche Berechtigungen

- Dataset erstellen:

bigquery.datasets.create - Verbindung erstellen, delegieren und verwenden:

bigquery.connections.* - Standardverbindung festlegen:

bigquery.config.* - Dienstkontoberechtigungen festlegen:

resourcemanager.projects.getIamPolicyundresourcemanager.projects.setIamPolicy - Objekttabelle erstellen:

bigquery.tables.createundbigquery.tables.update - Cloud Storage-Buckets und -Objekte erstellen:

storage.buckets.*undstorage.objects.* - Modell erstellen und Inferenz ausführen:

bigquery.jobs.createbigquery.models.createbigquery.models.getDatabigquery.models.updateDatabigquery.models.updateMetadata

- Dokumentprozessor erstellen:

documentai.processors.createdocumentai.processors.updatedocumentai.processors.delete

Sie können diese Berechtigungen auch mit benutzerdefinierten Rollen oder anderen vordefinierten Rollen erhalten.

Dataset erstellen

Erstellen Sie ein BigQuery-Dataset zum Speichern Ihres ML-Modells.

Konsole

Öffnen Sie in der Google Cloud Console die Seite BigQuery.

Klicken Sie im Bereich Explorer auf den Namen Ihres Projekts.

Klicken Sie auf Aktionen ansehen > Dataset erstellen.

Führen Sie auf der Seite Dataset erstellen die folgenden Schritte aus:

Geben Sie unter Dataset-ID

bqml_tutorialein.Wählen Sie als Standorttyp die Option Mehrere Regionen und dann USA (mehrere Regionen in den USA) aus.

Übernehmen Sie die verbleibenden Standardeinstellungen unverändert und klicken Sie auf Dataset erstellen.

bq

Wenn Sie ein neues Dataset erstellen möchten, verwenden Sie den Befehl bq mk mit dem Flag --location. Eine vollständige Liste der möglichen Parameter finden Sie in der bq mk --dataset-Befehlsreferenz.

Erstellen Sie ein Dataset mit dem Namen

bqml_tutorial, wobei der Datenspeicherort aufUSund die Beschreibung aufBigQuery ML tutorial datasetfestgelegt ist:bq --location=US mk -d \ --description "BigQuery ML tutorial dataset." \ bqml_tutorial

Anstelle des Flags

--datasetverwendet der Befehl die verkürzte Form-d. Wenn Sie-dund--datasetauslassen, wird standardmäßig ein Dataset erstellt.Prüfen Sie, ob das Dataset erstellt wurde:

bq ls

API

Rufen Sie die Methode datasets.insert mit einer definierten Dataset-Ressource auf.

{ "datasetReference": { "datasetId": "bqml_tutorial" } }

BigQuery DataFrames

Bevor Sie dieses Beispiel ausprobieren, folgen Sie den Schritten zur Einrichtung von BigQuery DataFrames in der BigQuery-Kurzanleitung: BigQuery DataFrames verwenden. Weitere Informationen finden Sie in der Referenzdokumentation zu BigQuery DataFrames.

Richten Sie zur Authentifizierung bei BigQuery die Standardanmeldedaten für Anwendungen ein. Weitere Informationen finden Sie unter ADC für eine lokale Entwicklungsumgebung einrichten.

Verbindung herstellen

Erstellen Sie eine Cloud-Ressourcenverbindung und rufen Sie das Dienstkonto der Verbindung ab. Erstellen Sie die Verbindung am selben Standort.

Sie können diesen Schritt überspringen, wenn Sie entweder eine Standardverbindung konfiguriert haben oder die Rolle „BigQuery-Administrator“ haben.

Erstellen Sie eine Cloud-Ressourcenverbindung, die vom Remote-Modell verwendet werden soll, und rufen Sie das Dienstkonto der Verbindung ab. Erstellen Sie die Verbindung am selben Speicherort wie das Dataset, das Sie im vorherigen Schritt erstellt haben.

Wählen Sie eine der folgenden Optionen aus:

Console

Rufen Sie die Seite BigQuery auf.

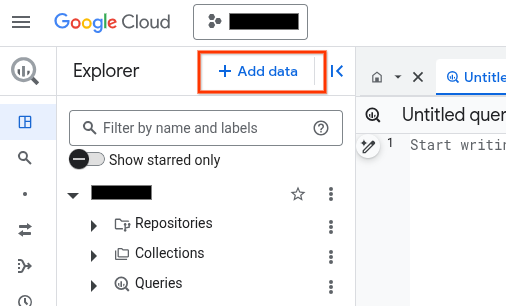

Klicken Sie im Bereich Explorer auf Daten hinzufügen:

Das Dialogfeld Daten hinzufügen wird geöffnet.

Wählen Sie im Bereich Filtern nach im Abschnitt Datenquellentyp die Option Geschäftsanwendungen aus.

Alternativ können Sie im Feld Nach Datenquellen suchen

Vertex AIeingeben.Klicken Sie im Abschnitt Empfohlene Datenquellen auf Vertex AI.

Klicken Sie auf die Lösungsübersichtskarte Vertex AI-Modelle: BigQuery Federation.

Wählen Sie in der Liste Verbindungstyp die Option Remote-Modelle in Vertex AI, Remote-Funktionen und BigLake (Cloud-Ressource) aus.

Geben Sie im Feld Verbindungs-ID einen Namen für die Verbindung ein.

Klicken Sie auf Verbindung erstellen.

Klicken Sie auf Zur Verbindung.

Kopieren Sie im Bereich Verbindungsinformationen die Dienstkonto-ID zur Verwendung in einem späteren Schritt.

bq

Erstellen Sie in einer Befehlszeilenumgebung eine Verbindung:

bq mk --connection --location=REGION --project_id=PROJECT_ID \ --connection_type=CLOUD_RESOURCE CONNECTION_ID

Der Parameter

--project_idüberschreibt das Standardprojekt.Ersetzen Sie dabei Folgendes:

REGION: Ihre VerbindungsregionPROJECT_ID: Ihre Google Cloud -Projekt-IDCONNECTION_ID: eine ID für Ihre Verbindung

Wenn Sie eine Verbindungsressource herstellen, erstellt BigQuery ein eindeutiges Systemdienstkonto und ordnet es der Verbindung zu.

Fehlerbehebung:Wird der folgende Verbindungsfehler angezeigt, aktualisieren Sie das Google Cloud SDK:

Flags parsing error: flag --connection_type=CLOUD_RESOURCE: value should be one of...

Rufen Sie die Dienstkonto-ID ab und kopieren Sie sie zur Verwendung in einem späteren Schritt:

bq show --connection PROJECT_ID.REGION.CONNECTION_ID

Die Ausgabe sieht in etwa so aus:

name properties 1234.REGION.CONNECTION_ID {"serviceAccountId": "connection-1234-9u56h9@gcp-sa-bigquery-condel.iam.gserviceaccount.com"}

Terraform

Verwenden Sie die Ressource google_bigquery_connection:

Richten Sie zur Authentifizierung bei BigQuery die Standardanmeldedaten für Anwendungen ein. Weitere Informationen finden Sie unter Authentifizierung für Clientbibliotheken einrichten.

Im folgenden Beispiel wird eine Cloud-Ressourcenverbindung mit dem Namen my_cloud_resource_connection in der Region US erstellt:

Führen Sie die Schritte in den folgenden Abschnitten aus, um Ihre Terraform-Konfiguration auf ein Google Cloud -Projekt anzuwenden.

Cloud Shell vorbereiten

- Rufen Sie Cloud Shell auf.

-

Legen Sie das Standardprojekt Google Cloud fest, auf das Sie Ihre Terraform-Konfigurationen anwenden möchten.

Sie müssen diesen Befehl nur einmal pro Projekt und in jedem beliebigen Verzeichnis ausführen.

export GOOGLE_CLOUD_PROJECT=PROJECT_ID

Umgebungsvariablen werden überschrieben, wenn Sie in der Terraform-Konfigurationsdatei explizite Werte festlegen.

Verzeichnis vorbereiten

Jede Terraform-Konfigurationsdatei muss ein eigenes Verzeichnis haben (auch als Stammmodul bezeichnet).

-

Erstellen Sie in Cloud Shell ein Verzeichnis und eine neue Datei in diesem Verzeichnis. Der Dateiname muss die Erweiterung

.tfhaben, z. B.main.tf. In dieser Anleitung wird die Datei alsmain.tfbezeichnet.mkdir DIRECTORY && cd DIRECTORY && touch main.tf

-

Wenn Sie einer Anleitung folgen, können Sie den Beispielcode in jedem Abschnitt oder Schritt kopieren.

Kopieren Sie den Beispielcode in das neu erstellte

main.tf.Kopieren Sie optional den Code aus GitHub. Dies wird empfohlen, wenn das Terraform-Snippet Teil einer End-to-End-Lösung ist.

- Prüfen und ändern Sie die Beispielparameter, die auf Ihre Umgebung angewendet werden sollen.

- Speichern Sie die Änderungen.

-

Initialisieren Sie Terraform. Dies ist nur einmal für jedes Verzeichnis erforderlich.

terraform init

Fügen Sie optional die Option

-upgradeein, um die neueste Google-Anbieterversion zu verwenden:terraform init -upgrade

Änderungen anwenden

-

Prüfen Sie die Konfiguration und prüfen Sie, ob die Ressourcen, die Terraform erstellen oder aktualisieren wird, Ihren Erwartungen entsprechen:

terraform plan

Korrigieren Sie die Konfiguration nach Bedarf.

-

Wenden Sie die Terraform-Konfiguration an. Führen Sie dazu den folgenden Befehl aus und geben Sie

yesan der Eingabeaufforderung ein:terraform apply

Warten Sie, bis Terraform die Meldung „Apply complete“ anzeigt.

- Öffnen Sie Ihr Google Cloud Projekt, um die Ergebnisse aufzurufen. Rufen Sie in der Google Cloud Console Ihre Ressourcen in der Benutzeroberfläche auf, um sicherzustellen, dass Terraform sie erstellt oder aktualisiert hat.

Zugriff auf das Dienstkonto gewähren

Wählen Sie eine der folgenden Optionen aus:

Console

Zur Seite IAM & Verwaltung.

Klicken Sie auf Zugriff gewähren.

Das Dialogfeld Principals hinzufügen wird geöffnet.

Geben Sie im Feld Neue Hauptkonten die Dienstkonto-ID ein, die Sie zuvor kopiert haben.

Wählen Sie im Feld Rolle auswählen die Option Document AI und dann Document AI-Betrachter aus.

Klicken Sie auf Weitere Rolle hinzufügen.

Wählen Sie im Feld Rolle auswählen die Option Cloud Storage und dann Storage Object Viewer aus.

Klicken Sie auf Weitere Rolle hinzufügen.

Wählen Sie im Feld Rolle auswählen die Option Vertex AI und dann Vertex AI-Nutzer aus.

Klicken Sie auf Speichern.

gcloud

Führen Sie den Befehl gcloud projects add-iam-policy-binding aus:

gcloud projects add-iam-policy-binding 'PROJECT_NUMBER' --member='serviceAccount:MEMBER' --role='roles/documentai.viewer' --condition=None gcloud projects add-iam-policy-binding 'PROJECT_NUMBER' --member='serviceAccount:MEMBER' --role='roles/storage.objectViewer' --condition=None gcloud projects add-iam-policy-binding 'PROJECT_NUMBER' --member='serviceAccount:MEMBER' --role='roles/aiplatform.user' --condition=None

Dabei gilt:

PROJECT_NUMBER: Ihre Projektnummer.MEMBER: Die Dienstkonto-ID, die Sie zuvor kopiert haben.

Beispiel-PDF in Cloud Storage hochladen

So laden Sie die Beispiel-PDF in Cloud Storage hoch:

- Laden Sie die

scf23.pdf-Beispiel-PDF-Datei unter https://www.federalreserve.gov/publications/files/scf23.pdf herunter, indem Sie auf „Herunterladen“ klicken. - Cloud Storage-Bucket erstellen

- Laden Sie die Datei

scf23.pdfin den Bucket hoch.

Objekttabelle erstellen

Erstellen Sie eine Objekttabelle für die PDF-Datei in Cloud Storage:

Öffnen Sie in der Google Cloud Console die Seite BigQuery.

Führen Sie im Abfrageeditor folgende Abfrage aus:

CREATE OR REPLACE EXTERNAL TABLE `bqml_tutorial.pdf` WITH CONNECTION `LOCATION.CONNECTION_ID` OPTIONS( object_metadata = 'SIMPLE', uris = ['gs://BUCKET/scf23.pdf']);

Ersetzen Sie Folgendes:

LOCATION: Standort der VerbindungCONNECTION_IDist die ID Ihrer BigQuery-Verbindung.Wenn Sie sich Verbindungsdetails in der Google Cloud Console ansehen, ist die

CONNECTION_IDder Wert im letzten Abschnitt der voll qualifizierten Verbindungs-ID, der unter Verbindungs-ID angezeigt wird, z. B.projects/myproject/locations/connection_location/connections/myconnection.BUCKET: Der Cloud Storage-Bucket, der diescf23.pdf-Datei enthält. Der vollständige Optionswerturisollte in etwa so aussehen:['gs://mybucket/scf23.pdf'].

Dokumentprozessor erstellen

Erstellen Sie einen Dokumentprozessor, der auf dem Layout-Parser-Prozessor in der multiregionalen Region us basiert.

Remote-Modell für den Dokumentprozessor erstellen

Erstellen Sie ein Remote-Modell, um auf den Document AI-Prozessor zuzugreifen:

Öffnen Sie in der Google Cloud Console die Seite BigQuery.

Führen Sie im Abfrageeditor folgende Abfrage aus:

CREATE OR REPLACE MODEL `bqml_tutorial.parser_model` REMOTE WITH CONNECTION `LOCATION.CONNECTION_ID` OPTIONS(remote_service_type = 'CLOUD_AI_DOCUMENT_V1', document_processor = 'PROCESSOR_ID');

Ersetzen Sie Folgendes:

LOCATION: Standort der VerbindungCONNECTION_IDist die ID Ihrer BigQuery-Verbindung.Wenn Sie sich Verbindungsdetails in der Google Cloud Console ansehen, ist die

CONNECTION_IDder Wert im letzten Abschnitt der voll qualifizierten Verbindungs-ID, der unter Verbindungs-ID angezeigt wird, z. B.projects/myproject/locations/connection_location/connections/myconnection.PROCESSOR_ID: die Prozessor-ID des Dokuments. Um diesen Wert zu ermitteln, sehen Sie sich die Prozessordetails an und suchen Sie dann im Abschnitt Allgemeine Informationen nach der Zeile ID.

PDF-Datei in Chunks parsen

Verwenden Sie den Dokumentprozessor mit der Funktion ML.PROCESS_DOCUMENT, um die PDF-Datei in Chunks zu parsen und die Inhalte dann in eine Tabelle zu schreiben. Die Funktion ML.PROCESS_DOCUMENT gibt die PDF-Chunks im JSON-Format zurück.

Öffnen Sie in der Google Cloud Console die Seite BigQuery.

Führen Sie im Abfrageeditor folgende Abfrage aus:

CREATE or REPLACE TABLE

bqml_tutorial.chunked_pdfAS ( SELECT * FROM ML.PROCESS_DOCUMENT( MODELbqml_tutorial.parser_model, TABLEbqml_tutorial.pdf, PROCESS_OPTIONS => (JSON '{"layout_config": {"chunking_config": {"chunk_size": 250}}}') ) );

PDF-Chunk-Daten in separate Spalten aufteilen

Extrahieren Sie den PDF-Inhalt und die Metadaten aus den JSON-Daten, die von der Funktion ML.PROCESS_DOCUMENT zurückgegeben werden, und schreiben Sie diesen Inhalt dann in eine Tabelle:

Öffnen Sie in der Google Cloud Console die Seite BigQuery.

Führen Sie im Abfrageeditor die folgende Anweisung aus, um den PDF-Inhalt zu parsen:

CREATE OR REPLACE TABLE

bqml_tutorial.parsed_pdfAS ( SELECT uri, JSON_EXTRACT_SCALAR(json , '$.chunkId') AS id, JSON_EXTRACT_SCALAR(json , '$.content') AS content, JSON_EXTRACT_SCALAR(json , '$.pageFooters[0].text') AS page_footers_text, JSON_EXTRACT_SCALAR(json , '$.pageSpan.pageStart') AS page_span_start, JSON_EXTRACT_SCALAR(json , '$.pageSpan.pageEnd') AS page_span_end FROMbqml_tutorial.chunked_pdf, UNNEST(JSON_EXTRACT_ARRAY(ml_process_document_result.chunkedDocument.chunks, '$')) json );Führen Sie im Abfrageeditor die folgende Anweisung aus, um eine Teilmenge des geparsten PDF-Inhalts aufzurufen:

SELECT * FROM `bqml_tutorial.parsed_pdf` ORDER BY id LIMIT 5;

Die Ausgabe sieht etwa so aus:

+-----------------------------------+------+------------------------------------------------------------------------------------------------------+-------------------+-----------------+---------------+ | uri | id | content | page_footers_text | page_span_start | page_span_end | +-----------------------------------+------+------------------------------------------------------------------------------------------------------+-------------------+-----------------+---------------+ | gs://mybucket/scf23.pdf | c1 | •BOARD OF OF FEDERAL GOVERN NOR RESERVE SYSTEM RESEARCH & ANALYSIS | NULL | 1 | 1 | | gs://mybucket/scf23.pdf | c10 | • In 2022, 20 percent of all families, 14 percent of families in the bottom half of the usual ... | NULL | 8 | 9 | | gs://mybucket/scf23.pdf | c100 | The SCF asks multiple questions intended to capture whether families are credit constrained, ... | NULL | 48 | 48 | | gs://mybucket/scf23.pdf | c101 | Bankruptcy behavior over the past five years is based on a series of retrospective questions ... | NULL | 48 | 48 | | gs://mybucket/scf23.pdf | c102 | # Percentiles of the Distributions of Income and Net Worth | NULL | 48 | 49 | +-----------------------------------+------+------------------------------------------------------------------------------------------------------+-------------------+-----------------+---------------+

Remote-Modell für die Generierung von Einbettungen erstellen

Erstellen Sie ein Remote-Modell, das ein gehostetes Vertex AI-Modell zur Generierung von Texteinbettungen darstellt:

Öffnen Sie in der Google Cloud Console die Seite BigQuery.

Führen Sie im Abfrageeditor folgende Abfrage aus:

CREATE OR REPLACE MODEL `bqml_tutorial.embedding_model` REMOTE WITH CONNECTION `LOCATION.CONNECTION_ID` OPTIONS (ENDPOINT = 'text-embedding-005');

Ersetzen Sie Folgendes:

LOCATION: Standort der VerbindungCONNECTION_IDist die ID Ihrer BigQuery-Verbindung.Wenn Sie sich Verbindungsdetails in der Google Cloud Console ansehen, ist die

CONNECTION_IDder Wert im letzten Abschnitt der voll qualifizierten Verbindungs-ID, der unter Verbindungs-ID angezeigt wird, z. B.projects/myproject/locations/connection_location/connections/myconnection.

Einbettungen generieren

Generieren Sie Einbettungen für den geparsten PDF-Inhalt und schreiben Sie sie dann in eine Tabelle:

Öffnen Sie in der Google Cloud Console die Seite BigQuery.

Führen Sie im Abfrageeditor folgende Abfrage aus:

CREATE OR REPLACE TABLE `bqml_tutorial.embeddings` AS SELECT * FROM ML.GENERATE_EMBEDDING( MODEL `bqml_tutorial.embedding_model`, TABLE `bqml_tutorial.parsed_pdf` );

Vektorsuche ausführen

Führen Sie eine Vektorsuche für die geparsten PDF-Inhalte aus.

In der folgenden Abfrage wird Text als Eingabe verwendet, mit der Funktion ML.GENERATE_EMBEDDING eine Einbettung für diese Eingabe erstellt und dann mit der Funktion VECTOR_SEARCH die Eingabe-Einbettung mit den ähnlichsten PDF-Inhaltseinbettungen abgeglichen. Die Ergebnisse sind die zehn besten PDF-Chunks, die der Eingabe semantisch am ähnlichsten sind.

Rufen Sie die Seite BigQuery auf.

Führen Sie im Abfrageeditor folgende SQL-Anweisung aus:

SELECT query.query, base.id AS pdf_chunk_id, base.content, distance FROM VECTOR_SEARCH( TABLE `bqml_tutorial.embeddings`, 'ml_generate_embedding_result', ( SELECT ml_generate_embedding_result, content AS query FROM ML.GENERATE_EMBEDDING( MODEL `bqml_tutorial.embedding_model`, ( SELECT 'Did the typical family net worth increase? If so, by how much?' AS content) ) ), top_k => 10, OPTIONS => '{"fraction_lists_to_search": 0.01}') ORDER BY distance DESC;

Die Ausgabe sieht in etwa so aus:

+-------------------------------------------------+--------------+------------------------------------------------------------------------------------------------------+---------------------+ | query | pdf_chunk_id | content | distance | +-------------------------------------------------+--------------+------------------------------------------------------------------------------------------------------+---------------------+ | Did the typical family net worth increase? ,... | c9 | ## Assets | 0.31113668174119469 | | | | | | | | | The homeownership rate increased slightly between 2019 and 2022, to 66.1 percent. For ... | | +-------------------------------------------------+--------------+------------------------------------------------------------------------------------------------------+---------------------+ | Did the typical family net worth increase? ,... | c50 | # Box 3. Net Housing Wealth and Housing Affordability | 0.30973592073929113 | | | | | | | | | For families that own their primary residence ... | | +-------------------------------------------------+--------------+------------------------------------------------------------------------------------------------------+---------------------+ | Did the typical family net worth increase? ,... | c50 | 3 In the 2019 SCF, a small portion of the data collection overlapped with early months of | 0.29270064592817646 | | | | the COVID- ... | | +-------------------------------------------------+--------------+------------------------------------------------------------------------------------------------------+---------------------+

Remote-Modell für die Textgenerierung erstellen

Erstellen Sie ein Remote-Modell, das ein gehostetes Vertex AI-Textgenerierungsmodell darstellt:

Öffnen Sie in der Google Cloud Console die Seite BigQuery.

Führen Sie im Abfrageeditor folgende Abfrage aus:

CREATE OR REPLACE MODEL `bqml_tutorial.text_model` REMOTE WITH CONNECTION `LOCATION.CONNECTION_ID` OPTIONS (ENDPOINT = 'gemini-2.0-flash-001');

Ersetzen Sie Folgendes:

LOCATION: Standort der VerbindungCONNECTION_IDist die ID Ihrer BigQuery-Verbindung.Wenn Sie sich Verbindungsdetails in der Google Cloud Console ansehen, ist die

CONNECTION_IDder Wert im letzten Abschnitt der voll qualifizierten Verbindungs-ID, der unter Verbindungs-ID angezeigt wird, z. B.projects/myproject/locations/connection_location/connections/myconnection.

Durch Vektorsuchergebnisse erweiterten Text generieren

Führen Sie eine Vektorsuche für die Einbettungen durch, um semantisch ähnliche PDF-Inhalte zu identifizieren. Verwenden Sie dann die Funktion ML.GENERATE_TEXT mit den Vektorsuchergebnissen, um die Prompt-Eingabe zu erweitern und die Ergebnisse der Textgenerierung zu verbessern. In diesem Fall werden in der Abfrage Informationen aus den PDF-Chunks verwendet, um eine Frage zur Änderung des Familiennettovermögens im letzten Jahrzehnt zu beantworten.

Öffnen Sie in der Google Cloud Console die Seite BigQuery.

Führen Sie im Abfrageeditor folgende Abfrage aus:

SELECT ml_generate_text_llm_result AS generated FROM ML.GENERATE_TEXT( MODEL `bqml_tutorial.text_model`, ( SELECT CONCAT( 'Did the typical family net worth change? How does this compare the SCF survey a decade earlier? Be concise and use the following context:', STRING_AGG(FORMAT("context: %s and reference: %s", base.content, base.uri), ',\n')) AS prompt, FROM VECTOR_SEARCH( TABLE `bqml_tutorial.embeddings`, 'ml_generate_embedding_result', ( SELECT ml_generate_embedding_result, content AS query FROM ML.GENERATE_EMBEDDING( MODEL `bqml_tutorial.embedding_model`, ( SELECT 'Did the typical family net worth change? How does this compare the SCF survey a decade earlier?' AS content ) ) ), top_k => 10, OPTIONS => '{"fraction_lists_to_search": 0.01}') ), STRUCT(512 AS max_output_tokens, TRUE AS flatten_json_output) );

Die Ausgabe sieht in etwa so aus:

+-------------------------------------------------------------------------------+ | generated | +-------------------------------------------------------------------------------+ | Between the 2019 and 2022 Survey of Consumer Finances (SCF), real median | | family net worth surged 37 percent to $192,900, and real mean net worth | | increased 23 percent to $1,063,700. This represents the largest three-year | | increase in median net worth in the history of the modern SCF, exceeding the | | next largest by more than double. In contrast, between 2010 and 2013, real | | median net worth decreased 2 percent, and real mean net worth remained | | unchanged. | +-------------------------------------------------------------------------------+

Bereinigen

- In the Google Cloud console, go to the Manage resources page.

- In the project list, select the project that you want to delete, and then click Delete.

- In the dialog, type the project ID, and then click Shut down to delete the project.