Exportar modelos

En esta página se explica cómo exportar modelos de BigQuery ML. Puedes exportar modelos de BigQuery ML a Cloud Storage y usarlos para hacer predicciones online o editarlos en Python. Puedes exportar un modelo de BigQuery ML de las siguientes formas:

- Con la Google Cloud consola.

- Usar la instrucción

EXPORT MODEL. - Usando el comando

bq extracten la herramienta de línea de comandos bq. - Enviar un trabajo de

extracta través de la API o de las bibliotecas de cliente.

Puede exportar los siguientes tipos de modelos:

AUTOENCODERAUTOML_CLASSIFIERAUTOML_REGRESSORBOOSTED_TREE_CLASSIFIERBOOSTED_TREE_REGRESSORDNN_CLASSIFIERDNN_REGRESSORDNN_LINEAR_COMBINED_CLASSIFIERDNN_LINEAR_COMBINED_REGRESSORKMEANSLINEAR_REGLOGISTIC_REGMATRIX_FACTORIZATIONRANDOM_FOREST_CLASSIFIERRANDOM_FOREST_REGRESSORTENSORFLOW(modelos importados de TensorFlow)PCATRANSFORM_ONLY

Exportar formatos y muestras de modelos

En la siguiente tabla se muestran los formatos de destino de exportación de cada tipo de modelo de BigQuery ML y se proporciona un ejemplo de los archivos que se escriben en el segmento de Cloud Storage.

| Tipo de modelo | Formato de exportación del modelo | Ejemplo de archivos exportados |

|---|---|---|

| AUTOML_CLASSIFIER | SavedModel de TensorFlow (TF 2.1.0) | gcs_bucket/

|

| AUTOML_REGRESSOR | ||

| AUTOENCODER | SavedModel de TensorFlow (TF 1.15 o versiones posteriores) | |

| DNN_CLASSIFIER | ||

| DNN_REGRESSOR | ||

| DNN_LINEAR_COMBINED_CLASSIFIER | ||

| DNN_LINEAR_COMBINED_REGRESSOR | ||

| KMEANS | ||

| LINEAR_REGRESSOR | ||

| LOGISTIC_REG | ||

| MATRIX_FACTORIZATION | ||

| PCA | ||

| TRANSFORM_ONLY | ||

| BOOSTED_TREE_CLASSIFIER | Refuerzo (XGBoost 0.82) | gcs_bucket/

main.py es para la ejecución local. Consulta más información sobre la implementación de modelos.

|

| BOOSTED_TREE_REGRESSOR | ||

| RANDOM_FOREST_REGRESSOR | ||

| RANDOM_FOREST_REGRESSOR | ||

| TENSORFLOW (importado) | SavedModel de TensorFlow | Exactamente los mismos archivos que estaban presentes al importar el modelo |

Exportar un modelo entrenado con TRANSFORM

Si el modelo se entrena con la cláusula TRANSFORM, un modelo de preprocesamiento adicional realiza la misma lógica en la cláusula TRANSFORM y se guarda en formato TensorFlow SavedModel en el subdirectorio transform.

Puedes desplegar un modelo entrenado con la cláusula TRANSFORM en Vertex AI y de forma local. Para obtener más información, consulta el artículo sobre el despliegue de modelos.

| Formato de exportación del modelo | Ejemplo de archivos exportados |

|---|---|

|

Modelo de predicción: TensorFlow SavedModel o Booster (XGBoost 0.82).

Modelo de preprocesamiento para la cláusula TRANSFORM: SavedModel de TensorFlow (TF 2.5 o versiones posteriores) |

gcs_bucket/

|

El modelo no contiene la información sobre la ingeniería de funciones

realizada fuera de la cláusula TRANSFORM

durante el entrenamiento. Por ejemplo, cualquier elemento de la instrucción SELECT . Por lo tanto, tendrás que convertir manualmente los datos de entrada antes de introducirlos en el modelo de preprocesamiento.

Tipos de datos admitidos

Cuando se exportan modelos entrenados con la cláusula TRANSFORM,

se admiten los siguientes tipos de datos para la cláusula TRANSFORM.

| Tipo de entrada TRANSFORM | Ejemplos de entrada de TRANSFORM | Muestras de entrada del modelo de preprocesamiento exportadas |

|---|---|---|

| INT64 |

10,

|

tf.constant(

|

| NUMERIC |

NUMERIC 10,

|

tf.constant(

|

| BIGNUMERIC |

BIGNUMERIC 10,

|

tf.constant(

|

| FLOAT64 |

10.0,

|

tf.constant(

|

| BOOL |

TRUE,

|

tf.constant(

|

| STRING |

'abc',

|

tf.constant(

|

| BYTES |

b'abc',

|

tf.constant(

|

| FECHA |

DATE '2020-09-27',

|

tf.constant(

|

| DATETIME |

DATETIME '2023-02-02 02:02:01.152903',

|

tf.constant(

|

| HORA |

TIME '16:32:36.152903',

|

tf.constant(

|

| TIMESTAMP |

TIMESTAMP '2017-02-28 12:30:30.45-08',

|

tf.constant(

|

| ARRAY |

['a', 'b'],

|

tf.constant(

|

| ARRAY< STRUCT< INT64, FLOAT64>> |

[(1, 1.0), (2, 1.0)],

|

tf.sparse.from_dense(

|

| NULL |

NULL,

|

tf.constant(

|

Funciones de SQL admitidas

Cuando exportes modelos entrenados con la cláusula TRANSFORM, puedes usar las siguientes funciones de SQL dentro de la cláusula TRANSFORM.

- Operadores

+,-,*,/,=,<,>,<=,>=,!=,<>,[NOT] BETWEEN,[NOT] IN,IS [NOT] NULL,IS [NOT] TRUE,IS [NOT] FALSE,NOT,AND,OR.

- Expresiones condicionales

CASE expr,CASE,COALESCE,IF,IFNULLyNULLIF.

- Funciones matemáticas

ABS,ACOS,ACOSH,ASINH,ATAN,ATAN2,ATANH,CBRT,CEIL,CEILING,COS,COSH,COT,COTH,CSC,CSCH,EXP,FLOOR,IS_INF,IS_NAN,LN,LOG,LOG10,MOD,POW,POWER,SEC,SECH,SIGN,SIN,SINH,SQRT,TANyTANH.

- Funciones de conversión

CAST AS INT64,CAST AS FLOAT64,CAST AS NUMERIC,CAST AS BIGNUMERIC,CAST AS STRING,SAFE_CAST AS INT64,SAFE_CAST AS FLOAT64

- Funciones de cadena

CONCAT,LEFT,LENGTH,LOWER,REGEXP_REPLACE,RIGHT,SPLIT,SUBSTR,SUBSTRING,TRIM,UPPER.

- Funciones de fecha

Date,DATE_ADD,DATE_SUB,DATE_DIFF,DATE_TRUNC,EXTRACT,FORMAT_DATE,PARSE_DATE,SAFE.PARSE_DATE.

- Funciones de fecha y hora

DATETIME,DATETIME_ADD,DATETIME_SUB,DATETIME_DIFF,DATETIME_TRUNC,EXTRACT,PARSE_DATETIME,SAFE.PARSE_DATETIME.

- Funciones de tiempo

TIME,TIME_ADD,TIME_SUB,TIME_DIFF,TIME_TRUNC,EXTRACT,FORMAT_TIME,PARSE_TIME,SAFE.PARSE_TIME.

- Funciones de marca de tiempo

TIMESTAMP,TIMESTAMP_ADD,TIMESTAMP_SUB,TIMESTAMP_DIFF,TIMESTAMP_TRUNC,FORMAT_TIMESTAMP,PARSE_TIMESTAMP,SAFE.PARSE_TIMESTAMP,TIMESTAMP_MICROS,TIMESTAMP_MILLIS,TIMESTAMP_SECONDS,EXTRACT,STRING,UNIX_MICROS,UNIX_MILLIS,UNIX_SECONDS.

- Funciones de preprocesamiento manual

ML.IMPUTER,ML.HASH_BUCKETIZE,ML.LABEL_ENCODER,ML.MULTI_HOT_ENCODER,ML.NGRAMS,ML.ONE_HOT_ENCODER,ML.BUCKETIZE,ML.MAX_ABS_SCALER,ML.MIN_MAX_SCALER,ML.NORMALIZER,ML.QUANTILE_BUCKETIZE,ML.ROBUST_SCALER,ML.STANDARD_SCALER.

Limitaciones

Se aplican las siguientes limitaciones al exportar modelos:

No se puede exportar el modelo si se ha usado alguna de las siguientes funciones durante el entrenamiento:

- Se han detectado tipos de funciones

ARRAY,TIMESTAMPoGEOGRAPHYen los datos de entrada.

- Se han detectado tipos de funciones

Los modelos exportados de los tipos

AUTOML_REGRESSORyAUTOML_CLASSIFIERno se pueden desplegar en Vertex AI para hacer predicciones online.El límite de tamaño del modelo es de 1 GB para la exportación de modelos de factorización de matrices. El tamaño del modelo es aproximadamente proporcional a

num_factors, por lo que puedes reducirnum_factorsdurante el entrenamiento para reducir el tamaño del modelo si alcanzas el límite.En el caso de los modelos entrenados con la cláusula

TRANSFORMde BigQuery ML para el preprocesamiento manual de características, consulta los tipos de datos y las funciones admitidos para la exportación.Los modelos entrenados con la cláusula BigQuery ML

TRANSFORMantes del 18 de septiembre del 2023 deben volver a entrenarse para poder desplegarse a través de Model Registry para hacer predicciones online.Durante la exportación del modelo, se admiten

ARRAY<STRUCT<INT64, FLOAT64>>,ARRAYyTIMESTAMPcomo datos pretransformados, pero no como datos postransformados.

Exportar modelos de BigQuery ML

Para exportar un modelo, selecciona una de las siguientes opciones:

Consola

Abre la página de BigQuery en la Google Cloud consola

.En el panel de la izquierda, haz clic en Explorador:

Si no ves el panel de la izquierda, haz clic en Ampliar panel de la izquierda para abrirlo.

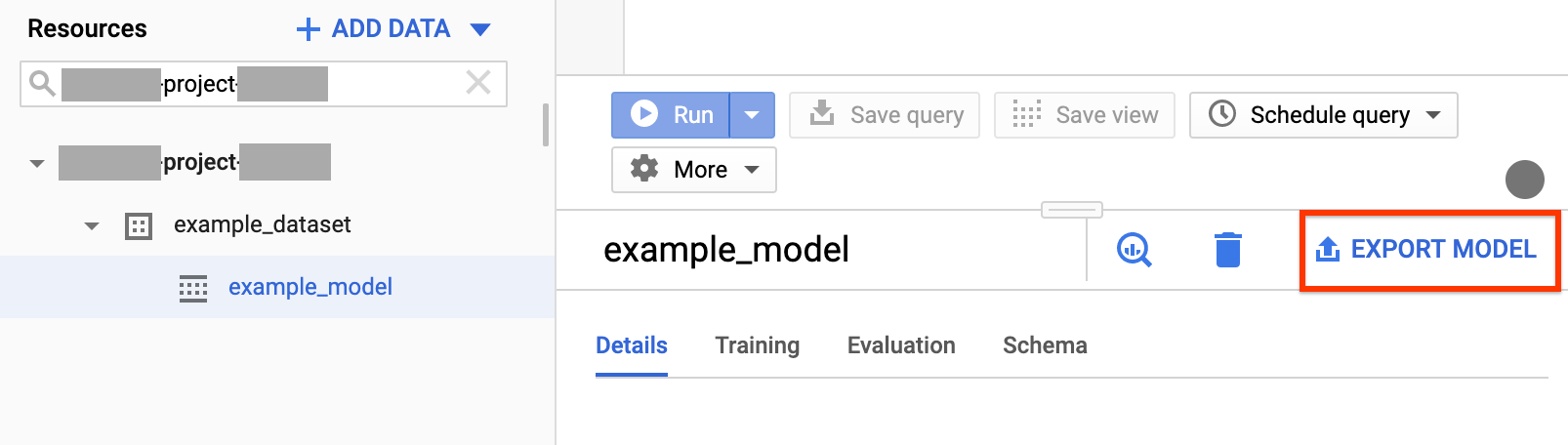

En el panel Explorador, despliega tu proyecto, haz clic en Conjuntos de datos y, a continuación, en el conjunto de datos que quieras.

Haga clic en Resumen > Modelos y, a continuación, en el nombre del modelo que quiera exportar.

Haz clic en Más > Exportar:

En el cuadro de diálogo Exportar modelo a Google Cloud Storage, haz lo siguiente:

- En Seleccionar ubicación de GCS, busca el bucket o la carpeta en los que quieras exportar el modelo y haz clic en Seleccionar.

- Haz clic en Enviar para exportar el modelo.

Para comprobar el progreso del trabajo, en el panel Explorador, haz clic en Historial de trabajos y busca un trabajo de tipo EXTRACT.

SQL

La instrucción EXPORT MODEL te permite exportar modelos de BigQuery ML a Cloud Storage mediante la sintaxis de consulta GoogleSQL.

Para exportar un modelo de BigQuery ML en la consola mediante la instrucción EXPORT MODEL, sigue estos pasos: Google Cloud

En la Google Cloud consola, abre la página de BigQuery.

Haz clic en Redactar nueva consulta.

En el campo Editor de consultas, escribe tu

EXPORT MODELsentencia.La siguiente consulta exporta un modelo llamado

myproject.mydataset.mymodela un segmento de Cloud Storage con el URIgs://bucket/path/to/saved_model/.EXPORT MODEL `myproject.mydataset.mymodel` OPTIONS(URI = 'gs://bucket/path/to/saved_model/')

Haz clic en Ejecutar. Cuando se complete la consulta, aparecerá lo siguiente en el panel Resultados de la consulta:

Successfully exported model.

bq

Usa el comando bq extract con la marca --model.

(Opcional) Proporciona la marca --destination_format y elige el formato del modelo exportado.

(Opcional) Proporciona la marca --location y asigna el valor de tu ubicación.

bq --location=location extract \ --destination_format format \ --model project_id:dataset.model \ gs://bucket/model_folder

Donde:

- location es el nombre de tu ubicación. La marca

--locationes opcional. Por ejemplo, si usas BigQuery en la región de Tokio, puedes asignar el valorasia-northeast1a la marca. Puedes definir un valor predeterminado para la ubicación mediante el archivo.bigqueryrc. - destination_format es el formato del modelo exportado:

ML_TF_SAVED_MODEL(predeterminado) oML_XGBOOST_BOOSTER. - project_id es el ID del proyecto.

- dataset es el nombre del conjunto de datos de origen.

- model es el modelo que vas a exportar.

- bucket es el nombre del segmento de Cloud Storage al que se exportan los datos. El conjunto de datos de BigQuery y el segmento de Cloud Storage deben estar en la misma ubicación.

- model_folder es el nombre de la carpeta en la que se escribirán los archivos de modelo exportados.

Ejemplos:

Por ejemplo, el siguiente comando exporta mydataset.mymodel en formato TensorFlow SavedModel a un segmento de Cloud Storage llamado mymodel_folder.

bq extract --model \ 'mydataset.mymodel' \ gs://example-bucket/mymodel_folder

El valor predeterminado de destination_format es ML_TF_SAVED_MODEL.

El siguiente comando exporta mydataset.mymodel en formato XGBoost Booster a un segmento de Cloud Storage llamado mymodel_folder.

bq extract --model \ --destination_format ML_XGBOOST_BOOSTER \ 'mydataset.mytable' \ gs://example-bucket/mymodel_folder

API

Para exportar un modelo, crea un trabajo extract y rellena la configuración del trabajo.

(Opcional) Especifica tu ubicación en la propiedad location de la sección jobReference del recurso de trabajo.

Crea una tarea de extracción que apunte al modelo de BigQuery ML y al destino de Cloud Storage.

Especifica el modelo de origen mediante el objeto de configuración

sourceModel, que contiene el ID del proyecto, el ID del conjunto de datos y el ID del modelo.La propiedad

destination URI(s)debe ser una URL cualificada con el formato gs://bucket/model_folder.Especifica el formato de destino configurando la propiedad

configuration.extract.destinationFormat. Por ejemplo, para exportar un modelo de árbol reforzado, asigna a esta propiedad el valorML_XGBOOST_BOOSTER.Para comprobar el estado de la tarea, llama a jobs.get(job_id) con el ID de la tarea devuelto por la solicitud inicial.

- Si

status.state = DONE, el trabajo se ha completado correctamente. - Si la propiedad

status.errorResultestá presente, significa que se ha producido un error en la solicitud y que el objeto incluirá información que describe lo que ha fallado. - Si no aparece

status.errorResult, significa que el trabajo se ha completado correctamente, aunque puede que se hayan producido algunos errores no graves. Los errores no fatales se indican en la propiedadstatus.errorsdel objeto de trabajo devuelto.

- Si

Notas sobre la API:

Como práctica recomendada, genera un ID único y pásalo como

jobReference.jobIdal llamar ajobs.insertpara crear un trabajo. Este enfoque es más sólido ante fallos de red, ya que el cliente puede sondear o volver a intentar la operación con el ID de trabajo conocido.Llamar a

jobs.inserten un ID de trabajo determinado es idempotente. En otras palabras, puedes volver a intentarlo tantas veces como quieras en el mismo ID de trabajo y, como máximo, una de esas operaciones se completará correctamente.

Java

Antes de probar este ejemplo, sigue las Javainstrucciones de configuración de la guía de inicio rápido de BigQuery con bibliotecas de cliente. Para obtener más información, consulta la documentación de referencia de la API Java de BigQuery.

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta el artículo Configurar la autenticación para bibliotecas de cliente.

Despliegue de modelo

Puedes desplegar el modelo exportado en Vertex AI y de forma local. Si la cláusula TRANSFORM del modelo contiene funciones de fecha, de fecha y hora, de hora o de marca de tiempo, debes usar la biblioteca bigquery-ml-utils en el contenedor. La excepción es si despliegas a través de Model Registry,

que no necesita modelos exportados ni contenedores de servicio.

Despliegue de Vertex AI

| Formato de exportación del modelo | Implementación |

|---|---|

| SavedModel de TensorFlow (modelos que no son de AutoML) | Despliega un SavedModel de TensorFlow. Debes crear el archivo SavedModel con una versión compatible de TensorFlow. |

| SavedModel de TensorFlow (modelos de AutoML) | No es compatible. |

| XGBoost Booster |

Usa una rutina de predicción personalizada. En el caso de los modelos de refuerzo de XGBoost, la información de preprocesamiento y postprocesamiento se guarda en los archivos exportados, y una rutina de predicción personalizada te permite implementar el modelo con los archivos exportados adicionales.

Debes crear los archivos de modelo con una versión compatible de XGBoost. |

Despliegue local

| Formato de exportación del modelo | Implementación |

|---|---|

| SavedModel de TensorFlow (modelos que no son de AutoML) |

SavedModel es un formato estándar que puedes desplegar en un contenedor de Docker de TensorFlow Serving. También puedes aprovechar la ejecución local de la predicción online de Vertex AI. |

| SavedModel de TensorFlow (modelos de AutoML) | Conteneriza y ejecuta el modelo. |

| XGBoost Booster |

Para ejecutar modelos de refuerzo de XGBoost de forma local, puedes usar el archivo main.py

exportado:

|

Formato de salida de la predicción

En esta sección se proporciona el formato de salida de las predicciones de los modelos exportados para cada tipo de modelo. Todos los modelos exportados admiten la predicción por lotes, por lo que pueden gestionar varias filas de entrada a la vez. Por ejemplo, hay dos filas de entrada en cada uno de los siguientes ejemplos de formato de salida.

AUTOENCODER

| Formato de salida de la predicción | Ejemplo de salida |

|---|---|

+------------------------+------------------------+------------------------+

| LATENT_COL_1 | LATENT_COL_2 | ... |

+------------------------+------------------------+------------------------+

| [FLOAT] | [FLOAT] | ... |

+------------------------+------------------------+------------------------+

|

+------------------+------------------+------------------+------------------+

| LATENT_COL_1 | LATENT_COL_2 | LATENT_COL_3 | LATENT_COL_4 |

+------------------------+------------+------------------+------------------+

| 0.21384512 | 0.93457112 | 0.64978097 | 0.00480489 |

+------------------+------------------+------------------+------------------+

|

AUTOML_CLASSIFIER

| Formato de salida de la predicción | Ejemplo de salida |

|---|---|

+------------------------------------------+

| predictions |

+------------------------------------------+

| [{"scores":[FLOAT], "classes":[STRING]}] |

+------------------------------------------+

|

+---------------------------------------------+

| predictions |

+---------------------------------------------+

| [{"scores":[1, 2], "classes":['a', 'b']}, |

| {"scores":[3, 0.2], "classes":['a', 'b']}] |

+---------------------------------------------+

|

AUTOML_REGRESSOR

| Formato de salida de la predicción | Ejemplo de salida |

|---|---|

+-----------------+

| predictions |

+-----------------+

| [FLOAT] |

+-----------------+

|

+-----------------+

| predictions |

+-----------------+

| [1.8, 2.46] |

+-----------------+

|

BOOSTED_TREE_CLASSIFIER y RANDOM_FOREST_CLASSIFIER

| Formato de salida de la predicción | Ejemplo de salida |

|---|---|

+-------------+--------------+-----------------+

| LABEL_PROBS | LABEL_VALUES | PREDICTED_LABEL |

+-------------+--------------+-----------------+

| [FLOAT] | [STRING] | STRING |

+-------------+--------------+-----------------+

|

+-------------+--------------+-----------------+

| LABEL_PROBS | LABEL_VALUES | PREDICTED_LABEL |

+-------------+--------------+-----------------+

| [0.1, 0.9] | ['a', 'b'] | ['b'] |

+-------------+--------------+-----------------+

| [0.8, 0.2] | ['a', 'b'] | ['a'] |

+-------------+--------------+-----------------+

|

BOOSTED_TREE_REGRESSOR Y RANDOM_FOREST_REGRESSOR

| Formato de salida de la predicción | Ejemplo de salida |

|---|---|

+-----------------+

| predicted_label |

+-----------------+

| FLOAT |

+-----------------+

|

+-----------------+

| predicted_label |

+-----------------+

| [1.8] |

+-----------------+

| [2.46] |

+-----------------+

|

DNN_CLASSIFIER

| Formato de salida de la predicción | Ejemplo de salida |

|---|---|

+---------------+-------------+-----------+---------+------------------------+--------+---------------+

| ALL_CLASS_IDS | ALL_CLASSES | CLASS_IDS | CLASSES | LOGISTIC (binary only) | LOGITS | PROBABILITIES |

+---------------+-------------+-----------+---------+------------------------+--------+---------------+

| [INT64] | [STRING] | INT64 | STRING | FLOAT | [FLOAT]| [FLOAT] |

+---------------+-------------+-----------+---------+------------------------+--------+---------------+

|

+---------------+-------------+-----------+---------+------------------------+--------+---------------+

| ALL_CLASS_IDS | ALL_CLASSES | CLASS_IDS | CLASSES | LOGISTIC (binary only) | LOGITS | PROBABILITIES |

+---------------+-------------+-----------+---------+------------------------+--------+---------------+

| [0, 1] | ['a', 'b'] | [0] | ['a'] | [0.36] | [-0.53]| [0.64, 0.36] |

+---------------+-------------+-----------+---------+------------------------+--------+---------------+

| [0, 1] | ['a', 'b'] | [0] | ['a'] | [0.2] | [-1.38]| [0.8, 0.2] |

+---------------+-------------+-----------+---------+------------------------+--------+---------------+

|

DNN_REGRESSOR

| Formato de salida de la predicción | Ejemplo de salida |

|---|---|

+-----------------+

| PREDICTED_LABEL |

+-----------------+

| FLOAT |

+-----------------+

|

+-----------------+

| PREDICTED_LABEL |

+-----------------+

| [1.8] |

+-----------------+

| [2.46] |

+-----------------+

|

DNN_LINEAR_COMBINED_CLASSIFIER

| Formato de salida de la predicción | Ejemplo de salida |

|---|---|

+---------------+-------------+-----------+---------+------------------------+--------+---------------+

| ALL_CLASS_IDS | ALL_CLASSES | CLASS_IDS | CLASSES | LOGISTIC (binary only) | LOGITS | PROBABILITIES |

+---------------+-------------+-----------+---------+------------------------+--------+---------------+

| [INT64] | [STRING] | INT64 | STRING | FLOAT | [FLOAT]| [FLOAT] |

+---------------+-------------+-----------+---------+------------------------+--------+---------------+

|

+---------------+-------------+-----------+---------+------------------------+--------+---------------+

| ALL_CLASS_IDS | ALL_CLASSES | CLASS_IDS | CLASSES | LOGISTIC (binary only) | LOGITS | PROBABILITIES |

+---------------+-------------+-----------+---------+------------------------+--------+---------------+

| [0, 1] | ['a', 'b'] | [0] | ['a'] | [0.36] | [-0.53]| [0.64, 0.36] |

+---------------+-------------+-----------+---------+------------------------+--------+---------------+

| [0, 1] | ['a', 'b'] | [0] | ['a'] | [0.2] | [-1.38]| [0.8, 0.2] |

+---------------+-------------+-----------+---------+------------------------+--------+---------------+

|

DNN_LINEAR_COMBINED_REGRESSOR

| Formato de salida de la predicción | Ejemplo de salida |

|---|---|

+-----------------+

| PREDICTED_LABEL |

+-----------------+

| FLOAT |

+-----------------+

|

+-----------------+

| PREDICTED_LABEL |

+-----------------+

| [1.8] |

+-----------------+

| [2.46] |

+-----------------+

|

KMEANS

| Formato de salida de la predicción | Ejemplo de salida |

|---|---|

+--------------------+--------------+---------------------+

| CENTROID_DISTANCES | CENTROID_IDS | NEAREST_CENTROID_ID |

+--------------------+--------------+---------------------+

| [FLOAT] | [INT64] | INT64 |

+--------------------+--------------+---------------------+

|

+--------------------+--------------+---------------------+

| CENTROID_DISTANCES | CENTROID_IDS | NEAREST_CENTROID_ID |

+--------------------+--------------+---------------------+

| [1.2, 1.3] | [1, 2] | [1] |

+--------------------+--------------+---------------------+

| [0.4, 0.1] | [1, 2] | [2] |

+--------------------+--------------+---------------------+

|

LINEAR_REG

| Formato de salida de la predicción | Ejemplo de salida |

|---|---|

+-----------------+

| PREDICTED_LABEL |

+-----------------+

| FLOAT |

+-----------------+

|

+-----------------+

| PREDICTED_LABEL |

+-----------------+

| [1.8] |

+-----------------+

| [2.46] |

+-----------------+

|

LOGISTIC_REG

| Formato de salida de la predicción | Ejemplo de salida |

|---|---|

+-------------+--------------+-----------------+

| LABEL_PROBS | LABEL_VALUES | PREDICTED_LABEL |

+-------------+--------------+-----------------+

| [FLOAT] | [STRING] | STRING |

+-------------+--------------+-----------------+

|

+-------------+--------------+-----------------+

| LABEL_PROBS | LABEL_VALUES | PREDICTED_LABEL |

+-------------+--------------+-----------------+

| [0.1, 0.9] | ['a', 'b'] | ['b'] |

+-------------+--------------+-----------------+

| [0.8, 0.2] | ['a', 'b'] | ['a'] |

+-------------+--------------+-----------------+

|

MATRIX_FACTORIZATION

Nota: Actualmente, solo admitimos que se introduzca un usuario y se devuelvan los 50 pares principales (predicted_rating, predicted_item) ordenados por predicted_rating de forma descendente.

| Formato de salida de la predicción | Ejemplo de salida |

|---|---|

+--------------------+--------------+

| PREDICTED_RATING | PREDICTED_ITEM |

+------------------+----------------+

| [FLOAT] | [STRING] |

+------------------+----------------+

|

+--------------------+--------------+

| PREDICTED_RATING | PREDICTED_ITEM |

+------------------+----------------+

| [5.5, 1.7] | ['A', 'B'] |

+------------------+----------------+

| [7.2, 2.7] | ['B', 'A'] |

+------------------+----------------+

|

TENSORFLOW (importado)

| Formato de salida de la predicción |

|---|

| Igual que el modelo importado |

PCA

| Formato de salida de la predicción | Ejemplo de salida |

|---|---|

+-------------------------+---------------------------------+

| PRINCIPAL_COMPONENT_IDS | PRINCIPAL_COMPONENT_PROJECTIONS |

+-------------------------+---------------------------------+

| [INT64] | [FLOAT] |

+-------------------------+---------------------------------+

|

+-------------------------+---------------------------------+

| PRINCIPAL_COMPONENT_IDS | PRINCIPAL_COMPONENT_PROJECTIONS |

+-------------------------+---------------------------------+

| [1, 2] | [1.2, 5.0] |

+-------------------------+---------------------------------+

|

TRANSFORM_ONLY

| Formato de salida de la predicción |

|---|

Es igual que las columnas especificadas en la cláusula TRANSFORM

del modelo.

|

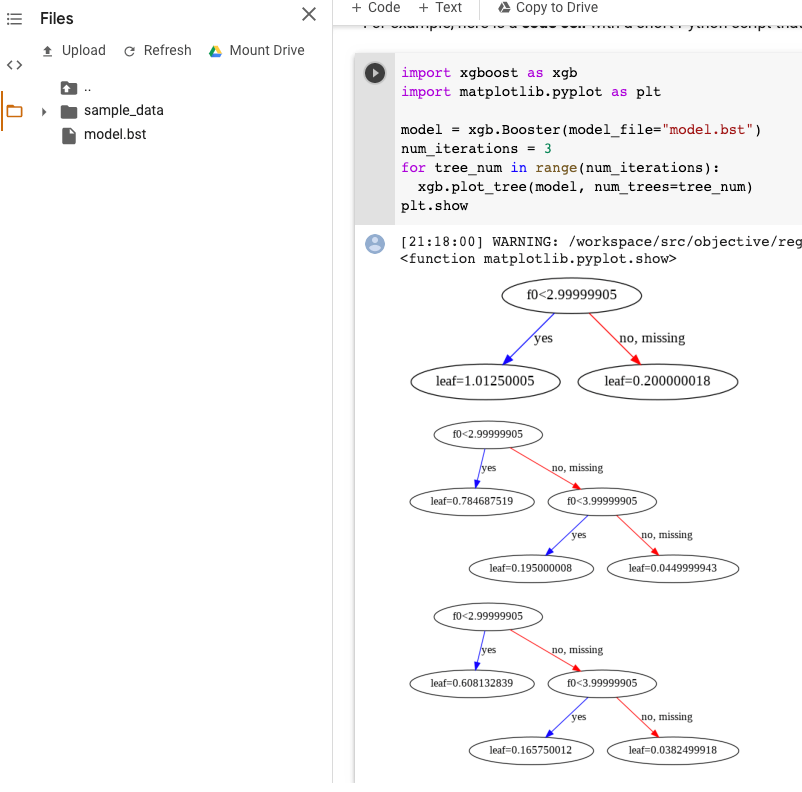

Visualización del modelo XGBoost

Puedes visualizar los árboles reforzados con la API de Python plot_tree después de exportar el modelo. Por ejemplo, puedes usar Colab sin instalar las dependencias:

- Exporta el modelo de árbol reforzado a un segmento de Cloud Storage.

- Descarga el archivo

model.bstdel segmento de Cloud Storage. - En un cuaderno de Colab,

sube el archivo

model.bstaFiles. Ejecuta el siguiente código en el cuaderno:

import xgboost as xgb import matplotlib.pyplot as plt model = xgb.Booster(model_file="model.bst") num_iterations = <iteration_number> for tree_num in range(num_iterations): xgb.plot_tree(model, num_trees=tree_num) plt.show

En este ejemplo se representan varios árboles (un árbol por iteración):

Actualmente, no guardamos los nombres de las funciones en el modelo, por lo que verás nombres como "f0", "f1" y así sucesivamente. Puedes encontrar los nombres de las funciones correspondientes en el archivo assets/model_metadata.json exportado usando estos nombres (como "f0") como índices.

Permisos obligatorios

Para exportar un modelo de BigQuery ML a Cloud Storage, necesitas permisos para acceder al modelo de BigQuery ML, permisos para ejecutar una tarea de extracción y permisos para escribir los datos en el segmento de Cloud Storage.

Permisos de BigQuery

Para exportar un modelo, como mínimo debes tener permisos de

bigquery.models.export. Los siguientes roles predefinidos de gestión de identidades y accesos (IAM) tienen permisosbigquery.models.export:bigquery.dataViewerbigquery.dataOwnerbigquery.dataEditorbigquery.admin

Para ejecutar una tarea de exportación, como mínimo debes tener los permisos

bigquery.jobs.create. Los siguientes roles de gestión de identidades y accesos predefinidos tienen permisos debigquery.jobs.create:bigquery.userbigquery.jobUserbigquery.admin

Permisos de Cloud Storage

Para escribir los datos en un segmento de Cloud Storage, debe tener los permisos

storage.objects.create. Los siguientes roles de gestión de identidades y accesos predefinidos tienen permisos destorage.objects.create:storage.objectCreatorstorage.objectAdminstorage.admin

Para obtener más información sobre los roles y permisos de gestión de identidades y accesos en BigQuery ML, consulta el artículo sobre el control de acceso.

Mover datos de BigQuery entre ubicaciones

No puede cambiar la ubicación de un conjunto de datos después de crearlo, pero sí puede hacer una copia del conjunto de datos.

Política de cuotas

Para obtener información sobre las cuotas de tareas de extracción, consulta la sección Tareas de extracción de la página Cuotas y límites.

Precios

No se cobra por exportar modelos de BigQuery ML, pero las exportaciones están sujetas a las cuotas y los límites de BigQuery. Para obtener más información sobre los precios de BigQuery, consulta la página Precios.

Una vez que se hayan exportado los datos, se te cobrará por almacenarlos en Cloud Storage. Para obtener más información sobre los precios de Cloud Storage, consulta la página Precios de Cloud Storage.

Siguientes pasos

- Sigue el tutorial Exportar un modelo de BigQuery ML para hacer predicciones online.