Questa guida alla pianificazione fornisce agli amministratori SAP e Google Cloud le informazioni necessarie per pianificare la replica dei dati SAP in BigQuery utilizzando la versione 2.9 (più recente) di BigQuery Connector per SAP con SAP LT Replication Server.

Questa guida tratta i seguenti argomenti:

- Requisiti software

- Sicurezza

- Networking

- Pianificazione del rendimento

- Opzioni di mappatura di tabelle e campi

- Ciclo di vita dell'assistenza

Per informazioni sugli acceleratori di soluzioni per la modellazione dei dati SAP in BigQuery, consulta il Google Cloud Cortex Framework.

Requisiti software

Questa sezione descrive i requisiti software per BigQuery Connector per SAP.

Puoi installare BigQuery Connector per SAP in SAP LT Replication Server su Google Cloud, on-premise o su cloud pubblici, come AWS, Azure e così via.

Requisiti della versione del software SAP

Le versioni richieste di SAP LT Replication Server e dei sistemi di origine SAP variano a seconda che tu installi SAP LT Replication Server sul proprio server in un'architettura autonoma o all'interno del sistema di applicazioni ABAP di origine in un'architettura incorporata.

Anche i requisiti software SAP variano a seconda del sistema SAP che utilizzi come origine dati: SAP S/4HANA o SAP ECC.

Per visualizzare le versioni del software SAP supportate da BigQuery Connector per SAP, seleziona la scheda corrispondente al tuo sistema di origine SAP: Google Cloud

S/4HANA

| Architettura dell'installazione | Sistema | Versioni supportate | Componente aggiuntivo dell'interfaccia utente (UI) |

|---|---|---|---|

| Autonoma | Sistema di origine |

|

Assicurati che il componente aggiuntivo UI sia la versione più recente compatibile con la tua versione di SAP NetWeaver, come consigliato da SAP. /UI2/CL_JSON: PL12 o versioni successive. Per informazioni sulla versione minima richiesta di UI Add-On, consulta la sezione "Support Package" nella nota SAP 22798102 - /UI2/CL_JSON corrections - PL12. Per informazioni sulla compatibilità di UI Add-On con SAP NetWeaver, vedi: |

| Sistema SAP LT Replication Server |

|

||

| Strato | Sistema di origine |

|

ECC

| Architettura dell'installazione | Sistema | Versioni supportate | Componente aggiuntivo dell'interfaccia utente (UI) |

|---|---|---|---|

| Autonoma | Sistema di origine |

|

Assicurati che il componente aggiuntivo UI sia la versione più recente compatibile con la tua versione di SAP NetWeaver, come consigliato da SAP. /UI2/CL_JSON: PL12 o versioni successive. Per informazioni sulla versione minima richiesta di UI Add-On, consulta la sezione "Support Package" nella nota SAP 22798102 - /UI2/CL_JSON corrections - PL12. Per informazioni sulla compatibilità di UI Add-On con SAP NetWeaver, vedi: |

| Sistema SAP LT Replication Server |

|

||

| Strato | Sistema di origine |

|

Requisiti del sistema operativo

BigQuery Connector per SAP supporta qualsiasi sistema operativo supportato da SAP LT Replication Server.

Per informazioni sui sistemi operativi supportati da SAP LT Replication Server, consulta la matrice di disponibilità dei prodotti SAP.

Requisito dell'account di fatturazione Cloud

Sebbene BigQuery Connector per SAP sia offerto senza costi, è necessario un account di fatturazione Cloud per ricevere il pacchetto di installazione.

Scalabilità

Per volumi molto grandi, ad esempio miliardi di record di dati con milioni di delta, BigQuery Connector per SAP utilizza le funzioni di scalabilità e partizionamento di SAP LT Replication Server per parallelizzare l'estrazione dei dati su larga scala. Per ulteriori informazioni, consulta la guida al dimensionamento per la tua versione di SAP LT Replication Server nel portale di assistenza SAP.

Sul lato Google Cloud , a seconda del percorso di replica, BigQuery Connector per SAP utilizza diversi servizi Google Cloud per scalare il caricamento dei dati:

- Per la replica CDC tramite Pub/Sub, BigQuery Connector per SAP utilizza l'API Pub/Sub e l'API Storage Write.

- Per la replica dei dati di streaming, BigQuery Connector per SAP utilizza l'API BigQuery Streaming.

Origini di replica supportate

BigQuery Connector per SAP supporta la maggior parte dei sistemi di origine di applicazioni e database comunemente utilizzati supportati da SAP LT Replication Server.

Origini delle applicazioni SAP supportate

Puoi replicare i dati dalle origini delle applicazioni SAP supportate da SAP LT Replication Server. BigQuery Connector per SAP supporta le versioni principali delle applicazioni aziendali in manutenzione come origini dati, nonché le applicazioni legacy precedenti. Alcune delle applicazioni SAP supportate includono:

- SAP Business Suite 7

- S/4HANA

- Applicazioni SAP in esecuzione su SAP NetWeaver

Per la replica dei dati da SAP Business Warehouse, SAP sconsiglia l'utilizzo di SAP LT Replication Server. Per ulteriori informazioni da SAP, consulta la nota SAP 2525755.

Le applicazioni cloud SAP, come S/4HANA Cloud, SAP Ariba, SAP SuccessFactors e altre, non sono supportate.

Origini dati supportate

Puoi replicare solo tabelle trasparenti o cluster.

BigQuery Connector per SAP non supporta la replica delle viste SAP Core Data Services (CDS).

In Information Design Tool, BigQuery è supportato a partire da SAP BusinessObjects Business Intelligence 4.3 come origine dati. Puoi eseguire query sui dati archiviati in BigQuery dagli strumenti di reporting SAP BusinessObjects, come SAP BusinessObjects Web Intelligence e SAP Crystal Reports for Enterprise, tra gli altri.

Per ulteriori informazioni sul controllo di compatibilità, consulta la nota SAP 2750723 - Support of Google BigQuery in SAP BI platform products.

Sicurezza

Quando implementi la sicurezza per la replica dei dati da SAP LT Replication Server a BigQuery, devi implementare i controlli di sicurezza in SAP LT Replication Server, nel sistema operativo host di SAP LT Replication Server e inGoogle Cloud.

Per la comunicazione tra BigQuery Connector per SAP e BigQuery, BigQuery Connector per SAP utilizza la comunicazione HTTPS end-to-end e SSL.

Sicurezza SAP

Per controllare chi può configurare e utilizzare BigQuery Connector per SAP in SAP LT Replication Server, utilizza l'autorizzazione standard basata sui ruoli SAP.

BigQuery Connector per SAP fornisce l'oggetto

autorizzazione ZGOOG_MTID nell'ambito dell'installazione del trasporto.

Per configurare ed eseguire job di replica dei dati che utilizzano BigQuery Connector per SAP, puoi definire un ruolo con accesso amministrativo all'interno di SAP LT Replication Server, come descritto in Creare ruoli e autorizzazioni SAP per BigQuery Connector per SAP.

Ad esempio, potresti definire un ruolo denominato ZGOOGLE_BIGQUERY_ADMIN che

dispone di tutte le autorizzazioni SAP e delle autorizzazioni ZGOOG_MTID

necessarie per configurare e gestire

la replica dei dati in BigQuery utilizzando

BigQuery Connector per SAP.

Per ulteriori informazioni da SAP su ruoli e autorizzazione, consulta la guida alla sicurezza per la tua versione di SAP LT Replication Server nel portale di assistenza SAP.

Google Cloud sicurezza

L'implementazione della sicurezza su Google Cloud per BigQuery Connector per SAP può comportare i seguenti controlli di sicurezza:

- Autorizzazioni, ruoli, service account e chiavi IAM (Identity and Access Management).

- Controlli BigQuery impostati a livello di set di dati o tabella.

- Controlli di servizio VPC (Virtual Private Cloud) per servizi basati su API come BigQuery.

- Endpoint Private Service Connect che consentono il consumo privato di servizi, come BigQuery, in tutte le reti VPC.

Google Cloud Identity and Access Management

Per l'autenticazione e l'autorizzazione di BigQuery Connector per SAP, hai bisogno di unaccount di serviziot IAM nel progettoGoogle Cloud che contiene il tuo set di dati BigQuery.

Per l'autorizzazione a interagire con le risorse Google Cloud , concedi ruoli alaccount di serviziot che contiene le autorizzazioni per interagire con i servizi BigQuery e Pub/Sub.

Per la replica dei dati di streaming (solo inserimento), le autorizzazioni necessarie a BigQuery Connector per SAP per accedere a BigQuery sono contenute nei seguenti ruoli IAM:

Per la replica Change Data Capture (CDC), le autorizzazioni necessarie a BigQuery Connector per SAP per accedere a Pub/Sub e BigQuery sono contenute nei seguenti ruoli IAM:

Se SAP LT Replication Server è in esecuzione su una VM Compute Engine, devi anche concedere il ruolo Creatore token service account alaccount di serviziont della VM host.

Se SAP LT Replication Server è in esecuzione on-premise o su un'altra piattaforma cloud, oltre a creare un account di servizio, devi anche creare una chiave dell'account di servizio per BigQuery Connector per SAP. L'amministratore SAP installa la chiave sull'host SAP LT Replication Server. Quando BigQuery Connector per SAP si connette a Pub/Sub o BigQuery, SAP LT Replication Server utilizza la chiave dell'account di servizio per l'autenticazione con Google Cloud.

La chiave del account di servizio non è necessaria quando SAP LT Replication Server è in esecuzione su Google Cloud.

Per ulteriori informazioni su IAM, service account, ruoli e autorizzazioni, consulta:

- Service account

- Autenticazione come service account

- Best practice per gli account di servizio

- Introduzione all'autenticazione dell'API BigQuery

Controlli dell'accesso a set di dati e tabelle BigQuery

Oltre ai controlli IAM, puoi anche controllare l'accesso utilizzando BigQuery. Per BigQuery Connector per SAP, puoi impostare i controlli dell'accesso su set di dati e tabelle.

Per ulteriori informazioni, vedi:

Controlli di servizio VPC

Su Google Cloud, le regole firewall VPC non sono applicabili alle interazioni basate su API con BigQuery. Puoi invece utilizzare Controlli di servizio VPC per limitare il traffico.

Se il tuo workload SAP viene eseguito su Google Cloud, puoi implementare i Controlli di servizio VPC definendo i perimetri di servizio. Per maggiori informazioni, consulta Perimetri di servizio.

Se il tuo workload SAP non è in esecuzione su Google Cloud, puoi implementare i Controlli di servizio VPC nell'ambito della configurazione dell'accesso privato Google per gli host on-premise.

Per saperne di più sulla sicurezza di rete per BigQuery, vedi Sicurezza di rete.

Endpoint di Private Service Connect

Se vuoi configurare endpoint nella tua rete VPC che consentano il consumo privato di servizi gestiti da Google come BigQuery, puoi utilizzare Private Service Connect.

Private Service Connect ti consente di creare endpoint privati che utilizzano indirizzi IP interni da un intervallo CIDR VPC per accedere ad API e servizi Google. Puoi anche utilizzare Private Service Connect per creare un nome DNS privato personalizzato per l'API BigQuery Streaming. Per ulteriori informazioni, consulta Private Service Connect.

Per BigQuery Connector per SAP in esecuzione su un host esterno a Google Cloud, Private Service Connect non è supportato.

Ulteriori informazioni sulla sicurezza di Google Cloud

Per ulteriori informazioni su account di sicurezza, ruoli e autorizzazioni, consulta:

- Service account

- Creazione e abilitazione degli account di servizio per le istanze

- Panoramica della sicurezza e della governance dei dati

- Autenticazione e autorizzazione BigQuery

Networking

Quando pianifichi il percorso di rete per la replica in BigQuery, considera quanto segue:

- Larghezza di banda

- Latenza e il suo impatto sul consumo di risorse sull'host SAP LT Replication Server

- Volume di dati e relativo impatto sul carico di rete esistente

- Se il tuo carico di lavoro SAP non viene eseguito su Google Cloud, quale tipo di connessione utilizzare: Cloud Interconnect o Cloud VPN

Connessione a Google Cloud

Se i tuoi sistemi SAP non vengono eseguiti su Google Cloud e non hai già una connessione dai tuoi sistemi SAP a Google Cloud, devi stabilire una connessione e configurare l'accesso privato alle API Google Cloud .

Puoi stabilire una connessione a Google Cloud utilizzando Cloud Interconnect o Cloud VPN.

Cloud Interconnect in genere fornisce larghezza di banda più elevata, latenza inferiore e minore contesa di rete rispetto a Cloud VPN. Per i job di replica con volumi elevati e sensibili alle prestazioni, Google Cloud consiglia Cloud Interconnect per BigQuery Connector per SAP.

Con Cloud VPN, i dati di replica vengono trasferiti sulla rete internet pubblica, pertanto la contesa di rete è meno prevedibile e le latenze sono in genere più elevate.

Indipendentemente dall'opzione di connessione scelta, devi esaminare tutto il traffico che prevedi che la connessione supporti. Determina se la connessione ha larghezza di banda e velocità di rete sufficienti per supportare i job di replica e qualsiasi altro carico di lavoro senza influire negativamente su nessuno dei due.

Le connessioni lente possono aumentare il consumo di risorse sia sul server di origine SAP sia sull'host SAP LT Replication Server estendendo il tempo necessario per completare i job delle risorse, il che mantiene le risorse necessarie per la replica impegnate per periodi di tempo più lunghi.

Per saperne di più sulle opzioni di connessione, consulta le seguenti risorse:

Per utilizzare un server proxy per inviare le richieste HTTP a Google Cloud, ti

consigliamo di utilizzare le destinazioni RFC definite nella

transazione SM59.

Destinazioni RFC

I file di trasporto di BigQuery Connector per SAP contengono le seguenti destinazioni RFC di esempio

nella transazione SM59. Queste destinazioni RFC sono connessioni HTTP a server esterni (tipo G) e si connettono all'endpoint API pubblico del rispettivo servizio.

| Nome destinazione RFC di esempio | Host di destinazione (endpoint API) | Note |

|---|---|---|

GOOG_BIGQUERY |

https://bigquery.googleapis.com |

Questa destinazione RFC ha come target l'API BigQuery. |

GOOG_PUBSUB |

https://pubsub.googleapis.com |

Questa destinazione RFC ha come target l'API Pub/Sub. |

GOOG_IAMCREDENTIALS |

https://iamcredentials.googleapis.com |

Questa destinazione RFC ha come target l'API IAM. |

GOOG_OAUTH2_TOKEN |

https://googleapis.com/oauth2 |

Questa destinazione RFC ha come target l'endpoint Google Cloud per l'autenticazione basata su OAuth 2.0. Lo utilizzi per i carichi di lavoro SAP in esecuzione al di fuori di Google Cloud e solo quando vuoi autenticarti su Google Cloud utilizzando JSON Web Token (JWT). |

L'utilizzo delle destinazioni RFC per connettersi a Google Cloud offre i seguenti vantaggi:

Se utilizzi un server proxy nel tuo ambiente SAP e vuoi utilizzarlo per inviare le richieste HTTP a Google Cloud, puoi configurare il server proxy nella destinazione RFC.

Se vuoi abilitare l'accesso ad API e servizi tramite endpoint Private Service Connect, puoi creare questi endpoint nel tuo progettoGoogle Cloud e poi specificarli nelle destinazioni RFC. Google Cloud

Puoi utilizzare la compressione HTTP, che Google Cloud consiglia per le repliche tra regioni, in cui il sistema di origine SAP e il set di dati BigQuery si trovano in regioni Compute Engine diverse.

Per utilizzare le destinazioni RFC per connetterti ad API o servizi, devi creare voci nella tabella /GOOG/SERVIC_MAP che mappano le destinazioni RFC alla tabella /GOOG/CLIENT_KEY. Google Cloud Per i passaggi di configurazione, consulta la

Guida all'installazione e alla configurazione di BigQuery Connector per SAP per il tuo scenario.

Compressione HTTP

Quando utilizzi le destinazioni RFC per configurare la connessione

tra BigQuery Connector per SAP e le API Google Cloud , puoi utilizzare l'opzione

Compressione per comprimere il corpo della richiesta HTTP. La compressione HTTP è

disponibile solo quando configuri le destinazioni RFC per l'utilizzo di HTTP 1.1.

Prima di attivare la compressione HTTP nell'ambiente di produzione, analizza i parametri del profilo che influiscono sulla compressione HTTP in un ambiente di test. Per ulteriori informazioni da SAP, consulta SAP Note 1037677 - HTTP compression compresses certain documents only.

Larghezza di banda

Assicurati che la connessione di rete tra SAP LT Replication Server e Google Cloud abbia una larghezza di banda sufficiente per supportare il volume di dati alla velocità che ti serve.

Le connessioni di rete più lente aumentano la latenza della replica dei dati, il che aumenta le risorse utilizzate dalla replica nel sistema SAP di origine.

Per le installazioni produttive, Google Cloud consiglia una connessione Cloud Interconnect. Puoi anche utilizzare Cloud VPN.

Latenza

Per ridurre la latenza della connessione di rete, crea il set di dati BigQuery di destinazione il più vicino possibile al sistema SAP LT Replication Server e al sistema di origine SAP. Se il sistema SAP di origine è in esecuzione su Google Cloud, crea il set di dati BigQuery nella stessa regione Google Cloud del sistema SAP di origine.

Testa la latenza prima di eseguire la migrazione dell'installazione a un ambiente di produzione.

Per ulteriori informazioni sulle prestazioni di rete, consulta Prestazioni della connessione di rete.

Controlli di accesso alla rete

Puoi implementare i controlli dell'accesso di rete su entrambi i lati della connessione tra SAP LT Replication Server e Google Cloud.

Google Cloud Controlli di accesso alla rete

BigQuery Connector per SAP comunica con BigQuery tramite un endpoint API, che non è soggetto alle regole firewall VPC. Google Cloud

Utilizza invece i controlli di servizio VPC per limitare il traffico.

Per saperne di più sulla sicurezza di rete per BigQuery, vedi Sicurezza di rete.

Controlli dell'accesso di rete dell'host SAP LT Replication Server

Sull'host SAP LT Replication Server, devi assicurarti che eventuali firewall o proxy consentano il traffico in uscita dal server agli endpoint API BigQuery e Pub/Sub. In particolare, assicurati che il tuo SAP LT Replication Server possa accedere alle seguenti API Google Cloud :

https://bigquery.googleapis.comhttps://pubsub.googleapis.comhttps://iamcredentials.googleapis.com

Se vuoi utilizzare gli endpoint Private Service Connect per accedere alle API BigQuery e Pub/Sub, devi configurare gli endpoint Private Service Connect nella tabella /GOOG/SERVIC_MAP.

Pianificazione del rendimento

Il rendimento dei caricamenti iniziali e dei job di replica tra SAP LT Replication Server e BigQuery è influenzato da più fattori in diversi punti del percorso di replica.

Tuttavia, alcuni fattori di base, come la distanza tra SAP LT Replication Server e il tuo set di dati BigQuery o la larghezza di banda della tua connessione a Google Cloud, hanno un impatto maggiore sulle prestazioni rispetto alla maggior parte degli altri fattori.

Best practice generali per il rendimento

Per un rendimento ottimale, incorpora i seguenti consigli nella configurazione di SAP LT Replication Server:

- Esegui il tuo workload SAP, inclusi il sistema di origine SAP e SAP LT Replication Server, su Google Cloud.

- Se il tuo workload SAP si trova su Google Cloud, crea il set di dati BigQuery nella stessa regione del tuo workload SAP.

- Se non riesci a eseguire il workload SAP su Google Cloud:

- Crea il set di dati BigQuery nella regione Google Cloudpiù vicina al tuo carico di lavoro SAP.

- Connettiti a Google Cloud utilizzando Cloud Interconnect.

- Per evitare conflitti per le risorse, utilizza host dedicati separati sia per il sistema di origine SAP sia per SAP LT Replication Server.

- Dimensiona in modo ottimale il sistema SAP LT Replication Server per il tuo workload in base alla guida al dimensionamento per la tua versione di SAP LT Replication Server nel portale di assistenza SAP.

- Utilizza le seguenti impostazioni di replica di SAP LT Replication Server:

- Job paralleli.

- Tipo di lettura 1, se possibile. Per saperne di più, consulta Prestazioni e impostazioni avanzate di replica LTRS.

- Configura BigQuery Connector per SAP con:

- Compressione predefinita dei record.

- Dimensione predefinita del chunk.

- Quando mappi i campi alla tabella BigQuery, evita i nomi personalizzati, se possibile.

Per ulteriori informazioni, vedi:

- Considerazioni sulle prestazioni di SAP LT Replication Server

- Rendimento della connessione di rete

- Trasmissione dei dati

- Compressione dei record

Caratteristiche aggiuntive che possono influire sul rendimento

Molte caratteristiche della configurazione e dei dati possono influire sulle prestazioni. Alcune di queste caratteristiche potrebbero non essere modificabili. Queste caratteristiche includono:

- Sul server di origine:

- Il numero di CPU.

- La quantità di memoria.

- Il database utilizzato, ad esempio SAP HANA, SAP ASE, IBM Db2 o altri.

- Il numero di colonne nella tabella di origine.

- La quantità di dati contenuti in ogni record.

- I metadati della tabella, ad esempio la lunghezza dei nomi dei campi.

- Il numero di processi di lavoro della finestra di dialogo.

- Sul server di replica SAP LT:

- Il numero di CPU.

- La quantità di memoria.

- Altri carichi di lavoro che l'host potrebbe eseguire.

- Processi di lavoro di dialogo e in background SAP.

- Il tipo di architettura di installazione di SAP LT Replication Server. Per ulteriori informazioni, consulta Installazione autonoma (consigliata) o incorporata di SAP LT Replication Server.

- Il numero di job in background in esecuzione sul sistema SAP LT Replication Server.

- Il numero di job in background allocati al trasferimento collettivo

nella scheda Amministrazione della transazione

LTRC. - Le impostazioni di rendimento delle transazioni

LTRS, tra cui Tipo di lettura e Dimensioni porzione.

- Nella configurazione della replica BigQuery (transazione

/GOOG/SLT_SETTINGS):- Indica se sono stati specificati nomi personalizzati per i campi di destinazione. L'elaborazione dei nomi dei campi BigQuery di destinazione può avere un leggero impatto sulle prestazioni.

- Indica se la compressione dei record è abilitata.

- Dimensioni dei chunk, che possono influire sul numero totale di richieste HTTP inviate.

Considerazioni sulle prestazioni di SAP LT Replication Server

Le sezioni seguenti descrivono le opzioni di rendimento correlate alla configurazione di SAP LT Replication Server.

Prestazioni e architettura di installazione di SAP LT Replication Server

Un'architettura autonoma, in cui SAP LT Replication Server è installato sul proprio server dedicato, di solito offre prestazioni migliori rispetto a un'architettura incorporata, in cui SAP LT Replication Server è installato sullo stesso server del sistema di origine.

In un'architettura incorporata, SAP LT Replication Server deve condividere le risorse del server con il sistema di origine SAP.

Anche con un'architettura autonoma, la CPU e la memoria dell'host, nonché qualsiasi altro carico di lavoro che potrebbe essere in esecuzione sul server, possono influire sulle prestazioni di un'istanza di SAP LT Replication Server.

Rendimento e LTRS Impostazioni di replica avanzate

Il rendimento dei caricamenti iniziali e della replica è influenzato dalle impostazioni specificate per la tabella di origine nella transazione LTRS in Impostazioni di replica avanzate.

Per indicazioni sull'ottimizzazione delle prestazioni, in particolare per l'ottimizzazione dei caricamenti iniziali o della replica di volumi elevati, consulta la Guida all'ottimizzazione delle prestazioni di SAP LT Replication Server nel portale di assistenza SAP.

Google Cloud consiglia le seguenti specifiche nella sezione

Impostazioni di replica avanzate > Prestazioni generali di

transazione LTRS:

Per i caricamenti iniziali della maggior parte dei tipi di tabelle, specifica 1 Range Calculation come Reading Type. Per le tabelle troppo grandi per il calcolo di un intervallo, specifica il tipo di lettura 5.

Per le repliche, nella sezione Impostazioni attive:

- Per le repliche più veloci, specifica Intervalli automatici.

- Per repliche più affidabili, specifica Nessun intervallo.

La seguente tabella suggerisce le impostazioni per alcuni scenari comuni.

| Tipo di tabella | Tipo di lettura consigliato |

|---|---|

| Trasparente (piccolo-medio) | Tipo di lettura 1 - Calcolo dell'intervallo |

| Trasparente (grande) | Solo se il tipo di lettura 1 non funziona, tipo di lettura 5 - Calcolo intervallo |

| Tabella dei cluster | Tipo di lettura 4 - Coda mittente |

Prestazioni della connessione di rete

La larghezza di banda e la latenza della connessione tra il sistema SAP LT Replication Server e Google Cloud possono influire sulle prestazioni complessive della replica in BigQuery.

L'impatto influisce non solo sulla velocità di replica, ma anche sulla quantità di risorse consumate da SAP LT Replication Server e dal sistema di origine, perché più tempo ci vuole per ricevere la conferma della replica da BigQuery, più a lungo SAP LT Replication Server e il sistema di origine mantengono le risorse host.

Se il tuo carico di lavoro SAP viene eseguito on-premise o su un altro cloud provider, Google Cloud consiglia di utilizzare una connessione Cloud Interconnect, che fornisce larghezza di banda elevata e bassa latenza senza dover competere con il traffico su internet pubblico.

Puoi utilizzare Cloud VPN per connetterti a Google Cloud e BigQuery, tuttavia, con una connessione VPN, le repliche devono competere con il traffico internet generale.

Se il tuo carico di lavoro SAP viene eseguito su Google Cloud, Google Cloud consiglia di posizionare SAP LT Replication Server e il tuo set di dati BigQuery nella stessa regione. Se SAP LT Replication Server e BigQuery si trovano in regioni diverse, la latenza è in genere maggiore e le prestazioni sono in genere peggiori. Per saperne di più sulla scelta di una regione, consulta Scelta di una regione e di una zona.

Trasmissione dei dati

In genere, è consigliabile inviare il maggior numero possibile di dati in ogni richiesta HTTP per ridurre il numero complessivo di richieste HTTP e il sovraccarico di elaborazione correlato.

In alcuni casi, tuttavia, potrebbe essere necessario ridurre la quantità di dati inviati, a causa delle dimensioni dei record in una determinata tabella o perché hai raggiunto un limite di quota o un altro limite in Pub/Sub o BigQuery.

Puoi controllare la quantità di dati inviati in ogni richiesta nei seguenti modi:

- Modifica la quantità di dati (le dimensioni della porzione) che SAP LT Replication Server invia a BigQuery Connector per SAP.

- Regola la quantità di dati (la dimensione del chunk) che BigQuery Connector per SAP invia a BigQuery.

- Modifica le quote per gli inserimenti in streaming nel tuo progetto BigQuery.

Modifica della quantità di dati inviati da SAP LT Replication Server

SAP LT Replication Server invia i record dal sistema di origine a BigQuery Connector per SAP in porzioni. Ogni porzione viene gestita come un job di caricamento o replica separato che consuma risorse del server fino al completamento.

In genere, se aumenti le dimensioni della porzione di SAP LT Replication Server, diminuisci il numero di processi SAP LT Replication Server, nonché l'overhead associato.

Dimensioni della porzione e dimensioni del segmento

Le porzioni di SAP LT Replication Server sono dimensionate in byte o come prodotto di byte e record. I blocchi di BigQuery Connector per SAP sono dimensionati in base al numero di record che possono contenere. Le dimensioni in byte di un chunk variano in base a diversi fattori, tra cui il numero di campi nei record e la quantità di dati contenuti in ciascun record.

Se la dimensione della porzione di SAP LT Replication Server è maggiore della dimensione del blocco di BigQuery Connector per SAP, BigQuery Connector per SAP invia più blocchi per ogni porzione, finché tutti i record della porzione non vengono inviati.

Se la dimensione della porzione è inferiore alla dimensione del blocco, BigQuery Connector per SAP invia un solo blocco per porzione. Ogni blocco contiene solo il numero di record inviati in ogni porzione, indipendentemente dalle dimensioni del blocco impostate in BigQuery Connector per SAP.

Idealmente, imposta una dimensione della porzione in SAP LT Replication Server che consenta a BigQuery Connector per SAP di creare i blocchi più grandi possibili senza superare il limite di Pub/Sub o BigQuery per il numero di byte in ogni richiesta HTTP.

Per ulteriori indicazioni su come specificare una dimensione del blocco, vedi Dimensione del blocco in BigQuery Connector per SAP.

Dimensione della porzione in SAP LT Replication Server

Per modificare le dimensioni predefinite della porzione utilizzata da SAP LT Replication Server,

esegui la transazione LTRS e regola il valore nel campo Dimensioni pacchetto

in Impostazioni di replica avanzate nella sezione Opzioni di rendimento.

Per ulteriori informazioni, consulta la guida all'ottimizzazione delle prestazioni di SAP LT Replication Server nel portale di assistenza SAP.

Dimensione dei blocchi in BigQuery Connector per SAP

BigQuery Connector per SAP invia i dati a BigQuery come blocchi di record.

Per la replica CDC tramite Pub/Sub, ti consigliamo di utilizzare la dimensione predefinita del blocco con BigQuery Connector per SAP, ovvero 1000 record. Questo è il numero massimo di record consentiti da Pub/Sub.

Per la replica dei dati di streaming, ti consigliamo di utilizzare la dimensione predefinita dei blocchi con BigQuery Connector per SAP, ovvero 10.000 record. Tuttavia, se i record di una tabella di origine contengono pochissimi campi o i campi contengono valori di dati di dimensioni molto ridotte, puoi utilizzare una dimensione del blocco più grande fino alla dimensione massima del blocco consentita da BigQuery, ovvero 50.000 record.

Se il numero di record in un determinato blocco si risolve in una dimensione in byte che supera il limite consentito per le richieste HTTP, potresti ricevere un errore quotaExceeded o invalid.

Ciò può verificarsi se i record di una tabella di origine contengono molti campi o se i campi contengono molti dati.

Se ricevi un errore relativo alle dimensioni del blocco, prova a ridurre le dimensioni del blocco specificate nella configurazione del trasferimento collettivo per quella tabella. In alternativa, puoi abilitare la dimensione dinamica dei chunk per la tabella in modo da regolare automaticamente la dimensione dei chunk. Per ulteriori informazioni, vedi Dimensioni dinamiche dei chunk.

Se non hai attivato la dimensione dinamica dei chunk, per le tabelle di origine SAP come

MSEG, ACDOCA e MATDOC, che possono contenere record di grandi dimensioni con molti

campi per record, potrebbe essere necessario specificare una dimensione dei chunk inferiore.

Puoi specificare una dimensione del blocco eseguendo la transazione /GOOG/SLT_SETTINGS. Le dimensioni del blocco sono specificate nel campo Dimensioni blocco

nella schermata degli attributi della tabella.

Per ulteriori indicazioni su come specificare le dimensioni di un blocco, consulta:

- Per la replica CDC tramite Pub/Sub, consulta Specificare la creazione di tabelle e altri attributi generali.

- Per la replica dei dati di streaming, vedi Specificare la creazione di tabelle e altri attributi generali.

Per ulteriori informazioni sui messaggi di errore di BigQuery, vedi Messaggi di errore.

Overhead di elaborazione associato all'invio di porzioni

Ogni porzione inviata attiva le seguenti azioni, ognuna delle quali comporta un sovraccarico di elaborazione o un consumo di risorse:

- Una raccolta di record modificati nella tabella di logging del sistema di origine viene inviata a SAP LT Replication Server in un'unica porzione. I record modificati non sono ancora stati eliminati dalla tabella di logging.

- SAP LT Replication Server richiede un nuovo token di accesso da Google Cloud.

- BigQuery Connector per SAP invia una richiesta HTTP a Google Cloud per controllare la struttura della tabella di destinazione.

- BigQuery Connector per SAP invia i record a Google Cloud in tanti blocchi quanti sono necessari per inviare tutti i record che ha ricevuto nella singola porzione. Ogni blocco viene inviato in una richiesta HTTP separata.

- Google Cloud elabora ogni blocco che riceve.

- Per ogni blocco viene restituito a SAP LT Replication Server un codice di stato HTTP

OK. - Dopo che Google Cloud riceve tutti i record, SAP LT Replication Server elimina i record inviati dalla tabella di logging, il che libera finalmente le risorse sul sistema di origine.

Per ulteriori informazioni sulle porzioni e sulla configurazione di SAP LT Replication Server per le prestazioni, consulta la Guida all'ottimizzazione delle prestazioni di SAP LT Replication Server nel portale di assistenza SAP.

Quote BigQuery

Le quote dell'API BigQuery Streaming in vigore per il tuo progetto limitano la quantità di dati che puoi trasmettere in streaming in BigQuery nel tempo e in una singola richiesta HTTP.

Ad esempio, BigQuery imposta limiti per metriche come:

- Il numero di byte al secondo per progetto che puoi inviare.

- Il numero massimo di record o righe che puoi inviare in una singola richiesta HTTP.

- La dimensione massima di una richiesta HTTP che puoi inviare.

Per gli inserimenti di flussi di dati, BigQuery fissa la dimensione delle richieste HTTP a 10 MB e il numero di record che puoi inviare in una singola richiesta HTTP a 50.000.

Nella maggior parte dei casi, puoi modificare le quote, ma non i limiti.

Puoi visualizzare e modificare le quote in vigore per il tuo progetto nella consoleGoogle Cloud nella pagina Quote.

Per ulteriori informazioni sulle quote e sui limiti di BigQuery per gli inserimenti di flussi di dati, consulta:

Quote di Pub/Sub

Le quote dell'API Pub/Sub in vigore per il tuo progetto limitano la quantità di dati che puoi trasmettere in streaming a BigQuery nel tempo e in una singola richiesta HTTP.

Ad esempio, Pub/Sub imposta limiti per metriche come:

- Il numero di byte al secondo per progetto che puoi inviare.

- Il numero massimo di record o righe che puoi inviare in una singola richiesta HTTP.

- La dimensione massima di una richiesta HTTP che puoi inviare.

Per i dati CDC, Pub/Sub fissa le dimensioni delle richieste HTTP a 10 MB e il numero di record che puoi inviare in una singola richiesta HTTP a 1000.

Nella maggior parte dei casi, puoi modificare le quote, ma non i limiti.

Puoi visualizzare e modificare le quote in vigore per il tuo progetto nella consoleGoogle Cloud nella pagina Quote.

Per ulteriori informazioni sulle quote e sui limiti delle risorse di Pub/Sub, consulta:

Compressione dei record

Per la replica CDC tramite Pub/Sub, la funzionalità di compressione dei record non è supportata.

Per la replica dei dati di streaming, per impostazione predefinita BigQuery Connector per SAP migliora il rendimento della replica comprimendo i record che invia a BigQuery. A partire dalla versione 2.8 di BigQuery Connector per SAP, l'opzione di compressione dei record è disponibile a livello di tabella e di campo.

Quando la compressione dei record è abilitata a livello di tabella, che è l'impostazione predefinita, BigQuery Connector per SAP omette tutti i campi vuoti nel record di origine dai record inviati a BigQuery. Quando il record viene inserito in BigQuery, i campi omessi dai dati inviati vengono inizializzati con null nella tabella di destinazione in BigQuery.

Tuttavia, se devi replicare alcuni campi vuoti con i loro valori iniziali in BigQuery continuando a utilizzare la compressione dei record a livello di tabella, puoi modificare l'impostazione di compressione dei record per questi campi specifici. Ciò significa che i valori vuoti nei campi specificati non vengono omessi dai dati inviati e mantengono il valore con cui vengono inizializzati nella tabella di origine.

Puoi controllare il comportamento di compressione dei record utilizzando l'impostazione Invia flag non compresso disponibile a livello di tabella e campo. La seguente tabella riassume il comportamento di compressione dei record:

| Invia il flag non compresso a livello di tabella | Invia il flag non compresso a livello di campo | Comportamento di compressione della registrazione |

|---|---|---|

| Sì | No | Tutti i campi vengono inviati senza compressione. |

| Sì | Sì | Tutti i campi vengono inviati senza compressione. |

| No | Sì | Solo i campi selezionati a livello di campo vengono inviati senza compressione. |

| No | No | Tutti i campi vengono inviati compressi. |

Quando i dati decompressi vengono inviati per la replica, ad eccezione dei campi data e timestamp, i campi vuoti mantengono il valore con cui sono stati inizializzati nella tabella di origine. Il valore inizializzato per i campi data e timestamp riceve i seguenti valori:

- Valore di inizializzazione del campo data:

DATE 1970-01-01 - Valore di inizializzazione del campo timestamp:

TIMESTAMP 1970-01-01 00:00:00 UTC

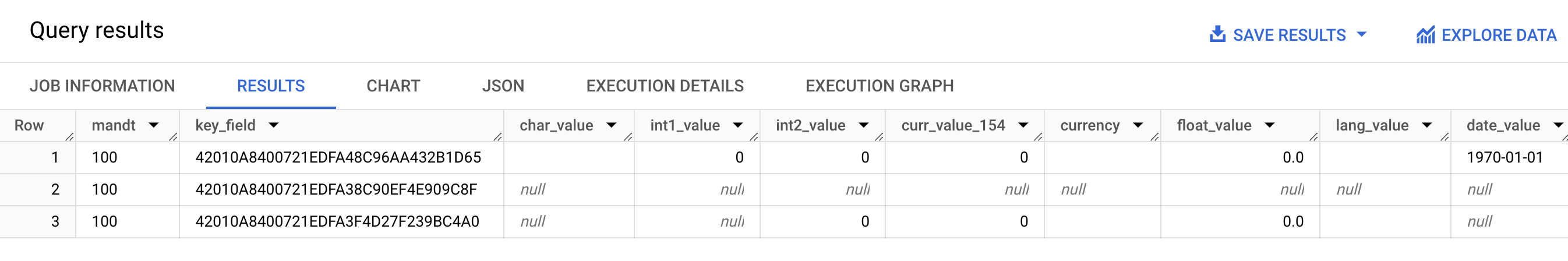

Lo screenshot seguente mostra un esempio del comportamento di compressione dei record:

- Riga 1: tutti i campi sono decompressi. Il flag Invia non compresso è selezionato a livello di tabella.

- Riga 2: tutti i campi sono compressi. Il flag Invia non compresso è deselezionato a livello di tabella.

- Riga 3: i seguenti campi non sono compressi:

int2_value,curr_value_154,currency,float_valueelang_value. Per questi campi, Invia flag non compresso è selezionato a livello di campo.

Per ottenere prestazioni migliori, non disattivare la compressione dei record selezionando Invia flag non compresso a livello di tabella. Può avere un impatto negativo sulle prestazioni della replica. Se devi inviare dati non compressi solo per campi specifici, seleziona Invia flag non compresso per questi campi specifici a livello di campo. Per ulteriori informazioni su come la compressione dei record influisce sui dati trasferiti da SAP LT Replication Server a BigQuery, consulta Informazioni sulla funzionalità di compressione di BigQuery Connector per SAP.

Configurazioni di replica BigQuery

Quando configuri la replica con BigQuery Connector per SAP, utilizzi diverse transazioni SAP, inclusa una transazione personalizzata fornita da Google Cloud:

SM30: definisce le proprietà per la connessione a Google Cloud, che vengono memorizzate come record nella tabella di configurazione personalizzata/GOOG/CLIENT_KEY. Se vuoi, quando utilizzi le destinazioni RFC per connetterti alle API e ai serviziGoogle Cloud , alcune proprietà di connessione vengono archiviate nella tabella di configurazione personalizzata/GOOG/SERVIC_MAP.LTRC: definisce l'applicazione di replica BigQuery Connector per SAP e l'ID trasferimento collettivo, tra le altre proprietà.SM59: definisce le destinazioni RFC che consentono la connessione a Google Cloud API e servizi come BigQuery e IAM./GOOG/SLT_SETTINGS: definisce le proprietà per il set di dati, la tabella e i campi BigQuery di destinazione. Quando inserisci/GOOG/SLT_SETTINGSin SAP LT Replication Server, devi aggiungere/nper eseguire l'escape della barra iniziale nel nome della transazione.

Supporto dei linguaggi

BigQuery Connector per SAP supporta solo le configurazioni di replica in inglese. Quando configuri la replica utilizzando le transazioni SAP e la transazione personalizzata fornita da Google Cloud, utilizza l'inglese come lingua di accesso nella schermata di accesso SAP.

Tuttavia, BigQuery Connector per SAP supporta l'esecuzione di job in background in esecuzione su SAP LT Replication Server in tutte le lingue supportate da SAP SLT.

Eventuali messaggi di errore che potresti riscontrare quando utilizzi BigQuery Connector per SAP vengono generati in inglese indipendentemente dalla lingua di esecuzione del job in background.

Proprietà della tabella di destinazione

Quando configuri la replica in SAP LT Replication Server eseguendo

la transazione /GOOG/SLT_SETTINGS, puoi specificare

le impostazioni che vengono applicate quando BigQuery Connector per SAP crea la

tabella di destinazione in BigQuery.

Ad esempio, puoi specificare le seguenti proprietà per una tabella BigQuery di destinazione:

- Nome tabella

- L'opzione di denominazione predefinita per i campi

- Campi aggiuntivi per acquisire le modifiche ai record e per abilitare le query di conteggio dei record

- Partizionamento delle tabelle

Opzioni di denominazione predefinite per i campi

Puoi configurare BigQuery Connector per SAP in modo da creare i nomi dei campi nella tabella BigQuery di destinazione a partire dai nomi dei campi di origine o dalle etichette e dalle descrizioni dei campi di origine. Le etichette e le descrizioni sono in genere più informative sui contenuti del campo.

Per impostazione predefinita, BigQuery Connector per SAP utilizza i nomi dei campi di origine.

Puoi modificare il valore predefinito specificando il flag Nomi personalizzati quando specifichi gli attributi di creazione delle tabelle nella configurazione del trasferimento collettivo della transazione /GOOG/SLT_SETTINGS. Questa specifica

è memorizzata nella tabella di configurazione /GOOG/BQ_MASTR.

Quando vengono creati i nomi, BigQuery Connector per SAP li modifica in modo che siano conformi alla convenzione di denominazione di BigQuery.

Prima di creare una tabella, puoi modificare i nomi dei campi nella schermata di mappatura dei campi della transazione /GOOG/SLT_SETTINGS.

Quando viene specificato il flag Nomi personalizzati, i nomi che il connettore BigQuery per SAP utilizzerà quando crea la tabella di destinazione vengono visualizzati nella colonna Nome campo esterno della schermata di mappatura dei campi.

BigQuery Connector per SAP crea i nomi nella colonna Nome campo esterno dall'etichetta del campo medium di ogni campo di origine. Se un'etichetta del campo mezzo non è specificata nella definizione del campo di origine, viene utilizzata la descrizione breve del campo. Se non viene specificata neanche la descrizione breve, viene utilizzata l'etichetta più breve specificata. Se non viene specificato nulla, viene utilizzato il nome del campo di origine.

Per ulteriori informazioni sulla personalizzazione dei nomi dei campi di destinazione, vedi Personalizzare i nomi dei campi di destinazione.

Acquisizione delle modifiche ai record e attivazione dei conteggi dei record

Per acquisire il tipo di modifica nella tabella di origine che ha attivato la replica e per poter eseguire query sui conteggi dei record nella tabella BigQuery per il confronto con SAP LT Replication Server o sui conteggi dei record nella tabella di origine, specifica l'opzione Flag campi aggiuntivi nella transazione /GOOG/SLT_SETTINGS durante la configurazione della replica.

Quando viene specificata l'opzione Flag campi aggiuntivi, vengono aggiunte le seguenti colonne allo schema della tabella BigQuery di destinazione:

| Nome campo | Tipo di dati | Descrizione |

|---|---|---|

operation_flag

|

STRING

|

Identifica il tipo di modifica nella tabella di origine che ha attivato il caricamento o la replica del record in BigQuery.

Per conteggiare i record inseriti in modalità di replica, esegui una query

sui record con valore

Per conteggiare i record inseriti in modalità di caricamento iniziale, esegui una query

sui record con un valore di |

is_deleted

|

BOOLEAN

|

Quando true, indica che il record di origine è stato

eliminato dalla tabella di origine.

Per conteggiare solo i record di una tabella BigQuery che

non sono stati eliminati dalla tabella di origine, utilizza il

campo |

recordstamp

|

TIMESTAMP

|

L'ora in cui SAP LT Replication Server ha inviato il record a BigQuery. Per conteggiare il numero di record univoci in una tabella BigQuery, esegui query solo sull'istanza inserita più di recente di ogni record. Per un esempio di query, vedi Eseguire una query sul conteggio totale dei record in una tabella BigQuery. |

L'impostazione attuale dell'opzione Flag campi aggiuntivi è memorizzata nella

tabella di configurazione /GOOG/BQ_MASTR.

Per ulteriori informazioni su come specificare il flag Campi aggiuntivi, vedi:

- Per la replica CDC tramite Pub/Sub, consulta Specificare la creazione di tabelle e altri attributi generali.

- Per la replica dei dati di streaming, vedi Specificare la creazione di tabelle e altri attributi generali.

Partizionamento delle tabelle

Puoi creare tabelle BigQuery partizionate in base a un campo timestamp nella tabella di origine, che crea una tabella partizionata per unità di tempo per colonna, oppure in base all'ora in cui i record vengono inseriti in BigQuery, che crea una tabella partizionata per tempo di inserimento.

Per abilitare il partizionamento, specifica un tipo di partizione nel campo Tipo

partizione in /GOOG/BQ_TABLE quando configuri le proprietà

di replica.

I tipi di partizione che puoi specificare regolano la granularità del partizionamento per ora, giorno, mese o anno.

Per utilizzare un timestamp della tabella di origine per il partizionamento delle colonne delle unità di tempo, specifica il nome del campo di origine nel campo Campo di partizionamento.

Per utilizzare un orario di inserimento BigQuery per il partizionamento al momento dell'importazione, puoi lasciare vuoto il campo Campo di partizionamento. BigQuery Connector per SAP crea un campo nella tabella di destinazione per archiviare l'ora di inserimento.

Proprietà dei campi target

Per impostazione predefinita, BigQuery Connector per SAP utilizza i nomi dei campi e i tipi di dati nella tabella di origine SAP come nomi dei campi e tipi di dati in BigQuery di destinazione.

Se vuoi, prima di creare la tabella di destinazione, puoi personalizzare i nomi dei campi o modificare il tipo di dati BigQuery.

Personalizzare i nomi dei campi target

Prima di creare una tabella, puoi personalizzare i nomi dei campi di destinazione.

Se necessario, BigQuery Connector per SAP modifica i nomi personalizzati che specifichi in modo che siano conformi alla convenzione di denominazione di BigQuery.

Quando configuri la replica, puoi visualizzare i nomi dei campi nella schermata di mappatura dei campi della transazione /GOOG/SLT_SETTINGS. BigQuery Connector per SAP archivia le impostazioni nella tabella di configurazione /GOOG/BQ_FIELD.

Prima di creare una tabella, puoi specificare un nome campo personalizzato modificando il nome generato nella colonna Nome campo temporaneo della schermata di mappatura dei campi. Se elimini un valore e lasci vuoto il campo Nome campo temporaneo, il connettore BigQuery per SAP utilizza il nome del campo di origine per il nome del campo di destinazione.

Dopo aver apportato modifiche al nome campo temporaneo, quando fai clic su Salva, BigQuery Connector per SAP convalida il valore, applica le convenzioni di denominazione di BigQuery se necessario e salva le modifiche. Puoi convalidare un valore senza salvarlo premendo Invio.

Per informazioni sull'impostazione del metodo di denominazione predefinito per i campi di destinazione, vedi Opzioni di denominazione predefinite per i campi.

Utilizzare un foglio di lavoro o un file di testo per modificare la mappatura dei campi BigQuery

Prima di creare una tabella BigQuery di destinazione, puoi facoltativamente salvare i tipi di dati, i nomi e le descrizioni predefiniti dei campi di destinazione in un foglio di lavoro o in un file di testo, in modo che gli ingegneri o gli amministratori dei dati BigQuery possano modificare i valori senza richiedere l'accesso a SAP LT Replication Server.

Dopo aver modificato i valori, devi convertire il file e i relativi contenuti

nel formato CSV (valori separati da virgole). Puoi quindi applicare gli aggiornamenti

alle impostazioni di trasferimento collettivo caricando il file CSV utilizzando la

transazione personalizzata /GOOG/SLT_SETTINGS.

La procedura per modificare la mappatura dei campi BigQuery utilizzando un file CSV include i seguenti passaggi:

- Crea un foglio di lavoro o un file di testo dei mapping dei campi predefiniti.

- Modifica i valori.

- Converti il foglio di lavoro o il file di testo in formato CSV.

- Carica il file CSV.

Per istruzioni dettagliate per ogni passaggio, vedi Modificare la mappatura dei campi BigQuery in un file CSV.

Convenzione di denominazione di BigQuery per i campi

La convenzione di denominazione BigQuery utilizza solo lettere minuscole, numeri e trattini bassi.

BigQuery Connector per SAP applica le convenzioni di denominazione di BigQuery a qualsiasi valore di input da utilizzare per il nome di un campo di destinazione.

Ad esempio, se inserisci FIELD-@#!*123 come nome di un campo personalizzato, BigQuery Connector per SAP modifica il nome in field_123.

Per saperne di più sulla convenzione di denominazione di BigQuery per i campi, consulta Nomi delle colonne.

Mappatura dei tipi di dati

Per impostazione predefinita, BigQuery Connector per SAP assegna i tipi di dati ai campi BigQuery di destinazione in base al tipo SAP o al tipo di dati SAP del campo SAP di origine.

Per la replica CDC tramite Pub/Sub, la procedura prevede un passaggio intermedio nella mappatura dei tipi di dati:

BigQuery Connector per SAP a Pub/Sub: quando BigQuery Connector per SAP invia dati a un argomento Pub/Sub, i tipi di dati SAP vengono inizialmente convertiti in tipi di dati Pub/Sub Avro.

Pub/Sub a BigQuery: i dati in formato Avro di Pub/Sub vengono poi trasmessi in streaming a BigQuery utilizzando una sottoscrizione BigQuery. A questo punto, Pub/Sub assegna i tipi di dati BigQuery finali.

Per garantire un flusso di dati fluido e un'interpretazione accurata, i tipi di dati Avro di Pub/Sub e i tipi di dati BigQuery finali devono essere compatibili. Per informazioni sulla compatibilità dello schema tra un argomento Pub/Sub e una tabella BigQuery, consulta Compatibilità dello schema.

Quando configuri la replica, puoi visualizzare i tipi di dati nella schermata di mappatura dei campi della transazione /GOOG/SLT_SETTINGS. BigQuery Connector per SAP archivia le impostazioni nella tabella di configurazione /GOOG/BQ_FIELD.

Prima della creazione di una tabella, puoi modificare la specifica del tipo di dati predefinito in un tipo di dati BigQuery e un tipo di dati Avro Pub/Sub diversi.

Tipi di dati che richiedono una gestione speciale

Diversi tipi di dati SAP richiedono una gestione speciale per essere rappresentati in modo accurato nella tabella BigQuery di destinazione.

Alcuni di questi tipi di dati devono essere gestiti personalmente. BigQuery Connector per SAP si occupa degli altri per te.

Booleani

Per i valori booleani, SAP utilizza il tipo di dati CHAR, che per impostazione predefinita

BigQuery Connector per SAPP mappa al tipo di dati STRING nella

tabella BigQuery di destinazione.

Di conseguenza, per i booleani, quando configuri la replica utilizzando la transazione /GOOG/SLT_SETTINGS, devi modificare l'assegnazione del tipo di dati predefinito per i campi booleani da STRING a BOOLEAN nella schermata di mappatura dei campi.

Timestamp

Per i timestamp, SAP utilizza i tipi di dati P (packed decimal) o DEC

(decimal), che per impostazione predefinita BigQuery Connector per SAP mappa a

NUMERIC nella tabella BigQuery di destinazione.

Di conseguenza, per i timestamp, quando configuri la replica utilizzando la transazione /GOOG/SLT_SETTINGS, devi modificare l'assegnazione del tipo di dati predefinito per i campi timestamp da NUMERIC a TIMESTAMP o TIMESTAMP (LONG) nella schermata di mappatura dei campi.

X Tipo di SAP

Il tipo SAP X è esadecimale ed è rappresentato dai tipi di dati SAP RAW,

RAWSTRING o LRAW. Per impostazione predefinita, BigQuery Connector per SAP

mappa questi tipi di dati su STRING nella tabella BigQuery

di origine.

Se devi mappare un campo di origine con il tipo SAP X a BYTES, devi modificare l'assegnazione del tipo di dati predefinito per il campo nella schermata di mappatura dei campi della transazione /GOOG/SLT_SETTINGS.

A volte, in SAP viene utilizzato anche il tipo SAP X per rappresentare i numeri interi.

In questo caso, BigQuery Connector per SAP controlla il tipo di dati del

campo di origine per uno dei tipi di dati SAP per i numeri interi, INT1, INT2,

INT4, INT8 e assegna il tipo di dati INTEGER nella tabella BigQuery

di destinazione.

y Tipo di SAP

Il tipo SAP y è una stringa di byte ed è rappresentato dai tipi di dati SAP RAW,

RAWSTRING o LRAW. Per impostazione predefinita, BigQuery Connector per SAP

mappa questi tipi di dati su STRING nella tabella BigQuery

di origine.

Se devi mappare un campo di origine con il tipo SAP y a BYTES, devi modificare l'assegnazione del tipo di dati predefinito per il campo nella schermata di mappatura dei campi della transazione /GOOG/SLT_SETTINGS.

LRAW Tipo di dati SAP

BigQuery Connector per SAP archivia i tipi di dati LRAW in BigQuery

come stringhe codificate Base64.

Se utilizzi la replica CDC tramite Pub/Sub, il connettore

converte i campi LRAW nella codifica UTF-8 prima di inviarli

a Pub/Sub. Nonostante questa conversione, il connettore

memorizza comunque i dati come Base64 in BigQuery.

La conversione UTF-8 del connettore del valore di un campo LRAW considera solo

i byte iniziali indicati dalla colonna della lunghezza precedente. Ciò è conforme agli

standard SAP, in cui il campo

lunghezza precedente (un tipo INT2 o INT4) definisce

la lunghezza valida dei contenuti LRAW.

Mappatura predefinita dei tipi di dati

La tabella seguente mostra la conversione predefinita dei tipi di dati di BigQuery Connector per SAP:

| Tipo di SAP | Tipo di dati SAP | Tipo di dati BigQuery | Tipo di dati Pub/Sub Avro | Note |

|---|---|---|---|---|

b (numero intero di 1 byte)s (numero intero di 2 byte)I (numero intero di 4 byte)8 (numero intero di 8 byte)

|

INT1INT2INT4INT8

|

INTEGER |

INT |

|

F (float)

|

FLTP

|

FLOAT |

FLOAT |

|

P (compresso)

|

CURRDECQUAN

|

NUMERIC |

DOUBLE |

Per impostazione predefinita, il tipo SAP P viene mappato al tipo di dati BigQuery NUMERIC e convertito in un numero nel formato esterno. |

a (numero in virgola mobile decimale, 16 cifre)

|

DECFLOAT16 |

NUMERIC |

DOUBLE |

|

e (numero in virgola mobile decimale, 16 cifre)

|

DECFLOAT34 |

NUMERIC |

DOUBLE |

|

N (numerico) |

NUMC |

STRING |

STRING |

|

X (esadecimale)y (stringa di byte)

|

RAWRAWSTRINGLRAW

|

STRING |

STRING |

Se il tipo SAP è X, ma il nome del tipo di dati copre

il pattern 'INT*' (INT1, INT2, INT4), un elemento di dati di origine viene sostituito

con un nuovo elemento di dati TYPINT8 con TYPEKIND '8', che viene mappato

al tipo di dati BigQuery INTEGER. |

C (carattere)g (stringa di caratteri)? (csequence)& (clike)

|

CHARSTRING |

STRING |

STRING |

|

D (data) |

DATS |

DATE |

STRING |

|

T (ora) |

TIMS |

TIME |

STRING |

Licenze

BigQuery Connector per SAP è reso disponibile come "Software" ai sensi del contratto che regola il tuo utilizzo della Google Cloud Platform, inclusi i Termini specifici del servizio disponibili all'indirizzo https://cloud.google.com/terms/service-terms. Senza limitare la generalità dei termini precedenti, non puoi modificare o distribuire BigQuery Connector per SAP senza l'espressa autorizzazione scritta di Google.

BigQuery Connector per il software SAP è offerto senza costi. Per chiarezza, l'utilizzo di altri "Software" e "Servizi" ai sensi del contratto che disciplina l'utilizzo della piattaforma Google Cloud , come BigQuery, Pub/Sub, API Pub/Sub, API Storage Write e API BigQuery Streaming, potrebbe comportare un costo.

BigQuery Connector per SAP non include alcuna licenza per il software SAP, incluso, senza alcuna limitazione, SAP LT Replication Server; devi procurarti separatamente una licenza appropriata per il software SAP.

Ciclo di vita dell'assistenza

Google Cloud supporta e gestisce l'ultima versione principale di BigQuery Connector per SAP per un periodo di almeno 12 mesi dopo la pubblicazione di un avviso di ritiro nella pagina delle note di rilascio per SAP su Google Cloud, la versione principale precedente.

Passaggi successivi

Per informazioni su come installare BigQuery Connector per SAP, consulta Installare BigQuery Connector per SAP.