O BigQuery Toolkit para SAP permite acessar recursos do BigQuery de maneira programática no ambiente SAP usando ABAP. É possível acessar recursos do BigQuery no SAP sem precisar escrever código boilerplate para operações comuns, como:

- Sincronização da definição de tabela: mantenha as tabelas do SAP e do BigQuery sincronizadas.

- Mapeamento de tipos de dados: mapeie tipos de dados entre o SAP e o BigQuery.

- Divisão de dados em partes: transfira grandes conjuntos de dados com eficiência.

- Tratamento de erros: gerencie possíveis erros durante a replicação de dados.

Ao contrário do BigQuery Connector para SAP, que exige um SAP Landscape Transformation Replication Server, é possível usar o BigQuery Toolkit para SAP em qualquer sistema SAP ERP em que o ABAP seja compatível.

O BigQuery Toolkit para SAP é enviado como um subpacote da edição no local ou em qualquer edição na nuvem do ABAP SDK for Google Cloud. Para usar o kit de ferramentas, instale o SDK no seu ambiente SAP. Para informações sobre as etapas de instalação, consulte Instalar e configurar a edição local ou de qualquer nuvem do SDK do ABAP para Google Cloud.

O BigQuery Toolkit para SAP está disponível apenas com a edição no local ou em qualquer nuvem do ABAP SDK for Google Cloud.

Replicação de dados do SAP para o BigQuery

Com o módulo de transferência de dados do BigQuery do BigQuery Toolkit para SAP, é possível replicar dados do SAP para o BigQuery para análise e geração de relatórios.

O diagrama a seguir mostra as configurações de transferência de dados e o fluxo de replicação de dados no módulo de transferência de dados do BigQuery:

Configurações de transferência de dados

Como mostrado no diagrama da seção anterior, para estabelecer a replicação de dados do SAP para o BigQuery, os administradores fazem as seguintes configurações:

- No Google Cloud, o administrador da nuvem configura o BigQuery e concede as permissões necessárias do IAM.

- No sistema SAP, o administrador do sistema SAP configura o ABAP SDK for Google Cloud para permitir a comunicação com Google Cloud.

- No sistema SAP, o administrador configura o módulo de transferência de dados do BigQuery para gerenciar as configurações de transferência de dados e os detalhes dos recursos do BigQuery. Essas configurações

são armazenadas nas seguintes tabelas:

/GOOG/BQTR_MASTER/GOOG/BQTR_TABLE/GOOG/BQTR_FIELD/GOOG/BQTR_PARAMS

Quando o código ABAP é executado, a classe de carga de dados do BigQuery lê as configurações dessas tabelas para orientar o processo de replicação de dados.

Fluxo de replicação de dados

Como mostrado no diagrama da seção anterior, para replicar dados de sistemas SAP para o BigQuery, os desenvolvedores do ABAP escrevem um código ABAP personalizado que faz o seguinte:

- Lê dados de tabelas SAP padrão ou personalizadas.

Usa a classe de carregamento de dados do BigQuery

/GOOG/CL_BQTR_DATA_LOADpara replicar os dados selecionados no BigQuery. Esta classe:- Usa a configuração armazenada nas tabelas de configuração do serviço de transferência de dados do BigQuery.

- Usa a classe

/GOOG/CL_BIGQUERY_V2para realizar a sincronização da definição de tabela e a replicação de dados.

Implementa a lógica de negócios de acompanhamento.

Lida com erros e exceções.

Fontes compatíveis para replicação de dados

Use o módulo de transferência de dados do BigQuery do BigQuery Toolkit para SAP para carregar dados de forma programática de objetos do dicionário ABAP, como tabelas, visualizações do dicionário, visualizações do CDS, entidades do CDS, ou de qualquer objeto de dados com um tipo de estrutura simples no BigQuery.

É possível usar o BigQuery Toolkit para SAP para replicação de dados das seguintes maneiras:

- Como um plug-in em frameworks de melhoria do SAP, como complementos empresariais (BAdIs), saídas de usuário e rotinas. Por exemplo, o kit de ferramentas pode ser conectado a rotinas do Business Warehouse (BW) para enviar os dados que estão sendo processados pelo processo de transferência de dados (DTP) do BW.

- Para carregar dados em lote de um programa ABAP personalizado.

Planejamento de desempenho

O BigQuery Toolkit para SAP fornece a etapa final da transmissão de dados para o BigQuery fazendo chamadas síncronas para a API BigQuery.

Ao usar o BigQuery Toolkit para SAP no seu aplicativo ABAP personalizado, é possível otimizar a performance da replicação de dados na sua carga de trabalho do SAP e nas configurações do serviço de transferência de dados do BigQuery.

Opções de ajuste de performance com sua carga de trabalho SAP e aplicativo personalizado

Para otimizar o desempenho da sua carga de trabalho SAP e dos aplicativos personalizados, considere as seguintes opções:

- Execute sua carga de trabalho do SAP, o sistema de origem de onde os dados são replicados para o BigQuery, em Google Cloud.

- Se a carga de trabalho da SAP estiver no Google Cloud, crie o conjunto de dados do BigQuery na mesma região que a carga de trabalho da SAP.

- Se não for possível executar sua carga de trabalho da SAP em Google Cloud, faça o seguinte:

- Crie seu conjunto de dados do BigQuery em uma região Google Cloud mais próxima da sua carga de trabalho da SAP.

- Conecte-se ao Google Cloud usando o Cloud Interconnect.

- Dimensione o sistema de servidor SAP de maneira ideal para sua carga de trabalho.

- Implemente o processamento paralelo para chamar o módulo de transferência de dados do BigQuery em várias linhas de execução paralelas e aumentar a capacidade de transferência.

Como o BigQuery Toolkit para SAP fornece a etapa final da transmissão de dados para o BigQuery, a performance dele é influenciada por vários fatores no seu ambiente específico. Esses fatores podem incluir:

Infraestrutura de rede: limitações de largura de banda, latência e estabilidade geral da rede têm um papel significativo na velocidade e eficiência da replicação.

Sistemas de origem: o desempenho dos bancos de dados de origem, incluindo hardware, configuração e carga atual, pode afetar o desempenho da replicação.

Volume de dados e taxa de mudança: a quantidade de dados replicados e a frequência das mudanças afetam o tempo e os recursos necessários para a replicação.

Outros componentes: firewalls, políticas de segurança, balanceadores de carga e outros elementos de infraestrutura podem contribuir para a performance geral da replicação de dados.

Você é responsável por testar o desempenho do BigQuery Toolkit para SAP no seu próprio ambiente. Para ter resultados ideais, considere e otimize todos os componentes relevantes do seu ambiente.

Opções de ajuste de performance disponíveis nas configurações do serviço de transferência de dados do BigQuery

As configurações de transferência de dados do BigQuery oferecem as seguintes opções para controlar o desempenho da replicação:

Tamanho do bloco de transferência de dados

O BigQuery Toolkit para SAP envia dados ao BigQuery como blocos de registros. Recomendamos que você use o tamanho de bloco padrão com o BigQuery Toolkit para SAP, que é de 10.000 registros. Se os registros em uma tabela de origem contiverem muito poucos campos ou os campos tiverem valores de dados de tamanho muito pequeno, você poderá usar um tamanho de bloco maior até o tamanho máximo de bloco permitido pelo BigQuery Toolkit para SAP, que é de 50.000 registros.

Se o número de registros em um determinado bloco for resolvido para um tamanho de byte que excede o limite do BigQuery para o tamanho de byte das solicitações HTTP, você poderá receber umquotaExceeded erro

ou uminvalid erro. Isso pode acontecer se os registros em uma tabela de origem

contiverem muitos campos ou houver muitos dados.

Se você receber um erro relacionado ao tamanho do bloco, reduza o tamanho do bloco especificado na configuração de transferência em massa para essa tabela. Como alternativa, é possível ativar o tamanho dinâmico do bloco para essa tabela e ajustá-lo automaticamente. Para ver mais informações, consulte Tamanho dinâmico do bloco.

Se você não tiver ativado o tamanho dinâmico do bloco, para tabelas de origem SAP, como

MSEG, ACDOCA e MATDOC, que podem ter registros grandes com muitos

campos por registro, talvez seja necessário especificar um bloco de até 2.000.

É possível especificar um tamanho de bloco executando a transação /GOOG/BQTR_SETTINGS. O tamanho do bloco é especificado no campo Tamanho do bloco na tela Atributos da tabela.

Compactação de registro

Por padrão, o BigQuery Toolkit para SAP melhora o desempenho da replicação compactando os registros enviados ao BigQuery.

Quando a compactação de registros está ativada no nível da tabela, que é a configuração padrão,

o BigQuery Toolkit para SAP omite todos os campos vazios no registro de origem

dos registros enviados para o BigQuery. Quando o registro é inserido no BigQuery, os campos que foram omitidos dos dados enviados são inicializados com null na tabela de destino do BigQuery.

No entanto, se você precisar replicar alguns campos vazios com os valores iniciais para o BigQuery e ainda usar a compactação de registros no nível da tabela, mude a configuração de compactação de registros para esses campos específicos. Como resultado, os valores vazios nos campos especificados não são omitidos dos dados enviados e mantêm o valor com que foram inicializados na tabela de origem.

Na sua configuração de transferência em massa, é possível controlar o comportamento da compactação de registros usando a configuração Enviar flag não compactada, disponível no nível da tabela e do campo. A tabela a seguir resume o comportamento da compactação de registros dependendo da configuração Enviar flag não compactada:

| Enviar flag não compactada no nível da tabela | Enviar flag não compactada no nível do campo | Comportamento de compactação de registros |

|---|---|---|

| Sim | Não | Todos os campos são enviados sem compactação. |

| Sim | Sim | Todos os campos são enviados sem compactação. |

| Não | Sim | Somente os campos selecionados no nível do campo são enviados sem compactação. |

| Não | Não | Todos os campos são enviados como compactados. |

Quando você envia a replicação de dados não compactados, exceto para campos de data e carimbo de data/hora, os campos vazios mantêm o valor com que foram inicializados na tabela de origem. Os valores a seguir para data e carimbo de data/hora recebem:

- Valor da inicialização do campo de data:

DATE 1970-01-01 - Valor da inicialização do campo de carimbo de data/hora:

TIMESTAMP 1970-01-01 00:00:00 UTC

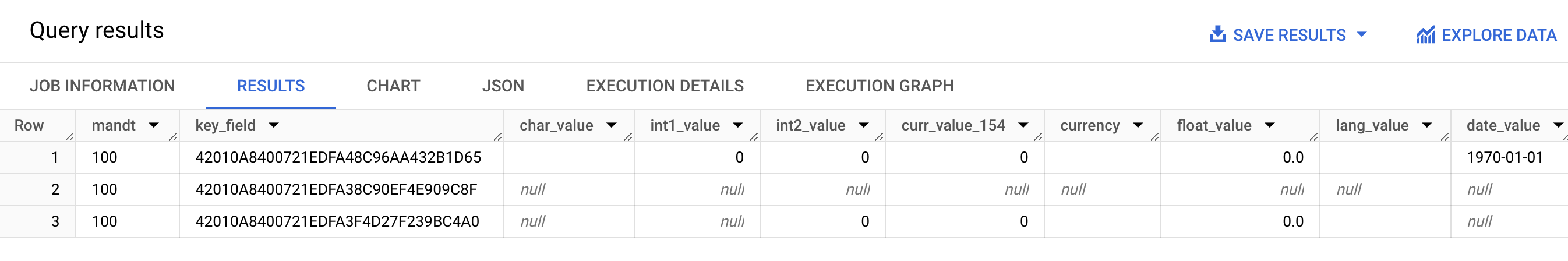

A captura de tela a seguir mostra um exemplo do comportamento da compactação de registros:

A imagem acima mostra o seguinte:

- Linha 1: todos os campos estão descompactados. A flag de envio não compactada está selecionada no nível da tabela.

- Linha 2: todos os campos estão compactados. A flag "Send Uncompressed" está limpa no nível da tabela.

- Linha 3: os seguintes campos não estão compactados:

int2_value,curr_value_154,currency,float_valueelang_value. Para esses campos, a flag "Enviar sem compactação" é selecionada no nível do campo.

Para melhorar o desempenho, recomendamos que você não desative a compactação de registros selecionando Enviar flag não compactada no nível da tabela. Isso pode ter um impacto negativo no desempenho da replicação. Se você precisar enviar dados não compactados apenas para campos específicos, selecione Enviar flag não compactada para esses campos no nível do campo.

Propriedades da tabela de destino

Ao configurar a replicação no módulo de transferência de dados do BigQuery do BigQuery Toolkit para SAP, é possível especificar as configurações que se aplicam quando o BigQuery Toolkit para SAP cria a tabela de destino no BigQuery.

Por exemplo, é possível especificar as seguintes propriedades para uma tabela de destino do BigQuery:

- Nome da tabela

- A opção de nomeação padrão dos campos

- Campos extras para capturar alterações de registros e ativar consultas de contagem de registros

- Particionamento de tabelas

Opções de nomeação padrão dos campos

É possível configurar o BigQuery Toolkit para SAP para criar os nomes dos campos na tabela de destino do BigQuery a partir dos nomes dos campos de origem ou dos rótulos e descrições dos campos de origem. Os rótulos e descrições geralmente são mais informativos sobre o conteúdo do campo.

Por padrão, o BigQuery Toolkit para SAP usa os nomes dos campos de origem.

É possível alterar o padrão especificando a sinalização de Nomes personalizados ao especificar os atributos de criação da tabela na configuração de transferência em massa da transação /GOOG/BQTR_SETTINGS. Essa especificação é armazenada na tabela de configuração /GOOG/BQTR_MASTR.

Ao criar os nomes, o BigQuery Toolkit para SAP os modifica para ficar em conformidade com a convenção de nomenclatura do BigQuery.

Antes que o BigQuery Toolkit para SAP crie uma tabela no BigQuery,

é possível editar os nomes dos campos na tela de mapeamento de campos

da transação /GOOG/BQTR_SETTINGS.

Quando a flag Nomes personalizados é especificada, os nomes que o BigQuery Toolkit para SAP vai usar ao criar a tabela de destino são mostrados na coluna Nome do campo externo da tela de mapeamento de campo.

O BigQuery Toolkit para SAP cria os nomes na coluna Nome do campo externo a partir do rótulo de campo médio de cada campo de origem. Se um rótulo de campo médio não for especificado na definição do campo de origem, a descrição curta do campo será usada. Se a descrição curta não for especificada, o rótulo especificado mais curto será usado. Se nada for especificado, será usado o nome do campo de origem.

Para mais informações sobre como personalizar os nomes dos campos de destino, consulte Como personalizar nomes de campos de destino.

Como capturar alterações de registro e ativar contagens de registros

Para capturar o tipo de mudança na tabela de origem que acionou a replicação e consultar as contagens de registros na tabela do BigQuery para comparação com as contagens na tabela de origem, especifique a opção Sinalização de campos extras na transação /GOOG/BQTR_SETTINGS ao configurar a replicação.

Quando você especifica a opção Sinalização de campos extras, as seguintes colunas são adicionadas ao esquema da tabela de destino do BigQuery:

| Nome do campo | Tipo de dado | Descrição |

|---|---|---|

operation_flag

|

STRING

|

Identifica o tipo de alteração na tabela de origem que acionou o carregamento ou a replicação do registro no BigQuery.

Para contar registros inseridos no modo de replicação, consulte

registros com valor

Para contar registros inseridos no modo de carregamento inicial, consulte

registros que têm um valor de |

is_deleted

|

BOOLEAN

|

Quando true, indica que o registro de origem foi

excluído da tabela de origem.

Para contar apenas os registros em uma tabela do BigQuery que

não foram excluídos da tabela de origem, use o

campo |

recordstamp

|

TIMESTAMP

|

A hora em que o BigQuery Toolkit para SAP enviou o registro ao BigQuery. Para contar o número de registros exclusivos em uma tabela do BigQuery, consulte apenas a instância inserida mais recentemente de cada registro. Para ver um exemplo de consulta, acesse Consultar a contagem total de registros em uma tabela do BigQuery. |

A configuração atual da opção Sinalização de campos extras é armazenada na tabela de configuração /GOOG/BQTR_MASTR.

Para mais informações sobre como especificar a Sinalização de campos extras, consulte Especificar a criação de tabelas e outros atributos gerais.

Particionamento de tabelas

É possível criar tabelas do BigQuery de uma das seguintes maneiras:

- Tabelas particionadas por um campo de carimbo de data/hora na tabela de origem, que cria uma tabela particionada por coluna de unidade de tempo.

- Tabelas particionadas pelo momento em que os registros são inseridos no BigQuery, o que cria uma tabela particionada por tempo de ingestão.

Ative o particionamento especificando um tipo de partição no campo Tipo de partição no /GOOG/BQTR_TABLE ao configurar as propriedades de replicação.

Os tipos de partição que podem ser especificados ajustam a granularidade do particionamento por hora, dia, mês ou ano.

Para usar um carimbo de data/hora da tabela de origem para particionamento da coluna de unidade de tempo, especifique o nome do campo de origem no campo Partition Field.

Para usar um tempo de inserção do BigQuery para particionamento por tempo de ingestão, deixe o Campo da partição em branco. O BigQuery Toolkit para SAP cria um campo na tabela de destino para armazenar o tempo de inserção.

Propriedades do campo de destino

Por padrão, o BigQuery Toolkit para SAP usa os nomes de campos e os tipos de dados na tabela de origem SAP como nomes de campos e tipos de dados no BigQuery de destino.

Opcionalmente, antes de a tabela de destino ser criada, é possível personalizar os nomes dos campos ou alterar o tipo de dados do BigQuery.

Como personalizar nomes de campos de destino

Antes de criar uma tabela, é possível personalizar os nomes dos campos de destino.

Se necessário, o BigQuery Toolkit para SAP modifica os nomes personalizados especificados para conformidade com a convenção de nomenclatura do BigQuery.

Ao configurar a replicação, é possível visualizar os nomes dos campos na tela de mapeamento de campo da transação /GOOG/BQTR_SETTINGS. O

BigQuery Toolkit para SAP armazena suas configurações na tabela de

configuração /GOOG/BQTR_FIELD.

Antes de criar uma tabela no BigQuery, é possível especificar um nome de campo personalizado editando o nome gerado na coluna Nome do campo temporário da tela de mapeamento de campo. Se você excluir um valor e deixar o campo Nome do campo temporário em branco, o BigQuery Toolkit para SAP usará o nome do campo de origem como o nome desse campo.

Depois de fazer edições na coluna Nome do campo temporário, clique em Salvar. O BigQuery Toolkit para SAP valida o valor, aplica as convenções de nomenclatura do BigQuery conforme necessário e salva as mudanças. É possível validar um valor sem salvá-lo pressionando Enter no teclado.

Para mais informações sobre como definir o método de nomenclatura padrão para os campos de destino, consulte Opções de nomenclatura padrão para campos.

Usar uma planilha ou um arquivo de texto para editar o mapa de campos do BigQuery

Opcionalmente, antes de criar uma tabela de destino do BigQuery, é possível salvar os tipos de dados, os nomes e as descrições padrão dos campos de destino em uma planilha ou em um arquivo de texto. Essa abordagem permite que os administradores ou engenheiros de dados do BigQuery editem os valores mesmo que não tenham acesso ao seu servidor SAP.

Depois que os valores forem editados, você precisará converter o arquivo e o conteúdo dele

no formato de valores separados por vírgula (CSV). É possível aplicar as atualizações

às configurações de transferência em massa fazendo upload do arquivo CSV usando a

transação personalizada /GOOG/BQTR_SETTINGS.

Para usar um arquivo CSV e editar o mapa de campos do BigQuery, faça o seguinte:

- Crie uma planilha ou um arquivo de texto com os mapeamentos de campo padrão.

- Edite os valores na planilha ou no arquivo de texto.

- Converta a planilha ou o arquivo de texto no formato CSV.

- Na tela Transferência de dados do BigQuery: manutenção de configurações, faça upload do arquivo CSV.

Para mais informações sobre esse processo, consulte Editar o mapa de campos do BigQuery em um arquivo CSV.

Convenção de nomenclatura do BigQuery para campos

A convenção de nomenclatura do BigQuery usa apenas letras minúsculas, números e sublinhados.

O BigQuery Toolkit para SAP aplica as convenções de nomenclatura do BigQuery a qualquer valor de entrada a ser usado para o nome de um campo de destino.

Por exemplo, se você inserir FIELD-@#!*123 como um nome de campo personalizado, o

BigQuery Toolkit para SAP vai mudar o nome para field_123.

Para mais informações sobre a convenção de nomenclatura do BigQuery para campos, consulte Nomes de colunas.

Mapeamento de tipo de dados

Por padrão, o BigQuery Toolkit para SAP atribui tipos de dados aos campos de destino do BigQuery com base no Tipo de dados SAP ou no Tipo de dados SAP da SAP de origem.

Ao configurar a replicação, é possível visualizar os tipos de dados na tela de mapeamento

de campo da transação /GOOG/BQTR_SETTINGS. O

BigQuery Toolkit para SAP armazena suas configurações na tabela de

configuração /GOOG/BQTR_FIELD.

Antes que o BigQuery Toolkit para SAP crie uma tabela no BigQuery, é possível mudar a especificação de tipo de dados padrão para um tipo de dados diferente do BigQuery na coluna Elemento de dados externo da tela de mapeamento de campo.

Tipos de dados que exigem tratamento especial

Para garantir a precisão e a compatibilidade com as tabelas de destino do BigQuery, vários tipos de dados SAP exigem tratamento ou conversão especial durante o processo de replicação.

Embora o BigQuery Toolkit para SAP processe automaticamente algumas dessas conversões, outras exigem sua atenção e configuração manual.

É necessário processar manualmente as conversões dos seguintes tipos de dados:

Booleanos

Para booleanos, o SAP usa o tipo de dados CHAR. Por padrão, o

BigQuery Toolkit para SAP mapeia esse tipo de dados para o tipo de dados STRING na

tabela de destino do BigQuery.

Consequentemente, ao configurar a replicação para booleanos usando

a transação /GOOG/BQTR_SETTINGS, é necessário mudar a atribuição de tipo de dados

padrão dos campos booleanos de STRING para BOOLEAN na

tela de mapeamento de campo.

Carimbos de data/hora

Para carimbos de data/hora, a SAP usa os tipos de dados P (decimal) ou DEC (decimal). Por padrão, o BigQuery Toolkit para SAP mapeia esses tipos de dados para NUMERIC na tabela de destino do BigQuery.

Consequentemente, no caso dos carimbos de data/hora, quando você configura a replicação usando

a transação /GOOG/BQTR_SETTINGS, é necessário mudar a atribuição de tipo de dados

padrão dos campos de carimbo de data/hora de NUMERIC para TIMESTAMP ou

TIMESTAMP (LONG) na tela de mapeamento de campo.

Tipo de tipo SAP X

O tipo de tipo SAP X é um hexadecimal e é representado pelos tipos de dados RAW, RAWSTRING ou LRAW. Por padrão, o BigQuery Toolkit para SAP

mapeia esses tipos de dados para STRING na tabela de origem do BigQuery.

Se você precisar que um campo de origem com o tipo de tipo SAP X seja mapeado para BYTES, em vez disso, será necessário alterar a atribuição de tipo de dados padrão para o campo na tela de mapeamento de campo da transação /GOOG/BQTR_SETTINGS.

kinds vezes, o tipo de tipo SAP X também é usado em SAP para representar números inteiros.

Nesse caso, o BigQuery Toolkit para SAP verifica o tipo de dados do campo de origem de um dos tipos de dados SAP para números inteiros, INT1, INT2, INT4, INT8 e atribui o tipo de dados INTEGER na tabela de destino do BigQuery.

Tipo de tipo SAP y

O tipo de tipo SAP y é uma string de bytes e é representado pelos tipos de dados RAW, RAWSTRING ou LRAW. Por padrão, o BigQuery Toolkit para SAP

mapeia esses tipos de dados para STRING na tabela de origem do BigQuery.

Se você precisar que um campo de origem com o tipo de tipo SAP y seja mapeado para BYTES, em vez disso, será necessário alterar a atribuição de tipo de dados padrão para o campo na tela de mapeamento de campo do /GOOG/BQTR_SETTINGS.

Mapeamento de tipo de dados padrão

A tabela a seguir mostra a conversão de tipo de dados padrão do BigQuery Toolkit para SAP:

| Tipo de SAP | Tipo de dados do SAP | Tipo de dados BigQuery | Observações |

|---|---|---|---|

b (número inteiro de 1 byte)s (número inteiro de 2 bytes)I (número inteiro de 4 bytes)8 (inteiro de 8 bytes)

|

INT1INT2INT4INT8

|

INTEGER |

|

F (float)

|

FLTP

|

FLOAT |

|

P (embalado)

|

CURRDECQUAN

|

NUMERIC |

Por padrão, o tipo de tipo SAP P é mapeado para o tipo de dados do BigQuery NUMERIC e convertido em um número no formato externo. |

a (número flutuante decimal, 16 casas)

|

DECFLOAT16 |

NUMERIC |

|

e (número flutuante decimal, 16 casas)

|

DECFLOAT34 |

NUMERIC |

|

N (numérico) |

NUMC |

STRING |

|

X (hexadecimal)y (string de bytes)

|

RAWRAWSTRINGLRAW

|

STRING |

Se o tipo de tipo SAP é X, mas o nome do tipo de dados abrange

o padrão 'INT*' (INT1, INT2, INT4), um elemento de dados de origem é substituído

por um novo elemento de dados TYPINT8 com TYPEKIND '8', que é mapeado

para o tipo de dados do BigQuery INTEGER. |

C (caractere)g (string de caracteres)? (csequência)& (semelhante)

|

CHARSTRING |

STRING |

|

D (data) |

DATS |

DATE |

|

T (período) |

TIMS |

TIME |

Recursos da comunidade

Para acelerar a implementação de aplicativos baseados no BigQuery Toolkit em sistemas SAP S/4HANA que usam o BW incorporado, use as ferramentas de geração de código aberto disponíveis no GitHub.

Receber suporte

Google Cloud oferece suporte para problemas e dúvidas relacionados à instalação, configuração, operação e manutenção do BigQuery Toolkit para SAP.

Para problemas originados de componentes gerenciados pela SAP, como Operational Data Provisioning (ODP), Data Migration Server (DMIS), Core Data Services (CDS), Internet Communication Manager (ICM) ou software de terceiros, Google Cloud o atendimento ao cliente faz o possível para identificar a causa raiz. Para resolver esses problemas, entre em contato com o fornecedor ou provedor de suporte respectivo.

Para resolver problemas com o BigQuery Toolkit para SAP, consulte Solução de problemas do BigQuery Toolkit para SAP.

Se você precisar de ajuda para resolver problemas com o ABAP SDK for Google Cloud, faça o seguinte:

Consulte o guia de solução de problemas do ABAP SDK for Google Cloud.

Faça suas perguntas e discuta o ABAP SDK for Google Cloud com a comunidade nos Fóruns do Cloud.

Colete todas as informações de diagnóstico disponíveis e entre em contato com o Cloud Customer Care. Para mais informações sobre como entrar em contato com o atendimento ao cliente, consulte Como receber suporte para o SAP no Google Cloud.