이 튜토리얼에서는 Vertex AI 엔드포인트를 BigQuery에서 원격 모델로 등록합니다. 그런 다음 ML.PREDICT 함수를 사용하여 원격 모델을 통해 예측합니다.

모델이 너무 커서 BigQuery로 가져올 수 없는 경우 원격 모델을 사용할 수 있습니다. 온라인, 배치, 마이크로 배치 사용 사례에 단일 추론 지점을 사용하려는 경우에도 유용합니다.

Vertex AI Model Registry로 모델 가져오기

이 튜토리얼에서는 Cloud Storage의 gs://cloud-samples-data/bigquery/ml/remote_model_tutorial/에서 사용할 수 있는 사전 학습된 TensorFlow 모델을 사용합니다. Cloud Storage 버킷은 US 멀티 리전 위치에 있습니다.

이 모델은 saved_model.pb라는 TensorFlow 모델입니다. 일반 텍스트 IMDB 영화 리뷰로 BERT 모델을 미세 조정하여 만든 맞춤설정된 감정 분석 모델입니다. 이 모델은 영화 리뷰의 텍스트 입력을 사용하고 0과 1 사이의 감정 점수를 반환합니다. 모델을 Model Registry에 가져올 때는 사전 빌드된 TensorFlow 컨테이너를 사용합니다.

모델을 가져오려면 다음 단계를 따르세요.

Google Cloud 콘솔에서 Vertex AI Model Registry 페이지로 이동합니다.

가져오기를 클릭합니다.

1단계: 이름 및 리전의 경우 다음 단계를 따르세요.

새 모델로 가져오기를 선택합니다.

이름에

bert_sentiment를 입력합니다.설명에

BQML tutorial model을 입력합니다.리전에서

us-central1을 선택합니다. Cloud Storage 버킷이US멀티 리전 위치에 있으므로 미국 기반 리전을 선택해야 합니다.계속을 클릭합니다.

2단계: 모델 설정의 경우 다음 단계를 따르세요.

사전 빌드된 새 컨테이너로 모델 아티팩트 가져오기를 선택합니다.

사전 빌드된 컨테이너 설정 섹션에서 다음을 수행합니다.

모델 프레임워크에서 TensorFlow를 선택합니다.

모델 프레임워크 버전에서 2.15를 선택합니다.

가속기 유형에서 GPU를 선택합니다.

모델 아티팩트 위치에

gs://cloud-samples-data/bigquery/ml/remote_model_tutorial/을 입력합니다.나머지 모든 옵션의 기본값은 그대로 두고 가져오기를 클릭합니다.

가져오기가 완료되면 Model Registry 페이지에 모델이 나타납니다.

Vertex AI 엔드포인트에 모델 배포

모델을 엔드포인트에 배포하려면 다음 단계를 따르세요.

Google Cloud 콘솔에서 Vertex AI Model Registry 페이지로 이동합니다.

이름 열에서

bert_sentiment를 클릭합니다.배포 및 테스트 탭을 클릭합니다.

엔드포인트에 배포를 클릭합니다.

첫 번째 단계인 엔드포인트 정의에서는 다음을 실행합니다.

새 엔드포인트 만들기를 클릭합니다.

엔드포인트 이름에

bert sentiment endpoint를 입력합니다.나머지 기본값은 그대로 두고 계속을 클릭합니다.

두 번째 단계인 모델 설정에서는 다음을 실행합니다.

컴퓨팅 설정 섹션의 최소 컴퓨팅 노드 수에

1을 입력합니다. 이 숫자는 모델에서 항상 사용할 수 있는 노드 수여야 합니다.고급 확장 옵션 섹션의 머신 유형에서 표준(n1-standard-2)을 선택합니다. 모델을 가져올 때 GPU를 가속기 유형으로 선택했으므로 머신 유형을 선택한 후 가속기 유형과 가속기 수가 자동으로 설정됩니다.

나머지 기본값은 그대로 두고 배포를 클릭합니다.

모델이 엔드포인트에 배포되면 상태가

Active로 변경됩니다.ID 열의 숫자 엔드포인트 ID와 리전 열의 값을 복사합니다. 나중에 이 값이 필요합니다.

데이터 세트 만들기

ML 모델을 저장할 BigQuery 데이터 세트를 만듭니다.

콘솔

Google Cloud 콘솔에서 BigQuery 페이지로 이동합니다.

탐색기 창에서 프로젝트 이름을 클릭합니다.

작업 보기 > 데이터 세트 만들기를 클릭합니다.

데이터 세트 만들기 페이지에서 다음을 수행합니다.

데이터 세트 ID에

bqml_tutorial를 입력합니다.위치 유형에 대해 멀티 리전을 선택한 다음 US(미국 내 여러 리전)를 선택합니다.

나머지 기본 설정은 그대로 두고 데이터 세트 만들기를 클릭합니다.

bq

새 데이터 세트를 만들려면 --location 플래그와 함께 bq mk 명령어를 실행합니다. 사용할 수 있는 전체 파라미터 목록은 bq mk --dataset 명령어 참조를 확인하세요.

데이터 위치가

US로 설정되고 설명이BigQuery ML tutorial dataset인bqml_tutorial데이터 세트를 만듭니다.bq --location=US mk -d \ --description "BigQuery ML tutorial dataset." \ bqml_tutorial

--dataset플래그를 사용하는 대신 이 명령어는-d단축키를 사용합니다.-d와--dataset를 생략하면 이 명령어는 기본적으로 데이터 세트를 만듭니다.데이터 세트가 생성되었는지 확인합니다.

bq ls

API

데이터 세트 리소스가 정의된 datasets.insert 메서드를 호출합니다.

{ "datasetReference": { "datasetId": "bqml_tutorial" } }

BigQuery DataFrames

이 샘플을 사용해 보기 전에 BigQuery DataFrames를 사용하여 BigQuery 빠른 시작의 BigQuery DataFrames 설정 안내를 따르세요. 자세한 내용은 BigQuery DataFrames 참고 문서를 확인하세요.

BigQuery에 인증하려면 애플리케이션 기본 사용자 인증 정보를 설정합니다. 자세한 내용은 로컬 개발 환경의 ADC 설정을 참조하세요.

BigQuery Cloud 리소스 연결 생성

Vertex AI 엔드포인트에 연결하려면 Cloud 리소스 연결이 필요합니다.

콘솔

BigQuery 페이지로 이동합니다.

왼쪽 창에서 탐색기를 클릭합니다.

왼쪽 창이 표시되지 않으면 왼쪽 창 펼치기를 클릭하여 창을 엽니다.

탐색기 창에서 데이터 추가를 클릭합니다.

데이터 추가 대화상자가 열립니다.

필터링 기준 창의 데이터 소스 유형 섹션에서 데이터베이스를 선택합니다.

또는 데이터 소스 검색 필드에

Vertex AI을 입력할 수 있습니다.추천 데이터 소스 섹션에서 Vertex AI를 클릭합니다.

Vertex AI 모델: BigQuery 제휴 솔루션 카드를 클릭합니다.

연결 유형 목록에서 Vertex AI 원격 모델, 원격 함수, BigLake(Cloud 리소스)를 선택합니다.

연결 ID 필드에

bqml_tutorial을 입력합니다.멀티 리전—미국이 선택되어 있는지 확인합니다.

연결 만들기를 클릭합니다.

창 하단에서 연결로 이동을 클릭합니다. 또는 탐색기 창에서 연결을 클릭한 다음

us.bqml_tutorial을 클릭합니다.연결 정보 창에서 서비스 계정 ID를 복사합니다. 연결의 권한을 구성할 때 이 ID가 필요합니다. 연결 리소스를 만들면 BigQuery가 고유한 시스템 서비스 계정을 만들고 이를 연결에 연계합니다.

bq

연결을 만듭니다.

bq mk --connection --location=US --project_id=PROJECT_ID \ --connection_type=CLOUD_RESOURCE bqml_tutorial

PROJECT_ID를Google Cloud 프로젝트 ID로 바꿉니다.--project_id매개변수는 기본 프로젝트를 재정의합니다.연결 리소스를 만들면 BigQuery가 고유한 시스템 서비스 계정을 만들고 이를 연결에 연계합니다.

문제 해결: 다음 연결 오류가 발생하면 Google Cloud SDK를 업데이트하세요.

Flags parsing error: flag --connection_type=CLOUD_RESOURCE: value should be one of...

이후 단계에서 사용할 수 있도록 서비스 계정 ID를 가져와 복사합니다.

bq show --connection PROJECT_ID.us.bqml_tutorial

출력은 다음과 비슷합니다.

name properties 1234.REGION.CONNECTION_ID {"serviceAccountId": "connection-1234-9u56h9@gcp-sa-bigquery-condel.iam.gserviceaccount.com"}

연결 액세스 설정

클라우드 리소스 연결의 서비스 계정에 Vertex AI 사용자 역할을 부여합니다. 원격 모델 엔드포인트를 만든 것과 동일한 프로젝트에서 이 역할을 부여해야 합니다.

역할을 부여하려면 다음 단계를 따르세요.

IAM 및 관리자 페이지로 이동합니다.

액세스 권한 부여를 클릭합니다.

새 주 구성원 필드에 이전에 복사한 클라우드 리소스 연결의 서비스 계정 ID를 입력합니다.

역할 선택 필드에서 Vertex AI를 선택한 후 Vertex AI 사용자를 선택합니다.

저장을 클릭합니다.

BigQuery ML 원격 모델 만들기

CREATE MODEL 문을 REMOTE WITH CONNECTION 절과 함께 사용하여 BigQuery ML 원격 모델을 만듭니다. CREATE MODEL 문에 관한 자세한 내용은 커스텀 모델을 통한 원격 모델의 CREATE MODEL 문을 참조하세요.

US 멀티 리전 위치에서 모델을 만듭니다. BigQuery 멀티 리전(US, EU) 데이터 세트에서는 동일한 멀티 리전 위치(US, EU) 내 리전에 배포된 엔드포인트에 연결되는 원격 모델만 만들 수 있습니다.

원격 모델을 만들 때는 Vertex AI에 모델을 배포할 때 생성된 엔드포인트 ID가 필요합니다. 또한 입력 및 출력 필드 이름과 유형은 Vertex AI 모델의 입력 및 출력과 정확히 동일해야 합니다. 이 예시에서 입력은 텍스트 STRING이고 출력은 FLOAT64 유형의 ARRAY입니다.

콘솔

Google Cloud 콘솔에서 BigQuery 페이지로 이동합니다.

새로 만들기에서 SQL 쿼리를 클릭합니다.

쿼리 편집기에서 이

CREATE MODEL문을 입력한 후 실행을 클릭합니다.CREATE OR REPLACE MODEL `PROJECT_ID.bqml_tutorial.bert_sentiment` INPUT (text STRING) OUTPUT(scores ARRAY<FLOAT64>) REMOTE WITH CONNECTION `PROJECT_ID.us.bqml_tutorial` OPTIONS(ENDPOINT = 'https://us-central1-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/us-central1/endpoints/ENDPOINT_ID')

다음을 바꿉니다.

- PROJECT_ID: 프로젝트 이름입니다.

- ENDPOINT_ID: 이전에 복사한 엔드포인트 ID입니다.

작업이 완료되면

Successfully created model named bert_sentiment와 유사한 메시지가 표시됩니다.새 모델이 리소스 패널에 표시됩니다. 모델은 모델 아이콘(

)으로 표시됩니다.

)으로 표시됩니다.리소스 패널에서 새 모델을 선택하면 모델에 대한 정보가 쿼리 편집기 아래에 표시됩니다.

bq

다음

CREATE MODEL문을 입력하여 원격 모델을 만듭니다.bq query --use_legacy_sql=false \ "CREATE OR REPLACE MODEL `PROJECT_ID.bqml_tutorial.bert_sentiment` INPUT (text STRING) OUTPUT(scores ARRAY<FLOAT64>) REMOTE WITH CONNECTION `PROJECT_ID.us.bqml_tutorial` OPTIONS(ENDPOINT = 'https://us-central1-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/us-central1/endpoints/ENDPOINT_ID')"

다음을 바꿉니다.

- PROJECT_ID: 프로젝트 이름입니다.

- ENDPOINT_ID: 이전에 복사한 엔드포인트 ID입니다.

모델을 만든 후 모델이 데이터 세트에 표시되는지 확인합니다.

bq ls -m bqml_tutorial

출력은 다음과 비슷합니다.

Id Model Type Labels Creation Time ---------------- ------------ -------- ----------------- bert_sentiment 28 Jan 17:39:43

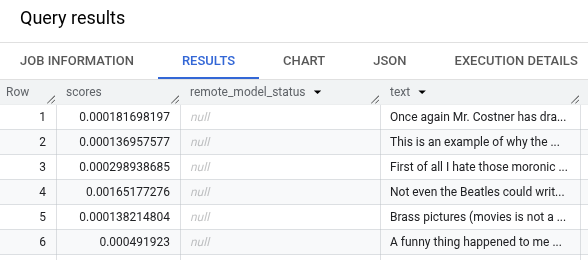

ML.PREDICT를 사용하여 예측 가져오기

ML.PREDICT 함수를 사용하여 원격 모델에서 감정 예측을 가져옵니다. 입력은 bigquery-public-data.imdb.reviews 테이블의 영화 리뷰가 포함된 텍스트 열(review)입니다.

이 예시에서는 10,000개의 레코드가 선택되고 예측을 위해 전송됩니다. 원격 모델의 배치 크기는 기본적으로 요청의 인스턴스 128개로 설정됩니다.

콘솔

Google Cloud 콘솔에서 BigQuery 페이지로 이동합니다.

새로 만들기 섹션에서 SQL 쿼리를 클릭합니다.

쿼리 편집기에서

ML.PREDICT함수를 사용하는 다음 쿼리를 입력한 후 실행을 클릭합니다.SELECT * FROM ML.PREDICT ( MODEL `PROJECT_ID.bqml_tutorial.bert_sentiment`, ( SELECT review as text FROM `bigquery-public-data.imdb.reviews` LIMIT 10000 ) )

쿼리 결과는 다음과 비슷하게 표시됩니다.

bq

다음 명령어를 입력하여 ML.PREDICT를 사용하는 쿼리를 실행합니다.

bq query --use_legacy_sql=false \ 'SELECT * FROM ML.PREDICT ( MODEL `PROJECT_ID.bqml_tutorial.bert_sentiment`, ( SELECT review as text FROM `bigquery-public-data.imdb.reviews` LIMIT 10000 ) )'