Questa pagina mostra come valutare i modelli di classificazione e regressione AutoML.

Vertex AI fornisce metriche di valutazione dei modelli per aiutarti a determinare le prestazioni dei tuoi modelli, come le metriche di precisione e richiamo. Vertex AI calcola le metriche di valutazione utilizzando il set di test.

Prima di iniziare

Prima di valutare il modello, addestralo.

Come utilizzare le metriche di valutazione del modello

Le metriche di valutazione del modello forniscono misure quantitative del rendimento del modello sul set di test. L'interpretazione e l'utilizzo di queste metriche dipendono dalle esigenze aziendali e dal problema che il modello è addestrato a risolvere. Ad esempio, potresti avere una tolleranza inferiore per i falsi positivi rispetto ai falsi negativi o viceversa. Questi tipi di domande influiscono sulle metriche su cui ti concentri.

Recupero delle metriche di valutazione

Puoi ottenere un insieme aggregato di metriche di valutazione per il tuo modello e, per alcuni obiettivi, metriche di valutazione per una determinata classe o etichetta. Le metriche di valutazione per una determinata classe o etichetta sono note anche come slice di valutazione. I seguenti contenuti descrivono come ottenere metriche di valutazione aggregate e sezioni di valutazione utilizzando la console Google Cloud o l'API.

Console Google Cloud

Nella console Google Cloud , nella sezione Vertex AI, vai alla pagina Modelli.

Nel menu a discesa Regione, seleziona la regione in cui si trova il modello.

Nell'elenco dei modelli, fai clic sul tuo modello per aprire la scheda Valuta.

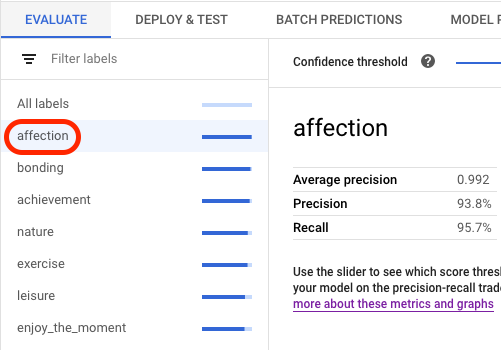

Nella scheda Valuta puoi visualizzare le metriche di valutazione aggregate del modello, come precisione media e richiamo.

Se l'obiettivo del modello ha sezioni di valutazione, la console mostra un elenco di etichette. Puoi fare clic su un'etichetta per visualizzare le metriche di valutazione per quell'etichetta, come mostrato nell'esempio seguente:

API

Le richieste API per ottenere le metriche di valutazione sono le stesse per ogni tipo di dati e obiettivo, ma gli output sono diversi. Gli esempi seguenti mostrano la stessa richiesta, ma risposte diverse.

Recupero delle metriche di valutazione del modello aggregate

Le metriche di valutazione del modello aggregato forniscono informazioni sul modello nel suo complesso. Per visualizzare informazioni su una sezione specifica, elenca le sezioni di valutazione del modello.

Per visualizzare le metriche di valutazione del modello aggregate, utilizza il metodo

projects.locations.models.evaluations.get.

Seleziona la scheda di seguito per il tuo obiettivo:

Classificazione

Vertex AI restituisce un array di metriche di confidenza. Ogni elemento

mostra le metriche di valutazione a un valore confidenceThreshold diverso

(a partire da 0 e fino a 1). Visualizzando diversi valori di soglia, puoi vedere in che modo la soglia influisce su altre metriche come precisione e richiamo.

Seleziona una scheda corrispondente alla tua lingua o al tuo ambiente:

REST

Prima di utilizzare i dati della richiesta, apporta le seguenti sostituzioni:

- LOCATION: la regione in cui è archiviato il modello.

- PROJECT: il tuo ID progetto

- MODEL_ID: l'ID della risorsa modello.

- PROJECT_NUMBER: il numero di progetto generato automaticamente per il tuo progetto.

- EVALUATION_ID: ID per la valutazione del modello (visualizzato nella risposta).

Metodo HTTP e URL:

GET https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT/locations/LOCATION/models/MODEL_ID/evaluations

Per inviare la richiesta, scegli una di queste opzioni:

curl

Esegui questo comando:

curl -X GET \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

"https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT/locations/LOCATION/models/MODEL_ID/evaluations"

PowerShell

Esegui questo comando:

$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred" }

Invoke-WebRequest `

-Method GET `

-Headers $headers `

-Uri "https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT/locations/LOCATION/models/MODEL_ID/evaluations" | Select-Object -Expand Content

Dovresti ricevere una risposta JSON simile alla seguente:

Java

Prima di provare questo esempio, segui le istruzioni di configurazione di Java nella guida rapida di Vertex AI per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API Vertex AI Java.

Per autenticarti in Vertex AI, configura le Credenziali predefinite dell'applicazione. Per ulteriori informazioni, consulta Configura l'autenticazione per un ambiente di sviluppo locale.

Node.js

Prima di provare questo esempio, segui le istruzioni di configurazione di Node.js nella guida rapida di Vertex AI per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API Vertex AI Node.js.

Per autenticarti in Vertex AI, configura le Credenziali predefinite dell'applicazione. Per ulteriori informazioni, consulta Configura l'autenticazione per un ambiente di sviluppo locale.

Python

Per scoprire come installare o aggiornare l'SDK Vertex AI Python, consulta Installare l'SDK Vertex AI Python. Per saperne di più, consulta la documentazione di riferimento dell'API Python.

Regressione

Seleziona una scheda corrispondente alla tua lingua o al tuo ambiente:

REST

Prima di utilizzare i dati della richiesta, apporta le seguenti sostituzioni:

- LOCATION: la regione in cui è archiviato il modello.

- PROJECT: .

- MODEL_ID: l'ID della risorsa modello.

- PROJECT_NUMBER: il numero di progetto generato automaticamente per il tuo progetto.

- EVALUATION_ID: ID per la valutazione del modello (visualizzato nella risposta).

Metodo HTTP e URL:

GET https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT/locations/LOCATION/models/MODEL_ID/evaluations

Per inviare la richiesta, scegli una di queste opzioni:

curl

Esegui questo comando:

curl -X GET \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

"https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT/locations/LOCATION/models/MODEL_ID/evaluations"

PowerShell

Esegui questo comando:

$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred" }

Invoke-WebRequest `

-Method GET `

-Headers $headers `

-Uri "https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT/locations/LOCATION/models/MODEL_ID/evaluations" | Select-Object -Expand Content

Dovresti ricevere una risposta JSON simile alla seguente:

Java

Prima di provare questo esempio, segui le istruzioni di configurazione di Java nella guida rapida di Vertex AI per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API Vertex AI Java.

Per autenticarti in Vertex AI, configura le Credenziali predefinite dell'applicazione. Per ulteriori informazioni, consulta Configura l'autenticazione per un ambiente di sviluppo locale.

Node.js

Prima di provare questo esempio, segui le istruzioni di configurazione di Node.js nella guida rapida di Vertex AI per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API Vertex AI Node.js.

Per autenticarti in Vertex AI, configura le Credenziali predefinite dell'applicazione. Per ulteriori informazioni, consulta Configura l'autenticazione per un ambiente di sviluppo locale.

Python

Per scoprire come installare o aggiornare l'SDK Vertex AI Python, consulta Installare l'SDK Vertex AI Python. Per saperne di più, consulta la documentazione di riferimento dell'API Python.

Elenco di tutte le sezioni di valutazione (solo modelli di classificazione)

Il metodo

projects.locations.models.evaluations.slices.list

elenca tutte le sezioni di valutazione per il tuo modello. Devi

avere l'ID valutazione del modello, che puoi ottenere quando

visualizzi le metriche di valutazione aggregate.

Puoi utilizzare le sezioni di valutazione del modello per determinare il rendimento del modello su un'etichetta specifica. Il campo value indica l'etichetta a cui si riferiscono le metriche.

Vertex AI restituisce un array di metriche di confidenza. Ogni elemento

mostra le metriche di valutazione a un valore confidenceThreshold diverso

(a partire da 0 e fino a 1). Visualizzando diversi valori di soglia, puoi vedere in che modo la soglia influisce su altre metriche come precisione e richiamo.

REST

Prima di utilizzare i dati della richiesta, apporta le seguenti sostituzioni:

- LOCATION: la regione in cui si trova il modello. Ad esempio,

us-central1. - PROJECT: .

- MODEL_ID: l'ID del modello.

- EVALUATION_ID: ID della valutazione del modello che contiene le sezioni di valutazione da elencare.

Metodo HTTP e URL:

GET https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT/locations/LOCATION/models/MODEL_ID/evaluations/EVALUATION_ID/slices

Per inviare la richiesta, scegli una di queste opzioni:

curl

Esegui questo comando:

curl -X GET \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

"https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT/locations/LOCATION/models/MODEL_ID/evaluations/EVALUATION_ID/slices"

PowerShell

Esegui questo comando:

$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred" }

Invoke-WebRequest `

-Method GET `

-Headers $headers `

-Uri "https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT/locations/LOCATION/models/MODEL_ID/evaluations/EVALUATION_ID/slices" | Select-Object -Expand Content

Dovresti ricevere una risposta JSON simile alla seguente:

Java

Prima di provare questo esempio, segui le istruzioni di configurazione di Java nella guida rapida di Vertex AI per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API Vertex AI Java.

Per autenticarti in Vertex AI, configura le Credenziali predefinite dell'applicazione. Per ulteriori informazioni, consulta Configura l'autenticazione per un ambiente di sviluppo locale.

Node.js

Prima di provare questo esempio, segui le istruzioni di configurazione di Node.js nella guida rapida di Vertex AI per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API Vertex AI Node.js.

Per autenticarti in Vertex AI, configura le Credenziali predefinite dell'applicazione. Per ulteriori informazioni, consulta Configura l'autenticazione per un ambiente di sviluppo locale.

Python

Per scoprire come installare o aggiornare l'SDK Vertex AI Python, consulta Installare l'SDK Vertex AI Python. Per saperne di più, consulta la documentazione di riferimento dell'API Python.

Visualizzare le metriche per una singola sezione

Per visualizzare le metriche di valutazione per una singola sezione, utilizza il metodo

projects.locations.models.evaluations.slices.get. Devi disporre dell'ID slice, che viene fornito quando elenco di tutte le slice. Il seguente esempio si applica a tutti i tipi di dati e

obiettivi.

REST

Prima di utilizzare i dati della richiesta, apporta le seguenti sostituzioni:

- LOCATION: la regione in cui si trova il modello. Ad esempio, us-central1.

- PROJECT: .

- MODEL_ID: l'ID del modello.

- EVALUATION_ID: l'ID della valutazione del modello che contiene la fetta di valutazione da recuperare.

- SLICE_ID: l'ID di una sezione di valutazione da recuperare.

- PROJECT_NUMBER: il numero di progetto generato automaticamente per il tuo progetto.

- EVALUATION_METRIC_SCHEMA_FILE_NAME: il nome di un file di schema

che definisce le metriche di valutazione da restituire, ad esempio

classification_metrics_1.0.0.

Metodo HTTP e URL:

GET https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT/locations/LOCATION/models/MODEL_ID/evaluations/EVALUATION_ID/slices/SLICE_ID

Per inviare la richiesta, scegli una di queste opzioni:

curl

Esegui questo comando:

curl -X GET \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

"https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT/locations/LOCATION/models/MODEL_ID/evaluations/EVALUATION_ID/slices/SLICE_ID"

PowerShell

Esegui questo comando:

$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred" }

Invoke-WebRequest `

-Method GET `

-Headers $headers `

-Uri "https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT/locations/LOCATION/models/MODEL_ID/evaluations/EVALUATION_ID/slices/SLICE_ID" | Select-Object -Expand Content

Dovresti ricevere una risposta JSON simile alla seguente:

Java

Prima di provare questo esempio, segui le istruzioni di configurazione di Java nella guida rapida di Vertex AI per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API Vertex AI Java.

Per autenticarti in Vertex AI, configura le Credenziali predefinite dell'applicazione. Per ulteriori informazioni, consulta Configura l'autenticazione per un ambiente di sviluppo locale.

Node.js

Prima di provare questo esempio, segui le istruzioni di configurazione di Node.js nella guida rapida di Vertex AI per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API Vertex AI Node.js.

Per autenticarti in Vertex AI, configura le Credenziali predefinite dell'applicazione. Per ulteriori informazioni, consulta Configura l'autenticazione per un ambiente di sviluppo locale.

Python

Per scoprire come installare o aggiornare l'SDK Vertex AI Python, consulta Installare l'SDK Vertex AI Python. Per saperne di più, consulta la documentazione di riferimento dell'API Python.

Metriche di valutazione del modello

Vertex AI restituisce diverse metriche di valutazione, come precisione, richiamo e soglie di confidenza. Le metriche restituite da Vertex AI dipendono dall'obiettivo del modello. Ad esempio, Vertex AI fornisce metriche di valutazione diverse per un modello di classificazione delle immagini rispetto a un modello di rilevamento di oggetti immagine.

Un file schema determina quali metriche di valutazione fornisce Vertex AI per ogni obiettivo.

Puoi visualizzare e scaricare i file di schema dalla seguente posizione di Cloud Storage:

gs://google-cloud-aiplatform/schema/modelevaluation/

Le metriche di valutazione sono:

Classificazione

- AuPRC: l'area sotto la curva di precisione-richiamo (PR), chiamata anche precisione media. Il valore va da zero a uno, dove un valore più elevato indica un modello di qualità superiore.

- AuROC: l'area sotto la curva della caratteristica operativa del ricevitore. Il valore varia in un intervallo da zero a uno, dove un valore più elevato indica un modello di qualità superiore.

- Perdita logaritmica: l'entropia incrociata tra le inferenze del modello e i valori target. L'intervallo va da zero a infinito, dove un valore più basso indica un modello di qualità superiore.

- Soglia di confidenza: un punteggio di confidenza che determina quali inferenze restituire. Un modello restituisce inferenze che hanno questo valore o superiore. Una soglia di confidenza più alta aumenta la precisione, ma riduce il richiamo. Vertex AI restituisce metriche di confidenza a diversi valori di soglia per mostrare l'impatto della soglia su precisione e richiamo.

- Richiamo: la frazione di inferenze con questa classe che il modello ha previsto correttamente. Chiamata anche percentuale di veri positivi.

- Richiamo a 1: il richiamo (tasso di veri positivi) quando si considera solo l'etichetta con il punteggio di inferenza più alto e non inferiore alla soglia di confidenza per ogni esempio.

- Precisione: la frazione delle inferenze di classificazione prodotte dal modello che sono risultate corrette.

- Precisione a 1: la precisione quando si considera solo l'etichetta con il punteggio di inferenza più alto e non inferiore alla soglia di confidenza per ogni esempio.

- Punteggio F1: la media armonica di precisione e richiamo. F1 è una metrica utile per trovare un equilibrio tra precisione e richiamo qualora esista una distribuzione non uniforme delle classi.

- Punteggio F1 a 1: la media armonica di richiamo a 1 e precisione a 1.

- Conteggio dei veri negativi: il numero di volte in cui un modello ha previsto correttamente una classe negativa.

- Conteggio dei veri positivi: il numero di volte in cui un modello ha previsto correttamente una classe positiva.

- Conteggio falsi negativi: il numero di volte in cui un modello ha previsto erroneamente una classe negativa.

- Conteggio falsi positivi: il numero di volte in cui un modello ha previsto erroneamente una classe positiva.

- Tasso di falsi positivi: la frazione di risultati previsti in modo errato sul totale dei risultati previsti.

- Tasso di falsi positivi a 1: il tasso di falsi positivi quando viene presa in considerazione solo l'etichetta con il punteggio di inferenza più alto e non inferiore alla soglia di confidenza per ogni esempio.

- Matrice di confusione: una matrice di confusione mostra la frequenza con cui un modello ha previsto correttamente un risultato. Per i risultati previsti in modo errato, la matrice mostra la previsione del modello. La matrice di confusione ti aiuta a capire dove il modello "confonde" due risultati.

- Attribuzioni delle caratteristiche del modello: Vertex AI mostra l'impatto di ciascuna caratteristica su un modello. I valori sono forniti sotto forma percentuale per ogni caratteristica: più alta è la percentuale, maggiore è l'impatto della caratteristica sull'addestramento del modello. Esamina queste informazioni per assicurarti che tutte le caratteristiche più importanti abbiano senso per i dati in uso e per il problema aziendale. Per saperne di più, consulta Attribuzioni delle funzionalità per la classificazione e la regressione.

Regressione

- MAE: l'errore medio assoluto (MAE) indica la differenza media assoluta tra i valori target e quelli previsti. Questa metrica va da zero a infinito e un valore inferiore corrisponde a un modello di qualità superiore.

- RMSE: l'errore quadratico medio è la radice quadrata della media della differenza quadratica tra i valori di destinazione e quelli previsti. L'RMSE è più sensibile agli outlier rispetto al MAE. Di conseguenza,se la preoccupazione principale riguarda gli errori di grande entità, l'RMSE può essere una metrica più utile da valutare. Analogamente al MAE, un valore minore indica un modello di qualità migliore (0 rappresenta un predittore perfetto).

- RMSLE: la metrica dell'errore logaritmico quadratico medio è simile all'RMSE, tranne per il fatto che utilizza il logaritmo naturale dei valori previsti ed effettivi più 1. L'RMSLE penalizza maggiormente la sottoinferenza rispetto alla sovrainferenza. Può essere una buona metrica anche nel caso in cui non si voglia penalizzare più pesantemente le differenze per i valori di inferenza elevati rispetto a quelli ridotti. Questa metrica varia da zero a infinito e un valore inferiore indica un modello di qualità superiore. La metrica di valutazione RMSLE viene restituita solo se tutti i valori previsti e tutte le etichette sono non negativi.

- r^2: r al quadrato (r^2) è il quadrato del coefficiente di correlazione Pearson tra le etichette e i valori previsti. Questa metrica va da zero a uno. Un valore più alto indica una maggiore aderenza alla retta di regressione.

-

MAPE: l'errore percentuale assoluto medio (MAPE, Mean Absolute Percentage Error) corrisponde alla differenza percentuale media assoluta tra le etichette e i valori previsti. Questa metrica

va da zero a infinito, dove un valore più basso indica un modello di qualità

migliore.

Se la colonna target contiene valori zero, il MAPE non viene mostrato. In questo caso, il MAPE non è definito. - Attribuzioni delle caratteristiche del modello: Vertex AI mostra l'impatto di ciascuna caratteristica su un modello. I valori sono forniti sotto forma percentuale per ogni caratteristica: più alta è la percentuale, maggiore è l'impatto della caratteristica sull'addestramento del modello. Esamina queste informazioni per assicurarti che tutte le caratteristiche più importanti abbiano senso per i dati in uso e per il problema aziendale. Per saperne di più, consulta Attribuzioni delle funzionalità per la classificazione e la regressione.

Passaggi successivi

Quando è tutto pronto per fare previsioni con il modello di classificazione o regressione, hai due opzioni:

- Fare previsioni online (in tempo reale) utilizzando il modello.

- Ottieni previsioni batch direttamente dal modello.

Inoltre, puoi:

- Visualizza l'architettura del modello.

- Scopri come esportare il modello.