Este tópico explica como configurar uma implementação em várias regiões para o Apigee hybrid no Microsoft® Azure Kubernetes Service (AKS).

As topologias para a implementação multirregional incluem o seguinte:

- Ativo-ativo: quando tem aplicações implementadas em várias localizações geográficas e precisa de uma resposta da API com baixa latência para as suas implementações. Tem a opção de implementar a solução híbrida em várias localizações geográficas mais próximas dos seus clientes. Por exemplo: Costa Oeste dos EUA, Costa Leste dos EUA, Europa, APAC.

- Ativo-passivo: quando tem uma região principal e uma região de recuperação de desastres ou de comutação por falha.

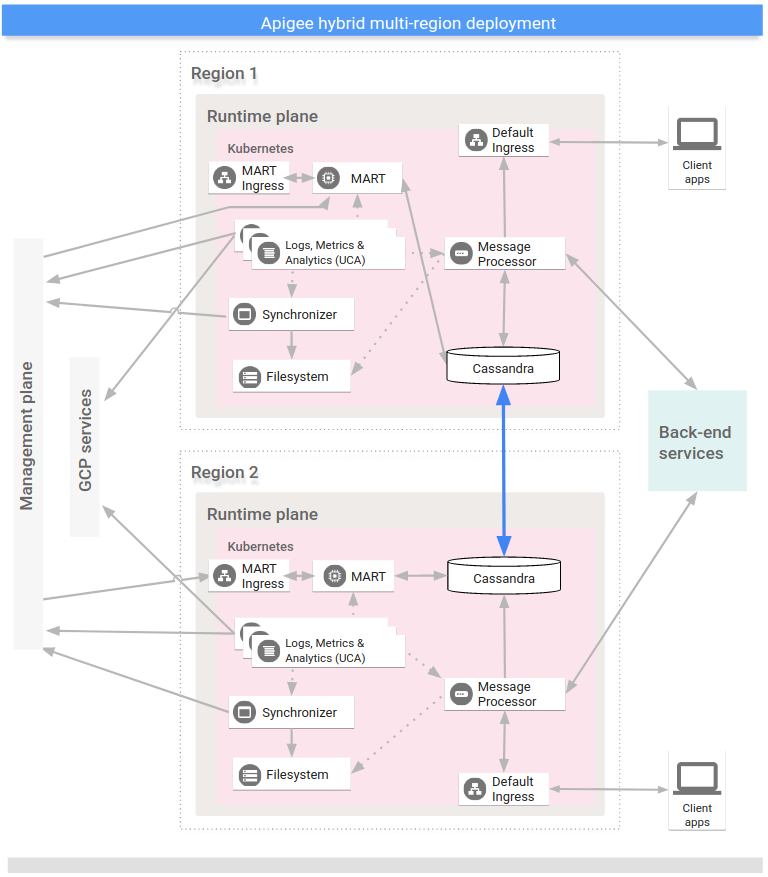

As regiões numa implementação híbrida de várias regiões comunicam através do Cassandra, conforme mostra a imagem seguinte:

Pré-requisitos

Antes de configurar o modo híbrido para várias regiões, tem de concluir os seguintes pré-requisitos:

- Siga o guia de instalação híbridapara ver os pré-requisitos, como o GCP e a configuração da organização , antes de avançar para os passos de configuração do cluster.

Para obter informações detalhadas, consulte a documentação do Kubernetes.

Crie uma rede virtual em cada região

Crie uma rede virtual para a implementação multirregional. Por exemplo, os comandos de exemplo seguintes criam redes nas regiões Central dos EUA e Leste dos EUA.

Execute este comando para criar uma rede virtual na região Eastern US, com o nome my-hybrid-rg-vnet:

az network vnet create \ --name my-hybrid-rg-vnet \ --location eastus \ --resource-group my-hybrid-rg \ --address-prefixes 120.38.1.0/24 \ --subnet-name my-hybrid-rg-vnet-subnet \ --subnet-prefix 120.38.1.0/26

Execute este comando para criar uma rede virtual na região Central dos EUA com o nome my-hybrid-rg-vnet-ext01:

az network vnet create \ --name my-hybrid-rg-vnet-ext01 \ --location centralus \ --resource-group my-hybrid-rg \ --address-prefixes 192.138.0.0/24 \ --subnet-name my-hybrid-rg-vnet-ext01-subnet \ --subnet-prefix 192.138.0.0/26

Crie o intercâmbio de rede

Crie um intercâmbio de rede entre as redes virtuais.

Obtenha os IDs de rede virtuais

As interligações são estabelecidas entre IDs de redes virtuais. Obtenha o ID de cada rede virtual com o comando az network vnet show e armazene o ID numa variável.

Obtenha o ID da primeira rede virtual, a que tem o nome my-hybrid-rg-vnet:

vNet1Id=$(az network vnet show \ --resource-group my-hybrid-rg \ --name my-hybrid-rg-vnet \ --query id --out tsv)

Obtenha o ID da segunda rede virtual, a que tem o nome my-hybrid-rg-vnet-ext01:

vNet2Id=$(az network vnet show \ --resource-group my-hybrid-rg \ --name my-hybrid-rg-vnet-ext01 \ --query id \ --out tsv)

Crie uma interligação entre a primeira e a segunda rede virtual

Com os IDs de rede virtual, pode criar uma interligação a partir da primeira rede virtual (my-hybrid-rg-vnet) para a segunda (my-hybrid-rg-vnet-ext01), conforme mostrado nos exemplos seguintes:

az network vnet peering create \ --name my-hybrid-rg-vnet1-peering \ # The name of the virtual network peering. --resource-group my-hybrid-rg \ --vnet-name my-hybrid-rg-vnet \ # The virtual network name. --remote-vnet $vNet2Id \ # Resource ID of the remote virtual network. --allow-vnet-access

No resultado do comando, repare que o peeringState é Initiated.

A interligação permanece no estado Iniciado até criar a interligação da segunda rede virtual para a primeira.

{

...

"peeringState": "Initiated",

...

}

Crie uma interligação da segunda rede virtual para a primeira

Exemplo de comando:

az network vnet peering create \ --name my-hybrid-rg-vnet2-peering \ # The name of the virtual network peering. --resource-group my-hybrid-rg \ --vnet-name my-hybrid-rg-vnet-ext01 \ # The virtual network name. --remote-vnet $vNet1Id \ # Resource ID of the remote virtual network. --allow-vnet-access

Na saída do comando, repare que peeringState está Ligado. O Azure também altera o estado de peering do primeiro para o segundo peering de rede virtual para Ligado.

{

...

"peeringState": "Connected",

...

}

Também pode confirmar que o estado de peering de my-hybrid-rg-vnet1-peering para

my-hybrid-rg-vnet2-peering:

mudou para Ligado com o seguinte comando:

az network vnet peering show \ --name my-hybrid-rg-vnet1-peering \ --resource-group my-hybrid-rg \ --vnet-name my-hybrid-rg-vnet \ --query peeringState

Resultado esperado:

Connected

Crie clusters multirregionais

Configure clusters do Kubernetes em várias regiões com diferentes blocos CIDR. Consulte também o início rápido do AKS. Use os nomes das localizações e das redes virtuais que criou anteriormente.

Abra as portas 7000 e 7001 do Cassandra entre clusters do Kubernetes em todas as regiões (7000 pode ser usado como uma opção de cópia de segurança durante a resolução de problemas)

Configure o anfitrião de origem multirregião

Esta secção descreve como expandir o cluster do Cassandra existente para uma nova região. Esta configuração permite que a nova região inicialize o cluster e se junte ao centro de dados existente. Sem esta configuração, os clusters Kubernetes multirregionais não se reconheceriam.

- Defina o contexto do kubectl para o cluster original antes de obter o nome da semente:

kubectl config use-context original-cluster-name

Execute o seguinte comando

kubectlpara identificar um endereço de anfitrião inicial para o Cassandra na região atual.Um endereço de anfitrião inicial permite que uma nova instância regional encontre o cluster original no primeiro arranque para saber a topologia do cluster. O endereço do anfitrião inicial é designado como o ponto de contacto no cluster.

kubectl get pods -o wide -n apigee | grep apigee-cassandra apigee-cassandra-0 1/1 Running 0 4d17h 120.38.1.9 aks-agentpool-21207753-vmss000000

- Decida qual dos IPs devolvidos pelo comando anterior vai ser o anfitrião

principal de várias regiões. Neste exemplo, em que apenas está em execução um cluster cassandra de nó único, o anfitrião de sementes é

120.38.1.9. - No centro de dados 2, copie o ficheiro de substituições para um novo ficheiro cujo nome inclua o nome do cluster. Por exemplo,

overrides_your_cluster_name.yaml. - No centro de dados 2, configure

cassandra.multiRegionSeedHostecassandra.datacenteremoverrides_your_cluster_name.yaml, ondemultiRegionSeedHosté um dos IPs devolvidos pelo comando anterior:cassandra: multiRegionSeedHost: seed_host_IP datacenter: data_center_name rack: rack_name

Por exemplo:

cassandra: multiRegionSeedHost: 120.38.1.9 datacenter: "centralus" rack: "ra-1"

- No novo centro de dados/região, antes de instalar o híbrido, defina os mesmos certificados TLS e

credenciais em

overrides_your_cluster_name.yamlque definiu na primeira região.

Configure a nova região

Depois de configurar o anfitrião inicial, pode configurar a nova região.

Para configurar a nova região:

- Copie o certificado do cluster existente para o novo cluster. A nova raiz da AC é usada pelo Cassandra e outros componentes híbridos para mTLS. Por conseguinte, é essencial ter

certificados consistentes no cluster.

- Defina o contexto para o espaço de nomes original:

kubectl config use-context original-cluster-name

- Exporte a configuração do espaço de nomes atual para um ficheiro:

$ kubectl get namespace

-o yaml > apigee-namespace.yaml - Exporte o segredo

apigee-capara um ficheiro:kubectl -n cert-manager get secret apigee-ca -o yaml > apigee-ca.yaml

- Defina o contexto para o nome do cluster da nova região:

kubectl config use-context new-cluster-name

- Importe a configuração do espaço de nomes para o novo cluster.

Certifique-se de que atualiza o "espaço de nomes" no ficheiro se estiver a usar um espaço de nomes diferente na nova região:

kubectl apply -f apigee-namespace.yaml

Importe o segredo para o novo cluster:

kubectl -n cert-manager apply -f apigee-ca.yaml

- Defina o contexto para o espaço de nomes original:

- Instale o híbrido na nova região. Certifique-se de que o ficheiro

overrides_your_cluster_name.yamlinclui os mesmos certificados TLS que estão configurados na primeira região, conforme explicado na secção anterior.Execute os dois comandos seguintes para instalar o híbrido na nova região:

apigeectl init -f overrides_your_cluster_name.yaml

apigeectl apply -f overrides_your_cluster_name.yaml

Expanda todos os espaços de chaves do Apigee.

Os passos seguintes expandem os dados do Cassandra para o novo centro de dados:

- Abra uma shell no pod do Cassandra:

kubectl run -i --tty --restart=Never --rm --image google/apigee-hybrid-cassandra-client:1.0.0 cqlsh

- Estabeleça ligação ao servidor Cassandra:

cqlsh apigee-cassandra-0.apigee-cassandra.apigee.svc.cluster.local -u ddl_user --ssl Password: Connected to apigeecluster at apigee-cassandra-0.apigee-cassandra.apigee.svc.cluster.local:9042. [cqlsh 5.0.1 | Cassandra 3.11.3 | CQL spec 3.4.4 | Native protocol v4] Use HELP for help.

- Obtenha os espaços de chaves disponíveis:

SELECT * from system_schema.keyspaces ; keyspace_name | durable_writes | replication ----------------------------+----------------+-------------------------------------------------------------------------------------------------------- system_auth | True | {'class': 'org.apache.cassandra.locator.NetworkTopologyStrategy', 'dc-1': '1', 'dc-2': '1'} system_schema | True | {'class': 'org.apache.cassandra.locator.LocalStrategy'} cache_hybrid_test_7_hybrid | True | {'class': 'org.apache.cassandra.locator.NetworkTopologyStrategy', 'dc-1': '3'} kms_hybrid_test_7_hybrid | True | {'class': 'org.apache.cassandra.locator.NetworkTopologyStrategy', 'dc-1': '3'} kvm_hybrid_test_7_hybrid | True | {'class': 'org.apache.cassandra.locator.NetworkTopologyStrategy', 'dc-1': '3'} system_distributed | True | {'class': 'org.apache.cassandra.locator.NetworkTopologyStrategy', 'dc-1': '1', 'dc-2': '1'} system | True | {'class': 'org.apache.cassandra.locator.LocalStrategy'} perses | True | {'class': 'org.apache.cassandra.locator.NetworkTopologyStrategy', 'dc-1': '3'} quota_hybrid_test_7_hybrid | True | {'class': 'org.apache.cassandra.locator.NetworkTopologyStrategy', 'dc-1': '3'} system_traces | True | {'class': 'org.apache.cassandra.locator.NetworkTopologyStrategy', 'dc-1': '1', 'dc-2': '1'} (10 rows) - Atualize/expanda os espaços de chaves do Apigee:

ALTER KEYSPACE cache_hybrid_test_7_hybrid WITH replication = {'class': 'NetworkTopologyStrategy', 'dc-1':3, 'dc-2':3};ALTER KEYSPACE kms_hybrid_test_7_hybrid WITH replication = {'class': 'NetworkTopologyStrategy', 'dc-1':3, 'dc-2':3};ALTER KEYSPACE kvm_hybrid_test_7_hybrid WITH replication = {'class': 'NetworkTopologyStrategy', 'dc-1':3, 'dc-2':3};ALTER KEYSPACE perses WITH replication = {'class': 'NetworkTopologyStrategy', 'dc-1':3, 'dc-2':3};ALTER KEYSPACE quota_hybrid_test_7_hybrid WITH replication = {'class': 'NetworkTopologyStrategy', 'dc-1':3, 'dc-2':3}; - Valide a expansão do espaço de chaves:

SELECT * from system_schema.keyspaces ; keyspace_name | durable_writes | replication ----------------------------+----------------+-------------------------------------------------------------------------------------------------------- system_auth | True | {'class': 'org.apache.cassandra.locator.NetworkTopologyStrategy', 'dc-1': '1', 'dc-2': '1'} system_schema | True | {'class': 'org.apache.cassandra.locator.LocalStrategy'} cache_hybrid_test_7_hybrid | True | {'class': 'org.apache.cassandra.locator.NetworkTopologyStrategy', 'dc-1': '3', 'dc-2': '3'} kms_hybrid_test_7_hybrid | True | {'class': 'org.apache.cassandra.locator.NetworkTopologyStrategy', 'dc-1': '3', 'dc-2': '3'} kvm_hybrid_test_7_hybrid | True | {'class': 'org.apache.cassandra.locator.NetworkTopologyStrategy', 'dc-1': '3', 'dc-2': '3'} system_distributed | True | {'class': 'org.apache.cassandra.locator.NetworkTopologyStrategy', 'dc-1': '1', 'dc-2': '1'} system | True | {'class': 'org.apache.cassandra.locator.LocalStrategy'} perses | True | {'class': 'org.apache.cassandra.locator.NetworkTopologyStrategy', 'dc-1': '3', 'dc-2': '3'} quota_hybrid_test_7_hybrid | True | {'class': 'org.apache.cassandra.locator.NetworkTopologyStrategy', 'dc-1': '3', 'dc-2': '3'} system_traces | True | {'class': 'org.apache.cassandra.locator.NetworkTopologyStrategy', 'dc-1': '1', 'dc-2': '1'} (10 rows) ddl@cqlsh>

- Abra uma shell no pod do Cassandra:

- Executar

nodetool rebuildsequencialmente em todos os nós no novo centro de dados. Este processo pode demorar alguns minutos a algumas horas, consoante o tamanho dos dados.kubectl exec apigee-cassandra-0 -n apigee -- nodetool rebuild -- dc-1

- Valide os processos de reconstrução a partir dos registos. Além disso, valide o tamanho dos dados

com o comando

nodetool status:kubectl logs apigee-cassandra-0 -f -n apigee

O exemplo seguinte mostra entradas de registo de exemplo:

INFO 01:42:24 rebuild from dc: dc-1, (All keyspaces), (All tokens) INFO 01:42:24 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889] Executing streaming plan for Rebuild INFO 01:42:24 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889] Starting streaming to /10.12.1.45 INFO 01:42:25 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889, ID#0] Beginning stream session with /10.12.1.45 INFO 01:42:25 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889] Starting streaming to /10.12.4.36 INFO 01:42:25 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889 ID#0] Prepare completed. Receiving 1 files(0.432KiB), sending 0 files(0.000KiB) INFO 01:42:25 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889] Session with /10.12.1.45 is complete INFO 01:42:25 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889, ID#0] Beginning stream session with /10.12.4.36 INFO 01:42:25 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889] Starting streaming to /10.12.5.22 INFO 01:42:26 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889 ID#0] Prepare completed. Receiving 1 files(0.693KiB), sending 0 files(0.000KiB) INFO 01:42:26 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889] Session with /10.12.4.36 is complete INFO 01:42:26 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889, ID#0] Beginning stream session with /10.12.5.22 INFO 01:42:26 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889 ID#0] Prepare completed. Receiving 3 files(0.720KiB), sending 0 files(0.000KiB) INFO 01:42:26 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889] Session with /10.12.5.22 is complete INFO 01:42:26 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889] All sessions completed

- Atualize os anfitriões iniciais. Remova

multiRegionSeedHost: 10.0.0.11deoverrides-DC_name.yamle volte a aplicar.apigeectl apply -f overrides-DC_name.yaml