Introducción

En esta página, se proporciona una breve descripción general conceptual de los métodos de atribución de atributos disponibles con Vertex AI. Para obtener un análisis técnico detallado, consulta nuestro Informe sobre AI Explanations.

La importancia de los atributos globales (atribuciones de atributos del modelo) muestra cómo cada atributo afecta a un modelo. Los valores se proporcionan como un porcentaje para cada atributo: cuanto más alto sea el porcentaje, más impacto tendrá el atributo en el entrenamiento del modelo. Para ver la importancia global de los atributos en tu modelo, examina las métricas de evaluación.

Las atribuciones de atributos locales para los modelos de series temporales indican cuánto contribuyó cada atributo de los datos al resultado previsto. Usa esta información para verificar que el modelo se comporta según lo previsto, reconocer sesgos en los modelos y obtener ideas que te permitan mejorar el modelo y los datos de entrenamiento. Cuando solicitas inferencias, obtienes valores predichos según corresponda para tu modelo. Cuando solicitas explicaciones, obtienes las inferencias junto con la información de atribución de atributos.

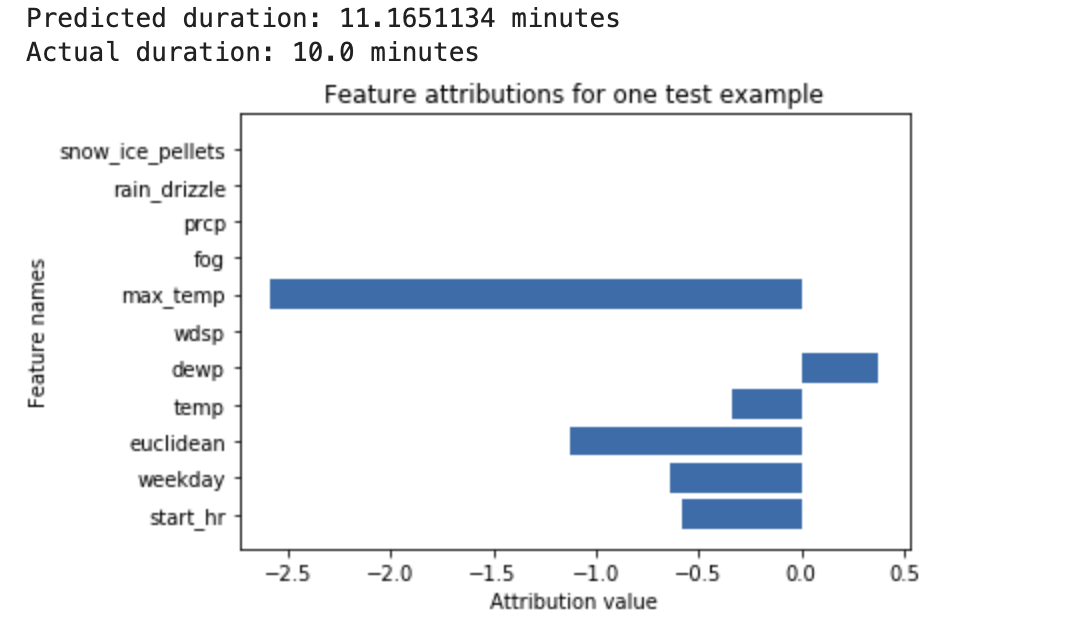

Considera el siguiente ejemplo: Una red neuronal profunda está entrenada para predecir la duración de un viaje en bicicleta, según los datos del clima y los datos compartidos de viajes anteriores. Si solo solicitas inferencias de este modelo, obtendrás predicciones de la duración de los viajes en bicicleta en minutos. Si solicitas explicaciones, obtendrás la duración prevista del viaje en bicicleta, y una puntuación de atribución relativa a cada atributo de la solicitud de explicaciones. Las puntuaciones de atribución muestran cuánto influyó el atributo en el cambio del valor de la inferencia, en relación con el valor del modelo de referencia que especificaste. Elige un modelo de referencia que sea relevante para el modelo (en este caso, la duración media del viaje en bicicleta).

Puedes trazar la puntuación de atribución de atributos para ver cuáles son los atributos que más contribuyeron a la inferencia resultante:

Genera y consulta atribuciones de atributos locales cuando realices un trabajo de inferencia en línea o de inferencia por lotes.

Ventajas

Si inspeccionas instancias específicas y agregas atribuciones de atributos en el conjunto de datos de entrenamiento, puedes obtener estadísticas más detalladas sobre cómo funciona el modelo. Ten en cuenta las siguientes ventajas:

Depuración de modelos: Las atribuciones de atributos pueden ayudar a detectar problemas en los datos que las técnicas de evaluación de modelos estándar suelen pasar por alto.

Optimización de modelos: Puedes identificar y quitar atributos que sean menos importantes, lo que puede generar modelos más eficaces.

Limitaciones conceptuales

Ten en cuenta las siguientes limitaciones de las atribuciones de atributos:

Las atribuciones de atributos, incluida la importancia de los atributos locales para AutoML, son específicas de las inferencias individuales. Si inspeccionas una atribución de atributos para una inferencia individual, puedes obtener una buena estadística, aunque es posible que esta no se aplique a toda la clase de esa instancia individual ni a todo el modelo.

Para obtener estadísticas más generalizadas de los modelos de AutoML, consulta la importancia de los atributos del modelo. A fin de obtener estadísticas más generalizables sobre otros modelos, agrega las atribuciones sobre subconjuntos en el conjunto de datos o en todo el conjunto de datos.

Cada atribución solo muestra en qué medida el atributo afectó la inferencia para ese ejemplo en particular. Es posible que una sola atribución no refleje el comportamiento general del modelo. Para comprender el comportamiento aproximado del modelo en un conjunto de datos completo, agrega las atribuciones a todo el conjunto de datos.

Aunque las atribuciones de atributos pueden ayudar con la depuración de modelos, no siempre indican con claridad si un problema surge del modelo o de los datos con los que se entrena el modelo. Usa tu mejor criterio y diagnostica problemas de datos comunes para reducir el rango de causas posibles.

Las atribuciones dependen en su totalidad del modelo y de los datos que se usan para entrenar el modelo. Solo pueden revelar los patrones que el modelo encontró en los datos y no pueden detectar ninguna relación fundamental en estos. La presencia o ausencia de una atribución sólida en una función determinada no significa que exista o no una relación entre dicha función y el objetivo. La atribución solo muestra que el modelo usa o no la característica en sus inferencias.

Las atribuciones por sí solas no pueden determinar si el modelo es equitativo, imparcial o de buena calidad. Evalúa con cuidado los datos de entrenamiento y las métricas de evaluación, además de las atribuciones.

Para obtener más información sobre las limitaciones, consulta el Informe sobre AI Explanations.

Mejora las atribuciones de funciones

Los siguientes factores tienen el mayor impacto en las atribuciones de funciones:

- Los métodos de atribución se aproximan al valor de Shapley. Para aumentar la precisión de la aproximación, aumenta la cantidad de rutas del método de Shapley con muestreo. Como resultado, las atribuciones podrían cambiar de forma significativa.

- Las atribuciones solo indican en qué medida la función afectó el cambio en el valor de inferencia, en relación con el valor del modelo de referencia. Asegúrate de elegir un modelo de referencia significativo, pertinente a la pregunta que haces sobre el modelo. Los valores de atribución y su interpretación pueden cambiar de forma significativa a medida que cambias de modelo de referencia.

Algoritmo

Vertex AI proporciona atribuciones de funciones mediante Valores de Shapley, un algoritmo cooperativo de teoría de juegos que asigna crédito a cada jugador para obtener un resultado en particular. Cuando se aplica a los modelos de aprendizaje automático, cada atributo del modelo se considera un “jugador” del juego y se asigna crédito en proporción al resultado de una inferencia en particular. Para los modelos de datos estructurados, Vertex AI usa una aproximación de muestreo de los valores exactos de Shapley llamados Shapley con muestreo.

Para obtener información detallada sobre cómo funciona el método de Shapley de muestra, lee el documento Cómo limitar el error de estimación de la aproximación de valores de Shapley basada en la muestra.

¿Qué sigue?

Los siguientes recursos proporcionan material educativo más útil: