您可以使用 Google Cloud 控制台或 Python 適用的 Vertex AI SDK,將 pipeline 執行作業新增至實驗或實驗執行作業。

Google Cloud 控制台

請按照下列操作說明執行 ML 管道,並使用 Google Cloud 控制台將管道與實驗建立關聯,也可以選擇與實驗執行建立關聯。實驗執行作業只能透過 Python 適用的 Vertex AI SDK 建立 (請參閱「建立及管理實驗執行作業」)。- 在 Google Cloud 控制台的 Vertex AI 專區中,前往「Pipelines」頁面。

前往 Pipelines - 在「Region」(區域) 下拉式選單中,選取要建立管道執行的區域。

- 按一下「建立執行作業」,開啟「建立管道執行作業」窗格。

- 指定下列「執行」詳細資料。

- 在「檔案」欄位中,按一下「選擇」開啟檔案選取工具。 找出要執行的已編譯 pipeline JSON 檔案,選取該 pipeline,然後按一下「開啟」。

- 「管道名稱」預設為您在管道定義中指定的名稱。(選用) 指定其他管道名稱。

- 指定執行作業名稱,以便唯一識別這項管道執行作業。

- 如要指定這個管道執行作業使用自訂服務帳戶、客戶管理的加密金鑰或對等互連的虛擬私有雲網路,請按一下「Advanced options」(進階選項) (選用)。

按照下列操作說明設定進階選項,例如自訂服務帳戶。- 如要指定服務帳戶,請從「服務帳戶」下拉式清單中選取服務帳戶。

如果您未指定服務帳戶,Vertex AI Pipelines 會使用預設的 Compute Engine 服務帳戶執行管道。

進一步瞭解如何設定服務帳戶,以便搭配 Vertex AI Pipelines 使用。 - 如要使用客戶自行管理的加密金鑰 (CMEK),請選取「使用客戶自行管理的加密金鑰」。系統會顯示「選取客戶管理的金鑰」下拉式選單。在「Select a customer-managed key」(選取客戶管理的金鑰) 下拉式選單中,選取要使用的金鑰。

- 如要在這個管道執行中使用對等互連的虛擬私有雲網路,請在「對等互連的虛擬私有雲網路」方塊中輸入虛擬私有雲網路名稱。

- 如要指定服務帳戶,請從「服務帳戶」下拉式清單中選取服務帳戶。

- 按一下「繼續」。

系統會顯示「Cloud Storage」位置和「Pipeline parameters」窗格。 - 必要:輸入 Cloud Storage 輸出目錄,例如:gs://location_of_directory。

- 選用:指定要用於這項 pipeline 執行作業的參數。

- 按一下「提交」,建立管道執行作業。

- 提交管道後,管道會顯示在管道的 Google Cloud 控制台 表格中。

- 在與管道相關聯的資料列中,依序點按「 View more」(查看更多) >「Add to Experiment」(新增至實驗)。

- 選取現有實驗或建立新實驗。

- 選用:如果實驗執行作業與實驗相關聯,系統會將其顯示在下拉式選單中。選取現有的實驗執行。

- 按一下 [儲存]。

使用 Google Cloud 控制台比較管道執行作業與實驗執行作業

- 前往 Google Cloud 控制台的「Experiments」頁面。

前往「實驗」。

「實驗」頁面會顯示實驗清單。 - 選取要將管道執行作業加入的實驗。

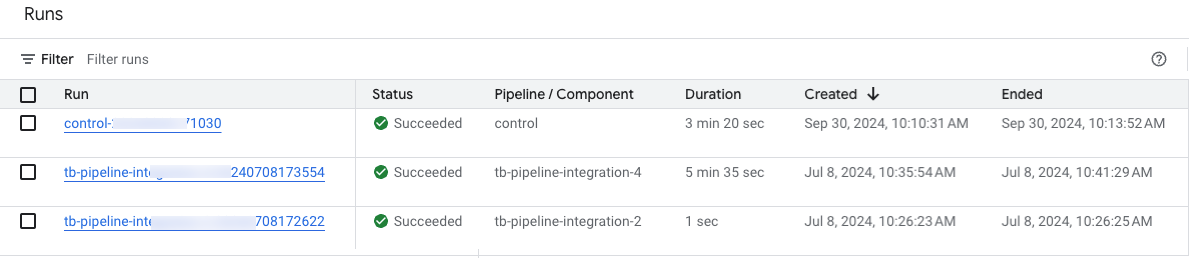

系統會顯示執行作業清單。 - 選取要比較的執行項目,然後按一下「比較」

- 按一下「新增跑步」按鈕。系統會顯示執行作業清單

- 選取要新增的管道執行作業。系統會新增執行作業。

Vertex AI SDK for Python {:#sdk-add-pipeline-run}

下列範例使用 PipelineJob API。

將管道執行作業與實驗建立關聯

這個範例說明如何將管道執行作業與實驗建立關聯。如要比較 Pipeline 執行作業,請將 Pipeline 執行作業與實驗建立關聯。請參閱 Python 適用的 Vertex AI SDK 參考說明文件。init

Python

experiment_name:為實驗命名。 如要查看實驗清單,請在 Google Cloud 控制台中選取區段導覽中的「實驗」。pipeline_job_display_name:這個管道的使用者定義名稱。template_path:PipelineJob 或 PipelineSpec JSON 或 YAML 檔案的路徑。可以是本機路徑或 Cloud Storage URI。 範例:「gs://project.name」pipeline_root:管道輸出的根目錄。預設為暫存 bucket。parameter_values:從執行階段參數名稱到其值的對應,可控制管道執行作業。project:。您可以在 Google Cloud 控制台 歡迎頁面中找到這些 ID。location:請參閱可用位置清單。

將管道執行作業與實驗執行作業建立關聯

提供的範例包括將管道執行作業與實驗執行作業建立關聯。

用途:

- 在進行本機模型訓練,然後對該模型執行評估時 (評估是使用管道完成)。在這種情況下,您會想將管道執行的評估指標寫入 ExperimentRun

- 多次重新執行相同管道時。舉例來說,如果您變更輸入參數,或是某個元件失敗而需要重新執行。

將管道執行作業與實驗執行作業建立關聯時,系統不會自動顯示參數和指標,因此需要使用記錄 API 手動記錄。

注意:如果選用 resume 參數指定為 TRUE,系統會繼續執行先前啟動的作業。如未指定,resume 會預設為 FALSE,並建立新的執行作業。

請參閱 Vertex AI SDK for Python 參考說明文件中的

init、

start_run 和

log。

Python

在 Google Cloud 控制台中查看 pipeline 執行作業清單

在 Google Cloud 控制台的 Vertex AI 專區中,前往「Pipelines」頁面。

請確認您位於正確的專案中。

與專案管道執行相關的實驗和執行清單會分別顯示在「實驗」和「實驗執行」欄中。

程式碼實驗室

-

本程式碼研究室將說明如何使用 Vertex AI 建構管道,在 TensorFlow 中訓練自訂 Keras 模型。Vertex AI Experiments 可追蹤及比較實驗執行作業,找出能產生最佳成效的超參數組合。