Questo articolo fa parte di una serie che illustra il disaster recovery (RE) in Google Cloud. Questa parte descrive il processo di progettazione dei carichi di lavoro utilizzando Google Cloud e i componenti di base resilienti alle interruzioni dell'infrastruttura cloud.

La serie è composta dalle seguenti parti:

- Guida alla pianificazione del ripristino di emergenza

- Componenti di base per il ripristino di emergenza

- Scenari di ripristino di emergenza dei dati

- Scenari di ripristino di emergenza per le applicazioni

- Progettazione ripristino di emergenza per i workload con limitazioni a livello di località

- Casi d'uso di ripristino di emergenza: applicazioni di analisi dei dati con limitazioni di località

- Progettazione del ripristino di emergenza per interruzioni dell'infrastruttura cloud (questo documento)

Introduzione

Man mano che le aziende spostano i carichi di lavoro sul cloud pubblico, devono tradurre la loro comprensione della creazione di sistemi on-premise resilienti nell'infrastruttura iperscalabile di fornitori di servizi cloud come Google Cloud. Questo articolo mappa i concetti standard del settore relativi al ripristino di emergenza, come RTO (Recovery Time Objective) e RPO (Recovery Point Objective), all'infrastruttura Google Cloud.

Le indicazioni contenute in questo documento seguono uno dei principi chiave di Google per ottenere una disponibilità del servizio estremamente elevata: pianificare gli errori. Sebbene Google Cloud offra un servizio estremamente affidabile, i disastri si verificheranno: catastrofi naturali, interruzioni della fibra e guasti complessi e imprevedibili dell'infrastruttura, che causano interruzioni. La pianificazione delle interruzioni consente ai clienti diGoogle Cloud creare applicazioni che funzionano in modo prevedibile durante questi eventi inevitabili, utilizzando prodotti con meccanismi di ripristino di emergenza "integrati" Google Cloud .

Il ripristino di emergenza è un argomento ampio che copre molto più dei semplici guasti all'infrastruttura, come bug software o danneggiamento dei dati, e dovresti avere un piano end-to-end completo. Tuttavia, questo articolo si concentra su una parte di un piano diRER complessivo: come progettare applicazioni resilienti alle interruzioni dell'infrastruttura cloud. Nello specifico, questo articolo illustra:

- L'infrastruttura Google Cloud , come si manifestano gli eventi catastrofici come Google Cloud interruzioni e come Google Cloud è progettato per ridurre al minimo la frequenza e l'ambito delle interruzioni.

- Una guida alla pianificazione dell'architettura che fornisce un framework per classificare e progettare applicazioni in base ai risultati di affidabilità desiderati.

- Un elenco dettagliato di alcuni Google Cloud prodotti che offrono funzionalità di RE integrate che potresti voler utilizzare nella tua applicazione.

Per ulteriori dettagli sulla pianificazione generale RE e sull'utilizzo di Google Cloud come componente della tua strategia diRER on-premise, consulta la Guida alla pianificazione del disaster recovery. Inoltre, sebbene l'alta disponibilità sia un concetto strettamente correlato al ripristino di emergenza, non è trattato in questo articolo. Per ulteriori dettagli sulla progettazione per l'alta disponibilità, consulta il Well-Architected Framework.

Una nota sulla terminologia: questo articolo si riferisce alla disponibilità quando discute della possibilità di accedere e utilizzare in modo significativo un prodotto nel tempo, mentre l'affidabilità si riferisce a un insieme di attributi che includono la disponibilità, ma anche elementi come la durata e la correttezza.

Come Google Cloud è progettato per la resilienza

Data center di Google

I data center tradizionali si basano sulla massimizzazione della disponibilità dei singoli componenti. Nel cloud, la scalabilità consente a operatori come Google di distribuire i servizi su molti componenti utilizzando tecnologie di virtualizzazione e superando così l'affidabilità tradizionale dei componenti. Ciò significa che puoi abbandonare la mentalità dell'architettura di affidabilità che ti preoccupava per i dettagli innumerevoli on-premise. Anziché preoccuparti delle varie modalità di guasto dei componenti, come il raffreddamento e l'alimentazione, puoi pianificare in base ai Google Cloud prodotti e alle relative metriche di affidabilità dichiarate. Queste metriche riflettono il rischio di interruzione aggregato dell'intera infrastruttura sottostante. In questo modo, puoi concentrarti molto di più sulla progettazione, sul deployment e sulle operazioni delle applicazioni anziché sulla gestione dell'infrastruttura.

Google progetta la sua infrastruttura per soddisfare obiettivi di disponibilità aggressivi in base alla nostra vasta esperienza nella creazione e nella gestione di data center moderni. Google è un leader mondiale nella progettazione di data center. Dall'alimentazione al raffreddamento alle reti, ogni tecnologia del data center ha le proprie ridondanze e mitigazioni, inclusi piani FMEA. I data center di Google sono costruiti in modo da bilanciare questi numerosi rischi diversi e presentare ai clienti un livello di disponibilità previsto coerente per i prodotti Google Cloud . Google utilizza la propria esperienza per modellare la disponibilità dell'architettura complessiva del sistema fisico e logico per garantire che la progettazione del data center soddisfi le aspettative. Gli ingegneri di Google si impegnano molto a livello operativo per contribuire a garantire che queste aspettative vengano soddisfatte. La disponibilità effettiva misurata supera normalmente i nostri obiettivi di progettazione di un margine confortevole.

Riassumendo tutti questi rischi e mitigazioni dei data center in prodotti rivolti agli utenti, Google Cloud ti esonera da queste responsabilità di progettazione e operative. Puoi invece concentrarti sull'affidabilità progettata per le regioni e le zoneGoogle Cloud .

Regioni e zone

Le regioni sono aree geografiche indipendenti costituite da zone. Zone e regioni sono astrazioni logiche delle risorse fisiche sottostanti. Per saperne di più sulle considerazioni specifiche per le regioni, consulta Area geografica e regioni.

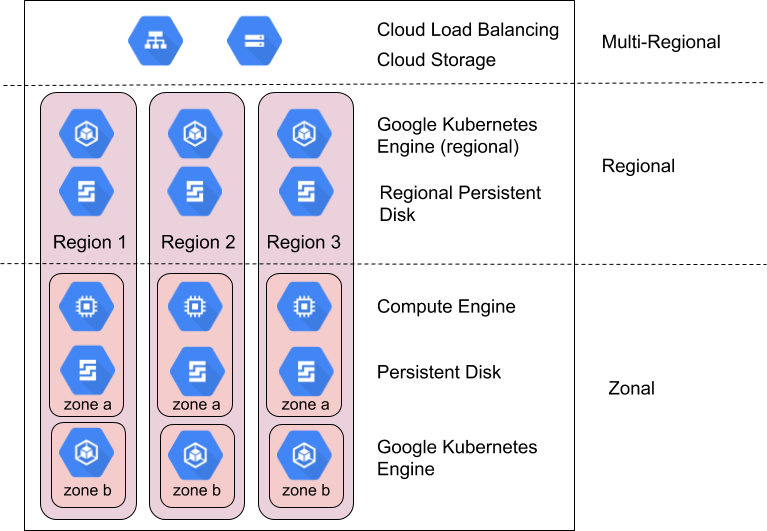

I prodottiGoogle Cloud sono suddivisi in risorse a livello di zona, risorse regionali o risorse multiregionali.

Le risorse di zona sono ospitate all'interno di una singola zona. Un'interruzione del servizio in quella zona può influire su tutte le risorse al suo interno. Ad esempio, un'istanza Compute Engine viene eseguita in una singola zona specificata; se un guasto hardware interrompe il servizio in quella zona, l'istanza Compute Engine non è disponibile per la durata dell'interruzione.

Le risorse regionali vengono distribuite in modo ridondante in più zone all'interno di una regione. Ciò offre loro una maggiore affidabilità rispetto alle risorse di zona.

Le risorse multiregionali sono distribuite all'interno e tra le regioni. In generale, le risorse multiregionali hanno un'affidabilità maggiore rispetto a quelle regionali. Tuttavia, a questo livello i prodotti devono ottimizzare la disponibilità, le prestazioni e l'efficienza delle risorse. Di conseguenza, è importante comprendere i compromessi fatti da ogni prodotto multiregionale che decidi di utilizzare. Questi compromessi sono documentati in base al prodotto più avanti in questo documento.

Come sfruttare zone e regioni per ottenere affidabilità

I tecnici SRE di Google gestiscono e scalano prodotti per utenti globali altamente affidabili come Gmail e la Ricerca attraverso una serie di tecniche e tecnologie che sfruttano in modo ottimale l'infrastruttura di computing in tutto il mondo. Ciò include il reindirizzamento del traffico dalle località non disponibili utilizzando il bilanciamento del carico globale, l'esecuzione di più repliche in molte località in tutto il mondo e la replica dei dati tra le località. Queste stesse funzionalità sono disponibili per i clienti Google Cloud tramite prodotti come Cloud Load Balancing, Google Kubernetes Engine (GKE) e Spanner.

Google Cloud progetta generalmente i prodotti per offrire i seguenti livelli di disponibilità per zone e regioni:

| Risorsa | Esempi | Obiettivo di progettazione della disponibilità | Tempo di inattività implicito |

|---|---|---|---|

| A livello di zona | Compute Engine, Persistent Disk | 99,9% | 8,75 ore / anno |

| Regionale | Cloud Storage regionale, Persistent Disk replicato, GKE regionale | 99,99% | 52 minuti / anno |

Confronta gli obiettivi di progettazione della disponibilità di Google Cloud con il livello di downtime accettabile per identificare le risorse Google Cloud appropriate. Mentre i progetti tradizionali si concentrano sul miglioramento della disponibilità a livello di componente per migliorare la disponibilità dell'applicazione risultante, i modelli cloud si concentrano invece sulla composizione dei componenti per raggiungere questo obiettivo. Molti prodotti all'interno di Google Cloud utilizzano questa tecnica. Ad esempio, Spanner offre un database multiregionale che comprende più regioni per garantire una disponibilità del 99,999%.

La composizione è importante perché, senza di essa, la disponibilità dell'applicazione non può superare quella dei prodotti Google Cloud che utilizzi; infatti, a meno che la tua applicazione non abbia mai esito negativo, avrà una disponibilità inferiore rispetto ai prodotti Google Cloud sottostanti. Il resto di questa sezione mostra in generale come utilizzare una composizione di prodotti zonali e regionali per ottenere una disponibilità delle applicazioni superiore a quella che fornirebbe una singola zona o regione. La sezione successiva fornisce una guida pratica per applicare questi principi alle tue applicazioni.

Pianificazione degli ambiti di interruzione del servizio a livello di zona

Gli errori dell'infrastruttura di solito causano interruzioni del servizio in una singola zona. All'interno di una regione, le zone sono progettate per ridurre al minimo il rischio di errori correlati con altre zone e un'interruzione del servizio in una zona di solito non influisce sul servizio di un'altra zona nella stessa regione. Un'interruzione limitata a una zona non significa necessariamente che l'intera zona non è disponibile, ma definisce solo il confine dell'incidente. È possibile che un'interruzione della zona non abbia effetti tangibili sulle tue risorse specifiche in quella zona.

È un evento più raro, ma è anche fondamentale notare che più zone alla fine subiranno comunque un'interruzione correlata a un certo punto all'interno di una singola regione. Quando si verifica un'interruzione in due o più zone, si applica la strategia di ambito dell'interruzione regionale riportata di seguito.

Le risorse regionali sono progettate per resistere alle interruzioni di zona fornendo il servizio da una composizione di più zone. Se una delle zone che supportano una risorsa di regione viene interrotta, la risorsa si rende automaticamente disponibile da un'altra zona. Per ulteriori dettagli, controlla attentamente la descrizione della funzionalità del prodotto nell'appendice.

Google Cloud offre solo alcune risorse di zona, ovvero macchine virtuali (VM) Compute Engine e Persistent Disk. Se prevedi di utilizzare risorse zonali, dovrai eseguire la composizione delle risorse progettando, creando e testando il failover e il ripristino tra le risorse zonali situate in più zone. Alcune strategie includono:

- Instradamento rapido del traffico alle macchine virtuali in un'altra zona utilizzando Cloud Load Balancing quando un controllo di integrità determina che una zona sta riscontrando problemi.

- Utilizza i modelli di istanza Compute Engine e/o i gruppi di istanze gestite per eseguire e scalare istanze VM identiche in più zone.

- Utilizza un Persistent Disk regionale per replicare in modo sincrono i dati in un'altra zona di una regione. Per ulteriori dettagli, consulta Opzioni di alta affidabilità utilizzando dischi permanenti regionali.

Pianificare gli ambiti di interruzione regionali

Un'interruzione regionale è un'interruzione del servizio che interessa più di una zona in una singola regione. Si tratta di interruzioni su larga scala e meno frequenti, che possono essere causate da catastrofi naturali o guasti su larga scala dell'infrastruttura.

Per un prodotto regionale progettato per fornire una disponibilità del 99,99%, un'interruzione può comunque tradursi in quasi un'ora di inattività per un determinato prodotto ogni anno. Pertanto, le tue applicazioni critiche potrebbero richiedere un piano di RE multiregionale se questa durata dell'interruzione non è accettabile.

Le risorse multiregionali sono progettate per resistere alle interruzioni a livello di regione fornendo il servizio da più regioni. Come descritto sopra, i prodotti multiregionali trovano un compromesso tra latenza, coerenza e costi. Il compromesso più comune riguarda la replica dei dati sincrona e asincrona. La replica asincrona offre una latenza inferiore a costo del rischio di perdita di dati durante un'interruzione. Pertanto, è importante controllare la descrizione delle funzionalità del prodotto nell'appendice per ulteriori dettagli.

Se vuoi utilizzare risorse regionali e rimanere resiliente alle interruzioni regionali, devi eseguire la composizione delle risorse progettando, creando e testando il failover e il ripristino tra le risorse regionali che si trovano in più regioni. Oltre alle strategie zonali descritte sopra, che puoi applicare anche in più regioni, considera:

- Le risorse regionali devono replicare i dati in una regione secondaria, in un'opzione di archiviazione multiregionale come Cloud Storage o in un'opzione di cloud ibrido come GKE Enterprise.

- Dopo aver implementato una mitigazione dell'interruzione regionale, testala regolarmente. Non c'è niente di peggio che pensare di essere resistenti a un'interruzione di una singola regione e scoprire che non è così quando si verifica realmente.

Google Cloud approccio alla resilienza e alla disponibilità

Google Cloud supera regolarmente i target di progettazione della disponibilità, ma non devi presumere che questo solido rendimento passato sia la disponibilità minima che puoi progettare. In alternativa, devi selezionare le dipendenze Google Cloud i cui target "Progettato per" superano l'affidabilità prevista della tua applicazione, in modo che il tempo di inattività della tua applicazione più il tempo di inattività Google Cloud forniscano il risultato che stai cercando.

Un sistema ben progettato può rispondere alla domanda: "Cosa succede quando una zona o regione subisce un'interruzione di 1, 5, 10 o 30 minuti?" Questo aspetto deve essere preso in considerazione a molti livelli, tra cui:

- Cosa sperimenteranno i miei clienti durante un'interruzione?

- Come faccio a rilevare un'interruzione?

- Cosa succede alla mia applicazione durante un'interruzione?

- Cosa succede ai miei dati durante un'interruzione?

- Che cosa succede alle mie altre applicazioni a causa di un'interruzione (dovuta a dipendenze incrociate)?

- Che cosa devo fare per eseguire il recupero dopo la risoluzione di un'interruzione? Chi lo fa?

- Chi devo informare di un'interruzione e entro quale periodo di tempo?

Guida passo passo alla progettazione del ripristino di emergenza per le applicazioni in Google Cloud

Le sezioni precedenti hanno illustrato come Google crea l'infrastruttura cloud e alcuni approcci per gestire le interruzioni zonali e regionali.

Questa sezione ti aiuta a sviluppare un framework per applicare il principio di composizione alle tue applicazioni in base ai risultati di affidabilità che desideri.

Le applicazioni dei clienti in Google Cloud che hanno come target obiettivi di ripristino di emergenza come RTO e RPO devono essere progettate in modo che le operazioni business-critical, soggette a RTO/RPO, abbiano dipendenze solo dai componenti del data plane responsabili dell'elaborazione continua delle operazioni per il servizio. In altre parole, queste operazioni business critical dei clienti non devono dipendere dalle operazioni del management plane, che gestiscono lo stato della configurazione e la inviano al control plane e al data plane.

Ad esempio, Google Cloud i clienti che intendono raggiungere l'RTO per le operazioni business-critical non devono dipendere da un'API di creazione di VM o dall'aggiornamento di un'autorizzazione IAM.

Passaggio 1: raccogli i requisiti esistenti

Il primo passaggio consiste nel definire i requisiti di disponibilità per le tue applicazioni. La maggior parte delle aziende ha già un certo livello di linee guida di progettazione in questo spazio, che possono essere sviluppate internamente o derivare da normative o altri requisiti legali. Queste linee guida di progettazione sono normalmente codificate in due metriche chiave: Recovery Time Objective (RTO) e Recovery Point Objective (RPO). In termini aziendali, RTO si traduce in "Quanto tempo dopo un disastro prima che io sia di nuovo operativo". L'RPO si traduce in "Quanti dati posso permettermi di perdere in caso di disastro".

Storicamente, le aziende hanno definito i requisiti RTO e RPO per un'ampia gamma di eventi di emergenza, dai guasti dei componenti ai terremoti. Ciò aveva senso nel mondo on-premise, in cui i pianificatori dovevano mappare i requisiti RTO/RPO nell'intero stack software e hardware. Nel cloud, non è più necessario definire i requisiti in modo così dettagliato perché se ne occupa il provider. Puoi invece definire i requisiti RTO e RPO in termini di ambito della perdita (intere zone o regioni) senza specificare i motivi sottostanti. Per Google Cloud questo semplifica la raccolta dei requisiti in tre scenari: un'interruzione a livello di zona, un'interruzione a livello di regione o l'interruzione estremamente improbabile di più regioni.

Riconoscendo che non tutte le applicazioni hanno la stessa criticità, la maggior parte dei clienti le classifica in livelli di criticità a cui può essere applicato un requisito RTO/RPO specifico. Se presi insieme, RTO/RPO e criticità dell'applicazione semplificano il processo di progettazione di una determinata applicazione rispondendo a:

- L'applicazione deve essere eseguita in più zone nella stessa regione o in più zone in più regioni?

- Da quali prodotti Google Cloud può dipendere l'applicazione?

Questo è un esempio dell'output dell'esercizio di raccolta dei requisiti:

RTO e RPO per criticità dell'applicazione per l'organizzazione di esempio Co:

| Criticità dell'applicazione | % di app | Esempi di app | Interruzione della zona | Interruzione a livello di regione |

|---|---|---|---|---|

| Livello 1

(più importante) |

5% | In genere applicazioni globali o esterne rivolte ai clienti, come pagamenti in tempo reale e vetrine e-commerce. | RTO Zero

RPO Zero |

RTO Zero

RPO Zero |

| Livello 2 | 35% | In genere applicazioni regionali o applicazioni interne importanti, come CRM o ERP. | RTO 15 minuti

RPO 15 minuti |

RTO 1 ora

RPO 1hr |

| Livello 3

(meno importante) |

60% | In genere applicazioni di team o di reparto, come back office, prenotazione di ferie, viaggi interni, contabilità e RU. | RTO 1 ora

RPO 1hr |

RTO 12 ore

RPO 12 ore |

Passaggio 2: mappatura delle funzionalità ai prodotti disponibili

Il secondo passaggio consiste nel comprendere le funzionalità di resilienza dei prodotti Google Cloud che verranno utilizzati dalle tue applicazioni. La maggior parte delle aziende esamina le informazioni sui prodotti pertinenti e poi aggiunge indicazioni su come modificare le architetture per colmare eventuali lacune tra le funzionalità del prodotto e i requisiti di resilienza. Questa sezione tratta alcune aree comuni e consigli sulle limitazioni di dati e applicazioni in questo spazio.

Come accennato in precedenza, i prodotti di Google con funzionalità di RE sono pensati per due tipi di ambiti di interruzione: regionale e di zona. I disservizi parziali devono essere pianificati allo stesso modo di un disservizio completo in termini diREa. In questo modo si ottiene una matrice iniziale di alto livello dei prodotti adatti a ogni scenario per impostazione predefinita:

Google Cloud Funzionalità generali del prodotto

(vedi l'appendice per le funzionalità specifiche del prodotto)

| Tutti i prodotti Google Cloud | Prodotti Google Cloud regionali con replica automatica tra le zone | Prodotti multiregionali o globali Google Cloud con replica automatica tra le regioni | |

|---|---|---|---|

| Guasto di un componente all'interno di una zona | Coperto* | Con copertura | Con copertura |

| Interruzione della zona | Non inclusi | Con copertura | Con copertura |

| Interruzione a livello di regione | Non inclusi | Non inclusi | Con copertura |

* Tutti Google Cloud i prodotti sono resistenti al guasto dei componenti, tranne in casi specifici indicati nella documentazione del prodotto. In genere, si tratta di scenari in cui il prodotto offre accesso diretto o mappatura statica a un componente hardware speciale come memoria o unità a stato solido (SSD).

In che modo RPO limita le scelte di prodotto

Nella maggior parte delle implementazioni cloud, l'integrità dei dati è l'aspetto architettonico più significativo da considerare per un servizio. Almeno alcune applicazioni hanno un requisito RPO pari a zero, il che significa che non deve verificarsi alcuna perdita di dati in caso di interruzione. In genere, ciò richiede la replica sincrona dei dati in un'altra zona o regione. La replica sincrona presenta compromessi in termini di costi e latenza, pertanto, mentre molti prodotti forniscono la replica sincrona tra zone, solo alcuni la forniscono tra regioni. Google Cloud Questo compromesso tra costi e complessità significa che non è insolito che diversi tipi di dati all'interno di un'applicazione abbiano valori RPO diversi.

Per i dati con un RPO maggiore di zero, le applicazioni possono sfruttare la replica asincrona. La replica asincrona è accettabile quando i dati persi possono essere ricreati facilmente o recuperati da un'origine dati di riferimento se necessario. Può anche essere una scelta ragionevole quando una piccola perdita di dati è un compromesso accettabile nel contesto delle durate previste di interruzione zonale e regionale. È anche importante notare che durante un'interruzione temporanea, i dati scritti nella località interessata ma non ancora replicati in un'altra località generalmente diventano disponibili dopo la risoluzione dell'interruzione. Ciò significa che il rischio di perdita di dati permanente è inferiore al rischio di perdere l'accesso ai dati durante un'interruzione.

Azioni chiave:stabilisci se hai assolutamente bisogno di RPO zero e, in caso affermativo, se puoi farlo per un sottoinsieme dei tuoi dati. In questo modo, aumenterà notevolmente la gamma di servizi abilitati per il RE a tua disposizione. In Google Cloud, ottenere un RPO pari a zero significa utilizzare prevalentemente prodotti regionali per la tua applicazione, che per impostazione predefinita sono resilienti alle interruzioni a livello di zona, ma non a livello di regione.

In che modo i limiti RTO limitano le scelte di prodotto

Uno dei principali vantaggi del cloud computing è la possibilità di eseguire il deployment dell'infrastruttura on demand. Tuttavia, questo non equivale a un deployment istantaneo. Il valore RTO per la tua applicazione deve tenere conto dell'RTO combinato dei prodotti Google Cloud utilizzati dalla tua applicazione e di qualsiasi azione che i tuoi ingegneri o SRE devono intraprendere per riavviare le VM o i componenti dell'applicazione. Un RTO misurato in minuti significa progettare un'applicazione che recuperi automaticamente da un disastro senza intervento umano o con passaggi minimi, ad esempio premendo un pulsante per il failover. Il costo e la complessità di questo tipo di sistema sono sempre stati molto elevati, ma Google Cloud prodotti come i bilanciatori del carico e i gruppi di istanze rendono questo design molto più economico e semplice. Pertanto, devi prendere in considerazione il failover e il ripristino automatici per la maggior parte delle applicazioni. Tieni presente che la progettazione di un sistema per questo tipo di failover attivo tra regioni è complessa e costosa; solo una piccolissima parte dei servizi critici giustifica questa funzionalità.

La maggior parte delle applicazioni avrà un RTO compreso tra un'ora e un giorno, il che consente un failover caldo in uno scenario di emergenza, con alcuni componenti dell'applicazione in esecuzione in modalità standby, come i database, mentre altri vengono scalati in caso di emergenza reale, come i server web. Per queste applicazioni, ti consigliamo vivamente di prendere in considerazione l'automazione per gli eventi di scalabilità orizzontale. I servizi con un RTO superiore a un giorno hanno la criticità più bassa e spesso possono essere recuperati da un backup o ricreati da zero.

Azioni chiave: stabilisci se hai assolutamente bisogno di un RTO pari a (quasi) zero per il failover regionale e, in caso affermativo, se puoi farlo per un sottoinsieme dei tuoi servizi. In questo modo cambiano i costi di esecuzione e manutenzione del servizio.

Passaggio 3: sviluppa le tue architetture di riferimento e guide

Il passaggio finale consigliato è la creazione di pattern di architettura specifici per la tua azienda per aiutare i tuoi team a standardizzare il loro approccio alripristino di emergenzay. La maggior parte dei Google Cloud clienti produce una guida per i propri team di sviluppo che abbina le proprie aspettative individuali di resilienza aziendale alle due principali categorie di scenari di interruzione su Google Cloud. In questo modo, i team possono classificare facilmente i prodotti abilitati al RE adatti a ogni livello di criticità.

Creare linee guida per i prodotti

Se esaminiamo di nuovo la tabella RTO/RPO di esempio riportata sopra, abbiamo una guida ipotetica che elenca i prodotti consentiti per impostazione predefinita per ogni livello di criticità. Tieni presente che, laddove alcuni prodotti sono stati identificati come non adatti per impostazione predefinita, puoi sempre aggiungere i tuoi meccanismi di replica e failover per abilitare la sincronizzazione tra zone o regioni, ma questo esercizio non rientra nell'ambito di questo articolo. Le tabelle contengono anche link a ulteriori informazioni su ciascun prodotto per aiutarti a comprenderne le funzionalità in relazione alla gestione delle interruzioni di zone o regioni.

Modelli di architettura di esempio per l'organizzazione di esempio Co: interruzione della zona - resilienza

| Google Cloud Prodotto | Il prodotto soddisfa i requisiti di interruzione zonale per l'organizzazione di esempio (con la configurazione del prodotto appropriata) | ||

|---|---|---|---|

| Livello 1 | Livello 2 | Livello 3 | |

| Compute Engine | No | No | No |

| Dataflow | No | No | No |

| BigQuery | No | No | Sì |

| GKE | Sì | Sì | Sì |

| Cloud Storage | Sì | Sì | Sì |

| Cloud SQL | No | Sì | Sì |

| Spanner | Sì | Sì | Sì |

| Cloud Load Balancing | Sì | Sì | Sì |

Questa tabella è solo un esempio basato sui livelli ipotetici mostrati sopra.

Modelli di architettura di esempio per la resilienza alle interruzioni regionali dell'organizzazione di esempio Co

| Google Cloud Prodotto | Il prodotto soddisfa i requisiti di interruzione del servizio per regione per l'organizzazione di esempio (con la configurazione del prodotto appropriata) | ||

|---|---|---|---|

| Livello 1 | Livello 2 | Livello 3 | |

| Compute Engine | Sì | Sì | Sì |

| Dataflow | No | No | No |

| BigQuery | No | No | Sì |

| GKE | Sì | Sì | Sì |

| Cloud Storage | No | No | No |

| Cloud SQL | No | Sì | Sì |

| Spanner | Sì | Sì | Sì |

| Cloud Load Balancing | Sì | Sì | Sì |

Questa tabella è solo un esempio basato sui livelli ipotetici mostrati sopra.

Per mostrare come verrebbero utilizzati questi prodotti, le sezioni seguenti descrivono alcune architetture di riferimento per ciascuno dei livelli di criticità ipotetici dell'applicazione. Si tratta di descrizioni di alto livello per illustrare le decisioni architetturali chiave e non sono rappresentative di una progettazione completa della soluzione.

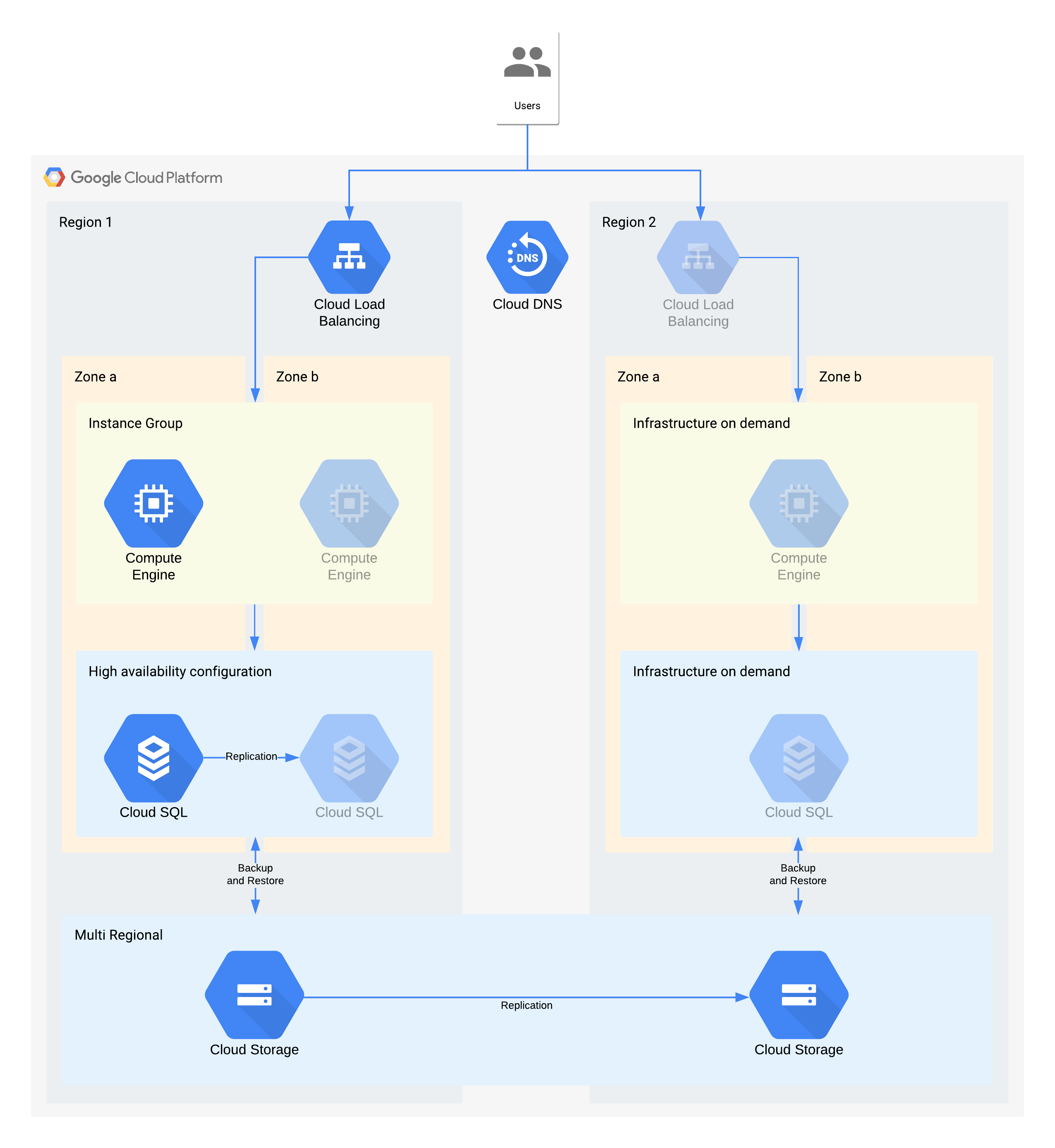

Architettura di esempio di livello 3

| Criticità dell'applicazione | Interruzione della zona | Interruzione a livello di regione |

|---|---|---|

| Livello 3 (meno importante) |

RTO 12 ore RPO 24 ore |

RTO 28 giorni RPO 24 ore |

(Le icone in grigio indicano l'infrastruttura da attivare per il recupero)

Questa architettura descrive una tradizionale applicazione client/server: gli utenti interni si connettono a un'applicazione in esecuzione su un'istanza di calcolo supportata da un database per l'archiviazione permanente.

È importante notare che questa architettura supporta valori RTO e RPO migliori di quelli richiesti. Tuttavia, dovresti anche valutare l'eliminazione di passaggi manuali aggiuntivi quando potrebbero rivelarsi costosi o inaffidabili. Ad esempio, il recupero di un database da un backup notturno potrebbe supportare l'RPO di 24 ore, ma in genere è necessario un professionista esperto come un amministratore di database che potrebbe non essere disponibile, soprattutto se più servizi sono stati interessati contemporaneamente. Con l'infrastruttura on demand di Google Cloud, puoi creare questa funzionalità senza dover scendere a compromessi sui costi e quindi questa architettura utilizza Cloud SQL HA anziché un backup/ripristino manuale per le interruzioni zonali.

Decisioni architetturali chiave per l'interruzione di zona: RTO di 12 ore e RPO di 24 ore:

- Un bilanciatore del carico interno viene utilizzato per fornire un punto di accesso scalabile per gli utenti, che consente il failover automatico in un'altra zona. Anche se il RTO è di 12 ore, le modifiche manuali agli indirizzi IP o persino gli aggiornamenti DNS possono richiedere più tempo del previsto.

- Un gruppo di istanze gestite a livello di regione è configurato con più zone, ma risorse minime. Questa opzione ottimizza i costi, ma consente comunque di scalare rapidamente le macchine virtuali nella zona di backup.

- Una configurazione Cloud SQL ad alta disponibilità prevede il failover automatico in un'altra zona. I database sono molto più difficili da ricreare e ripristinare rispetto alle macchine virtuali di Compute Engine.

Decisioni architetturali chiave per l'interruzione della regione: RTO di 28 giorni e RPO di 24 ore:

- Un bilanciatore del carico verrebbe costruito nella regione 2 solo in caso di interruzione a livello di regione. Cloud DNS viene utilizzato per fornire una funzionalità di failover regionale orchestrata ma manuale, poiché l'infrastruttura nella regione 2 sarebbe resa disponibile solo in caso di interruzione del servizio nella regione.

- Un nuovo gruppo di istanze gestite verrebbe creato solo in caso di interruzione della regione. In questo modo si ottimizzano i costi ed è improbabile che venga richiamato, data la breve durata della maggior parte delle interruzioni regionali. Tieni presente che, per semplicità, il diagramma non mostra gli strumenti associati necessari per il nuovo deployment o la copia delle immagini Compute Engine necessarie.

- Verrà ricreata una nuova istanza Cloud SQL e i dati verranno ripristinati da un backup. Anche in questo caso, il rischio di un'interruzione prolungata di una regione è estremamente basso, quindi si tratta di un altro compromesso per l'ottimizzazione dei costi.

- Cloud Storage multiregionale viene utilizzato per archiviare questi backup. Ciò garantisce la resilienza automatica a livello di zona e regione entro l'RTO e l'RPO.

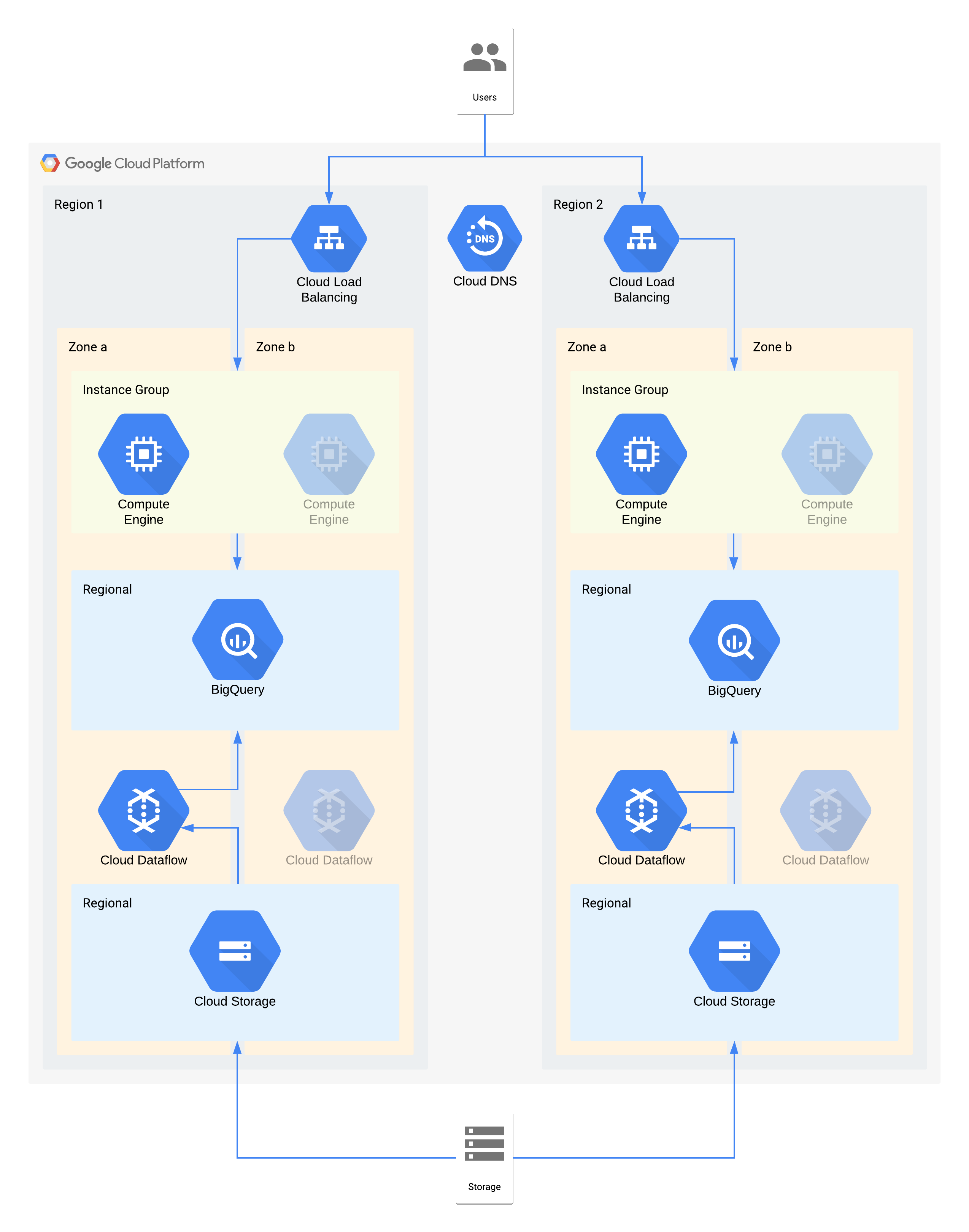

Architettura di esempio di livello 2

| Criticità dell'applicazione | Interruzione della zona | Interruzione a livello di regione |

|---|---|---|

| Livello 2 | RTO 4 ore RPO zero |

RTO 24 ore RPO 4 ore |

Questa architettura descrive un data warehouse con utenti interni che si connettono a un livello di visualizzazione dell'istanza di calcolo e a un livello di importazione e trasformazione dei dati che popola il data warehouse di backend.

Alcuni singoli componenti di questa architettura non supportano direttamente l'RPO richiesto per il loro livello. Tuttavia, a causa del modo in cui vengono utilizzati insieme, il servizio complessivo soddisfa l'RPO. In questo caso, poiché Dataflow è un prodotto zonale, segui i consigli per la progettazione ad alta disponibilità per evitare la perdita di dati durante un'interruzione. Tuttavia, il livello Cloud Storage è l'origine principale di questi dati e supporta un RPO di zero. Di conseguenza, puoi reimportare i dati persi in BigQuery utilizzando la zona b in caso di interruzione nella zona a.

Decisioni architetturali chiave per l'interruzione di zona: RTO di 4 ore e RPO pari a zero:

- Un bilanciatore del carico viene utilizzato per fornire un punto di accesso scalabile per gli utenti, che consente il failover automatico in un'altra zona. Anche se il RTO è di 4 ore, le modifiche manuali agli indirizzi IP o persino gli aggiornamenti DNS possono richiedere più tempo del previsto.

- Un gruppo di istanze gestite a livello di regione per il livello di calcolo della visualizzazione dei dati è configurato con più zone ma risorse minime. In questo modo, l'ottimizzazione dei costi è garantita, ma le macchine virtuali possono comunque essere scalate rapidamente.

- Cloud Storage regionale viene utilizzato come livello di gestione temporanea per l'importazione iniziale dei dati, fornendo resilienza automatica della zona.

- Dataflow viene utilizzato per estrarre i dati da Cloud Storage e trasformarli prima di caricarli in BigQuery. In caso di interruzione del servizio in una zona, si tratta di un processo stateless che può essere riavviato in un'altra zona.

- BigQuery fornisce il backend del data warehouse per il front-end di visualizzazione dei dati. In caso di interruzione di una zona, tutti i dati persi verranno reingestiti da Cloud Storage.

Decisioni architetturali chiave per l'interruzione della regione: RTO di 24 ore e RPO di 4 ore:

- Un bilanciatore del carico in ogni regione viene utilizzato per fornire un punto di accesso scalabile per gli utenti. Cloud DNS viene utilizzato per fornire una funzionalità di failover regionale orchestrata ma manuale, poiché l'infrastruttura nella regione 2 sarebbe disponibile solo in caso di interruzione della regione.

- Un gruppo di istanze gestite a livello di regione per il livello di calcolo della visualizzazione dei dati è configurato con più zone ma risorse minime. Non è accessibile finché il bilanciatore del carico non viene riconfigurato, ma non richiede altrimenti un intervento manuale.

- Cloud Storage regionale viene utilizzato come livello di gestione temporanea per l'importazione iniziale dei dati. Viene caricato contemporaneamente in entrambe le regioni per soddisfare i requisiti RPO.

- Dataflow viene utilizzato per estrarre i dati da Cloud Storage e trasformarli prima di caricarli in BigQuery. In caso di interruzione della regione, BigQuery verrà compilato con i dati più recenti di Cloud Storage.

- BigQuery fornisce il backend del data warehouse. Durante il normale funzionamento, questo valore viene aggiornato a intervalli regolari. In caso di interruzione di una regione, i dati più recenti verranno re-importati tramite Dataflow da Cloud Storage.

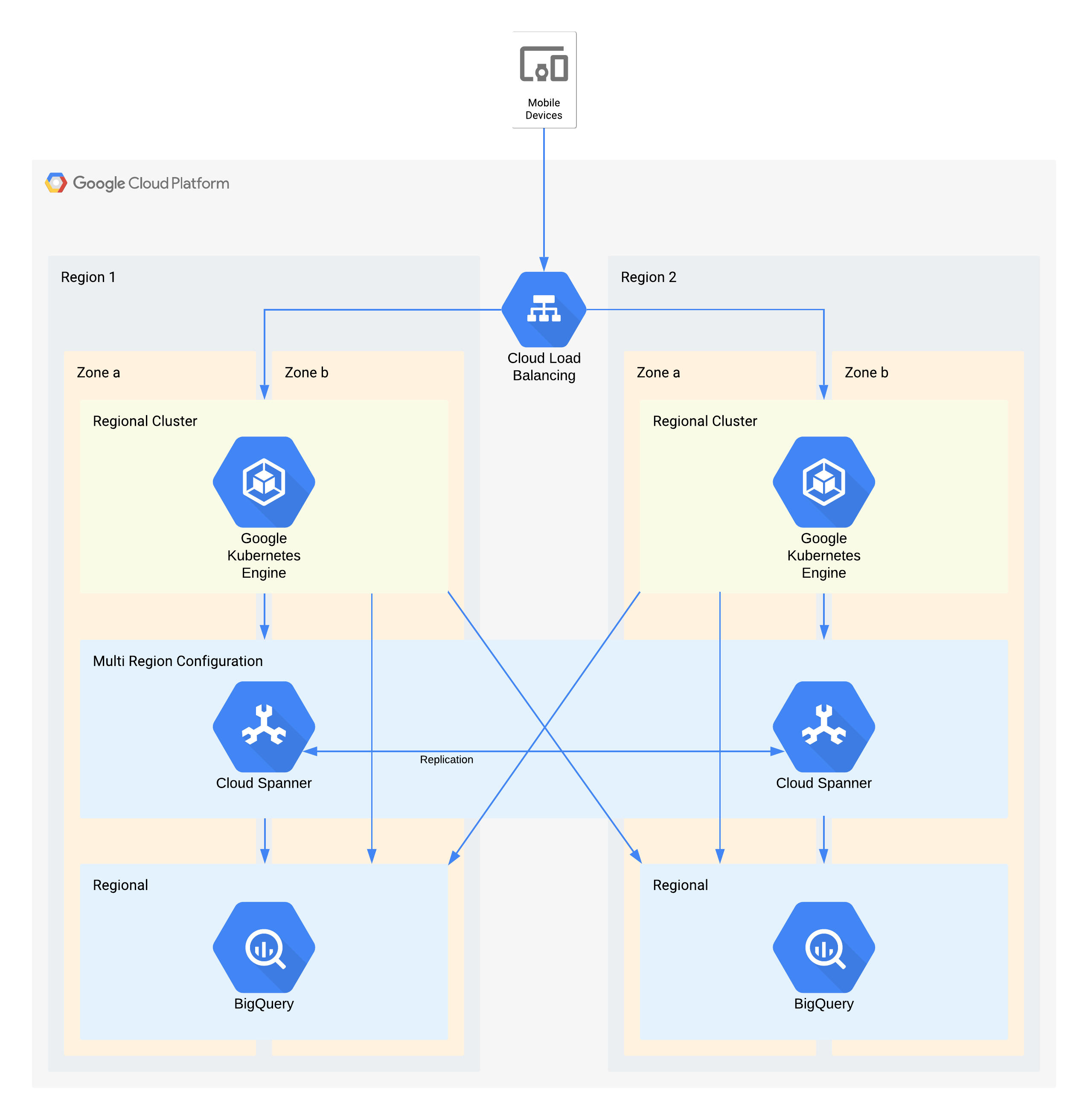

Architettura di esempio di livello 1

| Criticità dell'applicazione | Interruzione della zona | Interruzione a livello di regione |

|---|---|---|

| Livello 1 (il più importante) |

RTO zero RPO zero |

RTO 4 ore RPO 1 ora |

Questa architettura descrive un'infrastruttura di backend di app mobile con utenti esterni che si connettono a un insieme di microservizi in esecuzione in GKE. Spanner fornisce il livello di archiviazione dei dati di backend per i dati in tempo reale e i dati storici vengono trasmessi in streaming a un data lake BigQuery in ogni regione.

Anche in questo caso, alcuni singoli componenti di questa architettura non supportano direttamente l'RPO richiesto per il loro livello, ma grazie al modo in cui vengono utilizzati insieme il servizio complessivo lo supporta. In questo caso, BigQuery viene utilizzato per le query analitiche. Ogni regione viene alimentata contemporaneamente da Spanner.

Decisioni architetturali chiave per l'interruzione di zona: RTO pari a zero e RPO pari a zero:

- Un bilanciatore del carico viene utilizzato per fornire un punto di accesso scalabile per gli utenti, che consente il failover automatico in un'altra zona.

- Un cluster GKE regionale viene utilizzato per il livello applicazione, configurato con più zone. In questo modo si ottiene un RTO pari a zero in ogni regione.

- Spanner multiregionale viene utilizzato come livello di persistenza dei dati, fornendo resilienza automatica dei dati di zona e coerenza delle transazioni.

- BigQuery fornisce la funzionalità di analisi per l'applicazione. Ogni regione riceve i dati in modo indipendente da Spanner e l'applicazione vi accede in modo indipendente.

Decisioni architetturali chiave per l'interruzione della regione: RTO di 4 ore e RPO di 1 ora:

- Un bilanciatore del carico viene utilizzato per fornire un punto di accesso scalabile per gli utenti, che consente il failover automatico in un'altra regione.

- Un cluster GKE regionale viene utilizzato per il livello applicazione, configurato con più zone. In caso di interruzione di una regione, il cluster nella regione alternativa viene scalato automaticamente per gestire il carico di elaborazione aggiuntivo.

- Spanner multiregionale viene utilizzato come livello di persistenza dei dati, fornendo resilienza automatica dei dati regionali e coerenza delle transazioni. Questo è il componente chiave per raggiungere l'RPO tra regioni di 1 ora.

- BigQuery fornisce la funzionalità di analisi per l'applicazione. Ogni regione riceve i dati in modo indipendente da Spanner e l'applicazione vi accede in modo indipendente. Questa architettura compensa il componente BigQuery, consentendogli di soddisfare i requisiti generali dell'applicazione.

Appendice: Riferimento prodotto

Questa sezione descrive l'architettura e le funzionalità di RE dei prodotti Google Cloud più comunemente utilizzati nelle applicazioni dei clienti e che possono essere sfruttati facilmente per soddisfare i tuoi requisiti di RE.

Temi comuni

Molti Google Cloud prodotti offrono configurazioni regionali o multiregionali. I prodotti regionali sono resilienti alle interruzioni di zona, mentre i prodotti multiregionali e globali sono resilienti alle interruzioni di regione. In generale, ciò significa che durante un'interruzione, la tua applicazione subisce interruzioni minime. Google raggiunge questi risultati attraverso alcuni approcci architetturali comuni, che rispecchiano le indicazioni architetturali riportate sopra.

Deployment ridondante:i backend dell'applicazione e l'archiviazione dei dati vengono implementati in più zone all'interno di una regione e in più regioni all'interno di una località multiregionale. Per saperne di più sulle considerazioni specifiche per le regioni, consulta Area geografica e regioni.

Replica dei dati:i prodotti utilizzano la replica sincrona o asincrona nelle posizioni ridondanti.

La replica sincrona significa che quando la tua applicazione effettua una chiamata API per creare o modificare i dati archiviati dal prodotto, riceve una risposta positiva solo dopo che il prodotto ha scritto i dati in più posizioni. La replica sincrona garantisce che tu non perda l'accesso ai tuoi dati durante un'interruzione dell'infrastruttura Google Cloud perché tutti i tuoi dati sono disponibili in una delle posizioni di backend disponibili.

Sebbene questa tecnica fornisca la massima protezione dei dati, può comportare compromessi in termini di latenza e prestazioni. I prodotti multiregionali che utilizzano la replica sincrona risentono maggiormente di questo compromesso, in genere con un ordine di grandezza di decine o centinaia di millisecondi di latenza aggiuntiva.

La replica asincrona significa che quando la tua applicazione effettua una chiamata API per creare o modificare i dati archiviati dal prodotto, riceve una risposta positiva una volta che il prodotto ha scritto i dati in una singola posizione. Dopo la richiesta di scrittura, il prodotto replica i tuoi dati in posizioni aggiuntive.

Questa tecnica offre una latenza inferiore e un throughput più elevato nell'API rispetto alla replica sincrona, ma a scapito della protezione dei dati. Se la località in cui hai scritto i dati subisce un'interruzione prima che la replica sia completata, perdi l'accesso a questi dati finché l'interruzione della località non viene risolta.

Gestione delle interruzioni con il bilanciamento del carico: Google Cloud utilizza il bilanciamento del carico software per instradare le richieste ai backend dell'applicazione appropriati. Rispetto ad altri approcci come il bilanciamento del carico DNS, questo approccio riduce il tempo di risposta del sistema a un'interruzione. Quando si verifica un'interruzione della Google Cloud posizione, il bilanciatore del carico rileva rapidamente che il backend di cui è stato eseguito il deployment in quella posizione è diventato "non integro" e indirizza tutte le richieste a un backend in una posizione alternativa. Ciò consente al prodotto di continuare a gestire le richieste della tua applicazione durante un'interruzione del servizio di localizzazione. Quando l'interruzione della località viene risolta, il bilanciatore del carico rileva la disponibilità dei backend di prodotto in quella località e riprende a inviare traffico.

Gestore contesto accesso

Gestore contesto accesso consente alle aziende di configurare livelli di accesso che corrispondono a una norma definita negli attributi della richiesta. I criteri vengono replicati a livello regionale.

In caso di interruzione a livello di zona, le richieste alle zone non disponibili vengono gestite automaticamente e in modo trasparente da altre zone disponibili nella regione.

In caso di interruzione a livello regionale, i calcoli delle policy dell'area geografica interessata non sono disponibili finché l'area geografica non torna disponibile.

Access Transparency

Access Transparency consente agli amministratori dell'organizzazione Google Cloud di definire un controllo dell'accesso granulare e basato sugli attributi per progetti e risorse in Google Cloud. Di tanto in tanto, Google deve accedere ai dati dei clienti per scopi amministrativi. Quando accediamo ai dati dei clienti, Access Transparency fornisce i log di accesso ai clienti Google Cloudinteressati. Questi log di Access Transparency contribuiscono a garantire l'impegno di Google per la sicurezza dei dati e la trasparenza nella gestione dei dati.

Access Transparency è resiliente alle interruzioni a livello di zona e regione. Se si verifica un'interruzione a livello di zona o regionale, Access Transparency continua a elaborare i log di accesso amministrativo in un'altra zona o regione.

AlloyDB per PostgreSQL

AlloyDB per PostgreSQL è un servizio di database completamente gestito e compatibile con PostgreSQL. AlloyDB per PostgreSQL offre alta disponibilità in una regione tramite i nodi ridondanti dell'istanza principale, che si trovano in due zone diverse della regione. L'istanza principale mantiene la disponibilità regionale attivando un failover automatico nella zona di standby se la zona attiva riscontra un problema. L'archiviazione regionale garantisce la durabilità dei dati in caso di perdita di una singola zona.

Come ulteriore metodo di ripristino di emergenza, AlloyDB per PostgreSQL utilizza la replica tra regioni per fornire funzionalità di ripristino di emergenza replicando in modo asincrono i dati del cluster primario nei cluster secondari che si trovano in regioni Google Cloud separate.

Interruzione zonale: durante il normale funzionamento, è attivo solo uno dei due nodi di un'istanza principale ad alta disponibilità e gestisce tutte le scritture di dati. Questo nodo attivo archivia i dati nel livello di archiviazione regionale separato del cluster.

AlloyDB per PostgreSQL rileva automaticamente gli errori a livello di zona e attiva un failover per ripristinare la disponibilità del database. Durante il failover, AlloyDB per PostgreSQL avvia il database sul nodo di standby, che è già provisionato in una zona diversa. Le nuove connessioni al database vengono automaticamente indirizzate a questa zona.

Dal punto di vista di un'applicazione client, un'interruzione zonale assomiglia a un'interruzione temporanea della connettività di rete. Al termine del failover, un client può riconnettersi all'istanza allo stesso indirizzo, utilizzando le stesse credenziali, senza perdita di dati.

Interruzione regionale: la replica tra regioni utilizza la replica asincrona, che consente all'istanza principale di eseguire il commit delle transazioni prima che venga eseguito il commit sulle repliche. La differenza di tempo tra il momento in cui una transazione viene commitata sull'istanza primaria e il momento in cui viene commitata sulla replica è nota come ritardo della replica. La differenza di tempo tra il momento in cui il primario genera il log write-ahead (WAL) e il momento in cui il WAL raggiunge la replica è nota come flush lag. Il ritardo di replica e il ritardo di svuotamento dipendono dalla configurazione dell'istanza del database e dal carico di lavoro generato dall'utente.

In caso di interruzione a livello di regione, puoi promuovere i cluster secondari in una regione diversa a cluster primario autonomo scrivibile. Questo cluster promosso non replica più i dati dal cluster primario originale a cui era precedentemente associato. A causa del ritardo di svuotamento, potrebbe verificarsi una perdita di dati perché potrebbero esserci transazioni nel cluster primario originale che non sono state propagate al cluster secondario.

L'RPO della replica tra regioni è influenzato sia dall'utilizzo della CPU del cluster principale sia dalla distanza fisica tra la regione del cluster principale e quella del cluster secondario. Per ottimizzare l'RPO, ti consigliamo di testare il tuo carico di lavoro con una configurazione che includa una replica per stabilire un limite sicuro di transazioni al secondo (TPS), ovvero il TPS sostenuto più elevato che non accumula ritardo di svuotamento. Se il tuo workload supera il limite di TPS sicuro, si accumula un ritardo di svuotamento, che può influire sull'RPO. Per limitare il ritardo di rete, scegli coppie di regioni all'interno dello stesso continente.

Per saperne di più sul monitoraggio del ritardo di rete e di altre metriche di AlloyDB per PostgreSQL, consulta Monitorare le istanze.

Anti Money Laundering AI

Anti Money Laundering AI (AML AI) fornisce un'API per aiutare gli istituti finanziari globali a rilevare in modo più efficace ed efficiente il riciclaggio di denaro. L'AI antiriciclaggio è un'offerta regionale, il che significa che i clienti possono scegliere la regione, ma non le zone che la compongono. I dati e il traffico vengono bilanciati automaticamente tra le zone all'interno di una regione. Le operazioni (ad esempio, per creare una pipeline o eseguire una previsione) vengono scalate automaticamente in background e bilanciate tra le zone in base alle necessità.

Interruzione zonale:AML AI archivia i dati per le sue risorse a livello regionale, replicati in modo sincrono. Quando un'operazione a lunga esecuzione viene completata correttamente, è possibile fare affidamento sulle risorse indipendentemente dagli errori di zona. L'elaborazione viene replicata anche tra le zone, ma questa replica ha lo scopo di bilanciare il carico e non di garantire l'alta disponibilità, pertanto un errore a livello di zona durante un'operazione può comportare un errore dell'operazione. In questo caso, riprovare l'operazione può risolvere il problema. Durante un'interruzione a livello di zona, i tempi di elaborazione potrebbero essere interessati.

Interruzione regionale: i clienti scelgono la regione Google Cloud in cui vogliono creare le risorse AML AI. I dati non vengono mai replicati tra regioni. Il traffico dei clienti non viene mai indirizzato a un'altra regione dall'IA AML. In caso di errore a livello di regione, AML AI tornerà disponibile non appena l'interruzione verrà risolta.

Chiavi API

Le chiavi API forniscono una gestione scalabile delle risorse delle chiavi API per un progetto. Le chiavi API sono un servizio globale, il che significa che le chiavi sono visibili e accessibili da qualsiasi Google Cloud posizione. I relativi dati e metadati vengono archiviati in modo ridondante in più zone e regioni.

Le chiavi API sono resilienti sia alle interruzioni zonali che regionali. In caso di interruzione a livello di zona o regione, le chiavi API continuano a gestire le richieste provenienti da un'altra zona della stessa regione o di una regione diversa.

Per saperne di più sulle chiavi API, consulta la panoramica dell'API API Keys.

Apigee

Apigee fornisce una piattaforma sicura, scalabile e affidabile per lo sviluppo e la gestione delle API. Apigee offre deployment a livello di una o più regioni.

Interruzione zonale: i dati di runtime dei clienti vengono replicati in più zone di disponibilità. Pertanto, un'interruzione in una singola zona non influisce su Apigee.

Interruzione a livello regionale:per le istanze Apigee a una singola regione, se una regione non è più disponibile, le istanze Apigee non sono disponibili in quella regione e non possono essere ripristinate in regioni diverse. Per le istanze Apigee multiregionali, i dati vengono replicati in modo asincrono in tutte le regioni. Pertanto, l'errore di una regione non riduce completamente il traffico. Tuttavia, potresti non essere in grado di accedere ai dati non sottoposti a commit nella regione non riuscita. Puoi deviare il traffico dalle regioni non integre. Per ottenere il failover automatico del traffico, puoi configurare il routing di rete utilizzando i gruppi di istanze gestite (MIG).

AutoML Translation

AutoML Translation è un servizio di traduzione automatica che ti consente di importare i tuoi dati (coppie di frasi) per addestrare modelli personalizzati per le tue esigenze specifiche del dominio.

Interruzione zonale:AutoML Translation dispone di server di calcolo attivi in più zone e regioni. Supporta anche la replica sincrona dei dati tra le zone all'interno delle regioni. Queste funzionalità aiutano AutoML Translation a eseguire il failover istantaneo senza alcuna perdita di dati per gli errori di zona e senza richiedere alcun input o aggiustamento da parte del cliente.

Interruzione a livello regionale: in caso di errore a livello regionale, AutoML Translation non è disponibile.

AutoML Vision

AutoML Vision fa parte di Vertex AI. Offre un framework unificato per creare set di dati, importare dati, addestrare modelli e pubblicare modelli per la previsione online e la previsione batch.

AutoML Vision è un'offerta regionale. I clienti possono scegliere la regione da cui vogliono avviare un job, ma non possono scegliere le zone specifiche all'interno di quella regione. Il servizio bilancia automaticamente il carico dei workload in diverse zone all'interno della regione.

Interruzione zonale:AutoML Vision archivia i metadati per i job a livello regionale e scrive in modo sincrono tra le zone all'interno della regione. I job vengono avviati in una zona specifica, selezionata da Cloud Load Balancing.

Job di addestramento AutoML Vision: un'interruzione zonale causa l'interruzione di tutti i job in esecuzione e lo stato del job viene aggiornato a Non riuscito. Se un job non va a buon fine, riprova immediatamente. Il nuovo job viene indirizzato a una zona disponibile.

Job di previsioni in batch AutoML Vision: le previsioni in batch si basano sulle previsioni in batch di Vertex AI. Quando si verifica un'interruzione zonale, il servizio riprova automaticamente il job indirizzandolo alle zone disponibili. Se più tentativi non vanno a buon fine, lo stato del job viene aggiornato a non riuscito. Le richieste successive degli utenti per eseguire il job vengono instradate a una zona disponibile.

Interruzione regionale:i clienti scelgono la regione Google Cloud in cui vogliono eseguire i job. I dati non vengono mai replicati tra regioni. In caso di errore regionale, il servizio AutoML Vision non è disponibile in quella regione. Tornerà disponibile una volta risolto il problema. Per eseguire i job, consigliamo ai clienti di utilizzare più regioni. In caso di interruzione a livello di regione, indirizza i job a un'altra regione disponibile.

Batch

Batch è un servizio completamente gestito per mettere in coda, pianificare ed eseguire job batch su Google Cloud. Le impostazioni batch sono definite a livello di regione. I clienti devono scegliere una regione per inviare i job batch, non una zona in una regione. Quando viene inviato un job, Batch scrive in modo sincrono i dati dei clienti in più zone. Tuttavia, i clienti possono specificare le zone in cui le VM Batch eseguono i job.

Errore a livello di zona:quando si verifica un errore in una singola zona, anche le attività in esecuzione in quella zona non vanno a buon fine. Se le attività hanno impostazioni di nuovi tentativi, Batch esegue automaticamente il failover di queste attività in altre zone attive nella stessa regione. Il failover automatico è soggetto alla disponibilità di risorse nelle zone attive della stessa regione. I job che richiedono risorse di zona (come VM, GPU o dischi permanenti di zona) disponibili solo nella zona non riuscita vengono messi in coda fino al ripristino della zona non riuscita o fino al raggiungimento dei timeout di accodamento dei job. Se possibile, consigliamo ai clienti di lasciare che Batch scelga le risorse zonali per eseguire i job. In questo modo, i job sono resilienti a un'interruzione di zona.

Errore regionale:in caso di errore regionale, il service control plane non è disponibile nella regione. Il servizio non replica i dati né reindirizza le richieste tra le regioni. Consigliamo ai clienti di utilizzare più regioni per eseguire i propri job e reindirizzarli a un'altra regione in caso di errore.

Protezione dei dati e tutela dalle minacce di Chrome Enterprise Premium

La protezione dei dati e dalle minacce di Chrome Enterprise Premium fa parte della soluzione Chrome Enterprise Premium. Estende Chrome con una serie di funzionalità di sicurezza, tra cui protezione da malware e phishing, prevenzione della perdita di dati (DLP), regole di filtro degli URL e report sulla sicurezza.

Gli amministratori di Chrome Enterprise Premium possono attivare l'archiviazione dei contenuti principali dei clienti che violano le norme DLP o relative ai malware negli eventi dei log delle regole di Google Workspace e/o in Cloud Storage per indagini future. Gli eventi del log delle regole di Google Workspace sono basati su un database Spanner multiregionale. Chrome Enterprise Premium può richiedere fino a diverse ore per rilevare le violazioni delle norme. Durante questo periodo, tutti i dati non elaborati sono soggetti a perdita di dati a causa di un'interruzione zonale o regionale. Una volta rilevata una violazione, i contenuti che violano le tue norme vengono scritti negli eventi del log delle regole di Google Workspace e/o in Cloud Storage.

Interruzione zonale e regionale: Poiché la protezione dei dati e dalle minacce di Chrome Enterprise Premium è multizonale e multiregionale, può sopravvivere a una perdita completa e non pianificata di una zona o di una regione senza perdita di disponibilità. Fornisce questo livello di affidabilità reindirizzando il traffico al suo servizio in altre zone o regioni attive. Tuttavia, poiché la protezione dalle minacce e dei dati di Chrome Enterprise Premium può richiedere diverse ore per rilevare violazioni di DLP e malware, tutti i dati non elaborati in una zona o regione specifica sono soggetti a perdita a causa di un'interruzione zonale o regionale.

BigQuery

BigQuery è un data warehouse su cloud serverless, a scalabilità elevata e dai costi contenuti, progettato per l'agilità aziendale. BigQuery supporta i seguenti tipi di località per i set di dati utente:

- Una regione: una posizione geografica specifica, ad esempio Iowa (

us-central1) o Montréal (northamerica-northeast1). - Una località a più regioni: una realtà geografica di grandi dimensioni che contiene due o più luoghi geografici, ad esempio gli Stati Uniti (

US) o l'Europa (EU).

In entrambi i casi, i dati vengono archiviati in modo ridondante in due zone all'interno di una singola regione nella località selezionata. I dati scritti in BigQuery vengono scritti in modo sincrono sia nella zona primaria che in quella secondaria. Questa protezione impedisce l'indisponibilità di una singola zona all'interno della regione, ma non di un'interruzione a livello regionale.

Autorizzazione binaria

Autorizzazione binaria è un prodotto per la sicurezza della catena di fornitura del software per GKE e Cloud Run.

Tutti i criteri di Autorizzazione binaria vengono replicati in più zone all'interno di ogni regione. La replica aiuta le operazioni di lettura dei criteri di Autorizzazione binaria a ripristinarsi in seguito a errori in altre regioni. La replica rende anche le operazioni di lettura tolleranti agli errori zonali all'interno di ogni regione.

Le operazioni di applicazione di Autorizzazione binaria sono resilienti alle interruzioni a livello di zona, ma non a quelle a livello di regione. Le operazioni di applicazione vengono eseguite nella stessa regione del cluster GKE o del job Cloud Run che effettua la richiesta. Pertanto, in caso di interruzione del servizio a livello regionale, non è in esecuzione alcun processo per effettuare richieste di applicazioneAutorizzazione binarian.

Certificate Manager

Certificate Manager ti consente di acquisire e gestire i certificati Transport Layer Security (TLS) da utilizzare con diversi tipi di Cloud Load Balancing.

In caso di interruzione zonale, Certificate Manager regionale e globale sono resilienti agli errori zonali perché i job e i database sono ridondanti in più zone all'interno di una regione. In caso di interruzione regionale, Certificate Manager globale è resiliente agli errori regionali perché i job e i database sono ridondanti in più regioni. Regional Certificate Manager è un prodotto regionale, quindi non può resistere a un errore regionale.

Cloud Intrusion Detection System

Cloud Intrusion Detection System (Cloud IDS) è un servizio zonale che fornisce endpoint IDS con ambito zonale, che elaborano il traffico delle VM in una zona specifica e quindi non tollerano interruzioni zonali o regionali.

Interruzione a livello di zona:Cloud IDS è collegato alle istanze VM. Se un cliente pianifica di mitigare le interruzioni zonali eseguendo il deployment di VM in più zone (manualmente o tramite i gruppi di istanze gestite a livello di regione), dovrà eseguire il deployment anche degli endpoint Cloud IDS in queste zone.

Interruzione a livello di regione:Cloud IDS è un prodotto regionale. Non fornisce alcuna funzionalità cross-region. Un errore regionale interromperà tutte le funzionalità di Cloud IDS in tutte le zone della regione.

Google Security Operations SIEM

Google Security Operations SIEM (che fa parte di Google Security Operations) è un servizio completamente gestito che aiuta i team di sicurezza a rilevare, analizzare e rispondere alle minacce.

Google Security Operations SIEM offre servizi regionali e multiregionali.

Nelle offerte regionali, il bilanciamento del carico di dati e traffico viene eseguito automaticamente tra le zone all'interno della regione scelta e i dati vengono archiviati in modo ridondante tra le zone di disponibilità all'interno della regione.

Le regioni multiple sono geo-ridondanti. Questa ridondanza offre una gamma più ampia di protezioni rispetto allo spazio di archiviazione regionale. Inoltre, contribuisce a garantire che il servizio continui a funzionare anche in caso di perdita di un'intera regione.

La maggior parte dei percorsi di importazione dati replica i dati dei clienti in modo sincrono in più località. Quando i dati vengono replicati in modo asincrono, esiste un intervallo di tempo (un obiettivo del punto di ripristino o RPO) durante il quale i dati non vengono ancora replicati in più località. Questo è il caso dell'importazione con feed nei deployment multiregionali. Dopo l'RPO, i dati sono disponibili in più località.

Interruzione zonale:

Deployment regionali: le richieste vengono gestite da qualsiasi zona all'interno della regione. I dati vengono replicati in modo sincrono in più zone. In caso di interruzione dell'intera zona, le zone rimanenti continuano a gestire il traffico e a elaborare i dati. Il provisioning ridondante e lo scaling automatico per Google Security Operations SIEM contribuiscono a garantire che il servizio rimanga operativo nelle zone rimanenti durante questi spostamenti del carico.

Deployment multiregionali: le interruzioni a livello di zona sono equivalenti alle interruzioni a livello regionale.

Interruzione regionale:

Deployment regionali: Google Security Operations SIEM archivia tutti i dati dei clienti in una singola regione e il traffico non viene mai instradato tra le regioni. In caso di interruzione regionale, Google Security Operations SIEM non è disponibile nella regione fino alla risoluzione dell'interruzione.

Deployment multiregionali (senza feed): le richieste vengono gestite da qualsiasi regione del deployment multiregionale. I dati vengono replicati in modo sincrono in più regioni. In caso di interruzione a livello di regione, le regioni rimanenti continuano a gestire il traffico e a elaborare i dati. Il provisioning ridondante e lo scaling automatico per Google Security Operations SIEM contribuiscono a garantire che il servizio rimanga operativo nelle regioni rimanenti durante questi spostamenti del carico.

Deployment multiregionali (con feed): le richieste vengono gestite da qualsiasi regione del deployment multiregionale. I dati vengono replicati in modo asincrono in più regioni con l'RPO fornito. In caso di interruzione a livello di regione, solo i dati archiviati dopo l'RPO sono disponibili nelle regioni rimanenti. I dati all'interno della finestra RPO potrebbero non essere replicati.

Cloud Asset Inventory

Cloud Asset Inventory è un servizio globale ad alte prestazioni e resiliente che gestisce un repository di metadati di risorse e criteri. Google Cloud Cloud Asset Inventory fornisce strumenti di ricerca e analisi che ti aiutano a monitorare gli asset di cui è stato eseguito il deployment in organizzazioni, cartelle e progetti.

In caso di interruzione di una zona, Cloud Asset Inventory continua a gestire le richieste provenienti da un'altra zona nella stessa regione o in una regione diversa.

In caso di interruzione a livello di regione, Cloud Asset Inventory continua a gestire le richieste provenienti da altre regioni.

Bigtable

Bigtable è un servizio di database NoSQL ad alte prestazioni e completamente gestito per carichi di lavoro analitici e operativi di grandi dimensioni.

Panoramica della replica Bigtable

Bigtable offre una funzionalità di replica flessibile e completamente configurabile, che puoi utilizzare per aumentare la disponibilità e la durabilità dei tuoi dati copiandoli nei cluster in più regioni o più zone all'interno della stessa regione. Bigtable può anche fornire il failover automatico per le tue richieste quando utilizzi la replica.

Quando utilizzi configurazioni multizona o multiregionali con il routing multi-cluster, in caso di interruzione a livello di zona o regione, Bigtable reindirizza automaticamente il traffico e gestisce le richieste dal cluster disponibile più vicino. Poiché la replica Bigtable è asincrona e alla fine coerente, le modifiche più recenti ai dati nella località dell'interruzione potrebbero non essere disponibili se non sono ancora state replicate in altre località.

Considerazioni sulle prestazioni

Quando le richieste di risorse CPU superano la capacità del nodo disponibile, Bigtable dà sempre la priorità alla gestione delle richieste in entrata rispetto al traffico di replica.

Per saperne di più su come utilizzare la replica Bigtable con il tuo workload, consulta la panoramica della replica Cloud Bigtable e gli esempi di impostazioni di replica.

I nodi Bigtable vengono utilizzati sia per la gestione delle richieste in entrata sia per l'esecuzione della replica dei dati da altri cluster. Oltre a mantenere un numero sufficiente di nodi per cluster, devi anche assicurarti che le tue applicazioni utilizzino una progettazione dello schema corretta per evitare hotspot, che possono causare un utilizzo eccessivo o sbilanciato della CPU e una maggiore latenza di replica.

Per saperne di più sulla progettazione dello schema dell'applicazione per massimizzare le prestazioni e l'efficienza di Bigtable, consulta Best practice per la progettazione degli schemi.

Monitoraggio

Bigtable offre diversi modi per monitorare visivamente la latenza di replica delle istanze e dei cluster utilizzando i grafici per la replica disponibili in Google Cloud console.

Puoi anche monitorare in modo programmatico le metriche di replica di Bigtable utilizzando l'API Cloud Monitoring.

Certificate Authority Service

Certificate Authority Service (CA Service) consente ai clienti di semplificare, automatizzare e personalizzare il deployment, la gestione e la sicurezza delle autorità di certificazione (CA) private e di emettere certificati in modo resiliente su larga scala.

Interruzione zonale: CA Service è resiliente ai guasti zonali perché il suo control plane è ridondante in più zone all'interno di una regione. In caso di interruzione a livello di zona, CA Service continua a gestire le richieste provenienti da un'altra zona della stessa regione senza interruzioni. Poiché i dati vengono replicati in modo sincrono, non si verificano perdite o danneggiamenti.

Interruzione regionale: CA Service è un prodotto regionale, quindi non può resistere a un errore regionale. Se hai bisogno di resilienza agli errori regionali, crea CA emittenti in due regioni diverse. Crea la CA di emissione principale nella regione in cui ti servono i certificati. Crea una CA di fallback in un'altra regione. Utilizza il fallback quando si verifica un'interruzione nella regione della CA subordinata principale. Se necessario, entrambe le CA possono essere concatenate alla stessa CA radice.

Cloud Billing

L'API Cloud Billing consente agli sviluppatori di gestire la fatturazione per i propri progettiGoogle Cloud a livello di programmazione. L'API Cloud Billing è progettata come sistema globale con aggiornamenti scritti in modo sincrono in più zone e regioni.

Errore zonale o regionale: l'API Cloud Billing esegue automaticamente il failover in un'altra zona o regione. Le singole richieste potrebbero non riuscire, ma un criterio di riprova dovrebbe consentire di eseguire correttamente i tentativi successivi.

Cloud Build

Cloud Build è un servizio che esegue le tue build su Google Cloud.

Cloud Build è composto da istanze isolate a livello regionale che replicano i dati in modo sincrono tra le zone all'interno della regione. Ti consigliamo di utilizzare regioni specifiche Google Cloud anziché la regione globale e di assicurarti che le risorse utilizzate dalla build (inclusi bucket di log, repository Artifact Registry e così via) siano allineate alla regione in cui viene eseguita la build.

In caso di interruzione a livello di zona, le operazioni del control plane non sono interessate. Tuttavia, le build attualmente in esecuzione nella zona in errore verranno ritardate o perse definitivamente. Le build appena attivate verranno distribuite automaticamente alle zone funzionanti rimanenti.

In caso di errore regionale, il piano di controllo sarà offline e le build attualmente in esecuzione verranno ritardate o perse definitivamente. I trigger, i pool di worker e i dati di build non vengono mai replicati tra le regioni. Ti consigliamo di preparare trigger e pool di worker in più regioni per semplificare la mitigazione di un'interruzione.

Cloud CDN

Cloud CDN distribuisce e memorizza nella cache i contenuti in molte località della rete Google per ridurre la latenza di pubblicazione per i client. I contenuti memorizzati nella cache vengono pubblicati in base al miglior impegno possibile. Quando una richiesta non può essere gestita dalla cache di Cloud CDN, viene inoltrata ai server di origine, come le VM di backend o i bucket Cloud Storage, in cui sono archiviati i contenuti originali.

Quando una zona o una regione non funziona, le cache nelle località interessate non sono disponibili. Le richieste in entrata vengono instradate alle posizioni edge e alle cache di Google disponibili. Se queste cache alternative non possono soddisfare la richiesta, la inoltreranno a un server di origine disponibile. A condizione che il server possa soddisfare la richiesta con dati aggiornati, non si verificherà alcuna perdita di contenuti. Un aumento del tasso di fallimenti della cache farà sì che i server di origine registrino volumi di traffico superiori al normale man mano che le cache vengono riempite. Le richieste successive verranno servite dalle cache non interessate dall'interruzione del servizio nella zona o nella regione.

Per ulteriori informazioni su Cloud CDN e sul comportamento della cache, consulta la documentazione di Cloud CDN.

Cloud Composer

Cloud Composer è un servizio gestito per l'orchestrazione dei workflow che consente di creare, pianificare, monitorare e gestire workflow distribuiti su più cloud e sui data center on-premise. Gli ambienti Cloud Composer sono basati sul progetto open source Apache Airflow.

La disponibilità dell'API Cloud Composer non è interessata dall'indisponibilità zonale. Durante un'interruzione zonale, mantieni l'accesso all'API Cloud Composer, inclusa la possibilità di creare nuovi ambienti Cloud Composer.

Un ambiente Cloud Composer ha un cluster GKE come parte della sua architettura. Durante un'interruzione zonale, i workflow sul cluster potrebbero essere interrotti:

- In Cloud Composer 1, il cluster dell'ambiente è una risorsa di zona, pertanto un'interruzione del servizio a livello di zona potrebbe rendere il cluster non disponibile. Workflows in esecuzione al momento dell'interruzione potrebbero essere interrotti prima del completamento.

- In Cloud Composer 2, il cluster dell'ambiente è una risorsa regionale. Tuttavia, i flussi di lavoro eseguiti sui nodi nelle zone interessate da un'interruzione zonale potrebbero essere interrotti prima del completamento.

In entrambe le versioni di Cloud Composer, un'interruzione zonale potrebbe causare l'interruzione dell'esecuzione dei flussi di lavoro eseguiti parzialmente, incluse le azioni esterne che hai configurato per il flusso di lavoro. A seconda del flusso di lavoro, ciò può causare incoerenze a livello esterno, ad esempio se il flusso di lavoro si interrompe a metà di un'esecuzione in più passaggi per modificare gli archivi di dati esterni. Pertanto, devi considerare la procedura di recupero quando progetti il flusso di lavoro Airflow, incluso come rilevare gli stati del flusso di lavoro parzialmente eseguiti e riparare eventuali modifiche parziali dei dati.

In Cloud Composer 1, durante un'interruzione della zona, puoi scegliere di avviare un nuovo ambiente Cloud Composer in un'altra zona. Poiché Airflow mantiene lo stato dei workflow nel suo database di metadati, il trasferimento di queste informazioni a un nuovo ambiente Cloud Composer può richiedere ulteriori passaggi e preparazione.

In Cloud Composer 2, puoi risolvere le interruzioni zonali configurando in anticipo il recupero di emergenza con snapshot dell'ambiente. Durante un'interruzione del servizio a livello di zona, puoi passare a un altro ambiente trasferendo lo stato dei tuoi flussi di lavoro con uno snapshot dell'ambiente. Solo Cloud Composer 2 supporta il ripristino di emergenza con gli snapshot dell'ambiente.

Cloud Data Fusion

Cloud Data Fusion è un servizio di integrazione dei dati aziendali completamente gestito per creare e gestire rapidamente pipeline di dati. Offre tre edizioni.

Le interruzioni zonali influiscono sulle istanze dell'edizione Developer.

Le interruzioni regionali interessano le istanze delle versioni Basic ed Enterprise.

Per controllare l'accesso alle risorse, puoi progettare ed eseguire pipeline in ambienti separati. Questa separazione ti consente di progettare una pipeline una sola volta e poi eseguirla in più ambienti. Puoi recuperare le pipeline in entrambi gli ambienti. Per ulteriori informazioni, vedi Eseguire il backup e il ripristino dei dati dell'istanza.

I seguenti consigli si applicano sia alle interruzioni regionali che a quelle zonali.

Interruzioni nell'ambiente di progettazione della pipeline

Nell'ambiente di progettazione, salva le bozze delle pipeline in caso di interruzione. A seconda dei requisiti specifici di RTO e RPO, puoi utilizzare le bozze salvate per ripristinare la pipeline in un'altra istanza di Cloud Data Fusion durante un'interruzione.

Interruzioni nell'ambiente di esecuzione della pipeline

Nell'ambiente di esecuzione, avvii la pipeline internamente con trigger o pianificazioni di Cloud Data Fusion oppure esternamente con strumenti di orchestrazione, come Cloud Composer. Per poter recuperare le configurazioni di runtime delle pipeline, esegui il backup delle pipeline e delle configurazioni, come plug-in e pianificazioni. In caso di interruzione, puoi utilizzare il backup per replicare un'istanza in una regione o zona non interessata.

Un altro modo per prepararsi alle interruzioni è avere più istanze nelle regioni con la stessa configurazione e lo stesso set di pipeline. Se utilizzi l'orchestrazione esterna, l'esecuzione delle pipeline può essere bilanciata automaticamente tra le istanze. Presta particolare attenzione per assicurarti che non ci siano risorse (come origini dati o strumenti di orchestrazione) associate a una singola regione e utilizzate da tutte le istanze, in quanto potrebbero diventare un punto centrale di errore in caso di interruzione. Ad esempio, puoi avere più istanze in regioni diverse e utilizzare Cloud Load Balancing e Cloud DNS per indirizzare le richieste di esecuzione della pipeline a un'istanza non interessata da un'interruzione (vedi le architetture di livello 1 e livello 3).

Interruzioni di altri servizi di dati Google Cloud nella pipeline

L'istanza potrebbe utilizzare altri servizi Google Cloud come origini dati o ambienti di esecuzione della pipeline, come Dataproc, Cloud Storage o BigQuery. Questi servizi possono trovarsi in regioni diverse. Quando è necessaria l'esecuzione tra regioni, un errore in una delle due regioni comporta un'interruzione. In questo scenario, segui la procedura di ripristino di emergenza standard, tenendo presente che la configurazione tra regioni con servizi critici in regioni diverse è meno resiliente.

Cloud Deploy

Cloud Deploy fornisce la distribuzione continua dei carichi di lavoro nei servizi di runtime come GKE e Cloud Run. Il servizio è composto da istanze regionali che replicano i dati in modo sincrono tra le zone all'interno della regione.

Interruzione zonale: le operazioni del control plane non sono interessate. Tuttavia, le build di Cloud Build (ad esempio, le operazioni di rendering o deployment) in esecuzione quando si verifica un errore in una zona vengono ritardate o perse definitivamente. Durante un'interruzione, la risorsa Cloud Deploy che ha attivato la build (una release o un rollout) mostra uno stato di errore che indica che l'operazione sottostante non è riuscita. Puoi ricreare la risorsa per avviare una nuova build nelle zone funzionanti rimanenti. Ad esempio, crea una nuova implementazione eseguendo nuovamente il deployment della release in un target.

Interruzione a livello di regione: le operazioni del control plane non sono disponibili, così come i dati di Cloud Deploy, finché la regione non viene ripristinata. Per semplificare il ripristino del servizio in caso di interruzione regionale, ti consigliamo di archiviare la pipeline di distribuzione e le definizioni dei target nel controllo del codice sorgente. Puoi utilizzare questi file di configurazione per ricreare le pipeline Cloud Deploy in una regione funzionante. Durante un'interruzione, i dati sulle uscite esistenti vengono persi. Crea una nuova release per continuare a eseguire il deployment del software nei target.

Cloud DNS

Cloud DNS è un servizio DNS (Domain Name System) globale, resiliente e ad alte prestazioni che pubblica i tuoi nomi di dominio nel DNS globale in modo conveniente.

In caso di interruzione di servizio a livello di zona, Cloud DNS continua a gestire le richieste provenienti da un'altra zona della stessa regione o di una regione diversa senza interruzioni. Gli aggiornamenti ai record Cloud DNS vengono replicati in modo sincrono tra le zone all'interno della regione in cui vengono ricevuti. Pertanto, non si verifica alcuna perdita di dati.

In caso di interruzione a livello di regione, Cloud DNS continua a gestire le richieste provenienti da altre regioni. È possibile che gli aggiornamenti molto recenti ai record Cloud DNS non siano disponibili perché gli aggiornamenti vengono prima elaborati in una singola regione prima di essere replicati in modo asincrono in altre regioni.

API Cloud Healthcare

L'API Cloud Healthcare, un servizio per l'archiviazione e la gestione dei dati sanitari, è progettata per fornire alta disponibilità e offre protezione da errori zonali e regionali, a seconda della configurazione scelta.