In diesem Dokument wird beschrieben, wie Sie das Verhalten, den Zustand und die Leistung Ihrer vollständig verwalteten Modelle in Vertex AI überwachen. Darin wird beschrieben, wie Sie das vordefinierte Dashboard zur Modellbeobachtung verwenden, um Einblicke in die Modellnutzung zu erhalten, Latenzprobleme zu identifizieren und Fehler zu beheben.

Sie lernen, wie Sie Folgendes tun:

- Auf das Dashboard zur Modellbeobachtbarkeit zugreifen und es interpretieren

- Verfügbare Monitoring-Messwerte ansehen

- Traffic für Modellendpunkte mit Metrics Explorer überwachen

Auf das Dashboard zur Modellbeobachtbarkeit zugreifen und es interpretieren

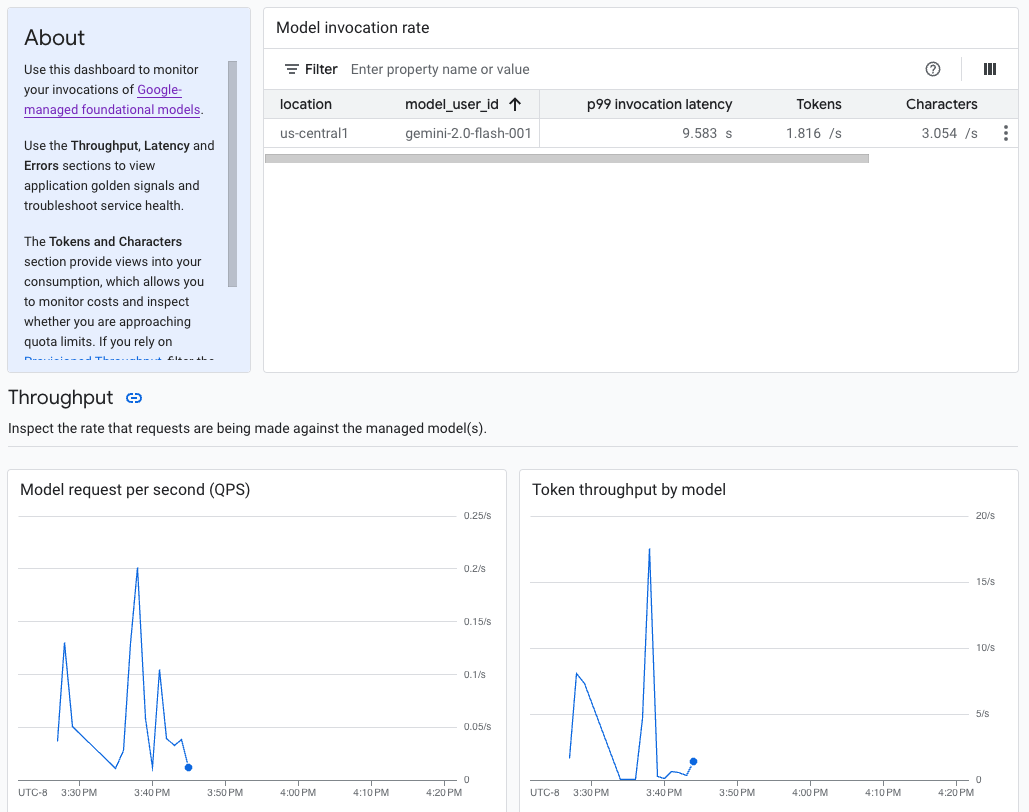

Generative AI in Vertex AI bietet ein vorgefertigtes Dashboard zur Modellbeobachtung, mit dem Sie das Verhalten, den Zustand und die Leistung vollständig verwalteter Modelle ansehen können. Vollständig verwaltete Modelle, auch als Model as a Service (MaaS) bezeichnet, werden von Google bereitgestellt und umfassen die Gemini-Modelle von Google und Partnermodelle mit verwalteten Endpunkten. Messwerte aus selbst gehosteten Modellen sind nicht im Dashboard enthalten.

Generative KI in Vertex AI erfasst und meldet automatisch Aktivitäten von MaaS-Modellen, damit Sie Latenzprobleme schnell beheben und die Kapazität überwachen können.

Anwendungsfall

Als Anwendungsentwickler können Sie sehen, wie Ihre Nutzer mit den von Ihnen bereitgestellten Modellen interagieren. So können Sie beispielsweise sehen, wie sich die Modellnutzung (Modellanfragen pro Sekunde) und die Rechenintensität von Nutzer-Prompts (Latenzen für den Modellaufruf) im Laufe der Zeit entwickeln. Da diese Messwerte mit der Modellnutzung zusammenhängen, können Sie auch die Kosten für die Ausführung der einzelnen Modelle schätzen.

Wenn ein Problem auftritt, können Sie es schnell über das Dashboard beheben. Sie können prüfen, ob Modelle zuverlässig und zeitnah reagieren, indem Sie sich die API-Fehlerraten, die Latenzen für das erste Token und den Token-Durchsatz ansehen.

Verfügbare Monitoring-Messwerte

Im Dashboard zur Modellbeobachtbarkeit wird eine Teilmenge der Messwerte angezeigt, die von Cloud Monitoring erfasst werden, z. B. Modellanfragen pro Sekunde (QPS), Token-Durchsatz und Latenzen für das erste Token. Dashboard ansehen

Beschränkungen

In Vertex AI werden Dashboard-Messwerte nur für API-Aufrufe an den Endpunkt eines Modells erfasst. Google Cloud Die Console-Nutzung, z. B. Messwerte aus Vertex AI Studio, wird dem Dashboard nicht hinzugefügt.

Dashboard aufrufen

Rufen Sie in der Google Cloud Console im Bereich „Vertex AI“ die Seite Dashboard auf.

Klicken Sie im Bereich Modellbeobachtbarkeit auf Alle Messwerte anzeigen, um das Dashboard zur Modellbeobachtbarkeit in der Google Cloud Observability Console aufzurufen.

Wenn Sie Messwerte für ein bestimmtes Modell oder an einem bestimmten Standort aufrufen möchten, legen Sie oben auf der Dashboardseite einen oder mehrere Filter fest.

Beschreibungen der einzelnen Messwerte finden Sie auf der Seite Google Cloud -Messwerte im Abschnitt „

aiplatform“.

Traffic von Modellendpunkten überwachen

Folgen Sie der Anleitung unten, um den Traffic zu Ihrem Endpunkt im Metrics Explorer zu beobachten.

Rufen Sie in der Google Cloud Console die Seite Metrics Explorer auf.

Wählen Sie das Projekt aus, für das Sie Messwerte aufrufen möchten.

Klicken Sie im Drop-down-Menü Messwert auf Messwert auswählen.

Geben Sie in der Suchleiste Nach Ressourcen- oder Messwertname filtern den Wert

Vertex AI Endpointein.Wählen Sie die Messwertkategorie Vertex AI-Endpunkt > Vorhersage aus. Wählen Sie unter Aktive Messwerte einen der folgenden Messwerte aus:

prediction/online/error_countprediction/online/prediction_countprediction/online/prediction_latenciesprediction/online/response_count

Klicken Sie auf Übernehmen. Wenn Sie mehrere Messwerte hinzufügen möchten, klicken Sie auf Abfrage hinzufügen.

Sie können Ihre Messwerte mit den folgenden Drop-down-Menüs filtern oder zusammenfassen:

Wenn Sie eine Teilmenge Ihrer Daten anhand bestimmter Kriterien auswählen und ansehen möchten, verwenden Sie das Drop-down-Menü Filter. Wenn Sie beispielsweise nach dem Modell

gemini-2.0-flash-001filtern möchten, verwenden Sieendpoint_id = gemini-2p0-flash-001. Beachten Sie, dass die.in der Modellversion durch einpersetzt wird.Wenn Sie mehrere Datenpunkte zu einem einzelnen Wert zusammenfassen und eine zusammengefasste Ansicht Ihrer Messwerte aufrufen möchten, verwenden Sie das Drop-down-Menü Aggregation. Sie können beispielsweise die Summe von

response_codeaggregieren.

Optional können Sie Benachrichtigungen für Ihren Endpunkt einrichten. Weitere Informationen finden Sie unter Benachrichtigungsrichtlinien verwalten.

Informationen zum Ansehen der Messwerte, die Sie Ihrem Projekt über ein Dashboard hinzufügen, finden Sie unter Dashboards – Übersicht.

Nächste Schritte

- Informationen zum Erstellen von Benachrichtigungen für Ihr Dashboard finden Sie unter Benachrichtigungen – Übersicht.

- Informationen zur Aufbewahrung von Messwertdaten finden Sie unter Monitoring-Kontingente und -Limits.

- Weitere Informationen zu ruhenden Daten finden Sie unter Ruhende Daten schützen.

- Eine Liste aller Messwerte, die von Cloud Monitoring erfasst werden, finden Sie im Abschnitt „

aiplatform“ auf der Seite Google Cloud -Messwerte.