Auf dieser Seite wird erläutert, wie Sie die Antworten eines Modells mit der Google Suche fundieren können. Dabei werden öffentlich verfügbare Webdaten verwendet. Außerdem werden Suchvorschläge erläutert, die in Ihren Antworten enthalten sind.

Fundierung mit der Google Suche

Wenn Sie Ihr Modell mit dem Wissen der ganzen Welt, einer Vielzahl von Themen oder aktuellen Informationen im Internet verknüpfen möchten, verwenden Sie die Fundierung mit der Google Suche.

Weitere Informationen zur Fundierung in Vertex AI finden Sie im Fundierungs-Überblick.

Unterstützte Modelle

In diesem Abschnitt sind die Modelle aufgeführt, die Grounding mit der Suche unterstützen.

- Gemini 2.5 Flash (Vorschau)

- Gemini 2.5 Flash-Lite (Vorschau)

- Gemini 2.5 Flash-Lite

- Gemini 2.5 Flash mit nativer Audio-Live-API (Vorabversion)

- Gemini 2.0 Flash mit Live API (Vorschau)

- Gemini 2.5 Pro

- Gemini 2.5 Flash

- Gemini 2.0 Flash

Unterstützte Sprachen

Eine Liste der unterstützten Sprachen finden Sie unter Sprachen.

Modell mit der Google Suche fundieren

Folgen Sie der nachstehenden Anleitung, um ein Modell mit öffentlich verfügbaren Webdaten zu fundieren.

Hinweise

Wenn Sie die Fundierung mit der Google Suche verwenden möchten, müssen Sie die Google-Suchvorschläge aktivieren. Weitere Informationen finden Sie unter Google-Suchvorschläge verwenden.

Die besten Ergebnisse erzielen Sie mit einer Temperatur von

1.0. Weitere Informationen zum Festlegen dieser Konfiguration finden Sie unter Gemini API-Anfragetext in der Modellreferenz.Die Fundierung mit der Google Suche ist auf eine Million Abfragen pro Tag beschränkt. Wenn Sie mehr Anfragen benötigen, wenden Sie sich an denGoogle Cloud -Support.

Suchergebnisse können für einen bestimmten geografischen Standort des Endnutzers angepasst werden, indem die Koordinaten für Breiten- und Längengrad verwendet werden. Weitere Informationen finden Sie in der Grounding API.

Console

So verwenden Sie die Fundierung mit der Google Suche mit Vertex AI Studio:

- Rufen Sie in der Google Cloud Console die Seite Vertex AI Studio auf.

- Klicken Sie auf den Tab Freies Format.

- Klicken Sie in der Seitenleiste auf den Schalter Antworten des Ground Models.

- Klicken Sie auf Anpassen und legen Sie die Google Suche als Quelle fest.

- Geben Sie Ihren Prompt in das Textfeld ein und klicken Sie auf Senden.

Ihre Prompt-Antworten werden jetzt in der Google Suche fundiert.

Python

Installieren

pip install --upgrade google-genai

Weitere Informationen finden Sie in der SDK-Referenzdokumentation.

Umgebungsvariablen für die Verwendung des Gen AI SDK mit Vertex AI festlegen:

# Replace the `GOOGLE_CLOUD_PROJECT` and `GOOGLE_CLOUD_LOCATION` values # with appropriate values for your project. export GOOGLE_CLOUD_PROJECT=GOOGLE_CLOUD_PROJECT export GOOGLE_CLOUD_LOCATION=global export GOOGLE_GENAI_USE_VERTEXAI=True

Go

Informationen zum Installieren oder Aktualisieren von Go

Weitere Informationen finden Sie in der SDK-Referenzdokumentation.

Umgebungsvariablen für die Verwendung des Gen AI SDK mit Vertex AI festlegen:

# Replace the `GOOGLE_CLOUD_PROJECT` and `GOOGLE_CLOUD_LOCATION` values # with appropriate values for your project. export GOOGLE_CLOUD_PROJECT=GOOGLE_CLOUD_PROJECT export GOOGLE_CLOUD_LOCATION=global export GOOGLE_GENAI_USE_VERTEXAI=True

Java

Informationen zum Installieren oder Aktualisieren von Java

Weitere Informationen finden Sie in der SDK-Referenzdokumentation.

Umgebungsvariablen für die Verwendung des Gen AI SDK mit Vertex AI festlegen:

# Replace the `GOOGLE_CLOUD_PROJECT` and `GOOGLE_CLOUD_LOCATION` values # with appropriate values for your project. export GOOGLE_CLOUD_PROJECT=GOOGLE_CLOUD_PROJECT export GOOGLE_CLOUD_LOCATION=global export GOOGLE_GENAI_USE_VERTEXAI=True

REST

Ersetzen Sie diese Werte in den folgenden Anfragedaten:

- LOCATION: Die Region, in der die Anfrage verarbeitet werden soll. Wenn Sie den globalen Endpunkt verwenden möchten, schließen Sie den Standort aus dem Endpunktnamen aus und konfigurieren Sie den Standort der Ressource auf „global“.

- PROJECT_ID: Ihre Projekt-ID.

- MODEL_ID: Die Modell-ID des multimodalen Modells.

- TEXT: Die Textanleitung, die in den Prompt eingefügt werden soll.

- EXCLUDE_DOMAINS (optional): Liste der Domains, die nicht zum Fundieren verwendet werden sollen.

- LATITUDE: Optional: Der Breitengrad des Standorts des Endnutzers. Ein Breitengrad von

37.7749steht beispielsweise für San Francisco. Sie können Breiten- und Längengradkoordinaten über Dienste wie Google Maps oder andere Geocoding-Tools abrufen. - LONGITUDE: Optional: Der Längengrad des Standorts des Endnutzers. Ein Längengrad von

-122.4194entspricht beispielsweise San Francisco.

HTTP-Methode und URL:

POST https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/MODEL_ID:generateContent

JSON-Text anfordern:

{

"contents": [{

"role": "user",

"parts": [{

"text": "TEXT"

}]

}],

"tools": [{

"googleSearch": {

"exclude_domains": [ "domain.com", "domain2.com" ]

}

}],

"toolConfig": {

"retrievalConfig": {

"latLng": {

"latitude": LATITUDE,

"longitude": LONGITUDE

}

}

},

"model": "projects/PROJECT_ID/locations/LOCATION/publishers/google/models/MODEL_ID"

}

Wenn Sie die Anfrage senden möchten, maximieren Sie eine der folgenden Optionen:

Sie sollten eine JSON-Antwort ähnlich wie diese erhalten:

{

"candidates": [

{

"content": {

"role": "model",

"parts": [

{

"text": "The weather in Chicago this weekend, will be partly cloudy. The temperature will be between 49°F (9°C) and 55°F (13°C) on Saturday and between 51°F (11°C) and 56°F (13°C) on Sunday. There is a slight chance of rain on both days.\n"

}

]

},

"finishReason": "STOP",

"groundingMetadata": {

"webSearchQueries": [

"weather in Chicago this weekend"

],

"searchEntryPoint": {

"renderedContent": "..."

},

"groundingChunks": [

{

"web": {

"uri": "https://www.google.com/search?q=weather+in+Chicago,+IL",

"title": "Weather information for locality: Chicago, administrative_area: IL",

"domain": "google.com"

}

},

{

"web": {

"uri": "...",

"title": "weatherbug.com",

"domain": "weatherbug.com"

}

}

],

"groundingSupports": [

{

"segment": {

"startIndex": 85,

"endIndex": 214,

"text": "The temperature will be between 49°F (9°C) and 55°F (13°C) on Saturday and between 51°F (11°C) and 56°F (13°C) on Sunday."

},

"groundingChunkIndices": [

0

],

"confidenceScores": [

0.8662828

]

},

{

"segment": {

"startIndex": 215,

"endIndex": 261,

"text": "There is a slight chance of rain on both days."

},

"groundingChunkIndices": [

1,

0

],

"confidenceScores": [

0.62836814,

0.6488607

]

}

],

"retrievalMetadata": {}

}

}

],

"usageMetadata": {

"promptTokenCount": 10,

"candidatesTokenCount": 98,

"totalTokenCount": 108,

"trafficType": "ON_DEMAND",

"promptTokensDetails": [

{

"modality": "TEXT",

"tokenCount": 10

}

],

"candidatesTokensDetails": [

{

"modality": "TEXT",

"tokenCount": 98

}

]

},

"modelVersion": "gemini-2.0-flash",

"createTime": "2025-05-19T14:42:55.000643Z",

"responseId": "b0MraIMFoqnf-Q-D66G4BQ"

}

Ihre Antwort verstehen

Wenn Ihr Modell-Prompt von Vertex AI Studio oder der API erfolgreich bei der Google Suche fundiert wird, enthalten die Antworten Metadaten mit Quelllinks (Web-URLs). Es gibt jedoch mehrere Gründe, warum diese Metadaten möglicherweise nicht bereitgestellt werden und die Prompt-Antwort nicht fundiert wird. Dazu gehören eine geringe Relevanz der Quelle oder unvollständige Informationen in der Antwort des Modells.

Unterstützung bei der Fundierung

Die Anzeige von Fundierungsunterstützung ist erforderlich, da sie Ihnen hilft, die Antworten der Publisher zu validieren, und Möglichkeiten zum weiteren Lernen bietet.

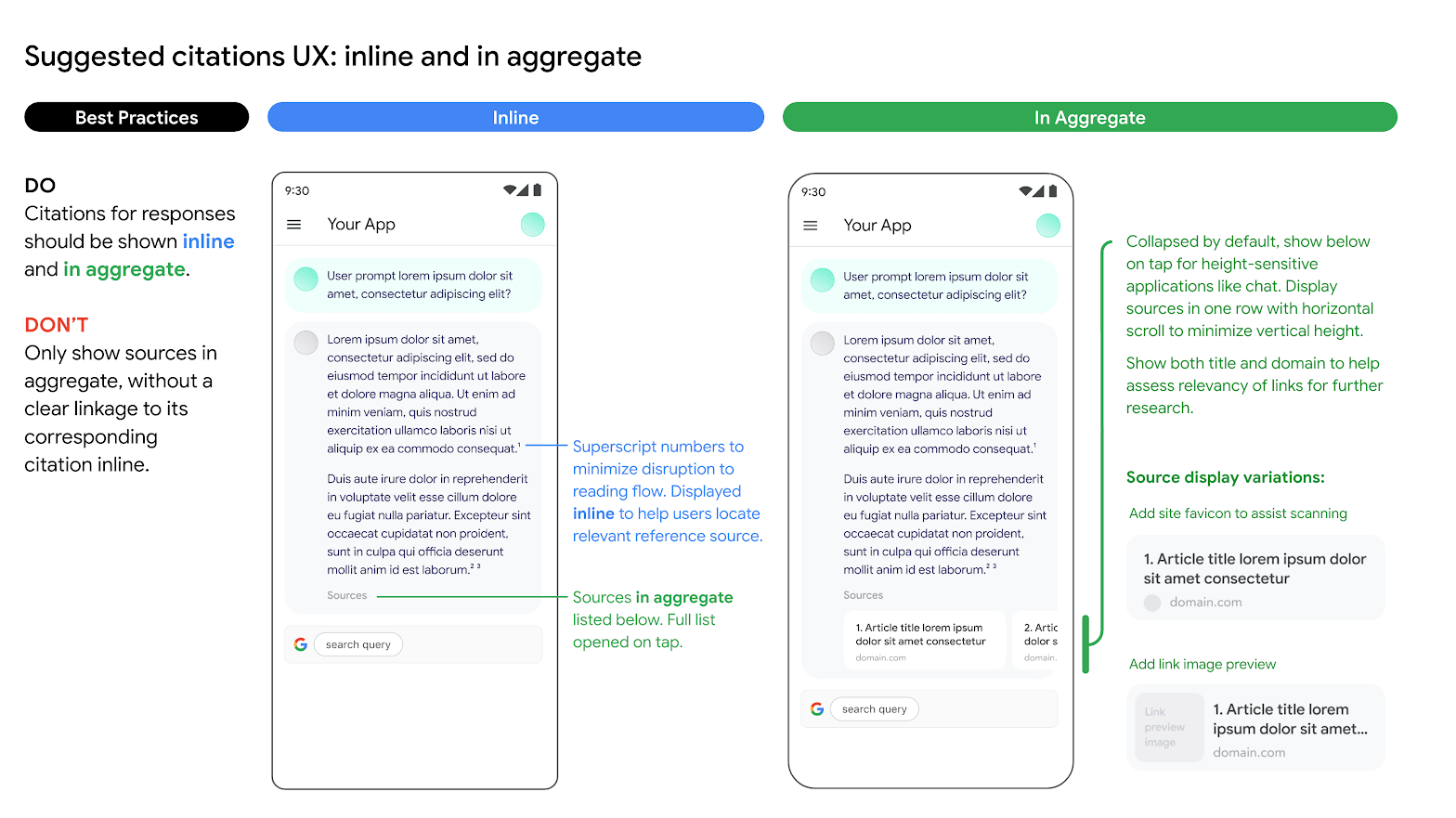

Die Fundierung von Antworten aus Quellen der Google Suche sollte sowohl inline als auch aggregiert angezeigt werden. In der folgenden Abbildung sehen Sie einen Vorschlag dafür.

Verwendung alternativer Suchmaschinenoptionen

Bei der Verwendung der Fundierung mit der Google Suche kann eine Kundenanwendung:

- Bieten Sie alternative Suchmaschinenoptionen an.

- andere Suchmaschinen als Standard festlegen

- Eigene oder Suchvorschläge oder Suchergebnisse von Drittanbietern anzeigen, sofern alle Nicht-Google-Ergebnisse getrennt von den fundierten Ergebnissen und Suchvorschlägen von Google angezeigt werden und so präsentiert werden, dass Nutzer nicht verwirrt werden oder der Eindruck entsteht, dass sie von Google stammen.

Vorteile

Die folgenden komplexen Prompts und Workflows, die Planung, Argumentation und Überlegung erfordern, können ausgeführt werden, wenn Sie die Google Suche als Tool verwenden:

- Sie können die Antworten auf aktuelle und genaue Informationen stützen.

- Sie können Artefakte aus dem Web abrufen, um Analysen durchzuführen.

- Sie können relevante Bilder, Videos oder andere Medien finden, die beim multimodalen Reasoning oder bei der Aufgabengenerierung helfen.

- Sie können Programmierung, technische Fehlerbehebung und andere spezielle Aufgaben ausführen.

- Sie können regionsspezifische Informationen finden oder bei der genauen Übersetzung von Inhalten helfen.

- Sie können relevante Websites zum Surfen finden.

Google-Suchvorschläge verwenden

Wenn Sie die Fundierung mit der Google Suche verwenden und Suchvorschläge in Ihrer Antwort erhalten, müssen Sie die Suchvorschläge in der Produktion und in Ihren Anwendungen anzeigen.

Weitere Informationen zur Fundierung mit der Google Suche finden Sie unter Fundierung mit der Google Suche.

Sie müssen insbesondere die Suchanfragen anzeigen, die in den Metadaten der fundierten Antwort enthalten sind. Die Antwort enthält:

"content": Von LLM generierte Antwort."webSearchQueries": Die Abfragen, die für Suchvorschläge verwendet werden sollen.

Im folgenden Code-Snippet antwortet Gemini beispielsweise auf eine auf der Google Suche basierende Eingabeaufforderung, in der nach einer Art tropischer Pflanze gefragt wird.

"predictions": [

{

"content": "Monstera is a type of vine that thrives in bright indirect light…",

"groundingMetadata": {

"webSearchQueries": ["What's a monstera?"],

}

}

]

Sie können diese Ausgabe über Suchvorschläge anzeigen lassen.

Anforderungen für Suchvorschläge

Für Vorschläge gelten die folgenden Anforderungen:

| Anforderung | Beschreibung |

|---|---|

| Das sollten Sie tun: |

|

| Was Sie nicht tun sollten |

|

Displayanforderungen

Es gelten die folgenden Anforderungen für die Darstellung:

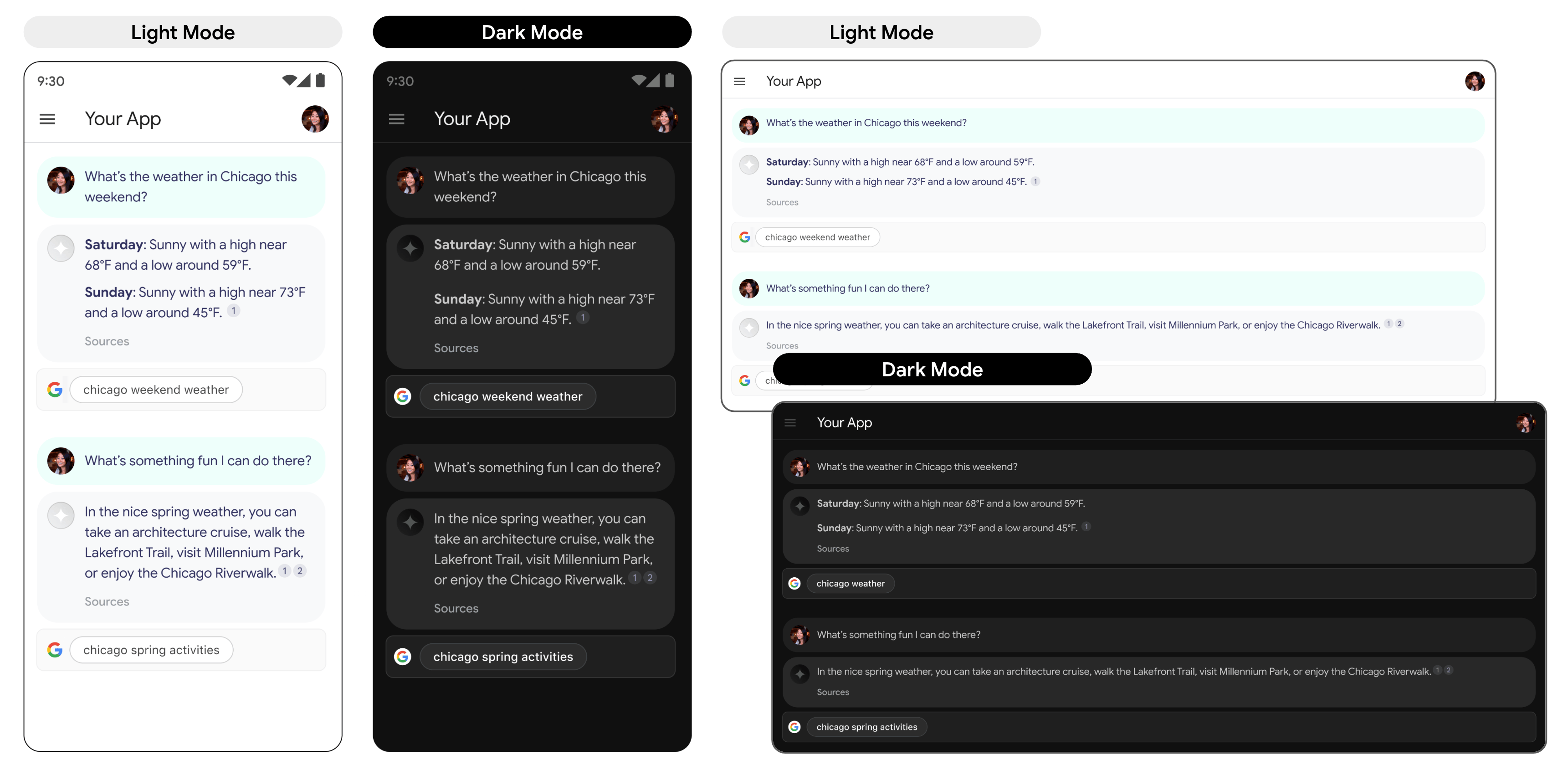

- Zeigen Sie den Suchvorschlag genau wie angegeben an und nehmen Sie keine Änderungen an Farben, Schriftarten oder Darstellung vor. Achten Sie darauf, dass der Suchvorschlag wie in den folgenden Modellen angegeben gerendert wird, einschließlich des hellen und des dunklen Modus:

- Bei der Anzeige einer fundierten Antwort sollte der entsprechende Suchvorschlag sichtbar bleiben.

- Beim Branding müssen Sie die Google-Richtlinien für die Verwendung von Google-Markenkennzeichen durch Dritte einhalten.

- Wenn Sie die Fundierung mit der Google Suche verwenden, werden Chips mit Suchvorschlägen angezeigt. Das Feld mit den Vorschlags-Chips muss dieselbe Breite wie die fundierte Antwort des LLM haben.

Verhalten beim Tippen

Wenn ein Nutzer auf den Chip tippt, wird er direkt zur Suchergebnisseite (SRP) für den im Chip angezeigten Suchbegriff weitergeleitet. Die SRP kann entweder im App-Browser oder in einer separaten Browseranwendung geöffnet werden. Es ist wichtig, die Anzeige der SRP in irgendeiner Weise nicht zu minimieren, zu entfernen oder zu verdecken. Das folgende animierte Modell veranschaulicht die Interaktion zwischen dem Tippen und SRP.

Code zum Implementieren eines Suchvorschlags

Wenn Sie die API verwenden, um eine Suchantwort zu fundieren, stellt die Modellantwort konforme HTML- und CSS-Stile im Feld renderedContent bereit, die Sie zum Anzeigen von Suchvorschlägen in Ihrer Anwendung implementieren.

Nächste Schritte

- Weitere Informationen zur Fundierung finden Sie unter Fundierungsübersicht.

- Informationen zum Senden von Anfragen für Chat-Prompts finden Sie unter Mehrere Antworten in einem Chat.

- Weitere Informationen zu Best Practices für verantwortungsbewusste KI und den Sicherheitsfiltern von Vertex AI finden Sie unter Best Practices für Sicherheit.

- Weitere Informationen zum Senden von Anfragen für Chat-Prompt-Anfragen

- Verantwortungsbewusste Best Practices für KI und Vertex AI-Sicherheitsfilter