Cet article fait partie d'une série qui traite de la reprise après sinistre (DR, Disaster Recovery) dans Google Cloud. Cette partie aborde le processus de conception de charges de travail à l'aide de Google Cloud et la création de composants résilients aux pannes d'infrastructure cloud.

La série comprend les éléments suivants :

- Guide de planification de reprise après sinistre

- Structure de la reprise après sinistre

- Scénarios de reprise après sinistre pour les données

- Scénarios de reprise après sinistre pour les applications

- Concevoir une solution de reprise après sinistre pour des charges de travail limitées à la localité

- Cas d'utilisation de reprise après sinistre : applications d'analyse de données limitées à la localité

- Concevoir une solution de reprise après sinistre pour les pannes d'infrastructure cloud (ce document)

Introduction

Pour migrer des charges de travail sur le cloud public, les entreprises doivent transposer leur savoir concernant la création de systèmes sur site résilients vers l'infrastructure hyperscale de fournisseurs cloud tels que Google Cloud. Cet article mappe les concepts de reprise après sinistre standards dans l'industrie, tels que l'objectif de temps de récupération (RTO) et l'objectif de point de récupération (RPO), à l'infrastructure Google Cloud.

Les conseils fournis dans ce document respectent l'un des principes clés de Google garantissant une très haute disponibilité des services : la planification contre les défaillances. Bien queGoogle Cloud fournisse un service extrêmement fiable, des sinistres peuvent survenir (catastrophes naturelles, ruptures de fibre et défaillances d'infrastructure imprévisibles et complexes), causant ainsi des pannes. La planification contre les pannes permet aux clientsGoogle Cloud de créer des applications qui fonctionnent de manière prévisible lors de ces événements inévitables, en utilisant des produits Google Cloud intégrant des mécanismes de reprise après sinistre.

La reprise après sinistre est un sujet vaste qui couvre bien plus que les défaillances d'infrastructure telles que les bugs logiciels ou la corruption de données. C'est pourquoi vous devez disposer d'un plan complet de bout en bout. Toutefois, cet article ne se concentre que sur une partie d'un plan de reprise après sinistre global, à savoir la conception d'applications résilientes aux pannes d'infrastructure cloud. Plus précisément, cet article décrit les éléments suivants :

- L'infrastructure Google Cloud , la façon dont les sinistres se manifestent en cas de pannesGoogle Cloud , ainsi que la manière dont Google Cloud est conçu pour minimiser la fréquence et l'étendue des pannes.

- Un guide de planification de l'architecture qui fournit un framework permettant de catégoriser et de concevoir des applications en fonction des résultats de fiabilité souhaités.

- La liste détaillée d'une sélection de produits Google Cloud proposant des fonctionnalités intégrées de reprise après sinistre que vous souhaiterez peut-être utiliser dans votre application.

Pour en savoir plus sur la planification générale de la reprise après sinistre et sur l'utilisation de Google Cloud en tant que composant de votre stratégie de reprise après sinistre sur site, consultez le guide de planification de reprise après sinistre. Bien que la haute disponibilité soit un concept étroitement lié à la reprise après sinistre, elle n'est pas traitée dans cet article. Pour en savoir plus sur la conception d'une architecture à haute disponibilité, consultez le framework Well-Architected.

Remarque sur la terminologie : dans cet article, le terme disponibilité désigne la capacité d'un produit à être accessible et utilisé de manière significative au fil du temps, tandis que le terme fiabilité désigne un ensemble d'attributs incluant la disponibilité ainsi que des éléments tels que la durabilité et l'exactitude.

Conception de Google Cloud pour la résilience

Centres de données Google

Les centres de données traditionnels visent à maximiser la disponibilité des composants individuels. Dans le cloud, le scaling permet à des opérateurs tels que Google de déployer des services sur de nombreux composants grâce à des technologies de virtualisation, allant ainsi au-delà de la fiabilité traditionnelle des composants. Cela signifie que vous pouvez changer votre approche en matière d'architecture de fiabilité et arrêter de vous focaliser sur les nombreux détails qui vous préoccupaient autrefois dans les environnements sur site. Plutôt que de vous soucier des différents modes de défaillance des composants (tels que le refroidissement et l'alimentation), vous pouvez baser votre planification sur les produits Google Cloud et leurs métriques de fiabilité annoncées. Ces métriques reflètent le risque de panne agrégé dans toute l'infrastructure sous-jacente. Vous pouvez ainsi vous concentrer davantage sur la conception, le déploiement et les opérations des applications plutôt que sur la gestion de l'infrastructure.

Google conçoit son infrastructure pour atteindre des objectifs de disponibilité ambitieux basés sur une vaste expérience dans les domaines de la création et de l'exploitation de centres de données modernes. Google est un leader mondial dans la conception de centres de données. De l'alimentation au refroidissement en passant par les réseaux, chaque technologie de centre de données dispose de ses propres redondances et mesures d'atténuation, y compris les plans FMEA. Les centres de données de Google sont conçus de manière à équilibrer ces nombreux risques différents et à présenter aux clients un niveau de disponibilité attendu cohérent pour les produits Google Cloud . Nous nous appuyons sur notre expérience pour modéliser la disponibilité de l'architecture globale du système physique et logique, et ainsi nous assurer que la conception des centres de données répond aux attentes. Les ingénieurs de Google déploient de nombreux efforts pour s'assurer que ces attentes sont satisfaites. La disponibilité réelle mesurée surpasse généralement de loin nos objectifs de conception.

En injectant l'ensemble de ces risques et mesures d'atténuation de centre de données dans les produits destinés aux utilisateurs, Google Cloud vous libère des responsabilités liées à la conception et à l'exploitation. À la place, vous pouvez vous concentrer sur la fiabilité intégrée aux régions et aux zonesGoogle Cloud .

Régions et zones

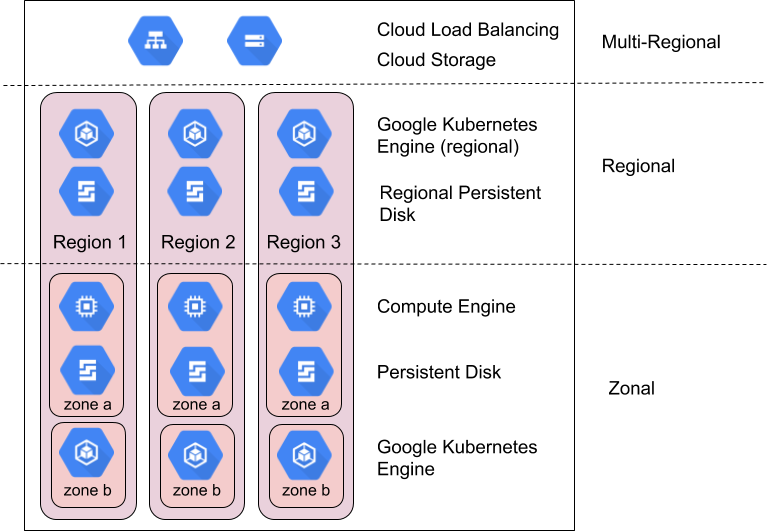

Les régions correspondent à des espaces géographiques indépendants qui sont constitués de zones. Les zones et les régions sont des abstractions logiques des ressources physiques sous-jacentes. Pour en savoir plus sur les considérations spécifiques à la région, consultez Zones géographiques et régions.

Les produitsGoogle Cloud sont divisés en ressources zonales, régionales ou multirégionales.

Les ressources zonales sont hébergées dans une seule zone. Une interruption de service dans la zone peut affecter toutes les ressources de cette zone. Prenons l'exemple d'une instance Compute Engine qui s'exécute dans une seule zone spécifiée. Si une défaillance matérielle cause l'arrêt du service dans cette zone, l'instance Compute Engine est indisponible pendant toute la durée de l'interruption.

Les ressources régionales sont déployées de façon redondante dans plusieurs zones d'une même région. Elles offrent ainsi une fiabilité plus élevée que les ressources zonales.

Les ressources multirégionales sont distribuées au sein des régions et entre elles. En général, les ressources multirégionales présentent une fiabilité plus élevée que les ressources régionales. À ce niveau, toutefois, les produits doivent optimiser la disponibilité, les performances et l'efficacité des ressources. Par conséquent, il est important de comprendre les compromis réalisés par chaque produit multirégional que vous décidez d'utiliser. Ces compromis sont décrits plus en détail dans la suite de ce document.

Exploiter les zones et les régions pour améliorer la fiabilité

Les ingénieurs SRE de Google gèrent et font évoluer des produits utilisateur hautement fiables et mondiaux, tels que Gmail et la recherche Google, à l'aide de diverses techniques et technologies qui exploitent de manière fluide l'infrastructure informatique du monde entier. Cela inclut la redirection du trafic depuis des emplacements indisponibles via l'équilibrage de charge global, l'exécution de plusieurs instances dupliquées dans de nombreux emplacements à travers le monde et la réplication des données entre les emplacements. Ces fonctionnalités sont disponibles pour les clients Google Cloudpar l'intermédiaire de produits tels que Cloud Load Balancing, Google Kubernetes Engine (GKE) et Spanner.

Google Cloud conçoit généralement les produits pour qu'ils offrent les niveaux de disponibilité suivants pour les zones et les régions :

| Ressource | Exemples | Objectif de conception de disponibilité | Temps d'arrêt implicite |

|---|---|---|---|

| Zonal | Compute Engine, Persistent Disk | 99,9 % | 8,75 heures/an |

| Régional | Cloud Storage régional, Persistent Disk (répliqué), GKE régional | 99,99 % | 52 minutes/an |

Comparez les objectifs de conception de disponibilité Google Cloud avec le temps d'arrêt que vous jugez acceptable pour identifier les ressources Google Cloud appropriées. Bien que les conceptions traditionnelles visent à améliorer la disponibilité au niveau des composants pour augmenter la disponibilité des applications résultantes, les modèles cloud se focalisent à la place sur la composition des composants pour atteindre cet objectif. De nombreux produits au sein deGoogle Cloud emploient cette technique. Par exemple, Spanner propose une base de données multirégionale qui compose plusieurs régions afin de fournir une disponibilité de 99,999 %.

La composition est importante, car sans elle, la disponibilité de votre application ne peut pas surpasser celle des produits Google Cloud que vous utilisez. En fait, à moins que votre application ne rencontre jamais de défaillance, sa disponibilité est inférieure à celle des produitsGoogle Cloud sous-jacents. Le reste de cette section explique de façon générale comment utiliser une composition de produits zonaux et régionaux pour obtenir une disponibilité d'application plus élevée qu'avec une seule zone ou région. La section suivante présente un guide pratique pour la mise en œuvre de ces principes dans vos applications.

Planification pour les pannes zonales

Les défaillances d'infrastructure entraînent généralement des interruptions de service dans une seule zone. Dans une région, les zones sont conçues pour minimiser le risque de pannes corrélées avec d'autres zones. Une interruption de service dans une zone n'affecte généralement pas le service d'une autre zone de la même région. Une panne limitée à une zone ne signifie pas nécessairement que la zone entière est indisponible ; cela définit simplement la limite de l'incident. Il est possible qu'une panne zonale n'ait aucun effet concret sur vos ressources spécifiques de cette zone.

Bien qu'il s'agisse d'un scénario plus rare, il est également essentiel de noter que plusieurs zones subiront à un moment donné une panne corrélée au sein d'une même région. Lorsque deux zones ou plus subissent une panne, la stratégie ci-dessous s'applique pour l'étendue de panne régionale.

Les ressources régionales sont conçues pour résister aux pannes zonales en distribuant le service à partir d'une composition de plusieurs zones. Si l'une des zones qui supportent la ressource régionale est interrompue, la ressource devient automatiquement disponible depuis une autre zone. Consultez attentivement la description des fonctionnalités produit dans l'annexe pour obtenir plus de détails.

Google Cloud ne propose que quelques ressources zonales, à savoir les machines virtuelles (VM) Compute Engine et les disques persistants. Si vous prévoyez d'utiliser des ressources zonales, vous devrez effectuer votre propre composition de ressources en concevant, en créant et en testant le basculement et la reprise entre des ressources zonales situées dans plusieurs zones. Voici quelques exemples de stratégies :

- Acheminez rapidement votre trafic vers des machines virtuelles d'une autre zone à l'aide de Cloud Load Balancing lorsqu'une vérification d'état détermine qu'une zone rencontre des problèmes.

- Utilisez des modèles d'instances Compute Engine et/ou des groupes d'instances gérés pour exécuter et faire évoluer des instances de VM identiques dans plusieurs zones.

- Utilisez un disque persistant régional pour répliquer les données de manière synchrone vers une autre zone d'une région. Consultez la page Options de haute disponibilité avec des disques persistants régionaux pour en savoir plus.

Planifier l'étendue des défaillances régionales

Une panne régionale est une interruption de service qui affecte plusieurs zones d'une même région. Ces pannes sont plus importantes et moins fréquentes, et peuvent être causées par des catastrophes naturelles ou des défaillances d'infrastructure à grande échelle.

Pour un produit régional conçu pour offrir une disponibilité de 99,99 %, une panne peut tout de même provoquer presque une heure de temps d'arrêt chaque année pour un produit donné. Par conséquent, vos applications critiques peuvent nécessiter la mise en œuvre d'un plan de reprise après sinistre multirégional si cette durée d'interruption est inacceptable.

Les ressources multirégionales sont conçues pour résister aux pannes régionales en distribuant le service à partir de plusieurs régions. Comme décrit ci-dessus, les produits multirégionaux offrent un compromis entre la latence, la cohérence et les coûts. Le compromis le plus courant se situe au niveau des réplications synchrone et asynchrone des données. La réplication asynchrone fournit une latence inférieure, mais inclut un risque de perte de données en cas de panne. Il est donc important de consulter la description des fonctionnalités produit dans l'annexe pour plus de détails.

Si vous souhaitez utiliser des ressources régionales tout en conservant une résilience aux pannes régionales, vous devez effectuer votre propre composition de ressources en concevant, en créant et en testant leur basculement et leur reprise entre des ressources régionales situées dans plusieurs régions. Outre les stratégies zonales décrites ci-dessus, que vous pouvez également appliquer aux régions, tenez compte des points suivants :

- Les ressources régionales doivent répliquer les données dans une région secondaire, dans une option de stockage multirégional telle que Cloud Storage, ou dans une option de cloud hybride telle que GKE Entreprise.

- Une fois que vous avez mis en place un système d'atténuation des pannes régionales, testez-le régulièrement. En effet, il n'y a rien de pire que de se croire résilient à une panne régionale, pour ensuite constater que ce n'est pas le cas en situation réelle.

Approche de résilience et de disponibilité deGoogle Cloud

Google Cloud surpasse régulièrement ses objectifs de conception de disponibilité, mais ne partez pas du principe que ces solides performances passées représentent la disponibilité minimale que vous pouvez concevoir. Sélectionnez plutôt les dépendances Google Cloud dont les objectifs de conception surpassent la fiabilité souhaitée pour votre application, de sorte que le temps d'arrêt de votre application et le temps d'arrêt de Google Cloud fournissent le résultat escompté.

Un système bien conçu peut répondre à la question suivante : "Que se passe-t-il lorsqu'une zone ou une région subit une panne de 1, 5, 10 ou 30 minutes ?" Cette question, ainsi que les questions suivantes, doivent être prises en compte au niveau de nombreuses couches :

- Quel est l'impact d'une panne pour mes clients ?

- Comment détecter une panne ?

- Qu'advient-il de mon application en cas de panne ?

- Qu'advient-il de mes données en cas de panne ?

- Qu'advient-il de mes autres applications lors d'une panne (en raison des dépendances croisées) ?

- Comment effectuer une reprise une fois la panne résolue ? Qui se charge de ce processus ?

- Qui informer d'une panne et dans quel délai ?

Guide par étapes sur la conception de la reprise après sinistre pour les applications dans Google Cloud

Dans les sections précédentes, vous avez découvert la façon dont Google conçoit une infrastructure cloud ainsi que quelques approches employées pour gérer les pannes zonales et régionales.

Cette section vous aide à développer un framework permettant d'appliquer le principe de composition à vos applications en fonction des résultats de fiabilité souhaités.

Les applications clientes dans Google Cloud qui ciblent des objectifs de reprise après sinistre tels que le RTO et le RPO doivent être conçues de manière à ce que les opérations critiques pour l'entreprise, soumises au RTO/RPO, ne dépendent que des composants du plan de données responsables du traitement continu des opérations pour le service. En d'autres termes, ces opérations critiques pour les entreprises clientes ne doivent pas dépendre des opérations du plan de gestion, qui gèrent l'état de la configuration et transfèrent la configuration au plan de contrôle et au plan de données.

Par exemple,les clients Google Cloud qui souhaitent atteindre un objectif RTO pour les opérations critiques ne doivent pas dépendre d'une API de création de VM ni de la mise à jour d'une autorisation IAM.

Étape 1 : Rassembler les exigences existantes

La première étape consiste à définir les exigences de disponibilité de vos applications. La plupart des entreprises reçoivent déjà dans une certaine mesure des conseils de conception dans cet espace, qui peuvent être développés ou dérivés en interne à partir de réglementations ou d'autres obligations légales. Ces conseils de conception sont généralement codifiés par deux métriques clés : l'objectif de temps de récupération (RTO) et l'objectif de point de récupération (RPO). Dans le langage d'affaires, la métrique RTO se traduit par "Combien de temps me faut-il pour redevenir opérationnel après un sinistre ?". La métrique RPO, quant à elle, se traduit par "Quelle quantité de données puis-je me permettre de perdre en cas de sinistre ?".

Par le passé, les entreprises ont défini des exigences en matière de RTO et de RPO pour un grand nombre de sinistres allant des défaillances de composants jusqu'aux séismes. Cette démarche était logique dans un monde sur site où les planificateurs devaient mapper les exigences en matière de RTO/RPO via l'ensemble de la pile logicielle et matérielle. Dans le cloud, vous n'avez plus besoin de définir vos exigences de manière aussi détaillée, car le fournisseur s'en charge. À la place, vous pouvez définir vos exigences en matière de RTO et de RPO en fonction de l'étendue de la perte (zones ou régions entières), sans spécifier de raisons sous-jacentes. Pour Google Cloud , cela réduit votre rassemblement des exigences à trois scénarios : panne zonale, panne régionale, ou panne extrêmement improbable de plusieurs régions.

Sachant que toutes les applications n'ont pas la même importance, la plupart des clients catégorisent leurs applications en niveaux de criticité auxquels appliquer une exigence RTO/RPO spécifique. Lorsqu'elles sont combinées, les métriques RTO/RPO et la criticité d'application simplifient le processus de conception d'une application donnée en répondant aux questions suivantes :

- L'application doit-elle s'exécuter dans plusieurs zones de la même région ou dans plusieurs zones de plusieurs régions ?

- Sur quels produits Google Cloud l'application peut-elle s'appuyer ?

Voici un exemple de résultat de l'exercice de rassemblement des exigences :

RTO et RPO par criticité d'application pour l'exemple d'organisation Co :

| Criticité d'application | Pourcentage d'applications | Exemples d'applications | Panne zonale | Panne régionale |

|---|---|---|---|---|

| Niveau 1

(le plus important) |

5 % | Applications externes ou mondiales destinées aux clients, telles que les applications de paiement en temps réel et les vitrines d'e-commerce. | RTO : zéro RPO : zéro |

RTO : zéro RPO : zéro |

| Niveau 2 | 35 % | Applications régionales ou applications internes importantes, telles que les solutions CRM ou ERP. | RTO : 15 minutes

RPO : 15 minutes |

RTO : 1 heure

RPO : 1 heure |

| Niveau 3

(le moins important) |

60 % | Applications destinées aux équipes ou aux services, telles que les applications pour le back-office, la gestion des congés, les déplacements internes, la comptabilité et les RH. | RTO : 1 heure

RPO : 1 heure |

RTO : 12 heures RPO : 12 heures |

Étape 2 : Mapper les fonctionnalités aux produits disponibles

La deuxième étape consiste à comprendre les fonctionnalités de résilience des produits Google Cloudque vos applications utiliseront. La plupart des entreprises examinent les informations pertinentes sur les produits, puis ajoutent des instructions décrivant comment modifier leurs architectures pour combler les écarts entre les fonctionnalités produit et leurs exigences de résilience. Cette section présente plusieurs recommandations et domaines courants concernant les limites des données et des applications dans cet espace.

Comme indiqué précédemment, les produits Google compatibles avec la reprise après sinistre répondent largement aux besoins de deux types d'étendue de panne : régionale et zonale. Les pannes partielles doivent être planifiées de la même manière que les pannes complètes en ce qui concerne la reprise après sinistre. Voici une matrice initiale d'ensemble décrivant les produits adaptés à chaque scénario par défaut :

Google Cloud Fonctionnalités générales des produits

(consultez l'annexe pour obtenir la liste des fonctionnalités de produits spécifiques)

| Tous les produits Google Cloud | Produits régionaux Google Cloud avec réplication automatique entre les zones | Produits multirégionaux ou mondiaux Google Cloud avec réplication automatique entre les régions | |

|---|---|---|---|

| Défaillance d'un composant d'une zone | Couvert* | Couvert | Couvert |

| Panne zonale | Non couvert | Couvert | Couvert |

| Panne régionale | Non couvert | Non couvert | Couvert |

* Tous les produits Google Cloud sont résilients aux défaillances des composants, sauf dans les cas spécifiques mentionnés dans la documentation du produit. Il s'agit habituellement de scénarios dans lesquels le produit fournit un accès direct ou un mappage statique à un élément matériel spécialisé, tel que la mémoire ou un disque SSD.

Comment le RPO limite le choix de produits

Dans la plupart des déploiements cloud, l'intégrité des données constitue l'aspect le plus important de l'architecture à prendre en compte pour un service. Au moins une partie des applications ont une exigence RPO de zéro, ce qui signifie qu'il n'y a aucune perte de données en cas de panne. Cette mise en œuvre nécessite généralement une réplication synchrone des données dans une autre zone ou région. La réplication synchrone présente des compromis en termes de coûts et de latence. Ainsi, même si de nombreux produits Google Cloud fournissent une réplication synchrone entre les zones, peu d'entre eux fournissent une réplication entre les régions. Ce compromis au niveau des coûts et de la complexité signifie qu'il n'est pas rare que différents types de données au sein d'une application aient des valeurs RPO différentes.

Pour les données avec un RPO supérieur à zéro, les applications peuvent tirer parti de la réplication asynchrone. La réplication asynchrone est acceptable lorsque les données perdues peuvent être facilement recréées, ou récupérées à partir d'une source de données fiable, si nécessaire. Il peut également s'agir d'un choix raisonnable lorsque la perte d'une faible quantité de données constitue un compromis acceptable pour les pannes zonales et régionales dont la durée est prévisible. Il est également important de noter qu'en cas de panne temporaire, les données écrites dans l'emplacement affecté qui n'ont pas encore été répliquées dans un autre emplacement deviennent généralement disponibles une fois la panne résolue. Cela signifie que le risque de perte de données permanente est inférieur au risque de perte d'accès aux données lors d'une panne.

Actions clés : déterminez si vous avez absolument besoin d'un RPO de zéro et, le cas échéant, si vous pouvez mettre en œuvre cette solution pour un sous-ensemble de vos données. Cela vous permet d'augmenter considérablement le nombre de services compatibles avec la reprise après sinistre dont vous pouvez disposer. Dans Google Cloud, l'obtention d'un RPO de zéro implique l'utilisation de produits principalement régionaux pour votre application, qui sont par défaut résilients aux pannes zonales, mais pas aux pannes régionales.

Comment le RPO limite le choix de produits

L'un des principaux avantages du cloud computing est la possibilité de déployer une infrastructure à la demande. Ce déploiement est toutefois différent d'un déploiement instantané. La valeur RTO de votre application doit inclure le RTO combiné des produits Google Cloud utilisés par votre application, ainsi que toutes les actions que vos ingénieurs ou ingénieurs SRE doivent entreprendre pour redémarrer vos VM ou les composants d'application. Un RTO mesuré en minutes implique de concevoir une application qui reprend automatiquement à la suite d'un sinistre sans intervention humaine, ou avec des étapes minimales (comme appuyer sur un bouton pour effectuer un basculement). Les coûts et la complexité de ce type de système ont toujours été très élevés, mais les produits Google Cloud tels que les équilibreurs de charge et les groupes d'instances rendent cette conception bien plus simple et abordable. Par conséquent, nous vous recommandons de mettre en place un basculement et une reprise automatiques pour la plupart des applications. Sachez que la conception d'un système pour ce type de basculement à chaud entre les régions est à la fois complexe et coûteuse. Seule une infime partie des services critiques justifient cette mise en œuvre.

La plupart des applications possèdent un RTO compris entre une heure et une journée. Cela permet un basculement tiède dans une situation de sinistre, où certains composants de l'application s'exécutent en permanence en mode de secours (tels que les bases de données), tandis que d'autres composants font l'objet d'un scaling horizontal en cas de sinistre (tels que les serveurs Web). Pour ces applications, nous vous conseillons vivement d'automatiser les événements à évolutivité horizontale. Les services avec un RTO de plus d'une journée sont les moins critiques et peuvent souvent être récupérés à partir d'une sauvegarde ou recréés entièrement.

Actions clés : déterminez si vous avez absolument besoin d'un RTO (proche) de zéro pour le basculement régional et, le cas échéant, si vous pouvez mettre en œuvre cette solution pour un sous-ensemble de vos services. Cela modifie le coût d'exécution et de maintenance de votre service.

Étape 3 : Développer vos propres architectures et guides de référence

La dernière étape recommandée consiste à créer vos propres modèles d'architecture spécifiques à l'entreprise pour aider vos équipes à standardiser leur approche de la reprise après sinistre. La plupart des clients Google Cloud fournissent à leurs équipes de développement un guide faisant correspondre leurs attentes métier individuelles en termes de résilience aux deux principales catégories de scénarios de panne sur Google Cloud. Ainsi, les équipes peuvent facilement catégoriser les produits compatibles avec la reprise après sinistre adaptés à chaque niveau de criticité.

Créer des directives produit

Reprenons l'exemple de tableau RTO/RPO ci-dessus. Vous disposez ici d'un guide hypothétique répertoriant les produits qui seront autorisés par défaut pour chaque niveau de criticité. Notez que même si certains produits ont été identifiés comme non adaptés par défaut, vous pouvez toujours ajouter vos propres mécanismes de réplication et de basculement pour obtenir une synchronisation interzone ou interrégionale, mais cet exercice dépasse le cadre de cet article. Les tableaux renvoient également vers des informations supplémentaires sur chaque produit pour vous aider à comprendre leurs fonctionnalités en ce qui concerne la gestion des pannes zonales ou régionales.

Exemples de modèles d'architecture pour l'exemple d'organisation Co - résilience aux pannes zonales

| Google Cloud Produit | Le produit répond-il aux exigences de panne zonale pour l'exemple d'organisation (avec une configuration de produit appropriée) ? | ||

|---|---|---|---|

| Niveau 1 | Niveau 2 | Niveau 3 | |

| Compute Engine | Non | Non | Non |

| Dataflow | Non | Non | Non |

| BigQuery | Non | Non | Yes |

| GKE | Yes | Oui | Oui |

| Cloud Storage | Oui | Oui | Oui |

| Cloud SQL | Non | Oui | Oui |

| Spanner | Oui | Oui | Oui |

| Cloud Load Balancing | Oui | Oui | Oui |

Le tableau ci-dessous n'est fourni qu'à titre d'exemple et est basé sur les niveaux hypothétiques présentés ci-dessus.

Exemples de modèles d'architecture pour l'exemple d'organisation Co - résilience aux pannes régionales

| Google Cloud Produit | Le produit répond-il aux exigences de panne régionale pour l'exemple d'organisation (avec une configuration de produit appropriée) ? | ||

|---|---|---|---|

| Niveau 1 | Niveau 2 | Niveau 3 | |

| Compute Engine | Oui | Oui | Oui |

| Dataflow | Non | Non | Non |

| BigQuery | Non | Non | Yes |

| GKE | Yes | Oui | Oui |

| Cloud Storage | Non | Non | Non |

| Cloud SQL | Non | Oui | Oui |

| Spanner | Oui | Oui | Oui |

| Cloud Load Balancing | Oui | Oui | Oui |

Le tableau ci-dessous n'est fourni qu'à titre d'exemple et est basé sur les niveaux hypothétiques présentés ci-dessus.

Pour vous montrer comment ces produits sont utilisés, les sections suivantes présentent quelques architectures de référence pour chaque niveau de criticité d'application. Il s'agit de descriptions volontairement générales qui illustrent les principales décisions en termes d'architecture. Elles ne représentent pas une conception de solution complète.

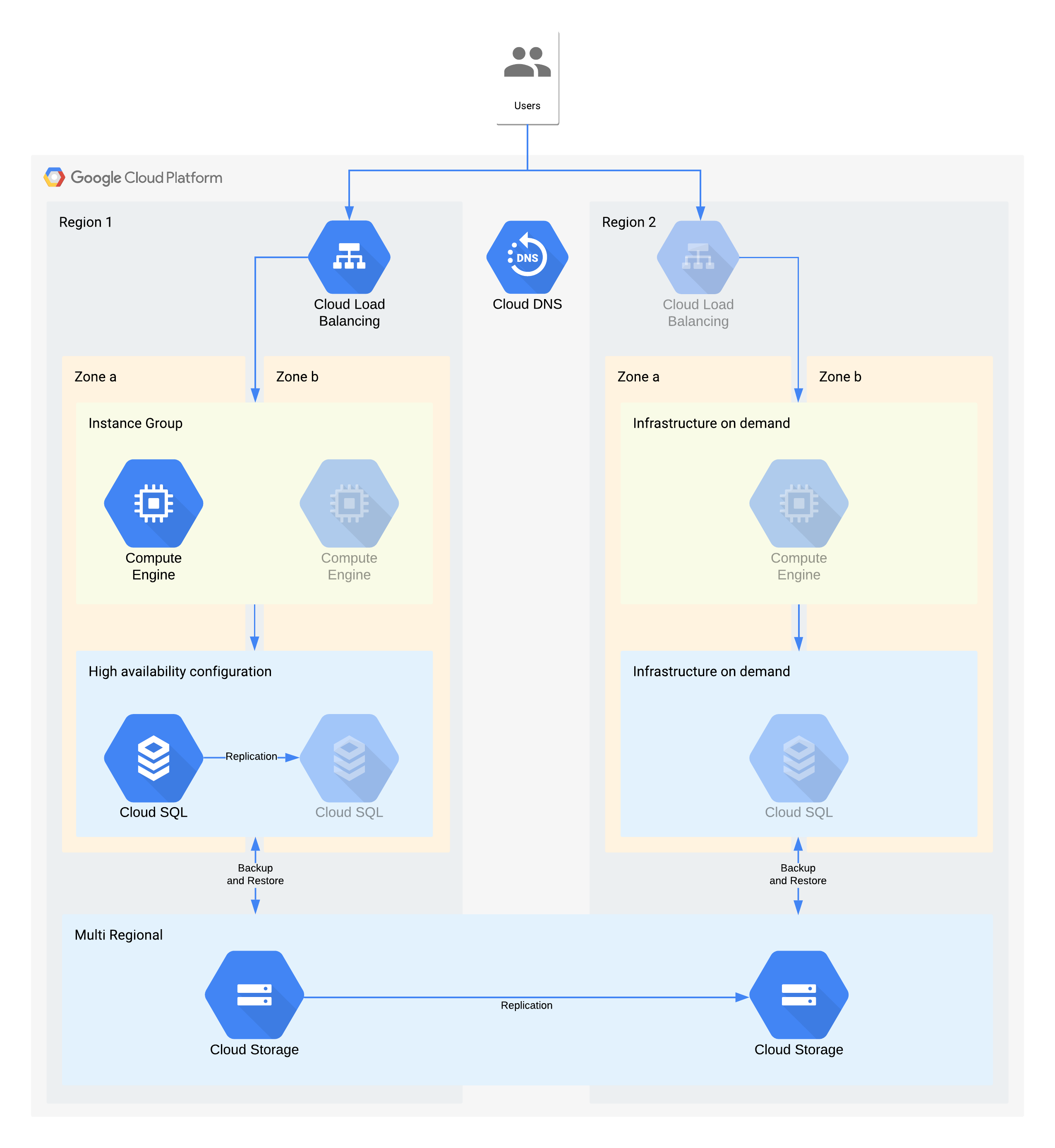

Exemple d'architecture de niveau 3

| Criticité d'application | Panne zonale | Panne régionale |

|---|---|---|

| Niveau 3 (le moins important) |

RTO : 12 heures RPO : 24 heures |

RTO : 28 jours RPO : 24 heures |

(Les icônes grisées indiquent l'infrastructure à activer pour la reprise.)

Cette architecture décrit une application cliente/serveur classique : les utilisateurs internes se connectent à une application qui s'exécute sur une instance de calcul soutenue par une base de données pour le stockage persistant.

Il est important de noter que cette architecture accepte des valeurs RTO et RPO supérieures à celles requises. Toutefois, vous devez également envisager de supprimer les étapes manuelles supplémentaires lorsqu'elles peuvent s'avérer coûteuses ou peu fiables. Par exemple, la récupération d'une base de données à partir d'une sauvegarde nocturne peut convenir au RPO de 24 heures, mais nécessite généralement la présence d'une personne qualifiée (telle qu'un administrateur de base de données) qui peut être indisponible, en particulier si plusieurs services ont été affectés en parallèle. Grâce à l'infrastructure à la demande de Google Cloud, vous pouvez bénéficier de cette fonctionnalité sans avoir à faire de compromis majeur en matière de coûts. Cette architecture exploite la haute disponibilité de Cloud SQL plutôt qu'une sauvegarde/restauration manuelle pour les pannes zonales.

Principales décisions en termes d'architecture pour les pannes zonales - RTO de 12 heures et RPO de 24 heures :

- Un équilibreur de charge interne est utilisé pour fournir un point d'accès évolutif aux utilisateurs, ce qui permet le basculement automatique vers une autre zone. Même si le RTO est de 12 heures, les modifications manuelles des adresses IP ou même les mises à jour DNS peuvent prendre plus de temps que prévu.

- Un groupe d'instances géré régional est configuré avec plusieurs zones, mais avec des ressources minimales. Ainsi, les coûts sont optimisés et les machines virtuelles peuvent toujours faire l'objet d'un scaling horizontal rapide dans la zone de sauvegarde.

- Une configuration Cloud SQL haute disponibilité fournit un basculement automatique vers une autre zone. Les bases de données sont considérablement plus difficiles à recréer et à restaurer que les machines virtuelles Compute Engine.

Principales décisions en termes d'architecture pour les pannes régionales - RTO de 28 jours et RPO de 24 heures :

- Un équilibreur de charge n'est créé dans la région 2 qu'en cas de panne régionale. Cloud DNS est employé pour fournir un basculement régional orchestré, mais manuel, dans la mesure où l'infrastructure de la région 2 n'est rendue disponible qu'en cas de panne régionale.

- Un nouveau groupe d'instances géré n'est créé qu'en cas de panne régionale. Cela permet d'optimiser les coûts, et ce scénario est peu susceptible de se produire en raison de la courte durée de la plupart des pannes régionales. Pour des raisons de simplicité, le schéma ne montre pas les outils associés nécessaires au redéploiement ni la copie des images Compute Engine requises.

- Une instance Cloud SQL est recréée et les données sont restaurées à partir d'une sauvegarde. Ici aussi, le risque d'une panne régionale prolongée est extrêmement faible. Il s'agit donc d'un autre compromis en matière d'optimisation des coûts.

- Le service Cloud Storage multirégional est utilisé pour stocker ces sauvegardes. Cela permet de fournir une zone automatique et une résilience régionale au sein du RTO et du RPO.

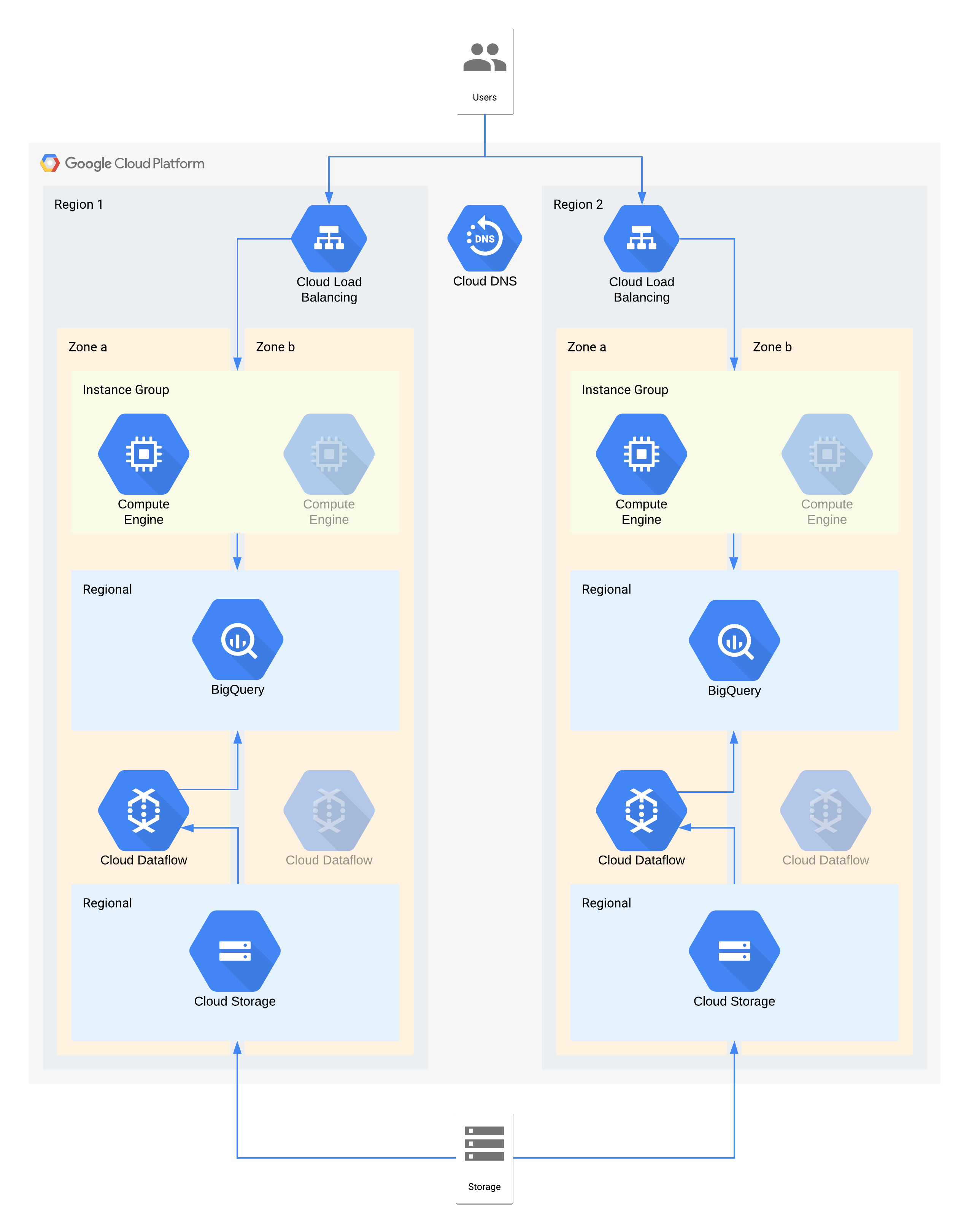

Exemple d'architecture de niveau 2

| Criticité d'application | Panne zonale | Panne régionale |

|---|---|---|

| Niveau 2 | RTO : 4 heures RPO : zéro |

RTO : 24 heures RPO : 4 heures |

Cette architecture décrit un entrepôt de données avec des utilisateurs internes qui se connectent à une couche de visualisation d'instances de calcul, ainsi qu'une couche d'ingestion et de transformation de données qui remplit l'entrepôt de données backend.

Certains composants individuels de cette architecture n'acceptent pas directement le RPO requis pour leur niveau. Toutefois, grâce à la façon dont ces composants sont associés, le service global répond aux exigences en matière de RPO. Ici, comme Dataflow est un produit zonal, suivez les recommandations de la conception à haute disponibilité pour éviter toute perte de données lors d'une panne. Cependant, la couche Cloud Storage est la source fiable de ces données et accepte un RPO de zéro. Par conséquent, vous pouvez réingérer toutes les données perdues dans BigQuery en utilisant la zone b en cas de panne dans la zone a.

Principales décisions en termes d'architecture pour les pannes zonales - RTO de 4 heures et RPO de zéro :

- Un équilibreur de charge est utilisé pour fournir un point d'accès évolutif aux utilisateurs, ce qui permet le basculement automatique vers une autre zone. Même si le RTO est de 4 heures, les modifications manuelles des adresses IP ou même les mises à jour DNS peuvent prendre plus de temps que prévu.

- Un groupe d'instances géré régional pour la couche de calcul de visualisation des données est configuré avec plusieurs zones, mais avec des ressources minimales. Ainsi, les coûts sont optimisés et les machines virtuelles peuvent toujours faire l'objet d'un scaling horizontal rapide.

- Le service Cloud Storage régional est utilisé en tant que couche de préproduction pour l'ingestion initiale des données, ce qui permet de fournir une résilience de zone automatique.

- Dataflow est employé pour extraire des données de Cloud Storage et les transformer avant de les charger dans BigQuery. En cas de panne zonale, il s'agit d'un processus sans état qui peut être redémarré dans une autre zone.

- BigQuery fournit le backend de l'entrepôt de données pour l'interface de visualisation des données. En cas de panne zonale, toutes les données perdues sont réingérées à partir de Cloud Storage.

Principales décisions en termes d'architecture pour les pannes régionales - RTO de 24 heures et RPO de 4 heures :

- Un équilibreur de charge dans chaque région est utilisé pour fournir un point d'accès évolutif aux utilisateurs. Cloud DNS est employé pour fournir un basculement régional orchestré, mais manuel, dans la mesure où l'infrastructure de la région 2 n'est rendue disponible qu'en cas de panne régionale.

- Un groupe d'instances géré régional pour la couche de calcul de visualisation des données est configuré avec plusieurs zones, mais avec des ressources minimales. Cette opération n'est pas possible avant la reconfiguration de l'équilibreur de charge, mais elle ne nécessite aucune intervention manuelle.

- Le service Cloud Storage régional est utilisé en tant que couche de préproduction pour l'ingestion initiale des données. Le chargement est effectué simultanément dans les deux régions afin de répondre aux exigences en matière de RPO.

- Dataflow est employé pour extraire des données de Cloud Storage et les transformer avant de les charger dans BigQuery. En cas de panne régionale, les données les plus récentes de Cloud Storage sont ainsi insérées dans BigQuery.

- BigQuery fournit le backend de l'entrepôt de données. En situation normale, les données de l'entrepôt sont actualisées de façon intermittente. En cas de panne régionale, les données les plus récentes sont réingérées à partir de Cloud Storage via Dataflow.

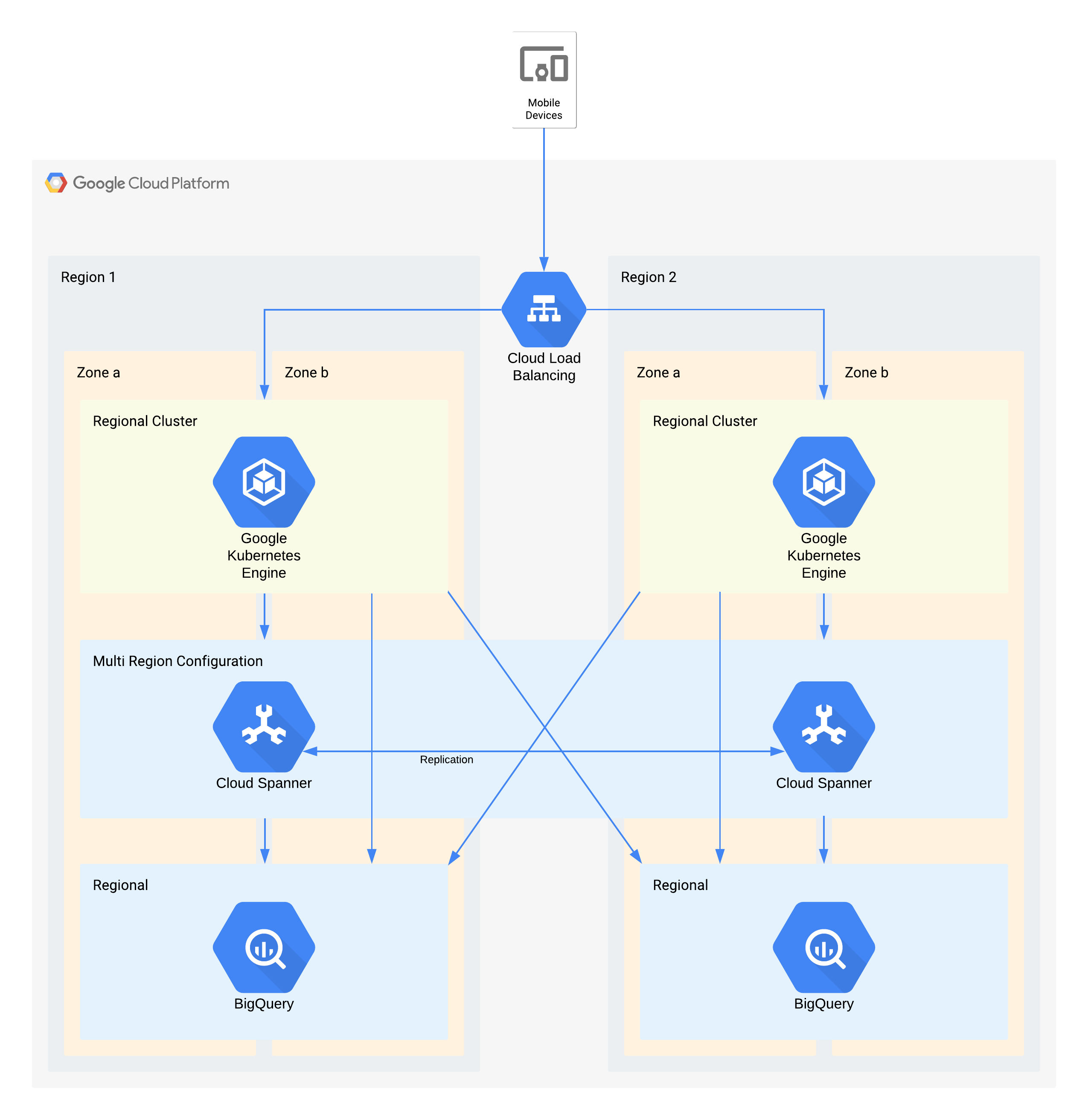

Exemple d'architecture de niveau 1

| Criticité d'application | Panne zonale | Panne régionale |

|---|---|---|

| Niveau 1 (le plus important) |

RTO : zéro RPO : zéro |

RTO : 4 heures RPO : 1 heure |

Cette architecture décrit une infrastructure backend d'application mobile avec des utilisateurs externes qui se connectent à un ensemble de microservices exécutés dans GKE. Spanner fournit la couche de stockage de données backend pour les données en temps réel, et les données de l'historique sont transmises à un lac de données BigQuery dans chaque région.

Ici aussi, certains composants individuels de cette architecture n'acceptent pas directement le RPO requis pour leur niveau. Mais grâce à la façon dont les composants sont associés, le service global accepte ce RPO. Dans ce cas, BigQuery est utilisé pour les requêtes analytiques. Chaque région reçoit simultanément des données de Spanner.

Principales décisions en termes d'architecture pour les pannes zonales - RTO de zéro et RPO de zéro :

- Un équilibreur de charge est utilisé pour fournir un point d'accès évolutif aux utilisateurs, ce qui permet le basculement automatique vers une autre zone.

- Un cluster GKE régional est utilisé pour la couche d'application qui est configurée avec plusieurs zones. Cela permet d'atteindre le RTO de zéro dans chaque région.

- Le service Spanner multirégional est utilisé en tant que couche de persistance des données, fournissant ainsi une résilience automatique des données de zone et une cohérence des transactions.

- BigQuery fournit la fonctionnalité d'analyse de l'application. Chaque région reçoit indépendamment des données de Spanner et est accessible indépendamment par l'application.

Principales décisions en termes d'architecture pour les pannes régionales - RTO de 4 heures et RPO de 1 heure :

- Un équilibreur de charge est utilisé pour fournir un point d'accès évolutif aux utilisateurs, ce qui permet le basculement automatique vers une autre région.

- Un cluster GKE régional est utilisé pour la couche d'application qui est configurée avec plusieurs zones. En cas de panne régionale, le cluster situé dans la région alternative fait l'objet d'un scaling automatique pour supporter la charge de traitement supplémentaire.

- Le service Spanner multirégional est utilisé en tant que couche de persistance des données, fournissant ainsi une résilience automatique des données régionales et une cohérence des transactions. Il s'agit du composant clé qui permet d'atteindre le RPO interrégional de 1 heure.

- BigQuery fournit la fonctionnalité d'analyse de l'application. Chaque région reçoit indépendamment des données de Spanner et est accessible indépendamment par l'application. Cette architecture compense le composant BigQuery en lui permettant de satisfaire aux exigences globales de l'application.

Annexe : documentation de référence produit

Cette section décrit l'architecture et les fonctionnalités de reprise après sinistre des produits Google Cloudles plus couramment utilisés dans les applications clientes et pouvant facilement répondre à vos exigences en matière de reprise après sinistre.

Thèmes communs

De nombreux produits Google Cloud proposent des configurations régionales ou multirégionales. Les produits régionaux sont résilients aux pannes zonales, tandis que les produits multirégionaux et mondiaux sont résilients aux pannes régionales. En général, cela signifie que lors d'une panne, votre application subit une perturbation minimale. Afin de parvenir à ce résultat, Google suit plusieurs approches architecturales courantes qui reflètent les conseils d'architecture ci-dessus.

Déploiement redondant : les backends d'applications et la solution de stockage des données sont déployés dans plusieurs zones d'une même région et dans plusieurs régions d'un même emplacement multirégional. Pour en savoir plus sur les considérations spécifiques à la région, consultez Zones géographiques et régions.

Réplication des données : les produits utilisent la réplication synchrone ou asynchrone sur les emplacements redondants.

La réplication synchrone signifie que lorsque votre application effectue un appel d'API pour créer ou modifier des données stockées par le produit, une réponse positive n'est obtenue qu'une fois que le produit a écrit les données dans plusieurs emplacements. La réplication synchrone garantit que vous ne perdrez pas l'accès à vos données lors d'une panne d'infrastructure Google Cloud , car toutes vos données sont disponibles dans l'un des emplacements de backend disponibles.

Bien que cette technique fournisse une protection maximale des données, elle peut présenter des compromis en termes de latence et de performances. Les produits multirégionaux qui utilisent la réplication synchrone font face à ce compromis de manière significative, et subissent généralement une latence supplémentaire de plusieurs dizaines ou centaines de millisecondes.

La réplication asynchrone signifie que lorsque votre application effectue un appel d'API pour créer ou modifier des données stockées par le produit, une réponse positive n'est obtenue qu'une fois que le produit a écrit les données dans un emplacement. Après votre requête d'écriture, le produit réplique vos données dans des emplacements supplémentaires.

Cette technique fournit une latence plus faible et un débit supérieur au niveau de l'API par rapport à la réplication synchrone, mais au détriment de la protection des données. Si l'emplacement dans lequel vous avez écrit des données subit une panne avant la fin de la réplication, vous perdez l'accès à ces données jusqu'à ce que la panne d'emplacement soit résolue.

Gestion des pannes grâce à l'équilibrage de charge : Google Cloud utilise l'équilibrage de charge logicielle pour acheminer les requêtes vers les backends d'applications appropriés. Comparée à d'autres approches telles que l'équilibrage de charge DNS, celle-ci réduit le temps mis par le système pour répondre à une panne. Lorsqu'une Google Cloud panne d'emplacement se produit, l'équilibreur de charge détecte rapidement que le backend déployé à cet emplacement n'est plus opérationnel et dirige toutes les requêtes vers un backend situé dans un autre emplacement. Ainsi, le produit peut continuer de diffuser les requêtes de votre application pendant une panne d'emplacement. Une fois la panne d'emplacement résolue, l'équilibreur de charge détecte que les backends de produit sont disponibles à cet emplacement et reprend la transmission du trafic.

Access Context Manager

Access Context Manager permet aux entreprises de configurer des niveaux d'accès en fonction d'une stratégie définie à partir des attributs d'une requête. Les stratégies sont mises en miroir au niveau régional.

En cas de panne zonale, les requêtes envoyées aux zones indisponibles sont diffusées automatiquement et de manière transparente depuis d'autres zones disponibles de la région.

En cas de panne régionale, les calculs de stratégie de la région concernée ne sont plus disponibles jusqu'à ce que la région redevienne disponible.

Access Transparency

Access Transparency permet aux administrateurs d'organisation Google Cloud de définir un contrôle d'accès précis et basé sur des attributs pour les projets et les ressources dans Google Cloud. Google doit parfois accéder aux données client à des fins administratives. Lorsque nous accédons aux données client, Access Transparency fournit des journaux d'accès aux clients Google Cloudconcernés. Ces journaux Access Transparency permettent de garantir l'engagement de Google en termes de sécurité des données et de transparence en matière de traitement des données.

Access Transparency est résilient aux pannes zonales et régionales. En cas de panne zonale ou régionale, Access Transparency continue de traiter les journaux d'accès administratifs dans une autre zone ou région.

AlloyDB pour PostgreSQL

AlloyDB pour PostgreSQL est un service de base de données entièrement géré compatible avec PostgreSQL. AlloyDB pour PostgreSQL offre une haute disponibilité dans une région via les nœuds redondants de son instance principale, qui sont situés dans deux zones différentes de la région. L'instance principale conserve la disponibilité régionale en déclenchant un basculement automatique vers la zone de secours si la zone active rencontre un problème. Le stockage régional garantit la durabilité des données en cas de perte d'une zone.

Comme autre méthode de reprise après sinistre, AlloyDB pour PostgreSQL utilise la réplication interrégionale pour fournir des fonctionnalités de reprise après sinistre en répliquant de manière asynchrone les données de votre cluster principal dans des clusters secondaires situés dans des régions Google Cloud distinctes.

Indisponibilité d'une zone : en fonctionnement normal, seul l'un des deux nœuds d'une instance principale à haute disponibilité est actif et diffuse toutes les écritures de données. Ce nœud actif stocke les données dans une couche de stockage régionale distincte du cluster.

AlloyDB pour PostgreSQL détecte automatiquement les défaillances au niveau d'une zone et déclenche un basculement pour restaurer la disponibilité de la base de données. Lors du basculement, AlloyDB pour PostgreSQL démarre la base de données sur le nœud de secours, qui est déjà provisionné dans une zone différente. Les nouvelles connexions à la base de données sont automatiquement acheminées vers cette zone.

Du point de vue d'une application cliente, l'indisponibilité d'une zone ressemble à une interruption temporaire de la connectivité réseau. Une fois le basculement terminé, un client peut se reconnecter à l'instance à la même adresse, en utilisant les mêmes identifiants, sans perdre de données.

Indisponibilité régionale : la réplication interrégionale utilise la réplication asynchrone, qui permet à l'instance principale d'effectuer un commit des transactions avant qu'elles ne soient validées sur les instances répliquées. Le délai entre le commit d'une transaction sur l'instance principale et le commit d'une transaction sur l'instance répliquée est appelé délai de réplication. Le délai entre le moment où l'instance principale génère le journal WAL et le moment où le journal WAL atteint l'instance répliquée est appelé délai de vidage. Le délai de réplication et le délai de vidage dépendent de la configuration de l'instance de base de données et de la charge de travail générée par l'utilisateur.

En cas d'indisponibilité régionale, vous pouvez promouvoir les clusters secondaires d'une autre région en cluster principal autonome accessible en écriture. Ce cluster promu ne réplique plus les données du cluster principal d'origine auquel il était auparavant associé. En raison du délai de vidage, les données peuvent être perdues, car certaines transactions du cluster principal d'origine peuvent ne pas être transmises au cluster secondaire.

Le RPO de réplication interrégionale est affecté par l'utilisation du processeur du cluster principal et la distance physique entre la région du cluster principal et la région du cluster secondaire. Pour optimiser le RPO, nous vous recommandons de tester votre charge de travail avec une configuration comprenant une instance répliquée pour établir une limite sûre de transactions par seconde (TPS), qui correspond au nombre de TPS le plus élevé n'augmentant pas le délai de vidage. Si votre charge de travail dépasse la limite sûre de TPS, le délai de vidage augmente et peut affecter le RPO. Pour limiter la latence du réseau, choisissez des paires de régions sur le même continent.

Pour en savoir plus sur la surveillance de la latence du réseau et d'autres métriques AlloyDB pour PostgreSQL, consultez Surveiller des instances.

Anti Money Laundering AI

Anti Money Laundering AI (AML AI) fournit une API pour aider les institutions financières internationales à détecter plus efficacement le blanchiment d'argent. Anti Money Laundering AI est une offre régionale, ce qui signifie que les clients peuvent choisir la région, mais pas les zones dont elle est composée. Les données et le trafic sont automatiquement équilibrés en charge entre les zones d'une même région. Les opérations (par exemple, la création d'un pipeline ou l'exécution d'une prédiction) font l'objet d'un scaling automatique en arrière-plan et sont équilibrées en charge entre les zones si nécessaire.

Indisponibilité d'une zone : AML AI stocke les données de ses ressources au niveau régional, répliquées de manière synchrone. Lorsqu'une opération de longue durée aboutit, les ressources peuvent être utilisées indépendamment des défaillances de zone. Le traitement est également répliqué sur plusieurs zones, mais cette réplication cible l'équilibrage de charge et non la haute disponibilité. L'indisponibilité d'une zone lors d'une opération peut donc entraîner l'échec de l'opération. Dans ce cas, relancez l'opération pour résoudre le problème. Lorsqu'une zone est indisponible, les temps de traitement peuvent être affectés.

Indisponibilité régionale : les clients choisissent la région Google Cloud dans laquelle ils souhaitent créer leurs ressources AML AI. Les données ne sont jamais répliquées entre les régions. Le trafic client n'est jamais acheminé vers une autre région par AML AI. En cas de défaillance d'une région, AML AI redevient disponible dès que la défaillance est résolue.

Clés API

Les clés API fournissent une gestion des ressources de clé API évolutive pour un projet. Les clés API sont un service global, ce qui signifie qu'elles sont visibles et accessibles depuis n'importe quel emplacement Google Cloud . Ses données et métadonnées sont stockées de manière redondante dans plusieurs zones et régions.

Les clés API sont résilientes aux pannes zonales et régionales. En cas de panne zonale ou régionale, les clés API continuent de diffuser les requêtes depuis une autre zone de la même région ou d'une région différente.

Pour plus d'informations sur les clés API, consultez la page Présentation de l'API des clés API.

Apigee

Apigee fournit une plate-forme sécurisée, évolutive et fiable pour développer et gérer des API. Apigee propose des déploiements régionaux et multirégionaux.

Panne zonale : es données d'exécution client sont répliquées dans plusieurs zones de disponibilité. Par conséquent, une panne dans une seule zone n'a aucun impact sur Apigee.

Panne régionale : pour les instances Apigee à région unique, si une région tombe en panne, les instances Apigee ne sont pas disponibles dans cette région et ne peuvent pas être restaurées dans différentes régions. Pour les instances Apigee multirégionales, les données sont répliquées de manière asynchrone dans toutes les régions. Par conséquent, la défaillance d'une région ne réduit pas entièrement le trafic. Toutefois, il est possible que vous ne puissiez pas accéder aux données non validées dans la région concernée. Vous pouvez détourner le trafic des régions non opérationnelles. Pour obtenir un basculement automatique du trafic, vous pouvez configurer le routage réseau à l'aide de groupes d'instances gérés (MIG).

AutoML Translation

AutoML Translation est un service de traduction automatique qui vous permet d'importer vos propres données (paires de phrases) pour entraîner des modèles personnalisés en fonction des besoins spécifiques à votre domaine.

Panne zonale : AutoML Translation dispose de serveurs de calcul actifs dans plusieurs zones et régions. Il est également compatible avec la réplication synchrone des données entre les zones des régions. Ces fonctionnalités aident AutoML Translation à effectuer un basculement instantané sans perte de données pour les défaillances de zones, et sans nécessiter d'entrée ni d'ajustements de la part des clients.

Panne régionale : en cas de défaillance régionale, AutoML Translation n'est pas disponible.

AutoML Vision

AutoML Vision fait partie de Vertex AI. Il offre un framework unifié pour créer des ensembles de données, importer des données, entraîner des modèles et les diffuser pour la prédiction en ligne et la prédiction par lot.

AutoML Vision est une offre régionale. Les clients peuvent choisir la région à partir de laquelle ils souhaitent lancer un job, mais pas les zones spécifiques de cette région. Le service équilibre automatiquement la charge de travail sur différentes zones de la région.

Panne zonale : AutoML Vision stocke les métadonnées des jobs au niveau régional et les écrit de manière synchrone dans les zones de la région. Les jobs sont lancés dans une zone spécifique, sélectionnée par Cloud Load Balancing.

Tâches d'entraînement AutoML Vision : une panne zonale entraîne l'échec de toutes les tâches en cours d'exécution, et l'état de la tâche est mis à jour. Si une tâche échoue, réessayez immédiatement. La nouvelle tâche est acheminée vers une zone disponible.

Jobs de prédiction par lots AutoML Vision : la prédiction par lots est basée sur Vertex AI Batch Prediction. En cas de panne zonale, le service relance automatiquement le job en le redirigeant vers les zones disponibles. Si plusieurs tentatives échouent, l'état du job passe à "Échec". Les requêtes utilisateur suivantes pour exécuter la tâche sont redirigées vers une zone disponible.

Panne régionale : les clients choisissent la région Google Cloud dans laquelle ils souhaitent exécuter leurs jobs. Les données ne sont jamais répliquées entre les régions. En cas de panne régionale, le service AutoML Vision n'est pas disponible dans cette région. Elle redevient disponible une fois la panne résolue. Nous recommandons aux clients d'utiliser plusieurs régions afin qu'ils puissent exécuter leurs tâches. En cas de panne régionale, redirigez les jobs vers une autre région disponible.

Lot

Batch est un service entièrement géré permettant de mettre en file d'attente, planifier et exécuter des tâches par lot sur Google Cloud. Les paramètres de traitement par lots sont définis au niveau de la région. Les clients doivent choisir une région pour envoyer leurs tâches par lot, et non une zone dans une région. Lorsqu'une tâche est envoyée, Batch écrit de manière synchrone les données client dans plusieurs zones. Toutefois, les clients peuvent spécifier les zones dans lesquelles les VM par lot exécutent des tâches.

Défaillance zonale : en cas de défaillance d'une seule zone, les tâches exécutées dans cette zone échouent également. Si les tâches ont des paramètres de nouvelle tentative, Batch bascule automatiquement ces tâches vers d'autres zones actives de la même région. Le basculement automatique est soumis à la disponibilité des ressources dans les zones actives de la même région. Les tâches nécessitant des ressources zonales (telles que des VM, des GPU ou des disques persistants zonaux) qui ne sont disponibles que dans la zone défaillante sont mises en file d'attente jusqu'à la récupération de la zone défaillante ou jusqu'à ce que les délais avant expiration des tâches soient atteints. Dans la mesure du possible, nous recommandons aux clients de laisser Batch choisir des ressources zonales pour exécuter leurs tâches. Cela permet de garantir que les tâches sont résilientes aux pannes zonales.

Défaillance régionale : en cas de défaillance régionale, le plan de contrôle du service n'est pas disponible dans la région. Le service ne réplique pas les données ni les requêtes de redirection entre les régions. Nous recommandons aux clients d'utiliser plusieurs régions pour exécuter leurs tâches et rediriger les tâches vers une autre région en cas de défaillance d'une région.

Prévention des menaces et protection des données de Chrome Enterprise Premium

La prévention des menaces et la protection des données de Chrome Enterprise Premium fait partie de la solution Chrome Enterprise Premium. Elle étend Chrome avec diverses fonctionnalités de sécurité, telles que la protection contre les logiciels malveillants et l'hameçonnage, la Protection contre la perte de données, les règles de filtrage des URL et les rapports de sécurité.

Les administrateurs Chrome Enterprise Premium peuvent choisir de stocker les contenus principaux du client qui ne respectent pas les règlements sur les logiciels malveillants ou sur la Protection contre la perte de données dans les événements de journaux des règles Google Workspace et/ou dans Cloud Storage en vue d'une investigation ultérieure. Les événements de journaux des règles Google Workspace sont alimentés par une base de données Spanner multirégionale. La détection des cas de non-respect des règles par Chrome Enterprise Premium peut prendre plusieurs heures. Pendant cette période, toutes les données non traitées sont sujettes à une perte de données due à une indisponibilité zonale ou régionale. Une fois une infraction détectée, le contenu qui ne respecte pas vos règles est consigné dans les événements du journal des règles Google Workspace et/ou dans Cloud Storage.

Panne zonale et régionale : Étant donné que la prévention des menaces et la protection des données de Chrome Enterprise Premium sont multizonales et multirégionales, elles peuvent survivre à une perte complète et non planifiée d'une zone ou d'une région, sans perte de disponibilité. Il offre ce niveau de fiabilité en redirigeant le trafic vers son service dans d'autres zones ou régions actives. Toutefois, comme la prévention des menaces et la protection des données de Chrome Enterprise Premium peut mettre plusieurs heures à détecter les cas de non respect des règlements sur les logiciels malveillants ou sur la Protection contre la perte de données, toutes les données non traitées dans une zone ou une région spécifique sont susceptibles d'être perdues en raison d'une indisponibilité zonale ou régionale.

BigQuery

BigQuery est un entrepôt de données cloud sans serveur, hautement évolutif et économique, conçu pour optimiser l'agilité des entreprises. BigQuery accepte les types d'emplacement suivants pour les ensembles de données utilisateur :

- Une région : emplacement géographique spécifique, par exemple l'Iowa (

us-central1) ou Montréal (northamerica-northeast1). - Un emplacement multirégional : secteur géographique de grande étendue contenant au moins deux lieux géographiques, tel que les États-Unis (

US) ou l'Europe (EU).

Dans les deux cas, les données sont stockées de manière redondante dans deux zones d'une même région de l'emplacement sélectionné. Les données écrites dans BigQuery sont écrites de manière synchrone dans les zones principale et secondaire. Cette mise en œuvre vous fournit une protection contre l'indisponibilité d'une zone de la région, mais pas contre une panne régionale.

Binary Authorization

L'autorisation binaire est un produit de sécurité de la chaîne d'approvisionnement logicielle pour GKE et Cloud Run.

Toutes les stratégies d'autorisation binaire sont répliquées dans plusieurs zones de chaque région. La réplication permet aux opérations de lecture de stratégies d'autorisation binaire de se rétablir en cas de défaillances d'autres régions. La réplication rend également les opérations de lecture tolérantes aux défaillances de zone dans chaque région.

Les opérations d'application de l'autorisation binaire sont résilientes face aux pannes zonales, mais elles ne sont pas résilientes face aux pannes régionales. Les opérations d'application s'exécutent dans la même région que le cluster GKE ou le job Cloud Run à l'origine de la requête. Par conséquent, en cas de panne régionale, il n'y a aucune exécution en cours pour envoyer des requêtes d'application de l'autorisation binaire.

Gestionnaire de certificats

Le gestionnaire de certificats vous permet d'acquérir et de gérer des certificats Transport Layer Security (TLS) à utiliser avec différents types d'équilibrage de charge Cloud Load Balancing.

En cas de panne zonale, les gestionnaires de certificats régional et global sont résilients aux pannes zonales, car les jobs et les bases de données sont redondants dans plusieurs zones d'une même région. En cas de panne régionale, le gestionnaire de certificats global est résilient aux pannes régionales, car les jobs et les bases de données sont redondants dans plusieurs régions. Le gestionnaire de certificats régional est un produit régional. Il ne peut donc pas résister à une défaillance régionale.

Cloud Intrusion Detection System

Cloud IDS (Cloud Intrusion Detection System) est un service zonal qui fournit des points de terminaison IDS à portée zonale. Ces points de terminaison traitent le trafic des VM d'une zone spécifique et ne sont donc pas tolérants aux pannes zonales ou régionales.

Panne zonale : Cloud IDS est lié aux instances de VM. Si un client prévoit d'atténuer les pannes zonales en déployant des VM dans plusieurs zones (manuellement ou via des groupes d'instances gérés régionaux), il devra également déployer des points de terminaison Cloud IDS dans ces zones.

Panne régionale : Cloud IDS est un produit régional. Il ne fournit aucune fonctionnalité interrégionale. Une défaillance régionale entraînera l'arrêt de toutes les fonctionnalités Cloud IDS dans toutes les zones de cette région.

Solution SIEM pour les opérations de sécurité Google

Google Security Operations SIEM (qui fait partie de Google Security Operations) est un service entièrement géré qui aide les équipes de sécurité à détecter, examiner et contrer les menaces.

Google Security Operations SIEM propose des offres régionales et multirégionales.

Dans les offres régionales, les données et le trafic sont automatiquement équilibrés en charge entre les zones de la région choisie, et les données sont stockées de manière redondante entre les zones de disponibilité de la région.

Les emplacements multirégionaux sont géoredondants. Cette redondance offre un ensemble de protections plus étendu que le stockage régional. Cela permet également de s'assurer que le service continue de fonctionner même en cas de perte d'une région entière.

La majorité des chemins d'ingestion de données répliquent les données client de manière synchrone dans plusieurs emplacements. Lorsque les données sont répliquées de manière asynchrone, il existe une période (objectif de point de récupération ou RPO) pendant laquelle les données ne sont pas encore répliquées dans plusieurs emplacements. C'est le cas lors de l'ingestion avec des flux dans les déploiements multirégionaux. Après le RPO, les données sont disponibles dans plusieurs emplacements.

Panne zonale :

Déploiements régionaux : les requêtes sont traitées à partir de n'importe quelle zone de la région. Les données sont répliquées de manière synchrone dans plusieurs zones. En cas de panne zonale, les zones restantes continuent de diffuser le trafic et de traiter les données. Le provisionnement redondant et le scaling automatisé de Google Security Operations SIEM permettent de garantir que le service reste opérationnel dans les zones restantes lors des changements de charge.

Déploiements multirégionaux : les pannes zonales équivalent aux pannes régionales.

Panne régionale :

Déploiements régionaux : Google Security Operations SIEM stocke toutes les données client dans une seule région et le trafic n'est jamais acheminé entre les régions. En cas de panne régionale, la solution SIEM des opérations de sécurité Google n'est pas disponible dans la région tant que la panne n'est pas résolue.

Déploiements multirégionaux (sans flux) : les requêtes sont traitées à partir de n'importe quelle région du déploiement multirégional. Les données sont répliquées de manière synchrone dans plusieurs régions. En cas de panne régionale, les régions restantes continuent de diffuser le trafic et de traiter les données. Le provisionnement redondant et le scaling automatisé de Google Security Operations SIEM permettent de s'assurer que le service reste opérationnel dans les régions restantes lors de ces changements de charge.

Déploiements multirégionaux (avec des flux) : les requêtes sont traitées à partir de n'importe quelle région du déploiement multirégional. Les données sont répliquées de manière asynchrone dans plusieurs régions avec le RPO fourni. En cas de panne dans une région entière, seules les données stockées après le RPO sont disponibles dans les régions restantes. Les données incluses dans la période RPO peuvent ne pas être répliquées.

Inventaire des éléments cloud

L'inventaire des éléments cloud est un service global résilient et hautes performances qui gère un dépôt de métadonnées de ressources et de règles Google Cloud . L'inventaire des éléments cloud fournit des outils de recherche et d'analyse qui vous aident à suivre les éléments déployés dans plusieurs organisations, dossiers et projets.

En cas de panne zonale, l'inventaire des éléments cloud continue de diffuser les requêtes provenant d'une autre zone de la même région ou d'une région différente.

En cas de panne régionale, l'inventaire des éléments cloud continue de diffuser les requêtes provenant d'autres régions.

Bigtable

Bigtable est un service de base de données NoSQL entièrement géré et hautes performances pour les charges de travail analytiques et opérationnelles volumineuses.

Présentation de la réplication Bigtable

Bigtable offre une fonctionnalité de réplication flexible et entièrement configurable, que vous pouvez utiliser pour augmenter la disponibilité et la durabilité de vos données en les copiant sur des clusters situés dans plusieurs régions, ou dans plusieurs zones d'une même région. Bigtable peut également assurer le basculement automatique de vos requêtes lorsque vous utilisez la réplication.

Lorsque vous utilisez des configurations multizones ou multirégionales avec routage multicluster en cas de panne zonale ou régionale, Bigtable redirige automatiquement le trafic et envoie les requêtes à partir du cluster disponible le plus proche. Étant donné que la réplication Bigtable est asynchrone et cohérente à terme, des modifications très récentes des données concernant l'emplacement de la panne peuvent être indisponibles si elles n'ont pas encore été répliquées dans d'autres emplacements.

Considérations sur les performances

Lorsque les besoins en ressources de processeur dépassent la capacité disponible pour le nœud, Bigtable donne toujours la priorité aux requêtes entrantes, par rapport au trafic de réplication.

Pour en savoir plus sur l'utilisation de la réplication Bigtable avec votre charge de travail, consultez la page Présentation de la réplication Cloud Bigtable et des exemples de paramètres de réplication.

Les nœuds Bigtable sont utilisés à la fois pour diffuser les requêtes entrantes et pour répliquer les données d'autres clusters. En plus de conserver suffisamment de nœuds par cluster, vous devez également vous assurer que vos applications utilisent une conception de schéma appropriée pour éviter les hotspots, qui peuvent entraîner une utilisation excessive ou déséquilibrée du processeur et accroître la latence de réplication.

Pour en savoir plus sur la conception de votre schéma d'application afin d'optimiser les performances et l'efficacité de Bigtable, consultez la page Bonnes pratiques liées à la conception de schémas.

Surveillance

Bigtable propose plusieurs moyens de surveiller visuellement la latence de réplication de vos instances et clusters, à l'aide des graphiques pour la réplication disponibles dans la Google Cloud console.

Vous pouvez également surveiller de manière automatisée les métriques de réplication Bigtable à l'aide de l'API Cloud Monitoring.

Certificate Authority Service

Certificate Authority Service (CA Service) permet aux clients de simplifier, d'automatiser et de personnaliser le déploiement, la gestion et la sécurité d'autorités de certification (CA) privées et d'émettre de manière résiliente des certificats à grande échelle.

Panne zonale : CA Service est résilient aux pannes zonales, car son plan de contrôle est redondant dans plusieurs zones d'une région. En cas de panne zonale, CA Service continue de diffuser de façon ininterrompue les requêtes qui proviennent d'une autre zone de la même région. Les données étant répliquées de manière synchrone, il n'y a aucune perte ni corruption de données.

Panne régionale : CA Service est un produit régional et ne peut donc pas résister à une défaillance régionale. Si vous avez besoin de résilience en cas de défaillance régionale, créez des autorités de certification émettrices dans deux régions différentes. Créez l'autorité de certification émettrice principale dans la région où vous avez besoin de certificats. Créez une autorité de certification de remplacement dans une autre région. Utilisez le remplacement en cas de panne de la région de l'autorité de certification subordonnée principale. Si nécessaire, les deux autorités de certification peuvent être associées à la même autorité de certification racine.

Cloud Billing

L'API Cloud Billing permet aux développeurs de gérer la facturation de leurs projetsGoogle Cloud de façon automatisée. L'API Cloud Billing est conçue comme un système mondial dans lequel les mises à jour sont écrites de manière synchrone dans plusieurs zones et régions.

Défaillance zonale ou régionale : l'API Cloud Billing bascule automatiquement vers une autre zone ou région. Les requêtes individuelles peuvent échouer, mais une stratégie de nouvelle tentative doit autoriser les tentatives ultérieures à réussir.

Cloud Build

Cloud Build est un service qui exécute vos compilations sur Google Cloud.

Cloud Build est composé d'instances isolées régionalement qui répliquent les données de manière synchrone entre les zones de la région. Nous vous recommandons d'utiliser des régions Google Cloud spécifiques plutôt que la région globale, et de vous assurer que les ressources que votre compilation utilise (y compris les buckets de journaux, les dépôts Artifact Registry, etc.) sont alignées sur la région dans laquelle votre compilation s'exécute.

En cas de panne zonale, les opérations du plan de contrôle ne sont pas affectées. Toutefois, les compilations en cours d'exécution dans la zone défaillante seront retardées ou définitivement perdues. Les compilations nouvellement déclenchées seront automatiquement distribuées aux zones opérationnelles restantes.

En cas de défaillance régionale, le plan de contrôle est hors connexion et les compilations en cours d'exécution sont retardées ou définitivement perdues. Les déclencheurs, les pools de nœuds de calcul et les données de compilation ne sont jamais répliqués entre les régions. Nous vous recommandons de préparer des déclencheurs et des pools de nœuds de calcul dans plusieurs régions pour faciliter la résolution des pannes.

Cloud CDN

Cloud CDN assure la distribution et la mise en cache de contenu pour de nombreux emplacements du réseau de Google, afin de réduire la latence de diffusion pour les clients. Le contenu mis en cache est diffusé de la manière la plus optimale possible : lorsqu'une requête ne peut pas être diffusée par le cache Cloud CDN, elle est transmise aux serveurs d'origine, tels que les VM de backend ou les buckets Cloud Storage, où est stocké le contenu d'origine.

En cas de défaillance d'une zone ou d'une région, les caches des emplacements concernés sont indisponibles. Les requêtes entrantes sont acheminées vers des emplacements et des caches Google disponibles en périphérie. Si ces autres caches ne peuvent pas diffuser la requête, ils transfèrent la requête vers un serveur d'origine disponible. Si le serveur peut traiter la requête avec des données à jour, le contenu ne sera pas perdu. Un taux de défaut de cache plus élevé entraîne une augmentation des volumes de trafic au-delà de la normale sur les serveurs d'origine, lors du remplissage des caches. Les requêtes ultérieures sont diffusées à partir des caches non affectés par la panne zonale ou régionale.

Pour plus d'informations sur le comportement de Cloud CDN et de la mise en cache, consultez la documentation de Cloud CDN.

Cloud Composer

Cloud Composer est un service d'orchestration de workflows géré qui vous permet de créer, planifier, surveiller et gérer des workflows couvrant des clouds et des centres de données sur site. Les environnements Cloud Composer sont basés sur le projet Open Source Apache Airflow.

La disponibilité de l'API Cloud Composer n'est pas affectée par l'indisponibilité zonale. Lors d'une panne zonale, vous conservez l'accès à l'API Cloud Composer, y compris la possibilité de créer des environnements Cloud Composer.

Un environnement Cloud Composer possède un cluster GKE dans son architecture. Lors d'une panne zonale, les workflows du cluster peuvent être interrompus :

- Dans Cloud Composer 1, le cluster de l'environnement est une ressource zonale. Par conséquent, une panne zonale peut rendre le cluster indisponible. Les workflows exécutés au moment de la panne peuvent être arrêtés avant leur terme.

- Dans Cloud Composer 2, le cluster de l'environnement est une ressource régionale. Toutefois, les workflows exécutés sur des nœuds dans les zones affectées par une panne de zone peuvent être arrêtés avant la fin.

Dans les deux versions de Cloud Composer, une panne zonale peut entraîner l'arrêt des workflows partiellement exécutés, y compris les actions externes que vous avez configurées. Selon le workflow, cette situation peut entraîner des incohérences en externe, par exemple, si le workflow s'arrête au milieu d'une exécution en plusieurs étapes visant à modifier des datastores externes. Par conséquent, vous devez tenir compte du processus de reprise lorsque vous concevez votre workflow Airflow, et envisager comment détecter l'état des workflows partiellement non exécutés et réparer les modifications de données partielles.

Dans Cloud Composer 1, vous pouvez choisir de démarrer un nouvel environnement Cloud Composer dans une autre zone lors d'une panne zonale. Airflow conserve l'état de vos workflows dans sa base de données de métadonnées. Par conséquent, le transfert de ces informations vers un nouvel environnement Cloud Composer peut nécessiter des étapes supplémentaires et de la préparation.

Dans Cloud Composer 2, vous pouvez gérer les pannes zonales en configurant au préalable la reprise après sinistre avec des instantanés d'environnement. Lors d'une panne zonale, vous pouvez basculer vers un autre environnement en transférant l'état de vos workflows avec un instantané d'environnement. Seul Cloud Composer 2 est compatible avec la reprise après sinistre avec des instantanés d'environnement.

Cloud Data Fusion

Cloud Data Fusion est un service cloud natif entièrement géré d'intégration de données d'entreprise qui permet de créer et de gérer rapidement des pipelines de données. Il fournit trois éditions.

Les pannes zonales affectent les instances de l'édition Developer.

Les pannes régionales ont une incidence sur les instances de l'édition Basic et Enterprise.

Pour contrôler l'accès aux ressources, vous pouvez concevoir et exécuter des pipelines dans des environnements distincts. Cette séparation vous permet de concevoir un pipeline une fois, puis de l'exécuter dans plusieurs environnements. Vous pouvez récupérer les pipelines dans les deux environnements. Pour en savoir plus, consultez la page Sauvegarder et restaurer des données d'instance.

Les conseils suivants s'appliquent aux pannes régionales et zonales.

Pannes dans l'environnement de conception du pipeline

Dans l'environnement de conception, enregistrez les brouillons du pipeline en cas de panne. En fonction d'exigences RTO et RPO spécifiques, vous pouvez utiliser les brouillons enregistrés pour restaurer le pipeline dans une autre instance Cloud Data Fusion lors d'une panne.

Pannes dans l'environnement d'exécution du pipeline

Dans l'environnement d'exécution, vous démarrez le pipeline en interne avec des déclencheurs ou des planifications Cloud Data Fusion, ou en externe avec des outils d'orchestration tels que Cloud Composer. Pour pouvoir récupérer les configurations d'exécution des pipelines, sauvegardez les pipelines et les configurations, tels que les plug-ins et les programmations. En cas de panne, vous pouvez utiliser la sauvegarde pour répliquer une instance dans une région ou une zone non affectée.