네트워크 대역폭이 높을수록 Compute Engine에서 실행되는 분산 워크로드를 지원하기 위해 GPU 인스턴스의 성능을 향상시킬 수 있습니다.

Compute Engine에서 GPU가 연결된 인스턴스에 사용 가능한 최대 네트워크 대역폭은 다음과 같습니다.

- A4X 가속기 최적화 인스턴스의 경우 머신 유형에 따라 최대 2,000Gbps까지 최대 네트워크 대역폭을 사용할 수 있습니다.

- A4 및 A3 가속기 최적화 인스턴스의 경우 머신 유형에 따라 최대 3,600Gbps까지 최대 네트워크 대역폭을 사용할 수 있습니다.

- G4 가속기 최적화 인스턴스의 경우 머신 유형에 따라 최대 400Gbps까지 최대 네트워크 대역폭을 사용할 수 있습니다.

- A2 및 G2 가속기 최적화 인스턴스의 경우 머신 유형에 따라 최대 100Gbps까지 최대 네트워크 대역폭을 사용할 수 있습니다.

- P100 및 P4 GPU가 연결된 N1 범용 인스턴스의 경우 최대 32Gbps 네트워크 대역폭을 사용할 수 있습니다. 이는 GPU가 연결되지 않은 N1 인스턴스에서 사용 가능한 최대 비율과 비슷합니다. 네트워크 대역폭에 대한 자세한 내용은 최대 이그레스 데이터 속도를 참조하세요.

- T4 및 V100 GPU가 연결된 N1 범용 인스턴스의 경우 GPU 및 vCPU 개수 조합에 따라 최대 100Gbps까지 최대 네트워크 대역폭을 사용할 수 있습니다.

네트워크 대역폭 및 NIC 배치 검토

다음 섹션을 사용하여 각 GPU 머신 유형의 네트워크 구성과 대역폭 속도를 검토하세요.

A4X 머신 유형

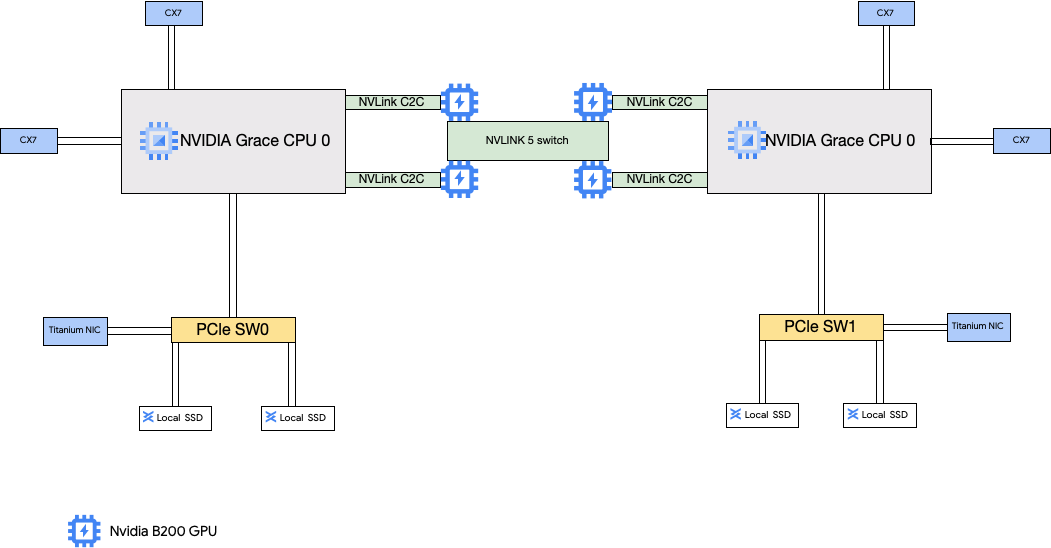

A4X 머신 유형에는 NVIDIA GB200 Superchips가 연결됩니다. 이러한 Superchips에는 NVIDIA B200 GPU가 있습니다.

이 머신 유형에는 NVIDIA ConnectX-7(CX-7) 네트워크 인터페이스 카드(NIC) 4개와 Titanium NIC 2개가 있습니다. 4개의 CX-7 NIC는 총 1,600Gbps의 네트워크 대역폭을 제공합니다. 이러한 CX-7 NIC는 고대역폭 GPU 간 통신 전용이며 공개 인터넷 액세스와 같은 다른 네트워킹 요구사항에는 사용할 수 없습니다. 두 개의 Titanium NIC는 범용 네트워킹 요구사항에 대해 400Gbps의 네트워크 대역폭을 추가로 제공하는 스마트 NIC입니다. 네트워크 인터페이스 카드를 모두 합치면 이러한 머신에 최대 2,000Gbps의 네트워크 대역폭을 제공할 수 있습니다.

A4X는 NVIDIA GB200 NVL72 랙 확장 아키텍처를 기반으로 하는 엑사스케일 플랫폼이며, 고대역폭 NVIDIA NVLink 칩 간(C2C) 상호 연결로 연결된 NVIDIA Hopper GPU와 NVIDIA Grace CPU를 제공하는 NVIDIA Grace Hopper Superchip 아키텍처를 도입합니다.

A4X 네트워킹 아키텍처는 레일 정렬 설계를 사용합니다. 이는 한 Compute Engine 인스턴스의 해당 네트워크 카드가 다른 인스턴스의 네트워크 카드에 연결되는 토폴로지입니다. 각 인스턴스의 4개 CX-7 NIC는 4방향 레일 정렬 네트워크 토폴로지에 물리적으로 격리되어 있어 A4X가 단일 비차단 클러스터에서 72개 GPU 그룹으로 확장하여 수천 개의 GPU까지 확장할 수 있습니다. 이 하드웨어 통합 접근 방식은 대규모 분산 워크로드에 필수적인 예측 가능하고 지연 시간이 짧은 성능을 제공합니다.

이러한 NIC를 여러 개 사용하려면 다음과 같이 가상 프라이빗 클라우드 네트워크 3개를 만들어야 합니다.

- VPC 네트워크 2개: 각 gVNIC는 서로 다른 VPC 네트워크에 연결되어야 합니다.

- RDMA 네트워크 프로필이 있는 VPC 네트워크 1개: 4개의 CX-7 NIC가 모두 동일한 VPC 네트워크를 공유합니다.

이러한 네트워크를 설정하려면 AI 하이퍼컴퓨터 문서의 VPC 네트워크 만들기를 참조하세요.

| 연결된 NVIDIA GB200 Grace Blackwell Superchips | |||||||

|---|---|---|---|---|---|---|---|

| 머신 유형 | vCPU 수1 | 인스턴스 메모리(GB) | 연결된 로컬 SSD(GiB) | 물리적 NIC 수 | 최대 네트워크 대역폭(Gbps)2 | GPU 수 | GPU 메모리3 (GB HBM3e) |

a4x-highgpu-4g |

140 | 884 | 12,000 | 6 | 2,000 | 4 | 720 |

1vCPU는 사용 가능한 CPU 플랫폼 중 하나에서 단일 하드웨어 하이퍼 스레드로 구현됩니다.

2 최대 이그레스 대역폭은 지정된 수를 초과할 수 없습니다. 실제 이그레스 대역폭은 대상 IP 주소와 기타 요인에 따라 다릅니다.

네트워크 대역폭에 대한 자세한 내용은 네트워크 대역폭을 참조하세요.

3GPU 메모리는 임시 데이터 스토리지에 사용할 수 있는 GPU 기기의 메모리입니다. 인스턴스의 메모리와는 별개이며 특히 그래픽 집약적인 워크로드의 더 높은 대역폭 수요를 처리하도록 설계되었습니다.

A4 및 A3 Ultra 머신 유형

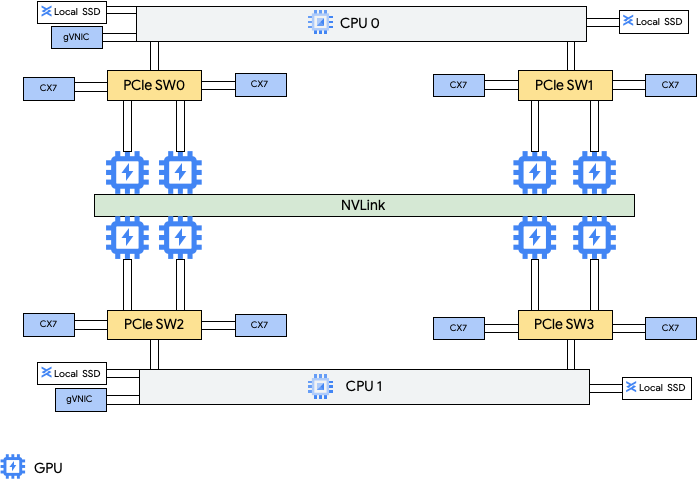

A4 머신 유형에는 NVIDIA B200 GPU가 연결되고 A3 Ultra 머신 유형에는 NVIDIA H200 GPU가 연결됩니다.

이러한 머신 유형은 NVIDIA ConnectX-7(CX-7) 네트워크 인터페이스 카드(NIC) 8개와 Google 가상 NIC(gVNIC) 2개를 제공합니다. 8개의 CX-7 NIC는 총 3,200Gbps의 네트워크 대역폭을 제공합니다. 이러한 NIC는 고대역폭 GPU 간 통신 전용이며 공개 인터넷 액세스와 같은 다른 네트워킹 요구사항에는 사용할 수 없습니다. 다음 다이어그램에 설명된 대로 각 CX-7 NIC는 비균일 메모리 액세스(NUMA)를 최적화하기 위해 GPU 1개와 정렬됩니다. 8개의 GPU는 모두 서로 연결하는 올투올(All-to-all) NVLink 브리지를 사용하여 서로 빠르게 통신할 수 있습니다. 나머지 두 개의 gVNIC 네트워크 인터페이스 카드는 범용 네트워킹 요구사항에 추가로 400Gbps의 네트워크 대역폭을 제공하는 스마트 NIC입니다. 네트워크 인터페이스 카드를 모두 합치면 이러한 머신에 최대 3,600Gbps의 네트워크 대역폭을 제공할 수 있습니다.

이러한 NIC를 여러 개 사용하려면 다음과 같이 가상 프라이빗 클라우드 네트워크 3개를 만들어야 합니다.

- 일반 VPC 네트워크 2개: 각 gVNIC는 서로 다른 VPC 네트워크에 연결되어야 합니다.

- RoCE VPC 네트워크 1개: 8개의 CX-7 NIC가 모두 동일한 RoCE VPC 네트워크를 공유합니다.

이러한 네트워크를 설정하려면 AI 하이퍼컴퓨터 문서의 VPC 네트워크 만들기를 참조하세요.

A4 VM

| 연결된 NVIDIA B200 Blackwell GPU | |||||||

|---|---|---|---|---|---|---|---|

| 머신 유형 | vCPU 수1 | 인스턴스 메모리(GB) | 연결된 로컬 SSD(GiB) | 물리적 NIC 수 | 최대 네트워크 대역폭(Gbps)2 | GPU 수 | GPU 메모리3 (GB HBM3e) |

a4-highgpu-8g |

224 | 3,968 | 12,000 | 10 | 3,600 | 8 | 1,440 |

A3 Ultra VM

| 연결된 NVIDIA H200 GPU | |||||||

|---|---|---|---|---|---|---|---|

| 머신 유형 | vCPU 수1 | 인스턴스 메모리(GB) | 연결된 로컬 SSD(GiB) | 물리적 NIC 수 | 최대 네트워크 대역폭(Gbps)2 | GPU 수 | GPU 메모리3 (GB HBM3e) |

a3-ultragpu-8g |

224 | 2,952 | 12,000 | 10 | 3,600 | 8 | 1128 |

A3 Mega, High, Edge 머신 유형

이러한 머신 유형에는 H100 GPU가 연결됩니다. 각 머신 유형에는 고정된 GPU 수, vCPU 수, 메모리 크기가 포함되어 있습니다.

- 단일 NIC A3 VM: GPU가 1~4개 연결된 A3 VM의 경우 단일 물리적 네트워크 인터페이스 카드(NIC)만 사용할 수 있습니다.

- 다중 NIC A3 VM: GPU 8개가 연결된 A3 VM의 경우 여러 개의 물리적 NIC를 사용할 수 있습니다. 이러한 A3 머신 유형의 경우 NIC는 PCIe(Peripheral Component Interconnect Express) 버스에서 다음과 같이 배열됩니다.

- A3 Mega 머신 유형: NIC 배열 8+1을 사용할 수 있습니다. 이렇게 구성하면 8개의 NIC가 동일한 PCIe 버스를 공유하며, 1개의 NIC가 별도의 PCIe 버스에 상주합니다.

- A3 High 머신 유형: NIC 배열 4+1을 사용할 수 있습니다. 이렇게 구성하면 4개의 NIC가 동일한 PCIe 버스를 공유하며, 1개의 NIC가 별도의 PCIe 버스에 상주합니다.

- A3 Edge 머신 유형 머신 유형: NIC 배열 4+1을 사용할 수 있습니다. 이렇게 구성하면 4개의 NIC가 동일한 PCIe 버스를 공유하며, 1개의 NIC가 별도의 PCIe 버스에 상주합니다. 이러한 5개의 NIC는 각 VM에 총 400Gbps의 네트워크 대역폭을 제공합니다.

동일한 PCIe 버스를 공유하는 NIC는 NVIDIA H100 GPU 2개당 NIC 1개의 비균일 메모리 액세스(NUMA) 정렬을 갖습니다. 이러한 NIC는 전용 고대역폭 GPU 간 통신에 적합합니다. 별도의 PCIe 버스에 있는 물리적 NIC는 다른 네트워킹 니즈에 적합합니다. A3 High 및 A3 Edge VM의 네트워킹을 설정하는 방법에 관한 안내는 점보 프레임 MTU 네트워크 설정을 참조하세요.

A3 Mega

| 연결된 NVIDIA H100 GPU | |||||||

|---|---|---|---|---|---|---|---|

| 머신 유형 | vCPU 수1 | 인스턴스 메모리(GB) | 연결된 로컬 SSD(GiB) | 물리적 NIC 수 | 최대 네트워크 대역폭(Gbps)2 | GPU 수 | GPU 메모리3 (GB HBM3) |

a3-megagpu-8g |

208 | 1,872 | 6,000 | 9 | 1,800 | 8 | 640 |

A3 High

| 연결된 NVIDIA H100 GPU | |||||||

|---|---|---|---|---|---|---|---|

| 머신 유형 | vCPU 수1 | 인스턴스 메모리(GB) | 연결된 로컬 SSD(GiB) | 물리적 NIC 수 | 최대 네트워크 대역폭(Gbps)2 | GPU 수 | GPU 메모리3 (GB HBM3) |

a3-highgpu-1g |

26 | 234 | 750 | 1 | 25 | 1 | 80 |

a3-highgpu-2g |

52 | 468 | 1,500 | 1 | 50 | 2 | 160 |

a3-highgpu-4g |

104 | 936 | 3,000 | 1 | 100 | 4 | 320 |

a3-highgpu-8g |

208 | 1,872 | 6,000 | 5 | 1,000 | 8 | 640 |

A3 Edge

| 연결된 NVIDIA H100 GPU | |||||||

|---|---|---|---|---|---|---|---|

| 머신 유형 | vCPU 수1 | 인스턴스 메모리(GB) | 연결된 로컬 SSD(GiB) | 물리적 NIC 수 | 최대 네트워크 대역폭(Gbps)2 | GPU 수 | GPU 메모리3 (GB HBM3) |

a3-edgegpu-8g |

208 | 1,872 | 6,000 | 5 |

|

8 | 640 |

1vCPU는 사용 가능한 CPU 플랫폼 중 하나에서 단일 하드웨어 하이퍼 스레드로 구현됩니다.

2 최대 이그레스 대역폭은 지정된 수를 초과할 수 없습니다. 실제 이그레스 대역폭은 대상 IP 주소와 기타 요인에 따라 다릅니다.

네트워크 대역폭에 대한 자세한 내용은 네트워크 대역폭을 참조하세요.

3GPU 메모리는 임시 데이터 스토리지에 사용할 수 있는 GPU 기기의 메모리입니다. 인스턴스의 메모리와는 별개이며 특히 그래픽 집약적인 워크로드의 더 높은 대역폭 수요를 처리하도록 설계되었습니다.

A2 머신 유형

각 A2 머신 유형에는 고정된 NVIDIA A100 40GB 또는 NVIDIA A100 80GB GPU가 연결됩니다. 각 머신 유형에는 또한 고정된 vCPU 개수 및 메모리 크기가 포함됩니다.

A2 머신 시리즈는 두 가지 유형으로 사용할 수 있습니다.

- A2 울트라: 이 머신 유형에는 A100 80GB GPU 및 로컬 SSD 디스크가 연결됩니다.

- A2 표준: 이 머신 유형에는 A100 40GB GPU가 연결됩니다.

A2 울트라

| 연결된 NVIDIA A100 80GB GPU | ||||||

|---|---|---|---|---|---|---|

| 머신 유형 | vCPU 수1 | 인스턴스 메모리(GB) | 연결된 로컬 SSD(GiB) | 최대 네트워크 대역폭(Gbps)2 | GPU 수 | GPU 메모리3 (GB HBM2e) |

a2-ultragpu-1g |

12 | 170 | 375 | 24 | 1 | 80 |

a2-ultragpu-2g |

24 | 340 | 750 | 32 | 2 | 160 |

a2-ultragpu-4g |

48 | 680 | 1,500 | 50 | 4 | 320 |

a2-ultragpu-8g |

96 | 1,360 | 3,000 | 100 | 8 | 640 |

A2 표준

| 연결된 NVIDIA A100 40GB GPU | ||||||

|---|---|---|---|---|---|---|

| 머신 유형 | vCPU 수1 | 인스턴스 메모리(GB) | 지원되는 로컬 SSD | 최대 네트워크 대역폭(Gbps)2 | GPU 수 | GPU 메모리3 (GB HBM2) |

a2-highgpu-1g |

12 | 85 | 예 | 24 | 1 | 40 |

a2-highgpu-2g |

24 | 170 | 예 | 32 | 2 | 80 |

a2-highgpu-4g |

48 | 340 | 예 | 50 | 4 | 160 |

a2-highgpu-8g |

96 | 680 | 예 | 100 | 8 | 320 |

a2-megagpu-16g |

96 | 1,360 | 예 | 100 | 16 | 640 |

1vCPU는 사용 가능한 CPU 플랫폼 중 하나에서 단일 하드웨어 하이퍼 스레드로 구현됩니다.

2 최대 이그레스 대역폭은 지정된 수를 초과할 수 없습니다. 실제 이그레스 대역폭은 대상 IP 주소와 기타 요인에 따라 다릅니다.

네트워크 대역폭에 대한 자세한 내용은 네트워크 대역폭을 참조하세요.

3GPU 메모리는 임시 데이터 스토리지에 사용할 수 있는 GPU 기기의 메모리입니다. 인스턴스의 메모리와는 별개이며 특히 그래픽 집약적인 워크로드의 더 높은 대역폭 수요를 처리하도록 설계되었습니다.

G4 머신 유형

G4 가속기 최적화 머신 유형은 NVIDIA RTX PRO 6000 Blackwell 서버 에디션 GPU (nvidia-rtx-pro-6000)를 사용하며 NVIDIA Omniverse 시뮬레이션 워크로드, 그래픽 집약적 애플리케이션, 동영상 트랜스코딩, 가상 데스크톱에 적합합니다. 또한 G4 머신 유형은 A 시리즈 머신 유형에 비해 단일 호스트 추론 및 모델 조정을 수행할 수 있는 저비용 솔루션을 제공합니다.

| 연결된 NVIDIA RTX PRO 6000 GPU | |||||||

|---|---|---|---|---|---|---|---|

| 머신 유형 | vCPU 수1 | 인스턴스 메모리(GB) | 지원되는 최대 티타늄 SSD(GiB)2 | 물리적 NIC 수 | 최대 네트워크 대역폭(Gbps)3 | GPU 수 | GPU 메모리4 (GB GDDR7) |

g4-standard-48 |

48 | 180 | 1,500 | 1 | 50 | 1 | 96 |

g4-standard-96 |

96 | 360 | 3,000 | 1 | 100 | 2 | 192 |

g4-standard-192 |

192 | 720 | 6,000 | 1 | 200 | 4 | 384 |

g4-standard-384 |

384 | 1,440 | 12,000 | 2 | 400 | 8 | 768 |

1vCPU는 사용 가능한 CPU 플랫폼 중 하나에서 단일 하드웨어 하이퍼 스레드로 구현됩니다.

2G4 인스턴스를 만들 때 티타늄 SSD 디스크를 추가할 수 있습니다. 연결할 수 있는 디스크 수는 로컬 SSD 디스크 수를 선택해야 하는 머신 유형을 참조하세요.

3최대 이그레스 대역폭은 지정된 수를 초과할 수 없습니다. 실제 이그레스 대역폭은 대상 IP 주소와 기타 요인에 따라 다릅니다.

네트워크 대역폭을 참조하세요.

4GPU 메모리는 임시 데이터 스토리지에 사용할 수 있는 GPU 기기의 메모리입니다. 인스턴스의 메모리와는 별개이며 특히 그래픽 집약적인 워크로드의 더 높은 대역폭 수요를 처리하도록 설계되었습니다.

G2 머신 유형

G2 가속기 최적화 머신 유형에는 NVIDIA L4 GPU가 연결되어 있으며 비용 최적화 추론, 그래픽 집약적 워크로드, 고성능 컴퓨팅 워크로드에 적합합니다.

각 G2 머신 유형에는 기본 메모리와 커스텀 메모리 범위도 있습니다. 커스텀 메모리 범위는 각 머신 유형의 인스턴스에 할당할 수 있는 메모리 양을 정의합니다. G2 인스턴스를 만들 때 로컬 SSD 디스크를 추가할 수도 있습니다. 연결할 수 있는 디스크 수는 로컬 SSD 디스크 수를 선택해야 하는 머신 유형을 참조하세요.

대부분의 GPU 인스턴스에 적용되는 더 높은 네트워크 대역폭 속도(50Gbps 이상)를 얻기 위해서는 Google Virtual NIC(gVNIC)를 사용하는 것이 좋습니다. gVNIC를 사용하는 GPU 인스턴스를 만드는 방법에 대한 자세한 내용은 더 높은 대역폭을 사용하는 GPU 인스턴스 만들기를 참조하세요.

| 연결된 NVIDIA L4 GPU | |||||||

|---|---|---|---|---|---|---|---|

| 머신 유형 | vCPU 수1 | 기본 인스턴스 메모리(GB) | 커스텀 인스턴스 메모리 범위(GB) | 지원되는 최대 로컬 SSD(GiB) | 최대 네트워크 대역폭(Gbps)2 | GPU 수 | GPU 메모리3(GB GDDR6) |

g2-standard-4 |

4 | 16 | 16~32 | 375 | 10 | 1 | 24 |

g2-standard-8 |

8 | 32 | 32~54 | 375 | 16 | 1 | 24 |

g2-standard-12 |

12 | 48 | 48~54 | 375 | 16 | 1 | 24 |

g2-standard-16 |

16 | 64 | 54~64 | 375 | 32 | 1 | 24 |

g2-standard-24 |

24 | 96 | 96~108 | 750 | 32 | 2 | 48 |

g2-standard-32 |

32 | 128 | 96~128 | 375 | 32 | 1 | 24 |

g2-standard-48 |

48 | 192 | 192~216 | 1,500 | 50 | 4 | 96 |

g2-standard-96 |

96 | 384 | 384~432 | 3,000 | 100 | 8 | 192 |

1vCPU는 사용 가능한 CPU 플랫폼 중 하나에서 단일 하드웨어 하이퍼 스레드로 구현됩니다.

2 최대 이그레스 대역폭은 지정된 수를 초과할 수 없습니다. 실제 이그레스 대역폭은 대상 IP 주소와 기타 요인에 따라 다릅니다.

네트워크 대역폭에 대한 자세한 내용은 네트워크 대역폭을 참조하세요.

3GPU 메모리는 임시 데이터 스토리지에 사용할 수 있는 GPU 기기의 메모리입니다. 인스턴스의 메모리와는 별개이며 특히 그래픽 집약적인 워크로드의 더 높은 대역폭 수요를 처리하도록 설계되었습니다.

N1 + GPU 머신 유형

T4 및 V100 GPU가 연결된 N1 범용 인스턴스의 경우 GPU 및 vCPU 개수 조합에 따라 최대 100Gbps까지 최대 네트워크 대역폭을 사용할 수 있습니다. 다른 모든 N1 GPU 인스턴스의 경우 개요를 참조하세요.

다음 섹션을 검토해서 GPU 모델, vCPU, GPU 수에 따라 T4 및 V100 인스턴스에 사용 가능한 최대 네트워크 대역폭을 계산합니다.

vCPU 5개 이하

vCPU가 5개 이하인 T4 및 V100 인스턴스의 경우 사용 가능한 최대 네트워크 대역폭은 10Gbps입니다.

vCPU 5개 초과

vCPU가 5개를 초과하는 T4 및 V100 인스턴스의 경우 최대 네트워크 대역폭은 해당 VM의 vCPU 및 GPU 개수를 기준으로 계산됩니다.

대부분의 GPU 인스턴스에 적용되는 더 높은 네트워크 대역폭 속도(50Gbps 이상)를 얻기 위해서는 Google Virtual NIC(gVNIC)를 사용하는 것이 좋습니다. gVNIC를 사용하는 GPU 인스턴스를 만드는 방법에 대한 자세한 내용은 더 높은 대역폭을 사용하는 GPU 인스턴스 만들기를 참조하세요.

| GPU 모델 | GPU 수 | 최대 네트워크 대역폭 계산 |

|---|---|---|

| NVIDIA V100 | 1 | min(vcpu_count * 2, 32) |

| 2 | min(vcpu_count * 2, 32) |

|

| 4 | min(vcpu_count * 2, 50) |

|

| 8 | min(vcpu_count * 2, 100) |

|

| NVIDIA T4 | 1 | min(vcpu_count * 2, 32) |

| 2 | min(vcpu_count * 2, 50) |

|

| 4 | min(vcpu_count * 2, 100) |

MTU 설정 및 GPU 머신 유형

네트워크 대역폭을 최대화하려면 VPC 네트워크의 최대 전송 단위(MTU) 값을 더 높게 설정하세요. MTU 값이 클수록 패킷 크기가 증가하고 패킷 헤더 오버헤드가 줄어들어 페이로드 데이터 처리량이 증가합니다.

GPU 머신 유형의 경우 VPC 네트워크에 다음 MTU 설정을 사용하는 것이 좋습니다.

| GPU 머신 유형 | 권장 MTU(바이트) | |

|---|---|---|

| VPC 네트워크 | RDMA 프로필이 있는 VPC 네트워크 | |

|

8896 | 8896 |

|

8244 | 해당 사항 없음 |

|

8896 | 해당 사항 없음 |

MTU 값을 설정할 때는 다음 사항에 유의하세요.

- 8192는 4KB 페이지 두 개입니다.

- 헤더 분할이 사용 설정된 GPU NIC의 경우 A3 Mega, A3 High, A3 Edge VM에서 8244가 권장됩니다.

- 표에 달리 명시되지 않는 한 8896 값을 사용합니다.

대역폭이 높은 GPU 머신 만들기

더 높은 네트워크 대역폭을 사용하는 GPU 인스턴스를 만들려면 머신 유형에 따라 다음 방법 중 하나를 사용하세요.

더 높은 네트워크 대역폭을 사용하는 A2, G2, N1 인스턴스를 만들려면 A2, G2, N1 인스턴스에 더 높은 네트워크 대역폭 사용을 참조하세요. 이러한 머신의 대역폭 속도를 테스트하거나 확인하려면 벤치마킹 테스트를 사용할 수 있습니다. 자세한 내용은 네트워크 대역폭 확인을 참조하세요.

더 높은 네트워크 대역폭을 사용하는 A3 Mega 인스턴스를 만들려면 ML 학습을 위한 A3 Mega Slurm 클러스터 배포를 참조하세요. 이러한 머신의 대역폭 속도를 테스트하거나 확인하려면 네트워크 대역폭 확인의 단계를 따라 벤치마킹 테스트를 사용하세요.

더 높은 네트워크 대역폭을 사용하는 A3 High 및 A3 Edge 인스턴스의 경우 GPUDirect-TCPX가 사용 설정된 A3 VM 만들기를 참조하세요. 이러한 머신의 대역폭 속도를 테스트하거나 확인하려면 벤치마킹 테스트를 사용할 수 있습니다. 자세한 내용은 네트워크 대역폭 확인을 참조하세요.

다른 가속기 최적화 머신 유형의 경우 더 높은 네트워크 대역폭을 사용하기 위해 필요한 조치가 없습니다. 설명된 대로 인스턴스를 만들면 이미 높은 네트워크 대역폭이 사용됩니다. 다른 가속기 최적화 머신 유형의 인스턴스를 만드는 방법을 알아보려면 GPU가 연결된 VM 만들기를 참조하세요.

다음 단계

- GPU 플랫폼 자세히 알아보기

- GPU가 연결된 인스턴스를 만드는 방법 알아보기

- 더 높은 네트워크 대역폭 사용 알아보기

- GPU 가격 책정 자세히 알아보기