Os SSDs locais foram projetados para casos de uso de armazenamento temporário como caches ou espaço de processamento de trabalho. Como os SSDs locais estão localizados na máquina física em que a VM está sendo executada, só é possível criá-los durante o processo de criação da VM. Não é possível usar os SSDs locais como dispositivos de inicialização.

Para a série de máquinas de terceira geração e versões mais recentes, uma quantidade definida de discos SSD locais é adicionada à VM quando você a cria. A única maneira de adicionar armazenamento SSD local a essas VMs é:

- Para C4, C4D, C3 e C3D, o armazenamento SSD local está disponível apenas com

determinados tipos de máquina, como

c3-standard-88-lssd. - Para as séries de máquinas ultra Z3, A4, A4X, A3 e A2, cada tipo de máquina vem com armazenamento SSD local.

Para os tipos de máquina M3 e de primeira e segunda geração, especifique discos SSD locais ao criar a VM.

Depois de criar um SSD local, formate e ative o dispositivo antes de usá-lo.

Para informações sobre a quantidade de armazenamento SSD local disponível com vários tipos de máquina e o número de discos SSD locais que você pode anexar a uma VM, consulteComo escolher um número válido de SSDs locais.

Antes de começar

- Confira as limitações do SSD local antes de usá-lo.

- Analise os cenários de persistência de dados dos discos SSD locais.

- Se você estiver adicionando SSDs locais a instâncias de máquinas virtuais (VM) com GPUs anexadas, consulte Disponibilidade de SSDs locais por regiões e zonas de GPU.

-

Configure a autenticação, caso ainda não tenha feito isso.

Com isso, você confirma sua identidade para acesso a serviços e APIs do Google Cloud . Para executar código ou exemplos em um ambiente de desenvolvimento local, faça a autenticação no Compute Engine com um destes métodos:

Select the tab for how you plan to use the samples on this page:

Console

When you use the Google Cloud console to access Google Cloud services and APIs, you don't need to set up authentication.

gcloud

-

Instale a CLI do Google Cloud. Após a instalação, inicialize a CLI do Google Cloud executando o seguinte comando:

gcloud initAo usar um provedor de identidade (IdP) externo, primeiro faça login na gcloud CLI com sua identidade federada.

- Set a default region and zone.

Terraform

Para usar os exemplos do Terraform desta página em um ambiente de desenvolvimento local, instale e inicialize a gcloud CLI e configure o Application Default Credentials com suas credenciais de usuário.

Instale a CLI do Google Cloud.

Ao usar um provedor de identidade (IdP) externo, primeiro faça login na gcloud CLI com sua identidade federada.

If you're using a local shell, then create local authentication credentials for your user account:

gcloud auth application-default login

You don't need to do this if you're using Cloud Shell.

If an authentication error is returned, and you are using an external identity provider (IdP), confirm that you have signed in to the gcloud CLI with your federated identity.

Saiba mais em Set up authentication for a local development environment.

Go

Para usar os exemplos do Go desta página em um ambiente de desenvolvimento local, instale e inicialize a gcloud CLI e configure o Application Default Credentials com suas credenciais de usuário.

Instale a CLI do Google Cloud.

Ao usar um provedor de identidade (IdP) externo, primeiro faça login na gcloud CLI com sua identidade federada.

If you're using a local shell, then create local authentication credentials for your user account:

gcloud auth application-default login

You don't need to do this if you're using Cloud Shell.

If an authentication error is returned, and you are using an external identity provider (IdP), confirm that you have signed in to the gcloud CLI with your federated identity.

Saiba mais em Set up authentication for a local development environment.

Java

Para usar os exemplos do Java desta página em um ambiente de desenvolvimento local, instale e inicialize a gcloud CLI e configure o Application Default Credentials com suas credenciais de usuário.

Instale a CLI do Google Cloud.

Ao usar um provedor de identidade (IdP) externo, primeiro faça login na gcloud CLI com sua identidade federada.

If you're using a local shell, then create local authentication credentials for your user account:

gcloud auth application-default login

You don't need to do this if you're using Cloud Shell.

If an authentication error is returned, and you are using an external identity provider (IdP), confirm that you have signed in to the gcloud CLI with your federated identity.

Saiba mais em Set up authentication for a local development environment.

Python

Para usar os exemplos do Python desta página em um ambiente de desenvolvimento local, instale e inicialize a gcloud CLI e configure o Application Default Credentials com suas credenciais de usuário.

Instale a CLI do Google Cloud.

Ao usar um provedor de identidade (IdP) externo, primeiro faça login na gcloud CLI com sua identidade federada.

If you're using a local shell, then create local authentication credentials for your user account:

gcloud auth application-default login

You don't need to do this if you're using Cloud Shell.

If an authentication error is returned, and you are using an external identity provider (IdP), confirm that you have signed in to the gcloud CLI with your federated identity.

Saiba mais em Set up authentication for a local development environment.

REST

Para usar as amostras da API REST desta página em um ambiente de desenvolvimento local, use as credenciais fornecidas para gcloud CLI.

Instale a CLI do Google Cloud.

Ao usar um provedor de identidade (IdP) externo, primeiro faça login na gcloud CLI com sua identidade federada.

Saiba mais em Autenticar para usar REST na documentação de autenticação do Google Cloud .

Criar uma VM com um SSD local

É possível criar uma VM com armazenamento em disco SSD local usando o Google Cloud console, a CLI gcloud ou a API Compute Engine.

Console

Acesse a página Criar uma instância.

Especifique o Nome, a Região e a Zona da VM. Opcionalmente, adicione tags ou rótulos.

Na seção Configuração da máquina, escolha a família de máquinas que contém o tipo de máquina de destino.

Selecione uma série na lista Série e escolha o tipo de máquina.

- Para C4, C4D, C3 e C3D, escolha um tipo de máquina que termine em

-lssd. - Para Z3, A4, A4X, A3 e A2 Ultra, cada tipo de máquina vem com armazenamento SSD local.

- No caso do M3 ou de séries de máquinas de primeira e segunda geração, depois de selecionar

o tipo de máquina, faça o seguinte:

- Expanda a seção Opções avançadas.

- Expanda Discos, clique em Adicionar SSD local e faça o seguinte:

- Na página Configurar SSD local, escolha o tipo de interface do disco.

- Selecione o número de discos que você quer na lista Capacidade de disco.

- Clique em Salvar.

- Para C4, C4D, C3 e C3D, escolha um tipo de máquina que termine em

Continue com o processo de criação da VM.

Depois de criar a VM com discos SSD locais, formate e ative cada dispositivo antes de usar os discos.

gcloud

Para as séries de máquinas ultra Z3, A4, A4X, A3 e A2, para criar uma VM com discos SSD locais anexados, crie uma VM que use qualquer um dos tipos de máquina disponíveis para essa série, seguindo as instruções para criar uma instância.

Para as séries de máquinas C4, C4D, C3 e C3D, para criar uma VM com discos SSD locais anexados, siga as instruções para criar uma instância, mas especifique um tipo de instância que inclua discos SSD locais (

-lssd).Por exemplo, é possível criar uma VM C3 com duas partições SSD locais que usam a interface do disco NVMe da seguinte maneira:

gcloud compute instances create example-c3-instance \ --zone ZONE \ --machine-type c3-standard-8-lssd \ --image-project IMAGE_PROJECT \ --image-family IMAGE_FAMILY

Para as séries de máquinas M3 e de primeira e segunda geração, para criar uma VM com discos SSD locais anexados, siga as instruções para criar uma instância, mas use o

--local-ssdpara criar e anexar um disco SSD local. Para criar várias partições de SSD local, adicione mais sinalizações--local-ssd. Se quiser, também é possível definir valores da interface e o nome do dispositivo de cada sinalização--local-ssd.Por exemplo, é possível criar uma VM do M3 com quatro discos SSD locais e especificar o tipo de interface do disco da seguinte maneira:

gcloud compute instances create VM_NAME \ --machine-type m3-ultramem-64 \ --zone ZONE \ --local-ssd interface=INTERFACE_TYPE,device-name=DEVICE-NAME \ --local-ssd interface=INTERFACE_TYPE,device-name=DEVICE-NAME \ --local-ssd interface=INTERFACE_TYPE,device-name=DEVICE-NAME \ --local-ssd interface=INTERFACE_TYPE \ --image-project IMAGE_PROJECT \ --image-family IMAGE_FAMILY

Substitua:

- VM_NAME: o nome da nova VM;

- ZONE: zona em que a VM será criada. Essa sinalização é

opcional se você tiver configurado a propriedade

compute/zoneda CLI gcloud ou a variável de ambienteCLOUDSDK_COMPUTE_ZONE. - INTERFACE_TYPE: é o tipo de interface do disco que você quer usar para o dispositivo SSD local. Especifique

nvmese estiver criando uma VM M3 ou se a imagem do disco de inicialização tiver drivers NVMe otimizados. Especifiquescsipara outras imagens. - DEVICE-NAME (opcional): um nome que indica o nome do disco a ser usado no link simbólico (link simbólico) do sistema operacional convidado.

- IMAGE_FAMILY: é uma das famílias de imagens disponíveis que você quer instalar no disco de inicialização

- IMAGE_PROJECT: o projeto de imagem ao qual a família de imagens pertence.

Se necessário, anexe SSDs locais a uma VM de primeira ou segunda geração usando uma combinação de

nvmeescsipara diferentes partições. O desempenho do dispositivonvmedepende da imagem de disco de inicialização da instância. As VMs de terceira geração oferecem suporte apenas à interface de disco NVMe.Depois de criar uma VM com o SSD local, formate e ative cada dispositivo antes de usá-lo.

Terraform

Para criar uma VM com discos SSD locais anexados, use o recurso

google_compute_instance.Para saber como aplicar ou remover uma configuração do Terraform, consulte Comandos básicos do Terraform.

Para gerar o código do Terraform, use o componente Código equivalente no console do Google Cloud .- No console do Google Cloud , acesse a página Instâncias de VM.

- Clique em Criar instância.

- Especifique os parâmetros desejados.

- Na parte superior ou inferior da página, clique em Código equivalente e, em seguida, clique na guia Terraform para ver o código do Terraform.

Go

Go

Antes de testar esta amostra, siga as instruções de configuração do Go no Guia de início rápido do Compute Engine: como usar bibliotecas de cliente. Para mais informações, consulte a documentação de referência da API Go do Compute Engine.

Para autenticar-se no Compute Engine, configure o Application Default Credentials. Para mais informações, consulte Configurar a autenticação para um ambiente de desenvolvimento local.

Java

Java

Antes de testar esta amostra, siga as instruções de configuração do Java no Guia de início rápido do Compute Engine: como usar bibliotecas de cliente. Para mais informações, consulte a documentação de referência da API Java do Compute Engine.

Para autenticar-se no Compute Engine, configure o Application Default Credentials. Para mais informações, consulte Configurar a autenticação para um ambiente de desenvolvimento local.

Python

Python

Antes de testar esta amostra, siga as instruções de configuração do Python no Guia de início rápido do Compute Engine: como usar bibliotecas de cliente. Para mais informações, consulte a documentação de referência da API Python do Compute Engine.

Para autenticar-se no Compute Engine, configure o Application Default Credentials. Para mais informações, consulte Configurar a autenticação para um ambiente de desenvolvimento local.

REST

Use o

instances.insert methodpara criar uma VM a partir de uma família de imagens ou de uma versão específica de uma imagem do sistema operacional.- Para as séries de máquinas ultra Z3, A4, A4X, A3 e A2, para criar uma VM com discos SSD locais anexados, crie uma VM que use qualquer um dos tipos de máquina disponíveis para essa série.

Para as séries de máquinas C4, C4D, C3 e C3D, para criar uma VM com discos SSD locais anexados, especifique um tipo de instância que inclua discos SSD locais (

-lssd).Veja um exemplo de payload de solicitação que cria uma VM C3 com um disco de inicialização do Ubuntu e dois discos SSD locais:

{ "machineType":"zones/us-central1-c/machineTypes/c3-standard-8-lssd", "name":"c3-with-local-ssd", "disks":[ { "type":"PERSISTENT", "initializeParams":{ "sourceImage":"projects/ubuntu-os-cloud/global/images/family/ubuntu-2204-lts" }, "boot":true } ], "networkInterfaces":[ { "network":"global/networks/default" } ] }Para as séries de máquinas M3 e de primeira e segunda geração, para criar uma VM com discos SSD locais anexados, é possível adicionar dispositivos SSD locais durante a criação da VM usando a propriedade

initializeParams. Forneça também as propriedades a seguir:diskType: definido como o SSD localautoDelete: definido como verdadeirotype: definido comoSCRATCH

Não é possível usar as propriedades a seguir com dispositivos SSD locais:

diskName- Propriedade

sourceImage diskSizeGb

Veja um exemplo de payload de solicitação que cria uma VM M3 com um disco de inicialização e quatro discos SSD locais:

{ "machineType":"zones/us-central1-f/machineTypes/m3-ultramem-64", "name":"local-ssd-instance", "disks":[ { "type":"PERSISTENT", "initializeParams":{ "sourceImage":"projects/ubuntu-os-cloud/global/images/family/ubuntu-2204-lts" }, "boot":true }, { "type":"SCRATCH", "initializeParams":{ "diskType":"zones/us-central1-f/diskTypes/local-ssd" }, "autoDelete":true, "interface": "NVME" }, { "type":"SCRATCH", "initializeParams":{ "diskType":"zones/us-central1-f/diskTypes/local-ssd" }, "autoDelete":true, "interface": "NVME" }, { "type":"SCRATCH", "initializeParams":{ "diskType":"zones/us-central1-f/diskTypes/local-ssd" }, "autoDelete":true, "interface": "NVME" }, { "type":"SCRATCH", "initializeParams":{ "diskType":"zones/us-central1-f/diskTypes/local-ssd" }, "autoDelete":true, "interface": "NVME" }, ], "networkInterfaces":[ { "network":"global/networks/default" } ] }

Depois de criar um SSD local, formate e ative cada dispositivo antes de usá-lo.

Para mais informações sobre como criar uma instância usando REST, consulte a API Compute Engine.

Formatar e ativar um dispositivo SSD local

É possível formatar e ativar cada disco SSD local individualmente ou combinar vários discos SSD locais em um único volume lógico.

Formatar e ativar partições SSD locais individuais

O jeito mais fácil de conectar SSDs locais à instância é formatar e ativar cada dispositivo com uma partição simples. Como alternativa, combine várias partições em um único volume lógico.

Instâncias do Linux

Formate e ative o novo SSD local na instância do Linux. Use qualquer formato de partição e configuração que precisar. Neste exemplo, crie uma única partição

ext4.Acesse a página "Instâncias de VM".

Clique no botão SSH ao lado da instância que tem o novo SSD local anexado. O navegador abrirá uma conexão de terminal com a instância.

No terminal, use o comando

findpara identificar o SSD local que você quer ativar.$ find /dev/ | grep google-local-nvme-ssdOs SSDs locais no modo SCSI têm nomes padrão como

google-local-ssd-0. Os SSDs locais no modo NVMe têm nomes comogoogle-local-nvme-ssd-0, conforme mostrado na saída a seguir:$ find /dev/ | grep google-local-nvme-ssd /dev/disk/by-id/google-local-nvme-ssd-0

Formate o SSD local com um sistema de arquivos ext4. Esse comando exclui todos os dados atuais do SSD local.

$ sudo mkfs.ext4 -F /dev/disk/by-id/[SSD_NAME]Substitua

[SSD_NAME]pelo ID do SSD local que você quer formatar. Por exemplo, especifiquegoogle-local-nvme-ssd-0para formatar o primeiro SSD local NVMe na instância.Use o comando

mkdirpara criar um diretório em que seja possível ativar o dispositivo.$ sudo mkdir -p /mnt/disks/[MNT_DIR]Substitua

[MNT_DIR]pelo caminho do diretório em que você quer ativar o disco SSD local.Ative o SSD local na VM.

$ sudo mount /dev/disk/by-id/[SSD_NAME] /mnt/disks/[MNT_DIR]Substitua:

[SSD_NAME]: o ID do SSD local que você quer ativar.[MNT_DIR]: o diretório em que você quer ativar o SSD local.

Configure o acesso de leitura e gravação no dispositivo. Neste exemplo, conceda acesso de gravação no dispositivo a todos os usuários.

$ sudo chmod a+w /mnt/disks/[MNT_DIR]Substitua

[MNT_DIR]pelo diretório em que você ativou o SSD local.

Se quiser, adicione o SSD local ao arquivo

/etc/fstabpara que o dispositivo seja reativado automaticamente quando a instância for reiniciada. Essa entrada não preserva dados no SSD local se a instância for interrompida. Consulte Persistência de dados do SSD local para ver todos os detalhes.Ao especificar o arquivo

/etc/fstabde entrada, inclua a opçãonofailpara que a instância possa continuar a inicialização mesmo que o SSD local não esteja presente. Por exemplo, se você tirar um snapshot do disco de inicialização e criar uma nova instância sem nenhum disco permanente vinculado, a instância poderá continuar o processo de inicialização sem pausar indefinidamente.Crie a entrada

/etc/fstab. Use o comandoblkidpara localizar o UUID do sistema de arquivos no dispositivo e edite o arquivo/etc/fstabpara incluir esse UUID com as opções de ativação. É possível concluir esta etapa com um único comando.Por exemplo, para um SSD local no modo NVMe, use o seguinte comando:

$ echo UUID=`sudo blkid -s UUID -o value /dev/disk/by-id/google-local-nvme-ssd-0` /mnt/disks/[MNT_DIR] ext4 discard,defaults,nofail 0 2 | sudo tee -a /etc/fstabPara um SSD local em um modo não NVMe, como SCSI, use o seguinte comando:

$ echo UUID=`sudo blkid -s UUID -o value /dev/disk/by-id/google-local-ssd-0` /mnt/disks/[MNT_DIR] ext4 discard,defaults,nofail 0 2 | sudo tee -a /etc/fstabSubstitua

[MNT_DIR]pelo diretório em que você ativou o SSD local.Use o comando

catpara verificar se as entradas/etc/fstabestão corretas:$ cat /etc/fstab

Se você criar um snapshot a partir do disco de inicialização dessa instância e usá-lo para gerar uma instância separada que não tenha SSDs locais, edite o arquivo

/etc/fstabe remova a entrada desse SSD local. Mesmo com a opçãonofail, mantenha o arquivo/etc/fstabsincronizado com as partições anexadas à instância e remova essas entradas antes de criar o snapshot do disco de inicialização.Instâncias do Windows

Use a ferramenta de gerenciamento de disco do Windows para formatar e ativar um SSD local em uma instância do Windows.

Conecte-se à instância por meio do RDP. Neste exemplo, acesse a página "Instâncias de VM" e clique no botão RDP ao lado da instância que tem os SSDs locais anexados. Depois de inserir o nome de usuário e a senha, uma janela é aberta com a interface da área de trabalho do servidor.

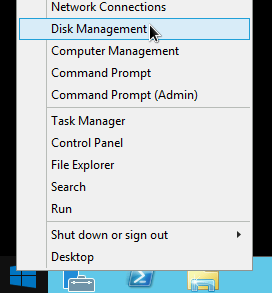

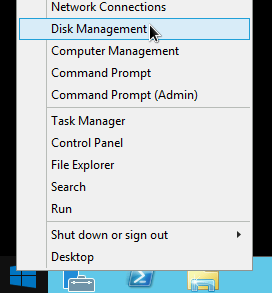

Clique com o botão direito do mouse no botão "Iniciar" do Windows e selecione Gerenciamento de Disco.

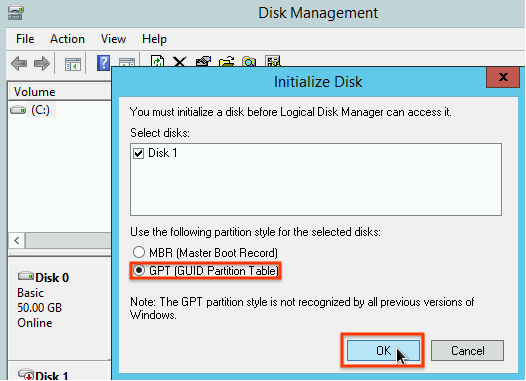

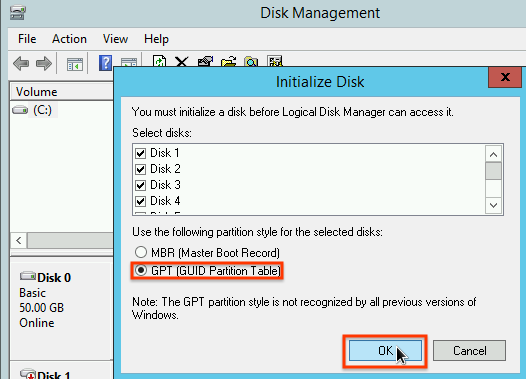

Se você não inicializou o SSD locais antes, a ferramenta solicitará que você selecione um esquema de particionamento para as novas partições. Selecione GPT e clique em OK.

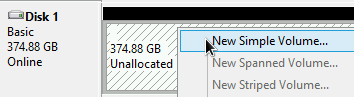

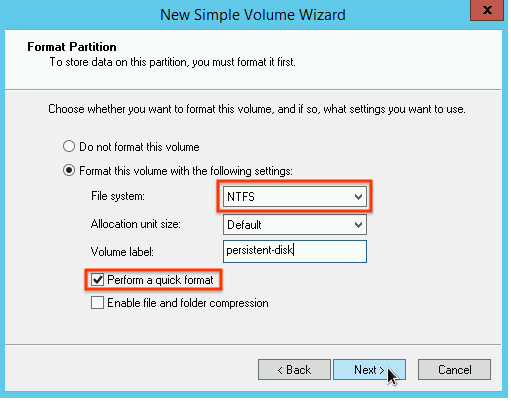

Após a inicialização do SSD local, clique com o botão direito do mouse no espaço em disco não alocado e selecione Novo Volume Simples.

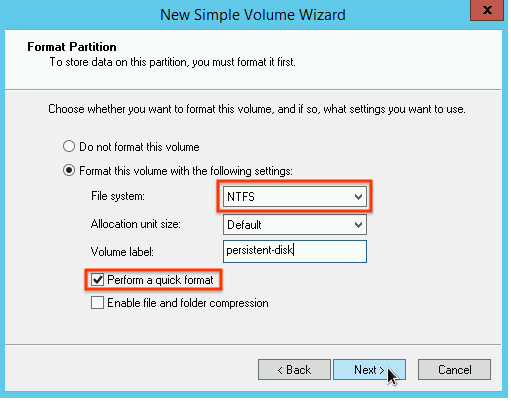

Siga as instruções no Assistente para Novas Partições Simples para configurar o novo volume. É possível usar qualquer formato de partição que preferir, mas, neste exemplo, selecione

NTFS. Além disso, marque Executar uma formatação rápida para acelerar esse processo.

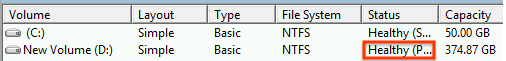

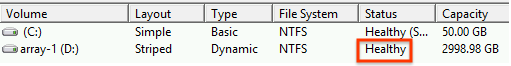

Após a conclusão do assistente e da formatação do volume, verifique se o novo SSD local tem o status

Healthy.

Pronto. Agora é possível gravar arquivos no SSD local.

Formatar e ativar várias partições de SSD local em um único volume lógico

Ao contrário dos SSDs permanentes, os SSDs locais têm uma capacidade fixa de 375 GB para cada dispositivo anexado à instância. Se quiser combinar várias partições de SSDs locais em um único volume lógico, defina o gerenciamento de volume em todas essas partições.

Instâncias do Linux

Use

mdadmpara criar uma matriz RAID 0. Neste exemplo, a matriz é formatada com um único sistema de arquivosext4, mas é possível aplicar qualquer sistema de arquivos que quiser.Acesse a página "Instâncias de VM".

Clique no botão SSH ao lado da instância que tem o novo SSD local anexado. O navegador abrirá uma conexão de terminal com a instância.

No terminal, instale a ferramenta

mdadm. O processo de instalação demdadminclui um prompt do usuário que interrompe os scripts. Por isso, execute esse processo manualmente.Debian e Ubuntu:

$ sudo apt update && sudo apt install mdadm --no-install-recommendsCentOS e RHEL:

$ sudo yum install mdadm -ySLES e openSUSE:

$ sudo zypper install -y mdadmUse o comando

findpara identificar todos os SSDs locais que você quer ativar:Neste exemplo, a instância tem oito partições de SSDs locais no modo NVMe:

$ find /dev/ | grep google-local-nvme-ssd /dev/disk/by-id/google-local-nvme-ssd-7 /dev/disk/by-id/google-local-nvme-ssd-6 /dev/disk/by-id/google-local-nvme-ssd-5 /dev/disk/by-id/google-local-nvme-ssd-4 /dev/disk/by-id/google-local-nvme-ssd-3 /dev/disk/by-id/google-local-nvme-ssd-2 /dev/disk/by-id/google-local-nvme-ssd-1 /dev/disk/by-id/google-local-nvme-ssd-0

findnão garante uma ordem. Não tem problema se os dispositivos estiverem listados em uma ordem diferente, desde que o número de linhas de saída corresponda ao número esperado de partições SSD. Os SSDs locais no modo SCSI têm nomes padrão comogoogle-local-ssd. Os SSDs locais no modo NVMe têm nomes comogoogle-local-nvme-ssd.Use

mdadmpara combinar vários dispositivos de SSD local em uma única matriz chamada/dev/md0. Neste exemplo, são combinados oito dispositivos de SSD local no modo NVMe. Para dispositivos de SSD local no modo SCSI, especifique os nomes que você conseguiu a partir do comandofind:$ sudo mdadm --create /dev/md0 --level=0 --raid-devices=8 \ /dev/disk/by-id/google-local-nvme-ssd-0 \ /dev/disk/by-id/google-local-nvme-ssd-1 \ /dev/disk/by-id/google-local-nvme-ssd-2 \ /dev/disk/by-id/google-local-nvme-ssd-3 \ /dev/disk/by-id/google-local-nvme-ssd-4 \ /dev/disk/by-id/google-local-nvme-ssd-5 \ /dev/disk/by-id/google-local-nvme-ssd-6 \ /dev/disk/by-id/google-local-nvme-ssd-7 mdadm: Defaulting to version 1.2 metadata mdadm: array /dev/md0 started.

É possível confirmar os detalhes da matriz com

mdadm --detail. Adicionar a sinalização--prefer=by-idlistará os dispositivos usando os caminhos/dev/disk/by-id.sudo mdadm --detail --prefer=by-id /dev/md0

A saída será semelhante à mostrada a seguir para cada dispositivo na matriz.

... Number Major Minor RaidDevice State 0 259 0 0 active sync /dev/disk/by-id/google-local-nvme-ssd-0 ...Formate a matriz

/dev/md0inteira com um sistema de arquivos ext4.$ sudo mkfs.ext4 -F /dev/md0Crie um diretório em que seja possível ativar

/dev/md0. Neste exemplo, crie o diretório/mnt/disks/ssd-array:$ sudo mkdir -p /mnt/disks/[MNT_DIR]Substitua

[MNT_DIR]pelo diretório em que você quer ativar a matriz do SSD local.Ative a matriz

/dev/md0no diretório/mnt/disks/ssd-array:$ sudo mount /dev/md0 /mnt/disks/[MNT_DIR]Substitua

[MNT_DIR]pelo diretório em que você quer ativar a matriz do SSD local.Configure o acesso de leitura e gravação no dispositivo. Neste exemplo, conceda acesso de gravação no dispositivo a todos os usuários.

$ sudo chmod a+w /mnt/disks/[MNT_DIR]Substitua

[MNT_DIR]pelo diretório em que você ativou a matriz do SSD local.

Se quiser, adicione o SSD local ao arquivo

/etc/fstabpara que o dispositivo seja reativado automaticamente quando a instância for reiniciada. Essa entrada não preserva dados no SSD local se a instância for interrompida. Consulte Permanência de dados do SSD local para mais detalhes.Ao especificar o arquivo

/etc/fstabde entrada, inclua a opçãonofailpara que a instância possa continuar a inicialização mesmo que o SSD local não esteja presente. Por exemplo, se você gerar um snapshot do disco de inicialização e criar uma instância nova sem SSDs locais anexados, a instância poderá continuar o processo de inicialização sem pausar indefinidamente.Crie a entrada

/etc/fstab. Use o comandoblkidpara localizar o UUID do sistema de arquivos no dispositivo e edite o arquivo/etc/fstabpara incluir esse UUID com as opções de ativação. Especifique a opçãonofailpara permitir que o sistema seja inicializado mesmo se o SSD local estiver indisponível. É possível concluir essa etapa com um único comando. Exemplo:$ echo UUID=`sudo blkid -s UUID -o value /dev/md0` /mnt/disks/[MNT_DIR] ext4 discard,defaults,nofail 0 2 | sudo tee -a /etc/fstabSubstitua

[MNT_DIR]pelo diretório em que você ativou a matriz do SSD local.Se você usar um nome de dispositivo como

/dev/md0no arquivo/etc/fstabem vez de UUID, precisará editar o arquivo/etc/mdadm/mdadm.confpara garantir que a matriz seja remontada automaticamente na inicialização. Para isso, siga as duas etapas a seguir:- Verifique se a matriz do disco foi verificada e remontada automaticamente na inicialização.

$ sudo mdadm --detail --scan | sudo tee -a /etc/mdadm/mdadm.conf - Atualize

initramfspara que a matriz esteja disponível durante o processo de inicialização antecipada.$ sudo update-initramfs -u

- Verifique se a matriz do disco foi verificada e remontada automaticamente na inicialização.

Use o comando

catpara verificar se as entradas/etc/fstabestão corretas:$ cat /etc/fstab

Se você criar um snapshot a partir do disco de inicialização dessa instância e usá-lo para gerar uma instância separada que não tenha SSDs locais, edite o arquivo

/etc/fstabe remova a entrada dessa matriz de SSD local. Mesmo com a opçãonofail, mantenha o arquivo/etc/fstabsincronizado com as partições anexadas à instância e remova essas entradas antes de criar o snapshot do disco de inicialização.Instâncias do Windows

Use a ferramenta de gerenciamento de disco do Windows para formatar e ativar uma matriz de SSDs locais em uma instância do Windows.

Conecte-se à instância por meio do RDP. Neste exemplo, acesse a página "Instâncias de VM" e clique no botão RDP ao lado da instância que tem os SSDs locais anexados. Depois de inserir o nome de usuário e a senha, uma janela é aberta com a interface da área de trabalho do servidor.

Clique com o botão direito do mouse no botão "Iniciar" do Windows e selecione Gerenciamento de Disco.

Se você não inicializou os SSDs locais antes, a ferramenta solicitará que você selecione um esquema de particionamento para as novas partições. Selecione GPT e clique em OK.

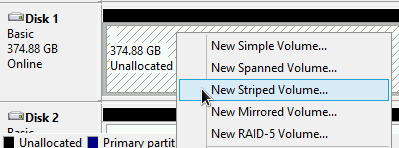

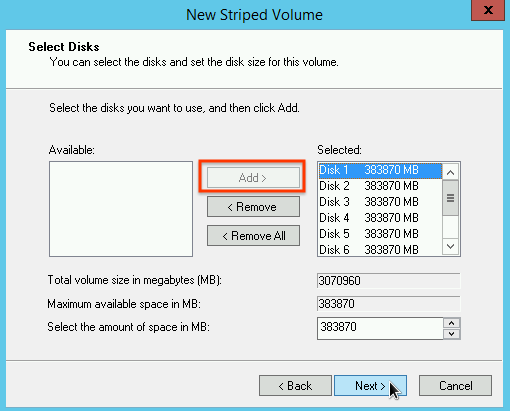

Após a inicialização do SSD local, clique com o botão direito do mouse no espaço em disco não alocado e selecione Novo Volume Distribuído.

Selecione as partições do SSD local que você quer incluir na matriz distribuída. Neste exemplo, selecione todos as partições para combiná-las em apenas um dispositivo de SSD local.

Siga as instruções no Assistente de Novo Volume Distribuído para configurar o novo volume. É possível usar qualquer formato de partição que preferir, mas, neste exemplo, selecione

NTFS. Além disso, marque Executar uma formatação rápida para acelerar esse processo.

Após a conclusão do assistente e da formatação do volume, verifique se o novo SSD local tem o status

Healthy.

Agora é possível gravar arquivos no SSD local.

A seguir

- Saiba mais sobre nomes de dispositivos para sua VM.

- Saiba como comparar o desempenho de discos SSD locais.

Exceto em caso de indicação contrária, o conteúdo desta página é licenciado de acordo com a Licença de atribuição 4.0 do Creative Commons, e as amostras de código são licenciadas de acordo com a Licença Apache 2.0. Para mais detalhes, consulte as políticas do site do Google Developers. Java é uma marca registrada da Oracle e/ou afiliadas.

Última atualização 2025-10-02 UTC.

-