ローカル SSD は、キャッシュやスクラッチ処理スペースなど、一時的なストレージのユースケース向けに設計されています。ローカル SSD は、VM が実行されている物理マシン上に配置されるため、VM の作成プロセスでのみ作成できます。ローカル SSD を起動デバイスとして使用することはできません。

第 3 世代のマシンシリーズの場合、VM の作成時に一定数のローカル SSD ディスクが VM に追加されます。これらの VM にローカル SSD ストレージを追加する唯一の方法は、次のとおりです。

- C4、C4D、C3、C3D の場合、ローカル SSD ストレージは

c3-standard-88-lssdなどの特定のマシンタイプでのみ使用できます。 - Z3、A4、A4X、A3、A2 Ultra マシンシリーズの場合、すべてのマシンタイプにローカル SSD ストレージが付属しています。

M3、第 1 世代、第 2 世代のマシンタイプの場合、VM の作成時にローカル SSD ディスクを指定する必要があります。

ローカル SSD を作成した後は、使用する前に、デバイスをフォーマットしてマウントする必要があります。

さまざまなマシンタイプで使用できるローカル SSD ストレージの容量と、VM にアタッチできるローカル SSD ディスクの数については、有効な数のローカル SSD を選択するをご覧ください。

始める前に

- ローカル SSD を使用する前に、ローカル SSD の制限を確認します。

- ローカル SSD ディスクのデータの永続性のシナリオを確認します。

- GPU がアタッチされた仮想マシン(VM)インスタンスにローカル SSD を追加する場合は、GPU のリージョンとゾーンごとのローカル SSD の可用性をご覧ください。

-

まだ設定していない場合は、認証を設定します。認証では、 Google Cloud サービスと API にアクセスするための ID が確認されます。ローカル開発環境からコードまたはサンプルを実行するには、次のいずれかのオプションを選択して Compute Engine に対する認証を行います。

Select the tab for how you plan to use the samples on this page:

Console

When you use the Google Cloud console to access Google Cloud services and APIs, you don't need to set up authentication.

gcloud

-

Google Cloud CLI をインストールします。 インストール後、次のコマンドを実行して Google Cloud CLI を初期化します。

gcloud init外部 ID プロバイダ(IdP)を使用している場合は、まず連携 ID を使用して gcloud CLI にログインする必要があります。

- Set a default region and zone.

Terraform

ローカル開発環境でこのページの Terraform サンプルを使用するには、gcloud CLI をインストールして初期化し、ユーザー認証情報を使用してアプリケーションのデフォルト認証情報を設定します。

Google Cloud CLI をインストールします。

外部 ID プロバイダ(IdP)を使用している場合は、まず連携 ID を使用して gcloud CLI にログインする必要があります。

If you're using a local shell, then create local authentication credentials for your user account:

gcloud auth application-default login

You don't need to do this if you're using Cloud Shell.

If an authentication error is returned, and you are using an external identity provider (IdP), confirm that you have signed in to the gcloud CLI with your federated identity.

詳細については Set up authentication for a local development environment をご覧ください。

Go

ローカル開発環境でこのページの Go サンプルを使用するには、gcloud CLI をインストールして初期化し、ユーザー認証情報を使用してアプリケーションのデフォルト認証情報を設定します。

Google Cloud CLI をインストールします。

外部 ID プロバイダ(IdP)を使用している場合は、まず連携 ID を使用して gcloud CLI にログインする必要があります。

If you're using a local shell, then create local authentication credentials for your user account:

gcloud auth application-default login

You don't need to do this if you're using Cloud Shell.

If an authentication error is returned, and you are using an external identity provider (IdP), confirm that you have signed in to the gcloud CLI with your federated identity.

詳細については Set up authentication for a local development environment をご覧ください。

Java

ローカル開発環境でこのページの Java サンプルを使用するには、gcloud CLI をインストールして初期化し、ユーザー認証情報を使用してアプリケーションのデフォルト認証情報を設定します。

Google Cloud CLI をインストールします。

外部 ID プロバイダ(IdP)を使用している場合は、まず連携 ID を使用して gcloud CLI にログインする必要があります。

If you're using a local shell, then create local authentication credentials for your user account:

gcloud auth application-default login

You don't need to do this if you're using Cloud Shell.

If an authentication error is returned, and you are using an external identity provider (IdP), confirm that you have signed in to the gcloud CLI with your federated identity.

詳細については Set up authentication for a local development environment をご覧ください。

Python

ローカル開発環境でこのページの Python サンプルを使用するには、gcloud CLI をインストールして初期化し、ユーザー認証情報を使用してアプリケーションのデフォルト認証情報を設定します。

Google Cloud CLI をインストールします。

外部 ID プロバイダ(IdP)を使用している場合は、まず連携 ID を使用して gcloud CLI にログインする必要があります。

If you're using a local shell, then create local authentication credentials for your user account:

gcloud auth application-default login

You don't need to do this if you're using Cloud Shell.

If an authentication error is returned, and you are using an external identity provider (IdP), confirm that you have signed in to the gcloud CLI with your federated identity.

詳細については Set up authentication for a local development environment をご覧ください。

REST

このページの REST API サンプルをローカル開発環境で使用するには、gcloud CLI に指定した認証情報を使用します。

Google Cloud CLI をインストールします。

外部 ID プロバイダ(IdP)を使用している場合は、まず連携 ID を使用して gcloud CLI にログインする必要があります。

詳細については、 Google Cloud 認証ドキュメントの REST を使用して認証するをご覧ください。

ローカル SSD を持つ VM を作成する

ローカル SSD ディスク ストレージを備えた VM を作成するには、 Google Cloud console、gcloud CLI、または Compute Engine API を使用します。

コンソール

[インスタンスの作成] ページに移動します。

VM の名前、リージョン、ゾーンを指定します。必要に応じて、タグまたはラベルを追加します。

[マシンの構成] セクションで、ターゲット マシンタイプを含むマシン ファミリーを選択します。

[シリーズ] リストからシリーズを選択し、マシンタイプを選択します。

- C4、C4D、C3、C3D の場合は、

-lssdで終わるマシンタイプを選択します。 - Z3、A4、A4X、A3、A2 Ultra の場合は、すべてのマシンタイプにローカル SSD ストレージが付属しています。

- M3、または第 1 世代と第 2 世代のマシンシリーズの場合は、マシンタイプを選択した後に次の操作を行います。

- [詳細オプション] セクションを開きます。

- [ディスク] を開き、[ローカル SSD を追加] をクリックして、次の操作を行います。

- [ローカル SSD の構成] ページで、ディスク インターフェースのタイプを選択します。

- [ディスク容量] リストから必要なディスクの数を選択します。

- [保存] をクリックします。

- C4、C4D、C3、C3D の場合は、

VM 作成プロセスを続行します。

ローカル SSD ディスクを使用して VM を作成したら、ディスクを使用する前に各デバイスをフォーマットしてマウントする必要があります。

gcloud

Z3、A4、A4X、A3、A2 Ultra マシンシリーズの場合、ローカル SSD ディスクがアタッチされた VM を作成するには、インスタンスを作成する手順に沿って、そのシリーズで使用可能なマシンタイプを使用する VM を作成します。

C4、C4D、C3、C3D マシンシリーズの場合、ローカル SSD ディスクがアタッチされた VM を作成するには、インスタンスの作成手順に沿って操作しますが、ローカル SSD ディスク(

-lssd)を含むインスタンス タイプを指定します。たとえば次のように、NVMe ディスク インターフェースを使用する 2 つのローカル SSD パーティションを持つ C3 VM を作成できます。

gcloud compute instances create example-c3-instance \ --zone ZONE \ --machine-type c3-standard-8-lssd \ --image-project IMAGE_PROJECT \ --image-family IMAGE_FAMILY

M3、第 1 世代、第 2 世代のマシンシリーズの場合、ローカル SSD ディスクがアタッチされた VM を作成するには、インスタンスを作成する手順に沿って操作しますが、ローカル SSD ディスクを作成してアタッチするため

--local-ssdフラグを使用します。複数のローカル SSD パーティションを作成するには、--local-ssdフラグを追加します。必要に応じて、インターフェースの値と各--local-ssdフラグのデバイス名を設定することもできます。たとえば、4 つのローカル SSD ディスクを持つ M3 VM を作成し、ディスク インターフェース タイプを次のように指定できます。

gcloud compute instances create VM_NAME \ --machine-type m3-ultramem-64 \ --zone ZONE \ --local-ssd interface=INTERFACE_TYPE,device-name=DEVICE-NAME \ --local-ssd interface=INTERFACE_TYPE,device-name=DEVICE-NAME \ --local-ssd interface=INTERFACE_TYPE,device-name=DEVICE-NAME \ --local-ssd interface=INTERFACE_TYPE \ --image-project IMAGE_PROJECT \ --image-family IMAGE_FAMILY

次のように置き換えます。

- VM_NAME: 新しい VM の名前

- ZONE: VM を作成するゾーン。gcloud CLI

compute/zoneプロパティまたは環境変数CLOUDSDK_COMPUTE_ZONEを構成している場合、このフラグは省略可能です。 - INTERFACE_TYPE: ローカル SSD デバイスに使用するディスク インターフェースの種類です。M3 VM を作成する場合、またはブートディスク イメージに最適化された NVMe ドライバがある場合は、

nvmeを指定します。他のイメージの場合はscsiを指定します。 - DEVICE-NAME: 省略可。ゲスト オペレーティング システムのシンボリック リンク(symlink)で使用するディスク名を示す名前。

- IMAGE_FAMILY: ブートディスクにインストールする使用可能なイメージ ファミリーのいずれかです。

- IMAGE_PROJECT: イメージ ファミリーが属するイメージ プロジェクトです。

必要に応じて、異なるパーティションに

nvmeとscsiを組み合わせて使用し、第 1 世代または第 2 世代の VM にローカル SSD をアタッチできます。nvmeデバイスのパフォーマンスは、インスタンスのブートディスク イメージにより異なります。第 3 世代の VM は、NVMe ディスク インターフェースのみをサポートします。ローカル SSD を使用して VM を作成した後は、使用する前に各デバイスをフォーマットしてマウントする必要があります。

Terraform

ローカル SSD ディスクがアタッチされた VM を作成するには、

google_compute_instanceリソースを使用します。Terraform 構成を適用または削除する方法については、基本的な Terraform コマンドをご覧ください。

Terraform コードを生成するには、 Google Cloud コンソールの同等のコード コンポーネントを使用します。- Google Cloud コンソールで、[VM インスタンス] ページに移動します。

- [インスタンスを作成] をクリックします。

- 必要なパラメータを指定します。

- ページの上部または下部で [同等のコード] をクリックし、[Terraform] タブをクリックして Terraform コードを表示します。

Go

Go

このサンプルを試す前に、Compute Engine クイックスタート: クライアント ライブラリの使用に記載されている Go の設定手順に沿って操作します。詳細については、Compute Engine Go API リファレンス ドキュメントをご覧ください。

Compute Engine に対して認証を行うには、アプリケーションのデフォルト認証情報を設定します。詳細については、ローカル開発環境の認証を設定するをご覧ください。

Java

Java

このサンプルを試す前に、Compute Engine クイックスタート: クライアント ライブラリの使用に記載されている Java の設定手順に沿って操作します。詳細については、Compute Engine Java API リファレンス ドキュメントをご覧ください。

Compute Engine に対して認証を行うには、アプリケーションのデフォルト認証情報を設定します。詳細については、ローカル開発環境の認証を設定するをご覧ください。

Python

Python

このサンプルを試す前に、Compute Engine クイックスタート: クライアント ライブラリの使用に記載されている Python の設定手順に沿って操作します。詳細については、Compute Engine Python API リファレンス ドキュメントをご覧ください。

Compute Engine に対して認証を行うには、アプリケーションのデフォルト認証情報を設定します。詳細については、ローカル開発環境の認証を設定するをご覧ください。

REST

instances.insert methodを使用して、イメージ ファミリーまたは特定のバージョンのオペレーティング システム イメージから VM を作成します。- Z3、A4、A4X、A3、A2 Ultra マシンシリーズの場合、ローカル SSD ディスクがアタッチされた VM を作成するには、そのシリーズで使用可能なマシンタイプを使用する VM を作成します。

C4、C4D、C3、C3D マシンシリーズの場合、ローカル SSD ディスクがアタッチされた VM を作成するには、ローカル SSD ディスクを含むインスタンス タイプ(

-lssd)を指定します。Ubuntu ブートディスクと 2 つのローカル SSD ディスクを持つ C3 VM を作成するリクエスト ペイロードの例を次に示します。

{ "machineType":"zones/us-central1-c/machineTypes/c3-standard-8-lssd", "name":"c3-with-local-ssd", "disks":[ { "type":"PERSISTENT", "initializeParams":{ "sourceImage":"projects/ubuntu-os-cloud/global/images/family/ubuntu-2204-lts" }, "boot":true } ], "networkInterfaces":[ { "network":"global/networks/default" } ] }M3、第 1 世代、第 2 世代のマシンシリーズの場合、ローカル SSD ディスクがアタッチされた VM を作成するには、VM の作成時に

initializeParamsプロパティを使用してローカル SSD デバイスを追加できます。次のプロパティも指定する必要があります。diskType: ローカル SSD に設定します。autoDelete: true に設定します。type:SCRATCHに設定します。

次のプロパティはローカル SSD デバイスでは使用できません。

diskNamesourceImageプロパティdiskSizeGb

ブートディスクと 4 つのローカル SSD ディスクを持つ M3 VM を作成するリクエスト ペイロードの例を次に示します。

{ "machineType":"zones/us-central1-f/machineTypes/m3-ultramem-64", "name":"local-ssd-instance", "disks":[ { "type":"PERSISTENT", "initializeParams":{ "sourceImage":"projects/ubuntu-os-cloud/global/images/family/ubuntu-2204-lts" }, "boot":true }, { "type":"SCRATCH", "initializeParams":{ "diskType":"zones/us-central1-f/diskTypes/local-ssd" }, "autoDelete":true, "interface": "NVME" }, { "type":"SCRATCH", "initializeParams":{ "diskType":"zones/us-central1-f/diskTypes/local-ssd" }, "autoDelete":true, "interface": "NVME" }, { "type":"SCRATCH", "initializeParams":{ "diskType":"zones/us-central1-f/diskTypes/local-ssd" }, "autoDelete":true, "interface": "NVME" }, { "type":"SCRATCH", "initializeParams":{ "diskType":"zones/us-central1-f/diskTypes/local-ssd" }, "autoDelete":true, "interface": "NVME" }, ], "networkInterfaces":[ { "network":"global/networks/default" } ] }

ローカル SSD を作成した後は、使用する前に、各デバイスをフォーマットしてマウントする必要があります。

REST を使用してインスタンスを作成する方法の詳細については、Compute Engine API をご覧ください。

ローカル SSD デバイスのフォーマットとマウント

各ローカル SSD ディスクを個別にフォーマットしてマウントすることも、複数のローカル SSD ディスクを単一の論理ボリュームに結合することもできます。

ローカル SSD パーティションを個別にフォーマットしてマウントする

ローカル SSD をインスタンスに接続する最も簡単な方法は、各デバイスを単一パーティションでフォーマットしてマウントすることです。または、複数のパーティションを単一の論理ボリュームに組み合わせることもできます。

Linux インスタンス

Linux インスタンスで新しいローカル SSD をフォーマットしてマウントします。必要に応じて任意のパーティション フォーマットと構成を使用できます。この例では、

ext4パーティションを 1 つ作成します。[VM インスタンス] ページに移動します。

新しいローカル SSD をアタッチしたインスタンスの隣にある [SSH] ボタンをクリックします。ブラウザが開き、インスタンスに対するターミナル接続が表示されます。

ターミナルでは、

findコマンドを使用して、マウントするローカル SSD を識別します。$ find /dev/ | grep google-local-nvme-ssdSCSI モードのローカル SSD には、

google-local-ssd-0といった標準の名前が割り当てられています。次の出力に示すように、NVMe モードのローカル SSD にはgoogle-local-nvme-ssd-0のような名前が付けられます。$ find /dev/ | grep google-local-nvme-ssd /dev/disk/by-id/google-local-nvme-ssd-0

ローカル SSD を ext4 ファイル システムでフォーマットします。次のコマンドを使用すると、ローカル SSD から既存のデータがすべて削除されます。

$ sudo mkfs.ext4 -F /dev/disk/by-id/[SSD_NAME][SSD_NAME]をフォーマットするローカル SSD の ID に置き換えます。たとえば、インスタンスの最初の NVMe ローカル SSD をフォーマットするにはgoogle-local-nvme-ssd-0を指定します。デバイスをマウントできるディレクトリを作成するには、

mkdirコマンドを使用します。$ sudo mkdir -p /mnt/disks/[MNT_DIR][MNT_DIR]は、ローカル SSD ディスクをマウントするディレクトリ パスに置き換えます。ローカル SSD を VM にマウントします。

$ sudo mount /dev/disk/by-id/[SSD_NAME] /mnt/disks/[MNT_DIR]次のように置き換えます。

[SSD_NAME]: マウントするローカル SSD の ID。[MNT_DIR]: ローカル SSD をマウントするディレクトリ。

デバイスに対する読み取りと書き込みのアクセスを構成します。この例では、デバイスへの書き込みアクセス権をすべてのユーザーに付与します。

$ sudo chmod a+w /mnt/disks/[MNT_DIR][MNT_DIR]は、ローカル SSD をマウントしたディレクトリに置き換えます。

ローカル SSD を

/etc/fstabファイルに追加して、インスタンスの再起動時にデバイスが自動的にマウントされるようにすることもできます。このエントリは、インスタンスが停止した場合、ローカル SSD 上のデータを保持しません。完全な詳細は、ローカル SSD データの永続性を参照してください。/etc/fstabファイルのエントリを指定する場合は、必ずnofailオプションを含め、ローカル SSD が存在しない場合でも、インスタンスが起動できるようにします。たとえば、ブートディスクのスナップショットを作成し、ローカル SSD をアタッチせずに新しいインスタンスを作成した場合、インスタンスは起動プロセスを続行でき、いつまでも一時停止することはありません。/etc/fstabエントリを作成します。blkidコマンドを使用して、デバイス上のファイル システムの UUID を検索し、UUID をマウント オプションとともに含めるように/etc/fstabファイルを編集します。この手順は 1 つのコマンドで完了できます。たとえば、NVMe モードのローカル SSD の場合は、次のコマンドを使用します。

$ echo UUID=`sudo blkid -s UUID -o value /dev/disk/by-id/google-local-nvme-ssd-0` /mnt/disks/[MNT_DIR] ext4 discard,defaults,nofail 0 2 | sudo tee -a /etc/fstabSCSI などの NVMe 以外のモードのローカル SSD については、次のコマンドを使用します。

$ echo UUID=`sudo blkid -s UUID -o value /dev/disk/by-id/google-local-ssd-0` /mnt/disks/[MNT_DIR] ext4 discard,defaults,nofail 0 2 | sudo tee -a /etc/fstab[MNT_DIR]は、ローカル SSD をマウントしたディレクトリに置き換えます。catコマンドを使用して、/etc/fstabエントリが正しいことを確認します。$ cat /etc/fstab

このインスタンスの起動ディスクからスナップショットを作成し、それを使用してローカル SSD がない別のインスタンスを作成する場合は、

/etc/fstabファイルを編集して、このローカル SSD のエントリを削除します。nofailオプションを使用する場合でも、インスタンスに接続されているパーティションとの/etc/fstabファイルの同期を維持し、ブートディスクのスナップショットを作成する前に、これらのエントリを削除します。Windows インスタンス

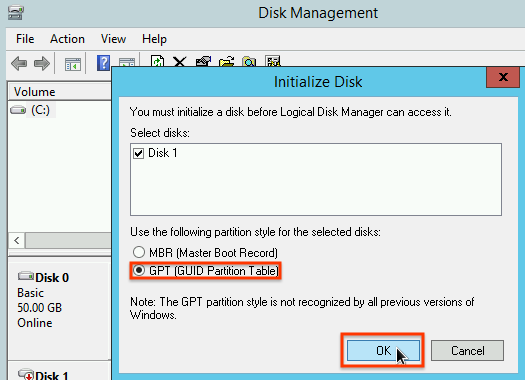

Windows のディスク管理ツールを使用して、Windows インスタンス上のローカル SSD をフォーマットしてマウントします。

RDP を使用してインスタンスに接続します。この例では、[VM インスタンス] ページに移動し、ローカル SSD がアタッチされているインスタンスの隣の [RDP] ボタンをクリックします。ユーザー名とパスワードを入力すると、ウィンドウが開き、サーバーに対するデスクトップ インターフェースが表示されます。

Windows [スタート] ボタンを右クリックして [ディスクの管理] を選択します。

![Windows の [スタート] ボタンの右クリック メニューから、Windows ディスク管理ツールを選択します。](https://cloud-dot-devsite-v2-prod.appspot.com/static/compute/images/start_disk_manager_windows.png?hl=ja)

ローカル SSD の初期化をまだ行っていない場合、新しいパーティションのパーティショニング スキームの選択を求められます。[GPT] を選択して、[OK] をクリックします。

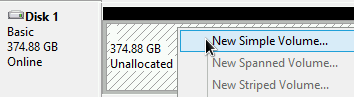

ローカル SSD を初期化した後、未割り当てのディスク スペースを右クリックして、[新しいシンプル ボリューム] を選択します。

新しいシンプル ボリューム ウィザードの指示に従って新しいボリュームを構成します。任意のパーティション形式を使用できますが、この例では

NTFSを選択します。[クイック フォーマットする] にもチェックを入れて、フォーマット処理を高速化します。![[新しいシンプル ボリューム ウィザード] でパーティションのフォーマット タイプを選択します。](https://cloud-dot-devsite-v2-prod.appspot.com/static/compute/images/configure_new_volume_windows.png?hl=ja)

ウィザードが完了し、ボリュームのフォーマットが終了後、新しいローカル SSD をチェックして、

Healthyのステータスを確認します。![Windows によって認識されたディスクのリストを表示し、ローカル SSD が [正常] ステータスであることを確認します。](https://cloud-dot-devsite-v2-prod.appspot.com/static/compute/images/local_ssd_healthy_windows.png?hl=ja)

これで、ローカル SSD にファイルを書き込むことができます。

複数のローカル SSD パーティションをフォーマットして単一の論理ボリュームにマウントする

永続 SSD とは異なり、インスタンスにアタッチする各デバイスのローカル SSD の容量は 375 GB の固定です。複数のローカル SSD パーティションを単一の論理ボリュームに組み合わせる場合、これらのパーティション間のボリューム管理をユーザー自身が定義する必要があります。

Linux インスタンス

mdadmを使用して、RAID 0 アレイを作成します。この例では、1 つのext4ファイル システムを使用したアレイをフォーマットしますが、任意のファイル システムを適用できます。[VM インスタンス] ページに移動します。

新しいローカル SSD をアタッチしたインスタンスの隣にある [SSH] ボタンをクリックします。ブラウザが開き、インスタンスに対するターミナル接続が表示されます。

ターミナルで、

mdadmツールをインストールします。mdadmのインストール プロセスには、スクリプトを停止するユーザー プロンプトが含まれているため、このプロセスは手動で実行してください。Debian と Ubuntu:

$ sudo apt update && sudo apt install mdadm --no-install-recommendsCentOS と RHEL:

$ sudo yum install mdadm -ySLES と openSUSE:

$ sudo zypper install -y mdadmfindコマンドを使用して、一緒にマウントするすべてのローカル SSD を識別します。この例では、インスタンスに NVMe モードのローカル SSD パーティションが 8 個あります。

$ find /dev/ | grep google-local-nvme-ssd /dev/disk/by-id/google-local-nvme-ssd-7 /dev/disk/by-id/google-local-nvme-ssd-6 /dev/disk/by-id/google-local-nvme-ssd-5 /dev/disk/by-id/google-local-nvme-ssd-4 /dev/disk/by-id/google-local-nvme-ssd-3 /dev/disk/by-id/google-local-nvme-ssd-2 /dev/disk/by-id/google-local-nvme-ssd-1 /dev/disk/by-id/google-local-nvme-ssd-0

findは順序を保証するものではありません。出力行の数が予想される SSD パーティションの数と一致している限り、デバイスが異なる順序でリストされていても問題ありません。SCSI モードのローカル SSD には、google-local-ssdといった標準の名前が割り当てられています。NVMe モードのローカル SSD には、google-local-nvme-ssdといった標準の名前が割り当てられています。mdadmを使用して、複数のローカル SSD デバイスを/dev/md0という名前の 1 つのアレイに結合します。この例では、NVMe モードの 8 個のローカル SSD デバイスをマージします。SCSI モードのローカル SSD デバイスについては、findコマンドから取得した名前を指定します。$ sudo mdadm --create /dev/md0 --level=0 --raid-devices=8 \ /dev/disk/by-id/google-local-nvme-ssd-0 \ /dev/disk/by-id/google-local-nvme-ssd-1 \ /dev/disk/by-id/google-local-nvme-ssd-2 \ /dev/disk/by-id/google-local-nvme-ssd-3 \ /dev/disk/by-id/google-local-nvme-ssd-4 \ /dev/disk/by-id/google-local-nvme-ssd-5 \ /dev/disk/by-id/google-local-nvme-ssd-6 \ /dev/disk/by-id/google-local-nvme-ssd-7 mdadm: Defaulting to version 1.2 metadata mdadm: array /dev/md0 started.

アレイの詳細は

mdadm --detailで確認できます。--prefer=by-idフラグを追加すると、/dev/disk/by-idパスを使用するデバイスが一覧表示されます。sudo mdadm --detail --prefer=by-id /dev/md0

出力は、アレイ内のデバイスごとに次のようになります。

... Number Major Minor RaidDevice State 0 259 0 0 active sync /dev/disk/by-id/google-local-nvme-ssd-0 .../dev/md0アレイ全体を ext4 ファイル システムでフォーマットします。$ sudo mkfs.ext4 -F /dev/md0/dev/md0がマウント可能なディレクトリを作成します。この例では、/mnt/disks/ssd-arrayディレクトリを作成します。$ sudo mkdir -p /mnt/disks/[MNT_DIR][MNT_DIR]は、ローカル SSD アレイをマウントするディレクトリに置き換えます。/dev/md0アレイを/mnt/disks/ssd-arrayディレクトリにマウントします。$ sudo mount /dev/md0 /mnt/disks/[MNT_DIR][MNT_DIR]は、ローカル SSD アレイをマウントするディレクトリに置き換えます。デバイスに対する読み取りと書き込みのアクセスを構成します。この例では、デバイスへの書き込みアクセス権をすべてのユーザーに付与します。

$ sudo chmod a+w /mnt/disks/[MNT_DIR][MNT_DIR]は、ローカル SSD アレイをマウントしたディレクトリに置き換えます。

ローカル SSD を

/etc/fstabファイルに追加して、インスタンスの再起動時にデバイスが自動的にマウントされるようにすることもできます。このエントリは、インスタンスが停止した場合、ローカル SSD 上のデータを保持しません。詳細は、ローカル SSD データの永続性を参照してください。/etc/fstabファイルのエントリを指定する場合は、必ずnofailオプションを含め、ローカル SSD が存在しない場合でも、インスタンスが起動できるようにします。たとえば、ブートディスクのスナップショットを取り、どのようなローカル SSD もアタッチしないで新しいインスタンスを作成した場合、インスタンスが起動プロセスを続行することができ、無期限に一時停止することはありません。/etc/fstabエントリを作成します。blkidコマンドを使用して、デバイス上のファイル システムの UUID を検索し、UUID をマウント オプションとともに含めるように/etc/fstabファイルを編集します。nofailオプションを指定して、ローカル SSD が利用できない場合でもシステムを起動できるようにします。この手順は 1 つのコマンドで完了できます。次に例を示します。$ echo UUID=`sudo blkid -s UUID -o value /dev/md0` /mnt/disks/[MNT_DIR] ext4 discard,defaults,nofail 0 2 | sudo tee -a /etc/fstab[MNT_DIR]は、ローカル SSD アレイをマウントしたディレクトリに置き換えます。/etc/fstabファイルの/dev/md0のようなデバイス名を使用している場合、UUID ではなく、/etc/mdadm/mdadm.confファイルを編集して配列が起動時に自動的に再構成されるようにします。これは次の 2 つのステップで行います。- 起動時にディスクアレイが自動的にスキャンされ、再構成されるようにします。

$ sudo mdadm --detail --scan | sudo tee -a /etc/mdadm/mdadm.conf initramfsを更新して、アレイがアーリーブート プロセス中に使用できるようにします。$ sudo update-initramfs -u

- 起動時にディスクアレイが自動的にスキャンされ、再構成されるようにします。

catコマンドを使用して、/etc/fstabエントリが正しいことを確認します。$ cat /etc/fstab

このインスタンスのブートディスクからスナップショットを作成し、それを使用してローカル SSD がない別のインスタンスを作成する場合は、

/etc/fstabファイルを編集して、このローカル SSD アレイのエントリを削除します。nofailオプションを使用する場合でも、インスタンスにアタッチされているパーティションとの/etc/fstabファイルの同期を維持し、ブートディスクのスナップショットを作成する前に、これらのエントリを削除します。Windows インスタンス

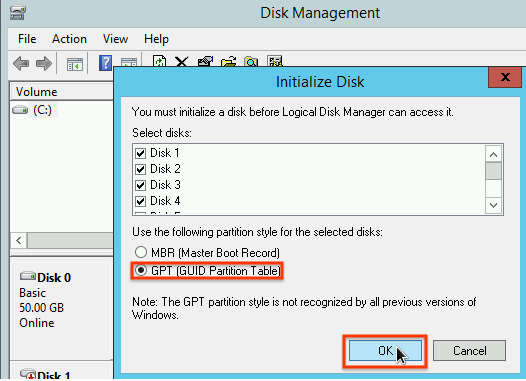

Windows のディスク管理ツールを使用して、Windows インスタンス上のローカル SSD のアレイをフォーマットしてマウントします。

RDP を使用してインスタンスに接続します。この例では、[VM インスタンス] ページに移動し、ローカル SSD がアタッチされているインスタンスの隣の [RDP] ボタンをクリックします。ユーザー名とパスワードを入力すると、ウィンドウが開き、サーバーに対するデスクトップ インターフェースが表示されます。

Windows [スタート] ボタンを右クリックして [ディスクの管理] を選択します。

![Windows の [スタート] ボタンの右クリック メニューから、Windows ディスク管理ツールを選択します。](https://cloud-dot-devsite-v2-prod.appspot.com/static/compute/images/start_disk_manager_windows.png?hl=ja)

ローカル SSD の初期化をまだ行っていない場合、新しいパーティションのパーティショニング スキームを選択するよう求められます。[GPT] を選択して、[OK] をクリックします。

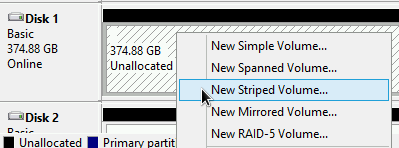

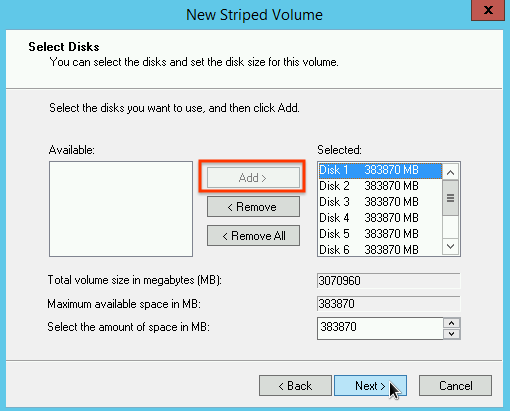

ローカル SSD を初期化した後、未割り当てのディスク スペースを右クリックして、[新しいストライプ ボリューム] を選択します。

ストライプ アレイに含めるローカル SSD パーティションを選択します。この例では、すべてのパーティションを選択して、1 つのローカル SSD デバイスに結合します。

[新しいストライプ ボリューム ウィザード] の指示に従って新しいボリュームを構成します。任意のパーティション形式を使用できますが、この例では

NTFSを選択します。[クイック フォーマットする] にもチェックを入れて、フォーマット処理を高速化します。![[新しいストライプ ボリューム ウィザード] でパーティションのフォーマット タイプを選択します。](https://cloud-dot-devsite-v2-prod.appspot.com/static/compute/images/configure_new_volume_windows.png?hl=ja)

ウィザードが完了し、ボリュームのフォーマットが終了後、新しいローカル SSD をチェックして、

Healthyのステータスを確認します。![Windows によって認識されたディスクのリストを表示し、ローカル SSD が [正常] ステータスであることを確認します。](https://cloud-dot-devsite-v2-prod.appspot.com/static/compute/images/local_ssd_array_healthy_windows.png?hl=ja)

ローカル SSD にファイルを書き込むことができます。

次のステップ

- VM のデバイス名の詳細を確認する。

- ローカル SSD ディスクのパフォーマンスをベンチマークする方法を学習する

特に記載のない限り、このページのコンテンツはクリエイティブ・コモンズの表示 4.0 ライセンスにより使用許諾されます。コードサンプルは Apache 2.0 ライセンスにより使用許諾されます。詳しくは、Google Developers サイトのポリシーをご覧ください。Java は Oracle および関連会社の登録商標です。

最終更新日 2025-10-19 UTC。

-