Lokale SSDs eignen sich zur temporären Speicherung. Mögliche Anwendungsfälle sind Cache- und temporärer Verarbeitungsspeicher. Da sich lokale SSDs auf der physischen Maschine befinden, auf der Ihre VM ausgeführt wird, können sie nur während der VM-Erstellung erstellt werden. Lokale SSDs können nicht als Bootgeräte verwendet werden.

Bei Maschinenserien der dritten Generation und höher wird der VM beim Erstellen eine bestimmte Anzahl lokaler SSD-Laufwerke hinzugefügt. Lokaler SSD-Speicher kann diesen VMs nur so hinzugefügt werden:

- Für C4, C4D, C3 und C3D ist lokaler SSD-Speicher nur für bestimmte Maschinentypen wie

c3-standard-88-lssdverfügbar. - Bei den Maschinenserien Z3, A4, A4X, A3 und A2 Ultra ist jeder Maschinentyp mit lokalem SSD-Speicher ausgestattet.

Bei M3- und Maschinentypen der ersten und zweiten Generation müssen Sie beim Erstellen der VM lokale SSD-Laufwerke angeben.

Nachdem Sie ein lokales SSD-Laufwerk erstellt haben, müssen Sie das Gerät formatieren und bereitstellen. Erst dann können Sie es verwenden.

Informationen zur Menge an lokalem SSD-Speicher, der mit verschiedenen Maschinentypen verfügbar ist, und zur Anzahl der lokalen SSD-Laufwerke, die Sie an eine VM anhängen können, finden Sie unter Gültige Anzahl lokaler SSDs auswählen.

Hinweise

- Überprüfen Sie vor der Verwendung lokaler SSDs die Einschränkungen für lokale SSDs.

- Sehen Sie sich die Szenarien für die Datenpersistenz für lokale SSD-Festplatten an.

- Wenn Sie lokale SSDs zu VM-Instanzen hinzufügen, die über angehängte GPUs verfügen, finden Sie weitere Informationen unter Verfügbarkeit lokaler SSDs nach GPU-Regionen und -Zonen.

-

Richten Sie die Authentifizierung ein, falls Sie dies noch nicht getan haben.

Bei der Authentifizierung wird Ihre Identität für den Zugriff auf Google Cloud -Dienste und APIs überprüft. Zum Ausführen von Code oder Beispielen aus einer lokalen Entwicklungsumgebung können Sie sich so bei Compute Engine authentifizieren:

Select the tab for how you plan to use the samples on this page:

Console

When you use the Google Cloud console to access Google Cloud services and APIs, you don't need to set up authentication.

gcloud

-

Installieren Sie die Google Cloud CLI. Initialisieren Sie die Google Cloud CLI nach der Installation mit dem folgenden Befehl:

gcloud initWenn Sie einen externen Identitätsanbieter (IdP) verwenden, müssen Sie sich zuerst mit Ihrer föderierten Identität in der gcloud CLI anmelden.

- Set a default region and zone.

Terraform

Wenn Sie die Terraform-Beispiele auf dieser Seite in einer lokalen Entwicklungsumgebung verwenden möchten, installieren und initialisieren Sie die gcloud CLI und richten Sie dann die Standardanmeldedaten für Anwendungen mit Ihren Nutzeranmeldedaten ein.

Installieren Sie die Google Cloud CLI.

Wenn Sie einen externen Identitätsanbieter (IdP) verwenden, müssen Sie sich zuerst mit Ihrer föderierten Identität in der gcloud CLI anmelden.

If you're using a local shell, then create local authentication credentials for your user account:

gcloud auth application-default login

You don't need to do this if you're using Cloud Shell.

If an authentication error is returned, and you are using an external identity provider (IdP), confirm that you have signed in to the gcloud CLI with your federated identity.

Weitere Informationen finden Sie unter Set up authentication for a local development environment.

Go

Wenn Sie die Go -Beispiele auf dieser Seite in einer lokalen Entwicklungsumgebung verwenden möchten, installieren und initialisieren Sie die gcloud CLI und richten Sie dann die Standardanmeldedaten für Anwendungen mit Ihren Nutzeranmeldedaten ein.

Installieren Sie die Google Cloud CLI.

Wenn Sie einen externen Identitätsanbieter (IdP) verwenden, müssen Sie sich zuerst mit Ihrer föderierten Identität in der gcloud CLI anmelden.

If you're using a local shell, then create local authentication credentials for your user account:

gcloud auth application-default login

You don't need to do this if you're using Cloud Shell.

If an authentication error is returned, and you are using an external identity provider (IdP), confirm that you have signed in to the gcloud CLI with your federated identity.

Weitere Informationen finden Sie unter Set up authentication for a local development environment.

Java

Wenn Sie die Java -Beispiele auf dieser Seite in einer lokalen Entwicklungsumgebung verwenden möchten, installieren und initialisieren Sie die gcloud CLI und richten Sie dann die Standardanmeldedaten für Anwendungen mit Ihren Nutzeranmeldedaten ein.

Installieren Sie die Google Cloud CLI.

Wenn Sie einen externen Identitätsanbieter (IdP) verwenden, müssen Sie sich zuerst mit Ihrer föderierten Identität in der gcloud CLI anmelden.

If you're using a local shell, then create local authentication credentials for your user account:

gcloud auth application-default login

You don't need to do this if you're using Cloud Shell.

If an authentication error is returned, and you are using an external identity provider (IdP), confirm that you have signed in to the gcloud CLI with your federated identity.

Weitere Informationen finden Sie unter Set up authentication for a local development environment.

Python

Wenn Sie die Python -Beispiele auf dieser Seite in einer lokalen Entwicklungsumgebung verwenden möchten, installieren und initialisieren Sie die gcloud CLI und richten Sie dann die Standardanmeldedaten für Anwendungen mit Ihren Nutzeranmeldedaten ein.

Installieren Sie die Google Cloud CLI.

Wenn Sie einen externen Identitätsanbieter (IdP) verwenden, müssen Sie sich zuerst mit Ihrer föderierten Identität in der gcloud CLI anmelden.

If you're using a local shell, then create local authentication credentials for your user account:

gcloud auth application-default login

You don't need to do this if you're using Cloud Shell.

If an authentication error is returned, and you are using an external identity provider (IdP), confirm that you have signed in to the gcloud CLI with your federated identity.

Weitere Informationen finden Sie unter Set up authentication for a local development environment.

REST

Wenn Sie die REST API-Beispiele auf dieser Seite in einer lokalen Entwicklungsumgebung verwenden möchten, verwenden Sie die Anmeldedaten, die Sie der gcloud CLI bereitstellen.

Installieren Sie die Google Cloud CLI.

Wenn Sie einen externen Identitätsanbieter (IdP) verwenden, müssen Sie sich zuerst mit Ihrer föderierten Identität in der gcloud CLI anmelden.

Weitere Informationen finden Sie in der Dokumentation zur Google Cloud -Authentifizierung unter Für die Verwendung von REST authentifizieren.

VM mit einer lokalen SSD erstellen

Sie können eine VM mit lokalem SSD-Laufwerksspeicher über die Google Cloud console, die gcloud CLI oder die Compute Engine API erstellen.

Console

Gehen Sie zur Seite Instanz erstellen.

Geben Sie den Namen, die Region und die Zone Ihrer VM an. Optional können Sie Tags oder Labels hinzufügen.

Wählen Sie im Abschnitt Maschinenkonfiguration die Maschinenfamilie aus, die Ihren Zielmaschinentyp enthält.

Wählen Sie eine Serie aus der Liste Serien aus und wählen Sie dann den Maschinentyp aus.

- Wählen Sie für C4, C4D, C3 und C3D einen Maschinentyp aus, der auf

-lssdendet. - Bei Z3, A4, A4X, A3 und A2 Ultra ist bei jedem Maschinentyp lokaler SSD-Speicher enthalten.

- Führen Sie bei M3 oder Maschinenserien der ersten und zweiten Generation nach der Auswahl des Maschinentyps die folgenden Schritte aus:

- Maximieren Sie den Bereich Erweiterte Optionen.

- Maximieren Sie Laufwerke, klicken Sie auf Lokale SSD hinzufügen und gehen Sie so vor:

- Wählen Sie auf der Seite Lokale SSD konfigurieren den Laufwerkschnittstellentyp aus.

- Wählen Sie in der Liste Laufwerkskapazität die gewünschte Anzahl von Laufwerken aus.

- Klicken Sie auf Speichern.

- Wählen Sie für C4, C4D, C3 und C3D einen Maschinentyp aus, der auf

Fahren Sie mit dem VM-Erstellungsprozess fort.

Nachdem Sie die VM mit lokalen SSD-Laufwerken erstellt haben, müssen Sie jedes Gerät formatieren und bereitstellen, bevor Sie die Laufwerke verwenden können.

gcloud

Wenn Sie für die Maschinenserien Z3, A4, A4X, A3 und A2 Ultra eine VM mit angehängten lokalen SSD-Laufwerken erstellen möchten, erstellen Sie eine VM, die einen der verfügbaren Maschinentypen für diese Serie verwendet. Folgen Sie dazu der Anleitung zum Erstellen einer Instanz.

Folgen Sie für die Maschinenserien C4, C4D, C3 und C3D der Anleitung zum Erstellen einer Instanz, um eine VM mit angehängten lokalen SSD-Laufwerken zu erstellen. Geben Sie jedoch einen Instanztyp an, der lokale SSD-Laufwerke (

-lssd) enthält.Sie können beispielsweise eine C3-VM mit zwei lokalen SSD-Partitionen erstellen, die die NVMe-Laufwerkschnittstelle so verwenden:

gcloud compute instances create example-c3-instance \ --zone ZONE \ --machine-type c3-standard-8-lssd \ --image-project IMAGE_PROJECT \ --image-family IMAGE_FAMILY

Folgen Sie für M3 und die erste und zweite Generation der Maschinenserien der Anleitung Instanz erstellen zum Erstellen einer VM mit angehängten lokalen SSD-Laufwerken, aber verwenden Sie das Flag

--local-ssd, um ein lokales SSD-Laufwerk zu erstellen und anzuhängen. Fügen Sie weitere--local-ssd-Flags hinzu, um mehrere lokale SSD-Laufwerke zu erstellen. Sie können auch für jedes--local-ssd-Flag Werte für die Schnittstelle und den Gerätenamen festlegen.Sie können beispielsweise eine M3-VM mit vier lokalen SSD-Laufwerken erstellen und den Laufwerkschnittstellentyp so angeben:

gcloud compute instances create VM_NAME \ --machine-type m3-ultramem-64 \ --zone ZONE \ --local-ssd interface=INTERFACE_TYPE,device-name=DEVICE-NAME \ --local-ssd interface=INTERFACE_TYPE,device-name=DEVICE-NAME \ --local-ssd interface=INTERFACE_TYPE,device-name=DEVICE-NAME \ --local-ssd interface=INTERFACE_TYPE \ --image-project IMAGE_PROJECT \ --image-family IMAGE_FAMILY

Ersetzen Sie Folgendes:

- VM_NAME ist der Name für die neue VM.

- ZONE ist die Zone, in der die VM erstellt werden soll. Dieses Flag ist optional, wenn Sie das

compute/zone-Attribut der gcloud CLI oder die UmgebungsvariableCLOUDSDK_COMPUTE_ZONEkonfiguriert haben. - INTERFACE_TYPE: der Festplattenschnittstellentyp, den Sie für das lokale SSD-Gerät verwenden möchten. Geben Sie

nvmean, wenn Sie eine M3-VM erstellen oder wenn das Bootlaufwerk-Image optimierte NVMe-Treiber hat. Geben Sie für andere Bilderscsian. - DEVICE-NAME: Optional: Ein Name, der den Laufwerksnamen angibt, der im symbolischen Link (Symlink) des Gastbetriebssystems verwendet werden soll.

- IMAGE_FAMILY ist eine der verfügbaren Image-Familien, die Sie auf dem Bootlaufwerk installiert haben möchten.

- IMAGE_PROJECT: Das Image-Projekt, zu dem die Image-Familie gehört.

Bei Bedarf können Sie lokale SSDs mit einer Kombination aus

nvmeundscsizu einer VM der ersten oder zweiten Generation hinzufügen. Die Leistung desnvme-Geräts hängt vom Bootlaufwerk-Image der Instanz ab. VMs der dritten Generation unterstützen nur die NVMe-Laufwerkschnittstelle.Nachdem Sie eine VM mit lokaler SSD erstellt haben, müssen Sie jedes Gerät formatieren und bereitstellen, bevor Sie es verwenden können.

Terraform

Zum Erstellen einer VM mit angehängten lokalen SSD-Laufwerken können Sie die Ressource

google_compute_instanceverwenden.Informationen zum Anwenden oder Entfernen einer Terraform-Konfiguration finden Sie unter Grundlegende Terraform-Befehle.

Zum Generieren des Terraform-Codes können Sie die Komponente Entsprechender Code in der Google Cloud Console verwenden.- Rufen Sie in der Google Cloud Console die Seite VM-Instanzen auf:

- Klicken Sie auf Instanz erstellen.

- Geben Sie die gewünschten Parameter an.

- Klicken Sie oben oder unten auf der Seite auf Entsprechender Code und dann auf den Tab Terraform, um den Terraform-Code aufzurufen.

Go

Go

Bevor Sie dieses Beispiel anwenden, folgen Sie den Schritten zur Einrichtung von Go in der Compute Engine-Kurzanleitung zur Verwendung von Clientbibliotheken. Weitere Informationen finden Sie in der Referenzdokumentation zur Compute Engine Go API.

Richten Sie die Standardanmeldedaten für Anwendungen ein, um sich bei Compute Engine zu authentifizieren. Weitere Informationen finden Sie unter Authentifizierung für eine lokale Entwicklungsumgebung einrichten.

Java

Java

Bevor Sie dieses Beispiel anwenden, folgen Sie den Schritten zur Einrichtung von Java in der Compute Engine-Kurzanleitung zur Verwendung von Clientbibliotheken. Weitere Informationen finden Sie in der Referenzdokumentation zur Compute Engine Java API.

Richten Sie die Standardanmeldedaten für Anwendungen ein, um sich bei Compute Engine zu authentifizieren. Weitere Informationen finden Sie unter Authentifizierung für eine lokale Entwicklungsumgebung einrichten.

Python

Python

Bevor Sie dieses Beispiel anwenden, folgen Sie den Schritten zur Einrichtung von Python in der Compute Engine-Kurzanleitung zur Verwendung von Clientbibliotheken. Weitere Informationen finden Sie in der Referenzdokumentation zur Compute Engine Python API.

Richten Sie die Standardanmeldedaten für Anwendungen ein, um sich bei Compute Engine zu authentifizieren. Weitere Informationen finden Sie unter Authentifizierung für eine lokale Entwicklungsumgebung einrichten.

REST

Erstellen Sie mit dem Befehl

instances.insert methodeine VM aus einer Image-Familie oder aus einer bestimmten Version eines Betriebssystem-Images.- Wenn Sie für die Maschinenserien Z3, A4, A4X, A3 und A2 Ultra eine VM mit angehängten lokalen SSD-Laufwerken erstellen möchten, erstellen Sie eine VM, die einen der verfügbaren Maschinentypen für diese Serie verwendet.

Wenn Sie für die Maschinenserien C4, C4D, C3 und C3D eine VM mit angehängten lokalen SSD-Laufwerken erstellen möchten, geben Sie einen Instanztyp an, der lokale SSD-Laufwerke (

-lssd) enthält.Hier sehen Sie eine Beispiel-Anfragenutzlast zum Erstellen einer C3-VM mit einem Ubuntu-Bootlaufwerk und zwei lokalen SSD-Laufwerken:

{ "machineType":"zones/us-central1-c/machineTypes/c3-standard-8-lssd", "name":"c3-with-local-ssd", "disks":[ { "type":"PERSISTENT", "initializeParams":{ "sourceImage":"projects/ubuntu-os-cloud/global/images/family/ubuntu-2204-lts" }, "boot":true } ], "networkInterfaces":[ { "network":"global/networks/default" } ] }Wenn Sie für M3 und die erste und zweite Generation der Maschinenserien eine VM mit angehängten lokalen SSD-Laufwerken erstellen möchten, können Sie beim Erstellen der VM mithilfe der Property

initializeParamslokale SSD-Geräte hinzufügen. Außerdem müssen Sie folgende Attribute angeben:diskType: Lokale SSD festlegenautoDelete: Auf "true" festlegentype: AufSCRATCHfestlegen

Die folgenden Attribute können nicht mit lokalen SSD-Geräten verwendet werden:

diskName- Attribut

sourceImage diskSizeGb

Hier sehen Sie eine Beispiel-Anfragenutzlast zum Erstellen einer M3-VM mit einem Bootlaufwerk und vier lokalen SSD-Laufwerken:

{ "machineType":"zones/us-central1-f/machineTypes/m3-ultramem-64", "name":"local-ssd-instance", "disks":[ { "type":"PERSISTENT", "initializeParams":{ "sourceImage":"projects/ubuntu-os-cloud/global/images/family/ubuntu-2204-lts" }, "boot":true }, { "type":"SCRATCH", "initializeParams":{ "diskType":"zones/us-central1-f/diskTypes/local-ssd" }, "autoDelete":true, "interface": "NVME" }, { "type":"SCRATCH", "initializeParams":{ "diskType":"zones/us-central1-f/diskTypes/local-ssd" }, "autoDelete":true, "interface": "NVME" }, { "type":"SCRATCH", "initializeParams":{ "diskType":"zones/us-central1-f/diskTypes/local-ssd" }, "autoDelete":true, "interface": "NVME" }, { "type":"SCRATCH", "initializeParams":{ "diskType":"zones/us-central1-f/diskTypes/local-ssd" }, "autoDelete":true, "interface": "NVME" }, ], "networkInterfaces":[ { "network":"global/networks/default" } ] }

Nachdem Sie ein lokales SSD-Laufwerk erstellt haben, müssen Sie das Gerät formatieren und bereitstellen. Erst dann können Sie es verwenden.

Weitere Informationen zum Erstellen einer Instanz mit REST finden Sie in der Compute Engine API.

Lokales SSD-Gerät formatieren und bereitstellen

Sie können jedes lokale SSD-Laufwerk einzeln formatieren und bereitstellen oder mehrere lokale SSD-Laufwerke in einem einzigen logischen Volume kombinieren.

Einzelne lokale SSD-Partitionen formatieren und bereitstellen

Am einfachsten verbinden Sie lokale SSDs mit Ihrer Instanz, indem Sie jedes Gerät mit einer einzelnen Partition formatieren und bereitstellen. Alternativ können Sie mehrere Partitionen zu einem logischen Volume kombinieren.

Linux-Instanzen

Formatieren Sie die neue lokale SSD und stellen Sie sie auf Ihrer Linux-Instanz bereit. Dazu können Sie jedes Partitionsformat und eine beliebige Konfiguration verwenden. Erstellen Sie für dieses Beispiel eine einzelne

ext4-Partition.Öffnen Sie die Seite der VM-Instanzen.

Klicken Sie auf die Schaltfläche SSH neben der Instanz mit der neuen lokalen SSD. Im Browser wird eine Terminalverbindung zur Instanz hergestellt.

Geben Sie im Terminal mit dem Befehl

finddie lokale SSD an, die Sie bereitstellen möchten.$ find /dev/ | grep google-local-nvme-ssdLokale SSDs im SCSI-Modus haben Standardnamen wie

google-local-ssd-0. Lokale SSDs im NVMe-Modus haben Namen wiegoogle-local-nvme-ssd-0, wie in der folgenden Ausgabe gezeigt:$ find /dev/ | grep google-local-nvme-ssd /dev/disk/by-id/google-local-nvme-ssd-0

Formatieren Sie die lokale SSD mit einem ext4-Dateisystem. Durch diesen Befehl werden alle vorhandenen Daten von der lokalen SSD gelöscht:

$ sudo mkfs.ext4 -F /dev/disk/by-id/[SSD_NAME]Ersetzen Sie

[SSD_NAME]durch die ID der lokalen SSD, die Sie formatieren möchten. Geben Sie beispielsweisegoogle-local-nvme-ssd-0an, um die erste lokale NVMe-SSD auf der Instanz zu formatieren.Erstellen Sie mit dem Befehl

mkdirein Verzeichnis, in dem Sie das Gerät bereitstellen können.$ sudo mkdir -p /mnt/disks/[MNT_DIR]Ersetzen Sie

[MNT_DIR]durch den Verzeichnispfad, in dem Sie die lokale SSD bereitstellen möchten.Stellen Sie die lokale SSD auf der VM bereit:

$ sudo mount /dev/disk/by-id/[SSD_NAME] /mnt/disks/[MNT_DIR]Ersetzen Sie Folgendes:

[SSD_NAME]: die ID der lokalen SSD, die Sie bereitstellen möchten.[MNT_DIR]: das Verzeichnis, in dem Sie Ihre lokale SSD bereitstellen möchten.

Konfigurieren Sie den Lese-/Schreibzugriff auf das Gerät. In diesem Beispiel wird allen Nutzern Schreibzugriff gewährt:

$ sudo chmod a+w /mnt/disks/[MNT_DIR]Ersetzen Sie

[MNT_DIR]durch das Verzeichnis, in dem Sie die lokale SSD bereitgestellt haben.

Optional können Sie die lokale SSD der Datei

/etc/fstabhinzufügen, damit das Gerät bei einem Neustart der Instanz automatisch wieder bereitgestellt wird. Dadurch bleiben die Daten auf der lokalen SSD beim Beenden der Instanz aber nicht erhalten. Weitere Informationen finden Sie unter Datenpersistenz auf lokalen SSDs.Achten Sie bei Ihrem Eintrag in die Datei

/etc/fstabdarauf, die Optionnofailaufzunehmen, damit die Instanz auch ohne die lokale SSD gestartet werden kann. Wenn Sie beispielsweise einen Snapshot des Bootlaufwerks erzeugen und eine neue Instanz ohne angehängte lokale SSD-Laufwerke erstellen, kann die Instanz den Startvorgang fortsetzen und wird nicht auf unbestimmte Zeit angehalten.Erstellen Sie den Eintrag

/etc/fstab. Suchen Sie mit dem Befehlblkidnach der UUID für das Dateisystem auf dem Gerät und nehmen Sie die UUID in der Datei/etc/fstabin die Bereitstellungsoptionen auf. Sie können diesen Schritt mit einem einzigen Befehl ausführen.Verwenden Sie beispielsweise für eine lokale SSD im NVMe-Modus den folgenden Befehl:

$ echo UUID=`sudo blkid -s UUID -o value /dev/disk/by-id/google-local-nvme-ssd-0` /mnt/disks/[MNT_DIR] ext4 discard,defaults,nofail 0 2 | sudo tee -a /etc/fstabVerwenden Sie für eine lokale SSD in einem Nicht-NVMe-Modus wie SCSI den folgenden Befehl:

$ echo UUID=`sudo blkid -s UUID -o value /dev/disk/by-id/google-local-ssd-0` /mnt/disks/[MNT_DIR] ext4 discard,defaults,nofail 0 2 | sudo tee -a /etc/fstabErsetzen Sie

[MNT_DIR]durch das Verzeichnis, in dem Sie die lokale SSD bereitgestellt haben.Prüfen Sie mit dem Befehl

cat, ob Ihre/etc/fstab-Einträge korrekt sind:$ cat /etc/fstab

Wenn Sie einen Snapshot des Bootlaufwerks dieser Instanz erstellen und diesen Snapshot zum Erstellen einer separaten Instanz ohne lokale SSDs verwenden, bearbeiten Sie die Datei

/etc/fstabund entfernen Sie den Eintrag für die lokale SSD. Auch bei aktivierter Optionnofailmüssen Sie die Datei/etc/fstabmit den Partitionen synchronisieren, die mit Ihrer Instanz verbunden sind, und diese Einträge entfernen, bevor Sie einen Snapshot Ihres Bootlaufwerks erstellen.Windows-Instanzen

Mit dem Datenträgerverwaltungstool von Windows können Sie eine lokale SSD auf einer Windows-Instanz formatieren und bereitstellen.

Stellen Sie über RDP eine Verbindung zur Instanz her. Öffnen Sie für dieses Beispiel die Seite "VM-Instanzen" und klicken Sie neben der Instanz mit den angehängten lokalen SSDs auf die Schaltfläche RDP. Nachdem Sie Nutzername und Passwort eingegeben haben, wird ein Fenster mit der Desktop-Oberfläche Ihres Servers angezeigt.

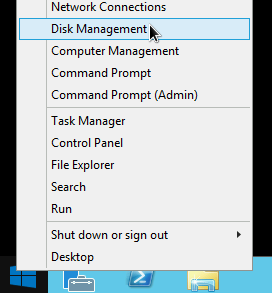

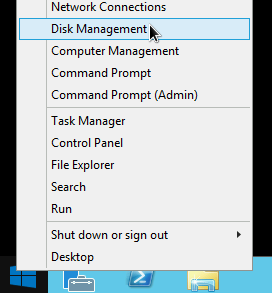

Klicken Sie mit der rechten Maustaste auf das Windows-Startmenü und wählen Sie Disk Management (Datenträgerverwaltung) aus.

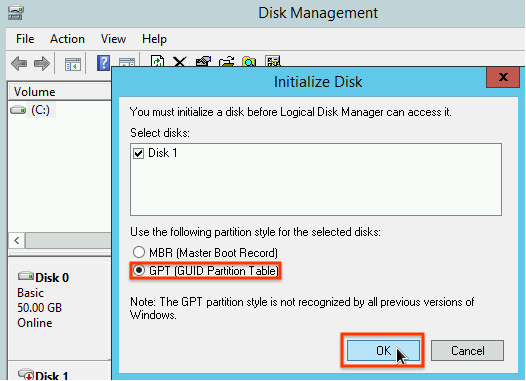

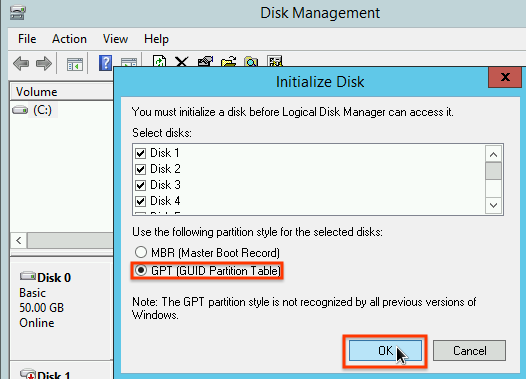

Falls Sie die lokale SSD noch nicht initialisiert haben, werden Sie nun durch das Tool aufgefordert, ein Partitionierungsschema für die neuen Partitionen festzulegen. Wählen Sie GPT aus und klicken Sie auf OK.

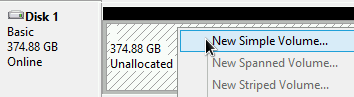

Klicken Sie nach dem Initialisieren der lokalen SSD mit der rechten Maustaste auf den nicht zugewiesenen Speicherplatz und wählen Sie New Simple Volume (Neues einfaches Volume) aus.

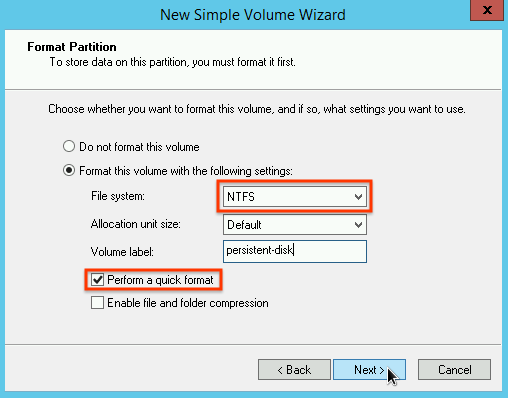

Folgen Sie der Anleitung im New Simple Volume Wizard (Assistent zum Erstellen neuer einfacher Volumes), um das neue Volume zu konfigurieren. Sie können ein beliebiges Partitionsformat verwenden. Wählen Sie für dieses Beispiel

NTFSaus. Klicken Sie außerdem auf das Kästchen Perform a quick format (Schnellformatierung), um die Formatierung zu beschleunigen.

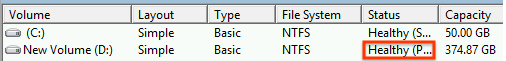

Prüfen Sie nach Abschluss des Assistenten und der Formatierung des Volumes, ob die neue lokale SSD den Status

Healthyhat.

Geschafft! Jetzt können Sie Dateien auf der lokalen SSD speichern.

Mehrere lokale SSD-Partitionen in einem logischen Volume formatieren und bereitstellen

Im Gegensatz zu nichtflüchtigen SSDs haben lokale SSDs eine feste Kapazität von 375 GB für jedes an die Instanz angehängte Gerät. Wenn Sie mehrere lokale SSD-Partitionen zu einem logischen Volume kombinieren möchten, müssen Sie die partitionenübergreifende Volumeverwaltung selbst definieren.

Linux-Instanzen

Verwenden Sie

mdadm, um ein RAID 0-Array zu erstellen. In diesem Beispiel wird das Array mit einem einzigenext4-Dateisystem formatiert. Sie können jedoch jedes beliebige Dateisystem anwenden.Öffnen Sie die Seite "VM-Instanzen".

Klicken Sie auf die Schaltfläche SSH neben der Instanz mit der neuen lokalen SSD. Im Browser wird eine Terminalverbindung zur Instanz hergestellt.

Installieren Sie im Terminal das Tool

mdadm. Der Installationsprozess fürmdadmenthält eine Eingabeaufforderung, mit der Skripts angehalten werden. Führen Sie diesen Prozess daher manuell aus.Debian und Ubuntu:

$ sudo apt update && sudo apt install mdadm --no-install-recommendsCentOS und RHEL:

$ sudo yum install mdadm -ySLES und openSUSE:

$ sudo zypper install -y mdadmVerwenden Sie den Befehl

find, um alle lokalen SSDs zu identifizieren, die zusammen bereitgestellt werden sollen.In diesem Beispiel sind der Instanz acht lokale SSD-Partitionen im NVMe-Modus zugeordnet:

$ find /dev/ | grep google-local-nvme-ssd /dev/disk/by-id/google-local-nvme-ssd-7 /dev/disk/by-id/google-local-nvme-ssd-6 /dev/disk/by-id/google-local-nvme-ssd-5 /dev/disk/by-id/google-local-nvme-ssd-4 /dev/disk/by-id/google-local-nvme-ssd-3 /dev/disk/by-id/google-local-nvme-ssd-2 /dev/disk/by-id/google-local-nvme-ssd-1 /dev/disk/by-id/google-local-nvme-ssd-0

findgarantiert keine Reihenfolge. Die Geräte können auch in einer anderen Reihenfolge aufgelistet werden, solange die Anzahl der Ausgabezeilen der erwarteten Anzahl von SSD-Partitionen entspricht. Lokale SSDs im SCSI-Modus haben Standardnamen wiegoogle-local-ssd. Lokale SSDs im NVMe-Modus haben Namen wiegoogle-local-nvme-ssd.Mit

mdadmkönnen Sie mehrere lokale SSD-Geräte zu einem einzigen Array namens/dev/md0zusammenfassen. In diesem Beispiel werden acht lokale SSD-Geräte im NVMe-Modus zusammengeführt. Geben Sie für lokale SSD-Geräte im SCSI-Modus die Namen an, die Sie mit dem Befehlfindabgerufen haben:$ sudo mdadm --create /dev/md0 --level=0 --raid-devices=8 \ /dev/disk/by-id/google-local-nvme-ssd-0 \ /dev/disk/by-id/google-local-nvme-ssd-1 \ /dev/disk/by-id/google-local-nvme-ssd-2 \ /dev/disk/by-id/google-local-nvme-ssd-3 \ /dev/disk/by-id/google-local-nvme-ssd-4 \ /dev/disk/by-id/google-local-nvme-ssd-5 \ /dev/disk/by-id/google-local-nvme-ssd-6 \ /dev/disk/by-id/google-local-nvme-ssd-7 mdadm: Defaulting to version 1.2 metadata mdadm: array /dev/md0 started.

Sie können die Details des Arrays mit

mdadm --detailbestätigen. Wenn Sie das Flag--prefer=by-idhinzufügen, werden die Geräte über die Pfade/dev/disk/by-idaufgelistet.sudo mdadm --detail --prefer=by-id /dev/md0

Die Ausgabe für jedes Gerät im Array sollte in etwa so aussehen:

... Number Major Minor RaidDevice State 0 259 0 0 active sync /dev/disk/by-id/google-local-nvme-ssd-0 ...Formatieren Sie das gesamte

/dev/md0-Array mit einem ext4-Dateisystem.$ sudo mkfs.ext4 -F /dev/md0Erstellen Sie mit dem Befehl ein Verzeichnis, in dem Sie

/dev/md0bereitstellen können. Erstellen Sie für dieses Beispiel das Verzeichnis/mnt/disks/ssd-array:$ sudo mkdir -p /mnt/disks/[MNT_DIR]Ersetzen Sie

[MNT_DIR]durch das Verzeichnis, in dem Sie das lokale SSD-Array bereitstellen möchten.Stellen Sie das Array

/dev/md0im Verzeichnis/mnt/disks/ssd-arraybereit:$ sudo mount /dev/md0 /mnt/disks/[MNT_DIR]Ersetzen Sie

[MNT_DIR]durch das Verzeichnis, in dem Sie das lokale SSD-Array bereitstellen möchten.Konfigurieren Sie den Lese-/Schreibzugriff auf das Gerät. In diesem Beispiel wird allen Nutzern Schreibzugriff gewährt:

$ sudo chmod a+w /mnt/disks/[MNT_DIR]Ersetzen Sie

[MNT_DIR]durch das Verzeichnis, in dem Sie das lokale SSD-Array bereitgestellt haben.

Optional können Sie die lokale SSD der Datei

/etc/fstabhinzufügen, damit das Gerät bei einem Neustart der Instanz automatisch wieder bereitgestellt wird. Dadurch bleiben die Daten auf der lokalen SSD beim Beenden der Instanz aber nicht erhalten. Weitere Informationen finden Sie unter Datenpersistenz auf lokalen SSDs.Achten Sie bei Ihrem Eintrag in die Datei

/etc/fstabdarauf, die Optionnofailaufzunehmen, damit die Instanz auch ohne die lokale SSD gestartet werden kann. Wenn Sie beispielsweise einen Snapshot des Bootlaufwerks erzeugen und eine neue Instanz ohne bereitgestellte lokale SSDs erstellen, kann die Instanz den Startvorgang fortsetzen und wird nicht auf unbestimmte Zeit angehalten.Erstellen Sie den Eintrag

/etc/fstab. Suchen Sie mit dem Befehlblkidnach der UUID für das Dateisystem auf dem Gerät und nehmen Sie die UUID in der Datei/etc/fstabin die Bereitstellungsoptionen auf. Geben Sie die Optionnofailan, damit das System auch dann starten kann, wenn die lokale SSD nicht verfügbar ist. Sie können diesen Schritt mit einem einzigen Befehl ausführen. Beispiel:$ echo UUID=`sudo blkid -s UUID -o value /dev/md0` /mnt/disks/[MNT_DIR] ext4 discard,defaults,nofail 0 2 | sudo tee -a /etc/fstabErsetzen Sie

[MNT_DIR]durch das Verzeichnis, in dem Sie das lokale SSD-Array bereitgestellt haben.Wenn Sie in der Datei

/etc/fstabanstelle der UUID einen Gerätenamen wie/dev/md0verwenden, müssen Sie die Datei/etc/mdadm/mdadm.confbearbeiten, damit das Array beim Booten automatisch neu zusammengesetzt wird. Dazu müssen Sie die folgenden zwei Schritte ausführen:- Achten Sie darauf, dass das Festplatten-Array beim Booten automatisch gescannt und neu zusammengesetzt wird.

$ sudo mdadm --detail --scan | sudo tee -a /etc/mdadm/mdadm.conf - Aktualisieren Sie

initramfs, damit das Array während des frühen Bootvorgangs verfügbar ist.$ sudo update-initramfs -u

- Achten Sie darauf, dass das Festplatten-Array beim Booten automatisch gescannt und neu zusammengesetzt wird.

Prüfen Sie mit dem Befehl

cat, ob Ihre/etc/fstab-Einträge korrekt sind:$ cat /etc/fstab

Wenn Sie einen Snapshot des Bootlaufwerks dieser Instanz erstellen und diesen Snapshot zum Erstellen einer separaten Instanz ohne lokale SSDs verwenden, bearbeiten Sie die Datei

/etc/fstabund entfernen Sie den Eintrag für dieses lokale SSD-Array. Auch bei aktivierter Optionnofailmüssen Sie die Datei/etc/fstabmit den Partitionen synchronisieren, die mit Ihrer Instanz verbunden sind, und diese Einträge entfernen, bevor Sie einen Snapshot Ihres Bootlaufwerks erstellen.Windows-Instanzen

Mit dem Datenträgerverwaltungstool von Windows können Sie ein Array lokaler SSDs auf einer Windows-Instanz formatieren und bereitstellen.

Stellen Sie über RDP eine Verbindung zur Instanz her. Öffnen Sie für dieses Beispiel die Seite "VM-Instanzen" und klicken Sie neben der Instanz mit den angehängten lokalen SSDs auf die Schaltfläche RDP. Nachdem Sie Nutzername und Passwort eingegeben haben, wird ein Fenster mit der Desktop-Oberfläche Ihres Servers angezeigt.

Klicken Sie mit der rechten Maustaste auf das Windows-Startmenü und wählen Sie Disk Management (Datenträgerverwaltung) aus.

Falls Sie die lokalen SSDs noch nicht initialisiert haben, werden Sie durch das Tool aufgefordert, ein Partitionierungsschema für die neuen Partitionen festzulegen. Wählen Sie GPT aus und klicken Sie auf OK.

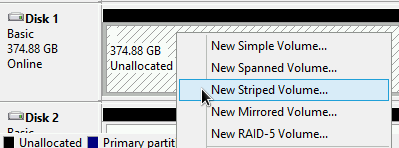

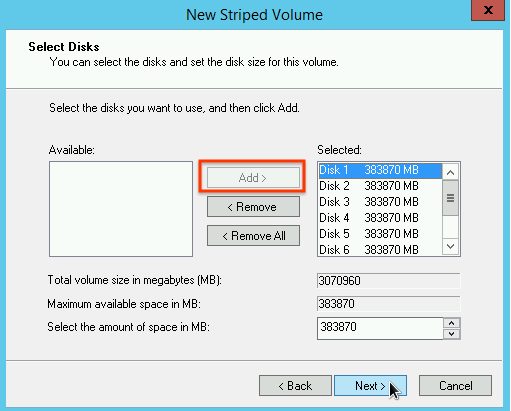

Klicken Sie nach der Initialisierung der lokalen SSD mit der rechten Maustaste auf den nicht zugewiesenen Speicherplatz und wählen Sie New Striped Volume (Neues Stripesetvolume) aus.

Wählen Sie die lokalen SSD-Partitionen aus, die zu dem Stripesetarray gehören sollen. In diesem Beispiel sollen alle Partitionen zu einem lokalen SSD-Gerät kombiniert werden.

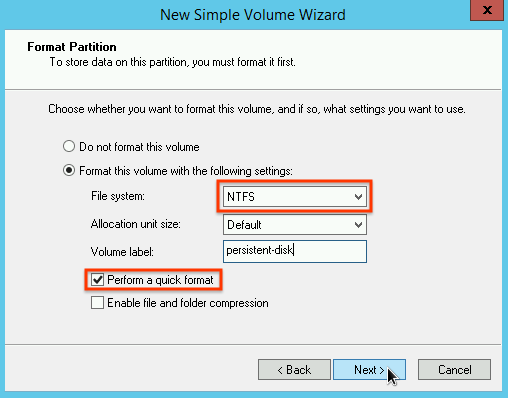

Befolgen Sie die Anleitung im New Striped Volume Wizard (Assistent zum Erstellen neuer Stripesetvolumes), um das neue Volume zu konfigurieren. Sie können ein beliebiges Partitionsformat verwenden. Wählen Sie für dieses Beispiel

NTFSaus. Klicken Sie außerdem auf das Kästchen Perform a quick format (Schnellformatierung), um die Formatierung zu beschleunigen.

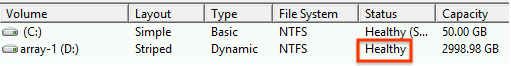

Prüfen Sie nach Abschluss des Assistenten und der Formatierung des Volumes, ob die neue lokale SSD den Status

Healthyhat.

Jetzt können Sie Dateien auf der lokalen SSD speichern.

Nächste Schritte

- Weitere Informationen zu Gerätenamen für Ihre VM.

- Leistung von lokalen SSD-Laufwerken vergleichen

Sofern nicht anders angegeben, sind die Inhalte dieser Seite unter der Creative Commons Attribution 4.0 License und Codebeispiele unter der Apache 2.0 License lizenziert. Weitere Informationen finden Sie in den Websiterichtlinien von Google Developers. Java ist eine eingetragene Marke von Oracle und/oder seinen Partnern.

Zuletzt aktualisiert: 2025-10-02 (UTC).

-