Nesta página, descrevemos como remover objetos de uma imagem. Com o Imagen na Vertex AI, é possível especificar uma área de máscara, chamada de repintura, para remover objetos de uma imagem. É possível usar sua própria máscara ou permitir que o Imagen na Vertex AI gere uma máscara para você.

Exemplo de remoção de conteúdo

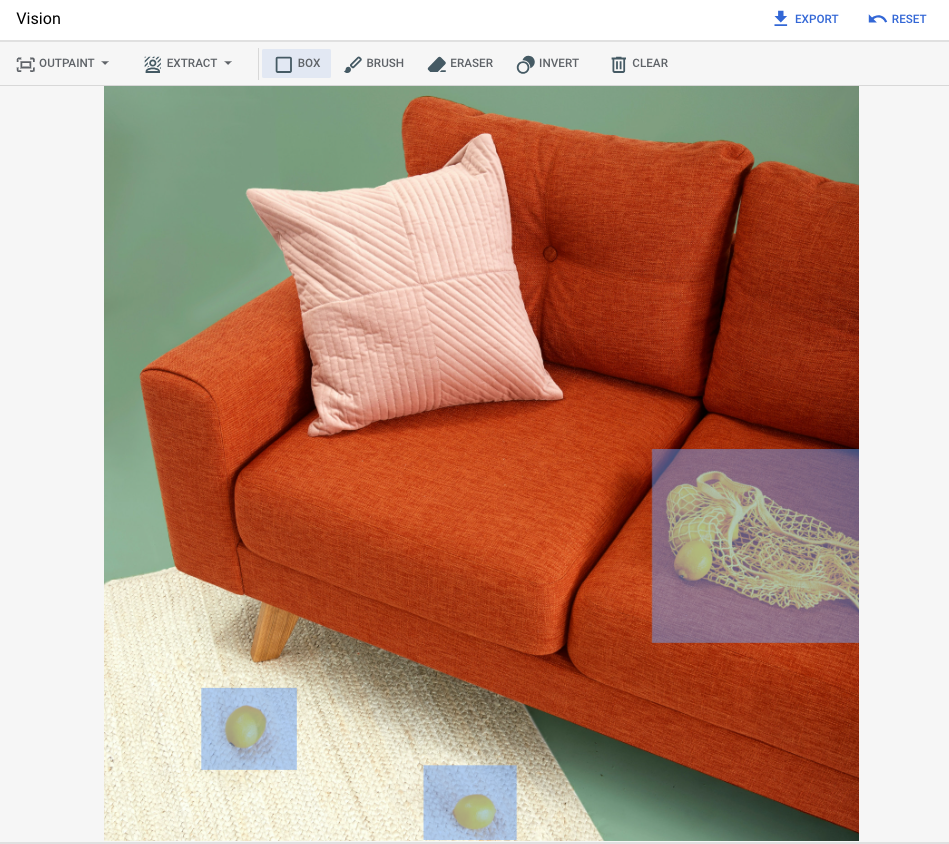

O exemplo a seguir usa o retoque para remover conteúdo de uma imagem atual usando uma máscara de imagem:

Entradas

Imagem de base* para editar |

Mascarar a área especificada usando ferramentas no console Google Cloud |

Comando de texto |

|---|---|---|

|

|

Comando: (nenhum comando fornecido) |

* Crédito da imagem: Inside Weather no Unsplash.

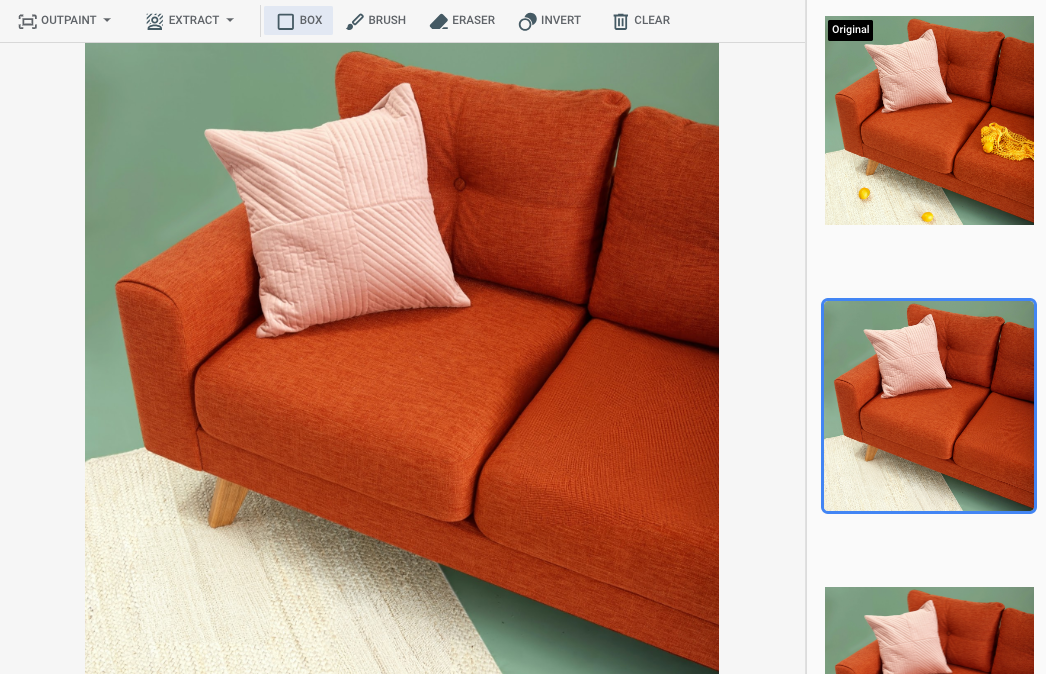

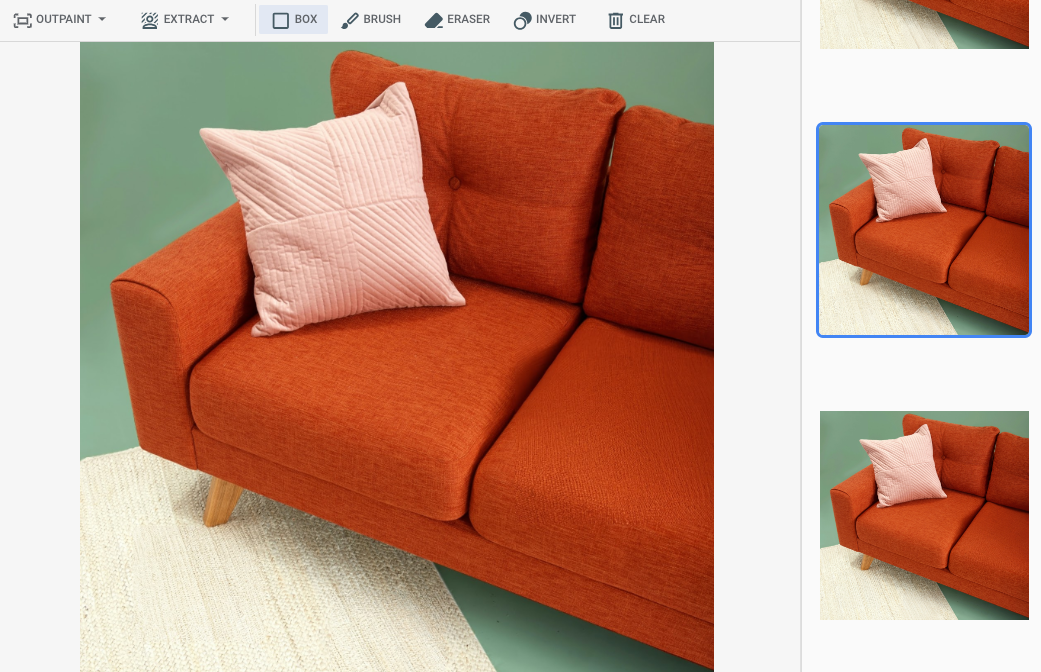

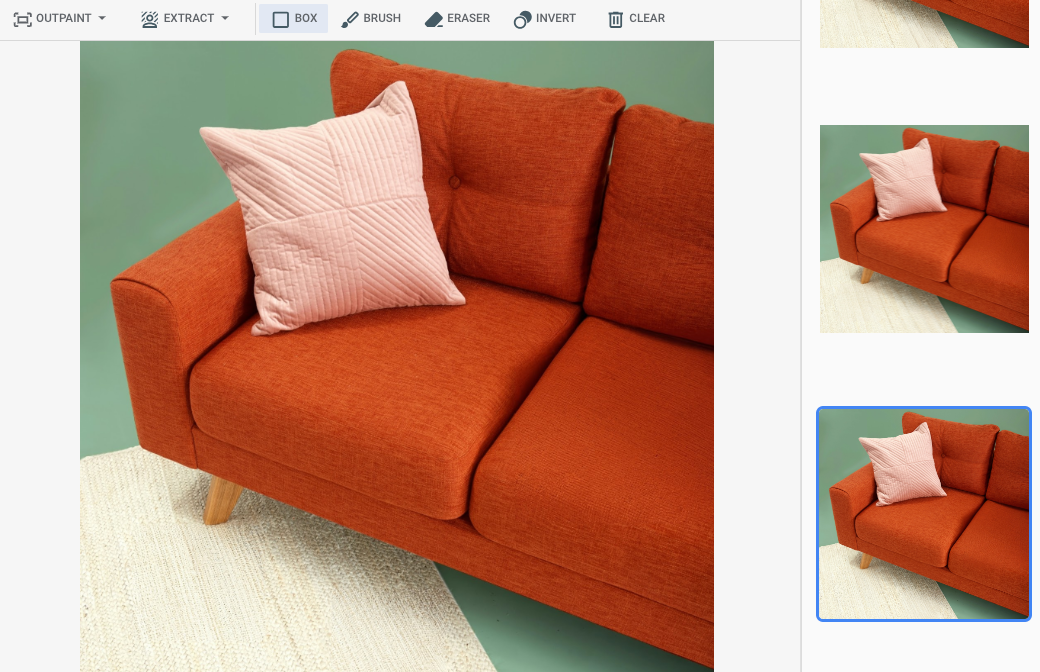

Saída após especificar uma área da máscara no Google Cloud console

|

|

|

Ver o card do modelo do Imagen para edição e personalização

Antes de começar

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Vertex AI API.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Vertex AI API.

-

Configure a autenticação do ambiente.

Select the tab for how you plan to use the samples on this page:

Console

When you use the Google Cloud console to access Google Cloud services and APIs, you don't need to set up authentication.

Java

Para usar os exemplos Java desta página em um ambiente de desenvolvimento local, instale e inicialize a CLI gcloud e configure o Application Default Credentials com suas credenciais de usuário.

Instale a CLI do Google Cloud.

Ao usar um provedor de identidade (IdP) externo, primeiro faça login na gcloud CLI com sua identidade federada.

If you're using a local shell, then create local authentication credentials for your user account:

gcloud auth application-default login

You don't need to do this if you're using Cloud Shell.

If an authentication error is returned, and you are using an external identity provider (IdP), confirm that you have signed in to the gcloud CLI with your federated identity.

Para mais informações, consulte Configurar o ADC para um ambiente de desenvolvimento local na documentação de autenticação do Google Cloud .

Node.js

Para usar os exemplos Node.js desta página em um ambiente de desenvolvimento local, instale e inicialize a CLI gcloud e configure o Application Default Credentials com suas credenciais de usuário.

Instale a CLI do Google Cloud.

Ao usar um provedor de identidade (IdP) externo, primeiro faça login na gcloud CLI com sua identidade federada.

If you're using a local shell, then create local authentication credentials for your user account:

gcloud auth application-default login

You don't need to do this if you're using Cloud Shell.

If an authentication error is returned, and you are using an external identity provider (IdP), confirm that you have signed in to the gcloud CLI with your federated identity.

Para mais informações, consulte Configurar o ADC para um ambiente de desenvolvimento local na documentação de autenticação do Google Cloud .

Python

Para usar os exemplos Python desta página em um ambiente de desenvolvimento local, instale e inicialize a CLI gcloud e configure o Application Default Credentials com suas credenciais de usuário.

Instale a CLI do Google Cloud.

Ao usar um provedor de identidade (IdP) externo, primeiro faça login na gcloud CLI com sua identidade federada.

If you're using a local shell, then create local authentication credentials for your user account:

gcloud auth application-default login

You don't need to do this if you're using Cloud Shell.

If an authentication error is returned, and you are using an external identity provider (IdP), confirm that you have signed in to the gcloud CLI with your federated identity.

Para mais informações, consulte Configurar o ADC para um ambiente de desenvolvimento local na documentação de autenticação do Google Cloud .

REST

Para usar as amostras da API REST nesta página em um ambiente de desenvolvimento local, use as credenciais fornecidas para a CLI gcloud.

Instale a CLI do Google Cloud.

Ao usar um provedor de identidade (IdP) externo, primeiro faça login na gcloud CLI com sua identidade federada.

Para mais informações, consulte Autenticar para usar REST na documentação de autenticação do Google Cloud .

Remover com uma área de máscara definida

Use os exemplos a seguir para especificar o retoque para remover o conteúdo. Nessas amostras, você especifica uma imagem de base, um prompt de texto e uma área de máscara para modificar a imagem de base.

Imagen 3

Use os exemplos a seguir para enviar uma solicitação de repintura usando o modelo do Imagen 3.

Console

-

No console do Google Cloud , acesse a página Vertex AI > Media Studio .

- Clique em Fazer upload. Na caixa de diálogo de arquivos exibida, selecione um arquivo para fazer upload.

- Clique em Pintar.

- No painel Parâmetros, clique em Pintar (remover).

-

Escolha uma destas opções:

- Fazer upload da sua própria máscara:

- Crie uma máscara no computador.

- Clique em Fazer upload da máscara. Na caixa de diálogo exibida, selecione uma máscara para fazer upload.

- Defina sua própria máscara:na barra de ferramentas de edição, use as ferramentas de máscara (caixa, pincel ou masked_transitions inverter) para especificar a área ou áreas às quais adicionar conteúdo.

- Fazer upload da sua própria máscara:

-

Opcional: no painel Parâmetros, ajuste as seguintes opções:

- Modelo: o modelo do Imagen a ser usado

- Número de resultados: o número de resultados a serem gerados.

- Comando negativo: itens a serem evitados na geração

- No campo de comando, digite um comando para modificar a imagem.

- Clique em Gerar.

Python

Instalar

pip install --upgrade google-genai

Para saber mais, consulte a documentação de referência do SDK.

Defina variáveis de ambiente para usar o SDK de IA generativa com a Vertex AI:

# Replace the `GOOGLE_CLOUD_PROJECT` and `GOOGLE_CLOUD_LOCATION` values # with appropriate values for your project. export GOOGLE_CLOUD_PROJECT=GOOGLE_CLOUD_PROJECT export GOOGLE_CLOUD_LOCATION=us-central1 export GOOGLE_GENAI_USE_VERTEXAI=True

REST

Para mais informações, consulte a referência da API Editar imagens.

Antes de usar os dados da solicitação abaixo, faça as substituições a seguir:

- PROJECT_ID: o ID do projeto do Google Cloud .

- LOCATION: a região do seu projeto. Por exemplo,

us-central1,europe-west2ouasia-northeast3. Para uma lista de regiões disponíveis, consulte IA generativa em locais da Vertex AI. prompt: para melhores resultados, omita um comando enegativePromptao usar a pintura interna para remoção.- B64_BASE_IMAGE: a imagem de base que será editada ou aprimorada. A imagem precisa ser especificada como uma string de bytes codificada em base64. Limite de tamanho: 10 MB.

- B64_MASK_IMAGE: a imagem em preto e branco que você quer usar como uma camada de máscara para editar a imagem original. A imagem precisa ser especificada como uma string de bytes codificada em base64. Limite de tamanho: 10 MB.

- MASK_DILATION: ponto flutuante. A porcentagem da largura da imagem para dilatar essa máscara. Um valor de

0.01é recomendado para compensar máscaras de entrada imperfeitas. - EDIT_STEPS: número inteiro. O número de etapas de amostragem para o modelo de base. Para a remoção de

inpainting, comece com

12etapas. Aumente as etapas até o limite superior de75se a qualidade não atender aos seus requisitos. Aumentar as etapas também aumenta a latência da solicitação. - EDIT_IMAGE_COUNT: o número de imagens editadas. Valores inteiros aceitos: 1 a 4. Valor padrão: 4.

Método HTTP e URL:

POST https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/imagen-3.0-capability-001:predict

Corpo JSON da solicitação:

{ "instances": [ { "prompt": "", "referenceImages": [ { "referenceType": "REFERENCE_TYPE_RAW", "referenceId": 1, "referenceImage": { "bytesBase64Encoded": "B64_BASE_IMAGE" } }, { "referenceType": "REFERENCE_TYPE_MASK", "referenceId": 2, "referenceImage": { "bytesBase64Encoded": "B64_MASK_IMAGE" }, "maskImageConfig": { "maskMode": "MASK_MODE_USER_PROVIDED", "dilation": MASK_DILATION } } ] } ], "parameters": { "editConfig": { "baseSteps": EDIT_STEPS }, "editMode": "EDIT_MODE_INPAINT_REMOVAL", "sampleCount": EDIT_IMAGE_COUNT } }Para enviar a solicitação, escolha uma destas opções:

O exemplo de resposta a seguir é para uma solicitação comcurl

Salve o corpo da solicitação em um arquivo com o nome

request.jsone execute o comando a seguir:curl -X POST \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "Content-Type: application/json; charset=utf-8" \

-d @request.json \

"https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/imagen-3.0-capability-001:predict"PowerShell

Salve o corpo da solicitação em um arquivo com o nome

request.jsone execute o comando a seguir:$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred" }

Invoke-WebRequest `

-Method POST `

-Headers $headers `

-ContentType: "application/json; charset=utf-8" `

-InFile request.json `

-Uri "https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/imagen-3.0-capability-001:predict" | Select-Object -Expand Content"sampleCount": 2. A resposta retorna dois objetos de previsão, com os bytes de imagem gerados codificados em base64.{ "predictions": [ { "bytesBase64Encoded": "BASE64_IMG_BYTES", "mimeType": "image/png" }, { "mimeType": "image/png", "bytesBase64Encoded": "BASE64_IMG_BYTES" } ] }Imagen 2

Use os exemplos a seguir para enviar uma solicitação de pintura usando o modelo do Imagen 2.

Console

-

No console do Google Cloud , acesse a página Vertex AI > Media Studio .

-

No painel inferior de tarefas, clique em Editar imagem.

-

Clique em Fazer upload para selecionar a imagem do produto armazenada localmente a ser editada.

-

Na barra de ferramentas de edição, use as ferramentas de máscara (caixa, pincel ou masked_transitions inverter) para especificar a área ou áreas das quais remover conteúdo.

-

Opcional. No painel Parâmetros, ajuste o Número de resultados, o Comando negativo (opcional para remoção), a Orientação de solicitação de texto ou outros parâmetros.

-

Deixe o campo de solicitação em branco.

-

Clique em Gerar.

REST

Antes de usar os dados da solicitação abaixo, faça as substituições a seguir:

- PROJECT_ID: o ID do projeto do Google Cloud .

- LOCATION: a região do seu projeto. Por exemplo,

us-central1,europe-west2ouasia-northeast3. Para uma lista de regiões disponíveis, consulte IA generativa em locais da Vertex AI. - B64_BASE_IMAGE: a imagem de base que será editada ou aprimorada. A imagem precisa ser especificada como uma string de bytes codificada em base64. Limite de tamanho: 10 MB.

- B64_MASK_IMAGE: a imagem em preto e branco que você quer usar como uma camada de máscara para editar a imagem original. A imagem precisa ser especificada como uma string de bytes codificada em base64. Limite de tamanho: 10 MB.

- EDIT_IMAGE_COUNT: o número de imagens editadas. Valor padrão: 4.

Método HTTP e URL:

POST https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/imagegeneration@006:predict

Corpo JSON da solicitação:

{ "instances": [ { "prompt": "", "image": { "bytesBase64Encoded": "B64_BASE_IMAGE" }, "mask": { "image": { "bytesBase64Encoded": "B64_MASK_IMAGE" } } } ], "parameters": { "sampleCount": EDIT_IMAGE_COUNT, "editConfig": { "editMode": "inpainting-remove" } } }Para enviar a solicitação, escolha uma destas opções:

O exemplo de resposta a seguir é para uma solicitação comcurl

Salve o corpo da solicitação em um arquivo com o nome

request.jsone execute o comando a seguir:curl -X POST \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "Content-Type: application/json; charset=utf-8" \

-d @request.json \

"https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/imagegeneration@006:predict"PowerShell

Salve o corpo da solicitação em um arquivo com o nome

request.jsone execute o comando a seguir:$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred" }

Invoke-WebRequest `

-Method POST `

-Headers $headers `

-ContentType: "application/json; charset=utf-8" `

-InFile request.json `

-Uri "https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/imagegeneration@006:predict" | Select-Object -Expand Content"sampleCount": 2. A resposta retorna dois objetos de previsão, com os bytes de imagem gerados codificados em base64.{ "predictions": [ { "bytesBase64Encoded": "BASE64_IMG_BYTES", "mimeType": "image/png" }, { "mimeType": "image/png", "bytesBase64Encoded": "BASE64_IMG_BYTES" } ] }Python

Para saber como instalar o SDK da Vertex AI para Python, consulte Instalar o SDK da Vertex AI para Python. Para mais informações, consulte a documentação de referência da API Python.

Java

Antes de testar esse exemplo, siga as instruções de configuração para Java no Guia de início rápido da Vertex AI sobre como usar bibliotecas de cliente. Para mais informações, consulte a documentação de referência da API Vertex AI para Java.

Para autenticar na Vertex AI, configure o Application Default Credentials. Para mais informações, consulte Configurar a autenticação para um ambiente de desenvolvimento local.

Neste exemplo, você especifica o modelo como parte de um

EndpointName. OEndpointNameé transmitido ao métodopredict, que é chamado em umPredictionServiceClient. O serviço retorna uma versão editada da imagem, que é salva localmente.Para mais informações sobre versões e recursos do modelo, consulte Modelos do Imagen.

Node.js

Antes de testar esse exemplo, siga as instruções de configuração para Node.js no Guia de início rápido da Vertex AI sobre como usar bibliotecas de cliente. Para mais informações, consulte a documentação de referência da API Vertex AI para Node.js.

Para autenticar na Vertex AI, configure o Application Default Credentials. Para mais informações, consulte Configurar a autenticação para um ambiente de desenvolvimento local.

Neste exemplo, você chama o métodopredictem umPredictionServiceClient. O serviço gera imagens que são salvas localmente. Para mais informações sobre versões e recursos do modelo, consulte Modelos do Imagen.Remover com detecção automática de máscaras

Use os exemplos a seguir para especificar o retoque para remover o conteúdo. Nessas amostras, você especifica uma imagem de base e um comando de texto. O Imagen detecta e cria automaticamente uma área de máscara para modificar a imagem de base.

Imagen 3

Use os exemplos a seguir para enviar uma solicitação de repintura usando o modelo do Imagen 3.

Console

-

No console do Google Cloud , acesse a página Vertex AI > Media Studio .

- Clique em Fazer upload. Na caixa de diálogo de arquivos exibida, selecione um arquivo para fazer upload.

- Clique em Pintar.

- No painel Parâmetros, selecione Repintura (remover).

- Na barra de ferramentas de edição, clique em background_replaceExtrair.

-

Selecione uma das opções de extração de máscara:

- Elementos de segundo plano: detecta os elementos de segundo plano e cria uma máscara em torno deles.

- Elementos em primeiro plano: detecta os objetos em primeiro plano e cria uma máscara ao redor deles.

- background_replacePessoas: detecta pessoas e cria uma máscara ao redor delas.

-

Opcional: no painel Parâmetros, ajuste as seguintes opções:

- Modelo: o modelo do Imagen a ser usado

- Número de resultados: o número de resultados a serem gerados.

- Comando negativo: itens a serem evitados na geração

- No campo de prompt, digite um novo prompt para modificar a imagem.

- Clique em enviarGerar.

Python

Instalar

pip install --upgrade google-genai

Para saber mais, consulte a documentação de referência do SDK.

Defina variáveis de ambiente para usar o SDK de IA generativa com a Vertex AI:

# Replace the `GOOGLE_CLOUD_PROJECT` and `GOOGLE_CLOUD_LOCATION` values # with appropriate values for your project. export GOOGLE_CLOUD_PROJECT=GOOGLE_CLOUD_PROJECT export GOOGLE_CLOUD_LOCATION=us-central1 export GOOGLE_GENAI_USE_VERTEXAI=True

REST

Para mais informações, consulte a referência da API Editar imagens.

Antes de usar os dados da solicitação abaixo, faça as substituições a seguir:

- PROJECT_ID: o ID do projeto do Google Cloud .

- LOCATION: a região do seu projeto. Por exemplo,

us-central1,europe-west2ouasia-northeast3. Para uma lista de regiões disponíveis, consulte IA generativa em locais da Vertex AI. prompt: para melhores resultados, omita um comando enegativePromptao usar a pintura interna para remoção.- B64_BASE_IMAGE: a imagem de base que será editada ou aprimorada. A imagem precisa ser especificada como uma string de bytes codificada em base64. Limite de tamanho: 10 MB.

- MASK_MODE: uma string que define o tipo de criação automática de máscara usada pelo modelo.

Valores disponíveis:

MASK_MODE_BACKGROUND: gera automaticamente uma máscara usando a segmentação de segundo plano. Use essa configuração para modificar o conteúdo em segundo plano.MASK_MODE_FOREGROUND: gera automaticamente uma máscara usando a segmentação em primeiro plano. Use essa configuração para modificar o conteúdo em primeiro plano, como remover esses objetos em primeiro plano (remoção usando pintura).MASK_MODE_SEMANTIC: gera automaticamente uma máscara usando a segmentação semântica com base nas classes de segmentação especificadas na matrizmaskImageConfig.maskClasses. Por exemplo:"maskImageConfig": { "maskMode": "MASK_MODE_SEMANTIC", "maskClasses": [175, 176], // bicycle, car "dilation": 0.01 }

- MASK_DILATION: ponto flutuante. A porcentagem da largura da imagem para dilatar essa máscara. Um valor de

0.01é recomendado para compensar máscaras de entrada imperfeitas. - EDIT_STEPS: número inteiro. O número de etapas de amostragem para o modelo de base. Para a remoção de

inpainting, comece com

12etapas. Aumente as etapas até o limite superior de75se a qualidade não atender aos seus requisitos. Aumentar as etapas também aumenta a latência da solicitação. - EDIT_IMAGE_COUNT: o número de imagens editadas. Valores inteiros aceitos: 1 a 4. Valor padrão: 4.

Método HTTP e URL:

POST https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/imagen-3.0-capability-001:predict

Corpo JSON da solicitação:

{ "instances": [ { "prompt": "", "referenceImages": [ { "referenceType": "REFERENCE_TYPE_RAW", "referenceId": 1, "referenceImage": { "bytesBase64Encoded": "B64_BASE_IMAGE" } }, { "referenceType": "REFERENCE_TYPE_MASK", "referenceId": 2, "maskImageConfig": { "maskMode": "MASK_MODE", "dilation": MASK_DILATION } } ] } ], "parameters": { "editConfig": { "baseSteps": EDIT_STEPS }, "editMode": "EDIT_MODE_INPAINT_REMOVAL", "sampleCount": EDIT_IMAGE_COUNT } }Para enviar a solicitação, escolha uma destas opções:

O exemplo de resposta a seguir é para uma solicitação comcurl

Salve o corpo da solicitação em um arquivo com o nome

request.jsone execute o comando a seguir:curl -X POST \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "Content-Type: application/json; charset=utf-8" \

-d @request.json \

"https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/imagen-3.0-capability-001:predict"PowerShell

Salve o corpo da solicitação em um arquivo com o nome

request.jsone execute o comando a seguir:$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred" }

Invoke-WebRequest `

-Method POST `

-Headers $headers `

-ContentType: "application/json; charset=utf-8" `

-InFile request.json `

-Uri "https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/imagen-3.0-capability-001:predict" | Select-Object -Expand Content"sampleCount": 2. A resposta retorna dois objetos de previsão, com os bytes de imagem gerados codificados em base64.{ "predictions": [ { "bytesBase64Encoded": "BASE64_IMG_BYTES", "mimeType": "image/png" }, { "mimeType": "image/png", "bytesBase64Encoded": "BASE64_IMG_BYTES" } ] }Imagen 2

Use os exemplos a seguir para enviar uma solicitação de pintura usando o modelo do Imagen 2.

Console

-

No console do Google Cloud , acesse a página Vertex AI > Media Studio .

-

No painel inferior de tarefas, clique em Editar imagem.

-

Clique em Fazer upload para selecionar a imagem do produto armazenada localmente a ser editada.

-

Na barra de ferramentas de edição, clique em background_replace Extract.

-

Selecione uma das opções de extração de máscara:

- Elementos de segundo plano: detecta os elementos de segundo plano e cria uma máscara em torno deles.

- Elementos em primeiro plano: detecta os objetos em primeiro plano e cria uma máscara ao redor deles.

- background_replace Pessoas: detecta pessoas e cria uma máscara ao redor delas.

-

Opcional. No painel Parâmetros, ajuste o Número de resultados, o Comando negativo, a Orientação de comando de texto ou outros parâmetros.

-

Deixe o campo de solicitação em branco.

-

Clique em Gerar.

REST

Antes de usar os dados da solicitação abaixo, faça as substituições a seguir:

- PROJECT_ID: o ID do projeto do Google Cloud .

- LOCATION: a região do seu projeto. Por exemplo,

us-central1,europe-west2ouasia-northeast3. Para uma lista de regiões disponíveis, consulte IA generativa em locais da Vertex AI. - B64_BASE_IMAGE: a imagem de base que será editada ou aprimorada. A imagem precisa ser especificada como uma string de bytes codificada em base64. Limite de tamanho: 10 MB.

- EDIT_IMAGE_COUNT: o número de imagens editadas. Valor padrão: 4.

- MASK_TYPE: solicita que o modelo gere uma máscara em vez de você precisar fornecer

uma. Consequentemente, ao fornecer esse parâmetro, você precisará omitir um objeto

mask. Valores disponíveis:background: gera automaticamente uma máscara para todas as regiões, exceto o objeto, a pessoa ou o assunto principal na imagem.foreground: gera automaticamente uma máscara para o objeto, a pessoa ou o assunto principal na imagem.semantic: use a segmentação automática para criar uma área de máscara para uma ou mais das classes de segmentação. Defina as classes de segmentação usando o parâmetroclassese os valoresclass_idcorrespondentes. É possível especificar até cinco classes. Quando você usa o tipo de máscara semântica, o objetomaskModeprecisa ter a seguinte aparência:"maskMode": { "maskType": "semantic", "classes": [class_id1, class_id2] }

Método HTTP e URL:

POST https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/imagegeneration@006:predict

Corpo JSON da solicitação:

{ "instances": [ { "prompt": "", "image": { "bytesBase64Encoded": "B64_BASE_IMAGE" } } ], "parameters": { "sampleCount": EDIT_IMAGE_COUNT, "editConfig": { "editMode": "inpainting-remove", "maskMode": { "maskType": "MASK_TYPE" } } } }Para enviar a solicitação, escolha uma destas opções:

O exemplo de resposta a seguir é para uma solicitação comcurl

Salve o corpo da solicitação em um arquivo com o nome

request.jsone execute o comando a seguir:curl -X POST \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "Content-Type: application/json; charset=utf-8" \

-d @request.json \

"https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/imagegeneration@006:predict"PowerShell

Salve o corpo da solicitação em um arquivo com o nome

request.jsone execute o comando a seguir:$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred" }

Invoke-WebRequest `

-Method POST `

-Headers $headers `

-ContentType: "application/json; charset=utf-8" `

-InFile request.json `

-Uri "https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/imagegeneration@006:predict" | Select-Object -Expand Content"sampleCount": 2. A resposta retorna dois objetos de previsão, com os bytes de imagem gerados codificados em base64.{ "predictions": [ { "bytesBase64Encoded": "BASE64_IMG_BYTES", "mimeType": "image/png" }, { "mimeType": "image/png", "bytesBase64Encoded": "BASE64_IMG_BYTES" } ] }Python

Para saber como instalar o SDK da Vertex AI para Python, consulte Instalar o SDK da Vertex AI para Python. Para mais informações, consulte a documentação de referência da API Python.

Limitações

As seções a seguir explicam as limitações do recurso de remoção de objetos da Imagen.

Pixels modificados

Não há garantia de que os pixels gerados pelo modelo que não estão na máscara sejam idênticos à entrada. Eles são gerados na resolução do modelo (como 1024 x 1024). Pode haver mudanças muito pequenas na imagem gerada.

Se você quiser preservar a imagem perfeitamente, recomendamos misturar a imagem gerada com a de entrada usando a máscara. Normalmente, se a resolução da imagem de entrada for 2K ou superior, é necessário combinar a imagem gerada e a imagem de entrada.

Limitação de remoção

Alguns objetos pequenos adjacentes às máscaras também podem ser removidos. Como prática recomendada, recomendamos que você faça a máscara o mais precisa possível.

Remover grandes áreas de regiões do céu em imagens externas pode resultar em artefatos indesejados. Como prática recomendada, recomendamos que você forneça um comando.

A seguir

Confira artigos sobre o Imagen e outras IAs generativas nos produtos da Vertex AI:

- Guia para desenvolvedores sobre como começar a usar o Imagen 3 na Vertex AI

- Novos modelos e ferramentas de mídia generativa criados com criadores para criadores

- Novidades no Gemini: Gems personalizados e geração de imagens aprimorada com o Imagen 3

- Google DeepMind: Imagen 3 — Nosso modelo de qualidade mais alta para conversão de texto em imagem

Exceto em caso de indicação contrária, o conteúdo desta página é licenciado de acordo com a Licença de atribuição 4.0 do Creative Commons, e as amostras de código são licenciadas de acordo com a Licença Apache 2.0. Para mais detalhes, consulte as políticas do site do Google Developers. Java é uma marca registrada da Oracle e/ou afiliadas.

Última atualização 2025-09-04 UTC.

-