Cette page décrit l'insertion d'objets dans une image, également appelée inpainting. Imagen sur Vertex AI vous permet de spécifier une zone de masque pour insérer des objets dans une image. Vous pouvez fournir votre propre masque ou laisser Imagen sur Vertex AI en générer un.

Exemple d'insertion de contenu

Avec l'insertion de contenu par inpainting, vous pouvez utiliser une image de base, un masque d'image et un prompt textuel pour ajouter du contenu à une image existante.

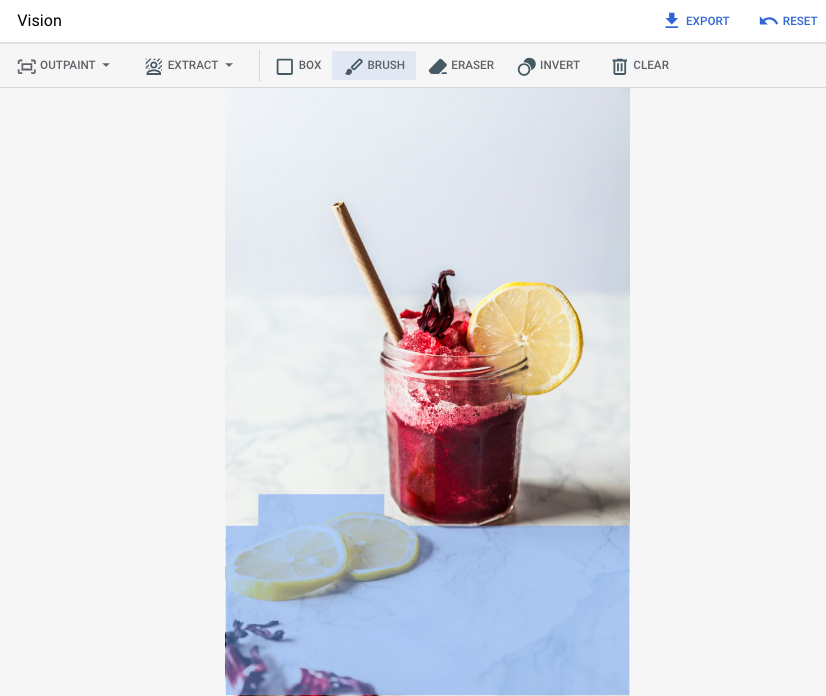

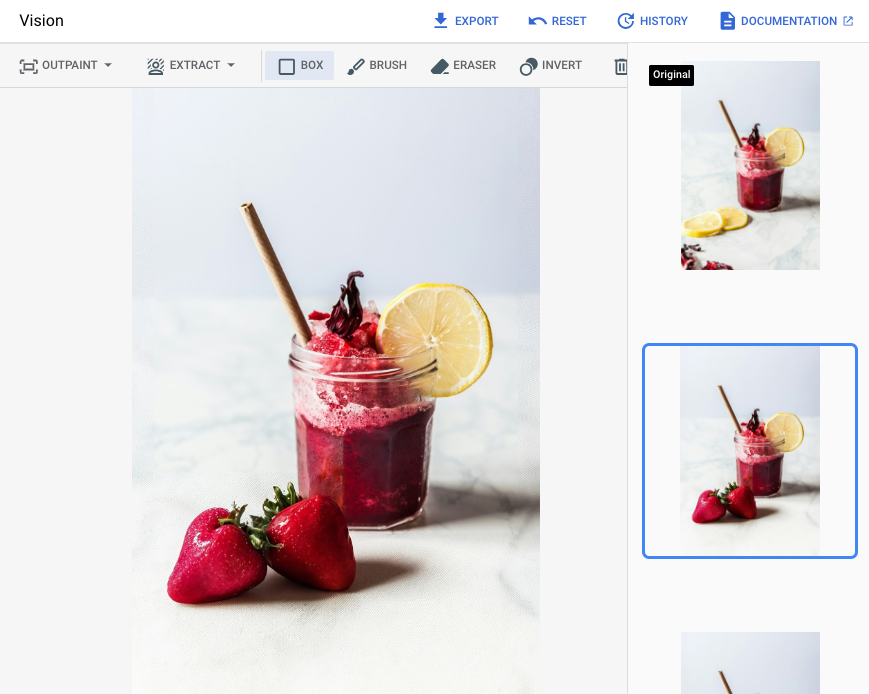

Entrées

| Image de base* à modifier | Zone de masque spécifiée à l'aide d'outils de la console Google Cloud | Requête textuelle |

|---|---|---|

|

|

fraises |

* Crédit image : Alex Lvrs sur Unsplash.

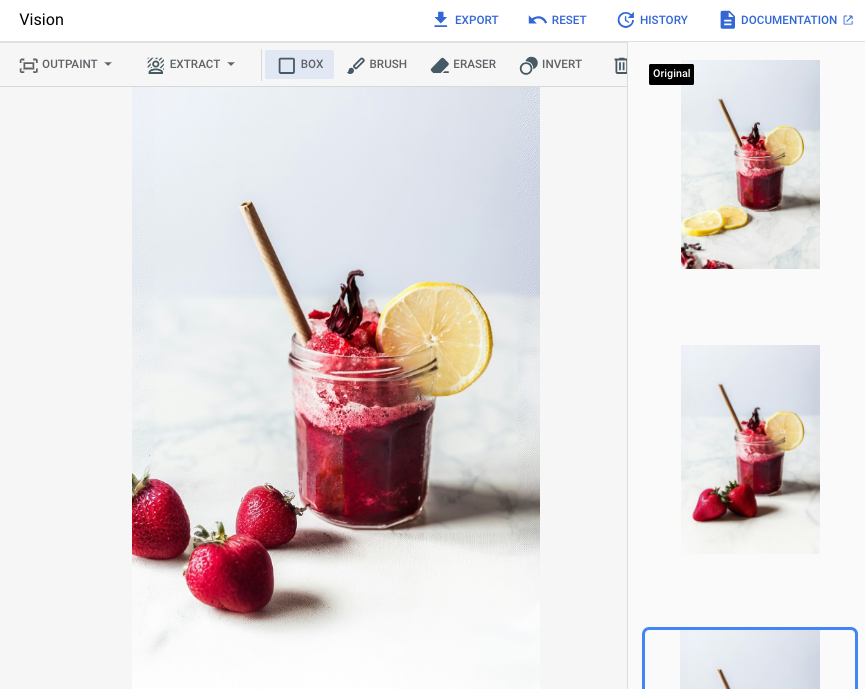

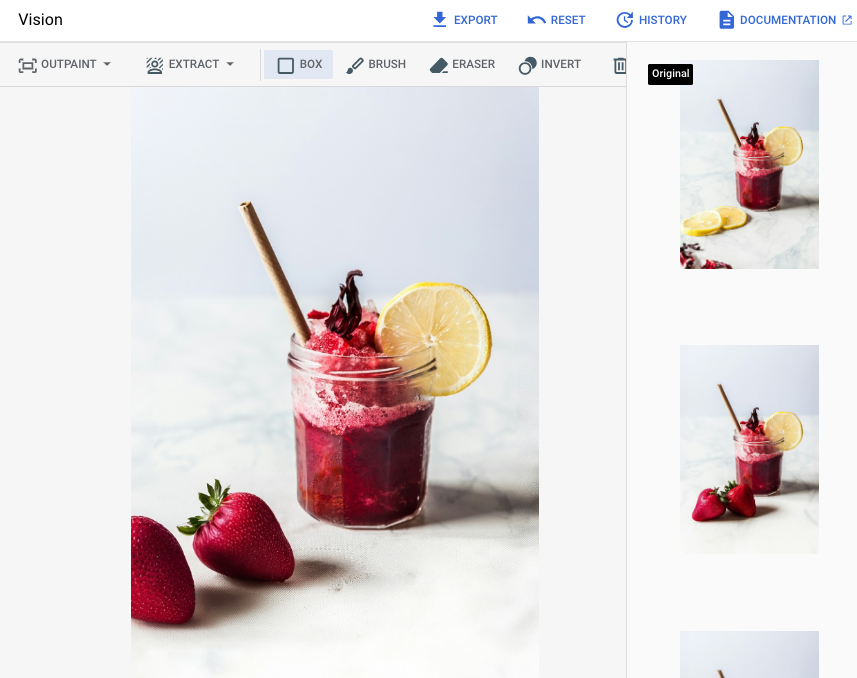

Sortie après avoir spécifié une zone de masque dans la console Google Cloud

|

|

|

Afficher la fiche de modèle Imagen pour la modification et la personnalisation

Avant de commencer

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Vertex AI API.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. -

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Vertex AI API.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. -

Configurez l'authentification pour votre environnement.

Select the tab for how you plan to use the samples on this page:

Console

When you use the Google Cloud console to access Google Cloud services and APIs, you don't need to set up authentication.

Java

Pour utiliser les exemples Java de cette page dans un environnement de développement local, installez et initialisez la gcloud CLI, puis configurez le service Identifiants par défaut de l'application à l'aide de vos identifiants utilisateur.

Installez la Google Cloud CLI.

Si vous utilisez un fournisseur d'identité (IdP) externe, vous devez d'abord vous connecter à la gcloud CLI avec votre identité fédérée.

If you're using a local shell, then create local authentication credentials for your user account:

gcloud auth application-default login

You don't need to do this if you're using Cloud Shell.

If an authentication error is returned, and you are using an external identity provider (IdP), confirm that you have signed in to the gcloud CLI with your federated identity.

Pour en savoir plus, consultez la section Configurer les ADC pour un environnement de développement local dans la documentation sur l'authentification Google Cloud .

Node.js

Pour utiliser les exemples Node.js de cette page dans un environnement de développement local, installez et initialisez la gcloud CLI, puis configurez le service Identifiants par défaut de l'application à l'aide de vos identifiants utilisateur.

Installez la Google Cloud CLI.

Si vous utilisez un fournisseur d'identité (IdP) externe, vous devez d'abord vous connecter à la gcloud CLI avec votre identité fédérée.

If you're using a local shell, then create local authentication credentials for your user account:

gcloud auth application-default login

You don't need to do this if you're using Cloud Shell.

If an authentication error is returned, and you are using an external identity provider (IdP), confirm that you have signed in to the gcloud CLI with your federated identity.

Pour en savoir plus, consultez la section Configurer les ADC pour un environnement de développement local dans la documentation sur l'authentification Google Cloud .

Python

Pour utiliser les exemples Python de cette page dans un environnement de développement local, installez et initialisez la gcloud CLI, puis configurez le service Identifiants par défaut de l'application à l'aide de vos identifiants utilisateur.

Installez la Google Cloud CLI.

Si vous utilisez un fournisseur d'identité (IdP) externe, vous devez d'abord vous connecter à la gcloud CLI avec votre identité fédérée.

If you're using a local shell, then create local authentication credentials for your user account:

gcloud auth application-default login

You don't need to do this if you're using Cloud Shell.

If an authentication error is returned, and you are using an external identity provider (IdP), confirm that you have signed in to the gcloud CLI with your federated identity.

Pour en savoir plus, consultez la section Configurer les ADC pour un environnement de développement local dans la documentation sur l'authentification Google Cloud .

REST

Pour utiliser les exemples API REST de cette page dans un environnement de développement local, vous devez utiliser les identifiants que vous fournissez à la gcloud CLI.

Installez la Google Cloud CLI.

Si vous utilisez un fournisseur d'identité (IdP) externe, vous devez d'abord vous connecter à la gcloud CLI avec votre identité fédérée.

Pour en savoir plus, consultez la section S'authentifier pour utiliser REST dans la documentation sur l'authentification Google Cloud .

Insérer avec une zone de masque définie

Utilisez les exemples suivants pour insérer du contenu par inpainting. Dans ces exemples, vous spécifiez une image de base, un prompt textuel et une zone de masque afin de modifier l'image de base.

Imagen 3

Utilisez les exemples suivants pour envoyer une requête d'inpainting à l'aide du modèle Imagen 3.

Console

-

Dans la console Google Cloud , accédez à la page Vertex AI>Media Studio .

- Cliquez sur Importer. Dans la boîte de dialogue de sélection de fichier qui s'affiche, sélectionnez un fichier à importer.

- Cliquez sur Réparation.

-

Effectuez l'une des opérations suivantes :

- Importer votre propre masque :

- Créez un masque sur votre ordinateur.

- Cliquez sur Importer un masque. Dans la boîte de dialogue qui s'affiche, sélectionnez un masque à importer.

- Définissez votre masque : dans la barre d'outils de modification, utilisez les outils de masque ( Zone, Pinceau ou masked_transitions Inversion) pour spécifier la ou les zones dans lesquelles vous souhaitez ajouter du contenu.

- Importer votre propre masque :

-

Facultatif : Dans le panneau Paramètres, ajustez les options suivantes :

- Modèle : modèle Imagen à utiliser

- Nombre de résultats : nombre de résultats à générer

- Requête négative : éléments à ne pas générer

- Dans le champ du prompt, saisissez un prompt pour modifier l'image.

- Cliquez sur Générer.

Python

Installer

pip install --upgrade google-genai

Pour en savoir plus, consultez la documentation de référence du SDK.

Définissez des variables d'environnement pour utiliser le SDK Gen AI avec Vertex AI :

# Replace the `GOOGLE_CLOUD_PROJECT` and `GOOGLE_CLOUD_LOCATION` values # with appropriate values for your project. export GOOGLE_CLOUD_PROJECT=GOOGLE_CLOUD_PROJECT export GOOGLE_CLOUD_LOCATION=us-central1 export GOOGLE_GENAI_USE_VERTEXAI=True

REST

Pour en savoir plus, consultez la documentation de référence de l'API Modifier des images.

Avant d'utiliser les données de requête, effectuez les remplacements suivants :

- PROJECT_ID : ID de votre projet Google Cloud .

- LOCATION : région de votre projet (

us-central1,europe-west2ouasia-northeast3, par exemple). Pour obtenir la liste des régions disponibles, consultez IA générative sur les emplacements Vertex AI. - TEXT_PROMPT : prompt textuel qui guide le modèle pour la génération d'images. Lorsque vous utilisez un prompt pour une insertion par inpainting, décrivez la zone de masque pour obtenir de meilleurs résultats. Évitez les prompts à un seul mot. Par exemple, saisissez un corgi mignon au lieu de corgi.

- B64_BASE_IMAGE : image de base à modifier ou à améliorer. L'image doit être spécifiée en tant que chaîne d'octets encodés en base64. Limite de taille : 10 Mo.

- B64_MASK_IMAGE : image en noir et blanc que vous souhaitez utiliser comme calque de masque pour modifier l'image d'origine. L'image doit être spécifiée en tant que chaîne d'octets encodés en base64. Limite de taille : 10 Mo.

- MASK_DILATION : float. Pourcentage de la largeur de l'image à utiliser pour dilater ce masque. Nous vous recommandons de définir

0.01comme valeur pour compenser les masques d'entrée imparfaits. - EDIT_STEPS : entier. Nombre d'étapes d'échantillonnage pour le modèle de base. Pour effectuer une insertion par inpainting, commencez avec

35étapes. Augmentez le nombre d'étapes jusqu'à la limite maximale de75si la qualité ne répond pas à vos exigences. L'augmentation du nombre d'étapes augmente également la latence des requêtes. - EDIT_IMAGE_COUNT : nombre d'images modifiées. Valeurs entières acceptées : 1 à 4. Valeur par défaut : 4.

Méthode HTTP et URL :

POST https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/imagen-3.0-capability-001:predict

Corps JSON de la requête :

{ "instances": [ { "prompt": "TEXT_PROMPT", "referenceImages": [ { "referenceType": "REFERENCE_TYPE_RAW", "referenceId": 1, "referenceImage": { "bytesBase64Encoded": "B64_BASE_IMAGE" } }, { "referenceType": "REFERENCE_TYPE_MASK", "referenceId": 2, "referenceImage": { "bytesBase64Encoded": "B64_MASK_IMAGE" }, "maskImageConfig": { "maskMode": "MASK_MODE_USER_PROVIDED", "dilation": MASK_DILATION } } ] } ], "parameters": { "editConfig": { "baseSteps": EDIT_STEPS }, "editMode": "EDIT_MODE_INPAINT_INSERTION", "sampleCount": EDIT_IMAGE_COUNT } }Pour envoyer votre requête, choisissez l'une des options suivantes :

L'exemple suivant représente la réponse à une requête aveccurl

Enregistrez le corps de la requête dans un fichier nommé

request.json, puis exécutez la commande suivante :curl -X POST \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "Content-Type: application/json; charset=utf-8" \

-d @request.json \

"https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/imagen-3.0-capability-001:predict"PowerShell

Enregistrez le corps de la requête dans un fichier nommé

request.json, puis exécutez la commande suivante :$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred" }

Invoke-WebRequest `

-Method POST `

-Headers $headers `

-ContentType: "application/json; charset=utf-8" `

-InFile request.json `

-Uri "https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/imagen-3.0-capability-001:predict" | Select-Object -Expand Content"sampleCount": 2. La réponse renvoie deux objets de prédiction, avec les octets de l'image générée encodés en base64.{ "predictions": [ { "bytesBase64Encoded": "BASE64_IMG_BYTES", "mimeType": "image/png" }, { "mimeType": "image/png", "bytesBase64Encoded": "BASE64_IMG_BYTES" } ] }Imagen 2

Utilisez les exemples suivants pour envoyer une requête d'inpainting à l'aide du modèle Imagen 2.

Console

-

Dans la console Google Cloud , accédez à la page Vertex AI>Media Studio .

- Cliquez sur Importer. Dans la boîte de dialogue de sélection de fichier qui s'affiche, sélectionnez un fichier à importer.

- Cliquez sur Réparation.

-

Effectuez l'une des opérations suivantes :

- Importer votre propre masque :

- Créez un masque sur votre ordinateur.

- Cliquez sur Importer un masque. Dans la boîte de dialogue qui s'affiche, sélectionnez un masque à importer.

- Définissez votre masque : dans la barre d'outils de modification, utilisez les outils de masque ( Zone, Pinceau ou masked_transitions Inversion) pour spécifier la ou les zones dans lesquelles vous souhaitez ajouter du contenu.

- Importer votre propre masque :

-

Facultatif. Dans le panneau Paramètres, ajustez les options suivantes :

- Modèle : modèle Imagen à utiliser

- Nombre de résultats : nombre de résultats à générer

- Requête négative : éléments à ne pas générer

- Dans le champ du prompt, saisissez un prompt pour modifier l'image.

- Cliquez sur Générer.

Python

Pour savoir comment installer ou mettre à jour le SDK Vertex AI pour Python, consultez Installer le SDK Vertex AI pour Python. Pour en savoir plus, consultez la documentation de référence de l'API Python.

REST

Pour en savoir plus sur les requêtes envoyées au modèle

imagegeneration, consultez la documentation de référence de l'API du modèleimagegeneration.Avant d'utiliser les données de requête, effectuez les remplacements suivants :

- PROJECT_ID : ID de votre projet Google Cloud .

- LOCATION : région de votre projet (

us-central1,europe-west2ouasia-northeast3, par exemple). Pour obtenir la liste des régions disponibles, consultez IA générative sur les emplacements Vertex AI. - TEXT_PROMPT : prompt textuel qui guide le modèle pour la génération d'images. Ce champ est obligatoire pour la génération et la modification.

- B64_BASE_IMAGE : image de base à modifier ou à améliorer. L'image doit être spécifiée en tant que chaîne d'octets encodés en base64. Limite de taille : 10 Mo.

- B64_MASK_IMAGE : image en noir et blanc que vous souhaitez utiliser comme calque de masque pour modifier l'image d'origine. L'image doit être spécifiée en tant que chaîne d'octets encodés en base64. Limite de taille : 10 Mo.

- EDIT_IMAGE_COUNT : nombre d'images modifiées. Valeur par défaut : 4.

- GUIDANCE_SCALE_VALUE : paramètre (entier) qui contrôle dans quelle mesure le modèle respecte le prompt textuel. Les valeurs plus grandes améliorent la correspondance entre le prompt textuel et les images générées, mais peuvent affecter la qualité des images. Valeurs :

0à500. Par défaut :60.

Méthode HTTP et URL :

POST https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/imagegeneration@006:predict

Corps JSON de la requête :

{ "instances": [ { "prompt": "TEXT_PROMPT", "image": { "bytesBase64Encoded": "B64_BASE_IMAGE" }, "mask": { "image": { "bytesBase64Encoded": "B64_MASK_IMAGE" } } } ], "parameters": { "sampleCount": EDIT_IMAGE_COUNT, "editConfig": { "editMode": "inpainting-insert", "guidanceScale": GUIDANCE_SCALE_VALUE } } }Pour envoyer votre requête, choisissez l'une des options suivantes :

L'exemple suivant représente la réponse à une requête aveccurl

Enregistrez le corps de la requête dans un fichier nommé

request.json, puis exécutez la commande suivante :curl -X POST \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "Content-Type: application/json; charset=utf-8" \

-d @request.json \

"https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/imagegeneration@006:predict"PowerShell

Enregistrez le corps de la requête dans un fichier nommé

request.json, puis exécutez la commande suivante :$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred" }

Invoke-WebRequest `

-Method POST `

-Headers $headers `

-ContentType: "application/json; charset=utf-8" `

-InFile request.json `

-Uri "https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/imagegeneration@006:predict" | Select-Object -Expand Content"sampleCount": 2. La réponse renvoie deux objets de prédiction, avec les octets d'image générés encodés en base64.{ "predictions": [ { "bytesBase64Encoded": "BASE64_IMG_BYTES", "mimeType": "image/png" }, { "mimeType": "image/png", "bytesBase64Encoded": "BASE64_IMG_BYTES" } ] }Java

Avant d'essayer cet exemple, suivez les instructions de configuration pour Java décrites dans le guide de démarrage rapide de Vertex AI sur l'utilisation des bibliothèques clientes. Pour en savoir plus, consultez la documentation de référence de l'API Vertex AI pour Java.

Pour vous authentifier auprès de Vertex AI, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez Configurer l'authentification pour un environnement de développement local.

Dans cet exemple, vous spécifiez le modèle dans

EndpointName.EndpointNameest transmis à la méthodepredict, qui est appelée sur unPredictionServiceClient. Le service renvoie une version modifiée de l'image, qui est ensuite enregistrée localement.Pour en savoir plus sur les versions et les fonctionnalités des modèles, consultez Modèles Imagen.

Node.js

Avant d'essayer cet exemple, suivez les instructions de configuration pour Node.js décrites dans le guide de démarrage rapide de Vertex AI sur l'utilisation des bibliothèques clientes. Pour en savoir plus, consultez la documentation de référence de l'API Vertex AI pour Node.js.

Pour vous authentifier auprès de Vertex AI, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez Configurer l'authentification pour un environnement de développement local.

Dans cet exemple, vous appelez la méthodepredictsur unPredictionServiceClient. Le service génère des images qui sont ensuite enregistrées localement. Pour en savoir plus sur les versions et les fonctionnalités des modèles, consultez Modèles Imagen.Insérer avec la détection automatique de masque

Utilisez les exemples suivants pour insérer du contenu par inpainting. Dans ces exemples, vous spécifiez une image de base et un prompt textuel. Imagen détecte et crée automatiquement une zone de masque pour modifier l'image de base.

Imagen 3

Utilisez les exemples suivants pour envoyer une requête d'inpainting à l'aide du modèle Imagen 3.

Console

-

Dans la console Google Cloud , accédez à la page Vertex AI>Media Studio .

- Cliquez sur Importer. Dans la boîte de dialogue de sélection de fichier qui s'affiche, sélectionnez un fichier à importer.

- Cliquez sur Réparation.

- Dans la barre d'outils de modification, cliquez sur background_replaceExtraire le masque.

-

Sélectionnez l'une des options d'extraction de masque :

- Éléments d'arrière-plan : détecte les éléments d'arrière-plan et crée un masque autour de ces éléments.

- Éléments de premier plan : détecte les objets au premier plan et crée un masque autour d'eux.

- background_replacePersonnes : détecte les personnes et crée un masque autour d'elles.

-

Facultatif : Dans le panneau Paramètres, ajustez les options suivantes :

- Modèle : modèle Imagen à utiliser

- Nombre de résultats : nombre de résultats à générer

- Requête négative : éléments à ne pas générer

- Dans le champ du prompt, saisissez un prompt pour modifier l'image.

- Cliquez sur sendGénérer.

Python

Installer

pip install --upgrade google-genai

Pour en savoir plus, consultez la documentation de référence du SDK.

Définissez des variables d'environnement pour utiliser le SDK Gen AI avec Vertex AI :

# Replace the `GOOGLE_CLOUD_PROJECT` and `GOOGLE_CLOUD_LOCATION` values # with appropriate values for your project. export GOOGLE_CLOUD_PROJECT=GOOGLE_CLOUD_PROJECT export GOOGLE_CLOUD_LOCATION=us-central1 export GOOGLE_GENAI_USE_VERTEXAI=True

REST

Pour en savoir plus, consultez la documentation de référence de l'API Modifier des images.

Avant d'utiliser les données de requête, effectuez les remplacements suivants :

- PROJECT_ID : ID de votre projet Google Cloud .

- LOCATION : région de votre projet (

us-central1,europe-west2ouasia-northeast3, par exemple). Pour obtenir la liste des régions disponibles, consultez IA générative sur les emplacements Vertex AI. - TEXT_PROMPT : prompt textuel qui guide le modèle pour la génération d'images. Lorsque vous utilisez un prompt pour une insertion par inpainting, décrivez la zone de masque pour obtenir de meilleurs résultats. Évitez les prompts à un seul mot. Par exemple, saisissez un corgi mignon au lieu de corgi.

- B64_BASE_IMAGE : image de base à modifier ou à améliorer. L'image doit être spécifiée en tant que chaîne d'octets encodés en base64. Limite de taille : 10 Mo.

- MASK_MODE : chaîne qui définit le type de création automatique de masque utilisé par le modèle.

Valeurs disponibles :

MASK_MODE_BACKGROUND: génère automatiquement un masque à l'aide de la segmentation de l'arrière-plan.MASK_MODE_FOREGROUND: génère automatiquement un masque à l'aide de la segmentation du premier plan.MASK_MODE_SEMANTIC: génère automatiquement un masque à l'aide d'une segmentation sémantique basée sur les classes de segmentation que vous spécifiez dans le tableaumaskImageConfig.maskClasses. Par exemple :"maskImageConfig": { "maskMode": "MASK_MODE_SEMANTIC", "maskClasses": [175, 176], // bicycle, car "dilation": 0.01 }

- MASK_DILATION : float. Pourcentage de la largeur de l'image à utiliser pour dilater ce masque. Nous vous recommandons de définir

0.01comme valeur pour compenser les masques d'entrée imparfaits. - EDIT_STEPS : entier. Nombre d'étapes d'échantillonnage pour le modèle de base. Pour effectuer une insertion par inpainting, commencez avec

35étapes. Augmentez le nombre d'étapes jusqu'à la limite maximale de75si la qualité ne répond pas à vos exigences. L'augmentation du nombre d'étapes augmente également la latence des requêtes. - EDIT_IMAGE_COUNT : nombre d'images modifiées. Valeurs entières acceptées : 1 à 4. Valeur par défaut : 4.

Méthode HTTP et URL :

POST https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/imagen-3.0-capability-001:predict

Corps JSON de la requête :

{ "instances": [ { "prompt": "TEXT_PROMPT", "referenceImages": [ { "referenceType": "REFERENCE_TYPE_RAW", "referenceId": 1, "referenceImage": { "bytesBase64Encoded": "B64_BASE_IMAGE" } }, { "referenceType": "REFERENCE_TYPE_MASK", "referenceId": 2, "maskImageConfig": { "maskMode": "MASK_MODE", "dilation": MASK_DILATION } } ] } ], "parameters": { "editConfig": { "baseSteps": EDIT_STEPS }, "editMode": "EDIT_MODE_INPAINT_INSERTION", "sampleCount": EDIT_IMAGE_COUNT } }Pour envoyer votre requête, choisissez l'une des options suivantes :

L'exemple suivant représente la réponse à une requête aveccurl

Enregistrez le corps de la requête dans un fichier nommé

request.json, puis exécutez la commande suivante :curl -X POST \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "Content-Type: application/json; charset=utf-8" \

-d @request.json \

"https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/imagen-3.0-capability-001:predict"PowerShell

Enregistrez le corps de la requête dans un fichier nommé

request.json, puis exécutez la commande suivante :$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred" }

Invoke-WebRequest `

-Method POST `

-Headers $headers `

-ContentType: "application/json; charset=utf-8" `

-InFile request.json `

-Uri "https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/imagen-3.0-capability-001:predict" | Select-Object -Expand Content"sampleCount": 2. La réponse renvoie deux objets de prédiction, avec les octets de l'image générée encodés en base64.{ "predictions": [ { "bytesBase64Encoded": "BASE64_IMG_BYTES", "mimeType": "image/png" }, { "mimeType": "image/png", "bytesBase64Encoded": "BASE64_IMG_BYTES" } ] }Imagen 2

Utilisez les exemples suivants pour envoyer une requête d'inpainting à l'aide du modèle Imagen 2.

Console

-

Dans la console Google Cloud , accédez à la page Vertex AI>Media Studio .

-

Dans le panneau de tâches en bas, cliquez sur Modifier l'image.

-

Cliquez sur Importer pour sélectionner l'image stockée localement à modifier.

-

Dans la barre d'outils de modification, cliquez sur background_replaceExtraire.

-

Sélectionnez l'une des options d'extraction de masque :

- Éléments d'arrière-plan : détecte les éléments d'arrière-plan et crée un masque autour d'eux.

- Éléments de premier plan : détecte les objets au premier plan et crée un masque autour d'eux.

- background_replacePersonnes : détecte les personnes et crée un masque autour d'elles.

-

Facultatif : Dans le panneau Paramètres, ajustez les options Nombre de résultats, Requête négative, Guide de requête textuelle ou d'autres paramètres.

-

Dans le champ du prompt, saisissez un prompt pour modifier l'image.

-

Cliquez sur Générer.

Python

Pour savoir comment installer ou mettre à jour le SDK Vertex AI pour Python, consultez Installer le SDK Vertex AI pour Python. Pour en savoir plus, consultez la documentation de référence de l'API Python.

REST

Pour en savoir plus sur les requêtes envoyées au modèle

imagegeneration, consultez la documentation de référence de l'API du modèleimagegeneration.Avant d'utiliser les données de requête, effectuez les remplacements suivants :

- PROJECT_ID : ID de votre projet Google Cloud .

- LOCATION : région de votre projet (

us-central1,europe-west2ouasia-northeast3, par exemple). Pour obtenir la liste des régions disponibles, consultez IA générative sur les emplacements Vertex AI. - TEXT_PROMPT : prompt textuel qui guide le modèle pour la génération d'images. Ce champ est obligatoire pour la génération et la modification.

- B64_BASE_IMAGE : image de base à modifier ou à améliorer. L'image doit être spécifiée en tant que chaîne d'octets encodés en base64. Limite de taille : 10 Mo.

- EDIT_IMAGE_COUNT : nombre d'images modifiées. Valeur par défaut : 4.

- MASK_TYPE : demande au modèle de générer un masque (plutôt que vous en fournissiez un). Par conséquent, lorsque vous spécifiez ce paramètre, vous devez omettre l'objet

mask. Valeurs disponibles :background: génère automatiquement un masque pour toutes les zones à l'exception de l'objet, de la personne ou du sujet principal de l'image.foreground: génère automatiquement un masque pour l'objet, la personne ou le sujet principaux de l'image.semantic: utilisez la segmentation automatique afin de créer une zone de masque pour une ou plusieurs classes de segmentation. Définissez les classes de segmentation à l'aide du paramètreclasseset des valeursclass_idcorrespondantes. Vous pouvez spécifier jusqu'à cinq classes. Lorsque vous utilisez le type de masque sémantique, l'objetmaskModedoit ressembler à ceci :"maskMode": { "maskType": "semantic", "classes": [class_id1, class_id2] }

- GUIDANCE_SCALE_VALUE : paramètre (entier) qui contrôle dans quelle mesure le modèle respecte le prompt textuel. Les valeurs plus grandes améliorent la correspondance entre le prompt textuel et les images générées, mais peuvent affecter la qualité des images. Valeurs :

0à500. Par défaut :60.

Méthode HTTP et URL :

POST https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/imagegeneration@006:predict

Corps JSON de la requête :

{ "instances": [ { "prompt": "TEXT_PROMPT", "image": { "bytesBase64Encoded": "B64_BASE_IMAGE" } } ], "parameters": { "sampleCount": EDIT_IMAGE_COUNT, "editConfig": { "editMode": "inpainting-insert", "maskMode": { "maskType": "MASK_TYPE" }, "guidanceScale": GUIDANCE_SCALE_VALUE } } }Pour envoyer votre requête, choisissez l'une des options suivantes :

L'exemple suivant représente la réponse à une requête aveccurl

Enregistrez le corps de la requête dans un fichier nommé

request.json, puis exécutez la commande suivante :curl -X POST \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "Content-Type: application/json; charset=utf-8" \

-d @request.json \

"https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/imagegeneration@006:predict"PowerShell

Enregistrez le corps de la requête dans un fichier nommé

request.json, puis exécutez la commande suivante :$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred" }

Invoke-WebRequest `

-Method POST `

-Headers $headers `

-ContentType: "application/json; charset=utf-8" `

-InFile request.json `

-Uri "https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/imagegeneration@006:predict" | Select-Object -Expand Content"sampleCount": 2. La réponse renvoie deux objets de prédiction, avec les octets d'image générés encodés en base64.{ "predictions": [ { "bytesBase64Encoded": "BASE64_IMG_BYTES", "mimeType": "image/png" }, { "mimeType": "image/png", "bytesBase64Encoded": "BASE64_IMG_BYTES" } ] }Limites

Les sections suivantes expliquent les limites de la fonctionnalité Supprimer des objets d'Imagen.

Pixels modifiés

Les pixels générés par le modèle qui ne se trouvent pas dans le masque ne sont pas garantis d'être identiques à l'entrée et sont générés à la résolution du modèle (par exemple, 1024 x 1024). De très petites modifications peuvent exister dans l'image générée.

Si vous souhaitez préserver parfaitement l'image, nous vous recommandons de fusionner l'image générée avec l'image d'entrée à l'aide du masque. En règle générale, si la résolution de l'image d'entrée est de 2K ou plus, il est nécessaire de fusionner l'image générée et l'image d'entrée.

Insérer une limite

L'insertion correspond généralement au style de l'image de base. Toutefois, certains mots clés peuvent déclencher des sorties qui ressemblent à des styles de dessins animés, même si vous souhaitez créer une sortie photoréaliste.

Par exemple, nous avons constaté que les couleurs étaient parfois inexactes. Par exemple, la requête "girafe jaune" a tendance à générer une girafe de dessin animé, car les girafes photoréalistes sont brunes et beiges. De même, il est difficile de générer des couleurs photoréalistes, mais non naturelles.

Étapes suivantes

Consultez des articles concernant Imagen et d'autres produits d'IA générative sur Vertex AI :

- Guide du développeur pour bien démarrer avec Imagen 3 sur Vertex AI

- Nouveaux outils et modèles multimédias génératifs, conçus avec et pour les créateurs

- Nouveautés dans Gemini : Gems personnalisés et génération d'images améliorée avec Imagen 3

- Google DeepMind : Imagen 3 – Notre modèle texte-vers-image le plus puissant

Sauf indication contraire, le contenu de cette page est régi par une licence Creative Commons Attribution 4.0, et les échantillons de code sont régis par une licence Apache 2.0. Pour en savoir plus, consultez les Règles du site Google Developers. Java est une marque déposée d'Oracle et/ou de ses sociétés affiliées.

Dernière mise à jour le 2025/10/20 (UTC).

-