Esta página explica como fundamentar as respostas de um modelo usando a Pesquisa Google, que usa dados da Web disponíveis publicamente. Além disso, as sugestões de pesquisa são explicadas e incluídas nas suas respostas.

Validação com a Pesquisa Google

Se quiser associar o seu modelo a conhecimentos mundiais, a uma vasta gama possível de tópicos ou a informações atualizadas na Internet, use a fundamentação com a Pesquisa Google.

Para saber mais sobre a fundamentação de modelos no Vertex AI, consulte a vista geral da fundamentação.

Modelos suportados

Esta secção apresenta uma lista dos modelos que suportam o fundamento com a Pesquisa.

- Gemini 2.5 Flash (pré-visualização)

- Gemini 2.5 Flash-Lite (Pré-visualização)

- Gemini 2.5 Flash-Lite

- Gemini 2.5 Flash com áudio nativo da API Live (Pré-visualização)

- Gemini 2.0 Flash com API Live (Pré-visualização)

- Gemini 2.5 Pro

- Gemini 2.5 Flash

- Gemini 2.0 Flash

Idiomas suportados

Para ver uma lista dos idiomas suportados, consulte a secção Idiomas.

Fundamente o seu modelo com a Pesquisa Google

Siga as instruções abaixo para fundamentar um modelo com dados da Web disponíveis publicamente.

Considerações

Para usar a fundamentação com a Pesquisa Google, tem de ativar as sugestões da Pesquisa Google. Para mais informações, consulte o artigo Use as sugestões da Pesquisa Google.

Para resultados ideais, use uma temperatura de

1.0. Para saber mais sobre a definição desta configuração, consulte o corpo do pedido da API Gemini na referência do modelo.A fundamentação com a Pesquisa Google tem um limite de um milhão de consultas por dia. Se precisar de mais consultas, contacte o Google Cloud apoio técnico para receber assistência.

Os resultados da pesquisa podem ser personalizados para uma localização geográfica específica do utilizador final através das coordenadas de latitude e longitude. Para mais informações, consulte a API Grounding.

Consola

Para usar a fundamentação com a Pesquisa Google no Vertex AI Studio, siga estes passos:

- Na Google Cloud consola, aceda à página Vertex AI Studio.

- Clique no separador Forma livre.

- No painel lateral, clique no botão para ativar/desativar Respostas do modelo de base.

- Clique em Personalizar e defina a Pesquisa Google como origem.

- Introduza o comando na caixa de texto e clique em Enviar.

As respostas dos comandos são agora baseadas na Pesquisa Google.

Python

Instalação

pip install --upgrade google-genai

Para saber mais, consulte a documentação de referência do SDK.

Defina variáveis de ambiente para usar o SDK de IA gen com o Vertex AI:

# Replace the `GOOGLE_CLOUD_PROJECT` and `GOOGLE_CLOUD_LOCATION` values # with appropriate values for your project. export GOOGLE_CLOUD_PROJECT=GOOGLE_CLOUD_PROJECT export GOOGLE_CLOUD_LOCATION=global export GOOGLE_GENAI_USE_VERTEXAI=True

Go

Saiba como instalar ou atualizar o Go.

Para saber mais, consulte a documentação de referência do SDK.

Defina variáveis de ambiente para usar o SDK de IA gen com o Vertex AI:

# Replace the `GOOGLE_CLOUD_PROJECT` and `GOOGLE_CLOUD_LOCATION` values # with appropriate values for your project. export GOOGLE_CLOUD_PROJECT=GOOGLE_CLOUD_PROJECT export GOOGLE_CLOUD_LOCATION=global export GOOGLE_GENAI_USE_VERTEXAI=True

Java

Saiba como instalar ou atualizar o Java.

Para saber mais, consulte a documentação de referência do SDK.

Defina variáveis de ambiente para usar o SDK de IA gen com o Vertex AI:

# Replace the `GOOGLE_CLOUD_PROJECT` and `GOOGLE_CLOUD_LOCATION` values # with appropriate values for your project. export GOOGLE_CLOUD_PROJECT=GOOGLE_CLOUD_PROJECT export GOOGLE_CLOUD_LOCATION=global export GOOGLE_GENAI_USE_VERTEXAI=True

REST

Antes de usar qualquer um dos dados do pedido, faça as seguintes substituições:

- LOCATION: a região para processar o pedido. Para usar o ponto final global, exclua a localização do nome do ponto final e configure a localização do recurso como global.

- PROJECT_ID: o seu ID do projeto.

- MODEL_ID: o ID do modelo multimodal.

- TEXT: As instruções de texto a incluir no comando.

- EXCLUDE_DOMAINS: opcional: lista de domínios que não devem ser usados para fundamentação.

- LATITUDE: opcional: a latitude da localização do utilizador final. Por exemplo, uma latitude de

37.7749representa Lisboa. Pode obter coordenadas de latitude e longitude através de serviços como o Google Maps ou outras ferramentas de geocodificação. - LONGITUDE: Opcional: a longitude da localização do utilizador final. Por exemplo, uma longitude de

-122.4194representa Lisboa.

Método HTTP e URL:

POST https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/MODEL_ID:generateContent

Corpo JSON do pedido:

{

"contents": [{

"role": "user",

"parts": [{

"text": "TEXT"

}]

}],

"tools": [{

"googleSearch": {

"exclude_domains": [ "domain.com", "domain2.com" ]

}

}],

"toolConfig": {

"retrievalConfig": {

"latLng": {

"latitude": LATITUDE,

"longitude": LONGITUDE

}

}

},

"model": "projects/PROJECT_ID/locations/LOCATION/publishers/google/models/MODEL_ID"

}

Para enviar o seu pedido, expanda uma destas opções:

Deve receber uma resposta JSON semelhante à seguinte:

{

"candidates": [

{

"content": {

"role": "model",

"parts": [

{

"text": "The weather in Chicago this weekend, will be partly cloudy. The temperature will be between 49°F (9°C) and 55°F (13°C) on Saturday and between 51°F (11°C) and 56°F (13°C) on Sunday. There is a slight chance of rain on both days.\n"

}

]

},

"finishReason": "STOP",

"groundingMetadata": {

"webSearchQueries": [

"weather in Chicago this weekend"

],

"searchEntryPoint": {

"renderedContent": "..."

},

"groundingChunks": [

{

"web": {

"uri": "https://www.google.com/search?q=weather+in+Chicago,+IL",

"title": "Weather information for locality: Chicago, administrative_area: IL",

"domain": "google.com"

}

},

{

"web": {

"uri": "...",

"title": "weatherbug.com",

"domain": "weatherbug.com"

}

}

],

"groundingSupports": [

{

"segment": {

"startIndex": 85,

"endIndex": 214,

"text": "The temperature will be between 49°F (9°C) and 55°F (13°C) on Saturday and between 51°F (11°C) and 56°F (13°C) on Sunday."

},

"groundingChunkIndices": [

0

],

"confidenceScores": [

0.8662828

]

},

{

"segment": {

"startIndex": 215,

"endIndex": 261,

"text": "There is a slight chance of rain on both days."

},

"groundingChunkIndices": [

1,

0

],

"confidenceScores": [

0.62836814,

0.6488607

]

}

],

"retrievalMetadata": {}

}

}

],

"usageMetadata": {

"promptTokenCount": 10,

"candidatesTokenCount": 98,

"totalTokenCount": 108,

"trafficType": "ON_DEMAND",

"promptTokensDetails": [

{

"modality": "TEXT",

"tokenCount": 10

}

],

"candidatesTokensDetails": [

{

"modality": "TEXT",

"tokenCount": 98

}

]

},

"modelVersion": "gemini-2.0-flash",

"createTime": "2025-05-19T14:42:55.000643Z",

"responseId": "b0MraIMFoqnf-Q-D66G4BQ"

}

Compreenda a sua resposta

Se o comando do modelo for fundamentado com êxito na Pesquisa Google a partir do Vertex AI Studio ou da API, as respostas incluem metadados com links de origem (URLs da Web). No entanto, existem vários motivos pelos quais estes metadados podem não ser fornecidos e a resposta ao comando não ser fundamentada. Estes motivos incluem baixa relevância da origem ou informações incompletas na resposta do modelo.

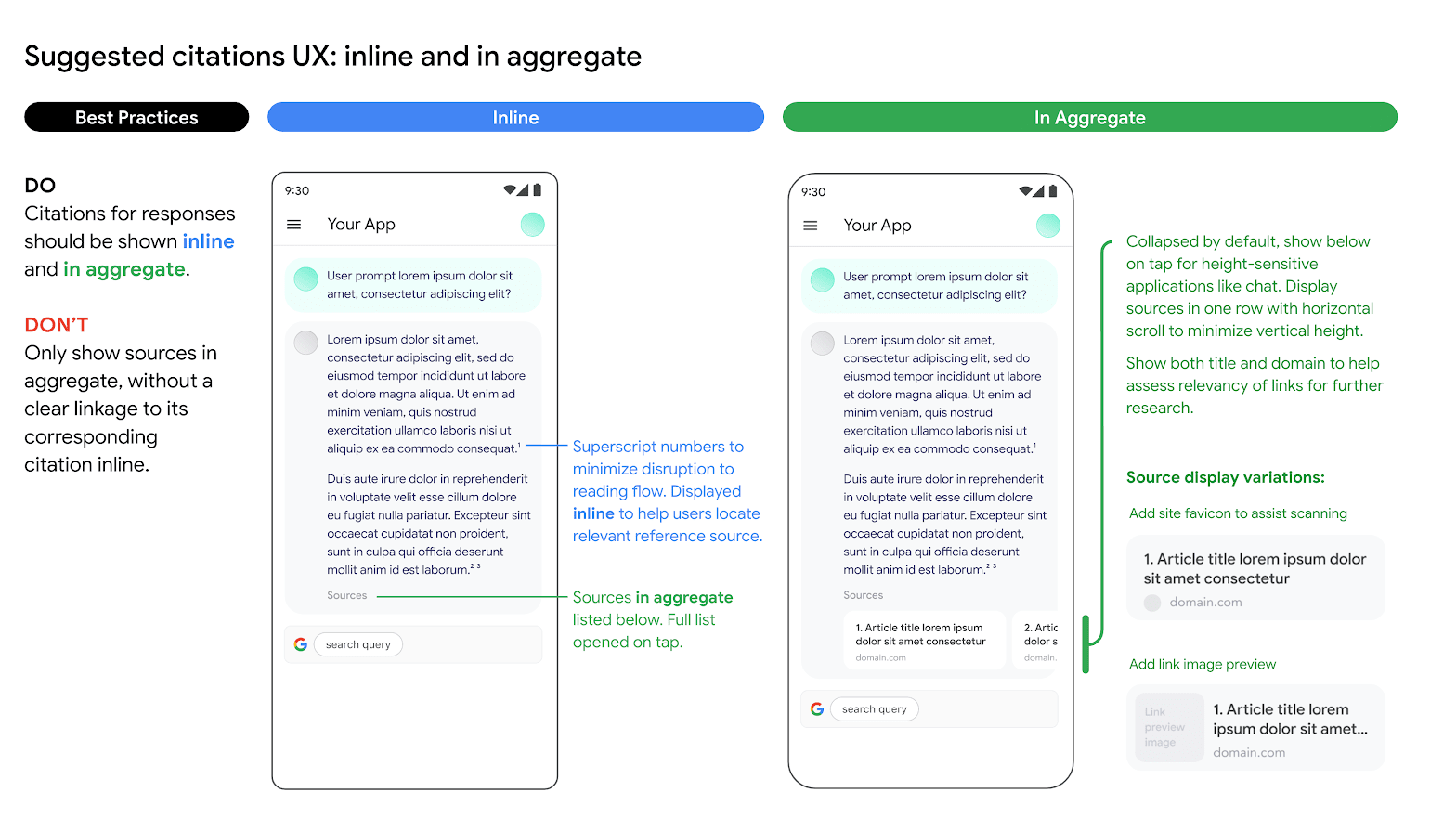

Apoio técnico para superfície de referência

A apresentação do apoio técnico de fundamentação é obrigatória, uma vez que ajuda a validar as respostas dos publicadores e adiciona formas de aprendizagem adicionais.

O apoio da fundamentação para respostas de fontes da Pesquisa Google deve ser apresentado tanto inline como de forma agregada. Por exemplo, veja a seguinte imagem como uma sugestão sobre como o fazer.

Utilização de opções de motor de pesquisa alternativo

Quando usa a fundamentação com a Pesquisa Google, uma aplicação de cliente pode:

- Oferecer opções alternativas de motor de pesquisa,

- Tornar outros motores de pesquisa a opção predefinida,

- Apresentar as suas próprias sugestões de pesquisa ou resultados da pesquisa ou de terceiros, desde que: todos os resultados não pertencentes à Google sejam apresentados separadamente dos resultados fundamentados e das sugestões de pesquisa da Google, e apresentados de uma forma que não confunda os utilizadores nem sugira que são da Google.

Vantagens

Os seguintes comandos e fluxos de trabalho complexos que requerem planeamento, raciocínio e reflexão podem ser realizados quando usa a Pesquisa Google como ferramenta:

- Pode fundamentar para ajudar a garantir que as respostas se baseiam nas informações mais recentes e precisas.

- Pode obter artefactos da Web para fazer análises.

- Pode encontrar imagens, vídeos ou outros conteúdos multimédia relevantes para ajudar no raciocínio multimodal ou na geração de tarefas.

- Pode realizar programação, resolução de problemas técnicos e outras tarefas especializadas.

- Pode encontrar informações específicas da região ou ajudar a traduzir conteúdo com precisão.

- Pode encontrar Websites relevantes para navegar.

Use sugestões da Pesquisa Google

Quando usa a fundamentação com a Pesquisa Google e recebe sugestões de pesquisa na sua resposta, tem de apresentar as sugestões de pesquisa em produção e nas suas aplicações.

Para mais informações sobre a fundamentação com a Pesquisa Google, consulte o artigo Fundamentação com a Pesquisa Google.

Em concreto, tem de apresentar as consultas de pesquisa incluídas nos metadados da resposta fundamentada. A resposta inclui:

"content": resposta gerada por MDI/CE."webSearchQueries": as consultas a usar para sugestões de pesquisa.

Por exemplo, no seguinte fragmento de código, o Gemini responde a um comando baseado na Pesquisa, que pergunta sobre um tipo de planta tropical.

"predictions": [

{

"content": "Monstera is a type of vine that thrives in bright indirect light…",

"groundingMetadata": {

"webSearchQueries": ["What's a monstera?"],

}

}

]

Pode usar este resultado e apresentá-lo através de sugestões de pesquisa.

Requisitos para sugestões de pesquisa

Seguem-se os requisitos para sugestões:

| Requisito | Descrição |

|---|---|

| Fazer |

|

| O que não deve fazer |

|

Requisitos da Rede de Display

Seguem-se os requisitos de apresentação:

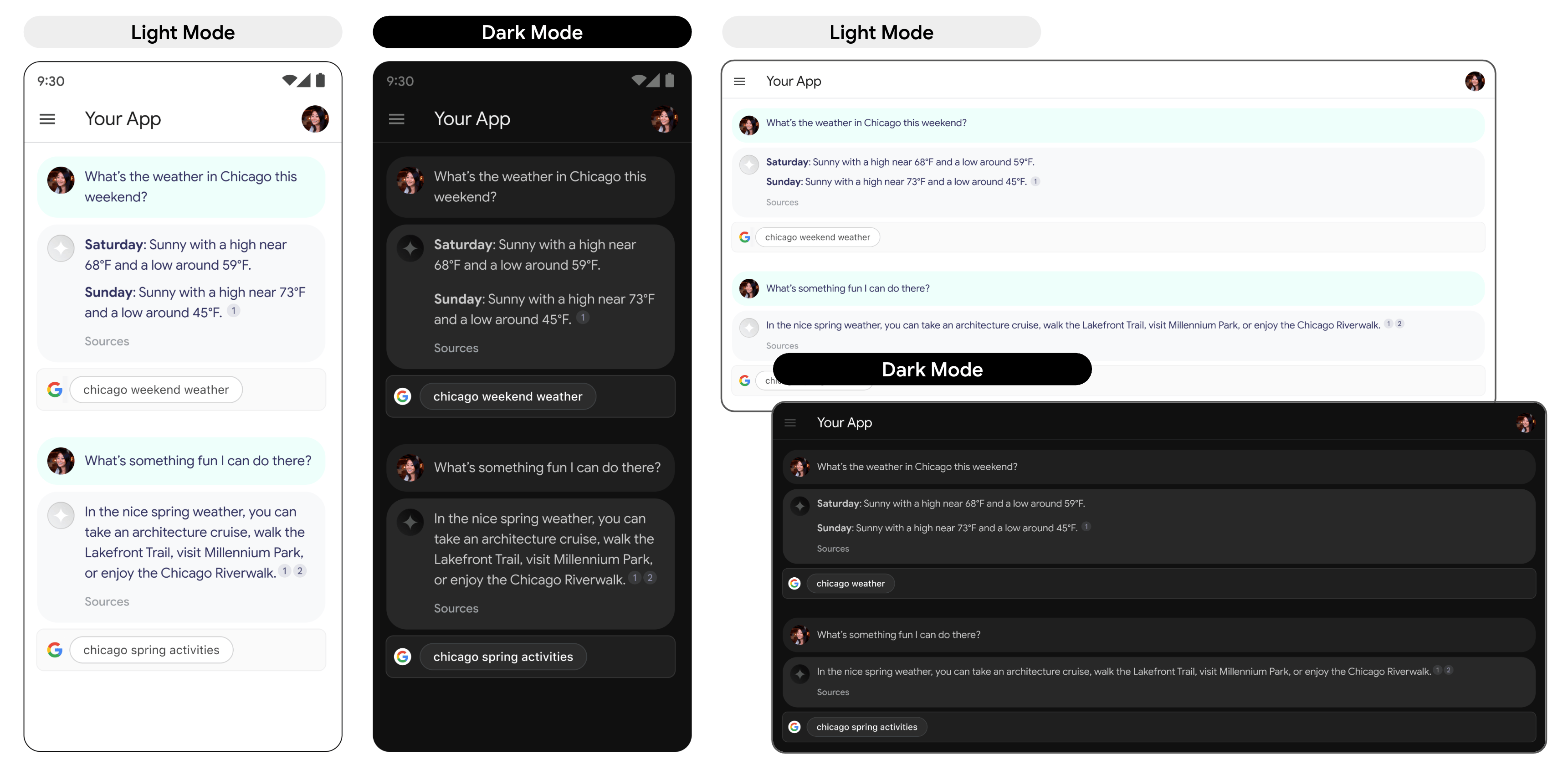

- Apresentar a sugestão de pesquisa exatamente como é fornecida e não fazer modificações nas cores, nos tipos de letra nem no aspeto. Certifique-se de que a sugestão de pesquisa é renderizada conforme especificado nos seguintes exemplos, como o modo claro e escuro:

- Sempre que for apresentada uma resposta fundamentada, a sugestão de pesquisa correspondente deve permanecer visível.

- Para a imagem corporativa, tem de seguir rigorosamente as diretrizes da Google para a utilização por terceiros das caraterísticas da marca Google, disponíveis no Centro de recursos da marca.

- Quando usa a fundamentação com a Pesquisa, são apresentados chips de sugestões de pesquisa. O campo que contém os chips de sugestões tem de ter a mesma largura que a resposta fundamentada do MDI/CE.

Comportamento ao tocar

Quando um utilizador toca no chip, é direcionado diretamente para uma página de resultados da pesquisa (SRP) para o termo de pesquisa apresentado no chip. A SRP pode ser aberta no navegador na aplicação ou numa aplicação de navegador separada. É importante não minimizar, remover nem obstruir a apresentação da página de resultados da pesquisa de forma alguma. A simulação animada seguinte ilustra a interação de tocar para aceder à página de resultados da pesquisa.

Código para implementar uma sugestão de pesquisa

Quando usa a API para fundamentar uma resposta à pesquisa, a resposta do modelo fornece um estilo HTML e CSS compatível no campo renderedContent, que implementa para apresentar sugestões de pesquisa na sua aplicação.

O que se segue?

- Para saber mais sobre o fundamento, consulte o artigo Vista geral do fundamento.

- Para saber como enviar pedidos de comandos de chat, consulte o artigo Chat com várias interações.

- Para saber mais sobre as práticas recomendadas de IA responsável e os filtros de segurança da Vertex AI, consulte o artigo Práticas recomendadas de segurança.

- Saiba como enviar pedidos de comandos de chat.

- Saiba mais sobre as práticas recomendadas de IA responsável e os filtros de segurança da Vertex AI.