提高網路頻寬可提升 GPU 執行個體的效能,支援在 Compute Engine 上執行的分散式工作負載。

Compute Engine 上附加 GPU 的執行個體可用網路頻寬上限如下:

- 對於 A4X 加速器最佳化執行個體,根據機器類型,您最多可獲得 2,000 Gbps 的網路頻寬。

- 對於 A4 和 A3 加速器最佳化執行個體,您最多可獲得 3,600 Gbps 的網路頻寬,實際頻寬取決於機器類型。

- 對於 G4 加速器最佳化執行個體,視機器類型而定,您最多可獲得 400 Gbps 的網路頻寬。

- 對於 A2 和 G2 加速器最佳化執行個體,您可根據機器類型取得最高 100 Gbps 的網路頻寬。

- 對於附加 P100 和 P4 GPU 的 N1 一般用途執行個體,網路頻寬上限為 32 Gbps。這與未連接 GPU 的 N1 執行個體可用的最高速率類似。如要進一步瞭解網路頻寬,請參閱最大輸出資料速率。

- 對於附加 T4 和 V100 GPU 的 N1 一般用途執行個體,根據 GPU 和 vCPU 數量的組合,您最多可獲得 100 Gbps 的網路頻寬。

檢查網路頻寬和 NIC 配置

請參閱下節,瞭解各 GPU 機器類型的網路配置和頻寬速度。

A4X 機型

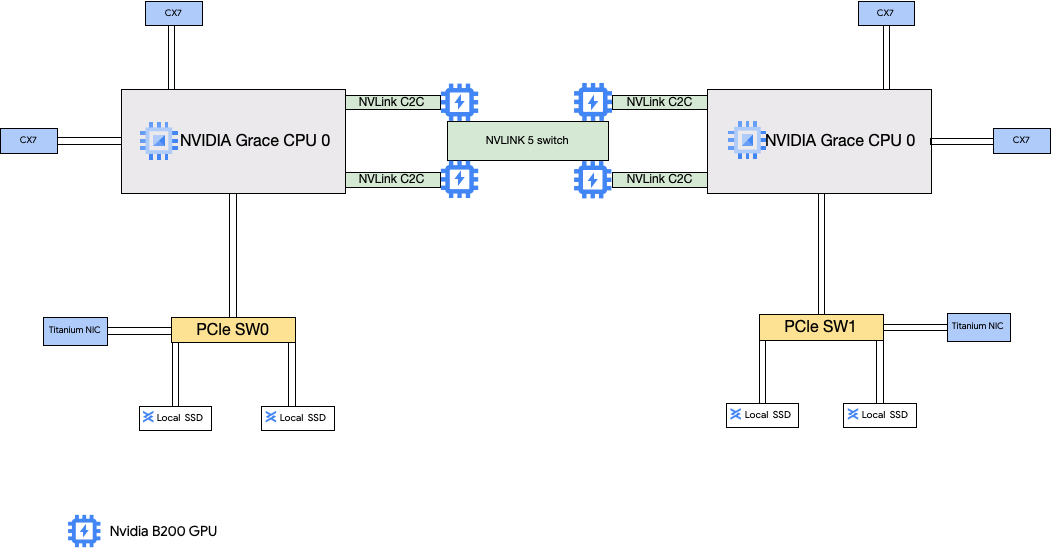

A4X 機型連接的是 NVIDIA GB200 Superchip。這些超級晶片搭載 NVIDIA B200 GPU。

這種機器類型有四張 NVIDIA ConnectX-7 (CX-7) 網路介面卡 (NIC) 和兩張 Titanium NIC。四個 CX-7 NIC 的總網路頻寬為 1,600 Gbps。這些 CX-7 NIC 專用於高頻寬 GPU 對 GPU 通訊,無法用於其他網路需求,例如存取公開網際網路。這兩張 Titanium NIC 是智慧型 NIC,可額外提供 400 Gbps 的網路頻寬,滿足一般用途的網路需求。這些網路介面卡加總後,可為這些機器提供總計 2,000 Gbps 的網路頻寬上限。

A4X 是以 NVIDIA GB200 NVL72 機架規模架構為基礎的百億級平台,並導入 NVIDIA Grace Hopper Superchip 架構,提供透過高頻寬 NVIDIA NVLink 晶片對晶片 (C2C) 互連網路連結的 NVIDIA Hopper GPU 和 NVIDIA Grace CPU。

A4X 網路架構採用軌道對齊設計,也就是一個拓撲,其中一個 Compute Engine 執行個體的對應網路介面卡會連線至另一個執行個體的網路介面卡。每個執行個體上的四個 CX-7 NIC 在實體上會以 4 向導軌對齊的網路拓撲隔離,因此 A4X 可在單一無阻斷叢集中,以 72 個 GPU 為一組,擴充至數千個 GPU。這種硬體整合式做法可提供可預測的低延遲效能,對於大規模分散式工作負載而言至關重要。

如要使用這些多重 NIC,您需要建立 3 個虛擬私有雲網路,如下所示:

- 2 個虛擬私有雲網路:每個 gVNIC 都必須連接至不同的虛擬私有雲網路

- 1 個具有 RDMA 網路設定檔的 VPC 網路:所有四個 CX-7 NIC 共用同一個 VPC 網路

如要設定這些網路,請參閱 AI Hypercomputer 說明文件中的「建立虛擬私有雲網路」。

| 已連結 NVIDIA GB200 Grace Blackwell 超級晶片 | |||||||

|---|---|---|---|---|---|---|---|

| 機型 | vCPU 數量1 | 執行個體記憶體 (GB) | 已連結的本機 SSD (GiB) | 實體 NIC 數量 | 網路頻寬上限 (Gbps)2 | GPU 數量 | GPU 記憶體3 (GB HBM3e) |

a4x-highgpu-4g |

140 | 884 | 12,000 | 6 | 2,000 | 4 | 720 |

1 在其中一個可用的 CPU 平台中,我們會以單一硬體超執行緒的形式提供 vCPU。

2輸出頻寬上限不得超過指定數量。實際輸出頻寬取決於目的地 IP 位址和其他因素。如要進一步瞭解網路頻寬,請參閱「網路頻寬」。

3GPU 記憶體是 GPU 裝置上的記憶體,可用於暫時儲存資料。這與執行個體的記憶體不同,專門用於處理需要高頻寬的繪圖密集型工作負載。

A4 和 A3 Ultra 機型

A4 機型連接的是 NVIDIA B200 GPU,A3 Ultra 機型連接的則是 NVIDIA H200 GPU。

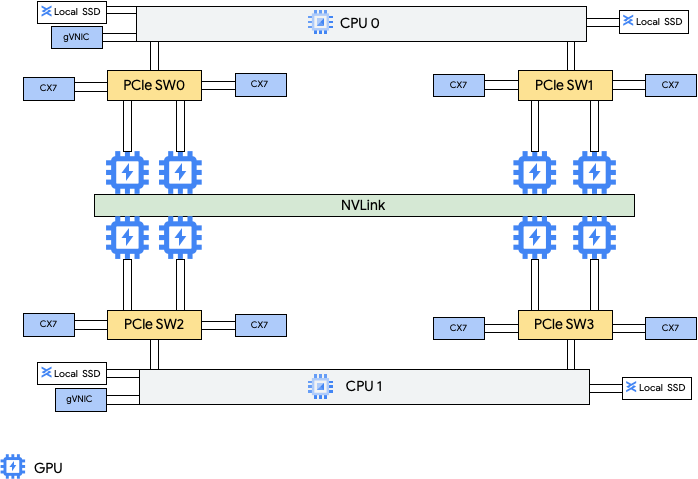

這些機器類型提供八張 NVIDIA ConnectX-7 (CX-7) 網路介面卡 (NIC) 和兩張 Google 虛擬 NIC (gVNIC)。八個 CX-7 NIC 可提供總計 3,200 Gbps 的網路頻寬。這些 NIC 專用於高頻寬 GPU 對 GPU 通訊,無法用於其他網路需求,例如存取公開網際網路。如下圖所示,每個 CX-7 NIC 都與一個 GPU 對齊,以最佳化非一致性記憶體存取 (NUMA)。八個 GPU 之間可透過 NVLink 橋接器快速通訊。另外兩張 gVNIC 網路介面卡是智慧型 NIC,可額外提供 400 Gbps 的網路頻寬,滿足一般用途的網路需求。這些網路介面卡加總起來,可為這些機器提供 3,600 Gbps 的網路頻寬上限。

如要使用這些多重 NIC,您需要建立 3 個虛擬私有雲網路,如下所示:

- 2 個一般虛擬私有雲網路:每個 gVNIC 都必須連接至不同的虛擬私有雲網路

- 1 個 RoCE VPC 網路:所有八個 CX-7 NIC 共用同一個 RoCE VPC 網路

如要設定這些網路,請參閱 AI Hypercomputer 說明文件中的「建立虛擬私有雲網路」。

A4 VM

| 已連結的 NVIDIA B200 Blackwell GPU | |||||||

|---|---|---|---|---|---|---|---|

| 機型 | vCPU 數量1 | 執行個體記憶體 (GB) | 已連結的本機 SSD (GiB) | 實體 NIC 數量 | 網路頻寬上限 (Gbps)2 | GPU 數量 | GPU 記憶體3 (GB HBM3e) |

a4-highgpu-8g |

224 | 3,968 | 12,000 | 10 | 3,600 | 8 | 1,440 |

A3 Ultra VM

| 附加的 NVIDIA H200 GPU | |||||||

|---|---|---|---|---|---|---|---|

| 機型 | vCPU 數量1 | 執行個體記憶體 (GB) | 已連結的本機 SSD (GiB) | 實體 NIC 數量 | 網路頻寬上限 (Gbps)2 | GPU 數量 | GPU 記憶體3 (GB HBM3e) |

a3-ultragpu-8g |

224 | 2,952 | 12,000 | 10 | 3,600 | 8 | 1128 |

A3 Mega、High 和 Edge 機型

這類機型連接 H100 GPU。這些機器類型各有固定的 GPU 數量、vCPU 數量和記憶體大小。

- 單一 NIC A3 VM:如果 A3 VM 附加 1 到 4 個 GPU,則只有單一實體網路介面卡 (NIC) 可用。

- 多 NIC A3 VM:對於附加 8 個 GPU 的 A3 VM,可使用多個實體 NIC。在這些 A3 機型中,NIC 會在 Peripheral Component Interconnect Express (PCIe) 匯流排上排列,如下所示:

- A3 Mega 機器類型:提供 8+1 的 NIC 配置。 採用這種配置時,8 個 NIC 會共用同一個 PCIe 匯流排,1 個 NIC 則位於不同的 PCIe 匯流排上。

- A3 High 機型:提供 4+1 的 NIC 配置。 這樣一來,4 個 NIC 會共用同一個 PCIe 匯流排,1 個 NIC 則位於不同的 PCIe 匯流排。

- A3 Edge 機型:可使用 4+1 的 NIC 配置。 採用這種配置時,4 個 NIC 會共用同一個 PCIe 匯流排,而 1 個 NIC 則位於不同的 PCIe 匯流排上。 這 5 個 NIC 可為每個 VM 提供 400 Gbps 的總網路頻寬。

共用相同 PCIe 匯流排的 NIC,每兩個 NVIDIA H100 GPU 有一個非一致性記憶體存取 (NUMA) 對齊。這些 NIC 非常適合用於 GPU 對 GPU 的專屬高頻寬通訊。位於獨立 PCIe 匯流排上的實體 NIC 非常適合其他網路需求。如要瞭解如何設定 A3 High 和 A3 Edge VM 的網路,請參閱設定巨型封包 MTU 網路。

A3 Mega

| 附加的 NVIDIA H100 GPU | |||||||

|---|---|---|---|---|---|---|---|

| 機型 | vCPU 數量1 | 執行個體記憶體 (GB) | 已連結的本機 SSD (GiB) | 實體 NIC 數量 | 網路頻寬上限 (Gbps)2 | GPU 數量 | GPU 記憶體3 (GB HBM3) |

a3-megagpu-8g |

208 | 1,872 | 6,000 | 9 | 1,800 | 8 | 640 |

A3 High

| 附加的 NVIDIA H100 GPU | |||||||

|---|---|---|---|---|---|---|---|

| 機型 | vCPU 數量1 | 執行個體記憶體 (GB) | 已連結的本機 SSD (GiB) | 實體 NIC 數量 | 網路頻寬上限 (Gbps)2 | GPU 數量 | GPU 記憶體3 (GB HBM3) |

a3-highgpu-1g |

26 | 234 | 750 | 1 | 25 | 1 | 80 |

a3-highgpu-2g |

52 | 468 | 1,500 | 1 | 50 | 2 | 160 |

a3-highgpu-4g |

104 | 936 | 3,000 | 1 | 100 | 4 | 320 |

a3-highgpu-8g |

208 | 1,872 | 6,000 | 5 | 1,000 | 8 | 640 |

A3 Edge

| 附加的 NVIDIA H100 GPU | |||||||

|---|---|---|---|---|---|---|---|

| 機型 | vCPU 數量1 | 執行個體記憶體 (GB) | 已連結的本機 SSD (GiB) | 實體 NIC 數量 | 網路頻寬上限 (Gbps)2 | GPU 數量 | GPU 記憶體3 (GB HBM3) |

a3-edgegpu-8g |

208 | 1,872 | 6,000 | 5 |

|

8 | 640 |

1 在其中一個可用的 CPU 平台中,我們會以單一硬體超執行緒的形式提供 vCPU。

2輸出頻寬上限不得超過指定數量。實際輸出頻寬取決於目的地 IP 位址和其他因素。如要進一步瞭解網路頻寬,請參閱「網路頻寬」。

3GPU 記憶體是 GPU 裝置上的記憶體,可用於暫時儲存資料。這與執行個體的記憶體不同,專門用於處理需要高頻寬的繪圖密集型工作負載。

A2 機型

每個 A2 機器類型連接固定數量的 NVIDIA A100 40GB 或 NVIDIA A100 80 GB GPU。每個機型也有固定的 vCPU 數量和記憶體大小。

A2 系列機器分為兩種:

- A2 Ultra:這類機型連接 A100 80GB GPU 和本機 SSD 磁碟。

- A2 Standard:這類機型連接 A100 40GB GPU。

A2 Ultra

| 已連結 NVIDIA A100 80GB GPU | ||||||

|---|---|---|---|---|---|---|

| 機型 | vCPU 數量1 | 執行個體記憶體 (GB) | 已連結的本機 SSD (GiB) | 網路頻寬上限 (Gbps)2 | GPU 數量 | GPU 記憶體3 (GB HBM2e) |

a2-ultragpu-1g |

12 | 170 | 375 | 24 | 1 | 80 |

a2-ultragpu-2g |

24 | 340 | 750 | 32 | 2 | 160 |

a2-ultragpu-4g |

48 | 680 | 1,500 | 50 | 4 | 320 |

a2-ultragpu-8g |

96 | 1,360 | 3,000 | 100 | 8 | 640 |

A2 Standard

| 已連結 NVIDIA A100 40GB GPU | ||||||

|---|---|---|---|---|---|---|

| 機型 | vCPU 數量1 | 執行個體記憶體 (GB) | 支援本機 SSD | 網路頻寬上限 (Gbps)2 | GPU 數量 | GPU 記憶體3 (GB HBM2) |

a2-highgpu-1g |

12 | 85 | 是 | 24 | 1 | 40 |

a2-highgpu-2g |

24 | 170 | 是 | 32 | 2 | 80 |

a2-highgpu-4g |

48 | 340 | 是 | 50 | 4 | 160 |

a2-highgpu-8g |

96 | 680 | 是 | 100 | 8 | 320 |

a2-megagpu-16g |

96 | 1,360 | 是 | 100 | 16 | 640 |

1 在其中一個可用的 CPU 平台中,我們會以單一硬體超執行緒的形式提供 vCPU。

2輸出頻寬上限不得超過指定數量。實際輸出頻寬取決於目的地 IP 位址和其他因素。如要進一步瞭解網路頻寬,請參閱「網路頻寬」。

3GPU 記憶體是 GPU 裝置上的記憶體,可用於暫時儲存資料。這與執行個體的記憶體不同,專門用於處理需要高頻寬的繪圖密集型工作負載。

G4 機型

G4 加速器最佳化

機型使用

NVIDIA RTX PRO 6000 Blackwell Server Edition GPU (nvidia-rtx-pro-6000),

適合用於 NVIDIA Omniverse 模擬工作負載、需要大量繪圖資源的應用程式、影片轉碼和虛擬桌面。與 A 系列機型相比,G4 機型也提供低成本解決方案,可執行單一主機推論和模型微調。

| 附加的 NVIDIA RTX PRO 6000 GPU | |||||||

|---|---|---|---|---|---|---|---|

| 機型 | vCPU 數量1 | 執行個體記憶體 (GB) | 支援的 Titanium SSD 容量上限 (GiB)2 | 實體 NIC 數量 | 網路頻寬上限 (Gbps)3 | GPU 數量 | GPU 記憶體4 (GB GDDR7) |

g4-standard-48 |

48 | 180 | 1,500 | 1 | 50 | 1 | 96 |

g4-standard-96 |

96 | 360 | 3,000 | 1 | 100 | 2 | 192 |

g4-standard-192 |

192 | 720 | 6,000 | 1 | 200 | 4 | 384 |

g4-standard-384 |

384 | 1,440 | 12,000 | 2 | 400 | 8 | 768 |

1 在其中一個可用的 CPU 平台中,我們會以單一硬體超執行緒的形式提供 vCPU。

2建立 G4 執行個體時,可以新增 Titanium SSD 磁碟。如要瞭解可附加的磁碟數量,請參閱需要選擇本機 SSD 磁碟數量的機器類型。

3輸出頻寬上限不得超過指定數量。實際輸出頻寬取決於目的地 IP 位址和其他因素。請參閱「網路頻寬」。

4GPU 記憶體是 GPU 裝置上的記憶體,可用於暫時儲存資料。這與執行個體的記憶體不同,專門用於處理需要高頻寬的繪圖密集型工作負載。

G2 機型

G2 加速器最佳化機型連接的是 NVIDIA L4 GPU,非常適合用於成本最佳化的推論、需要大量圖形處理的作業,以及高效能運算工作負載。

每個 G2 機型也都有預設記憶體和自訂記憶體範圍。自訂記憶體範圍會定義每個機型可分配給執行個體的記憶體大小。您也可以在建立 G2 執行個體時新增本機 SSD 磁碟。如要瞭解可附加的磁碟數量,請參閱需要選擇本機 SSD 磁碟數量的機器類型。

如要為大多數 GPU 執行個體套用較高的網路頻寬速率 (50 Gbps 以上),建議使用 Google 虛擬 NIC (gVNIC)。如要進一步瞭解如何建立使用 gVNIC 的 GPU 執行個體,請參閱建立使用較高頻寬的 GPU 執行個體。

| 已附加的 NVIDIA L4 GPU | |||||||

|---|---|---|---|---|---|---|---|

| 機型 | vCPU 數量1 | 預設執行個體記憶體 (GB) | 自訂執行個體記憶體範圍 (GB) | 支援的最大本機 SSD (GiB) | 網路頻寬上限 (Gbps)2 | GPU 數量 | GPU 記憶體3 (GB GDDR6) |

g2-standard-4 |

4 | 16 | 16 至 32 | 375 | 10 | 1 | 24 |

g2-standard-8 |

8 | 32 | 32 至 54 | 375 | 16 | 1 | 24 |

g2-standard-12 |

12 | 48 | 48 到 54 歲 | 375 | 16 | 1 | 24 |

g2-standard-16 |

16 | 64 | 54 到 64 | 375 | 32 | 1 | 24 |

g2-standard-24 |

24 | 96 | 96 至 108 | 750 | 32 | 2 | 48 |

g2-standard-32 |

32 | 128 | 96 到 128 | 375 | 32 | 1 | 24 |

g2-standard-48 |

48 | 192 | 192 至 216 | 1,500 | 50 | 4 | 96 |

g2-standard-96 |

96 | 384 | 384 到 432 | 3,000 | 100 | 8 | 192 |

1 在其中一個可用的 CPU 平台中,我們會以單一硬體超執行緒的形式提供 vCPU。

2輸出頻寬上限不得超過指定數量。實際輸出頻寬取決於目的地 IP 位址和其他因素。如要進一步瞭解網路頻寬,請參閱「網路頻寬」。

3GPU 記憶體是 GPU 裝置上的記憶體,可用於暫時儲存資料。這與執行個體的記憶體不同,專門用於處理需要高頻寬的繪圖密集型工作負載。

N1 + GPU 機器類型

對於附加 T4 和 V100 GPU 的 N1 一般用途執行個體,根據 GPU 和 vCPU 數量的組合,您最多可獲得 100 Gbps 的網路頻寬。如要瞭解其他 N1 GPU 執行個體,請參閱總覽。

請參閱下節,根據 GPU 型號、vCPU 和 GPU 數量,計算 T4 和 V100 執行個體可用的網路頻寬上限。

少於 5 個 vCPU

如果 T4 和 V100 執行個體的 vCPU 數量為 5 個以下,則網路頻寬上限為 10 Gbps。

超過 5 個 vCPU

如果 T4 和 V100 執行個體的 vCPU 數量超過 5 個,系統會根據該 VM 的 vCPU 和 GPU 數量,計算網路頻寬上限。

如要為大多數 GPU 執行個體套用較高的網路頻寬速率 (50 Gbps 以上),建議使用 Google 虛擬 NIC (gVNIC)。如要進一步瞭解如何建立使用 gVNIC 的 GPU 執行個體,請參閱建立使用較高頻寬的 GPU 執行個體。

| GPU 模型 | GPU 數量 | 計算最大網路頻寬 |

|---|---|---|

| NVIDIA V100 | 1 | min(vcpu_count * 2, 32) |

| 2 | min(vcpu_count * 2, 32) |

|

| 4 | min(vcpu_count * 2, 50) |

|

| 8 | min(vcpu_count * 2, 100) |

|

| NVIDIA T4 | 1 | min(vcpu_count * 2, 32) |

| 2 | min(vcpu_count * 2, 50) |

|

| 4 | min(vcpu_count * 2, 100) |

MTU 設定和 GPU 機器類型

如要盡量提高網路頻寬,請為虛擬私有雲網路設定較高的最大傳輸單位 (MTU) 值。MTU 值越高,封包大小就越大,封包標頭的負擔也會減少,進而提高酬載資料的總處理量。

如果是 GPU 機器類型,建議您為虛擬私有雲網路採用下列 MTU 設定。

| GPU 機器類型 | 建議的 MTU (以位元組為單位) | |

|---|---|---|

| 虛擬私有雲網路 | 具有 RDMA 設定檔的虛擬私有雲網路 | |

|

8896 | 8896 |

|

8244 | 不適用 |

|

8896 | 不適用 |

設定 MTU 值時,請注意下列事項:

- 8192 是兩個 4 KB 頁面。

- 如果 GPU NIC 已啟用標頭分割功能,建議在 A3 Mega、A3 High 和 A3 Edge VM 中使用 8244。

- 除非表格另有註明,否則請使用 8896 這個值。

建立高頻寬 GPU 機器

如要建立使用較高網路頻寬的 GPU 執行個體,請根據機器類型使用下列其中一種方法:

如要建立使用更高網路頻寬的 A2、G2 和 N1 執行個體,請參閱「為 A2、G2 和 N1 執行個體使用更高網路頻寬」。如要測試或驗證這些機器的頻寬速度,可以使用基準測試。詳情請參閱「檢查網路頻寬」。

如要建立使用較高網路頻寬的 A3 Mega 執行個體,請參閱「部署 A3 Mega Slurm 叢集以進行 ML 訓練」。如要測試或驗證這些機器的頻寬速度,請按照「檢查網路頻寬」一文中的步驟,進行基準測試。

如要瞭解如何為使用較高網路頻寬的 A3 High 和 A3 Edge 執行個體啟用 GPUDirect-TCPX,請參閱這篇文章。如要測試或驗證這些機器的頻寬速度,可以使用基準測試。詳情請參閱「檢查網路頻寬」。

如要使用其他加速器最佳化機型,不需要採取任何行動,只要按照文件說明建立執行個體,即可使用高網路頻寬。如要瞭解如何為其他加速器最佳化機型建立執行個體,請參閱建立附加 GPU 的 VM。

後續步驟

- 進一步瞭解 GPU 平台。

- 瞭解如何建立附加 GPU 的執行個體。

- 瞭解如何使用較高的網路頻寬。

- 瞭解 GPU 定價。