Puoi utilizzare la funzionalità di test integrata per scoprire bug e prevenire le regressioni. Per testare l'agente, puoi utilizzare il simulatore per interagire con l'agente e salvare la conversazione come caso di test.

Quando salvi un caso di test, le corrispondenze di intent, le azioni del playbook, i flussi attivati e le pagine attivate che si sono verificate durante la conversazione vengono salvate come aspettative del caso di test. Quando esegui lo scenario di test in un secondo momento dopo aver apportato aggiornamenti all'agente, queste aspettative vengono verificate. Puoi anche modificare queste aspettative quando crei o modifichi i casi di test.

Creare uno scenario di test

Per creare un caso di test utilizzando il simulatore:

- Apri il simulatore.

- Parla con l'agente.

- Fai clic sul pulsante Crea test case sopra il simulatore.

- Viene visualizzato il riquadro dell'editor del caso di test. Fornisci il nome visualizzato del caso di test e modifica le aspettative come preferisci.

- Fai clic sul pulsante Salva test case sopra il simulatore.

Esegui scenari di test

Per eseguire un singolo test case:

- Fai clic su Test case nel riquadro di navigazione a sinistra.

- Seleziona lo scenario di test che vuoi eseguire.

- Fai clic sul pulsante Esegui.

- Vengono visualizzati i risultati della cronologia degli scenari di test.

Per eseguire più casi di test:

- Fai clic su Test case nel riquadro di navigazione a sinistra.

- Seleziona gli scenari di test che vuoi eseguire utilizzando le caselle di controllo a sinistra.

- Fai clic su Esegui selezione.

- Vengono visualizzati i risultati dell'esecuzione della prova più recente per ogni caso di test.

Modificare uno scenario di test

Quando modifichi un caso di test, non puoi modificare il messaggio dell'utente finale o la risposta dell'agente, ma puoi modificare quanto segue:

- Aggiungi aspettative

- Eliminare le aspettative

- Aggiornare le aspettative

Per modificare uno scenario di test:

- Fai clic su Test case nel riquadro di navigazione a sinistra.

- Seleziona il caso di test che vuoi modificare.

- Fai clic sul pulsante Modifica sopra il riepilogo del caso di test.

- Puoi espandere la sezione Aspettative a livello di conversazione per modificare le aspettative che si applicano all'intera conversazione.

- Ogni turno di conversazione mostra il messaggio dell'utente finale, la risposta dell'agente e le aspettative per il turno. Non puoi modificare i messaggi, ma puoi modificare le aspettative a livello di svolta.

Elimina scenari di test

Per eliminare gli scenari di test:

- Fai clic su Test case nel riquadro di navigazione a sinistra.

- Seleziona i casi di test da eliminare utilizzando le caselle di controllo a sinistra.

- Fai clic su Elimina scenari di test selezionati.

Aspettative

Quando fornisci le aspettative per un test case, puoi fornire aspettative a livello di conversazione o aspettative a livello di turno.

Le aspettative a livello di conversazione si applicano all'intera conversazione e puoi fornire i seguenti tipi di aspettative:

- Utilizzo dello strumento

- Richiamo del flusso

- Richiamo del playbook

Le aspettative a livello di turno si applicano solo a un turno di conversazione specifico e puoi fornire i seguenti tipi di aspettative:

- Risposta dell'agente

- Flusso di corrente

- Intento corrente

- Pagina corrente

- Utilizzo dello strumento

- Richiamo del flusso

- Richiamo del playbook

Scenari di test legacy

Puoi utilizzare la funzionalità di test integrata per scoprire bug e prevenire le regressioni. Per testare l'agente, crei scenari di test utilizzando il simulatore per definire gli scenari di test di riferimento, poi esegui gli scenari di test in base alle esigenze. L'esecuzione di un test verifica che le risposte dell'agente non siano cambiate per gli input dell'utente finale definiti nel caso di test.

Le istruzioni riportate di seguito mostrano come utilizzare la console, ma puoi trovare la stessa funzionalità anche nell'API.

Impostazioni del simulatore

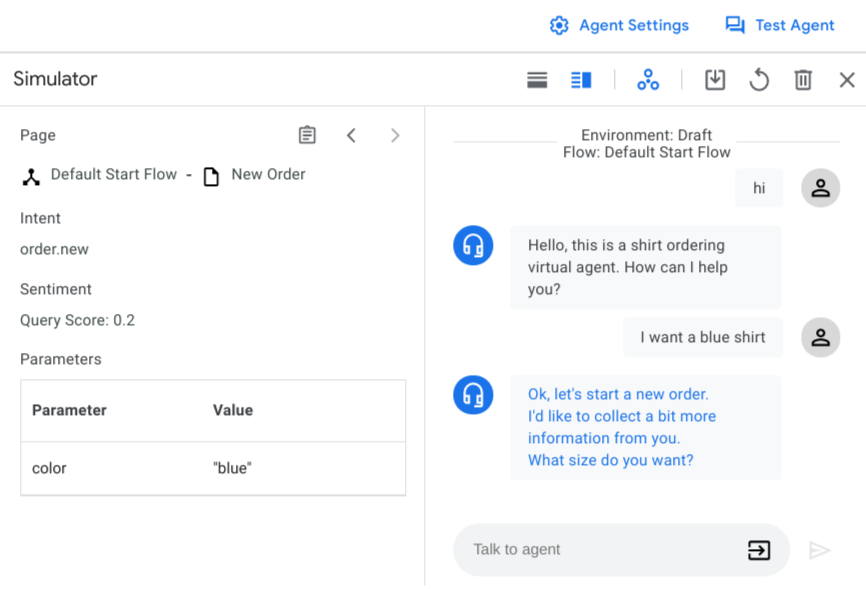

Quando apri il simulatore per la prima volta, devi selezionare un ambiente agente o le versioni dei flussi e un flusso attivo. Nella maggior parte dei casi, devi utilizzare l'ambiente di bozza e il flusso di avvio predefinito.

Puoi anche attivare o disattivare le chiamate webhook in qualsiasi momento con il pulsante di attivazione/disattivazione del webhook. La disattivazione degli webhook è utile per definire i casi di test.

Input del simulatore

Quando interagisci con il simulatore, fornisci l'input utente finale come testo, quindi premi Invio o fai clic sul pulsante invia . Oltre al testo normale, puoi scegliere tipi di input alternativi con il selettore di input :

- Parametro: inserisci un valore parametro. Puoi fornire nuovi parametri o valori preimpostati per i parametri esistenti.

- Evento: invoca un evento.

- DTMF: invia input di segnalazione multifrequenza a due toni (Touch-Tone) per le interazioni telefoniche.

Creare uno scenario di test

Per creare una conversazione:

- Apri la console Dialogflow CX.

- Scegli il tuo progetto.

- Seleziona il tuo agente.

- Fai clic su Agente di test per aprire il simulatore.

- Chatta con l'agente per creare una conversazione che copra la funzionalità che vuoi testare. Per ogni turno, verifica i valori corretti per l'intent attivato, la risposta dell'agente, la pagina attiva e i parametri della sessione.

Per salvare una conversazione come caso di test:

- Fai clic sul pulsante Salva.

- Inserisci il nome visualizzato del caso di test. Ogni caso di test deve avere un nome visualizzato univoco.

- (Facoltativo) Fornisci un nome per il tag. I tag ti aiutano a organizzare i casi di test. Tutti i tag devono iniziare con un "#".

- (Facoltativo) Fornisci una nota che descriva lo scopo del test case.

- Se vuoi, seleziona i parametri da monitorare nel caso di test. Viene fornito un elenco di parametri suggeriti. Puoi anche inserire altri parametri da monitorare. Se selezioni i parametri di monitoraggio, la verifica del parametro viene eseguita durante l'esecuzione dello scenario di test. Scopri di più sull'affermazione del parametro nella sezione Eseguire gli scenari di test.

- Fai clic su Salva per salvare lo scenario di test.

Esegui scenari di test

Per visualizzare tutti i casi di test per un agente, fai clic su Test case nella scheda Gestisci. La tabella dei casi di test mostra il nome del test, i tag, l'ora e l'ambiente di test più recenti e il risultato del test più recente.

Per eseguire gli scenari di test:

- Seleziona gli scenari di test da eseguire e fai clic su Esegui. In alternativa, puoi fare clic su Esegui tutti gli scenari di test.

- Seleziona l'ambiente in cui vuoi eseguire gli scenari di test.

- I test iniziano a essere eseguiti e puoi visualizzarne lo stato nella coda di attività. Il risultato del test verrà aggiornato al termine.

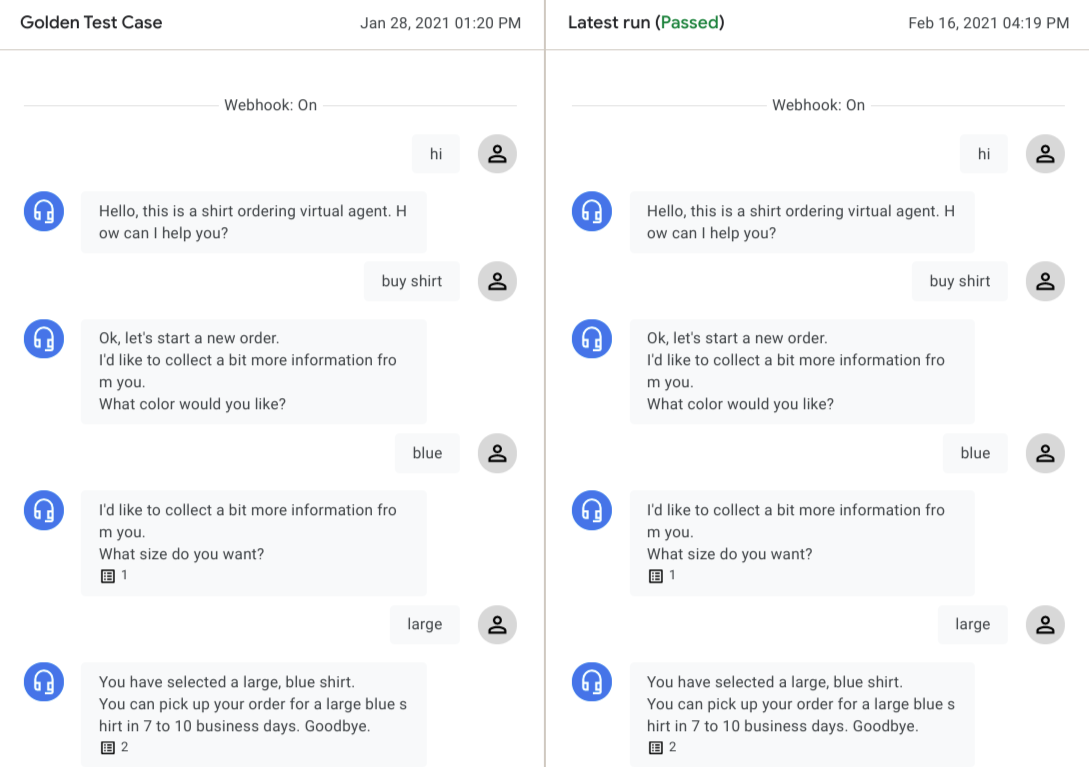

Per visualizzare il risultato dettagliato del test, fai clic sullo scenario di test. Il caso di test di riferimento e le conversazioni della run più recente vengono mostrate una accanto all'altra.

Puoi fare clic su qualsiasi turno di conversazione dell'agente per visualizzarne i dettagli. Il motore di test controlla i seguenti tipi di dati passaggio dopo passaggio per valutare il risultato del test:

Dialogo con l'agente:

Per ogni turno di conversazione, il dialogo dell'agente viene confrontato dall'esecuzione di riferimento a quella più recente. In caso di differenze, viene visualizzato un avviso. Queste differenze non impediscono il superamento di un test, perché il dialogo dell'agente varia spesso per lo stesso stato dell'agente.

Intention corrispondente:

L'intenzione associata deve essere la stessa per ogni turno affinché un test venga superato.

Pagina corrente:

Affinché un test venga superato, la pagina attiva deve essere la stessa per ogni svolta.

Parametri sessione:

Se hai aggiunto parametri di monitoraggio durante la creazione del caso di test, il motore di test controllerà i parametri di sessione corrispondenti e non supererà il test se sono presenti parametri mancanti/inaspettati o mancano corrispondenze valore parametro.

In alcuni casi, un test case potrebbe avere un errore previsto a causa di un agente aggiornato. Se la conversazione nell'ultima esecuzione riflette le modifiche previste, puoi fare clic su Salva come golden per sovrascrivere il caso di test golden.

Modificare gli scenari di test

Per modificare un caso di test, selezionalo dalla tabella Test case, quindi fai clic sull'icona di modifica accanto al nome del caso di test. Viene visualizzata la finestra di dialogo Aggiorna scenari di test.

Per modificare i metadati e le impostazioni del caso di test, fai clic sulla scheda Impostazioni.

Puoi modificare i campi Nome caso di test, Tag e Nota oppure aggiungere nuovi parametri di monitoraggio.

Fai clic su Salva.

Per modificare l'input utente per il caso di test, fai clic sulla scheda Input utente.

Aggiungi, rimuovi o modifica gli input utente in formato JSON.

Fai clic su Conferma. Viene avviata una corsa di prova automatica e la conversazione aggiornata viene visualizzata al termine della corsa di prova.

Fai clic su Salva per sovrascrivere il test case di riferimento originale oppure su Salva come per creare un nuovo test case con le modifiche.

Visualizza la copertura dei test

Per visualizzare un report sulla copertura dei test per tutti i casi di test, fai clic su Copertura.

La pagina Copertura include le seguenti schede:

La copertura delle transizioni viene determinata per tutti i gestori degli stati (esclusi i gruppi di route) con un target di transizione esercitato dal caso di test. Nella tabella sono elencati il flusso/la pagina di origine e il flusso/la pagina di destinazione della transizione.

La copertura degli intent viene determinata per tutti gli intent che corrispondono al caso di test.

La copertura dei gruppi di percorsi viene determinata per tutti i gruppi di percorsi corrispondenti al caso di test.

Importare ed esportare gli scenari di test

Per esportare gli scenari di test:

- Seleziona gli scenari di test e fai clic su Esporta o su Esporta tutti gli scenari di test.

- Fai clic su Scarica in un file locale o fornisci un URI del bucket Cloud Storage e fai clic su Esporta in Google Cloud Storage.

Quando importi gli scenari di test, Conversational Agents (Dialogflow CX) crea sempre nuovi scenari di test per l'agente di destinazione e non sovrascrive gli scenari di test esistenti. Per importare gli scenari di test:

- Fai clic su Importa.

- Scegli un file locale o fornisci un URI del bucket Cloud Storage.