En este documento, se proporciona una descripción general de la administración de cargas de trabajo en Google Distributed Cloud (GDC) aislado. Se tratan los siguientes temas:

Si bien se recomiendan algunos diseños de implementación de cargas de trabajo, no es necesario seguirlos exactamente como se indican. Cada universo de GDC tiene requisitos y consideraciones únicos que deben satisfacerse caso por caso.

Este documento está dirigido a los administradores de TI que forman parte del grupo de administradores de la plataforma y que son responsables de administrar los recursos dentro de su organización, y a los desarrolladores de aplicaciones que forman parte del grupo de operadores de aplicaciones y que son responsables de desarrollar y mantener aplicaciones en un universo de GDC.

Para obtener más información, consulta Audiences for GDC air-gapped documentation.

Dónde implementar cargas de trabajo

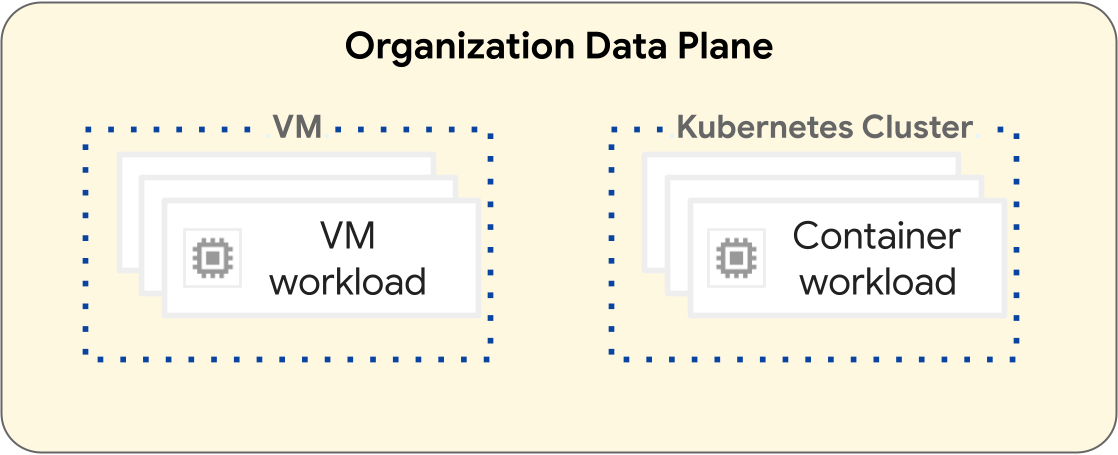

En la plataforma de GDC, las operaciones para implementar cargas de trabajo de máquinas virtuales (VM) y cargas de trabajo de contenedores son diferentes. En el siguiente diagrama, se ilustra la separación de cargas de trabajo dentro de la capa del plano de datos de tu organización.

Las cargas de trabajo basadas en VM operan dentro de una VM. Por el contrario, las cargas de trabajo de contenedores operan dentro de un clúster de Kubernetes. La separación fundamental entre las VMs y los clústeres de Kubernetes proporciona límites de aislamiento entre tus cargas de trabajo de VM y las cargas de trabajo de contenedores. Para obtener más información, consulta Jerarquía de recursos.

En las siguientes secciones, se presentan las diferencias entre cada tipo de carga de trabajo y su ciclo de vida de implementación.

Cargas de trabajo basadas en VM

Puedes crear VMs para alojar tus cargas de trabajo basadas en VM. Tienes muchas opciones de configuración para la forma y el tamaño de tu VM que te ayudarán a satisfacer mejor los requisitos de tu carga de trabajo basada en VM. Debes crear una VM en un proyecto, que puede tener muchas cargas de trabajo de VM. Las VMs son un recurso secundario de un proyecto. Para obtener más información, consulta la descripción general de las VMs.

Los proyectos que solo contienen cargas de trabajo basadas en VM no requieren un clúster de Kubernetes. Por lo tanto, no es necesario que aprovisiones clústeres de Kubernetes para las cargas de trabajo basadas en VM.

Cargas de trabajo basadas en contenedores

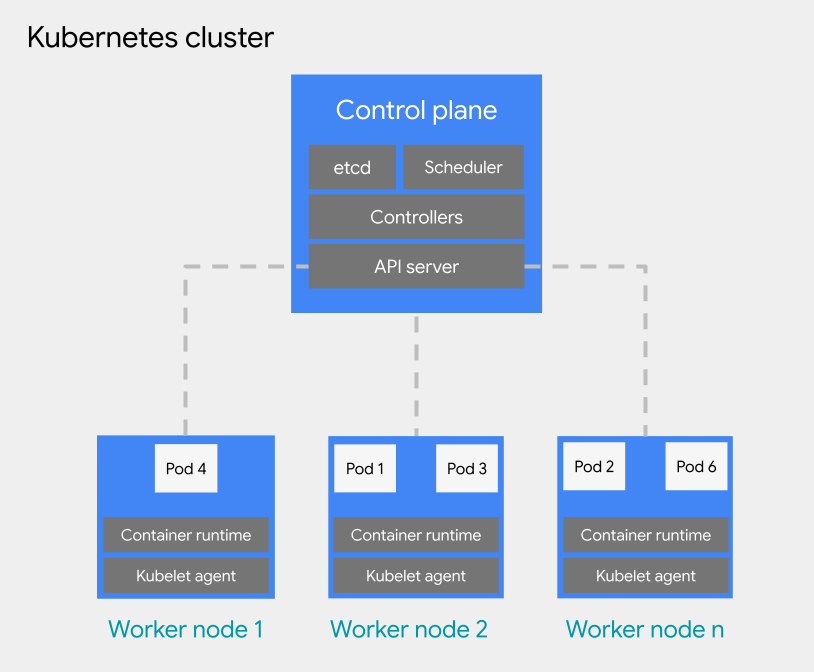

Puedes implementar cargas de trabajo basadas en contenedores en un Pod de un clúster de Kubernetes. Un clúster de Kubernetes consta de los siguientes tipos de nodos:

Nodo del plano de control: Ejecuta los servicios de administración, como la programación, etcd y un servidor de la API.

Nodo trabajador: Ejecuta tus pods y aplicaciones en contenedores.

Los clústeres de Kubernetes se pueden adjuntar a uno o varios proyectos, pero no son un recurso secundario de un proyecto. Esta es una diferencia fundamental que tienen los clústeres de Kubernetes en comparación con las VMs. Una VM es un recurso secundario de un proyecto, mientras que los clústeres de Kubernetes operan como un recurso secundario de una organización, lo que les permite adjuntarse a varios proyectos.

Para la programación de Pods dentro de un clúster de Kubernetes, GDC adopta los conceptos generales de Kubernetes sobre programación, interrupción y desalojo. Las prácticas recomendadas para programar Pods dentro de un clúster varían según los requisitos de tu carga de trabajo.

Para obtener más información sobre los clústeres de Kubernetes, consulta la descripción general de los clústeres de Kubernetes. Para obtener más información sobre cómo administrar tus contenedores en un clúster de Kubernetes, consulta Cargas de trabajo de contenedores en GDC.

Prácticas recomendadas para diseñar clústeres de Kubernetes

En esta sección, se presentan las prácticas recomendadas para diseñar clústeres de Kubernetes:

- Crea clústeres separados para cada entorno de desarrollo de software

- Crea menos clústeres más grandes

- Crea menos grupos de nodos más grandes dentro de un clúster

Ten en cuenta cada práctica recomendada para diseñar un clúster resiliente para el ciclo de vida de tu carga de trabajo de contenedores.

Crea clústeres separados para cada entorno de desarrollo de software

Además de proyectos separados por entorno de desarrollo de software, te recomendamos que diseñes clústeres de Kubernetes separados por entorno de desarrollo de software. Un entorno de desarrollo de software es un área dentro de tu universo de GDC destinada a todas las operaciones que corresponden a una fase designada del ciclo de vida. Por ejemplo, si tienes dos entornos de desarrollo de software llamados development y production en tu organización, puedes crear un conjunto independiente de clústeres de Kubernetes para cada entorno y adjuntar proyectos a cada clúster según tus necesidades. Recomendamos que los clústeres de Kubernetes en los ciclos de vida de producción previa y producción tengan varios proyectos adjuntos.

Los clústeres definidos para cada entorno de desarrollo de software suponen que las cargas de trabajo dentro de un entorno de desarrollo de software pueden compartir clústeres. Luego, asigna proyectos al clúster de Kubernetes del entorno adecuado. Un clúster de Kubernetes se puede subdividir en varios grupos de nodos o usar taints para aislar las cargas de trabajo.

Si separas los clústeres de Kubernetes por entorno de desarrollo de software, aíslas el consumo de recursos, las políticas de acceso, los eventos de mantenimiento y los cambios de configuración a nivel del clúster entre tus cargas de trabajo de producción y las que no son de producción.

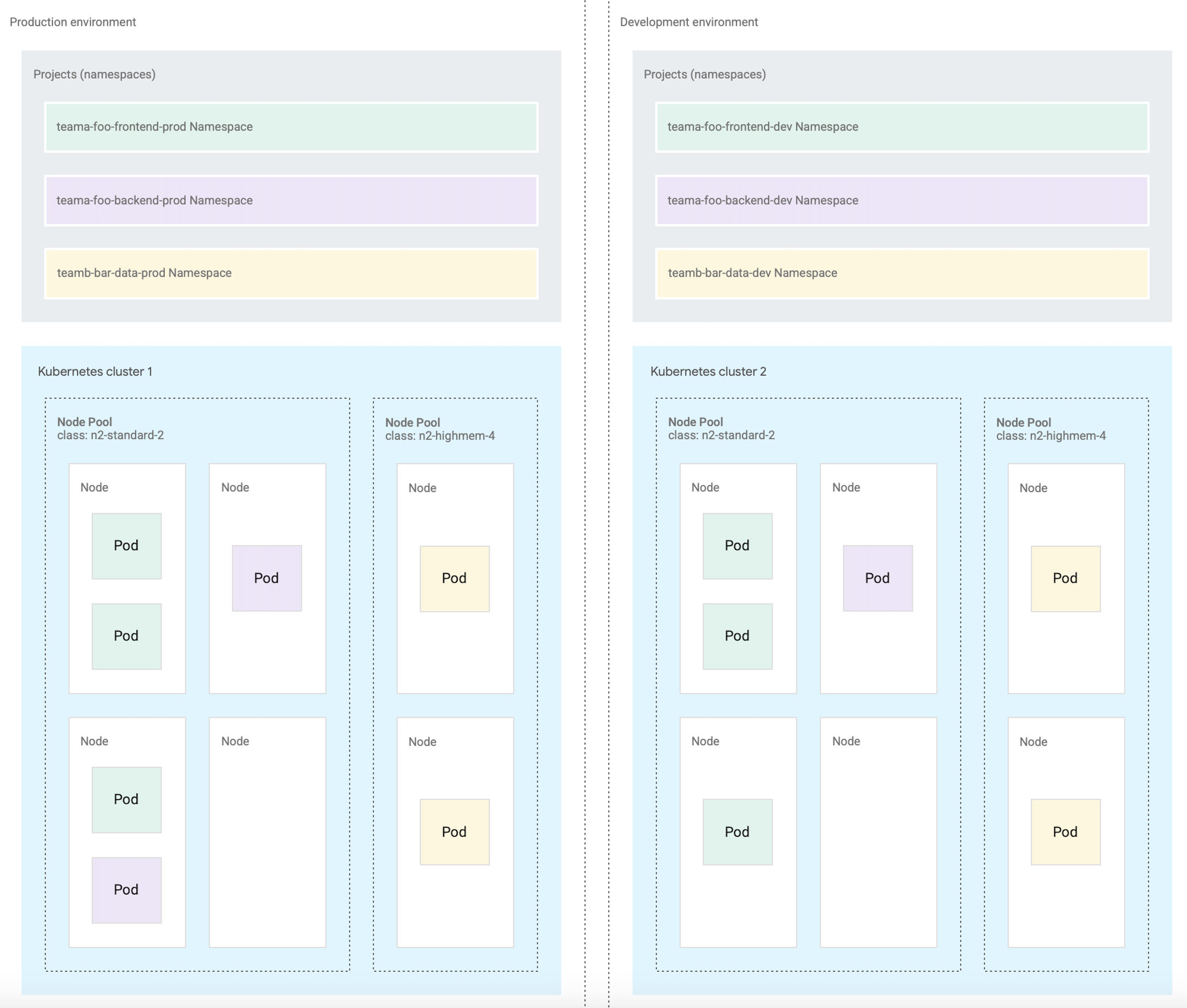

En el siguiente diagrama, se muestra un diseño de muestra de un clúster de Kubernetes para varias cargas de trabajo que abarcan proyectos, clústeres, entornos de desarrollo de software y clases de máquinas.

En esta arquitectura de muestra, se supone que las cargas de trabajo dentro de un entorno de desarrollo de software de producción y desarrollo pueden compartir clústeres. Cada entorno tiene un conjunto independiente de clústeres de Kubernetes, que se subdividen en varios grupos de nodos para diferentes requisitos de clase de máquina.

Como alternativa, diseñar varios clústeres de Kubernetes es útil para las operaciones de contenedores en las siguientes situaciones:

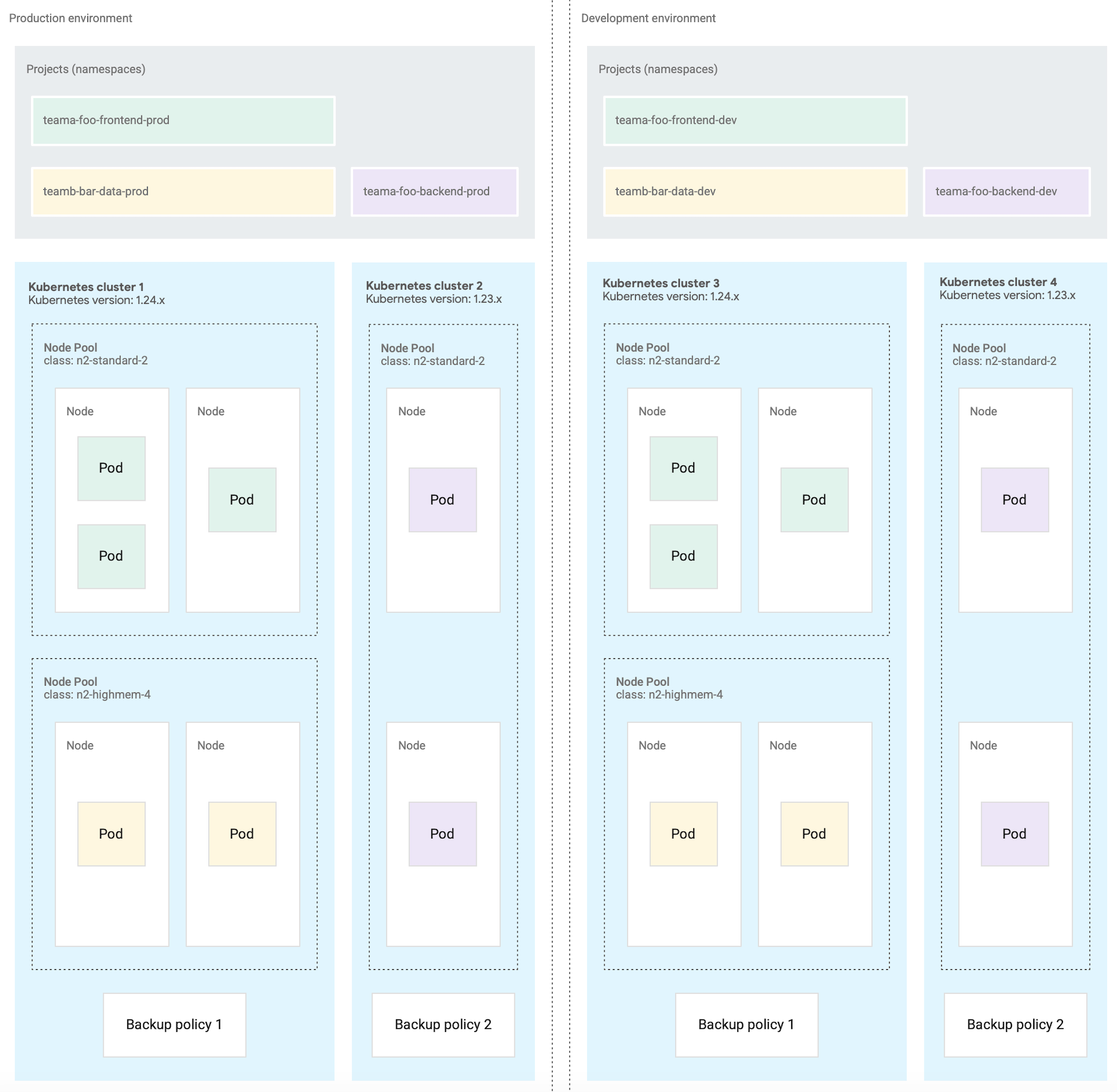

- Tienes algunas cargas de trabajo fijadas en una versión específica de Kubernetes, por lo que mantienes diferentes clústeres en diferentes versiones.

- Tienes algunas cargas de trabajo que requieren diferentes necesidades de configuración del clúster, como la política de copias de seguridad, por lo que creas varios clústeres con diferentes configuraciones.

- Ejecutas copias de un clúster en paralelo para facilitar las actualizaciones de versiones disruptivas o una estrategia de implementación azul-verde.

- Compilas una carga de trabajo experimental que corre el riesgo de limitar el servidor de API o cualquier otro punto único de falla dentro de un clúster, por lo que la aíslas de las cargas de trabajo existentes.

En el siguiente diagrama, se muestra un ejemplo en el que se configuran varios clústeres por entorno de desarrollo de software debido a requisitos como las operaciones de contenedores que se describieron en la sección anterior.

Crea menos clústeres

Para lograr un uso eficiente de los recursos, te recomendamos que diseñes la menor cantidad posible de clústeres de Kubernetes que cumplan con tus requisitos para separar los entornos de desarrollo de software y las operaciones de contenedores. Cada clúster adicional genera un consumo de recursos de sobrecarga adicional, como los nodos adicionales del plano de control que se requieren. Por lo tanto, un clúster más grande con muchas cargas de trabajo utiliza los recursos de procesamiento subyacentes de manera más eficiente que muchos clústeres pequeños.

Cuando hay varios clústeres con configuraciones similares, se genera una sobrecarga de mantenimiento adicional para supervisar la capacidad del clúster y planificar las dependencias entre clústeres.

Si un clúster se acerca a su capacidad máxima, te recomendamos que agregues nodos adicionales en lugar de crear uno nuevo.

Crea menos grupos de nodos dentro de un clúster

Para un uso eficiente de los recursos, recomendamos diseñar menos grupos de nodos más grandes dentro de un clúster de Kubernetes.

Configurar varios grupos de nodos es útil cuando necesitas programar pods que requieren una clase de máquina diferente a la de otros. Crea un grupo de nodos para cada clase de máquina que requieran tus cargas de trabajo y configura la capacidad de nodos en el ajuste de escala automático para permitir un uso eficiente de los recursos de procesamiento.

¿Qué sigue?

- Jerarquía de recursos

- Crea una app de contenedor con alta disponibilidad

- Crea una app de VM altamente disponible