このガイドは、分析レイクハウスのジャンプ スタート ソリューションの理解、デプロイ、使用に役立ちます。このソリューションでは、統合データスタックを使用してデータを保存、処理、分析、有効化する分析レイクハウスを作成し、データレイクとデータ ウェアハウスを統合する方法について説明します。

分析レイクハウスを構築する一般的なユースケースは次のとおりです。

- レポートデータと組み合わせたテレメトリー データの大規模な分析。

- 構造化データ分析と非構造化データ分析の統合。

- データ ウェアハウス用のリアルタイム分析機能を提供。

このドキュメントは、データ分析の経験があり、データベースまたはデータレイクを使用して分析を行ったことがあるデベロッパーを対象としています。このドキュメントは、クラウドの基本的なコンセプトを理解していることを前提としていますが、Google Cloudの知識が必須というわけではありません。また、Terraform の使用経験も役に立ちます。

目標

- 分析レイクハウスの設定方法について説明します。

- 共通のガバナンス レイヤを使用して分析レイクハウスを保護します。

- データからダッシュボードを構築し、データ分析を行います。

- 時間の経過に伴うデータ値を予測する ML モデルを作成します。

使用するプロダクト

このソリューションでは、次の Google Cloud プロダクトを使用します。

- BigQuery: ML 機能が組み込まれた、フルマネージドでスケーラビリティの高いデータ ウェアハウス。

- Dataproc: データレイクのモダナイゼーション、ETL、安全なデータ サイエンスを大規模に実現するフルマネージド サービスです。

- Looker Studio: データ インサイトの作成と共有に役立つセルフサービス ビジネス インテリジェンス プラットフォーム。

- Dataplex Universal Catalog: 大規模なデータを一元的に検出、管理、モニタリング、管理します。

- Cloud Storage: 低コストで無制限のオブジェクト ストレージをさまざまなデータ型に使用する、エンタープライズ クラスのサービス。データはGoogle Cloud の内部および外部からアクセス可能で、地理的に冗長に複製されます。

- BigLake: BigLake は、BigQuery と Spark などのオープンソース フレームワークから、詳細なアクセス制御によりデータにアクセスできるようにすることで、データ ウェアハウスとデータレイクを統合するストレージ エンジンです。

次の Google Cloud プロダクトは、ソリューションで最初に使用するデータをステージングする際に使用されます。

- Workflows: 指定された順序でサービスをワークフローとして実行する、フルマネージド オーケストレーション プラットフォーム。Workflows では、Cloud Run や Cloud Run functions でホストされているカスタム サービス、BigQuery などのGoogle Cloud サービス、HTTP ベースの任意の API といったサービスを組み合わせることができます。

アーキテクチャ

このソリューションでデプロイするレイクハウス アーキテクチャの例では、e コマース データセットを分析し、小売業者のパフォーマンスの推移を把握します。次の図は、このソリューションがデプロイする Google Cloud リソースのアーキテクチャを示しています。

ソリューションのフロー

このアーキテクチャは、分析レイクハウス アーキテクチャでデータを入力して変換する一般的なデータフローを表しています。

- データは Cloud Storage バケットに格納されます。

- Dataplex Universal Catalog にデータレイクが作成されます。バケット内のデータは、データレイク内のエンティティ(テーブル)に整理されます。

- データレイク内のテーブルは、BigLake テーブルとして、そのまま BigQuery で利用できます。

- データ変換は、Dataproc または BigQuery を使用するか、Apache Iceberg などのオープンソースのファイル形式を使用して実行できます。

- データは、ポリシータグと行アクセス ポリシーを使用して保護できます。

- 機械学習をテーブルに適用できます。

- ダッシュボードは、Looker Studio を使用してより詳細な分析を行うために、データから作成されます。

費用

分析レイクハウス ソリューションで使用される Google Cloud リソースの費用の見積もりについては、Google Cloud 料金計算ツールで事前に計算された見積もりをご覧ください。

見積もりを出発点として使用して、デプロイの費用を計算します。見積もりを変更して、ソリューションで使用するリソースに対して行う予定の構成の変更を反映できます。

事前に計算された見積もりは、次のような特定の要因に関する前提条件に基づいています。

- リソースがデプロイされている Google Cloud ロケーション。

- リソースが使用される時間。

始める前に

このソリューションをデプロイするには、まず Google Cloud プロジェクトと IAM 権限が必要です。

Google Cloud プロジェクトを作成または選択します。

ソリューションをデプロイするときに、リソースがデプロイされている Google Cloud プロジェクトを選択します。デプロイには、新しいプロジェクトを作成するか、既存のプロジェクトを使用できます。

新しいプロジェクトを作成する場合は、デプロイを始める前に作成します。新しいプロジェクトを使用すると、本番環境ワークロードに使用されるリソースなど、以前にプロビジョニングされたリソースとの競合を回避できます。

プロジェクトを作成するには、次の手順を完了します。

-

Ensure that you have the Project Creator IAM role

(

roles/resourcemanager.projectCreator). Learn how to grant roles. -

In the Google Cloud console, go to the project selector page.

-

Click Create project.

-

Name your project. Make a note of your generated project ID.

-

Edit the other fields as needed.

-

Click Create.

必要な IAM 権限を取得する

デプロイ プロセスを開始するには、次の表に示す Identity and Access Management(IAM)権限が必要です。

このソリューション用に新規プロジェクトを作成した場合は、そのプロジェクトに roles/owner 基本ロールが付与され、必要なすべての権限を持っています。roles/owner ロールがない場合は、これらの権限(またはこれらの権限を含むロール)の付与を管理者に依頼してください。

| 必要な IAM 権限 | 必要な権限を含む事前定義ロール |

|---|---|

|

Service Usage 管理者 ( roles/serviceusage.serviceUsageAdmin) |

|

サービス アカウント管理者 ( roles/iam.serviceAccountAdmin) |

|

プロジェクト IAM 管理者 ( roles/resourcemanager.projectIamAdmin) |

config.deployments.createconfig.deployments.list |

Cloud Infrastructure Manager 管理者 ( roles/config.admin) |

iam.serviceAccount.actAs |

サービス アカウント ユーザー ( roles/iam.serviceAccountUser) |

一時的なサービス アカウントの権限について

コンソールからデプロイ プロセスを開始すると、ユーザーに代わってソリューションをデプロイするために(また、必要に応じて後でデプロイを削除するために)サービス アカウントが作成されます。このサービス アカウントには、特定の IAM 権限が一時的に割り当てられます。つまり、ソリューションのデプロイと削除のオペレーションが完了すると、権限が自動的に取り消されます。ソリューションのデプロイを削除した後に、このガイドの後半で説明するように、サービス アカウントを削除することをおすすめします。

サービス アカウントに割り当てられたロールを確認する

Google Cloud プロジェクトや組織の管理者が必要とする場合に備え、各ロールを以下に示します。

roles/biglake.adminroles/bigquery.adminroles/compute.adminroles/datalineage.viewerroles/dataplex.adminroles/dataproc.adminroles/iam.serviceAccountAdminroles/iam.serviceAccountUserroles/resourcemanager.projectIamAdminroles/servicenetworking.serviceAgentroles/serviceusage.serviceUsageViewerroles/vpcaccess.adminroles/storage.adminroles/workflows.admin

ソリューションをデプロイする

このセクションでは、ソリューションのデプロイ プロセスについて説明します。

このソリューションを最小限の労力でデプロイできるように、Terraform 構成が GitHub で提供されています。Terraform 構成では、ソリューションに必要なすべてのGoogle Cloud リソースを定義しています。

次のいずれかの方法でソリューションをデプロイできます。

コンソールから: デフォルトの構成でソリューションを試して動作を確認する場合は、この方法を使用します。Cloud Build は、ソリューションに必要なすべてのリソースをデプロイします。デプロイされたソリューションが不要になった場合は、コンソールから削除できます。ソリューションのデプロイ後に作成したリソースは、個別に削除する必要があります。

このデプロイ方法を使用する場合、コンソールからデプロイするの手順に沿って操作します。

Terraform CLI を使用: このソリューションをカスタマイズする場合、または Infrastructure as Code(IaC)のアプローチを使用してリソースのプロビジョニングと管理を自動化する場合は、この方法を使用します。GitHub から Terraform 構成をダウンロードし、必要に応じてコードをカスタマイズしてから、Terraform CLI を使用してソリューションをデプロイします。ソリューションをデプロイした後も、引き続き Terraform を使用してソリューションを管理できます。

このデプロイ方法を使用するには、Terraform CLI を使用してデプロイするの手順に沿って操作します。

コンソールからデプロイする

事前構成済みのソリューションをデプロイするには、次の手順を完了します。

Google Cloud ジャンプ スタート ソリューションのカタログで、分析レイクハウス ソリューションに移動します。

ソリューションの概算費用やデプロイの推定時間など、ページに表示された情報を確認します。

ソリューションのデプロイを開始する準備ができたら、[デプロイ] をクリックします。

順を追って構成するペインが表示されます。

構成ペインの手順を実施します。

デプロイメントに入力する名前をメモします。この名前は、後でデプロイメントを削除するときに必要になります。

[デプロイ] をクリックすると、[ソリューションのデプロイ] ページが表示されます。このページの [ステータス] フィールドに「デプロイ中」が表示されます。

ソリューションがデプロイされるまで待ちます。

デプロイが失敗した場合、[ステータス] フィールドに「失敗」と表示されます。Cloud Build のログでエラーを診断できます。詳細については、コンソールからデプロイする際のエラーをご覧ください。

デプロイが完了すると、[ステータス] フィールドが [デプロイ済み] に変わります。

ソリューションを表示して使用するには、コンソールの [ソリューションのデプロイ] ページに戻ります。

- [アクション] メニューをクリックします。

- [Looker Studio ダッシュボードを表示] を選択して、ソリューションを使用して変換されたサンプルデータの上に構築されたダッシュボードを開きます。

- [BigQuery エディタを開く] を選択して、ソリューションのサンプルデータを使用してクエリを実行し、ML モデルを構築します。

- [Colab を表示する] を選択して、ノートブック環境でクエリを実行します。

このソリューションが不要になった場合は、デプロイメントを削除して、 Google Cloud リソースに対する課金が継続しないようにします。詳細については、デプロイメントを削除するをご覧ください。

Terraform CLI を使用してデプロイする

このセクションでは、Terraform CLI を使用してソリューションをカスタマイズする方法や、ソリューションのプロビジョニングと管理を自動化する方法について説明します。Terraform CLI を使用してデプロイするソリューションは、 Google Cloud コンソールの [ソリューションのデプロイ] ページに表示されません。

Terraform クライアントを設定する

Terraform は、Cloud Shell またはローカルホストで実行できます。このガイドでは、Terraform がプリインストールされ、 Google Cloudでの認証が構成されている Cloud Shell で Terraform を実行する方法について説明します。

このソリューションの Terraform コードは、GitHub リポジトリで入手できます。

Cloud Shell に GitHub リポジトリのクローンを作成します。

GitHub リポジトリを Cloud Shell にダウンロードするよう求めるメッセージが表示されます。

[確認] をクリックします。

別のブラウザタブで Cloud Shell が起動し、Cloud Shell 環境の

$HOME/cloudshell_openディレクトリに Terraform コードがダウンロードされます。Cloud Shell で、現在の作業ディレクトリが

$HOME/cloudshell_open/terraform-google-analytics-lakehouse/かどうかを確認します。このディレクトリには、ソリューションの Terraform 構成ファイルが含まれています。このディレクトリに移動する必要がある場合は、次のコマンドを実行します。cd $HOME/cloudshell_open/terraform-google-analytics-lakehouse/次のコマンドを実行して Terraform を初期化します。

terraform init次のメッセージが表示されるまで待ちます。

Terraform has been successfully initialized!

Terraform 変数を構成する

ダウンロードした Terraform コードには、要件に基づいてデプロイメントをカスタマイズするために使用できる変数が含まれています。たとえば、ソリューションをデプロイする Google Cloud プロジェクトとリージョンを指定できます。

現在の作業ディレクトリが

$HOME/cloudshell_open/terraform-google-analytics-lakehouse/であることを確認します。そうでない場合は、そのディレクトリに移動します。同じディレクトリに、

terraform.tfvarsという名前のテキスト ファイルを作成します。terraform.tfvarsファイルで次のコード スニペットをコピーし、必要な変数の値を設定します。- このコード スニペットにコメントとして記載されている手順を実施します。

- このコード スニペットには、値を設定する必要のある変数のみが含まれています。Terraform 構成には、デフォルト値を持つ他の変数が含まれています。すべての変数とデフォルト値を確認するには、

$HOME/cloudshell_open/terraform-google-analytics-lakehouse/ディレクトリにあるvariables.tfファイルをご覧ください。 terraform.tfvarsファイルで設定した各値が、variables.tfファイルで宣言されている変数の型と一致していることを確認します。たとえば、variables.tfファイル内の変数に定義されている型がboolの場合、その変数の値としてtrueまたはfalseをterraform.tfvarsファイル内で指定する必要があります。

# This is an example of the terraform.tfvars file. # The values in this file must match the variable types declared in variables.tf. # The values in this file override any defaults in variables.tf. # ID of the project in which you want to deploy the solution project_id = "PROJECT_ID" # Google Cloud region where you want to deploy the solution # Example: us-central1 region = "REGION" # Whether or not to enable underlying apis in this solution. # Example: true enable_apis = true # Whether or not to protect Cloud Storage and BigQuery resources from deletion when solution is modified or changed. # Example: false force_destroy = false

Terraform 構成を検証して確認する

現在の作業ディレクトリが

$HOME/cloudshell_open/terraform-google-analytics-lakehouse/であることを確認します。そうでない場合は、そのディレクトリに移動します。Terraform 構成にエラーがないことを確認します。

terraform validateコマンドからエラーが返された場合は、構成で必要な修正を行ってから、

terraform validateコマンドを再度実行します。コマンドで次のメッセージが返されるまで、この手順を繰り返します。Success! The configuration is valid.構成で定義されているリソースを確認します。

terraform plan前述のように変数定義ファイル(

terraform.tfvars)を作成しなかった場合、Terraform でデフォルト値のない変数の値の入力を求められます。必要な値を入力します。terraform planコマンドの出力に、構成の適用時に Terraform がプロビジョニングするリソースのリストが表示されます。変更を行う場合は、構成を編集してから、

terraform validateコマンドとterraform planコマンドを再度実行します。

リソースをプロビジョニングする

構成にこれ以上の変更が必要ない場合は、リソースをデプロイします。

現在の作業ディレクトリが

$HOME/cloudshell_open/terraform-google-analytics-lakehouse/であることを確認します。そうでない場合は、そのディレクトリに移動します。Terraform 構成を適用します。

terraform apply前述のように変数定義ファイル(

terraform.tfvars)を作成しなかった場合、Terraform でデフォルト値のない変数の値の入力を求められます。必要な値を入力します。作成されるリソースのリストが表示されます。

アクションの実行を求められたら、「

yes」と入力します。Terraform でデプロイの進行状況を示すメッセージが表示されます。

デプロイを完了できない場合、失敗の原因となったエラーが表示されます。エラー メッセージを確認し、構成を更新してエラーを修正します。次に、

terraform applyコマンドを再実行します。Terraform のエラーのトラブルシューティングについては、Terraform CLI を使用してソリューションをデプロイする際のエラーをご覧ください。すべてのリソースが作成されると、Terraform によって次のメッセージが表示されます。

Apply complete!Terraform の出力には、必要になる次の追加情報も表示されます。

- デプロイされたダッシュボードの Looker Studio の URL。

- サンプルクエリ用の BigQuery エディタを開くリンク。

- Colab チュートリアルを開くリンク。

次の例は、出力を示しています。

lookerstudio_report_url = "https://lookerstudio.google.com/reporting/create?c.reportId=79675b4f-9ed8-4ee4-bb35-709b8fd5306a&ds.ds0.datasourceName=vw_ecommerce&ds.ds0.projectId=${var.project_id}&ds.ds0.type=TABLE&ds.ds0.datasetId=gcp_lakehouse_ds&ds.ds0.tableId=view_ecommerce" bigquery_editor_url = "https://console.cloud.google.com/bigquery?project=my-cloud-project&ws=!1m5!1m4!6m3!1smy-cloud-project!2sds_edw!3ssp_sample_queries" lakehouse_colab_url = "https://colab.research.google.com/github/GoogleCloudPlatform/terraform-google-analytics-lakehouse/blob/main/assets/ipynb/exploratory-analysis.ipynb"ダッシュボードを表示して使用し、BigQuery でクエリを実行するには、前の手順で出力 URL をコピーし、新しいブラウザタブでその URL を開きます。

ダッシュボード、ノートブック、BigQuery エディタが新しいタブに表示されます。

このソリューションが不要になった場合は、デプロイメントを削除して、 Google Cloud リソースに対する課金が継続しないようにします。詳細については、デプロイメントを削除するをご覧ください。

ソリューションをカスタマイズする

このセクションでは、Terraform のデベロッパーが独自の技術的要件とビジネス要件を満たすために、分析レイクハウス ソリューションを変更するうえで使用できる情報を提供します。このセクションのガイダンスは、Terraform CLI を使用してソリューションをデプロイする場合にのみ該当します。

ソリューションがサンプルデータでどのように機能するかを確認したら、独自のデータを使用することもできます。独自のデータを使用するには、edw-raw-hash という Cloud Storage バケットに配置します。hash は、デプロイ中に生成されるランダムな 8 文字のセットです。Terraform コードは次の方法で変更できます。

- データセット ID。コードによって BigQuery データセットが作成されるときに、データに使用するデータセット ID が使用されるように Terraform コードを変更します。

- スキーマ。データの保存に使用する BigQuery テーブル ID を作成するように、Terraform コードを変更します。これには、BigQuery が Cloud Storage からデータを読み取れるように外部テーブル スキーマが含まれます。

- ゾーン。ビジネスニーズに合ったレイクゾーンを作成します(通常は、データ品質と使用状況に基づいて 2 階層または 3 階層のゾーンを作成します)。

- Looker ダッシュボード。Looker ダッシュボードを作成する Terraform コードを変更して、ダッシュボードに使用しているデータが反映されるようにします。

- PySpark ジョブ。Dataproc を使用して PySpark ジョブを実行するように Terraform コードを変更します。

以下に、一般的な分析レイクハウス オブジェクトを示します。これは、main.tf の Terraform サンプルコードを示しています。

-

BigQuery データセット: データベース オブジェクトをグループ化して保存するスキーマ。

resource "google_bigquery_dataset" "ds_edw" { project = module.project-services.project_id dataset_id = "DATASET_PHYSICAL_ID" friendly_name = "DATASET_LOGICAL_NAME" description = "DATASET_DESCRIPTION" location = "REGION" labels = var.labels delete_contents_on_destroy = var.force_destroy } -

BigQuery テーブル: BigQuery に保存されているデータ、または Cloud Storage に保存されているデータスキーマを表すデータベース オブジェクト。

resource "google_bigquery_table" "tbl_edw_taxi" { dataset_id = google_bigquery_dataset.ds_edw.dataset_id table_id = "TABLE_NAME" project = module.project-services.project_id deletion_protection = var.deletion_protection ... } -

BigQuery ストアド プロシージャ: 呼び出されたときに実行される 1 つ以上の SQL ステートメントを表すデータベース オブジェクト。たとえば、あるテーブルから別のテーブルにデータを変換したり、外部テーブルから標準テーブルにデータを読み込んだりします。

resource "google_bigquery_routine" "sp_sample_translation_queries" { project = module.project-services.project_id dataset_id = google_bigquery_dataset.ds_edw.dataset_id routine_id = "sp_sample_translation_queries" routine_type = "PROCEDURE" language = "SQL" definition_body = templatefile("${path.module}/assets/sql/sp_sample_translation_queries.sql", { project_id = module.project-services.project_id }) } -

Cloud Workflows ワークフロー: Workflows ワークフローは、特定の順序で実行されるステップの組み合わせを表します。これを使用すると、他の実行ステップとともにデータのセットアップやデータ変換を行えます。

resource "google_workflows_workflow" "copy_data" { name = "copy_data" project = module.project-services.project_id region = var.region description = "Copies data and performs project setup" service_account = google_service_account.workflows_sa.email source_contents = templatefile("${path.module}/src/yaml/copy-data.yaml", { public_data_bucket = var.public_data_bucket, textocr_images_bucket = google_storage_bucket.textocr_images_bucket.name, ga4_images_bucket = google_storage_bucket.ga4_images_bucket.name, tables_bucket = google_storage_bucket.tables_bucket.name, dataplex_bucket = google_storage_bucket.dataplex_bucket.name, images_zone_name = google_dataplex_zone.gcp_primary_raw.name, tables_zone_name = google_dataplex_zone.gcp_primary_staging.name, lake_name = google_dataplex_lake.gcp_primary.name }) }

ソリューションをカスタマイズするには、Cloud Shell で次の手順を完了します。

現在の作業ディレクトリが

$HOME/cloudshell_open/terraform-google-analytics-lakehouseであることを確認します。そうでない場合は、そのディレクトリに移動します。cd $HOME/cloudshell_open/terraform-google-analytics-lakehousemain.tfを開き、必要な変更を加えます。このようなカスタマイズが信頼性、セキュリティ、パフォーマンス、費用、オペレーションに及ぼす影響の詳細については、設計に関する推奨事項をご覧ください。

設計に関する推奨事項

このセクションでは、セキュリティ、信頼性、コスト、パフォーマンスの要件を満たすアーキテクチャを構築するために、分析レイクハウス ソリューションを使用する際の推奨事項について説明します。

レイクハウス ソリューションのスケーリングを開始するとき、クエリのパフォーマンスを向上させ、支出総額を削減する多数の方法を利用できます。これらの方法には、データの保存方法の変更、SQL クエリの変更、さまざまなテクノロジーを使用したクエリの実行方法の変更が含まれます。Spark ワークロードを最適化する方法の詳細については、本番環境向けの Dataproc のベスト プラクティスをご覧ください。

次の点にご注意ください。

- 設計を変更する前に、費用への影響を評価し、他の機能との潜在的なトレードオフを検討します。Google Cloud 料金計算ツールを使用すると、設計変更の費用への影響を評価できます。

- ソリューションの設計変更を実装するには、Terraform のコーディングに関する専門知識と、ソリューションで使用される Google Cloud サービスに関する高度な知識が必要です。

- Google 提供の Terraform 構成を変更してエラーが発生した場合は、GitHub で問題を作成します。GitHub の問題はベスト エフォート ベースで審査されます。これは、一般的な使用に関する質問を目的としたものではありません。

- Google Cloudで本番環境レベルの環境を設計して設定する方法について詳しくは、 Google Cloudのランディング ゾーンの設計と Google Cloud 設定のチェックリストをご覧ください。

ソリューションのデプロイを削除する

ソリューションのデプロイメントが不要になった場合は、作成したリソースに対して課金されないようにするため、デプロイメントを削除します。

コンソールからデプロイメントを削除する

この手順は、ソリューションをコンソールからデプロイした場合に実施します。

Google Cloud コンソールで、[ソリューションのデプロイメント] ページに移動します。

削除するデプロイメントが含まれているプロジェクトを選択します。

削除するデプロイメントを見つけます。

デプロイメントの行で、(アクション)アイコンをクリックし、[削除] を選択します。

行にアクション アイコンが表示されない場合は、スクロールしてください。

デプロイメントの名前を入力し、[確認] をクリックします。

[ステータス] フィールドに「削除中」が表示されます。

削除に失敗した場合は、デプロイメントの削除時のエラーのトラブルシューティング ガイダンスをご覧ください。

ソリューションに使用した Google Cloud プロジェクトが不要になった場合は、プロジェクトを削除できます。詳細については、省略可: プロジェクトを削除するをご覧ください。

Terraform CLI を使用してデプロイメントを削除する

Terraform CLI を使用してソリューションをデプロイした場合は、この手順を使用します。

Cloud Shell で、現在の作業ディレクトリが

$HOME/cloudshell_open/terraform-google-analytics-lakehouse/であることを確認します。そうでない場合は、そのディレクトリに移動します。Terraform によってプロビジョニングされたリソースを削除します。

terraform destroy破棄されるリソースのリストが表示されます。

アクションの実行を求められたら、「

yes」と入力します。進行状況を示すメッセージが表示されます。すべてのリソースが削除されると、次のメッセージが表示されます。

Destroy complete!削除に失敗した場合は、デプロイメントの削除時のエラーのトラブルシューティング ガイダンスをご覧ください。

ソリューションに使用した Google Cloud プロジェクトが不要になった場合は、プロジェクトを削除できます。詳細については、省略可: プロジェクトを削除するをご覧ください。

省略可: プロジェクトを削除する

ソリューションを新しい Google Cloud プロジェクトにデプロイした後、そのプロジェクトが不要になった場合は、次の手順で削除します。

- Google Cloud コンソールで [リソースの管理] ページに移動します。

- プロジェクト リストで、削除するプロジェクトを選択し、[削除] をクリックします。

- プロンプトでプロジェクト ID を入力し、[シャットダウン] をクリックします。

プロジェクトを保持する場合は、次のセクションで説明するように、このソリューション用に作成されたサービス アカウントを削除します。

省略可: サービス アカウントを削除する

ソリューションに使用したプロジェクトを削除した場合は、このセクションをスキップしてください。

このガイドの前半で説明したように、ソリューションをデプロイしたときに、ユーザーに代わってサービス アカウントが作成されました。このサービス アカウントには特定の IAM 権限が一時的に割り当てられました。ソリューションのデプロイと削除オペレーションが完了した後、権限は自動的に取り消されましたが、サービス アカウントは削除されません。このサービス アカウントを削除することをおすすめします。

Google Cloud コンソールからソリューションをデプロイした場合は、[ソリューションのデプロイメント] ページに移動します(すでにページが表示されている場合は、ブラウザを更新します)。サービス アカウントが削除されるように、バックグラウンドでプロセスがトリガーされます。特に操作を行う必要はありません。

Terraform CLI を使用してソリューションをデプロイした場合は、次の手順を完了します。

Google Cloud コンソールで、[サービス アカウント] ページに移動します。

ソリューションに使用したプロジェクトを選択します。

削除するサービス アカウントを選択します。

ソリューション用に作成されたサービス アカウントのメール ID は、次の形式になります。

goog-sc-DEPLOYMENT_NAME-NNN@PROJECT_ID.iam.gserviceaccount.comメール ID には次の値が含まれます。

- DEPLOYMENT_NAME: デプロイメントの名前。

- NNN: 3 桁のランダムな数字。

- PROJECT_ID: ソリューションをデプロイしたプロジェクトの ID。

[削除] をクリックします。

エラーのトラブルシューティングを行う

エラーを診断して解決するために実行できるアクションは、デプロイ方法とエラーの複雑さによって異なります。

コンソールからソリューションをデプロイする際のエラー

コンソールを使用してデプロイが失敗した場合は、次の操作を行います。

[ソリューションのデプロイ] ページに移動します。

デプロイが失敗した場合、[ステータス] フィールドに「失敗」と表示されます。

エラーの原因となったエラーの詳細を表示するには:

デプロイメントの行で、(アクション)をクリックします。

行にアクション アイコンが表示されない場合は、スクロールしてください。

[Cloud Build のログを表示する] を選択します。

Cloud Build のログを確認し、適切な措置を講じて失敗の原因となった問題を解決します。

Terraform CLI を使用してソリューションをデプロイする際のエラー

Terraform を使用したデプロイが失敗した場合、terraform

apply コマンドの出力には、問題を診断するために確認できるエラー メッセージが含まれます。

次のセクションの例では、Terraform の使用時に発生する可能性のあるデプロイエラーを示します。

「API が有効になっていない」エラー

プロジェクトを作成し、すぐに新しいプロジェクトでソリューションをデプロイすると、デプロイが失敗して次のようなエラーが発生することがあります。

Error: Error creating Network: googleapi: Error 403: Compute Engine API has not

been used in project PROJECT_ID before or it is disabled. Enable it by visiting

https://console.developers.google.com/apis/api/compute.googleapis.com/overview?project=PROJECT_ID

then retry. If you enabled this API recently, wait a few minutes for the action

to propagate to our systems and retry.

このエラーが発生した場合は、数分待ってから terraform apply コマンドを再度実行します。

「Cannot assign requested address」エラー

terraform apply コマンドを実行すると、cannot assign requested address エラーが発生し、次のようなメッセージが表示されることがあります。

Error: Error creating service account:

Post "https://iam.googleapis.com/v1/projects/PROJECT_ID/serviceAccounts:

dial tcp [2001:db8:ffff:ffff::5f]:443:

connect: cannot assign requested address

このエラーが発生した場合は、terraform apply コマンドを再度実行してください。

BigQuery または Looker Studio でのデータへのアクセスに関するエラー

Terraform プロビジョニング ステップの後に実行されるプロビジョニング ステップでは、環境にデータを読み込みます。Looker Studio ダッシュボードへのデータの読み込み中にエラーが発生した場合や、BigQuery の開始時にオブジェクトがない場合は、数分待ってからもう一度お試しください。

デプロイ削除時のエラー

デプロイメントを削除しようとして失敗することもあります。

- コンソールでソリューションをデプロイした後に、ソリューションによってプロビジョニングされたリソースを変更してからデプロイメントを削除しようとすると、削除が失敗することがあります。[ソリューションのデプロイ] ページの [ステータス] フィールドに「失敗」と表示され、Cloud Build のログにエラーの原因が表示されます。

- Terraform CLI を使用してソリューションをデプロイした後に、Terraform 以外のインターフェース(コンソールなど)を使用してリソースを変更し、デプロイメントを削除しようとすると、削除が失敗することがあります。

terraform destroyコマンドの出力にあるメッセージにエラーの原因が示されます。

エラーログとエラーの内容を確認し、エラーの原因となったリソースを特定して削除してから、もう一度デプロイメントを削除してみてください。

コンソールベースのデプロイメントが削除されず、Cloud Build ログを使用してエラーを診断できない場合は、Terraform CLI を使用してデプロイメントを削除できます。次のセクションをご覧ください。

Terraform CLI を使用してコンソールベースのデプロイメントを削除する

このセクションでは、コンソールからコンソールベースのデプロイメントを削除しようとしたときにエラーが発生した場合に、コンソールベースのデプロイメントを削除する方法について説明します。このアプローチでは、削除するデプロイメントの Terraform 構成をダウンロードし、Terraform CLI を使用してデプロイメントを削除します。

デプロイメントの Terraform コード、ログ、その他のデータが保存されているリージョンを特定します。このリージョンは、ソリューションのデプロイ時に選択したリージョンとは異なる場合があります。

Google Cloud コンソールで、[ソリューションのデプロイメント] ページに移動します。

削除するデプロイメントが含まれているプロジェクトを選択します。

デプロイメントのリストで、削除するデプロイメントの行を特定します。

「行の内容をすべて表示する」をクリックします。

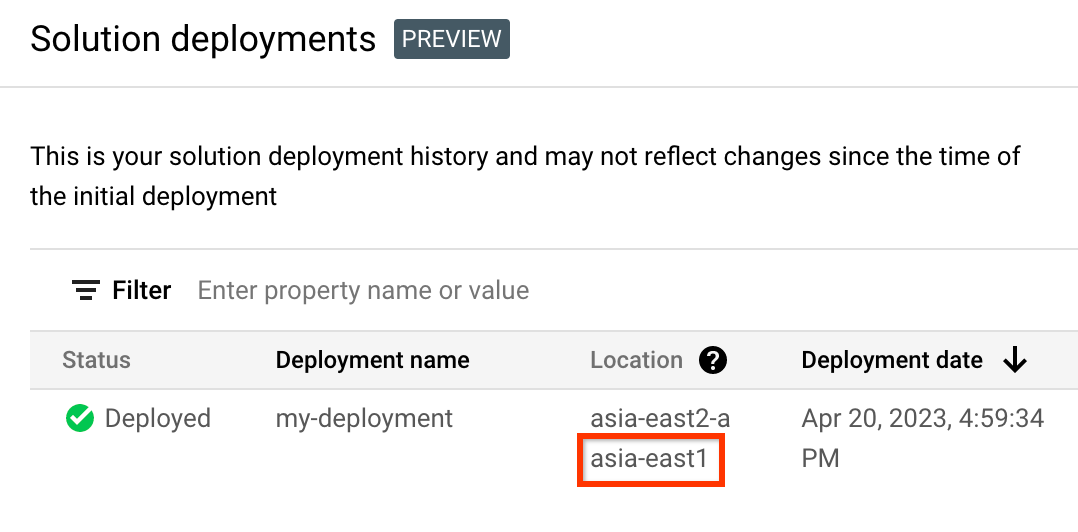

[場所] 列で、次の例でハイライトされているように、2 番目の場所をメモします。

In the Google Cloud console, activate Cloud Shell.

At the bottom of the Google Cloud console, a Cloud Shell session starts and displays a command-line prompt. Cloud Shell is a shell environment with the Google Cloud CLI already installed and with values already set for your current project. It can take a few seconds for the session to initialize.

プロジェクト ID、リージョン、削除するデプロイメントの名前の環境変数を作成します。

export REGION="REGION" export PROJECT_ID="PROJECT_ID" export DEPLOYMENT_NAME="DEPLOYMENT_NAME"これらのコマンドで、次のように置き換えます。

- REGION: この手順でメモした場所。

- PROJECT_ID: ソリューションをデプロイしたプロジェクトの ID。

- DEPLOYMENT_NAME: 削除するデプロイメントの名前。

削除するデプロイメントの最新リビジョンの ID を取得します。

export REVISION_ID=$(curl \ -H "Authorization: Bearer $(gcloud auth print-access-token)" \ -H "Content-Type: application/json" \ "https://config.googleapis.com/v1alpha2/projects/${PROJECT_ID}/locations/${REGION}/deployments/${DEPLOYMENT_NAME}" \ | jq .latestRevision -r) echo $REVISION_ID出力は次のようになります。

projects/PROJECT_ID/locations/REGION/deployments/DEPLOYMENT_NAME/revisions/r-0デプロイメントの Terraform 構成の Cloud Storage のロケーションを取得します。

export CONTENT_PATH=$(curl \ -H "Authorization: Bearer $(gcloud auth print-access-token)" \ -H "Content-Type: application/json" \ "https://config.googleapis.com/v1alpha2/${REVISION_ID}" \ | jq .applyResults.content -r) echo $CONTENT_PATHこのコマンドの出力例を次に示します。

gs://PROJECT_ID-REGION-blueprint-config/DEPLOYMENT_NAME/r-0/apply_results/contentCloud Storage から Cloud Shell に Terraform 構成をダウンロードします。

gcloud storage cp $CONTENT_PATH $HOME --recursive cd $HOME/content/次の例に示すように、

Operation completedメッセージが表示されるまで待ちます。Operation completed over 45 objects/268.5 KiBTerraform を初期化します。

terraform init次のメッセージが表示されるまで待ちます。

Terraform has been successfully initialized!デプロイされたリソースを削除します。

terraform destroy破棄されるリソースのリストが表示されます。

宣言されていない変数に関する警告が表示された場合は、警告を無視してください。

アクションの実行を求められたら、「

yes」と入力します。進行状況を示すメッセージが表示されます。すべてのリソースが削除されると、次のメッセージが表示されます。

Destroy complete!デプロイメント アーティファクトを削除します。

curl -X DELETE \ -H "Authorization: Bearer $(gcloud auth print-access-token)" \ -H "Content-Type: application/json" \ "https://config.googleapis.com/v1alpha2/projects/${PROJECT_ID}/locations/${REGION}/deployments/${DEPLOYMENT_NAME}?force=true&delete_policy=abandon"数秒待ってから、デプロイメント アーティファクトが削除されたことを確認します。

curl -H "Authorization: Bearer $(gcloud auth print-access-token)" \ -H "Content-Type: application/json" \ "https://config.googleapis.com/v1alpha2/projects/${PROJECT_ID}/locations/${REGION}/deployments/${DEPLOYMENT_NAME}" \ | jq .error.message出力に

nullと表示されている場合は、数秒待ってから、もう一度コマンドを実行します。デプロイメント アーティファクトが削除されると、次のようなメッセージが表示されます。

Resource 'projects/PROJECT_ID/locations/REGION/deployments/DEPLOYMENT_NAME' was not found- ドキュメント、コンソール内チュートリアル、またはソリューションについては、このページの [フィードバックを送信] ボタンを使用してください。

- Terraform コードを変更していない場合は、GitHub リポジトリで問題を作成します。GitHub の問題はベスト エフォート ベースで調査します。これは、一般的な使用に関する質問を目的としたものではありません。

- ソリューションで使用されているプロダクトに関する問題については、Cloud カスタマーケアにお問い合わせください。

- Dataplex Universal Catalog を使用してデータレイクを作成する

- Apache Iceberg 用の BigLake 外部テーブルを作成する

- Google Cloudで Apache Spark を使用する

- BigQuery について学習する

フィードバックを送信する

ジャンプ スタート ソリューションは情報提供のみを目的としており、正式にサポートされているプロダクトではありません。Google は、予告なくソリューションを変更または削除する場合があります。

エラーのトラブルシューティングを行うには、Cloud Build のログと Terraform の出力を確認します。

フィードバックを送信する場合は、次の操作を行います。