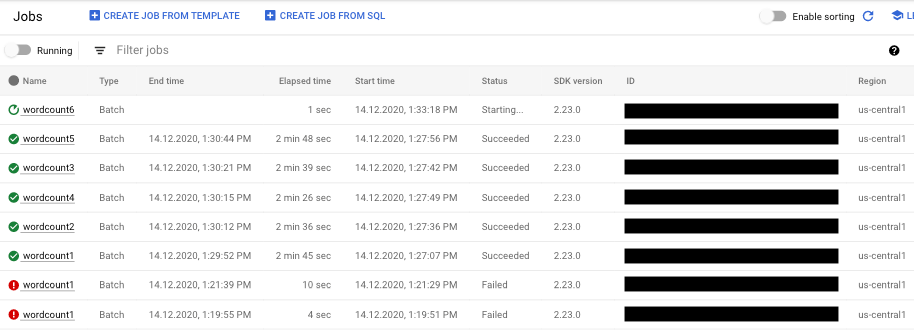

Eine Liste Ihrer Dataflow-Jobs finden Sie in der Google Cloud Console auf der Seite Dataflow > Jobs.

Eine Liste der Dataflow-Jobs mit ihrem Status wird angezeigt.

Ein Job kann folgende Statuswerte haben:

- –: Die Monitoring-Oberfläche hat noch keinen Status vom Dataflow-Dienst erhalten.

- Aktiv: Der Job wird ausgeführt.

- Starting... (Wird gestartet): Der Job ist erstellt, das System benötigt jedoch vor dem Start noch etwas Vorbereitungszeit.

- In der Warteschlange: Entweder wird ein FlexRS-Job in die Warteschlange gestellt oder ein Flex-Vorlagenjob gestartet (was mehrere Minuten in Anspruch nehmen kann).

- Canceling... (Wird abgebrochen): Der Job wird gerade abgebrochen.

- Abgebrochen: Der Job wurde abgebrochen.

- Draining… (Draining läuft…): Der Job wird gerade per Drain beendet.

- Draining angewendet: Der Job wird per Drain beendet.

- Updating… (Wird aktualisiert…): Der Job wird gerade aktualisiert.

- Aktualisiert: Der Job wurde aktualisiert.

- Succeeded (Erfolgreich): Der Job wurde erfolgreich abgeschlossen.

- Failed (Fehlgeschlagen): Der Job konnte nicht abgeschlossen werden.

Auf Jobvisualisierer zugreifen

Klicken Sie auf der Dataflow-Monitoring-Oberfläche auf den Jobnamen, um auf Diagramme für das Monitoring Ihres Jobs zuzugreifen. Die Seite Jobdetails wird mit folgenden Informationen angezeigt:

- Jobgrafik: die visuelle Darstellung Ihrer Pipeline

- Ausführungsdetails: Tool zur Optimierung der Pipeline-Leistung

- Jobmesswerte: Messwerte zur Ausführung des Jobs

- Kosten: Messwerte zu den geschätzten Kosten Ihres Jobs

- Autoscaling: Messwerte im Zusammenhang mit Autoscaling-Ereignissen für Streamingjobs

- Bereich „Jobinfo“: beschreibende Informationen zu Ihrer Pipeline

- Job-Logs: vom Dataflow-Dienst auf Jobebene generierte Logs

- Worker-Logs: vom Dataflow-Dienst auf Worker-Ebene generierte Logs

- Diagnose: Tabelle, in der angezeigt wird, wo Fehler in der ausgewählten Zeitachse aufgetreten sind, sowie mögliche Empfehlungen für Ihre Pipeline

- Datenstichprobe: Tool, mit dem Sie die Daten bei jedem Schritt einer Pipeline beobachten können.

Auf der Seite mit den Jobdetails können Sie die Jobansicht über die Tabs Jobdiagramm, Ausführungsdetails, Jobmesswerte, Kosten und Autoscaling wechseln.

Jobs mit der Google Cloud CLI auflisten

Sie können auch die Google Cloud CLI verwenden, um eine Liste Ihrer Dataflow-Jobs abzurufen.

Verwenden Sie den Befehl dataflow jobs list, um die Dataflow-Jobs in Ihrem Projekt aufzulisten:

gcloud dataflow jobs list

Der Befehl gibt eine Liste Ihrer aktuellen Jobs zurück. Hier ein Beispiel für eine Ausgabe:

ID NAME TYPE CREATION_TIME STATE REGION 2015-06-03_16_39_22-4020553808241078833 wordcount-janedoe-0603233849 Batch 2015-06-03 16:39:22 Done us-central1 2015-06-03_16_38_28-4363652261786938862 wordcount-johndoe-0603233820 Batch 2015-06-03 16:38:28 Done us-central1 2015-05-21_16_24_11-17823098268333533078 bigquerytornadoes-johndoe-0521232402 Batch 2015-05-21 16:24:11 Done europe-west1 2015-05-21_13_38_06-16409850040969261121 bigquerytornadoes-johndoe-0521203801 Batch 2015-05-21 13:38:06 Done us-central1 2015-05-21_13_17_18-18349574013243942260 bigquerytornadoes-johndoe-0521201710 Batch 2015-05-21 13:17:18 Done europe-west1 2015-05-21_12_49_37-9791290545307959963 wordcount-johndoe-0521194928 Batch 2015-05-21 12:49:37 Done us-central1 2015-05-20_15_54_51-15905022415025455887 wordcount-johndoe-0520225444 Batch 2015-05-20 15:54:51 Failed us-central1 2015-05-20_15_47_02-14774624590029708464 wordcount-johndoe-0520224637 Batch 2015-05-20 15:47:02 Done us-central1

Weitere Informationen zu einem Job erhalten Sie mit dem Befehl dataflow jobs describe:

gcloud dataflow jobs describe JOB_ID

Ersetzen Sie JOB_ID durch den Job ID. Die Ausgabe dieses Befehls sieht in etwa so aus:

createTime: '2015-02-09T19:39:41.140Z' currentState: JOB_STATE_DONE currentStateTime: '2015-02-09T19:56:39.510Z' id: 2015-02-09_11_39_40-15635991037808002875 name: tfidf-bchambers-0209193926 projectId: google.com:clouddfe type: JOB_TYPE_BATCH

Führen Sie den Befehl mit der Option --format=json aus, um das Ergebnis in JSON zu formatieren:

gcloud --format=json dataflow jobs describe JOB_ID

Dataflow-Jobs aus einer Liste archivieren (ausblenden)

Wenn Sie einen Dataflow-Job archivieren, wird der Job aus der Liste der Jobs auf der Dataflow-Seite Jobs in der Console entfernt. Der Job wird in eine archivierte Jobliste verschoben. Sie können nur abgeschlossene Jobs archivieren, einschließlich der Jobs in den folgenden Status:

JOB_STATE_CANCELLEDJOB_STATE_DRAINEDJOB_STATE_DONEJOB_STATE_FAILEDJOB_STATE_UPDATED

Weitere Informationen zum Prüfen dieser Status finden Sie unter Abschluss des Dataflow-Jobs.

Informationen zur Fehlerbehebung beim Archivieren von Jobs finden Sie unter Fehler in Dataflow archivieren unter „Fehlerbehebung bei Dataflow-Fehlern“.

Alle archivierten Jobs werden nach einer Aufbewahrungsfrist von 30 Tagen gelöscht.

Job archivieren

Führen Sie die folgenden Schritte aus, um einen abgeschlossenen Job aus der Hauptjobliste auf der Dataflow-Seite Jobs zu entfernen.

Console

Rufen Sie in der Google Cloud Console die Dataflow-Seite Jobs auf.

Eine Liste der Dataflow-Jobs mit ihrem Status wird angezeigt.

Wählen Sie einen Job aus.

Klicken Sie auf der Seite Jobdetails auf Archivieren. Wenn der Job nicht abgeschlossen wurde, ist die Option Archivieren nicht verfügbar.

REST

Verwenden Sie die Methode projects.locations.jobs.update, um einen Job mit der API zu archivieren.

In dieser Anfrage müssen Sie ein aktualisiertes JobMetadata-Objekt angeben. Verwenden Sie im JobMetadata.userDisplayProperties-Objekt das Schlüssel/Wert-Paar "archived":"true".

Zusätzlich zum aktualisierten JobMetadata-Objekt muss Ihre API-Anfrage auch den Abfrageparameter updateMask in der Anfrage-URL enthalten:

https://dataflow.googleapis.com/v1b3/[...]/jobs/JOB_ID/?updateMask=job_metadata.user_display_properties.archived

Ersetzen Sie diese Werte in den folgenden Anfragedaten:

- PROJECT_ID: Ihre Projekt-ID.

- REGION: eine Dataflow-Region

- JOB_ID: die ID Ihres Dataflow-Jobs.

HTTP-Methode und URL:

PUT https://dataflow.googleapis.com/v1b3/projects/PROJECT_ID/locations/REGION/jobs/JOB_ID/?updateMask=job_metadata.user_display_properties.archived

JSON-Text der Anfrage:

{

"job_metadata": {

"userDisplayProperties": {

"archived": "true"

}

}

}

Wenn Sie die Anfrage senden möchten, wählen Sie eine der folgenden Optionen aus:

curl

Speichern Sie den Anfragetext in einer Datei mit dem Namen request.json und führen Sie den folgenden Befehl aus:

curl -X PUT \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "Content-Type: application/json; charset=utf-8" \

-d @request.json \

"https://dataflow.googleapis.com/v1b3/projects/PROJECT_ID/locations/REGION/jobs/JOB_ID/?updateMask=job_metadata.user_display_properties.archived"

PowerShell

Speichern Sie den Anfragetext in einer Datei mit dem Namen request.json und führen Sie den folgenden Befehl aus:

$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred" }

Invoke-WebRequest `

-Method PUT `

-Headers $headers `

-ContentType: "application/json; charset=utf-8" `

-InFile request.json `

-Uri "https://dataflow.googleapis.com/v1b3/projects/PROJECT_ID/locations/REGION/jobs/JOB_ID/?updateMask=job_metadata.user_display_properties.archived" | Select-Object -Expand Content

Sie sollten eine JSON-Antwort ähnlich wie diese erhalten:

{

"id": "JOB_ID",

"projectId": "PROJECT_ID",

"currentState": "JOB_STATE_DONE",

"currentStateTime": "2025-05-20T20:54:41.651442Z",

"createTime": "2025-05-20T20:51:06.031248Z",

"jobMetadata": {

"userDisplayProperties": {

"archived": "true"

}

},

"startTime": "2025-05-20T20:51:06.031248Z"

}

gcloud

Mit diesem Befehl wird ein einzelner Job archiviert. Der Job muss sich in einem Endzustand befinden, damit er archiviert werden kann. Andernfalls wird die Anfrage abgelehnt. Nachdem Sie den Befehl gesendet haben, müssen Sie bestätigen, dass Sie ihn ausführen möchten.

Ersetzen Sie folgende Werte, bevor sie einen der Befehlsdaten verwenden:

JOB_ID: Die ID des Dataflow-Jobs, den Sie archivieren möchten.REGION: Optional. Die Dataflow-Region Ihres Jobs.

Führen Sie folgenden Befehl aus:

Linux, macOS oder Cloud Shell

gcloud dataflow jobs archive JOB_ID --region=REGION_ID

Windows (PowerShell)

gcloud dataflow jobs archive JOB_ID --region=REGION_ID

Windows (cmd.exe)

gcloud dataflow jobs archive JOB_ID --region=REGION_ID

Sie sollten eine Antwort ähnlich der folgenden erhalten:

Archived job [JOB_ID].

createTime: '2025-06-29T11:00:02.432552Z'

currentState: JOB_STATE_DONE

currentStateTime: '2025-06-29T11:04:25.125921Z'

id: JOB_ID

jobMetadata:

userDisplayProperties:

archived: 'true'

projectId: PROJECT_ID

startTime: '2025-06-29T11:00:02.432552Z'

Archivierte Jobs ansehen und wiederherstellen

Führen Sie die folgenden Schritte aus, um archivierte Jobs aufzurufen oder archivierte Jobs in der Hauptjobliste auf der Dataflow-Seite Jobs wiederherzustellen.

Console

Rufen Sie in der Google Cloud Console die Dataflow-Seite Jobs auf.

Klicken Sie auf den Schalter Archiviert. Eine Liste archivierter Dataflow-Jobs wird angezeigt.

Wählen Sie einen Job aus.

Klicken Sie auf der Seite Jobdetails auf Wiederherstellen, um den Job in der Hauptliste der Jobs auf der Dataflow-Seite Jobs wiederherzustellen.

REST

Verwenden Sie die Methode projects.locations.jobs.update, um einen archivierten Job mithilfe der API wiederherzustellen.

In dieser Anfrage müssen Sie ein aktualisiertes JobMetadata-Objekt angeben. Verwenden Sie im JobMetadata.userDisplayProperties-Objekt das Schlüssel/Wert-Paar "archived":"false".

Zusätzlich zum aktualisierten JobMetadata-Objekt muss Ihre API-Anfrage auch den Abfrageparameter updateMask in der Anfrage-URL enthalten:

https://dataflow.googleapis.com/v1b3/[...]/jobs/JOB_ID/?updateMask=job_metadata.user_display_properties.archived

Ersetzen Sie diese Werte in den folgenden Anfragedaten:

- PROJECT_ID: Ihre Projekt-ID.

- REGION: eine Dataflow-Region

- JOB_ID: die ID Ihres Dataflow-Jobs.

HTTP-Methode und URL:

PUT https://dataflow.googleapis.com/v1b3/projects/PROJECT_ID/locations/REGION/jobs/JOB_ID/?updateMask=job_metadata.user_display_properties.archived

JSON-Text der Anfrage:

{

"job_metadata": {

"userDisplayProperties": {

"archived": "false"

}

}

}

Wenn Sie die Anfrage senden möchten, wählen Sie eine der folgenden Optionen aus:

curl

Speichern Sie den Anfragetext in einer Datei mit dem Namen request.json und führen Sie den folgenden Befehl aus:

curl -X PUT \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "Content-Type: application/json; charset=utf-8" \

-d @request.json \

"https://dataflow.googleapis.com/v1b3/projects/PROJECT_ID/locations/REGION/jobs/JOB_ID/?updateMask=job_metadata.user_display_properties.archived"

PowerShell

Speichern Sie den Anfragetext in einer Datei mit dem Namen request.json und führen Sie den folgenden Befehl aus:

$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred" }

Invoke-WebRequest `

-Method PUT `

-Headers $headers `

-ContentType: "application/json; charset=utf-8" `

-InFile request.json `

-Uri "https://dataflow.googleapis.com/v1b3/projects/PROJECT_ID/locations/REGION/jobs/JOB_ID/?updateMask=job_metadata.user_display_properties.archived" | Select-Object -Expand Content

Sie sollten eine JSON-Antwort ähnlich wie diese erhalten:

{

"id": "JOB_ID",

"projectId": "PROJECT_ID",

"currentState": "JOB_STATE_DONE",

"currentStateTime": "2025-05-20T20:54:41.651442Z",

"createTime": "2025-05-20T20:51:06.031248Z",

"jobMetadata": {

"userDisplayProperties": {

"archived": "false"

}

},

"startTime": "2025-05-20T20:51:06.031248Z"

}