このドキュメントでは、 Google Cloud コンソール、Google Cloud CLI、Logging API を使用して Cloud Logging バケットを作成して管理する方法について説明します。また、Google Cloud プロジェクト レベルでログバケットを作成して管理する手順についても説明します。フォルダまたは組織のレベルではログバケットを作成できません。Cloud Logging は、フォルダと組織のレベルで _Default と _Required のバケットを自動的に作成します。

ログバケットをアップグレードすると、ログ分析を使用できるようになります。ログ分析を使用すると、ログデータに対して SQL クエリを実行し、アプリケーション、セキュリティ、ネットワークの問題をトラブルシューティングできます。

BigQuery を使用してログデータを分析するには、次の 2 つの方法があります。

ログ分析を使用するようにログバケットをアップグレードし、リンクされた BigQuery データセットを作成する。このシナリオでは、ログデータの保存は Logging が行いますが、ログデータの読み取りは BigQuery で行うことができます。

ログエントリを BigQuery にエクスポートする。このシナリオでは、シンクの作成はユーザーが行う必要がありますが、データの保存と管理は BigQuery が行います。パーティション分割テーブルも使用できます。

ログデータが BigQuery で利用可能になると、BigQuery に保存されている他のデータとログデータを結合し、Looker Studio や Looker などの他のツールからアクセスできるようになります。

バケットのコンセプトの概要については、転送と保存の概要: ログバケットをご覧ください。

このドキュメントでは、顧客管理の暗号鍵(CMEK)を使用するログバケットの作成方法については説明しません。このトピックの詳細については、ログストレージに CMEK を構成するをご覧ください。

始める前に

ログバケットを使用する前に、次のことを行う必要があります。

- Google Cloud プロジェクトを構成します。

-

Verify that billing is enabled for your Google Cloud project.

-

ログバケットの作成、アップグレード、リンクに必要な権限を取得するには、プロジェクトに対するログ構成書き込み(

roles/logging.configWriter)の IAM ロールを付与するように管理者へ依頼してください。ロールの付与については、プロジェクト、フォルダ、組織に対するアクセス権の管理をご覧ください。必要な権限は、カスタムロールや他の事前定義ロールから取得することもできます。

権限とロールの完全なリストについては、IAM によるアクセス制御をご覧ください。

- 省略可: BigQuery を使用してログバケットに保存されているデータを表示するには、次の操作を行います。

- BigQuery API が有効になっていることを確認します。API が有効になっていることを確認するには、使用可能なサービスを一覧表示します。

- 自身の Identity and Access Management ロールに、リンクされたデータセットを作成できる権限が含まれている必要があります。詳細については、リンクされた BigQuery データセットに対する権限をご覧ください。

-

- ログの保存がサポートされているリージョンを確認します。

-

Select the tab for how you plan to use the samples on this page:

Console

When you use the Google Cloud console to access Google Cloud services and APIs, you don't need to set up authentication.

gcloud

In the Google Cloud console, activate Cloud Shell.

At the bottom of the Google Cloud console, a Cloud Shell session starts and displays a command-line prompt. Cloud Shell is a shell environment with the Google Cloud CLI already installed and with values already set for your current project. It can take a few seconds for the session to initialize.

REST

このページの REST API サンプルをローカル開発環境で使用するには、gcloud CLI に指定した認証情報を使用します。

Google Cloud CLI をインストールします。 インストール後、次のコマンドを実行して Google Cloud CLI を初期化します。

gcloud init外部 ID プロバイダ(IdP)を使用している場合は、まず連携 ID を使用して gcloud CLI にログインする必要があります。

詳細については、 Google Cloud 認証ドキュメントの REST を使用して認証するをご覧ください。

- Google Cloud CLI または Cloud Logging API を使用してログバケットを作成または管理する場合は、

LogBucketのフォーマット要件を確認してください。バケットを作成する

Google Cloud プロジェクトあたり最大 100 個のバケットを作成できます。

Google Cloud プロジェクトにユーザー定義のログバケットを作成するには、次の操作を行います。

Google Cloud コンソール

Google Cloud プロジェクトにログバケットを作成するには、次の操作を行います。

-

Google Cloud コンソールで、[ログストレージ] ページに移動します。

このページを検索バーで検索する場合は、小見出しが「Logging」の結果を選択します。

[ログバケットを作成] をクリックします。

バケットの名前と説明を入力します。

省略可: ログ分析を使用できるように、バケットをアップグレードします。

[アップグレードして Log Analytics を使用する] を選択します。

ログ分析を使用するようにバケットをアップグレードすると、[ログ分析] ページで SQL クエリを使用してログをクエリできます。ログ エクスプローラでログを引き続き表示することもできます。

省略可: BigQuery でログを表示するには、[このバケットにリンクする新しい BigQuery データセットを作成する] を選択して、一意のデータセット名を入力します。

このオプションを選択すると、BigQuery はログバケットに保存されているデータを読み取ることができます。これで、BigQuery インターフェースでクエリして、ログデータを結合したり、Looker Studio や Looker などの他のツールからデータにアクセスできるようになりました。

省略可: ログストレージのリージョンを選択するには、[ログバケットのリージョンを選択] メニューをクリックしてリージョンを選択します。リージョンを選択しない場合は、

globalリージョンが使用されます。つまり、ログはサポートされている任意のリージョンに物理的に配置されます。省略可: バケット内のログにカスタム保持期間を設定するには、[次] をクリックします。

[保持期間] フィールドに、Cloud Logging でログを保持する日数を入力します(1~3,650 日)。保持期間をカスタマイズしない場合、デフォルトの

30 daysになります。バケットを作成した後にバケットを更新して、カスタム保持を適用するともできます。

[バケットを作成] をクリックします。

これらのオプションが選択されている場合は、ログバケットの作成後、Logging によってバケットがアップグレードされ、データセット リンクが作成されます。

これらの処理が完了するまでにしばらく時間がかかることがあります。

gcloud

ログバケットのみを作成するには、

gcloud logging buckets createコマンドを実行します。ログ分析を使用するようにログバケットをアップグレードする場合は、--enable-analyticsフラグと--asyncフラグを指定し、変数 LOCATION がサポートされているリージョンに設定されていることを確認します。gcloud logging buckets create BUCKET_ID --location=LOCATION --enable-analytics --async OPTIONAL_FLAGS

--asyncフラグを使用して、コマンドを非同期にします。非同期メソッドからは、メソッドの進行状況に関する情報が格納されているOperationオブジェクトが返されます。メソッドが完了すると、Operationオブジェクトにステータスが含まれます。詳細については、非同期 API メソッドをご覧ください。ログ分析を使用するようにログバケットをアップグレードしない場合は、

--enable-analyticsフラグと--asyncフラグを省略します。たとえば、

globalリージョンで BUCKET_IDmy-bucketのバケットを作成する場合、コマンドは次のようになります。gcloud logging buckets create my-bucket --location global --description "My first bucket"

たとえば、

globalのロケーションに BUCKET_IDmy-upgraded-bucketのバケットを作成し、ログ分析を使用するようにログバケットをアップグレードする場合、コマンドは次のようになります。gcloud logging buckets create my-upgraded-bucket --location global \ --description "My first upgraded bucket" \ --enable-analytics --retention-days=45REST

バケットを作成するには、

projects.locations.buckets.createメソッドまたはprojects.locations.buckets.createAsyncメソッドを使用します。次のように、メソッドの引数を準備します。バケットを作成するリソース(

projects/PROJECT_ID/locations/LOCATION)をparentパラメータに設定します。変数 LOCATION には、ログを保存するリージョンを指定します。

たとえば、リージョン

globalにプロジェクトmy-projectのバケットを作成する場合、parentパラメータはprojects/my-project/locations/globalのようになります。bucketIdパラメータを設定します。例:my-bucket次のいずれかを行います。

ログバケットを作成して、ログ分析を使用するようにログバケットをアップグレードするには:

LogBucket.analyticsEnabledブール値をtrueに設定します。非同期メソッド

projects.locations.buckets.createAsyncを呼び出してバケットを作成します。非同期メソッドのレスポンスは、

Operationオブジェクトです。このオブジェクトには、メソッドの進行状況に関する情報が格納されています。メソッドが完了すると、Operationオブジェクトにステータスが含まれます。詳細については、非同期 API メソッドをご覧ください。createAsyncメソッドが完了するまでに数分かかります。このメソッドでは、analyticsEnabledブール値がtrueに設定されていても、エラー メッセージが生成されず、エラーも発生しません。

そうでない場合は、同期メソッド

projects.locations.buckets.createを呼び出してバケットを作成します。

バケットを作成したら、ログエントリをバケットに転送するシンクを作成し、ログビューを構成して、新しいバケットのログにアクセスできるユーザーとアクセス可能なログを制御します。バケットを更新して、カスタム保持と制限付きフィールドを構成することもできます。

ログバケットに保存されているログの量を追跡する

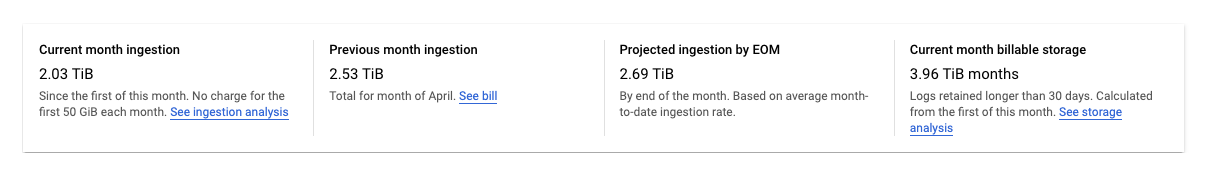

Google Cloud コンソールの [ログストレージ] ページには、ログバケットに保存されているログデータの量が表示されます。

Google Cloud コンソールで、[ログストレージ] ページに移動します。

このページを検索バーで検索する場合は、小見出しが「Logging」の結果を選択します。

[ログストレージ] ページに、Google Cloud プロジェクトの統計情報の概要が表示されます。

次の統計情報が報告されます。

今月の取り込み: 今月の初日以降にGoogle Cloud プロジェクトでログバケットに保存されたログデータの量。

前月の取り込み: 前月にGoogle Cloud プロジェクトがログバケットに保存したログデータの量。

予想される取り込み(月の終わりまで): 今月の初日から月末までにGoogle Cloud プロジェクトでログバケットに保存されるログデータの推定量(現在の使用量に基づいて推測)。

当月の課金対象ストレージ: 30 日以上保持されている課金対象のログデータの量。

上記の統計情報には、

_Requiredバケット内のログは含まれません。このバケットのログを除外したり、無効にすることはできません。Google Cloud コンソールの [ログルーター] ページにあるツールを使用すると、毎月の割り当てを超えるログバケットへのログの保存やストレージに対する料金を最小限に抑えることができます。以下の処理を行うことができます。

- バケットレベルでのログの保存を無効にする。

- 特定のログエントリをログバケットに保存しないようにする。

詳細については、シンクを管理するをご覧ください。

バケットを管理する

このセクションでは、Google Cloud CLI または Google Cloud コンソールでログバケットを管理する方法について説明します。

バケットを更新する

バケットのプロパティ(説明や保持期間など)を更新するには、次の操作を行います。Google Cloud コンソール

バケットのプロパティを更新するには、次の操作を行います。

-

Google Cloud コンソールで、[ログストレージ] ページに移動します。

このページを検索バーで検索する場合は、小見出しが「Logging」の結果を選択します。

更新するバケットで、[more_vertその他] をクリックします。

[バケットを編集] を選択します。

必要に応じてバケットを編集します。

[バケットを更新] をクリックします。

gcloud

バケットのプロパティを更新するには、

gcloud logging buckets updateコマンドを実行します。gcloud logging buckets update BUCKET_ID --location=LOCATION UPDATED_ATTRIBUTES

例:

gcloud logging buckets update my-bucket --location=global --description "Updated description"

REST

バケットのプロパティを更新するには、Logging API で

projects.locations.buckets.patchを使用します。ログ分析を使用できるようにログバケットをアップグレードする

ログ分析を使用するようにバケットをアップグレードすると、受信した新しいログエントリをログ分析インターフェースで分析できるようになります。また、Cloud Logging はバックフィル オペレーションを開始します。これにより、アップグレード前に書き込まれた古いログエントリを分析できます。バックフィル処理には数時間かかることがあります。バケットのアップグレード オペレーションは元に戻せません。

ログ分析を使用するように既存のバケットをアップグレードする場合は、次の要件を満たしている必要があります。

- ログバケットは Google Cloud プロジェクト レベルで作成されている。

_Requiredバケットでない限り、ログバケットのロックが解除されている。バケットの更新が保留中でない。

Google Cloud コンソール

ログ分析を使用するように既存のバケットをアップグレードするには、次の操作を行います。

-

Google Cloud コンソールで、[ログストレージ] ページに移動します。

このページを検索バーで検索する場合は、小見出しが「Logging」の結果を選択します。

アップグレードするバケットを見つけます。

[Log Analytics を使用可能] 列に「アップグレード」と表示されたら、ログバケットをアップグレードしてログ分析を使用できます。[アップグレード] をクリックします。

ダイアログが開きます。[確認] をクリックします。

gcloud

ログ分析を使用するようにログバケットをアップグレードするには、

gcloud logging buckets updateコマンドを実行します。--enable-analyticsフラグを設定する必要があります。また、--asyncフラグを含めることをおすすめします。gcloud logging buckets update BUCKET_ID --location=LOCATION --enable-analytics --async

--asyncフラグを使用して、コマンドを非同期にします。非同期メソッドからは、メソッドの進行状況に関する情報が格納されているOperationオブジェクトが返されます。メソッドが完了すると、Operationオブジェクトにステータスが含まれます。詳細については、非同期 API メソッドをご覧ください。REST

ログ分析を使用するようにログバケットをアップグレードするには、Cloud Logging API の

projects.locations.buckets.updateAsyncメソッドを使用します。次のように、メソッドの引数を準備します。

LogBucket.analyticsEnabledブール値をtrueに設定します。- コマンドのクエリ パラメータには

updateMask=analyticsEnabledを使用します。

非同期メソッドのレスポンスは、

Operationオブジェクトです。このオブジェクトには、メソッドの進行状況に関する情報が格納されています。メソッドが完了すると、Operationオブジェクトにステータスが含まれます。詳細については、非同期 API メソッドをご覧ください。updateAsyncが完了するまでに数分かかることがあります。リンクされた BigQuery データセットを作成する

BigQuery の機能を使用してログデータを分析する場合は、ログ分析を使用するようにログバケットをアップグレードし、リンクされたデータセットを作成します。この構成では、ログデータの保存は Logging が行いますが、ログデータの読み取りは BigQuery で行うことができます。

Google Cloud コンソール

既存のログバケットに BigQuery データセットへのリンクを作成するには、次の操作を行います。

-

Google Cloud コンソールで、[ログストレージ] ページに移動します。

このページを検索バーで検索する場合は、小見出しが「Logging」の結果を選択します。

ログバケットを見つけ、[Log Analytics を使用可能] 列に「開く」が表示されていることを確認します。

この列に「アップグレード」と表示されている場合、ログバケットはログ分析を使用するようにアップグレードされていません。ログ分析を構成します。

- [アップグレード] をクリックします。

- ダイアログで [確認] をクリックします。

アップグレードが完了したら、次のステップに進みます。

ログバケットで、[その他] more_vert をクリックし、[バケットを編集] をクリックします。

[ログバケットの編集] ダイアログが開きます。

[このバケットにリンクする新しい BigQuery データセットを作成する] を選択し、新しいデータセットの名前を入力します。

データセット名は、各 Google Cloud プロジェクトで一意である必要があります。既存のデータセットの名前を入力すると、「

Dataset name must be unique in the selected region.」というエラーが返されます。[完了]、[バケットを更新] の順にクリックします。

リンクされたデータセット名が Logging の [ログストレージ] ページに表示されてから BigQuery がデータセットを認識するまでに数分かかることがあります。

gcloud

ログ分析を使用するようにアップグレードされたログバケットに、リンクされたデータセットを作成するには、

gcloud logging links createコマンドを実行します。gcloud logging links create LINK_ID --bucket=BUCKET_ID --location=LOCATION

指定した LINK_ID は BigQuery データセットの名前として使用されます。このフィールドの値は、 Google Cloud プロジェクトで固有である必要があります。

links createコマンドは非同期です。非同期メソッドからは、メソッドの進行状況に関する情報が格納されているOperationオブジェクトが返されます。メソッドが完了すると、Operationオブジェクトにステータスが含まれます。詳細については、非同期 API メソッドをご覧ください。links createコマンドが完了するまでに数分かかります。たとえば、次のコマンドは、

my-bucketという名前のログバケットに、mylinkという名前でリンクされたデータセットを作成します。gcloud logging links create mylink --bucket=my-bucket --location=global

データセット名は、各 Google Cloud プロジェクトで一意である必要があります。既存のデータセットと同じ名前のデータセットを作成しようとすると、次のエラーを受信します。

BigQuery dataset with name "LINK_ID" already exists.ログ分析を使用するようにアップグレードされていないログバケットに、リンクされたデータセットを作成しようとすると、次のエラーが報告されます。

A link can only be created for an analytics-enabled bucket.REST

アップグレードされた既存のログバケットに、リンクされた BigQuery データセットを作成するには、ログ分析を使用します。Cloud Logging API の非同期

projects.locations.buckets.links.createメソッドを呼び出します。次のように、メソッドの引数を準備します。

createコマンドのリクエスト本文を作成します。リクエスト本文はLinkオブジェクトの形式です。- コマンドのクエリ パラメータには

linkId=LINK_IDを使用します。指定した LINK_ID は BigQuery データセットの名前として使用されます。このフィールドの値は、 Google Cloud プロジェクトで固有である必要があります。

非同期メソッドのレスポンスは、

Operationオブジェクトです。このオブジェクトには、メソッドの進行状況に関する情報が格納されています。メソッドが完了すると、Operationオブジェクトにステータスが含まれます。詳細については、非同期 API メソッドをご覧ください。links.createメソッドが完了するまでに数分かかります。データセット名は、各 Google Cloud プロジェクトで一意である必要があります。既存のデータセットと同じ名前のデータセットを作成しようとすると、次のエラーを受信します。

BigQuery dataset with name "LINK_ID" already exists.ログ分析を使用するようにアップグレードされていないログバケットに、リンクされたデータセットを作成しようとすると、次のエラーが報告されます。

A link can only be created for an analytics-enabled bucket.バケットをロックする

更新されないようにバケットをロックすると、バケットの保持ポリシーもロックされます。保持ポリシーがロックされると、バケット内のすべてのログエントリがバケットの保持期間を満了するまでバケットを削除できません。ロックされたログバケットを含むプロジェクトが誤って削除されないようにするには、プロジェクトにリーエンを追加します。詳しくは、リーエンによるプロジェクトの保護をご覧ください。

他のユーザーがログバケットを更新または削除できないようにするには、バケットをロックします。バケットをロックする手順は次のとおりです。

Google Cloud コンソール

Google Cloud コンソールでは、ログバケットのロックはサポートされていません。

gcloud

バケットをロックするには、

--lockedフラグを指定してgcloud logging buckets updateコマンドを実行します。gcloud logging buckets update BUCKET_ID --location=LOCATION --locked

例:

gcloud logging buckets update my-bucket --location=global --locked

REST

バケットの属性をロックするには、Logging API で

projects.locations.buckets.patchを使用します。lockedパラメータをtrueに設定します。バケットを一覧表示する

Google Cloud プロジェクトに関連付けられたログバケットを一覧表示し、保持設定などの詳細を確認するには、次のようにします。

Google Cloud コンソール

Google Cloud コンソールで、[ログストレージ] ページに移動します。

このページを検索バーで検索する場合は、小見出しが「Logging」の結果を選択します。

「ログバケット」という名前の表に、現在のGoogle Cloud プロジェクトに関連付けられたバケットが一覧表示されます。

この表には、各ログバケットの次の属性が一覧表示されます。

- 名前: ログバケットの名前。

- 説明: バケットの説明。

- 保持期間: Cloud Logging がバケットのデータを保存する日数。

- リージョン: バケットのデータが保存される地理的位置。

- ステータス: バケットがロックされているか、ロック解除されているか。

Cloud Logging がバケットを削除保留にしている場合、表のエントリに警告記号 warning が付いています。

gcloud

gcloud logging buckets listコマンドを実行します。gcloud logging buckets list

ログバケットの次の属性が表示されます。

LOCATION: バケットのデータが保存されるリージョン。BUCKET_ID: ログバケットの名前。RETENTION_DAYS: Cloud Logging がバケットのデータを保存する日数。LIFECYCLE_STATE: Cloud Logging がバケットを削除保留中としているかどうかを示します。LOCKED: バケットがロックされているか、ロック解除されているか。CREATE_TIME: バケットが作成された日時を示すタイムスタンプ。UPDATE_TIME: バケットが最後に変更された日時を示すタイムスタンプ。

1 つのバケットの属性だけを表示することもできます。たとえば、

globalリージョンの_Defaultログバケットの詳細を表示するには、gcloud logging buckets describeコマンドを実行します。gcloud logging buckets describe _Default --location=global

REST

Google Cloud プロジェクトに関連付けられたログバケットの一覧を取得するには、Logging API で

projects.locations.buckets.listを使用します。バケットの詳細を表示する

単一ログバケットの詳細を表示するには、次の操作を行います。

Google Cloud コンソール

Google Cloud コンソールで、[ログストレージ] ページに移動します。

このページを検索バーで検索する場合は、小見出しが「Logging」の結果を選択します。

ログバケットで more_vert(その他)をクリックして、[バケットの詳細を表示] を選択します。

このダイアログには、ログバケットの次の属性が表示されます。

- 名前: ログバケットの名前。

- 説明: ログバケットの説明。

- 保持期間: Cloud Logging がバケットのデータを保存する日数。

- リージョン: バケットのデータが保存される地理的位置。

- ログ分析: ログ分析を使用するようにバケットがアップグレードされているかどうかを示します。

- BigQuery 分析: BigQuery データセットがバケットにリンクされているかどうかを示します。

- BigQuery データセット: BigQuery データセットへのリンクを示します。この BigQuery データセットが [BigQuery Studio] ページで開きます。BigQuery のリンクが有効になった日付も表示されます。

gcloud

gcloud logging buckets describeコマンドを実行します。たとえば、次のコマンドは

_Defaultバケットの詳細を報告します。gcloud logging buckets describe _Default --location=global

ログバケットの次の属性が表示されます。

createTime: バケットが作成された日時を示すタイムスタンプ。description: ログバケットの説明。lifecycleState: Cloud Logging がバケットを削除保留中としているかどうかを示します。name: ログバケットの名前。retentionDays: Cloud Logging がバケットのデータを保存する日数。updateTime: バケットが最後に変更された日時を示すタイムスタンプ。

REST

単一ログバケットの詳細を表示するには、Logging API で

projects.locations.buckets.getを使用します。バケットを削除する

次のいずれかの条件を満たすログバケットを削除できます。

更新されないようにロックされたログバケットに、バケットの保持期間を満たしていないログエントリが保存されている場合、そのログバケットを削除することはできません。

削除コマンドを実行すると、ログバケットは

DELETE_REQUESTED状態に移行し、7 日間その状態を維持します。この間、Logging は引き続きログをログバケットに転送します。ログエントリをバケットに転送するログシンクを削除または変更すると、ログバケットへのログの転送を停止できます。DELETE_REQUESTED状態のログバケットと同じ名前を使用して、新しいログバケットを作成することはできません。ログバケットを削除するには、次の操作を行います。

Google Cloud コンソール

ログバケットを削除するには、次の操作を行います。

-

Google Cloud コンソールで、[ログストレージ] ページに移動します。

このページを検索バーで検索する場合は、小見出しが「Logging」の結果を選択します。

削除するバケットを見つけて、more_vert(その他)アイコンをクリックします。

[BigQuery のリンクされたデータセット] 列にリンクが表示されている場合は、リンクされた BigQuery データセットを削除します。

[バケットを編集] をクリックします。

[このバケットにリンクする新しい BigQuery データセットを作成する] をオフにして、[完了] をクリックし、[バケットを更新] をクリックします。

[ログストレージ] ページに戻り、削除するバケットの more_vert(その他)をクリックして、次の手順に進みます。

[バケットを削除] を選択します。

確認パネルで [削除] をクリックします。

[ログストレージ] ページに、バケットが削除保留中であることを示すインジケータが表示されます。すべてのログを含むバケットは 7 日後に削除されます。

gcloud

ログバケットを削除するには、

gcloud logging buckets deleteコマンドを実行します。gcloud logging buckets delete BUCKET_ID --location=LOCATION

ログバケットにリンクされた BigQuery データセットがある場合は、そのバケットを削除できません。

- ログバケットに関連付けられたリンクの一覧を取得するには、

gcloud logging links listコマンドを実行します。 - データセットを削除するには、

gcloud logging links deleteコマンドを実行します。

REST

バケットを削除するには、Logging API で

projects.locations.buckets.deleteを使用します。ログバケットにリンクされた BigQuery データセットがある場合、そのバケットを削除するとエラーが発生します。ログバケットを削除する前に、リンクされたデータセットを削除する必要があります。

- ログバケットに関連付けられたリンクの一覧を取得するには、

projects.locations.buckets.links.listメソッドを実行します。 - リンクされたデータセットを削除するには、

projects.locations.buckets.links.deleteメソッドを実行します。

削除したバケットを復元する

削除保留状態のバケットは、削除を取り消して復元できます。ログバケットの復元方法は次のとおりです。

Google Cloud コンソール

削除保留中のログバケットを復元するには、次の操作を行います。

-

Google Cloud コンソールで、[ログストレージ] ページに移動します。

このページを検索バーで検索する場合は、小見出しが「Logging」の結果を選択します。

復元するバケットで、more_vert(その他)をクリックし、[削除したバケットを復元する] を選択します。

確認パネルで [復元] をクリックします。

[ログストレージ] ページで、削除保留中であることを示すインジケータがバケットから削除されます。

gcloud

削除保留中のログバケットを復元するには、

gcloud logging buckets undeleteコマンドを実行します。gcloud logging buckets undelete BUCKET_ID --location=LOCATION

REST

削除保留中のバケットを復元するには、Logging API で

projects.locations.buckets.undeleteを使用します。ログバケットに保存されるログバイト数の月次合計に関するアラート

アラート ポリシーを作成するには、Google Cloud コンソールの [ログストレージ] ページで、[add_alert 使用量アラートを作成] をクリックします。このボタンをクリックすると、Monitoring の [アラート ポリシーを作成] ページが開き、指標タイプ フィールドに

logging.googleapis.com/billing/bytes_ingestedが入力されます。ログバケットに書き込まれたログバイト数が Cloud Logging のユーザー定義の上限を超えたときにトリガーされるアラート ポリシーを作成するには、次の設定を使用します。

[New condition]

フィールド

値リソースと指標 [リソース] メニューで、[グローバル] を選択します。

[指標カテゴリ] メニューで、[ログベースの指標] を選択します。

[指標] メニューで、[取り込みログバイト数の月間合計] を選択します。フィルタ なし 時系列全体

時系列集計sum

ローリング ウィンドウ 60 m

ローリング ウィンドウ関数 max[アラート トリガーの構成]

フィールド

値条件タイプ ThresholdAlert trigger Any time series violatesしきい値の位置 Above thresholdしきい値 許容値を決定します。 再テスト ウィンドウ 最小許容値は 30 分です。 アラート ポリシーに関する説明は、アラートの概要をご覧ください。

バケットに書き込む

ログバケットに直接ログを書き込むことはありません。代わりに、ログをGoogle Cloud リソース( Google Cloud プロジェクト、フォルダ、または組織)に書き込みます。親リソースのシンクは、ログバケットを含む宛先にログを転送します。ログがシンクのフィルタと一致し、シンクにログをログバケットに転送する権限がある場合、シンクはログをログバケットの宛先に転送します。

バケットから読み取る

各ログバケットには、一連のログビューがあります。ログバケットからログを読み取るには、ログバケットのログビューへのアクセス権が必要です。ログビューを使用すると、ログバケットに保存されているログのサブセットに対してのみユーザーにアクセス権を付与できます。ログビューの構成方法と、特定のログビューへのアクセス権を付与する方法については、ログバケットのログビューを構成するをご覧ください。

ログバケットからログを読み取るには、次の操作を行います。

Google Cloud コンソール

-

Google Cloud コンソールで [ログ エクスプローラ] ページに移動します。

このページを検索バーで検索する場合は、小見出しが「Logging」の結果を選択します。

ログ エクスプローラに表示されるログをカスタマイズするには、[範囲を絞り込む] をクリックしてオプションを選択します。たとえば、プロジェクトまたはログビューで保存されているログを表示できます。

[適用] をクリックします。[クエリ結果] ペインが更新され、選択したオプションに一致するログが再読み込みされます。

詳細については、ログ エクスプローラの概要: 範囲を絞り込むをご覧ください。

gcloud

ログバケットからログを読み取るには、

gcloud logging readコマンドを使用し、LOG_FILTERを追加してデータを選択します。gcloud logging read LOG_FILTER --bucket=BUCKET_ID --location=LOCATION --view=LOG_VIEW_ID

REST

ログバケットからログを読み取るには、entries.list メソッドを使用します。

resourceNamesを設定して適切なバケットとログビューを指定し、filterを設定してデータを選択します。フィルタリング構文の詳細については、Logging のクエリ言語をご覧ください。

カスタム保持を構成する

ログバケットを作成するときに、Cloud Logging でバケットのログが保存される期間をカスタマイズできます。保持期間は、ユーザー定義のログバケットと

_Defaultログバケットのそれぞれで構成できます。_Requiredログバケットの保持期間は変更できません。バケットの保持期間を短くすると、7 日間の猶予期間が設定されます。この間、期限切れのログは削除されません。期限切れのログに対してクエリの実行や表示はできませんが、この 7 日間にバケットの保持期間を延長することで、完全アクセス権を復元できます。猶予期間中に保存されたログは、保持費用に計上されます。

保持の適用は、結果整合性のプロセスです。ログエントリがバケットの保持期間よりも古い場合に、ログエントリをログバケットに書き込むと、これらのログエントリが一時的に表示されることがあります。たとえば、保持期間が 7 日間のログバケットに 10 日前のログエントリを送信すると、これらのログエントリは保存され、最終的に削除されます。これらのログエントリは、保持費用の計算対象になりません。ただし、ストレージ費用には影響します。ストレージ費用を最小限に抑えるには、バケットの保持期間を経過したログエントリを書き込まないでください。

カスタム ログバケットまたは

_Defaultログバケットの保持期間を更新するには、次の操作を行います。Google Cloud コンソール

ログバケットの保持期間を更新するには、次の操作を行います。

-

Google Cloud コンソールで、[ログストレージ] ページに移動します。

このページを検索バーで検索する場合は、小見出しが「Logging」の結果を選択します。

更新するバケットで more_vert(その他)をクリックし、[バケットを編集] を選択します。

[保持] フィールドに、Cloud Logging でログを保持する日数を入力します(1~3,650 日)。

[バケットを更新] をクリックします。新しい保持期間が [ログバケット] リストに表示されます。

gcloud

ログバケットの保持期間を更新するには、RETENTION_DAYS の値を設定して、

gcloud logging buckets updateコマンドを実行します。gcloud logging buckets update BUCKET_ID --location=LOCATION --retention-days=RETENTION_DAYS

たとえば、

globalロケーションの_Defaultバケットのログを 1 年間保持する場合、コマンドは次のようになります。gcloud logging buckets update _Default --location=global --retention-days=365

バケットの保持期間を延長した場合、保持ルールはその保持期間の終了後に適用されます。過去に遡って適用はされることはありません。所定の保持期間が終了すると、ログの復元はできなくなります。

非同期 API メソッド

projects.locations.buckets.createAsyncなどの非同期メソッドのレスポンスはOperationオブジェクトです。非同期 API メソッドを呼び出すアプリは、

Operation.doneフィールドの値がtrueになるまで、operation.getエンドポイントをポーリングする必要があります。doneがfalseの場合は、オペレーションが進行中です。ステータス情報を更新するには、

operation.getエンドポイントにGETリクエストを送信します。doneがtrueの場合、オペレーションは完了し、errorフィールドまたはresponseフィールドが次のように設定されます。error: この値が設定された場合、非同期処理が失敗しています。このフィールドの値は、gRPC エラーコードとエラー メッセージを含むStatusオブジェクトです。response: この値が設定されている場合、非同期オペレーションが正常に完了し、値に結果が反映されています。

Google Cloud CLI を使用して非同期コマンドをポーリングするには、次のコマンドを実行します。

gcloud logging operations describe OPERATION_ID --location=LOCATION --project=PROJECT_ID

詳細については、

gcloud logging operations describeをご覧ください。一般的な問題のトラブルシューティング

ログバケットの使用中に問題が発生した場合は、次のトラブルシューティング手順と一般的な質問に対する回答をご覧ください。

このバケットを削除できません。なぜですか?

バケットを削除するには、次の操作を行います。

バケットの削除に適切な権限があることを確認します。必要な権限のリストについては、IAM によるアクセス制御をご覧ください。

バケットの属性を一覧表示して、バケットがロックされているかどうかを確認します。バケットがロックされている場合は、バケットの保持期間を確認します。ロックされたバケットを削除するには、そのバケット内のすべてのログがバケットの保持期間を満たしている必要があります。

ログバケットにリンクされた BigQuery データセットがないことを確認します。リンクされたデータセットがあるログバケットは削除できません。

リンクされたデータセットがあるログバケットに対して

deleteコマンドを実行すると、次のエラーが表示されます。FAILED_PRECONDITION: This bucket is used for advanced analytics and has an active link. The link must be deleted first before deleting the bucket

ログバケットに関連付けられたリンクを一覧表示するには、

gcloud logging links listコマンドを実行するか、projects.locations.buckets.links.listAPI メソッドを実行します。

どのサービス アカウントがバケットにログを転送するのですか?

ログをバケットに転送する IAM 権限がサービス アカウントにあるかどうかを確認するには、次の操作を行います。

-

Google Cloud コンソールで [IAM] ページに移動します。

このページを検索バーで検索する場合は、小見出しが「IAM と管理」の結果を選択します。

[権限] タブで、ロール別に表示します。Google Cloud プロジェクトに関連付けられたすべての IAM ロールとプリンシパルを含む表が表示されます。

表の [フィルタ] テキスト ボックス filter_list に「ログバケット書き込み」と入力します。

ログバケット書き込みのロールを持つプリンシパルが表示されます。プリンシパルがサービス アカウントの場合、その ID には文字列

gserviceaccount.comが含まれます。省略可: Google Cloud プロジェクトにログを転送できないようにサービス アカウントを削除する場合は、サービス アカウントのチェックボックス check_box_outline_blank をオンにして、[削除] をクリックします。

ログが

_Defaultシンクから除外されていても Google Cloud プロジェクトのログが表示されるのはなぜですか?組織全体のログを集約する一元化された Google Cloud プロジェクトのログバケットでログを表示している可能性があります。

ログ エクスプローラを使用してこれらのログにアクセスしていて、

_Defaultシンクから除外したログが表示される場合は、ビューがGoogle Cloud プロジェクト レベルに設定されている可能性があります。この問題を解決するには、[範囲を絞り込む] メニューで [ログビュー] を選択し、Google Cloud プロジェクトの

_Defaultバケットに関連付けられているログビューを選択します。これで、除外されたログが表示されなくなります。次のステップ

Logs Bucket API メソッドの詳細については、

LogBucketリファレンス ドキュメントをご覧ください。組織またはフォルダを管理している場合は、子リソースの

_Defaultログバケットと_Requiredログバケットのロケーションを指定できます。ログバケットで CMEK を使用するかどうかと、_Defaultログシンクの動作を構成することもできます。詳しくは、組織とフォルダのデフォルト設定を構成するをご覧ください。ログバケットを使用して一般的なユースケースに対応する方法については、次のトピックをご覧ください。

特に記載のない限り、このページのコンテンツはクリエイティブ・コモンズの表示 4.0 ライセンスにより使用許諾されます。コードサンプルは Apache 2.0 ライセンスにより使用許諾されます。詳しくは、Google Developers サイトのポリシーをご覧ください。Java は Oracle および関連会社の登録商標です。

最終更新日 2025-10-29 UTC。

- Google Cloud CLI または Cloud Logging API を使用してログバケットを作成または管理する場合は、