このドキュメントでは、 Google Cloud コンソールを使用してログエントリをクエリ、表示、分析する方法について説明します。ログ エクスプローラとログ分析の 2 つのインターフェースがあります。両方のインターフェースでログのクエリ、表示、分析を行うことができます。ただし、クエリ言語は異なり、機能も異なります。ログデータのトラブルシューティングと探索には、ログ エクスプローラを使用することをおすすめします。分析情報と傾向を生成するには、ログ分析を使用することをおすすめします。Logging API コマンドを実行して、ログにクエリを実行し、クエリを保存できます。Google Cloud CLI を使用してログをクエリすることもできます。

ログ エクスプローラ

ログ エクスプローラは、サービスとアプリケーションのパフォーマンスのトラブルシューティングと分析に役立つように設計されています。たとえば、ヒストグラムにはエラー率が表示されます。エラーが急増した場合や、興味深いものが見つかった場合は、対応するログエントリを見つけて表示できます。ログエントリがエラーグループに関連付けられている場合、ログエントリには、エラーグループの詳細情報にアクセスできるオプション メニューが表示されます。

Cloud Logging API、Google Cloud CLI、ログ エクスプローラでは、同じクエリ言語がサポートされています。ログ エクスプローラでクエリの作成を簡素化するには、メニューの使用、テキストの入力、また場合によっては、個別のログエントリに表示されるオプションの使用により、クエリを作成します。

ログ エクスプローラでは、集約オペレーション(特定のパターンを含むログエントリの数をカウントするなど)がサポートされていません。集約オペレーションを実行するには、ログバケットで分析を有効にしてから、ログ分析を使用します。

ログ エクスプローラでのログの検索と表示の詳細については、ログ エクスプローラを使用してログを表示するをご覧ください。

ログ分析

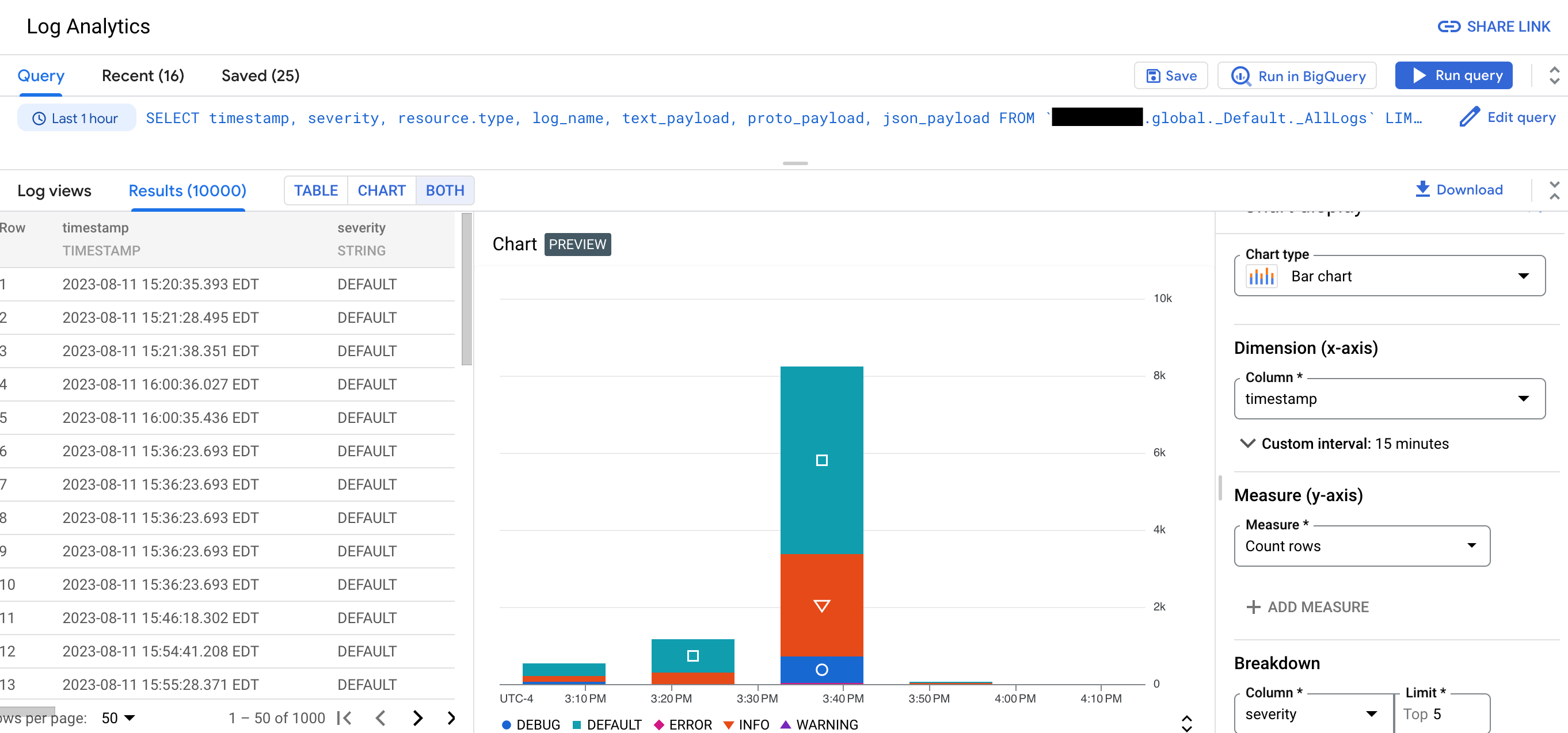

ログ分析を使用すると、ログデータを分析するクエリを実行して、クエリ結果を表示したりクエリ結果をグラフ化できます。グラフを使用すると、ログのパターンや傾向を時系列で識別できます。次のスクリーンショットは、ログ分析のグラフ作成機能を示しています。

たとえば、問題のトラブルシューティングをしており、ある程度の期間にわたり特定の URL に対して発行された HTTP リクエストの平均レイテンシを把握したいとします。ログ分析を使用するようにログバケットをアップグレードすると、SQL クエリを作成するか、クエリビルダーを使用してログバケットに保存されたログをクエリできます。

これらの SQL クエリには、パイプ構文を含めることもできます。ログをグループ化して集計すると、ログデータの分析情報が得られるため、トラブルシューティングに要する時間を短縮する効果があります。

ログ分析では、ログビューまたは分析ビューをクエリできます。ログビューには、LogEntry データ構造に対応する固定のスキーマがあります。分析ビューのスキーマは作成者が決定するため、分析ビューは、ログデータを LogEntry 形式からより適した形式に変換する場合に使用されます。

BigQuery を使用してデータをクエリすることもできます。たとえば、BigQuery を使用してログ内の URL を既知の悪意のある URL の公開データセットと比較するとします。BigQuery にログデータを表示するには、ログ分析を使用するようにバケットをアップグレードし、リンクされたデータセットを作成します。

問題のトラブルシューティングとこれらのバケット内の個々のログエントリの表示は、ログ エクスプローラを使用して引き続き行うことができます。

制限事項

ログ分析を使用するように既存のログバケットをアップグレードする場合は、次の要件を満たしている必要があります。

- ログバケットは Google Cloud プロジェクト レベルで作成されている。

_Requiredバケットでない限り、ログバケットのロックが解除されている。- バケットの更新が保留中でない。

バケットがアップグレードされる前に書き込まれたログエントリは、すぐには表示されません。バックフィル オペレーションが完了すると、これらのログエントリを分析できます。バックフィル プロセスには数日かかることがあります。

ログバケットにフィールド レベルのアクセス制御が構成されている場合、[ログ分析] ページを使用してログビューをクエリすることはできません。ただし、[ログ エクスプローラ] ページからクエリを実行したり、リンクされた BigQuery データセットに対してクエリを実行することはできます。BigQuery ではフィールド レベルのアクセス制御は考慮されないため、リンクされたデータセットをクエリすると、ログエントリ内のすべてのフィールドをクエリできます。

複数のログビューをクエリする場合は、同じロケーションに保存する必要があります。たとえば、2 つのビューが

us-east1ロケーションにある場合、1 つのクエリで両方のビューをクエリできます。usマルチリージョンにある 2 つのビューをクエリすることもできます。ただし、ビューのロケーションがglobalの場合、そのビューは任意の物理ロケーションに存在できます。したがって、ロケーションがglobalの 2 つのビュー間の結合が失敗する可能性があります。複数のログビューをクエリし、その基盤となるログバケットが異なる Cloud KMS 鍵で構成されている場合、次の制約が満たされない限り、クエリは失敗します。

- ログバケットの親リソースであるフォルダまたは組織がデフォルトの鍵で構成されている。

- デフォルトの鍵はログバケットと同じ場所にあります。

上記の制約を満たすと、親の Cloud KMS 鍵によって、ログ分析クエリによって生成された一時データが暗号化されます。

重複するログエントリは、クエリの実行前に削除されません。これは、ログ エクスプローラを使用してログエントリをクエリする場合とは異なります。ログ エクスプローラでは、ログ名、タイムスタンプ、挿入 ID のフィールドを比較して重複エントリが削除されます。詳細については、トラブルシューティング: ログ分析の結果に重複するログエントリがあるをご覧ください。

料金

Cloud Logging では、サポートされている宛先へのログの転送で料金を請求されることはありませんが、宛先での料金が発生する場合があります。_Required ログバケットを除き、Cloud Logging では、ログバケットへのログのストリーミングと、ログバケットのデフォルト保持期間よりも長いストレージの料金が請求されます。

Cloud Logging では、ログのコピー、ログスコープまたは分析ビューの作成、ログ エクスプローラまたはログ分析のページから発行されたクエリには課金されません。

詳細については、次のドキュメントをご覧ください。

- Google Cloud Observability の料金ページの Cloud Logging セクション。

ログデータを他の Google Cloud サービスに転送する場合の費用:

- VPC フローログの生成料金は、Cloud Logging から Virtual Private Cloud フローログを送信して除外した後に適用されます。

ログ分析を使用するようにバケットをアップグレードしてから、リンクされたデータセットを作成すると、BigQuery の取り込みやストレージの費用は発生しません。ログバケットのリンクされたデータセットを作成する場合、ログデータは BigQuery に取り込まれません。代わりに、リンクされたデータセットを介してログバケットに保存されているログデータへの読み取りアクセスを取得します。

BigQuery とリンクされているデータセット(BigQuery Studio ページ、BigQuery API、BigQuery コマンドライン ツールの使用など)で SQL クエリを実行すると、BigQuery 分析料金が適用されます。

ブログ

ログ分析の詳細については、次のブログ投稿をご覧ください。

- ログ分析の概要については、Cloud Logging のログ分析の GA を開始をご覧ください。

- ログ分析のクエリによって生成されたグラフを作成し、それらのグラフをカスタム ダッシュボードに保存する方法については、Cloud Logging のログ分析グラフとダッシュボードの公開プレビュー版をリリースをご覧ください。

- ログ分析を使用した監査ログの分析については、ログ分析を使用して監査ログからセキュリティ インサイトを収集するをご覧ください。

- ログを BigQuery に転送していて、そのソリューションとログ分析の違いを把握する場合は、BigQuery Export ユーザーのログ分析への移行をご覧ください。

次のステップ

- ログバケットを作成して、ログ分析を使用するようにアップグレードする

- ログ分析を使用するように既存のバケットをアップグレードする

ログのクエリと表示:

サンプルクエリ: