Vous pouvez utiliser la fonctionnalité de test intégrée pour déceler les bugs et éviter les régressions. Pour tester votre agent, vous pouvez utiliser le simulateur pour interagir avec lui et enregistrer la conversation en tant que scénario de test.

Lorsque vous enregistrez un scénario de test, les correspondances d'intent, les actions du playbook, les flux activés et les pages activées qui se sont produits au cours de la conversation sont enregistrés en tant qu'attentes du scénario de test. Lorsque vous exécuterez le scénario de test plus tard après avoir modifié votre agent, ces attentes seront vérifiées. Vous pouvez également modifier ces attentes lorsque vous créez ou modifiez des scénarios de test.

Créer un scénario de test

Pour créer un scénario de test à l'aide du simulateur:

- Ouvrez le simulateur.

- Discutez avec l'agent.

- Cliquez sur le bouton Créer un cas de test au-dessus du simulateur.

- Le panneau de l'éditeur de cas de test s'ouvre. Indiquez le nom à afficher du scénario de test et modifiez les attentes si vous le souhaitez.

- Cliquez sur le bouton Enregistrer le scénario de test au-dessus du simulateur.

Exécuter des scénarios de test

Pour exécuter un seul scénario de test:

- Cliquez sur Cas de test dans le panneau de navigation de gauche.

- Sélectionnez le scénario de test que vous souhaitez exécuter.

- Cliquez sur le bouton Exécuter.

- Les résultats de l'historique des scénarios de test s'affichent.

Pour exécuter plusieurs scénarios de test:

- Cliquez sur Cas de test dans le panneau de navigation de gauche.

- Sélectionnez les scénarios de test que vous souhaitez exécuter à l'aide des cases à cocher situées à gauche.

- Cliquez sur Exécuter la sélection.

- Les résultats de l'exécution du dernier test s'affichent pour chaque cas de test.

Modifier un scénario de test

Lorsque vous modifiez un scénario de test, vous ne pouvez pas modifier le message de l'utilisateur final ni la réponse de l'agent, mais vous pouvez modifier les éléments suivants:

- Ajouter des attentes

- Supprimer les attentes

- Mettre à jour les attentes

Pour modifier un scénario de test:

- Cliquez sur Cas de test dans le panneau de navigation de gauche.

- Sélectionnez le cas de test que vous souhaitez modifier.

- Cliquez sur le bouton Modifier au-dessus du résumé du cas de test.

- Vous pouvez développer la section Attentes au niveau de la conversation pour modifier les attentes qui s'appliquent à l'ensemble de la conversation.

- Chaque tour de conversation affiche le message de l'utilisateur final, la réponse de l'agent et les attentes pour le tour. Vous ne pouvez pas modifier les messages, mais vous pouvez modifier les attentes au niveau des virages.

Supprimer les scénarios de test

Pour supprimer des scénarios de test:

- Cliquez sur Cas de test dans le panneau de navigation de gauche.

- Sélectionnez les scénarios de test que vous souhaitez supprimer à l'aide des cases à cocher situées à gauche.

- Cliquez sur Supprimer les scénarios de test sélectionnés.

Attentes

Lorsque vous indiquez les attentes pour un cas de test, vous pouvez fournir des attentes au niveau de la conversation ou des attentes au niveau du tour de parole.

Les attentes au niveau de la conversation s'appliquent à l'ensemble de la conversation. Vous pouvez fournir les types d'attentes suivants:

- Utilisation de l'outil

- Appel de flux

- Appel du playbook

Les attentes au niveau de la prise de parole ne s'appliquent qu'à une prise de parole spécifique. Vous pouvez fournir les types d'attentes suivants:

- Réponse de l'agent

- Débit actuel

- Intention actuelle

- Page actuelle

- Utilisation de l'outil

- Appel de flux

- Appel du playbook

Anciens scénarios de test

Vous pouvez utiliser la fonctionnalité de test intégrée pour déceler les bugs et éviter les régressions. Pour tester votre agent, vous devez créer des scénarios de test à l'aide du simulateur afin de définir des scénarios de test de référence, puis exécuter des scénarios de test selon vos besoins. Une exécution de test vérifie que les réponses de l'agent n'ont pas changé pour les entrées de l'utilisateur final définies dans le scénario de test.

Les instructions ci-dessous montrent comment procéder à l'aide de la console, mais vous pouvez retrouver les mêmes fonctionnalités dans l'API.

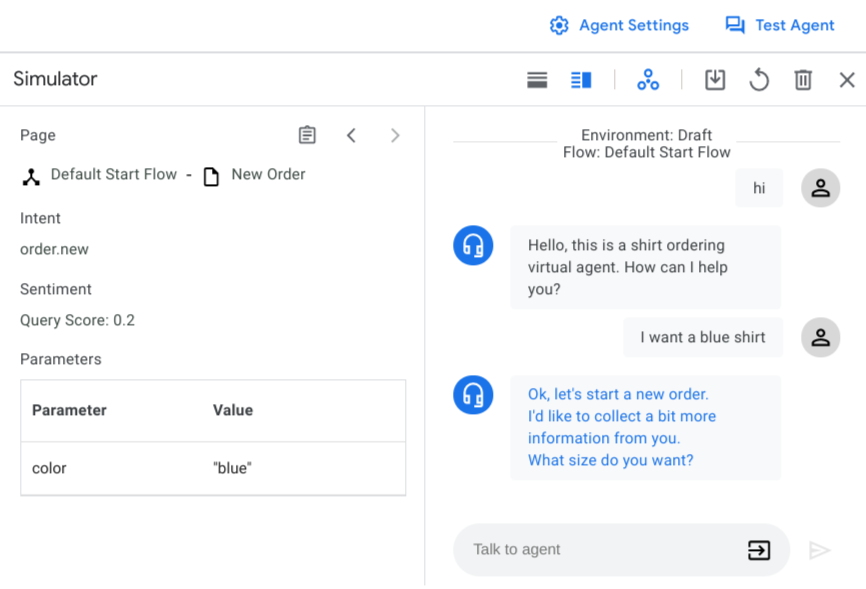

Paramètres du simulateur

Lorsque vous ouvrez le simulateur pour la première fois, vous devez sélectionner un environnement pour l'agent ou des versions de flux et un flux actif. Dans la plupart des cas, vous devez utiliser l'environnement brouillon et le flux de démarrage par défaut.

Vous pouvez également activer ou désactiver les appels webhook à tout moment à l'aide du bouton d'activation des webhooks . Il est recommandé de désactiver les webhooks lors de la définition des scénarios de test.

Entrées du simulateur

Lorsque vous travaillez sur le simulateur, vous devez saisir les entrées utilisateur sous forme de texte, puis appuyer sur Entrée ou cliquer sur le bouton "Envoyer" . En plus du texte brut, vous pouvez choisir d'autres types d'entrée avec le sélecteur d'entrée :

- Paramètre : injecte une valeur de paramètre. Vous pouvez fournir de nouveaux paramètres ou donner des valeurs prédéfinies aux paramètres existants.

- Événement : appelle un événement.

- DTMF : envoie des données relatives à la présence de signaux à double fréquence (à clavier) pour les interactions de téléphonie.

Créer un scénario de test

Pour créer une conversation, procédez comme suit :

- Ouvrez la console Dialogflow CX.

- Choisissez votre projet.

- Sélectionnez votre agent.

- Cliquez sur Test Agent (Tester l'agent) pour ouvrir le simulateur.

- Conversez avec l'agent pour créer une conversation couvrant la fonctionnalité que vous souhaitez tester. Pour chaque tour, vérifiez que les valeurs de l'intent déclenché, de la réponse de l'agent, de la page active et des paramètres de session sont correctes.

Pour enregistrer une conversation en tant que scénario de test, procédez comme suit :

- Cliquez sur le bouton Enregistrer .

- Saisissez un nom à afficher pour le scénario de test. Chaque scénario de test doit avoir un nom à afficher unique.

- Vous pouvez éventuellement indiquer un nom de tag. Les tags vous aident à organiser vos scénarios de test. Tous les tags doivent commencer par un "#".

- Si vous le souhaitez, vous pouvez ajouter une note décrivant l'objectif du scénario de test.

- Vous pouvez également sélectionner les paramètres dont vous souhaitez effectuer le suivi dans le scénario de test. Une liste de suggestions de paramètres est proposée. Vous pouvez également intégrer d'autres paramètres à suivre. Si vous sélectionnez des paramètres de suivi, leur assertion est vérifiée lors de l'exécution du scénario de test. Pour plus de détails sur l'assertion des paramètres, consultez la section Exécuter des scénarios de test.

- Cliquez sur Save (Enregistrer) pour enregistrer le scénario de test.

Exécuter des scénarios de test

Pour afficher tous les scénarios de test d'un agent, cliquez sur Scénarios de test dans l'onglet Gérer. Le tableau des scénarios de test indique le nom du test, ses tags, ainsi que l'environnement, la date et le résultat de la dernière exécution.

Pour exécuter des scénarios de test, procédez comme suit :

- Sélectionnez les scénarios de test que vous souhaitez exécuter, puis cliquez sur Run (Exécuter). Vous pouvez également cliquer sur Run all test cases (Exécuter tous les scénarios de test).

- Sélectionnez l'environnement sur lequel vous souhaitez exécuter les scénarios de test.

- Les tests commencent à s'exécuter et leur état s'affiche dans la file d'attente. Le résultat des tests est mis à jour une fois leur exécution terminée.

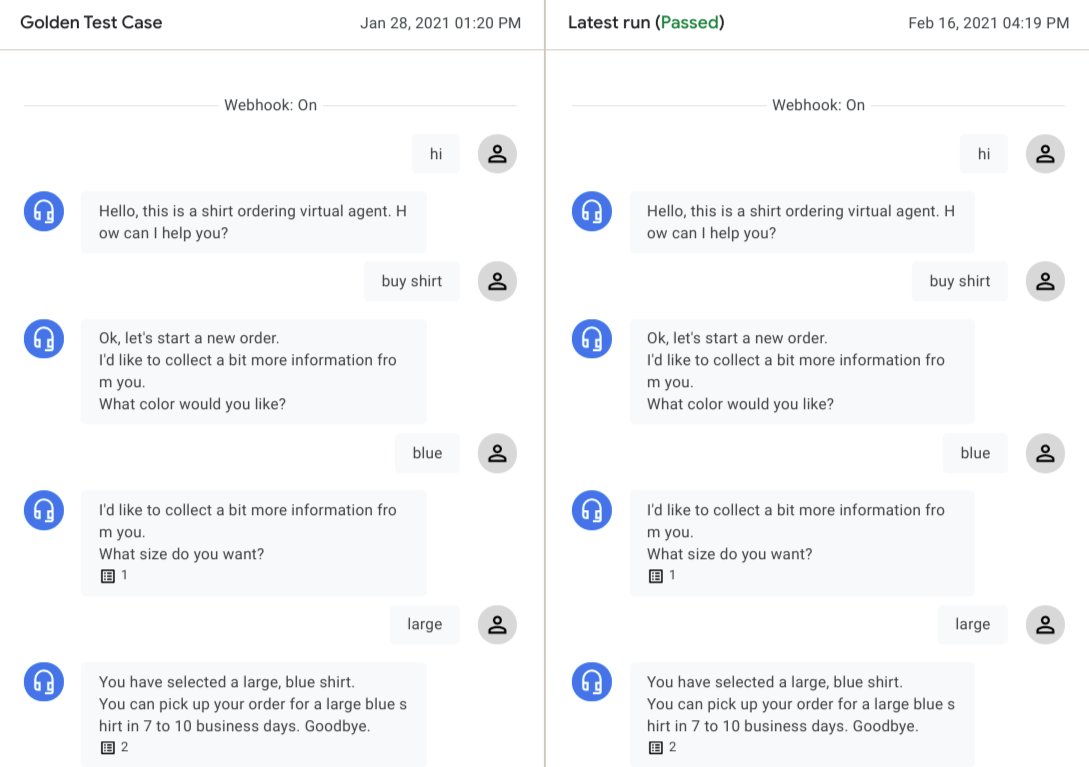

Pour afficher le résultat détaillé des tests, cliquez sur le scénario de test. Les conversations de scénario de test de référence et de dernière exécution sont affichées côte à côte.

Vous pouvez cliquer sur le tour de conversation de l'un des agents pour afficher les détails de ce tour. Le moteur de test vérifie alors les types de données suivants tour à tour pour évaluer les résultats du test :

Dialogue de l'agent :

À chaque tour de conversation, le dialogue de l'agent est comparé entre l'exécution de référence et la dernière exécution. En cas de différence, un avertissement s'affiche. Ces différences n'empêchent pas le test de réussir, car le dialogue de l'agent varie souvent pour le même état.

Intent mis en correspondance :

Pour qu'un test réussisse, il faut que, pour chaque tour, l'intent mis en correspondance soit identique à celui de l'original.

Page actuelle :

Pour qu'un test réussisse, il faut que, pour chaque tour, la page active soit identique à celle de l'original.

Paramètres de session :

Si vous avez ajouté des paramètres de suivi lorsque vous avez créé le scénario de test, le moteur de test vérifie les paramètres de session correspondants et fait échouer le test s'il existe des paramètres manquants ou inattendus, ou encore des incohérences dans les valeurs de paramètres.

Dans certains cas, un scénario de test peut échouer de manière prévisible en raison de la mise à jour d'un agent. Si la conversation de la dernière exécution est conforme aux modifications attendues, vous pouvez cliquer sur Save as golden (Enregistrer comme de référence) pour remplacer le scénario de test de référence.

Modifier des scénarios de test

Pour modifier un scénario de test, sélectionnez-le dans le tableau Scénarios de test, puis cliquez sur l'icône de modification située à côté du nom du scénario de test. La boîte de dialogue Mettre à jour les scénarios de test s'affiche.

Pour modifier les métadonnées et les paramètres du scénario de test, cliquez sur l'onglet Paramètres.

Vous pouvez modifier les champs Nom du scénario de test, Tags et Remarque, ou ajouter de nouveaux paramètres de suivi.

Cliquez sur Enregistrer.

Pour modifier l'entrée utilisateur du scénario de test, cliquez sur l'onglet Entrée utilisateur.

Ajoutez, supprimez ou modifiez les entrées utilisateur au format JSON.

Cliquez sur Confirmer. Une exécution de test automatique commence et la conversation mise à jour s'affiche une fois l'exécution du test terminée.

Cliquez sur Enregistrer pour écraser le scénario de test de référence d'origine, ou sur Enregistrer sous pour créer un nouveau scénario de test avec les modifications.

Afficher la couverture de test

Pour afficher un rapport sur la couverture de test pour tous les scénarios de test, cliquez sur Coverage (Couverture).

La page Couverture comprend les onglets suivants :

La couverture des transitions est déterminée pour tous les gestionnaires d'état (hors groupes de routes) dotés d'une cible de transition exécutée par le scénario de test. Le flux source, la page et le flux/la page de transition cible sont répertoriés dans le tableau.

La couverture des intents est déterminée pour tous les intents correspondant au scénario de test.

La couverture des groupes de routes est déterminée pour tous les groupes de routes correspondant au scénario de test.

Importer et exporter des scénarios de test

Pour exporter des scénarios de test, procédez comme suit :

- Sélectionnez des scénarios de test, puis cliquez sur Export (Exporter) ou cliquez sur Export all test cases (Exporter tous les scénarios de test).

- Cliquez sur Download to local file (Télécharger dans un fichier local) ou indiquez un URI de bucket Cloud Storage, puis cliquez sur Export to Google Cloud Storage (Exporter vers Google Cloud Storage).

Lorsque vous importez des cas de test, les agents conversationnels (Dialogflow CX) créent toujours de nouveaux cas de test pour l'agent cible et n'écrasent aucun cas de test existant. Pour importer des scénarios de test, procédez comme suit :

- Cliquez sur Import (Importer).

- Choisissez un fichier local ou fournissez un URI de bucket Cloud Storage.