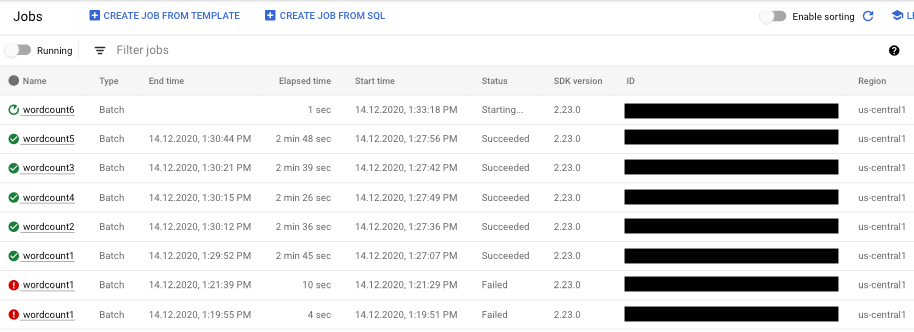

Per visualizzare un elenco dei tuoi job Dataflow, vai alla pagina Dataflow > Job nella console Google Cloud .

Viene visualizzato un elenco di job Dataflow insieme al relativo stato.

Un job può avere i seguenti stati:

- —: l'interfaccia di monitoraggio non ha ancora ricevuto uno stato dal servizio Dataflow.

- In esecuzione: il job è in esecuzione.

- Avvio in corso…: il job è stato creato, ma il sistema ha bisogno di un po' di tempo per prepararsi prima dell'avvio.

- In coda: un job FlexRS è in coda o un job Flex Template è in fase di avvio (operazione che potrebbe richiedere diversi minuti).

- Annullamento in corso…: il job è in fase di annullamento.

- Annullato: il job è stato annullato.

- Svuotamento in corso…: il job è in fase di svuotamento.

- Drained: il job è stato svuotato.

- Aggiornamento in corso…: il job è in fase di aggiornamento.

- Aggiornato: il job è stato aggiornato.

- Riuscito: il job è stato completato correttamente.

- Non riuscito: il job non è stato completato.

Accedere ai visualizzatori di job

Per accedere ai grafici per il monitoraggio del job, fai clic sul nome del job nell'interfaccia di monitoraggio di Dataflow. Viene visualizzata la pagina Dettagli job, che contiene le seguenti informazioni:

- Grafico del job: rappresentazione visiva della pipeline

- Dettagli esecuzione: strumento per ottimizzare il rendimento della pipeline

- Metriche del job: metriche relative all'esecuzione del job

- Costo: metriche relative al costo stimato del job

- Scalabilità automatica: metriche relative agli eventi di scalabilità automatica dei job di streaming

- Riquadro informazioni job: informazioni descrittive sulla pipeline

- Log job: log generati dal servizio Dataflow a livello di job

- Log dei worker: log generati dal servizio Dataflow a livello di worker

- Diagnostica: tabella che mostra dove si sono verificati errori lungo la cronologia scelta e possibili consigli per la tua pipeline

- Campionamento dei dati: strumento che consente di osservare i dati in ogni passaggio di una pipeline

Nella pagina Dettagli job, puoi cambiare la visualizzazione del job con le schede Grafico job, Dettagli esecuzione, Metriche job, Costo e Scalabilità automatica.

Utilizza Google Cloud CLI per elencare i job

Puoi anche utilizzare Google Cloud CLI per ottenere un elenco dei tuoi job Dataflow.

Per elencare i job Dataflow nel tuo progetto, utilizza il

comando dataflow jobs list:

gcloud dataflow jobs list

Il comando restituisce un elenco dei tuoi job attuali. Di seguito è riportato un output di esempio:

ID NAME TYPE CREATION_TIME STATE REGION 2015-06-03_16_39_22-4020553808241078833 wordcount-janedoe-0603233849 Batch 2015-06-03 16:39:22 Done us-central1 2015-06-03_16_38_28-4363652261786938862 wordcount-johndoe-0603233820 Batch 2015-06-03 16:38:28 Done us-central1 2015-05-21_16_24_11-17823098268333533078 bigquerytornadoes-johndoe-0521232402 Batch 2015-05-21 16:24:11 Done europe-west1 2015-05-21_13_38_06-16409850040969261121 bigquerytornadoes-johndoe-0521203801 Batch 2015-05-21 13:38:06 Done us-central1 2015-05-21_13_17_18-18349574013243942260 bigquerytornadoes-johndoe-0521201710 Batch 2015-05-21 13:17:18 Done europe-west1 2015-05-21_12_49_37-9791290545307959963 wordcount-johndoe-0521194928 Batch 2015-05-21 12:49:37 Done us-central1 2015-05-20_15_54_51-15905022415025455887 wordcount-johndoe-0520225444 Batch 2015-05-20 15:54:51 Failed us-central1 2015-05-20_15_47_02-14774624590029708464 wordcount-johndoe-0520224637 Batch 2015-05-20 15:47:02 Done us-central1

Per visualizzare ulteriori informazioni su un job, utilizza il comando

dataflow jobs describe:

gcloud dataflow jobs describe JOB_ID

Sostituisci JOB_ID con il job ID. L'output di

questo comando è simile al seguente:

createTime: '2015-02-09T19:39:41.140Z' currentState: JOB_STATE_DONE currentStateTime: '2015-02-09T19:56:39.510Z' id: 2015-02-09_11_39_40-15635991037808002875 name: tfidf-bchambers-0209193926 projectId: google.com:clouddfe type: JOB_TYPE_BATCH

Per formattare il risultato in JSON, esegui il comando con l'opzione --format=json:

gcloud --format=json dataflow jobs describe JOB_ID

Archiviare (nascondere) i job Dataflow da un elenco

Quando archivi un job Dataflow, questo viene rimosso dall'elenco dei job nella pagina Job di Dataflow nella console. Il job viene spostato in un elenco di job archiviati. Puoi archiviare solo i job completati, inclusi quelli nei seguenti stati:

JOB_STATE_CANCELLEDJOB_STATE_DRAINEDJOB_STATE_DONEJOB_STATE_FAILEDJOB_STATE_UPDATED

Per maggiori informazioni sulla verifica di questi stati, consulta Rilevare il completamento del job Dataflow.

Per informazioni sulla risoluzione dei problemi durante l'archiviazione dei job, vedi Errori di archiviazione dei job in "Risolvere i problemi relativi a Dataflow".

Tutti i lavori archiviati vengono eliminati dopo un periodo di conservazione di 30 giorni.

Archiviare un job

Segui questi passaggi per rimuovere un job completato dall'elenco principale dei job nella pagina Job di Dataflow.

Console

Nella console Google Cloud , vai alla pagina Job di Dataflow.

Viene visualizzato un elenco di job Dataflow insieme al relativo stato.

Seleziona un lavoro.

Nella pagina Dettagli job, fai clic su Archivia. Se il job non è stato completato, l'opzione Archivia non è disponibile.

REST

Per archiviare un job utilizzando l'API, utilizza il metodo

projects.locations.jobs.update.

In questa richiesta devi specificare un oggetto

JobMetadata

aggiornato. Nell'oggetto JobMetadata.userDisplayProperties, utilizza la coppia chiave-valore

"archived":"true".

Oltre all'oggetto JobMetadata aggiornato, la richiesta API deve includere anche il parametro di query updateMask nell'URL della richiesta:

https://dataflow.googleapis.com/v1b3/[...]/jobs/JOB_ID/?updateMask=job_metadata.user_display_properties.archived

Prima di utilizzare i dati della richiesta, apporta le seguenti sostituzioni:

- PROJECT_ID: il tuo ID progetto

- REGION: una regione Dataflow

- JOB_ID: l'ID del job Dataflow

Metodo HTTP e URL:

PUT https://dataflow.googleapis.com/v1b3/projects/PROJECT_ID/locations/REGION/jobs/JOB_ID/?updateMask=job_metadata.user_display_properties.archived

Corpo JSON della richiesta:

{

"job_metadata": {

"userDisplayProperties": {

"archived": "true"

}

}

}

Per inviare la richiesta, scegli una di queste opzioni:

curl

Salva il corpo della richiesta in un file denominato request.json,

ed esegui questo comando:

curl -X PUT \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "Content-Type: application/json; charset=utf-8" \

-d @request.json \

"https://dataflow.googleapis.com/v1b3/projects/PROJECT_ID/locations/REGION/jobs/JOB_ID/?updateMask=job_metadata.user_display_properties.archived"

PowerShell

Salva il corpo della richiesta in un file denominato request.json,

quindi esegui il comando seguente:

$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred" }

Invoke-WebRequest `

-Method PUT `

-Headers $headers `

-ContentType: "application/json; charset=utf-8" `

-InFile request.json `

-Uri "https://dataflow.googleapis.com/v1b3/projects/PROJECT_ID/locations/REGION/jobs/JOB_ID/?updateMask=job_metadata.user_display_properties.archived" | Select-Object -Expand Content

Dovresti ricevere una risposta JSON simile alla seguente:

{

"id": "JOB_ID",

"projectId": "PROJECT_ID",

"currentState": "JOB_STATE_DONE",

"currentStateTime": "2025-05-20T20:54:41.651442Z",

"createTime": "2025-05-20T20:51:06.031248Z",

"jobMetadata": {

"userDisplayProperties": {

"archived": "true"

}

},

"startTime": "2025-05-20T20:51:06.031248Z"

}

gcloud

Questo comando archivia un singolo job. Il job deve essere in uno stato terminale per poterlo archiviare. In caso contrario, la richiesta viene rifiutata. Dopo aver inviato il comando, devi confermare che vuoi eseguirlo.

Prima di utilizzare i dati dei comandi riportati di seguito, effettua le seguenti sostituzioni:

JOB_ID: l'ID del job Dataflow che vuoi archiviare.REGION: (Facoltativo). La regione Dataflow del job.

Esegui questo comando:

Linux, macOS o Cloud Shell

gcloud dataflow jobs archive JOB_ID --region=REGION_ID

Windows (PowerShell)

gcloud dataflow jobs archive JOB_ID --region=REGION_ID

Windows (cmd.exe)

gcloud dataflow jobs archive JOB_ID --region=REGION_ID

Dovresti ricevere una risposta simile alla seguente:

Archived job [JOB_ID].

createTime: '2025-06-29T11:00:02.432552Z'

currentState: JOB_STATE_DONE

currentStateTime: '2025-06-29T11:04:25.125921Z'

id: JOB_ID

jobMetadata:

userDisplayProperties:

archived: 'true'

projectId: PROJECT_ID

startTime: '2025-06-29T11:00:02.432552Z'

Visualizzare e ripristinare i job archiviati

Segui questi passaggi per visualizzare i job archiviati o per ripristinarli nell'elenco principale dei job nella pagina Job di Dataflow.

Console

Nella console Google Cloud , vai alla pagina Job di Dataflow.

Fai clic sul pulsante di attivazione/disattivazione Archiviati. Viene visualizzato un elenco di job Dataflow archiviati.

Seleziona un lavoro.

Per ripristinare il job nell'elenco principale dei job nella pagina Job di Dataflow, fai clic su Ripristina nella pagina Dettagli job.

REST

Per ripristinare un job archiviato utilizzando l'API, utilizza il metodo

projects.locations.jobs.update.

In questa richiesta devi specificare un oggetto

JobMetadata

aggiornato. Nell'oggetto JobMetadata.userDisplayProperties, utilizza la

coppia chiave-valore "archived":"false".

Oltre all'oggetto JobMetadata aggiornato, la richiesta API deve includere anche il parametro di query updateMask nell'URL della richiesta:

https://dataflow.googleapis.com/v1b3/[...]/jobs/JOB_ID/?updateMask=job_metadata.user_display_properties.archived

Prima di utilizzare i dati della richiesta, apporta le seguenti sostituzioni:

- PROJECT_ID: il tuo ID progetto

- REGION: una regione Dataflow

- JOB_ID: l'ID del job Dataflow

Metodo HTTP e URL:

PUT https://dataflow.googleapis.com/v1b3/projects/PROJECT_ID/locations/REGION/jobs/JOB_ID/?updateMask=job_metadata.user_display_properties.archived

Corpo JSON della richiesta:

{

"job_metadata": {

"userDisplayProperties": {

"archived": "false"

}

}

}

Per inviare la richiesta, scegli una di queste opzioni:

curl

Salva il corpo della richiesta in un file denominato request.json,

ed esegui questo comando:

curl -X PUT \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "Content-Type: application/json; charset=utf-8" \

-d @request.json \

"https://dataflow.googleapis.com/v1b3/projects/PROJECT_ID/locations/REGION/jobs/JOB_ID/?updateMask=job_metadata.user_display_properties.archived"

PowerShell

Salva il corpo della richiesta in un file denominato request.json,

quindi esegui il comando seguente:

$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred" }

Invoke-WebRequest `

-Method PUT `

-Headers $headers `

-ContentType: "application/json; charset=utf-8" `

-InFile request.json `

-Uri "https://dataflow.googleapis.com/v1b3/projects/PROJECT_ID/locations/REGION/jobs/JOB_ID/?updateMask=job_metadata.user_display_properties.archived" | Select-Object -Expand Content

Dovresti ricevere una risposta JSON simile alla seguente:

{

"id": "JOB_ID",

"projectId": "PROJECT_ID",

"currentState": "JOB_STATE_DONE",

"currentStateTime": "2025-05-20T20:54:41.651442Z",

"createTime": "2025-05-20T20:51:06.031248Z",

"jobMetadata": {

"userDisplayProperties": {

"archived": "false"

}

},

"startTime": "2025-05-20T20:51:06.031248Z"

}