Esta página descreve como gerenciar o controle de acesso ao implantar e executar um pipeline que usa clusters do Dataproc em outro Google Cloud projeto.

Cenário

Por padrão, quando uma instância do Cloud Data Fusion é iniciada em um projetoGoogle Cloud , ela implanta e executa pipelines usando clusters do Dataproc no mesmo projeto. No entanto, sua organização pode exigir que você use clusters em outro projeto. Para esse caso de uso, é necessário gerenciar o acesso entre os projetos. A página a seguir descreve como mudar as configurações de referência (padrão) e aplicar os controles de acesso adequados.

Antes de começar

Para entender as soluções neste caso de uso, você precisa do seguinte contexto:

- Conhecimento sobre os conceitos básicos do Cloud Data Fusion

- Conhecimento sobre o gerenciamento de identidade e acesso (IAM) do Cloud Data Fusion

- Conhecimento sobre a rede do Cloud Data Fusion

Pressuposições e escopo

Esse caso de uso tem os seguintes requisitos:

- Uma instância privada do Cloud Data Fusion. Por motivos de segurança, uma organização pode exigir que você use esse tipo de instância.

- Uma origem e um coletor do BigQuery.

- Controle de acesso com o IAM, não o controle de acesso baseado em papéis (RBAC).

Solução

Essa solução compara a arquitetura e a configuração específicas do caso de uso e da referência.

Arquitetura

Os diagramas a seguir comparam a arquitetura do projeto para criar uma instância do Cloud Data Fusion e executar pipelines quando você usa clusters no mesmo projeto (valor de referência) e em um projeto diferente pela VPC do projeto de locatário.

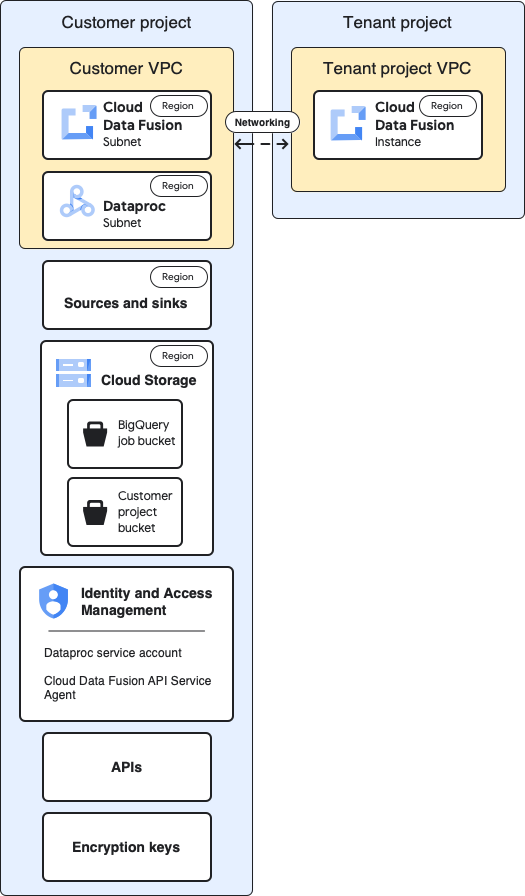

Arquitetura de referência

Este diagrama mostra a arquitetura de referência dos projetos:

Para a configuração de referência, crie uma instância particular do Cloud Data Fusion e execute um pipeline sem personalização adicional:

- Você usa um dos perfis de computação integrados

- A origem e o coletor estão no mesmo projeto da instância

- Nenhum outro papel foi concedido a nenhuma das contas de serviço

Para mais informações sobre projetos de locatário e cliente, consulte Redes.

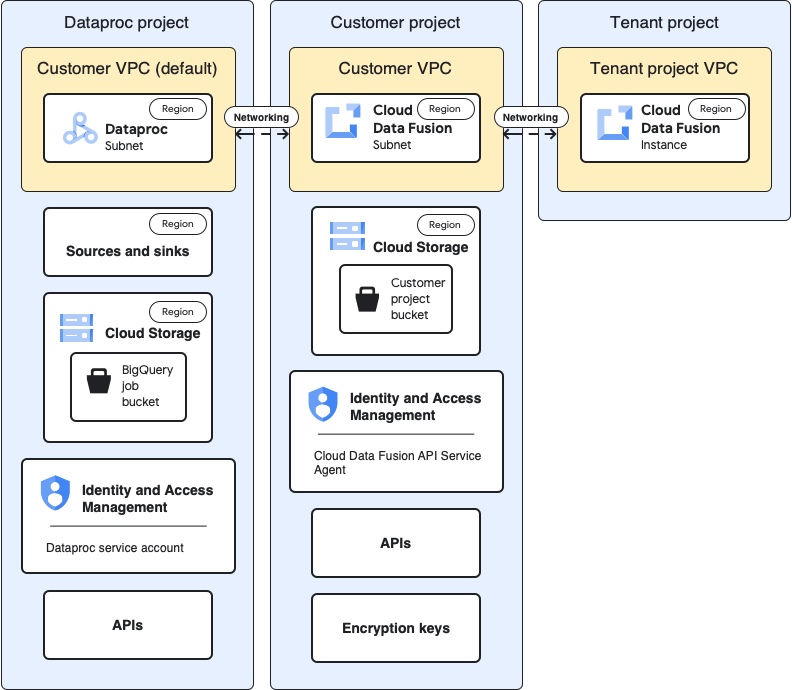

Arquitetura de casos de uso

Este diagrama mostra a arquitetura do projeto quando você usa clusters em outro projeto:

Configurações

As seções a seguir comparam as configurações de referência às configurações específicas do caso de uso para usar clusters do Dataproc em um projeto diferente pela VPC padrão do projeto do locatário.

Nas descrições de caso de uso a seguir, o projeto do cliente é onde a instância do Cloud Data Fusion é executada, e o projeto do Dataproc é onde o cluster do Dataproc é iniciado.

VPC e instância do projeto do locatário

| Valor de referência | Caso de uso |

|---|---|

No diagrama de arquitetura de referência anterior, o projeto do locatário

contém os seguintes componentes:

|

Não é necessário fazer mais nenhuma configuração para esse caso de uso. |

Projeto do cliente

| Valor de referência | Caso de uso |

|---|---|

| Seu projeto Google Cloud é onde você implanta e executa pipelines. Por padrão, os clusters do Dataproc são iniciados neste projeto quando você executa os pipelines. | Neste caso de uso, você gerencia dois projetos. Nesta página, o projeto do cliente se refere ao local em que a instância do Cloud Data Fusion é executada. O projeto do Dataproc se refere a onde os clusters do Dataproc são iniciados. |

VPC do cliente

| Valor de referência | Caso de uso |

|---|---|

Do seu ponto de vista (do cliente), a VPC do cliente é onde o Cloud Data Fusion está localizado de maneira lógica. Principal aprendizado: você pode encontrar os detalhes da VPC do cliente na página "Redes VPC" do seu projeto. |

Não é necessário fazer mais nenhuma configuração para esse caso de uso. |

Sub-rede do Cloud Data Fusion

| Valor de referência | Caso de uso |

|---|---|

Do seu ponto de vista (do cliente), essa sub-rede é onde o Cloud Data Fusion está localizado de forma lógica. Principal aprendizado: a região dessa sub-rede é a mesma do local da instância do Cloud Data Fusion no projeto do locatário. |

Não é necessário fazer mais nenhuma configuração para esse caso de uso. |

Sub-rede do Dataproc

| Valor de referência | Caso de uso |

|---|---|

A sub-rede em que os clusters do Dataproc são iniciados quando você executa um pipeline. Aprendizados importantes:

|

É uma nova sub-rede em que os clusters do Dataproc são iniciados quando você executa um pipeline. Aprendizados importantes:

|

Origens e coletores

| Valor de referência | Caso de uso |

|---|---|

As origens em que os dados são extraídos e os coletores em que os dados são carregados, como origens e coletores do BigQuery. Aprendizado importante:

|

As configurações de controle de acesso específicas do caso de uso nesta página são para fontes e destinos do BigQuery. |

Cloud Storage

| Valor de referência | Caso de uso |

|---|---|

O bucket de armazenamento no projeto do cliente que ajuda a transferir arquivos entre o Cloud Data Fusion e o Dataproc. Aprendizados importantes:

|

Não é necessário fazer mais nenhuma configuração para esse caso de uso. |

Buckets temporários usados pela origem e pelo coletor

| Valor de referência | Caso de uso |

|---|---|

Os buckets temporários criados por plug-ins para suas origens e coletores, como os jobs de carregamento iniciados pelo plug-in de coletor do BigQuery. Aprendizados importantes:

|

Para este caso de uso, o bucket pode ser criado em qualquer projeto. |

Buckets que são origens ou coletores de dados para plug-ins

| Valor de referência | Caso de uso |

|---|---|

| Os buckets do cliente, que você especifica nas configurações de plug-ins, como o plug-in do Cloud Storage e o plug-in do FTP para o Cloud Storage. | Não é necessário fazer mais nenhuma configuração para esse caso de uso. |

IAM: agente de serviço da API Cloud Data Fusion

| Valor de referência | Caso de uso |

|---|---|

Quando a API Cloud Data Fusion é ativada, o papel de agente de serviço da API Cloud Data Fusion ( Aprendizados importantes:

|

Para esse caso de uso, conceda o papel de agente de serviço da API Cloud Data Fusion à conta de serviço no projeto do Dataproc. Em seguida, conceda os seguintes papéis nesse projeto:

|

IAM: conta de serviço do Dataproc

| Valor de referência | Caso de uso |

|---|---|

A conta de serviço usada para executar o pipeline como um job no cluster do Dataproc. Por padrão, é a conta de serviço do Compute Engine. Opcional: na configuração de referência, você pode mudar a conta de serviço padrão para outra conta de serviço do mesmo projeto. Conceda os seguintes papéis do IAM à nova conta de serviço:

|

Este exemplo de caso de uso pressupõe que você use a conta de serviço padrão do Compute Engine ( Conceda os seguintes papéis à conta de serviço padrão do Compute Engine no projeto do Dataproc.

Conceda o papel de usuário da conta de serviço ao Cloud Data Fusion na conta de serviço padrão do Compute Engine do projeto do Dataproc. Essa ação precisa ser realizada no projeto do Dataproc. Adicione a conta de serviço padrão do Compute Engine do projeto do Dataproc ao projeto do Cloud Data Fusion. Conceda também os seguintes papéis:

|

APIs

| Valor de referência | Caso de uso |

|---|---|

Quando você ativa a API Cloud Data Fusion, as APIs a seguir também são ativadas. Para mais informações sobre essas APIs, acesse a página "APIs e serviços" do seu projeto.

Quando você ativa a API Cloud Data Fusion, as seguintes contas de serviço são adicionadas automaticamente ao seu projeto:

|

Para este caso de uso, ative as seguintes APIs no projeto que

contém o Dataproc:

|

Chaves de criptografia

| Valor de referência | Caso de uso |

|---|---|

Na configuração de referência, as chaves de criptografia podem ser gerenciadas pelo Google ou CMEK Aprendizados importantes: Se você usar a CMEK, a configuração de referência vai exigir o seguinte:

Dependendo dos serviços usados no pipeline, como o BigQuery ou o Cloud Storage, as contas de serviço também precisam ter a função de Criptografador/Descriptografador de CryptoKey do Cloud KMS:

|

Se você não usa a CMEK, não é necessário fazer outras mudanças para esse caso de uso. Se você usar a CMEK, o papel Criptografador/Descriptografador do CryptoKey do Cloud KMS precisa ser fornecido à conta de serviço a seguir no nível da chave no projeto em que ela foi criada:

Dependendo dos serviços usados no pipeline, como o BigQuery ou o Cloud Storage, outras contas de serviço também precisam receber o papel de Criptografador/Descriptografador de CryptoKey do Cloud KMS no nível da chave. Exemplo:

|

Depois de fazer essas configurações específicas do caso de uso, o pipeline de dados poderá começar a ser executado em clusters em outro projeto.

A seguir

- Saiba mais sobre redes no Cloud Data Fusion.

- Consulte a Referência dos papéis básicos e predefinidos do IAM.