Il connettore Hive-BigQuery open source consente ai carichi di lavoro Apache Hive di leggere e scrivere dati da e verso le tabelle BigQuery e BigLake. Puoi archiviare i dati nell'archivio BigQuery o in formati di dati open source su Cloud Storage.

Il connettore Hive-BigQuery implementa l'API Hive Storage Handler per consentire l'integrazione dei carichi di lavoro Hive con le tabelle BigQuery e BigLake. Il motore di esecuzione Hive gestisce le operazioni di calcolo, come aggregazioni e join, e il connettore gestisce le interazioni con i dati archiviati in BigQuery o nei bucket Cloud Storage connessi a BigLake.

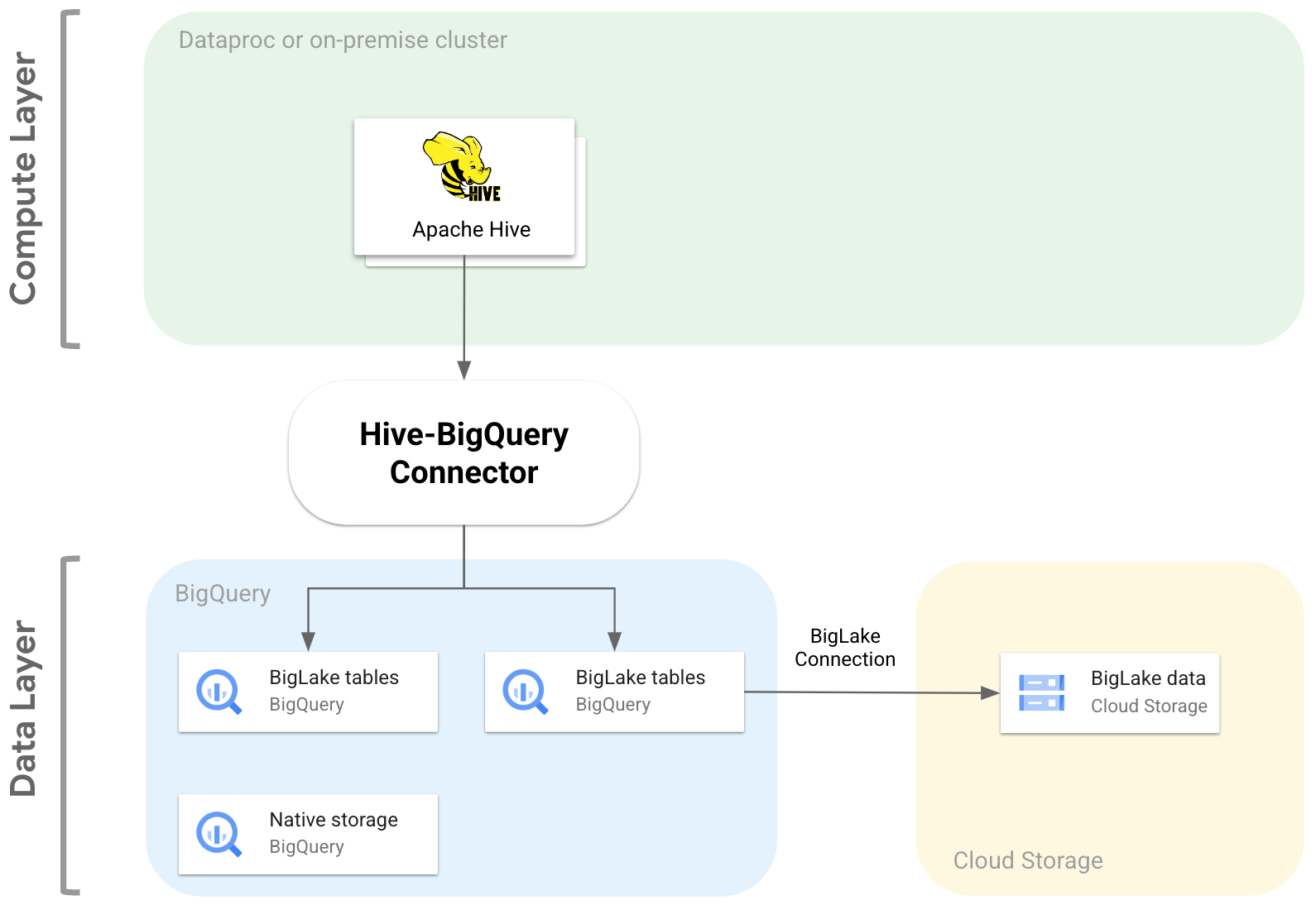

Il seguente diagramma illustra come il connettore Hive-BigQuery si inserisce tra i livelli di calcolo e dati.

Casi d'uso

Ecco alcuni modi in cui il connettore Hive-BigQuery può aiutarti in scenari comuni basati sui dati:

Migrazione dei dati. Prevedi di spostare il data warehouse Hive in BigQuery, quindi di tradurre in modo incrementale le query Hive nel dialetto SQL di BigQuery. Prevedi che la migrazione richieda un tempo significativo a causa delle dimensioni del data warehouse e del numero elevato di applicazioni connesse e devi garantire la continuità durante le operazioni di migrazione. Ecco il flusso di lavoro:

- Trasferisci i dati a BigQuery

- Utilizzando il connettore, puoi accedere ed eseguire le query Hive originali mentre traduci gradualmente le query Hive nel dialetto SQL conforme allo standard ANSI di BigQuery.

- Dopo aver completato la migrazione e la traduzione, ritiri Hive.

Workflow Hive e BigQuery. Prevedi di utilizzare Hive per alcune attività e BigQuery per i workload che traggono vantaggio dalle sue funzionalità, come BigQuery BI Engine o BigQuery ML. Utilizzi il connettore per unire le tabelle Hive alle tabelle BigQuery.

Affidamento a uno stack software open source (OSS). Per evitare il lock-in del fornitore, utilizzi uno stack OSS completo per il tuo data warehouse. Ecco il tuo piano dati:

Migri i dati nel formato OSS originale, ad esempio Avro, Parquet o ORC, nei bucket Cloud Storage utilizzando una connessione BigLake.

Continui a utilizzare Hive per eseguire ed elaborare le query del dialetto SQL di Hive.

Utilizzi il connettore in base alle esigenze per connetterti a BigQuery e usufruire delle seguenti funzionalità:

- Memorizzazione nella cache dei metadati per le prestazioni delle query

- Prevenzione della perdita di dati

- Controllo dell'accesso a livello di colonna

- Mascheramento dinamico dei dati per la sicurezza e la governance su vasta scala.

Funzionalità

Puoi utilizzare il connettore Hive-BigQuery per lavorare con i dati BigQuery e svolgere le seguenti attività:

- Esegui query con i motori di esecuzione MapReduce e Tez.

- Crea ed elimina tabelle BigQuery da Hive.

- Unire le tabelle BigQuery e BigLake con le tabelle Hive.

- Esegui letture rapide dalle tabelle BigQuery utilizzando i flussi dell'API Storage Read e il formato Apache Arrow.

- Scrivi i dati in BigQuery utilizzando i seguenti

metodi:

- Scritture dirette utilizzando l'API BigQuery Storage Write in modalità in attesa. Utilizza questo metodo per i workload che richiedono una bassa latenza di scrittura, ad esempio dashboard quasi in tempo reale con brevi finestre di aggiornamento.

- Scritture indirette mediante lo staging di file Avro temporanei in Cloud Storage e poi il caricamento dei file in una tabella di destinazione utilizzando l'API Load Job. Questo metodo è meno costoso di quello diretto, poiché i job di caricamento di BigQuery non comportano addebiti. Poiché questo metodo è più lento e trova il suo miglior utilizzo in carichi di lavoro non urgenti

Accedi alle tabelle partizionate in base al tempo e in cluster di BigQuery. Il seguente esempio definisce la relazione tra una tabella Hive e una tabella partizionata e raggruppata in cluster in BigQuery.

CREATE TABLE my_hive_table (int_val BIGINT, text STRING, ts TIMESTAMP) STORED BY 'com.google.cloud.hive.bigquery.connector.BigQueryStorageHandler' TBLPROPERTIES ( 'bq.table'='myproject.mydataset.mytable', 'bq.time.partition.field'='ts', 'bq.time.partition.type'='MONTH', 'bq.clustered.fields'='int_val,text' );

Elimina le colonne per evitare di recuperare colonne non necessarie dal livello dati.

Utilizza i pushdown dei predicati per prefiltrare le righe di dati nel livello di archiviazione BigQuery. Questa tecnica può migliorare significativamente le prestazioni complessive delle query riducendo la quantità di dati che attraversano la rete.

Converti automaticamente i tipi di dati Hive in tipi di dati BigQuery.

Leggi le viste e gli snapshot delle tabelle di BigQuery.

Esegui l'integrazione con Spark SQL.

Integrare con Apache Pig e HCatalog.

Inizia

Consulta le istruzioni per installare e configurare il connettore Hive-BigQuery su un cluster Hive.