Questo documento descrive come installare e utilizzare l'estensione JupyterLab su una macchina o una VM autogestita che ha accesso ai servizi Google. Descrive inoltre come sviluppare ed eseguire il deployment del codice del notebook Spark serverless.

Installa l'estensione in pochi minuti per usufruire delle seguenti funzionalità:

- Avvia notebook Spark e BigQuery serverless per sviluppare rapidamente il codice

- Sfoglia e visualizza l'anteprima dei set di dati BigQuery in JupyterLab

- Modificare i file Cloud Storage in JupyterLab

- Pianificare un notebook su Composer

Prima di iniziare

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Enable the Dataproc API.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. -

Install the Google Cloud CLI.

-

Se utilizzi un provider di identità (IdP) esterno, devi prima accedere a gcloud CLI con la tua identità federata.

-

Per inizializzare gcloud CLI, esegui questo comando:

gcloud init -

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Enable the Dataproc API.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. -

Install the Google Cloud CLI.

-

Se utilizzi un provider di identità (IdP) esterno, devi prima accedere a gcloud CLI con la tua identità federata.

-

Per inizializzare gcloud CLI, esegui questo comando:

gcloud init Scarica e installa Python versione 3.11 o successive da

python.org/downloads.- Verifica l'installazione di Python 3.11+.

python3 --version

- Verifica l'installazione di Python 3.11+.

Virtualizza l'ambiente Python.

pip3 install pipenv

- Crea una cartella di installazione.

mkdir jupyter

- Passa alla cartella di installazione.

cd jupyter

- Crea un ambiente virtuale.

pipenv shell

- Crea una cartella di installazione.

Installa JupyterLab nell'ambiente virtuale.

pipenv install jupyterlab

Installa l'estensione JupyterLab.

pipenv install bigquery-jupyter-plugin

jupyter lab

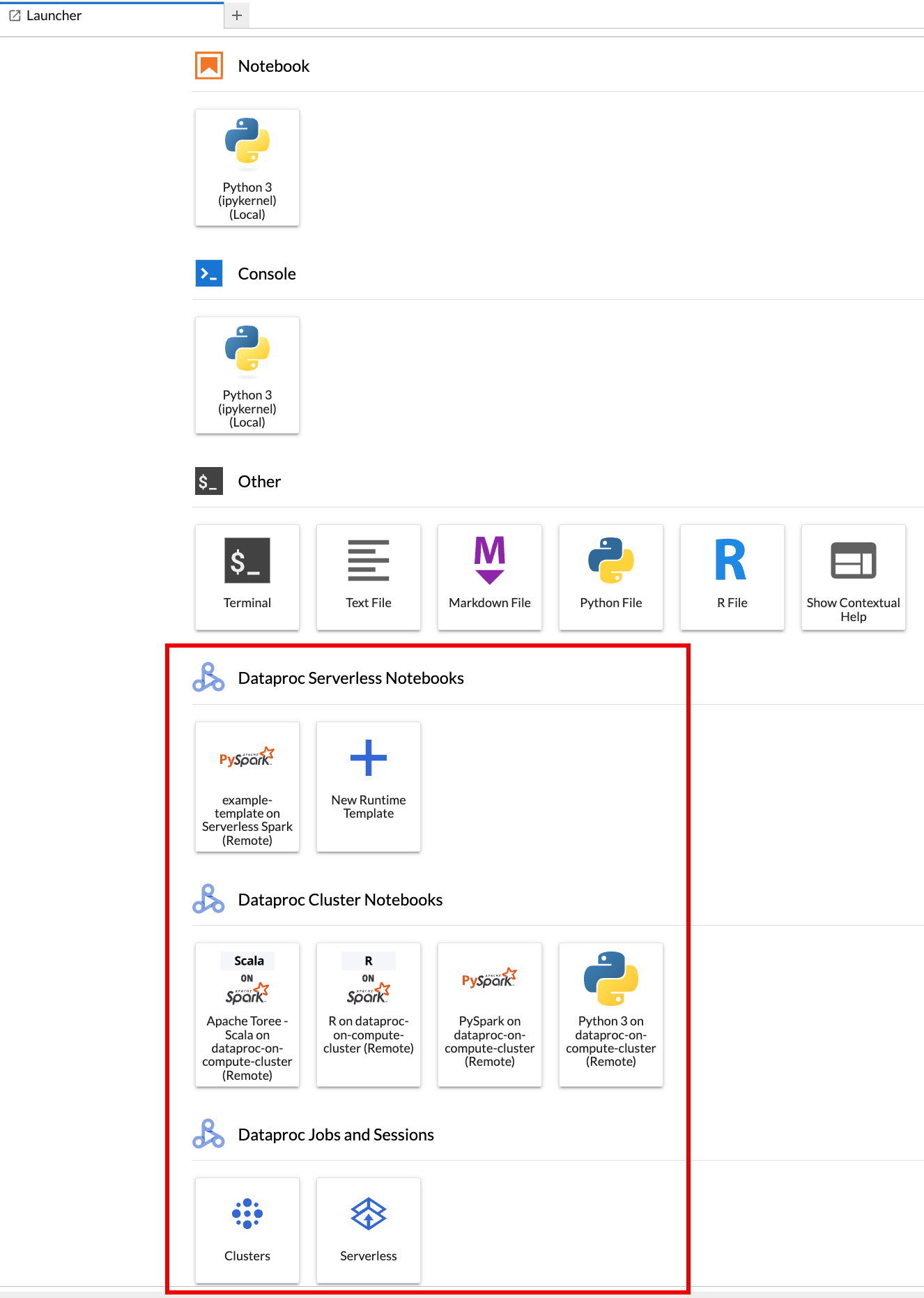

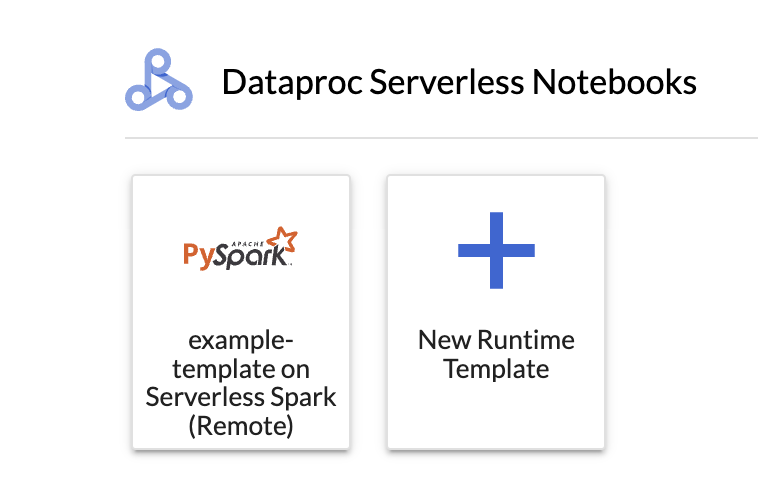

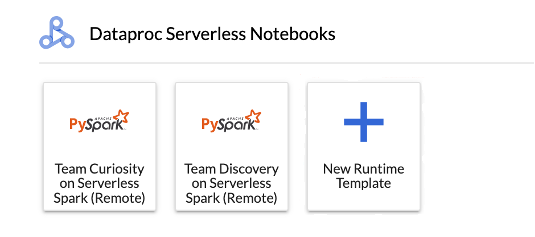

La pagina Avvio app di JupyterLab si apre nel browser. Contiene una sezione Job e sessioni Dataproc. Può contenere anche le sezioni Blocchi note Serverless per Apache Spark e Blocchi note cluster Dataproc se hai accesso ai blocchi note serverless Dataproc o ai cluster Dataproc con il componente facoltativo Jupyter in esecuzione nel tuo progetto.

Per impostazione predefinita, la sessione interattiva Serverless per Apache Spark viene eseguita nel progetto e nella regione che hai impostato quando hai eseguito

gcloud initin Prima di iniziare. Puoi modificare le impostazioni del progetto e della regione per le tue sessioni da JupyterLab Impostazioni > Google Cloud Impostazioni > Google Cloud Impostazioni progetto.Per applicare le modifiche, devi riavviare l'estensione.

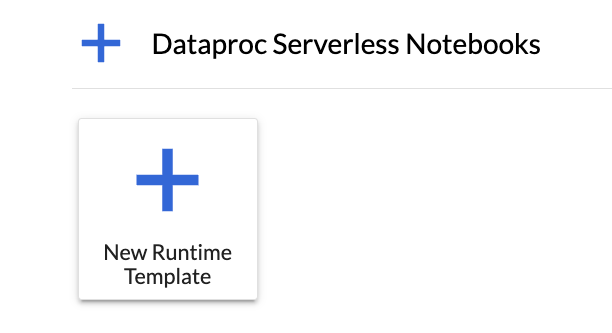

Fai clic sulla scheda

New runtime templatenella sezione Blocchi note serverless per Apache Spark nella pagina Launcher di JupyterLab.

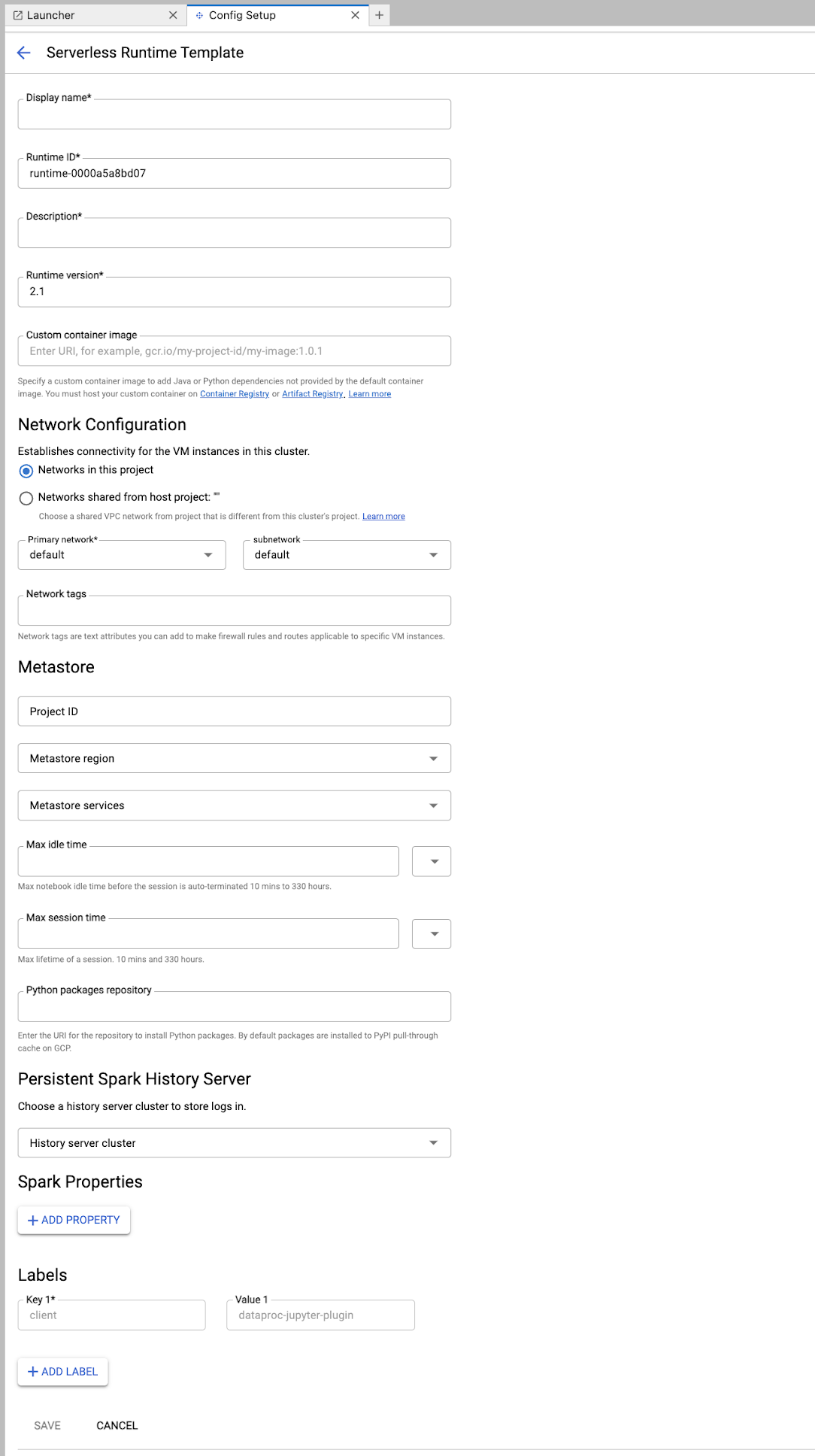

Compila il modulo Modello di runtime.

Informazioni sul modello:

- Nome visualizzato, ID runtime e Descrizione: accetta o compila un nome visualizzato del modello, un ID runtime del modello e una descrizione del modello.

Configurazione dell'esecuzione: seleziona Account utente per eseguire i blocchi note con l'identità utente anziché con l'identità del account di servizio Dataproc.

- Service account: se non specifichi un account di servizio, viene utilizzato il service account di servizio predefinito di Compute Engine.

- Versione runtime: conferma o seleziona la versione runtime.

- Immagine container personalizzata: specifica facoltativamente l'URI di un'immagine container personalizzata.

- Bucket di staging: puoi specificare facoltativamente il nome di un bucket di staging Cloud Storage da utilizzare con Serverless per Apache Spark.

- Repository di pacchetti Python: per impostazione predefinita, i pacchetti Python vengono scaricati e installati dalla cache pull-through PyPI quando gli utenti eseguono i comandi di installazione

pipnei loro notebook. Puoi specificare il repository di artefatti privati della tua organizzazione per i pacchetti Python da utilizzare come repository predefinito dei pacchetti Python.

Crittografia: accetta il valore predefinito Google-owned and Google-managed encryption key o seleziona Chiave di crittografia gestita dal cliente (CMEK). Se CMEK, seleziona o fornisci le informazioni sulla chiave.

Configurazione di rete: seleziona una subnet nel progetto o condivisa da un progetto host (puoi modificare il progetto da JupyterLab Impostazioni > Google Cloud Impostazioni > Google Cloud Impostazioni progetto. Puoi specificare tag di rete da applicare alla rete specificata. Tieni presente che Serverless per Apache Spark abilita l'accesso privato Google (PGA) nella subnet specificata. Per i requisiti di connettività di rete, vedi Google Cloud Configurazione di rete di Serverless per Apache Spark.

Configurazione sessione: puoi compilare facoltativamente questi campi per limitare la durata delle sessioni create con il modello.

- Tempo massimo di inattività:il tempo massimo di inattività prima che la sessione venga terminata. Intervallo consentito: da 10 minuti a 336 ore (14 giorni).

- Tempo massimo della sessione:la durata massima di una sessione prima che venga terminata. Intervallo consentito: da 10 minuti a 336 ore (14 giorni).

Metastore: per utilizzare un servizio Dataproc Metastore con le tue sessioni, seleziona l'ID progetto e il servizio metastore.

Server di cronologia permanente: puoi selezionare un server di cronologia Spark permanente disponibile per accedere ai log delle sessioni durante e dopo le sessioni.

Proprietà Spark:puoi selezionare e aggiungere le proprietà Allocazione risorse, Scalabilità automatica o GPU di Spark. Fai clic su Aggiungi proprietà per aggiungere altre proprietà Spark. Per maggiori informazioni, vedi Proprietà Spark.

Etichette:fai clic su Aggiungi etichetta per ogni etichetta da impostare nelle sessioni create con il modello.

Fai clic su Salva per creare il modello.

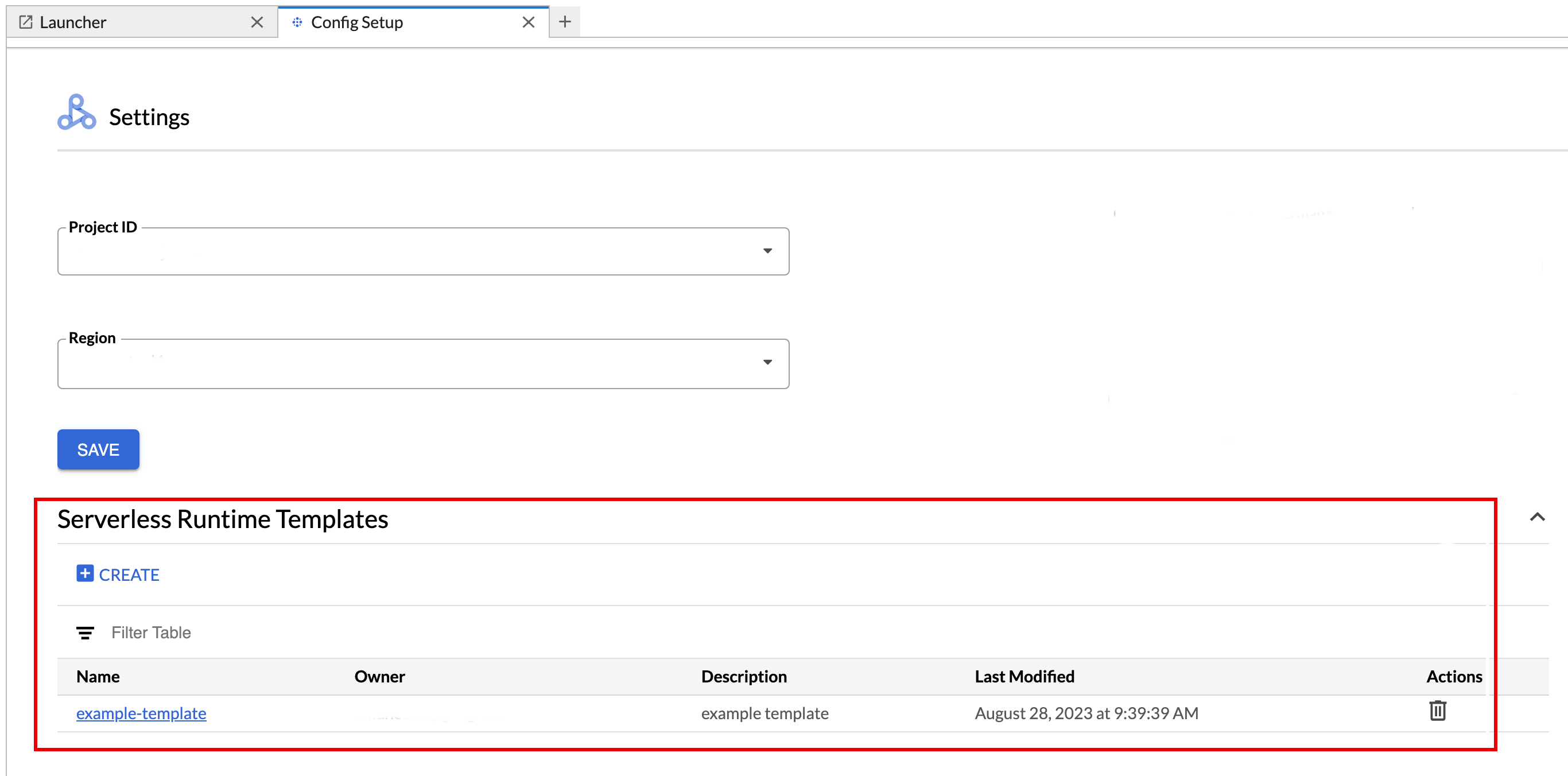

Per visualizzare o eliminare un modello di runtime.

- Fai clic su Impostazioni > Google Cloud Impostazioni.

La sezione Impostazioni Dataproc > Modelli di runtime serverless mostra l'elenco dei modelli di runtime.

- Fai clic sul nome di un modello per visualizzarne i dettagli.

- Puoi eliminare un modello dal menu Azione del modello.

Apri e ricarica la pagina Avvio app di JupyterLab per visualizzare la scheda del modello di notebook salvato nella pagina Avvio app di JupyterLab.

Crea un file YAML con la configurazione del modello di runtime.

YAML semplice

environmentConfig: executionConfig: networkUri: default jupyterSession: kernel: PYTHON displayName: Team A labels: purpose: testing description: Team A Development Environment

YAML complesso

description: Example session template environmentConfig: executionConfig: serviceAccount: sa1 # Choose either networkUri or subnetworkUri networkUri: subnetworkUri: default networkTags: - tag1 kmsKey: key1 idleTtl: 3600s ttl: 14400s stagingBucket: staging-bucket peripheralsConfig: metastoreService: projects/my-project-id/locations/us-central1/services/my-metastore-id sparkHistoryServerConfig: dataprocCluster: projects/my-project-id/regions/us-central1/clusters/my-cluster-id jupyterSession: kernel: PYTHON displayName: Team A labels: purpose: testing runtimeConfig: version: "2.3" containerImage: gcr.io/my-project-id/my-image:1.0.1 properties: "p1": "v1" description: Team A Development Environment

Crea un modello di sessione (runtime) dal file YAML eseguendo il comando gcloud beta dataproc session-templates import localmente o in Cloud Shell:

gcloud beta dataproc session-templates import TEMPLATE_ID \ --source=YAML_FILE \ --project=PROJECT_ID \ --location=REGION

- Consulta gcloud beta dataproc session-templates per i comandi per descrivere, elencare, esportare ed eliminare i modelli di sessione.

Fai clic su una scheda per creare una sessione Serverless per Apache Spark e avviare un notebook. Al termine della creazione della sessione e quando il kernel del notebook è pronto per l'uso, lo stato del kernel cambia da

StartingaIdle (Ready).Scrivere e testare il codice del notebook.

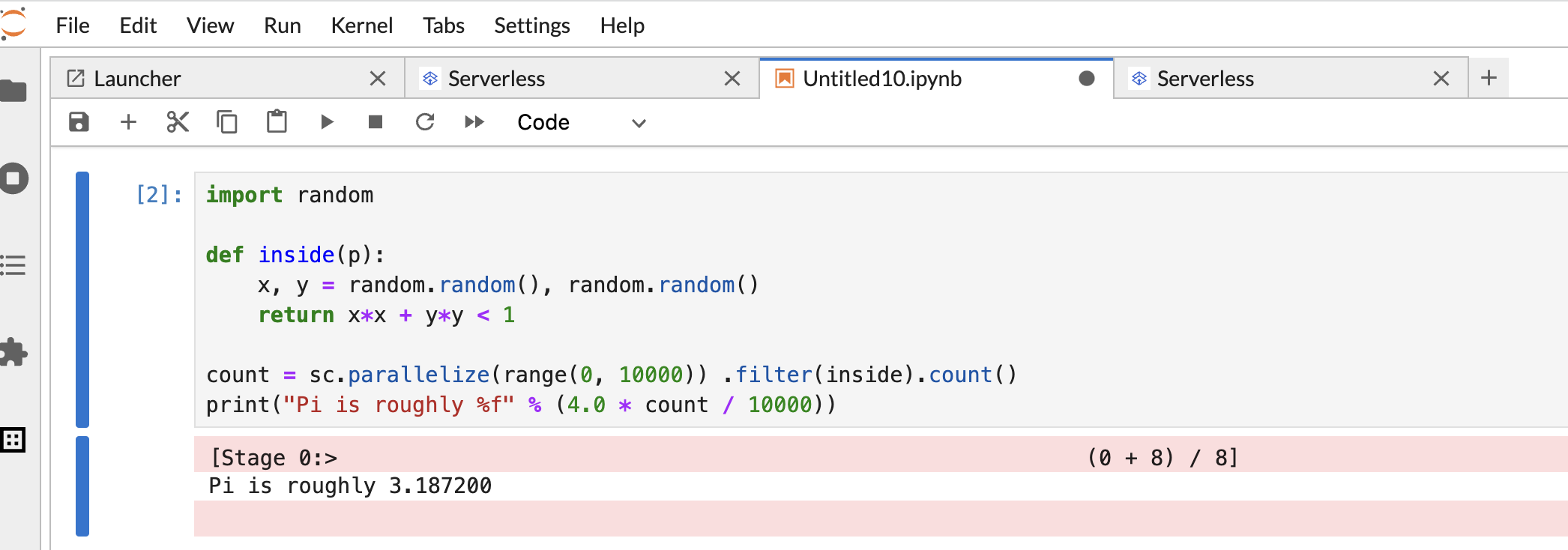

Copia e incolla il seguente codice PySpark

Pi estimationnella cella del notebook PySpark, quindi premi Maiusc+Invio per eseguire il codice.import random def inside(p): x, y = random.random(), random.random() return x*x + y*y < 1 count = sc.parallelize(range(0, 10000)) .filter(inside).count() print("Pi is roughly %f" % (4.0 * count / 10000))

Risultato del notebook:

Dopo aver creato e utilizzato un notebook, puoi terminare la sessione del notebook facendo clic su Arresta kernel nella scheda Kernel.

- Per riutilizzare la sessione, crea un nuovo notebook scegliendo Notebook dal menu File>>Nuovo. Dopo aver creato il nuovo notebook, scegli la sessione esistente dalla finestra di dialogo di selezione del kernel. Il nuovo notebook riutilizzerà la sessione e manterrà il contesto della sessione del notebook precedente.

Se non termini la sessione, Dataproc la termina alla scadenza del timer di inattività della sessione. Puoi configurare il tempo di inattività della sessione nella configurazione del modello di runtime. Il tempo di inattività della sessione predefinito è un'ora.

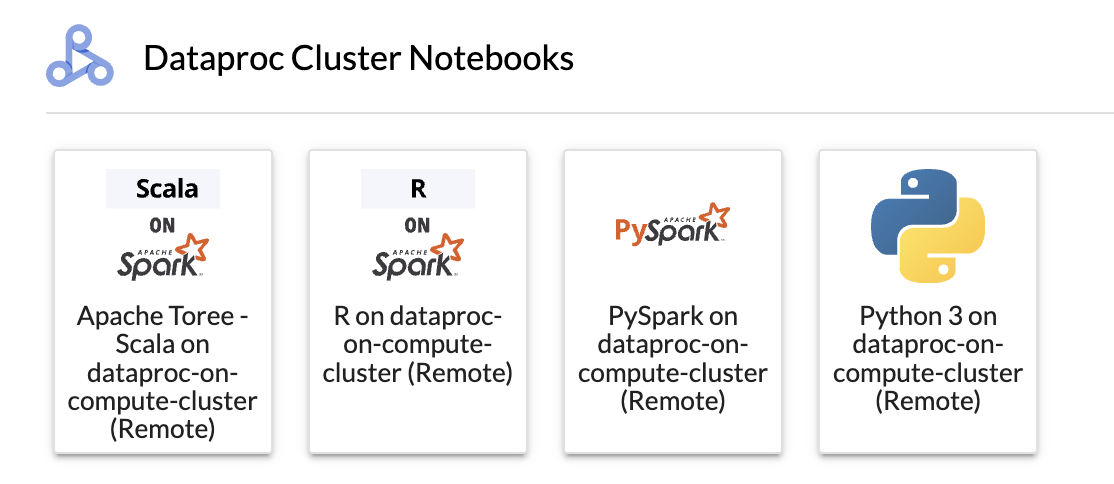

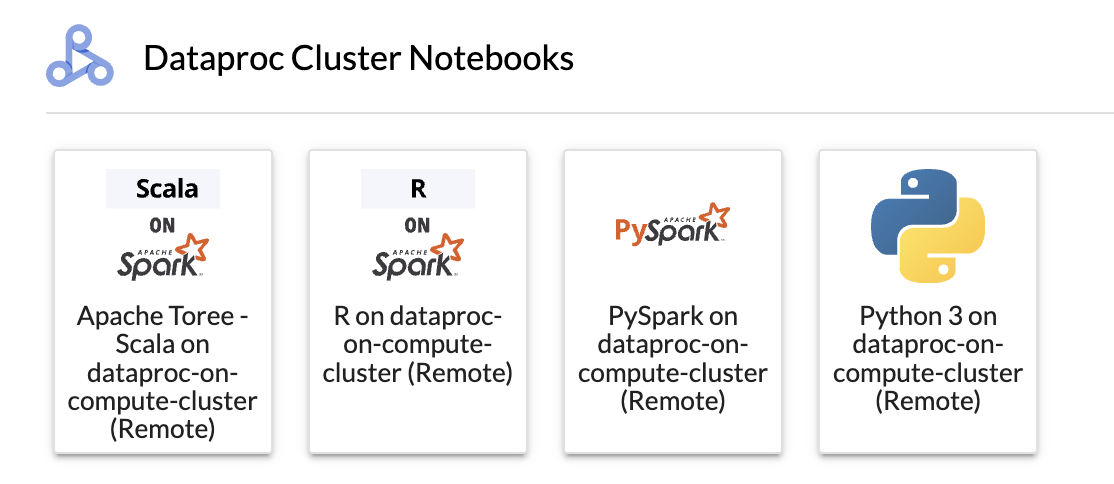

Fai clic su una scheda nella sezione Blocco note del cluster Dataproc.

Quando lo stato del kernel cambia da

StartingaIdle (Ready), puoi iniziare a scrivere ed eseguire il codice del notebook.Dopo aver creato e utilizzato un notebook, puoi terminare la sessione del notebook facendo clic su Arresta kernel nella scheda Kernel.

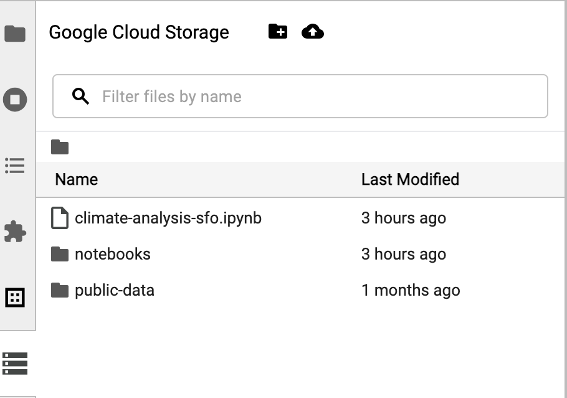

Per accedere al browser Cloud Storage, fai clic sull'icona del browser Cloud Storage nella barra laterale della pagina Launcher di JupyterLab, quindi fai doppio clic su una cartella per visualizzarne i contenuti.

Puoi fare clic sui tipi di file supportati da Jupyter per aprirli e modificarli. Quando salvi le modifiche ai file, queste vengono scritte in Cloud Storage.

Per creare una nuova cartella Cloud Storage, fai clic sull'icona della nuova cartella, quindi inserisci il nome della cartella.

Per caricare file in un bucket Cloud Storage o in una cartella, fai clic sull'icona di caricamento, poi seleziona i file da caricare.

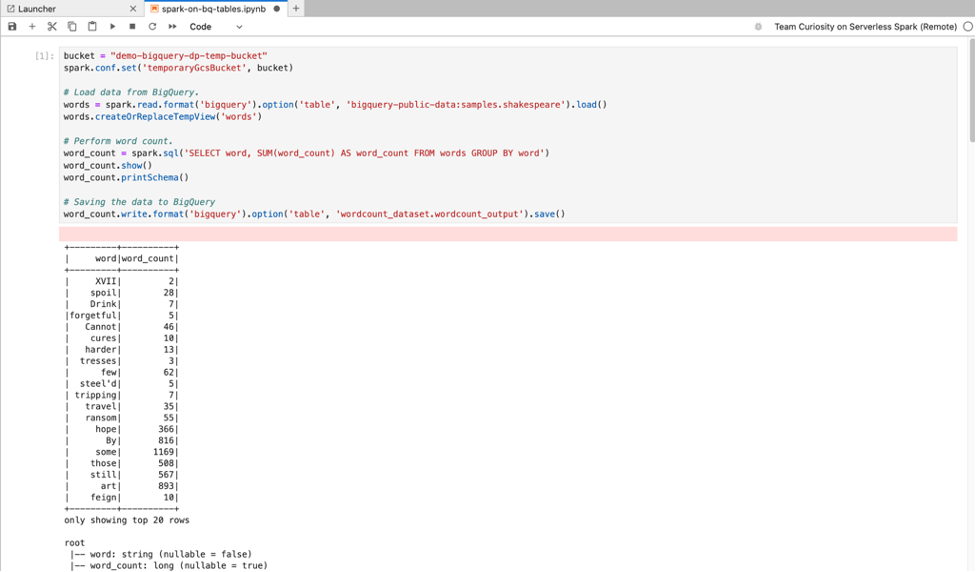

Fai clic su una scheda PySpark nella sezione Serverless per Apache Spark Notebooks o Dataproc Cluster Notebook della pagina Launcher di JupyterLab per aprire un notebook PySpark.

Fai clic su una scheda del kernel Python nella sezione Notebook del cluster Dataproc nella pagina Avvio app di JupyterLab per aprire un notebook Python.

Fai clic sulla scheda Apache Toree nella sezione Notebook del cluster Dataproc della pagina Avvio app di JupyterLab per aprire un notebook per lo sviluppo di codice Scala.

Figura 1. Scheda del kernel Apache Toree nella pagina Avvio app di JupyterLab. - Sviluppa ed esegui il codice Spark nei notebook Serverless per Apache Spark.

- Crea e gestisci modelli di runtime (sessione) Serverless per Apache Spark, sessioni interattive e workload batch.

- Sviluppare ed eseguire notebook BigQuery.

- Sfoglia, ispeziona e visualizza l'anteprima dei set di dati BigQuery.

- Scarica e installa VS Code.

- Apri VS Code, quindi fai clic su Estensioni nella barra delle attività.

Utilizza la barra di ricerca per trovare l'estensione Jupyter, quindi fai clic su Installa. L'estensione Jupyter di Microsoft è una dipendenza obbligatoria.

- Apri VS Code, quindi fai clic su Estensioni nella barra delle attività.

Utilizza la barra di ricerca per trovare l'estensione Google Cloud Code e poi fai clic su Installa.

Se richiesto, riavvia VS Code.

- Apri VS Code, quindi nella barra delle attività fai clic su Google Cloud Code.

- Apri la sezione Dataproc.

- Fai clic su Login to Google Cloud (Accedi a Google Cloud). Viene visualizzata la pagina di accesso con le tue credenziali.

- Utilizza la barra delle applicazioni di primo livello per andare a Code > Settings > Settings > Extensions.

- Trova Google Cloud Codice e fai clic sull'icona Gestisci per aprire il menu.

- Seleziona Settings (Impostazioni).

- Nei campi Progetto e Regione Dataproc, inserisci il nome del progetto e della regione da utilizzare per sviluppare blocchi note e gestire le risorse di Serverless per Apache Spark. Google Cloud

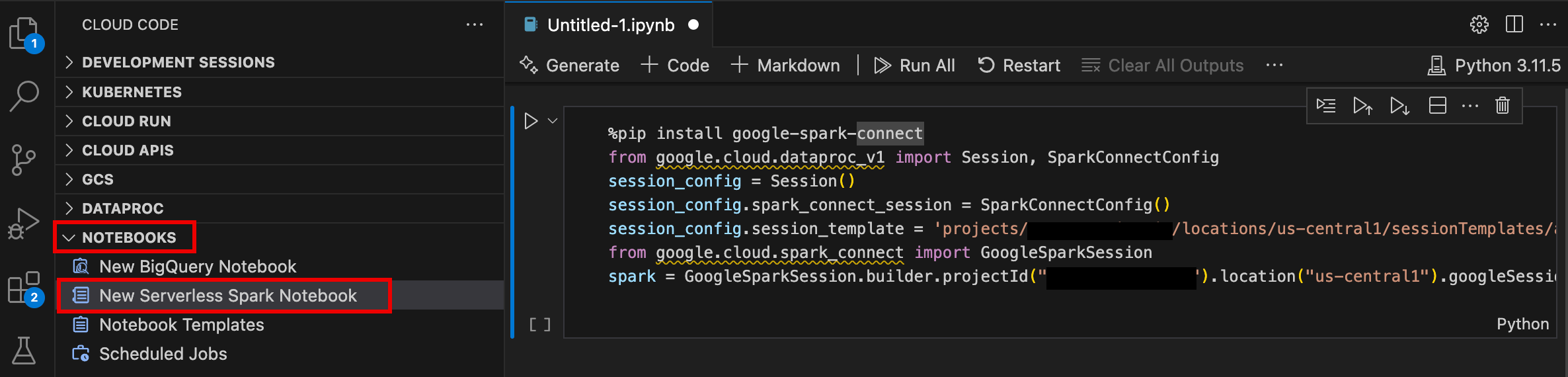

- Apri VS Code, quindi nella barra delle attività fai clic su Google Cloud Code.

- Apri la sezione Notebook, poi fai clic su Nuovo notebook Spark serverless.

- Seleziona o crea un nuovo modello di runtime (sessione) da utilizzare per la sessione del notebook.

Viene creato e aperto nell'editor un nuovo file

.ipynbcontenente codice campione.

Ora puoi scrivere ed eseguire codice nel notebook Serverless per Apache Spark.

- Apri VS Code, quindi nella barra delle attività fai clic su Google Cloud Code.

Apri la sezione Dataproc, quindi fai clic sui seguenti nomi delle risorse:

- Cluster: crea e gestisci cluster e job.

- Serverless: crea e gestisci carichi di lavoro batch e sessioni interattive.

- Modelli di runtime Spark: crea e gestisci i modelli di sessione.

Esegui il codice del notebook sull'infrastruttura Google Cloud Serverless per Apache Spark

Pianificare l'esecuzione del blocco note su Cloud Composer

Invia job batch all'infrastruttura Google Cloud Serverless per Apache Spark o al tuo cluster Dataproc su Compute Engine.

Fai clic sul pulsante Pianificatore di job in alto a destra del blocco note.

Compila il modulo Crea un job pianificato per fornire le seguenti informazioni:

- Un nome univoco per il job di esecuzione del notebook

- L'ambiente Cloud Composer da utilizzare per il deployment del notebook

- Parametri di input se il notebook è parametrizzato

- Il cluster Dataproc o il modello di runtime serverless da utilizzare

per eseguire il notebook

- Se è selezionato un cluster, se arrestare il cluster dopo che il notebook termina l'esecuzione sul cluster

- Numero di tentativi e ritardo tra i tentativi in minuti se l'esecuzione del notebook non riesce al primo tentativo

- Notifiche di esecuzione da inviare e l'elenco dei destinatari. Le notifiche vengono inviate utilizzando una configurazione SMTP di Airflow.

- La pianificazione dell'esecuzione del notebook

Fai clic su Crea.

Una volta pianificata correttamente la creazione del notebook, il nome del job viene visualizzato nell'elenco dei job pianificati nell'ambiente Cloud Composer.

Fai clic sulla scheda Serverless nella sezione Job e sessioni Dataproc nella pagina Launcher di JupyterLab.

Fai clic sulla scheda Batch, quindi su Crea batch e compila i campi Informazioni batch.

Fai clic su Invia per inviare il job.

Fai clic sulla scheda Cluster nella sezione Job e sessioni Dataproc nella pagina Launcher di JupyterLab.

Fai clic sulla scheda Job, quindi su Invia job.

Seleziona un cluster, quindi compila i campi Job.

Fai clic su Invia per inviare il job.

- Fai clic sulla scheda Serverless.

- Fai clic sulla scheda Sessioni, quindi su un ID sessione per aprire la pagina Dettagli sessione per visualizzare le proprietà della sessione, visualizzare i log in Esplora log e terminare una sessione. Google Cloud Nota: viene creata una sessione Google Cloud Serverless per Apache Spark univoca per avviare ogni notebook Google Cloud Serverless per Apache Spark.

- Fai clic sulla scheda Batch per visualizzare l'elenco dei batch di Google Cloud Serverless per Apache Spark nel progetto e nella regione correnti. Fai clic su un ID batch per visualizzare i dettagli del batch.

- Fai clic sulla scheda Cluster. La scheda Cluster è selezionata per elencare i cluster Dataproc su Compute Engine attivi nel progetto e nella regione correnti. Puoi fare clic sulle icone nella colonna Azioni per avviare, arrestare o riavviare un cluster. Fai clic sul nome di un cluster per visualizzarne i dettagli. Puoi fare clic sulle icone nella colonna Azioni per clonare, interrompere o eliminare un job.

- Fai clic sulla scheda Job per visualizzare l'elenco dei job nel progetto attuale. Fai clic su un ID job per visualizzare i dettagli del job.

Installa l'estensione JupyterLab

Puoi installare e utilizzare l'estensione JupyterLab su una macchina o una VM che ha accesso ai servizi Google, ad esempio la tua macchina locale o un'istanza VM di Compute Engine.

Per installare l'estensione:

Crea un modello di runtime Serverless per Apache Spark

I modelli di runtime Serverless per Apache Spark (chiamati anche modelli di sessione) contengono le impostazioni di configurazione per l'esecuzione del codice Spark in una sessione. Puoi creare e gestire i modelli di runtime utilizzando JupyterLab o gcloud CLI.

JupyterLab

gcloud

Avviare e gestire i notebook

Dopo aver installato l'estensione JupyterLab di Dataproc, puoi fare clic sulle schede dei modelli nella pagina Launcher di JupyterLab per:

Avvia un notebook Jupyter su Serverless per Apache Spark

La sezione Notebook Serverless per Apache Spark nella pagina di avvio di JupyterLab mostra le schede dei modelli di notebook che corrispondono ai modelli di runtime Serverless per Apache Spark (vedi Creare un modello di runtime Serverless per Apache Spark).

Avvia un notebook su un cluster Dataproc su Compute Engine

Se hai creato un cluster Jupyter Dataproc su Compute Engine, la pagina Launcher di JupyterLab contiene una sezione Notebook del cluster Dataproc con schede del kernel preinstallate.

Per avviare un notebook Jupyter sul cluster Dataproc su Compute Engine:

Gestire i file di input e di output in Cloud Storage

L'analisi dei dati esplorativi e la creazione di modelli ML spesso comportano input e output basati su file. Serverless per Apache Spark accede a questi file su Cloud Storage.

Sviluppare il codice del notebook Spark

Dopo aver installato l'estensione JupyterLab di Dataproc, puoi avviare i notebook Jupyter dalla pagina Avvio app di JupyterLab per sviluppare il codice dell'applicazione.

Sviluppo di codice PySpark e Python

I cluster Serverless per Apache Spark e Dataproc su Compute Engine supportano i kernel PySpark. Dataproc su Compute Engine supporta anche i kernel Python.

Sviluppo di codice SQL

Per aprire un notebook PySpark per scrivere ed eseguire codice SQL, nella pagina Launcher di JupyterLab, nella sezione Serverless per Apache Spark Notebooks o Dataproc Cluster Notebook, fai clic sulla scheda del kernel PySpark.

Magic di Spark SQL: poiché il kernel PySpark che avvia

Serverless per i blocchi note Apache Spark

è precaricato con la magic di Spark SQL, anziché utilizzare spark.sql('SQL STATEMENT').show()

per racchiudere l'istruzione SQL, puoi digitare

%%sparksql magic nella parte superiore di una cella, quindi digitare l'istruzione SQL nella cella.

BigQuery SQL: il connettore BigQuery Spark consente al codice del notebook di caricare i dati dalle tabelle BigQuery, eseguire l'analisi in Spark e quindi scrivere i risultati in una tabella BigQuery.

I runtime Serverless per Apache Spark 2.2

e successivi includono il

connettore BigQuery Spark.

Se utilizzi una versione precedente del runtime per avviare i notebook Serverless per Apache Spark,

puoi installare Spark BigQuery Connector aggiungendo la seguente proprietà Spark

al modello di runtime Serverless per Apache Spark:

spark.jars: gs://spark-lib/bigquery/spark-bigquery-with-dependencies_2.12-0.25.2.jar

Sviluppo di codice Scala

I cluster Dataproc su Compute Engine creati con le versioni

dell'immagine 2.0 e successive includono Apache Toree, un kernel Scala per la piattaforma Jupyter Notebook che fornisce l'accesso interattivo a Spark.

Sviluppare codice con l'estensione Visual Studio Code

Puoi utilizzare l'estensione Google Cloud Visual Studio Code (VS Code) per svolgere le seguenti operazioni:

L'estensione Visual Studio Code è gratuita, ma ti vengono addebitati i costi per tutti i serviziGoogle Cloud , incluse le risorse Dataproc, Serverless per Apache Spark e Cloud Storage che utilizzi.

Utilizzare VS Code con BigQuery: puoi anche utilizzare VS Code con BigQuery per fare quanto segue:

Prima di iniziare

Installa l' Google Cloud estensione

L'icona Google Cloud Codice è ora visibile nella barra delle attività di VS Code.

Configurare l'estensione

Sviluppare notebook Serverless per Apache Spark

Crea e gestisci le risorse Serverless per Apache Spark

Esplora set di dati

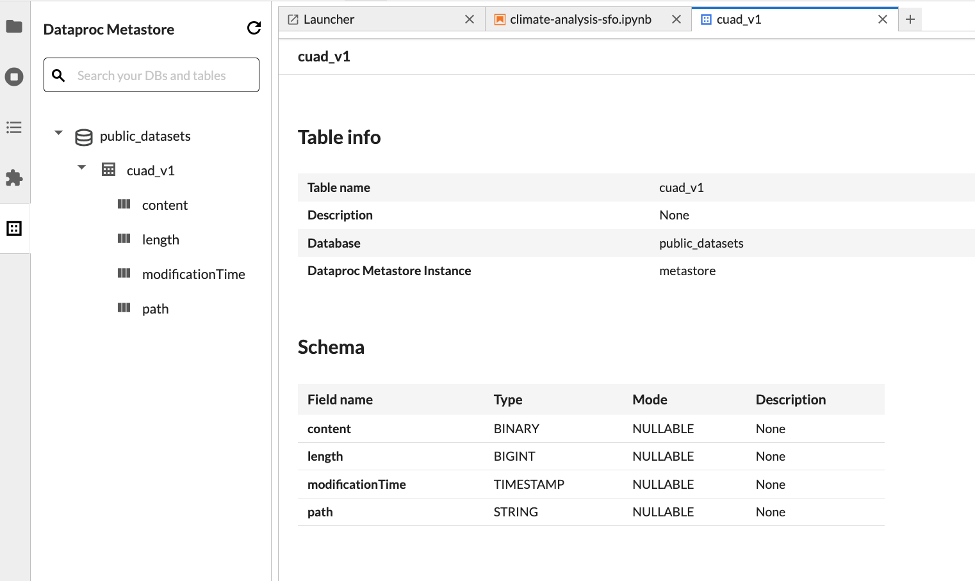

Utilizza l'esploratore di set di dati di JupyterLab per visualizzare i set di dati di BigLake Metastore.

Per aprire l'esploratore di set di dati di JupyterLab, fai clic sulla relativa icona nella barra laterale.

Puoi cercare un database, una tabella o una colonna in Esplora set di dati. Fai clic sul nome di un database, di una tabella o di una colonna per visualizzare i metadati associati.

Esegui il deployment del codice

Dopo aver installato l'estensione Dataproc JupyterLab, puoi utilizzare JupyterLab per:

Pianificare l'esecuzione del blocco note su Cloud Composer

Completa i seguenti passaggi per pianificare l'esecuzione del codice del notebook su Cloud Composer come job batch su Serverless per Apache Spark o su un cluster Dataproc su Compute Engine.

Invia un job batch a Google Cloud Serverless per Apache Spark

Invia un job batch a un cluster Dataproc su Compute Engine

Visualizzare e gestire le risorse

Dopo aver installato l'estensione JupyterLab di Dataproc, puoi visualizzare e gestire Google Cloud Serverless per Apache Spark e Dataproc su Compute Engine dalla sezione Job e sessioni Dataproc nella pagina Launcher di JupyterLab.

Fai clic sulla sezione Job e sessioni Dataproc per visualizzare le schede Cluster e Serverless.

Per visualizzare e gestire le sessioni di Google Cloud Serverless per Apache Spark:

Per visualizzare e gestire i batch Google Cloud Serverless per Apache Spark:

Per visualizzare e gestire i cluster Dataproc su Compute Engine:

Per visualizzare e gestire i job Dataproc su Compute Engine: