In diesem Dokument wird beschrieben, wie Sie Logeinträge mit der Google Cloud -Konsole abfragen, ansehen und analysieren. Es stehen zwei Oberflächen zur Verfügung: der Log-Explorer und Log Analytics. Mit beiden Oberflächen können Sie Protokolle abfragen, ansehen und analysieren. Sie verwenden jedoch unterschiedliche Abfragesprachen und haben unterschiedliche Funktionen. Für die Fehlerbehebung und Analyse von Logdaten empfehlen wir den Log-Explorer. Wir empfehlen Ihnen, Log Analytics zu verwenden, um Statistiken und Trends zu generieren. Sie können Ihre Logs abfragen und Ihre Abfragen speichern, indem Sie Logging API-Befehle ausführen. Sie können Ihre Logs auch mit der Google Cloud CLI abfragen.

Log-Explorer

Der Log-Explorer soll Ihnen bei der Fehlerbehebung und Leistungsanalyse Ihrer Dienste und Anwendungen helfen. Ein Histogramm zeigt beispielsweise die Fehlerrate an. Wenn Sie einen Anstieg der Fehlerzahl oder etwas anderes Interessantes sehen, können Sie die entsprechenden Logeinträge suchen und ansehen. Wenn ein Logeintrag mit einer Fehlergruppe verknüpft ist, wird er mit einem Optionsmenü versehen, über das Sie auf weitere Informationen zur Fehlergruppe zugreifen können.

Die Abfragesprache wird von der Cloud Logging API, der Google Cloud CLI und dem Log-Explorer unterstützt. Um das Erstellen von Abfragen im Log-Explorer zu vereinfachen, können Sie Abfragen erstellen, indem Sie Menüs verwenden, Text eingeben und in einigen Fällen Optionen nutzen, die mit der Anzeige eines einzelnen Logeintrags bereitgestellt werden.

Der Log-Explorer unterstützt keine aggregierten Vorgänge, z. B. das Zählen der Anzahl von Logeinträgen, die ein bestimmtes Muster enthalten. Wenn Sie Aggregatvorgänge ausführen möchten, aktivieren Sie Analysen für den Log-Bucket und verwenden Sie dann Loganalysen.

Weitere Informationen zum Suchen und Anzeigen von Logs mit dem Log-Explorer finden Sie unter Logs mit dem Log-Explorer ansehen.

Loganalysen

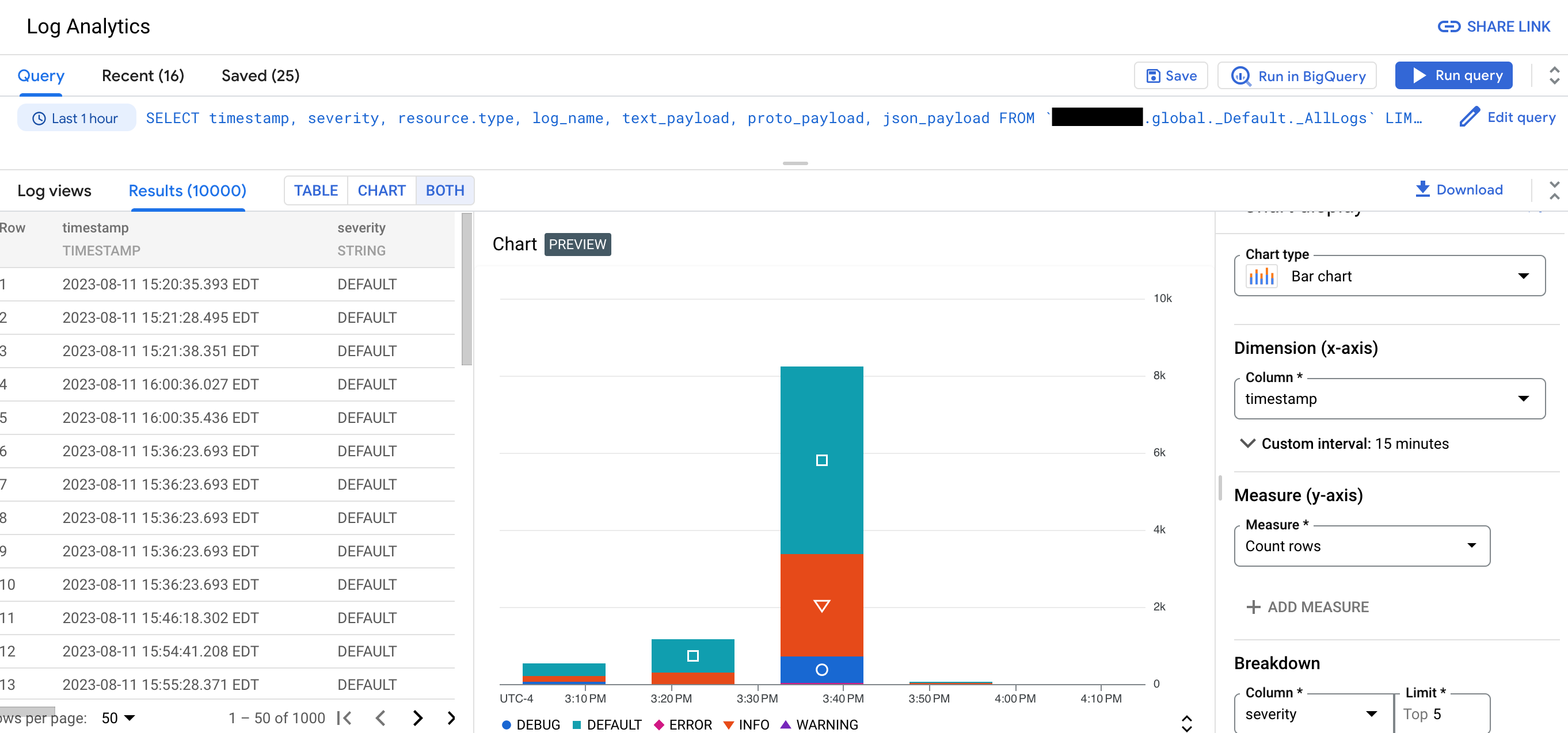

Mit Log Analytics können Sie Abfragen ausführen, um Ihre Logdaten zu analysieren. Anschließend können Sie die Abfrageergebnisse ansehen oder als Diagramm darstellen. Mithilfe von Diagrammen können Sie Muster und Trends in Ihren Logs im Zeitverlauf erkennen. Der folgende Screenshot zeigt die Diagrammfunktionen in Log Analytics:

Angenommen, Sie beheben ein Problem und möchten die durchschnittliche Latenz für HTTP-Anfragen an eine bestimmte URL im Zeitverlauf ermitteln. Wenn ein Log-Bucket für die Verwendung von Loganalysen aktualisiert wird, können Sie eine SQL-Abfrage schreiben oder den Abfragegenerator verwenden, um in Ihrem Log-Bucket gespeicherte Logs abzufragen.

Diese SQL-Abfragen können auch Pipe-Syntax enthalten. Durch das Gruppieren und Aggregieren Ihrer Logs können Sie Einblicke in Ihre Logdaten gewinnen, die Ihnen helfen können, den Zeitaufwand für die Fehlerbehebung zu reduzieren.

Mit Log Analytics können Sie Logansichten oder eine Analytics-Ansicht abfragen. Log-Ansichten haben ein festes Schema, das der Datenstruktur LogEntry entspricht.

Da der Ersteller einer Analytics-Datenansicht das Schema festlegt, können Sie mit Analytics-Datenansichten Protokolldaten aus dem LogEntry-Format in ein für Sie besser geeignetes Format umwandeln.

Sie können Ihre Daten auch mit BigQuery abfragen. Angenommen, Sie möchten mit BigQuery URLs in Ihren Logs mit einem öffentlichen Dataset bekannter schädlicher URLs vergleichen. Damit Ihre Logdaten in BigQuery sichtbar sind, müssen Sie Ihren Bucket auf Log Analytics upgraden und dann ein verknüpftes Dataset erstellen.

Sie können weiterhin Probleme beheben und einzelne Logeinträge in aktualisierten Log-Buckets mit dem Log-Explorer aufrufen.

Beschränkungen

Für das Upgrade eines vorhandenen Log-Buckets zur Verwendung von Log Analytics gelten die folgenden Einschränkungen:

- Der Log-Bucket wurde auf der Projektebene Google Cloud erstellt.

- Der Log-Bucket ist entsperrt, sofern es sich nicht um den Bucket

_Requiredhandelt. - Für den Bucket sind keine Updates ausstehend.

Logeinträge, die vor dem Upgrade eines Buckets geschrieben wurden, sind nicht sofort verfügbar. Wenn der Backfill-Vorgang abgeschlossen ist, können Sie diese Logeinträge analysieren. Der Backfill-Vorgang kann mehrere Stunden dauern.

Sie können die Seite Log Analytics nicht verwenden, um Logansichten abzufragen, wenn für den Log-Bucket Zugriffssteuerungen auf Feldebene konfiguriert sind. Sie können jedoch Abfragen über die Seite Log-Explorer ausführen und ein verknüpftes BigQuery-Dataset abfragen. Da in BigQuery keine Zugriffssteuerung auf Feldebene berücksichtigt wird, können Sie bei einer Abfrage eines verknüpften Datasets alle Felder in den Logeinträgen abfragen.

Wenn Sie mehrere Log-Buckets abfragen, die mit unterschiedlichen Cloud KMS-Schlüsseln konfiguriert sind, schlägt die Abfrage fehl, sofern die folgenden Einschränkungen nicht erfüllt sind:

- Die Log-Buckets befinden sich am selben Standort.

- Für einen Ordner oder eine Organisation, die eine übergeordnete Ressource der Log-Buckets ist, wird ein Standardschlüssel konfiguriert.

- Der Standardschlüssel befindet sich am selben Speicherort wie die Log-Buckets.

Wenn die vorherigen Einschränkungen erfüllt sind, werden alle temporären Daten, die von einer Log Analytics-Abfrage generiert werden, mit dem Cloud KMS-Schlüssel des übergeordneten Projekts verschlüsselt.

Doppelte Logeinträge werden nicht entfernt, bevor eine Abfrage ausgeführt wird. Dieses Verhalten unterscheidet sich von dem, wenn Sie Logeinträge mit dem Log-Explorer abfragen. Dort werden doppelte Einträge durch Vergleichen der Felder „Lognamen“, „Zeitstempel“ und „Insert-ID“ entfernt. Weitere Informationen finden Sie unter Fehlerbehebung: In meinen Log Analytics-Ergebnissen sind doppelte Logeinträge vorhanden.

Preise

Beim Weiterleiten von Logs an ein unterstütztes Ziel fallen für Cloud Logging keine Gebühren an. Es können aber Gebühren am Ziel erhoben werden.

Mit Ausnahme des _Required-Log-Buckets fallen in Cloud Logging Gebühren für das Streamen von Logs in Log-Buckets und für die Speicherung über den standardmäßigen Aufbewahrungszeitraum des Log-Buckets hinaus an.

Für Cloud Logging fallen keine Gebühren für das Kopieren von Logs, das Erstellen von Log-Bereichen oder Analyseansichten oder für Abfragen an, die über die Seiten Log-Explorer oder Loganalyse ausgegeben werden.

Weitere Informationen finden Sie in folgenden Dokumenten:

- Die Cloud Logging-Abschnitte auf der Seite Google Cloud Observability – Preise.

Kosten für das Weiterleiten von Logdaten an andere Google Cloud -Dienste:

- Gebühren für die Erzeugung von VPC-Flusslogs fallen an, wenn Sie Ihre Virtual Private Cloud-Flusslogs senden und dann von Cloud Logging ausschließen.

Wenn Sie ein Bucket für die Verwendung von Log Analytics upgraden und dann ein verknüpftes Dataset erstellen, fallen keine BigQuery-Kosten für die Aufnahme oder Speicherung an. Wenn Sie ein verknüpftes Dataset für einen Log-Bucket erstellen, werden Ihre Log-Daten nicht in BigQuery aufgenommen. Stattdessen erhalten Sie über das verknüpfte Dataset Lesezugriff auf die Logdaten, die in Ihrem Log-Bucket gespeichert sind.

BigQuery-Analysegebühren fallen an, wenn Sie SQL-Abfragen für verknüpfte BigQuery-Datasets ausführen. Das gilt auch für die Verwendung der Seite BigQuery Studio, der BigQuery API und des BigQuery-Befehlszeilentools.

Blogs

Weitere Informationen zu Loganalysen finden Sie in den folgenden Blogbeiträgen:

- Eine Übersicht über Loganalysen finden Sie unter Loganalysen in Cloud Logging sind jetzt allgemein verfügbar.

- Informationen zum Erstellen von Diagrammen, die von Log Analytics-Abfragen generiert werden, und zum Speichern dieser Diagramme in benutzerdefinierten Dashboards finden Sie unter Log Analytics-Diagramme und -Dashboards in Cloud Logging in der öffentlichen Vorschau.

- Informationen zum Analysieren von Audit-Logs mit Log Analytics finden Sie unter Mit Log Analytics Sicherheitsinformationen aus Audit-Logs gewinnen.

- Wenn Sie Logs an BigQuery weiterleiten und den Unterschied zwischen dieser Lösung und der Verwendung von Log Analytics verstehen möchten, lesen Sie den Abschnitt Für BigQuery-Exportnutzer zu Log Analytics wechseln.

Nächste Schritte

- Log-Bucket erstellen und für die Verwendung von Log Analytics upgraden

- Vorhandenen Bucket für die Verwendung von Log Analytics upgraden

Logs abfragen und ansehen:

Beispielanfragen: