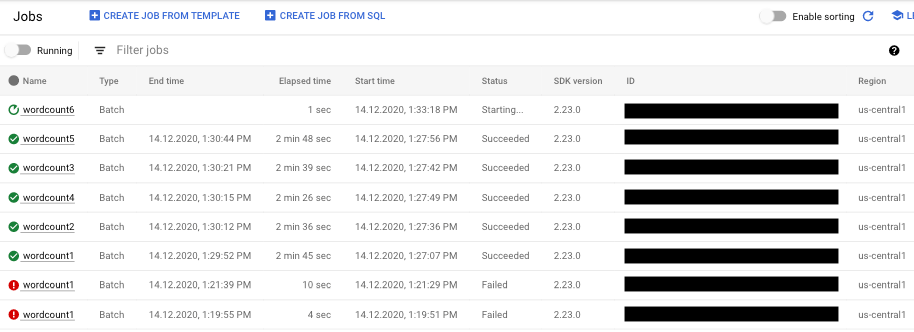

Para ver una lista de tus tareas de Dataflow, ve a la página Dataflow > Tareas de la Google Cloud consola.

Aparecerá una lista de tareas de Dataflow junto con su estado.

Un trabajo puede tener los siguientes estados:

- —: la interfaz de monitorización aún no ha recibido ningún estado del servicio Dataflow.

- En ejecución: la tarea se está ejecutando.

- Iniciando...: se ha creado el trabajo, pero el sistema necesita un tiempo para prepararse antes de iniciarlo.

- En cola: o bien hay una tarea de FlexRS en cola o se está iniciando una tarea de plantilla Flex (lo que puede tardar varios minutos).

- Cancelando...: la tarea se está cancelando.

- Cancelado: el trabajo se ha cancelado.

- Desviando...: el trabajo se está desviando.

- Agotado: el trabajo se ha agotado.

- Actualizando...: la tarea se está actualizando.

- Actualizado: la tarea se ha actualizado.

- Correcto: el trabajo ha finalizado correctamente.

- Error: no se ha podido completar el trabajo.

Acceder a visualizadores de tareas

Para acceder a los gráficos de monitorización de tu tarea, haz clic en el nombre de la tarea en la interfaz de monitorización de Dataflow. Se mostrará la página Detalles de la tarea, que contiene la siguiente información:

- Gráfico de la tarea: representación visual de tu flujo de procesamiento

- Detalles de ejecución: herramienta para optimizar el rendimiento de tu canalización

- Métricas de tareas: métricas sobre la ejecución de tu tarea.

- Coste: métricas sobre el coste estimado de tu trabajo

- Autoescalado: métricas relacionadas con eventos de autoescalado de trabajos de streaming.

- Panel de información del trabajo: información descriptiva sobre tu canalización.

- Registros de tareas: registros generados por el servicio Dataflow a nivel de tarea

- Registros de trabajador: registros generados por el servicio Dataflow a nivel de trabajador.

- Diagnóstico: tabla que muestra dónde se han producido errores a lo largo de la cronología elegida y posibles recomendaciones para su canalización

- Muestreo de datos: herramienta que te permite observar los datos en cada paso de un flujo de procesamiento.

En la página Detalles de la tarea, puede cambiar la vista de la tarea con las pestañas Gráfico de tareas, Detalles de ejecución, Métricas de tareas, Coste y Autoescalado.

Usar Google Cloud CLI para enumerar trabajos

También puedes usar la CLI de Google Cloud para obtener una lista de tus trabajos de Dataflow.

Para ver una lista de las tareas de Dataflow de tu proyecto, usa el comando dataflow jobs list:

gcloud dataflow jobs list

El comando devuelve una lista de tus trabajos actuales. A continuación, se muestra un ejemplo de salida:

ID NAME TYPE CREATION_TIME STATE REGION 2015-06-03_16_39_22-4020553808241078833 wordcount-janedoe-0603233849 Batch 2015-06-03 16:39:22 Done us-central1 2015-06-03_16_38_28-4363652261786938862 wordcount-johndoe-0603233820 Batch 2015-06-03 16:38:28 Done us-central1 2015-05-21_16_24_11-17823098268333533078 bigquerytornadoes-johndoe-0521232402 Batch 2015-05-21 16:24:11 Done europe-west1 2015-05-21_13_38_06-16409850040969261121 bigquerytornadoes-johndoe-0521203801 Batch 2015-05-21 13:38:06 Done us-central1 2015-05-21_13_17_18-18349574013243942260 bigquerytornadoes-johndoe-0521201710 Batch 2015-05-21 13:17:18 Done europe-west1 2015-05-21_12_49_37-9791290545307959963 wordcount-johndoe-0521194928 Batch 2015-05-21 12:49:37 Done us-central1 2015-05-20_15_54_51-15905022415025455887 wordcount-johndoe-0520225444 Batch 2015-05-20 15:54:51 Failed us-central1 2015-05-20_15_47_02-14774624590029708464 wordcount-johndoe-0520224637 Batch 2015-05-20 15:47:02 Done us-central1

Para mostrar más información sobre una tarea, usa el comando

dataflow jobs describe:

gcloud dataflow jobs describe JOB_ID

Sustituye JOB_ID por el trabajo ID. La salida de este comando tiene un aspecto similar al siguiente:

createTime: '2015-02-09T19:39:41.140Z' currentState: JOB_STATE_DONE currentStateTime: '2015-02-09T19:56:39.510Z' id: 2015-02-09_11_39_40-15635991037808002875 name: tfidf-bchambers-0209193926 projectId: google.com:clouddfe type: JOB_TYPE_BATCH

Para dar formato JSON al resultado, ejecuta el comando con la opción --format=json:

gcloud --format=json dataflow jobs describe JOB_ID

Archivar (ocultar) tareas de Dataflow de una lista

Cuando archivas una tarea de Dataflow, se elimina de la lista de tareas de la página Tareas de Dataflow en la consola. El trabajo se mueve a una lista de trabajos archivados. Solo puedes archivar los trabajos completados, incluidos los que tengan los siguientes estados:

JOB_STATE_CANCELLEDJOB_STATE_DRAINEDJOB_STATE_DONEJOB_STATE_FAILEDJOB_STATE_UPDATED

Para obtener más información sobre cómo verificar estos estados, consulta el artículo Detectar la finalización de una tarea de Dataflow.

Para obtener información sobre cómo solucionar problemas al archivar trabajos, consulta la sección Errores al archivar trabajos del artículo "Solucionar errores de Dataflow".

Todos los trabajos archivados se eliminan tras un periodo de conservación de 30 días.

Archivar una tarea

Sigue estos pasos para quitar una tarea completada de la lista principal de tareas de la página Tareas de Dataflow.

Consola

En la Google Cloud consola, ve a la página Trabajos de Dataflow.

Aparecerá una lista de tareas de Dataflow junto con su estado.

Selecciona un trabajo.

En la página Detalles del trabajo, haga clic en Archivar. Si la tarea no se ha completado, la opción Archivar no estará disponible.

REST

Para archivar un trabajo mediante la API, usa el método projects.locations.jobs.update.

En esta solicitud, debes especificar un objeto JobMetadata actualizado. En el objeto JobMetadata.userDisplayProperties, usa el par clave-valor "archived":"true".

Además del objeto JobMetadata actualizado, tu solicitud de la API también debe incluir el parámetro de consulta updateMask en la URL de la solicitud:

https://dataflow.googleapis.com/v1b3/[...]/jobs/JOB_ID/?updateMask=job_metadata.user_display_properties.archived

Antes de usar los datos de la solicitud, haz las siguientes sustituciones:

- PROJECT_ID: tu ID de proyecto

- REGION: una región de Dataflow

- JOB_ID: el ID de tu tarea de Dataflow

Método HTTP y URL:

PUT https://dataflow.googleapis.com/v1b3/projects/PROJECT_ID/locations/REGION/jobs/JOB_ID/?updateMask=job_metadata.user_display_properties.archived

Cuerpo JSON de la solicitud:

{

"job_metadata": {

"userDisplayProperties": {

"archived": "true"

}

}

}

Para enviar tu solicitud, elige una de estas opciones:

curl

Guarda el cuerpo de la solicitud en un archivo llamado request.json

y ejecuta el siguiente comando:

curl -X PUT \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "Content-Type: application/json; charset=utf-8" \

-d @request.json \

"https://dataflow.googleapis.com/v1b3/projects/PROJECT_ID/locations/REGION/jobs/JOB_ID/?updateMask=job_metadata.user_display_properties.archived"

PowerShell

Guarda el cuerpo de la solicitud en un archivo llamado request.json

y ejecuta el siguiente comando:

$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred" }

Invoke-WebRequest `

-Method PUT `

-Headers $headers `

-ContentType: "application/json; charset=utf-8" `

-InFile request.json `

-Uri "https://dataflow.googleapis.com/v1b3/projects/PROJECT_ID/locations/REGION/jobs/JOB_ID/?updateMask=job_metadata.user_display_properties.archived" | Select-Object -Expand Content

Deberías recibir una respuesta JSON similar a la siguiente:

{

"id": "JOB_ID",

"projectId": "PROJECT_ID",

"currentState": "JOB_STATE_DONE",

"currentStateTime": "2025-05-20T20:54:41.651442Z",

"createTime": "2025-05-20T20:51:06.031248Z",

"jobMetadata": {

"userDisplayProperties": {

"archived": "true"

}

},

"startTime": "2025-05-20T20:51:06.031248Z"

}

gcloud

Este comando archiva un solo trabajo. La tarea debe estar en un estado final para poder archivarse. De lo contrario, se rechazará la solicitud. Después de enviar el comando, debes confirmar que quieres ejecutarlo.

Antes de usar los datos de los comandos que se indican a continuación, haz los siguientes cambios:

JOB_ID: el ID de la tarea de Dataflow que quieres archivar.REGION: opcional. La región de Dataflow de tu tarea.

Ejecuta el siguiente comando:

Linux, macOS o Cloud Shell

gcloud dataflow jobs archive JOB_ID --region=REGION_ID

Windows (PowerShell)

gcloud dataflow jobs archive JOB_ID --region=REGION_ID

Windows (cmd.exe)

gcloud dataflow jobs archive JOB_ID --region=REGION_ID

Deberías recibir una respuesta similar a la siguiente:

Archived job [JOB_ID].

createTime: '2025-06-29T11:00:02.432552Z'

currentState: JOB_STATE_DONE

currentStateTime: '2025-06-29T11:04:25.125921Z'

id: JOB_ID

jobMetadata:

userDisplayProperties:

archived: 'true'

projectId: PROJECT_ID

startTime: '2025-06-29T11:00:02.432552Z'

Ver y restaurar trabajos archivados

Sigue estos pasos para ver las tareas archivadas o para restaurarlas en la lista principal de tareas de la página Tareas de Dataflow.

Consola

En la Google Cloud consola, ve a la página Trabajos de Dataflow.

Haz clic en el interruptor Archivados. Aparecerá una lista de trabajos de Dataflow archivados.

Selecciona un trabajo.

Para restaurar el trabajo en la lista principal de trabajos de la página Trabajos de Dataflow, en la página Detalles del trabajo, haz clic en Restaurar.

REST

Para restaurar un trabajo archivado mediante la API, usa el método projects.locations.jobs.update.

En esta solicitud, debes especificar un objeto JobMetadata actualizado. En el objeto JobMetadata.userDisplayProperties, usa el par clave-valor "archived":"false".

Además del objeto JobMetadata actualizado, tu solicitud de la API también debe incluir el parámetro de consulta updateMask en la URL de la solicitud:

https://dataflow.googleapis.com/v1b3/[...]/jobs/JOB_ID/?updateMask=job_metadata.user_display_properties.archived

Antes de usar los datos de la solicitud, haz las siguientes sustituciones:

- PROJECT_ID: tu ID de proyecto

- REGION: una región de Dataflow

- JOB_ID: el ID de tu tarea de Dataflow

Método HTTP y URL:

PUT https://dataflow.googleapis.com/v1b3/projects/PROJECT_ID/locations/REGION/jobs/JOB_ID/?updateMask=job_metadata.user_display_properties.archived

Cuerpo JSON de la solicitud:

{

"job_metadata": {

"userDisplayProperties": {

"archived": "false"

}

}

}

Para enviar tu solicitud, elige una de estas opciones:

curl

Guarda el cuerpo de la solicitud en un archivo llamado request.json

y ejecuta el siguiente comando:

curl -X PUT \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "Content-Type: application/json; charset=utf-8" \

-d @request.json \

"https://dataflow.googleapis.com/v1b3/projects/PROJECT_ID/locations/REGION/jobs/JOB_ID/?updateMask=job_metadata.user_display_properties.archived"

PowerShell

Guarda el cuerpo de la solicitud en un archivo llamado request.json

y ejecuta el siguiente comando:

$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred" }

Invoke-WebRequest `

-Method PUT `

-Headers $headers `

-ContentType: "application/json; charset=utf-8" `

-InFile request.json `

-Uri "https://dataflow.googleapis.com/v1b3/projects/PROJECT_ID/locations/REGION/jobs/JOB_ID/?updateMask=job_metadata.user_display_properties.archived" | Select-Object -Expand Content

Deberías recibir una respuesta JSON similar a la siguiente:

{

"id": "JOB_ID",

"projectId": "PROJECT_ID",

"currentState": "JOB_STATE_DONE",

"currentStateTime": "2025-05-20T20:54:41.651442Z",

"createTime": "2025-05-20T20:51:06.031248Z",

"jobMetadata": {

"userDisplayProperties": {

"archived": "false"

}

},

"startTime": "2025-05-20T20:51:06.031248Z"

}