Halaman ini menjelaskan cara melakukan streaming temuan baru dan yang diperbarui ke set data BigQuery menggunakan fungsi ekspor Security Command Center untuk BigQuery. Temuan yang ada tidak dikirim ke BigQuery kecuali jika diperbarui.

BigQuery adalah data warehouse analisis yang terkelola sepenuhnya, berskala petabyte, dan hemat biaya dari Google Cloud, yang memungkinkan Anda menjalankan analisis pada sejumlah besar data secara hampir real time. Anda dapat menggunakan BigQuery untuk menjalankan kueri terhadap temuan baru dan yang diperbarui, memfilter data untuk menemukan apa yang Anda butuhkan, dan membuat laporan kustom. Untuk mempelajari lebih lanjut BigQuery, lihat dokumentasi BigQuery.

Ringkasan

Jika Anda mengaktifkan fitur ini, temuan baru yang ditulis ke Security Command Center akan diekspor ke tabel BigQuery hampir secara real time. Kemudian, Anda dapat mengintegrasikan data ke dalam alur kerja yang ada dan membuat analisis kustom. Anda dapat mengaktifkan fitur ini di tingkat organisasi, folder, dan project untuk mengekspor temuan berdasarkan persyaratan Anda.

Fitur ini adalah cara yang direkomendasikan untuk mengekspor temuan Security Command Center ke BigQuery, karena dikelola sepenuhnya dan tidak memerlukan operasi manual atau penulisan kode kustom.

Struktur set data

Fitur ini menambahkan setiap temuan baru dan pembaruan berikutnya sebagai

baris baru dalam tabel findings, yang dikelompokkan berdasarkan source_id,

finding_id,

dan event_time.

Saat temuan diperbarui, fitur ini membuat beberapa catatan temuan dengan

nilai source_id dan finding_id yang sama, tetapi dengan nilai event_time

yang berbeda. Struktur set data ini memungkinkan Anda melihat perubahan status setiap temuan dari waktu ke waktu.

Perhatikan bahwa entri duplikat mungkin ada dalam set data Anda. Untuk menguraikannya, Anda

dapat menggunakan klausa DISTINCT, seperti yang ditunjukkan dalam

kueri contoh pertama.

Setiap set data berisi tabel findings, yang memiliki kolom berikut:

| Kolom | Deskripsi |

|---|---|

source_id |

ID unik yang ditetapkan Security Command Center ke

sumber temuan.

Misalnya, semua temuan dari sumber Cloud Anomaly Detection memiliki

nilai Contoh: |

finding_id |

ID unik yang merepresentasikan temuan. ID ini bersifat unik dalam sumber untuk organisasi. Alfanumerik dan memiliki kurang dari atau sama dengan 32 karakter. |

event_time |

Waktu terjadinya peristiwa atau waktu terjadinya update pada

temuan. Misalnya, jika temuan mewakili firewall yang terbuka, maka Contoh: |

bulk_export_id |

Untuk ekspor massal, ini adalah UUID. Untuk ekspor berkelanjutan, kolom ini kosong. |

finding |

Kumpulan data penilaian seperti keamanan, risiko, kesehatan, atau privasi, yang dimasukkan ke Security Command Center untuk presentasi, pemberitahuan, analisis, pengujian kebijakan, dan penegakan. Misalnya, kerentanan pembuatan skrip lintas situs (XSS) di aplikasi App Engine adalah temuan.

Untuk mengetahui informasi selengkapnya tentang kolom bertingkat, lihat referensi API

untuk objek

|

resource |

Informasi terkait resource yang dikaitkan dengan temuan ini. Google Cloud

Untuk mengetahui informasi selengkapnya tentang kolom bertingkat, lihat referensi API

untuk objek

|

Biaya

Anda akan dikenai biaya BigQuery terkait fitur ini. Untuk mengetahui informasi selengkapnya, lihat harga BigQuery.

Sebelum memulai

Anda harus menyelesaikan langkah-langkah ini sebelum mengaktifkan fitur ini.

Siapkan izin

Untuk menyelesaikan panduan ini, Anda harus memiliki peran Identity and Access Management (IAM) berikut:

Di organisasi, folder, atau project tempat Anda ingin mengekspor temuan, salah satu hal berikut:

- Security Center BigQuery Exports Editor

(

roles/securitycenter.bigQueryExportsEditor). - Security Center Admin

(

roles/securitycenter.admin).

Untuk mempelajari peran Security Command Center lebih lanjut, lihat Kontrol akses.

- Security Center BigQuery Exports Editor

(

Di set data BigQuery, berikan peran BigQuery Data Owner (

roles/bigquery.dataOwner).

Membuat set data BigQuery

Membuat set data BigQuery. Untuk informasi selengkapnya, lihat Membuat set data.

Merencanakan residensi data

Jika residensi data diaktifkan untuk

Security Command Center, konfigurasi yang menentukan ekspor streaming ke

BigQuery—resource BigQueryExport—tunduk pada

kontrol residensi data dan disimpan di

lokasi Security Command Center

yang Anda pilih.

Untuk mengekspor temuan di lokasi Security Command Center ke BigQuery, Anda harus mengonfigurasi ekspor BigQuery di lokasi Security Command Center yang sama dengan temuan.

Karena filter yang digunakan dalam ekspor BigQuery dapat berisi data yang tunduk pada kontrol residensi, pastikan Anda menentukan lokasi yang benar sebelum membuatnya. Security Command Center tidak membatasi lokasi tempat Anda membuat ekspor.

Ekspor BigQuery hanya disimpan di lokasi tempat ekspor tersebut dibuat dan tidak dapat dilihat atau diedit di lokasi lain.

Setelah membuat BigQuery Export, Anda tidak dapat mengubah lokasinya. Untuk mengubah lokasi, Anda harus menghapus ekspor BigQuery dan membuatnya ulang di lokasi baru.

Untuk mempelajari cara menggunakan Security Command Center saat residensi data diaktifkan, lihat Endpoint regional Security Command Center.

Mengekspor temuan dari Security Command Center ke BigQuery

Untuk mengekspor temuan, aktifkan terlebih dahulu Security Command Center API.

Mengaktifkan Security Command Center API

Untuk mengaktifkan Security Command Center API:

Buka halaman API Library di konsol Google Cloud .

Pilih project yang ingin Anda aktifkan Security Command Center API-nya.

Di kotak Search, masukkan

Security Command Center, lalu klik Security Command Center di hasil penelusuran.Di halaman API yang muncul, klik Enable.

Security Command Center API diaktifkan untuk project Anda. Selanjutnya, Anda akan menggunakan gcloud CLI untuk membuat konfigurasi ekspor baru ke BigQuery.

Memberikan akses perimeter di Kontrol Layanan VPC

Jika Anda menggunakan Kontrol Layanan VPC dan set data BigQuery Anda adalah bagian dari project di dalam perimeter layanan, Anda harus memberikan akses ke project untuk mengekspor temuan.

Untuk memberikan akses ke project, buat

aturan masuk dan keluar untuk

principal dan project tempat Anda mengekspor temuan. Aturan

mengizinkan akses ke resource yang dilindungi dan memungkinkan BigQuery memverifikasi bahwa

pengguna memiliki izin setIamPolicy pada set data

BigQuery.

Sebelum menyiapkan ekspor baru ke BigQuery

Konsol

-

Di konsol Google Cloud , buka halaman VPC Service Controls.

- Pilih organisasi atau project Anda.

-

Di menu drop-down, pilih kebijakan akses yang berisi perimeter layanan yang ingin Anda beri akses.

Perimeter layanan yang terkait dengan kebijakan akses akan muncul dalam daftar.

-

Klik nama perimeter layanan yang ingin Anda perbarui.

Untuk menemukan perimeter layanan yang perlu diubah, Anda dapat memeriksa entri log yang menunjukkan pelanggaran

RESOURCES_NOT_IN_SAME_SERVICE_PERIMETER. Dalam entri tersebut, periksa kolomservicePerimeterName:accessPolicies/ACCESS_POLICY_ID/servicePerimeters/SERVICE_PERIMETER_NAME

- Klik Edit.

- Klik Kebijakan traffic keluar.

- Klik Tambahkan aturan traffic keluar.

-

Di bagian Dari, tetapkan detail berikut:

- Untuk Identitas > Identitas, pilih Pilih identitas & grup.

- Klik Tambahkan identitas.

-

Masukkan alamat email principal yang digunakan untuk memanggil Security Command Center API.

- Pilih pemilik atau tekan ENTER, lalu klik Tambahkan identitas.

-

Di bagian Tujuan, tetapkan detail berikut:

- Untuk Resources > Projects, pilih All projects.

- Untuk Operasi atau peran IAM, pilih Pilih operasi.

-

Klik Tambahkan operasi, lalu tambahkan operasi berikut:

- Tambahkan layanan bigquery.googleapis.com.

- Klik Semua metode.

- Klik Tambahkan semua metode.

- Tambahkan layanan bigquery.googleapis.com.

- Klik Ingress policy.

- Klik Tambahkan aturan ingress.

-

Di bagian Dari, tetapkan detail berikut:

- Untuk Identitas > Identitas, pilih Pilih identitas & grup.

- Klik Tambahkan identitas.

-

Masukkan alamat email principal yang digunakan untuk memanggil Security Command Center API.

- Pilih pemilik atau tekan ENTER, lalu klik Tambahkan identitas.

- Untuk Sumber, pilih Semua sumber.

-

Di bagian Tujuan, tetapkan detail berikut:

- Untuk Resources > Projects, pilih Select projects.

- Klik Tambahkan project, lalu tambahkan project yang berisi set data BigQuery.

- Untuk Operasi atau peran IAM, pilih Pilih operasi.

-

Klik Tambahkan operasi, lalu tambahkan operasi berikut:

- Tambahkan layanan bigquery.googleapis.com.

- Klik Semua metode.

- Klik Tambahkan semua metode.

- Tambahkan layanan bigquery.googleapis.com.

- Klik Simpan.

gcloud

-

Jika project kuota belum ditetapkan, tetapkan project kuota. Pilih project yang mengaktifkan Access Context Manager API.

gcloud config set billing/quota_project QUOTA_PROJECT_ID

Ganti

QUOTA_PROJECT_IDdengan ID project yang ingin Anda gunakan untuk penagihan dan kuota. -

Buat file bernama

egress-rule.yamldengan konten berikut:- egressFrom: identities: - PRINCIPAL_ADDRESS egressTo: operations: - serviceName: bigquery.googleapis.com methodSelectors: - method: '*' resources: - '*'

Ganti

PRINCIPAL_ADDRESSdengan alamat principal yang digunakan untuk memanggil Security Command Center API. -

Buat file bernama

ingress-rule.yamldengan konten berikut:- ingressFrom: identities: - PRINCIPAL_ADDRESS sources: - accessLevel: '*' ingressTo: operations: - serviceName: bigquery.googleapis.com methodSelectors: - method: '*' resources: - '*'

Ganti

PRINCIPAL_ADDRESSdengan alamat principal yang digunakan untuk memanggil Security Command Center API. -

Tambahkan aturan traffic keluar ke perimeter:

gcloud access-context-manager perimeters update PERIMETER_NAME \ --set-egress-policies=egress-rule.yaml

Ganti kode berikut:

-

PERIMETER_NAME: nama perimeter. Misalnya,accessPolicies/1234567890/servicePerimeters/example_perimeter.Untuk menemukan perimeter layanan yang perlu diubah, Anda dapat memeriksa log untuk menemukan entri yang menunjukkan pelanggaran

RESOURCES_NOT_IN_SAME_SERVICE_PERIMETER. Dalam entri tersebut, periksa kolomservicePerimeterName:accessPolicies/ACCESS_POLICY_ID/servicePerimeters/SERVICE_PERIMETER_NAME

-

-

Tambahkan aturan traffic masuk ke perimeter:

gcloud access-context-manager perimeters update PERIMETER_NAME \ --set-ingress-policies=ingress-rule.yaml

Ganti kode berikut:

-

PERIMETER_NAME: nama perimeter. Misalnya,accessPolicies/1234567890/servicePerimeters/example_perimeter.Untuk menemukan perimeter layanan yang perlu diubah, Anda dapat memeriksa log untuk menemukan entri yang menunjukkan pelanggaran

RESOURCES_NOT_IN_SAME_SERVICE_PERIMETER. Dalam entri tersebut, periksa kolomservicePerimeterName:accessPolicies/ACCESS_POLICY_ID/servicePerimeters/SERVICE_PERIMETER_NAME

-

Lihat Aturan traffic masuk dan keluar untuk informasi selengkapnya.

Menyiapkan ekspor baru ke BigQuery

Pada langkah ini, Anda membuat konfigurasi ekspor untuk mengekspor temuan ke instance BigQuery. Anda dapat membuat konfigurasi ekspor di level project, folder, atau organisasi. Misalnya, jika Anda ingin mengekspor temuan dari project ke set data BigQuery, Anda membuat konfigurasi ekspor di tingkat project untuk mengekspor hanya temuan yang terkait dengan project tersebut. Secara opsional, Anda dapat menentukan filter untuk mengekspor temuan tertentu saja.

Pastikan untuk membuat konfigurasi ekspor di tingkat yang sesuai. Misalnya, jika Anda membuat konfigurasi ekspor di Project B untuk mengekspor temuan dari Project A dan Anda menentukan filter seperti resource.project_display_name: project-a-id, konfigurasi tidak akan mengekspor temuan apa pun.

Anda dapat membuat maksimum 500 konfigurasi ekspor ke BigQuery untuk organisasi Anda. Anda dapat menggunakan set data yang sama untuk beberapa konfigurasi ekspor. Jika Anda menggunakan set data yang sama, semua pembaruan akan dilakukan pada tabel temuan yang sama.

Saat Anda membuat konfigurasi ekspor pertama, akun layanan akan otomatis dibuat untuk Anda. Akun layanan ini diperlukan untuk membuat atau

memperbarui tabel temuan dalam set data dan untuk mengekspor temuan ke tabel.

Memiliki bentuk

service-org-ORGANIZATION_ID@gcp-sa-scc-notification.iam.gservicaccount.com dan

diberi peran BigQuery Data Editor (roles/bigquery.dataEditor) di tingkat

set data BigQuery.

Di konsol Google Cloud , beberapa resource BigQueryExport mungkin memiliki label Legacy

yang menunjukkan bahwa resource tersebut dibuat dengan Security Command Center API v1. Anda dapat mengelola resource BigQueryExport ini dengan konsol Google Cloud , gcloud CLI, Security Command Center API v1, atau library klien v1 untuk Security Command Center.

Untuk mengelola resource BigQueryExport ini dengan gcloud CLI, Anda tidak boleh menentukan

lokasi saat menjalankan perintah gcloud CLI.

gcloud

Buka konsol Google Cloud .

Pilih project tempat Anda mengaktifkan Security Command Center API.

Klik Activate Cloud Shell.

Untuk membuat konfigurasi ekspor baru, jalankan perintah berikut:

gcloud scc bqexports create BIGQUERY_EXPORT \ --dataset=DATASET_NAME \ --folder=FOLDER_ID | --organization=ORGANIZATION_ID | --project=PROJECT_ID \ --location=LOCATION \ [--description=DESCRIPTION] \ [--filter=FILTER]Ganti kode berikut:

BIGQUERY_EXPORTdengan nama untuk konfigurasi ekspor ini.DATASET_NAMEdengan nama set data BigQuery—misalnya,projects/PROJECT_ID/datasets/DATASET_ID.FOLDER_ID,ORGANIZATION_ID, atauPROJECT_IDdengan nama folder, organisasi, atau project Anda. Anda harus menyetel salah satu opsi ini. Untuk folder dan organisasi, namanya adalah ID folder atau ID organisasi. Untuk project, namanya adalah nomor project atau ID project.LOCATION: lokasi Security Command Center tempat konfigurasi ekspor akan dibuat; jika retensi data diaktifkan, gunakaneu,sa, atauus; jika tidak, gunakan nilaiglobal.DESCRIPTIONdengan deskripsi konfigurasi ekspor yang dapat dibaca manusia. Variabel ini bersifat opsional.FILTERdengan ekspresi yang menentukan temuan yang akan disertakan dalam ekspor. Misalnya, jika Anda ingin memfilter kategori XSS_SCRIPTING, ketik"category=\"XSS_SCRIPTING\". Variabel ini bersifat opsional.

Terraform

Untuk mempelajari cara menerapkan atau menghapus konfigurasi Terraform, lihat Perintah dasar Terraform. Untuk mengetahui informasi selengkapnya, lihat dokumentasi referensi penyedia Terraform.

Buat konfigurasi ekspor untuk organisasi:

Membuat konfigurasi ekspor untuk folder:

Buat konfigurasi ekspor untuk project:

Java

Untuk melakukan autentikasi ke Security Command Center, siapkan Kredensial Default Aplikasi. Untuk mengetahui informasi selengkapnya, lihat Menyiapkan ADC untuk lingkungan pengembangan lokal.

Python

Untuk melakukan autentikasi ke Security Command Center, siapkan Kredensial Default Aplikasi. Untuk mengetahui informasi selengkapnya, lihat Menyiapkan ADC untuk lingkungan pengembangan lokal.

Anda akan melihat temuan di set data BigQuery dalam waktu sekitar 15 menit setelah Anda membuat konfigurasi ekspor. Setelah tabel BigQuery dibuat, temuan baru dan yang diperbarui yang cocok dengan filter dan cakupan Anda akan muncul di tabel hampir secara real time.

Untuk meninjau temuan Anda, lihat Meninjau temuan.

Buat aturan ingress untuk ekspor baru ke BigQuery

Jika Anda menggunakan Kontrol Layanan VPC dan set data BigQuery Anda adalah bagian dari project di dalam perimeter layanan, Anda harus membuat aturan masuk untuk ekspor baru ke BigQuery.

Konsol

-

Buka kembali perimeter layanan dari bagian sebelumnya.

- Klik Ingress policy.

- Klik Tambahkan aturan ingress.

-

Di bagian Dari, tetapkan detail berikut:

- Untuk Identitas > Identitas, pilih Pilih identitas & grup.

- Klik Tambahkan identitas.

-

Masukkan alamat email agen layanan konfigurasi ekspor BigQuery. Alamat agen layanan memiliki format berikut:

service-org-ORGANIZATION_ID@gcp-sa-scc-notification.

Ganti

ORGANIZATION_IDdengan ID organisasi Anda. - Pilih agen layanan atau tekan ENTER, lalu klik Tambahkan identitas.

- Untuk Sumber, pilih Semua sumber.

-

Di bagian Tujuan, tetapkan detail berikut:

- Untuk Resources > Projects, pilih Select projects.

- Klik Tambahkan project, lalu tambahkan project yang berisi set data BigQuery.

- Untuk Operasi atau peran IAM, pilih Pilih operasi.

-

Klik Tambahkan operasi, lalu tambahkan operasi berikut:

- Tambahkan layanan bigquery.googleapis.com.

- Klik Semua metode.

- Klik Tambahkan semua metode.

- Tambahkan layanan bigquery.googleapis.com.

- Klik Simpan.

gcloud

-

Jika project kuota belum ditetapkan, tetapkan project kuota. Pilih project yang mengaktifkan Access Context Manager API.

gcloud config set billing/quota_project QUOTA_PROJECT_ID

Ganti

QUOTA_PROJECT_IDdengan ID project yang ingin Anda gunakan untuk penagihan dan kuota. -

Buat file bernama

ingress-rule.yamldengan konten berikut:- ingressFrom: identities: - serviceAccount:service-org-ORGANIZATION_ID@gcp-sa-scc-notification. sources: - accessLevel: '*' ingressTo: operations: - serviceName: bigquery.googleapis.com methodSelectors: - method: '*' resources: - '*'

Ganti

ORGANIZATION_IDdengan ID organisasi Anda. -

Tambahkan aturan traffic masuk ke perimeter:

gcloud access-context-manager perimeters update PERIMETER_NAME \ --set-ingress-policies=ingress-rule.yaml

Ganti kode berikut:

-

PERIMETER_NAME: nama perimeter. Misalnya,accessPolicies/1234567890/servicePerimeters/example_perimeter.Untuk menemukan perimeter layanan yang perlu diubah, Anda dapat memeriksa log untuk menemukan entri yang menunjukkan pelanggaran

RESOURCES_NOT_IN_SAME_SERVICE_PERIMETER. Dalam entri tersebut, periksa kolomservicePerimeterName:accessPolicies/ACCESS_POLICY_ID/servicePerimeters/SERVICE_PERIMETER_NAME

-

Lihat Aturan traffic masuk dan keluar untuk informasi selengkapnya.

Project, pengguna, dan akun layanan yang dipilih kini dapat mengakses resource yang dilindungi dan mengekspor temuan.

Jika Anda telah mengikuti semua langkah dalam panduan ini, dan ekspor berfungsi dengan benar, Anda kini dapat menghapus hal berikut:

- Aturan masuk untuk akun utama

- Aturan keluar untuk akun utama

Aturan tersebut hanya diperlukan untuk mengonfigurasi konfigurasi ekspor. Namun, agar konfigurasi ekspor terus berfungsi, Anda harus mempertahankan aturan masuk yang Anda buat sebelumnya, yang memungkinkan Security Command Center mengekspor temuan ke set data BigQuery Anda di balik perimeter layanan.

Melihat detail konfigurasi ekspor

gcloud

Buka konsol Google Cloud .

Pilih project tempat Anda mengaktifkan Security Command Center API.

Klik Activate Cloud Shell.

Untuk memverifikasi detail konfigurasi ekspor, jalankan perintah berikut:

gcloud scc bqexports get BIGQUERY_EXPORT \ --folder=FOLDER_ID | --organization=ORGANIZATION_ID | --project=PROJECT_ID \ --location=LOCATIONGanti kode berikut:

- Ganti

BIGQUERY_EXPORTdengan nama untuk konfigurasi ekspor ini. FOLDER_ID,ORGANIZATION_ID, atauPROJECT_IDdengan nama folder, organisasi, atau project Anda. Anda harus menyetel salah satu opsi ini. Untuk folder dan organisasi, namanya adalah ID folder atau ID organisasi. Untuk project, namanya adalah nomor project atau ID project.LOCATION: lokasi Security Command Center tempat konfigurasi ekspor akan dibuat; jika retensi data diaktifkan, gunakaneu,sa, atauus; jika tidak, gunakan nilaiglobal.Misalnya, untuk mendapatkan konfigurasi ekspor bernama

my-bq-exportdari organisasi dengan ID organisasi yang ditetapkan ke123, jalankan:gcloud scc bqexports get my-bq-export \ --organization=123 \ --location=global

- Ganti

Memperbarui konfigurasi ekspor

Jika perlu, Anda dapat mengubah filter, set data, dan deskripsi konfigurasi ekspor yang ada. Anda tidak dapat mengubah nama konfigurasi ekspor.

gcloud

Buka konsol Google Cloud .

Pilih project tempat Anda mengaktifkan Security Command Center API.

Klik Activate Cloud Shell.

Untuk memperbarui konfigurasi ekspor, jalankan perintah berikut:

gcloud scc bqexports update BIGQUERY_EXPORT \ --dataset=DATASET_NAME \ --folder=FOLDER_ID | --organization=ORGANIZATION_ID | --project=PROJECT_ID \ --location=LOCATION \ [--description=DESCRIPTION] \ [--filter=FILTER]Ganti kode berikut:

BIGQUERY_EXPORTdengan nama konfigurasi ekspor yang ingin Anda perbarui.DATASET_NAMEdengan nama set data BigQuery—misalnya,projects/PROJECT_ID/datasets/DATASET_ID.FOLDER_ID,ORGANIZATION_ID, atauPROJECT_IDdengan nama folder, organisasi, atau project Anda. Anda harus menyetel salah satu opsi ini. Untuk folder dan organisasi, namanya adalah ID folder atau ID organisasi. Untuk project, namanya adalah nomor project atau ID project.LOCATION: lokasi Security Command Center tempat konfigurasi ekspor akan diperbarui; jika retensi data diaktifkan, gunakaneu,sa, atauus; jika tidak, gunakan nilaiglobal.DESCRIPTIONdengan deskripsi konfigurasi ekspor yang dapat dibaca manusia. Variabel ini bersifat opsional.FILTERdengan ekspresi yang menentukan temuan yang akan disertakan dalam ekspor. Misalnya, jika Anda ingin memfilter kategori XSS_SCRIPTING, ketik"category=\"XSS_SCRIPTING\". Variabel ini bersifat opsional.

Melihat semua konfigurasi ekspor

Anda dapat melihat semua konfigurasi ekspor dalam organisasi, folder, atau project.

gcloud

Buka konsol Google Cloud .

Pilih project tempat Anda mengaktifkan Security Command Center API.

Klik Activate Cloud Shell.

Untuk mencantumkan konfigurasi ekspor, jalankan perintah berikut:

gcloud scc bqexports list \ --folder=FOLDER_ID | --organization=ORGANIZATION_ID | --project=PROJECT_ID \ --location=LOCATION \ [--limit=LIMIT] \ [--page-size=PAGE_SIZE]Ganti kode berikut:

FOLDER_ID,ORGANIZATION_ID, atauPROJECT_IDdengan nama folder, organisasi, atau project Anda. Anda harus menyetel salah satu opsi ini. Untuk folder dan organisasi, namanya adalah ID folder atau ID organisasi. Untuk project, namanya adalah nomor project atau ID project.Jika Anda menentukan ID organisasi, daftar akan mencakup semua konfigurasi ekspor yang ditentukan dalam organisasi tersebut, termasuk yang berada di tingkat folder dan project. Jika Anda menentukan ID folder, daftar ini akan mencakup semua konfigurasi ekspor yang ditentukan di tingkat folder dan di project dalam folder tersebut. Jika Anda menentukan nomor project atau project ID, daftar hanya mencakup semua konfigurasi ekspor untuk project tersebut.

LOCATION: lokasi Security Command Center tempat konfigurasi ekspor akan dicantumkan; jika retensi data diaktifkan, gunakaneu,sa, atauus; jika tidak, gunakan nilaiglobal.LIMITdengan jumlah konfigurasi ekspor yang ingin Anda lihat. Variabel ini bersifat opsional.PAGE_SIZEdengan nilai ukuran halaman. Variabel ini bersifat opsional.

Java

Untuk melakukan autentikasi ke Security Command Center, siapkan Kredensial Default Aplikasi. Untuk mengetahui informasi selengkapnya, lihat Menyiapkan ADC untuk lingkungan pengembangan lokal.

Python

Untuk melakukan autentikasi ke Security Command Center, siapkan Kredensial Default Aplikasi. Untuk mengetahui informasi selengkapnya, lihat Menyiapkan ADC untuk lingkungan pengembangan lokal.

Menghapus konfigurasi ekspor

Jika tidak lagi memerlukan konfigurasi ekspor, Anda dapat menghapusnya.

gcloud

Buka konsol Google Cloud .

Pilih project tempat Anda mengaktifkan Security Command Center API.

Klik Activate Cloud Shell.

Untuk menghapus konfigurasi ekspor, jalankan perintah berikut:

gcloud scc bqexports delete BIGQUERY_EXPORT \ --folder=FOLDER_ID | --organization=ORGANIZATION_ID | --project=PROJECT_ID \ --location=LOCATIONGanti kode berikut:

BIGQUERY_EXPORTdengan nama konfigurasi ekspor yang ingin Anda hapus.FOLDER_ID,ORGANIZATION_ID, atauPROJECT_IDdengan nama folder, organisasi, atau project Anda. Anda harus menyetel salah satu opsi ini. Untuk folder dan organisasi, namanya adalah ID folder atau ID organisasi. Untuk project, namanya adalah nomor project atau ID project.LOCATION: lokasi Security Command Center tempat konfigurasi ekspor akan dihapus; jika retensi data diaktifkan, gunakaneu,sa, atauus; jika tidak, gunakan nilaiglobal.Misalnya, untuk menghapus konfigurasi ekspor bernama

my-bq-exportdari organisasi dengan ID organisasi yang ditetapkan ke123, jalankan:gcloud scc bqexports delete my-bq-export \ --organization=123 \ --location=global

Java

Untuk melakukan autentikasi ke Security Command Center, siapkan Kredensial Default Aplikasi. Untuk mengetahui informasi selengkapnya, lihat Menyiapkan ADC untuk lingkungan pengembangan lokal.

Python

Untuk melakukan autentikasi ke Security Command Center, siapkan Kredensial Default Aplikasi. Untuk mengetahui informasi selengkapnya, lihat Menyiapkan ADC untuk lingkungan pengembangan lokal.

Setelah menghapus konfigurasi ekspor, Anda dapat menghapus data dari Looker Studio. Untuk mengetahui informasi selengkapnya, lihat Menghapus, menghapus, dan memulihkan sumber data.

Meninjau temuan di BigQuery

Setelah Anda membuat konfigurasi ekspor, temuan baru akan diekspor ke set data BigQuery di project yang Anda tentukan.

Untuk meninjau temuan di BigQuery, lakukan hal berikut:

Buka project di BigQuery.

Pilih project.

Di panel Explorer, luaskan node untuk project Anda.

Perluas set data Anda.

Klik tabel temuan.

Di tab yang terbuka, klik Pratinjau. Contoh set data akan ditampilkan.

Kueri yang berguna

Bagian ini memberikan contoh kueri

untuk menganalisis data temuan. Dalam contoh berikut, ganti

DATASET dengan nama yang ditetapkan ke set data Anda dan

PROJECT_ID dengan nama project untuk set data Anda.

Untuk memecahkan masalah error yang Anda alami, lihat Pesan error.

Jumlah temuan baru yang dibuat dan diperbarui setiap hari

SELECT

FORMAT_DATETIME("%Y-%m-%d", event_time) AS date,

count(DISTINCT finding_id)

FROM `PROJECT_ID.DATASET.findings`

GROUP BY date

ORDER BY date DESC

Data temuan terbaru untuk setiap temuan

SELECT

* EXCEPT(row)

FROM (

SELECT *, ROW_NUMBER() OVER(

PARTITION BY finding_id

ORDER BY event_time DESC, finding.mute_update_time DESC

) AS row

FROM `PROJECT_ID.DATASET.findings`

)

WHERE row = 1

Temuan saat ini yang aktif, diurutkan berdasarkan waktu

WITH latestFindings AS (

SELECT * EXCEPT(row)

FROM (

SELECT *, ROW_NUMBER() OVER(

PARTITION BY finding_id

ORDER BY event_time DESC, finding.mute_update_time DESC

) AS row

FROM `PROJECT_ID.DATASET.findings`

) WHERE row = 1

)

SELECT finding_id, event_time, finding

FROM latestFindings

WHERE finding.state = "ACTIVE"

ORDER BY event_time DESC

Temuan saat ini yang ada dalam project

WITH latestFindings AS (

SELECT * EXCEPT(row)

FROM (

SELECT *, ROW_NUMBER() OVER(

PARTITION BY finding_id

ORDER BY event_time DESC, finding.mute_update_time DESC

) AS row

FROM `PROJECT_ID.DATASET.findings`

) WHERE row = 1

)

SELECT finding_id, event_time, finding, resource

FROM latestFindings

WHERE resource.project_display_name = 'PROJECT'

Ganti PROJECT dengan nama project.

Temuan saat ini yang ada di folder

WITH latestFindings AS(

SELECT * EXCEPT(row)

FROM (

SELECT *, ROW_NUMBER() OVER(

PARTITION BY finding_id

ORDER BY event_time DESC, finding.mute_update_time DESC

) AS row

FROM `PROJECT_ID.DATASET.findings`

) WHERE row = 1

)

SELECT finding_id, event_time, finding, resource

FROM latestFindings

CROSS JOIN UNNEST(resource.folders) AS folder

WHERE folder.resource_folder_display_name = 'FOLDER'

Ganti FOLDER dengan nama folder.

Temuan saat ini dari pemindai Logging Scanner

WITH latestFindings AS (

SELECT * EXCEPT(row)

FROM (

SELECT *, ROW_NUMBER() OVER(

PARTITION BY finding_id

ORDER BY event_time DESC, finding.mute_update_time DESC

) AS row

FROM `PROJECT_ID.DATASET.findings`

) WHERE row = 1

)

SELECT finding_id, event_time, finding

FROM latestFindings

CROSS JOIN UNNEST(finding.source_properties) AS source_property

WHERE source_property.key = "ScannerName"

AND source_property.value = "LOGGING_SCANNER"

Hasil temuan aktif saat ini dari jenis Persistence: IAM Anomalous Grant

WITH latestFindings AS(

SELECT * EXCEPT(row)

FROM (

SELECT *, ROW_NUMBER() OVER(

PARTITION BY finding_id

ORDER BY event_time DESC, finding.mute_update_time DESC

) AS row

FROM `PROJECT_ID.DATASET.findings`

) WHERE row = 1

)

SELECT finding_id, event_time, finding

FROM latestFindings

WHERE finding.state = "ACTIVE"

AND finding.category = "Persistence: IAM Anomalous Grant"

Menghubungkan temuan aktif dari jenis tertentu dengan Cloud Audit Logs

Contoh kueri ini membantu menyelidiki temuan pemberian IAM yang anomali dari Event Threat Detection menggunakan Cloud Audit Logs dengan menampilkan urutan tindakan Aktivitas Admin pemberi selama jangka waktu sebelum dan sesudah tindakan pemberian IAM yang anomali. Kueri berikut mengorelasikan log Aktivitas Admin antara 1 jam sebelum dan 1 jam setelah stempel waktu temuan.

WITH latestFindings AS(

SELECT * EXCEPT(row)

FROM (

SELECT *, ROW_NUMBER() OVER(

PARTITION BY finding_id

ORDER BY event_time DESC, finding.mute_update_time DESC

) AS row

FROM `PROJECT_ID.DATASET.findings`

) WHERE row = 1

)

SELECT

finding_id,

ANY_VALUE(event_time) as event_time,

ANY_VALUE(finding.access.principal_email) as grantor,

JSON_VALUE_ARRAY(ANY_VALUE(finding.source_properties_json), '$.properties.sensitiveRoleGrant.members') as grantees,

ARRAY_AGG(

STRUCT(

timestamp,

IF(timestamp < event_time, 'before', 'after') as timeline,

protopayload_auditlog.methodName,

protopayload_auditlog.resourceName,

protopayload_auditlog.serviceName

)

ORDER BY timestamp ASC

) AS recent_activity

FROM (

SELECT

f.*,

a.*,

FROM latestFindings AS f

LEFT JOIN `PROJECT_ID.DATASET.cloudaudit_googleapis_com_activity` AS a

ON a.protopayload_auditlog.authenticationInfo.principalEmail = f.finding.access.principal_email

WHERE f.finding.state = "ACTIVE"

AND f.finding.category = "Persistence: IAM Anomalous Grant"

AND a.timestamp >= TIMESTAMP_SUB(f.event_time, INTERVAL 1 HOUR)

AND a.timestamp <= TIMESTAMP_ADD(f.event_time, INTERVAL 1 HOUR)

)

GROUP BY

finding_id

ORDER BY

event_time DESC

Outputnya mirip dengan hal berikut ini:

Membuat diagram di Looker Studio

Looker Studio memungkinkan Anda membuat laporan dan dasbor interaktif.

Secara umum, Anda akan dikenai biaya penggunaan BigQuery saat mengakses BigQuery melalui Looker Studio. Untuk mengetahui informasi selengkapnya, lihat Memvisualisasikan data BigQuery menggunakan Looker Studio.

Untuk membuat diagram yang memvisualisasikan data temuan berdasarkan tingkat keparahan dan kategori, lakukan hal berikut:

- Buka Looker Studio dan login.

- Jika diminta, berikan informasi tambahan dan siapkan preferensi lainnya. Baca persyaratan layanan dan, jika Anda setuju, lanjutkan.

- Klik Laporan Kosong.

- Di tab Hubungkan ke data, klik kartu BigQuery.

- Jika diminta, izinkan Looker Studio mengakses project BigQuery.

Hubungkan ke data temuan Anda:

- Untuk Project, pilih project tersebut untuk set data Anda. Atau, di tab Project saya, masukkan project ID Anda untuk menelusurinya.

- Untuk Set data, klik nama set data Anda.

- Untuk Table, klik findings.

- Klik Tambahkan.

- Pada dialog, klik Tambahkan ke laporan.

Setelah laporan ditambahkan, klik Tambahkan diagram.

Klik Diagram kolom bertumpuk, lalu klik area tempat Anda ingin menempatkannya.

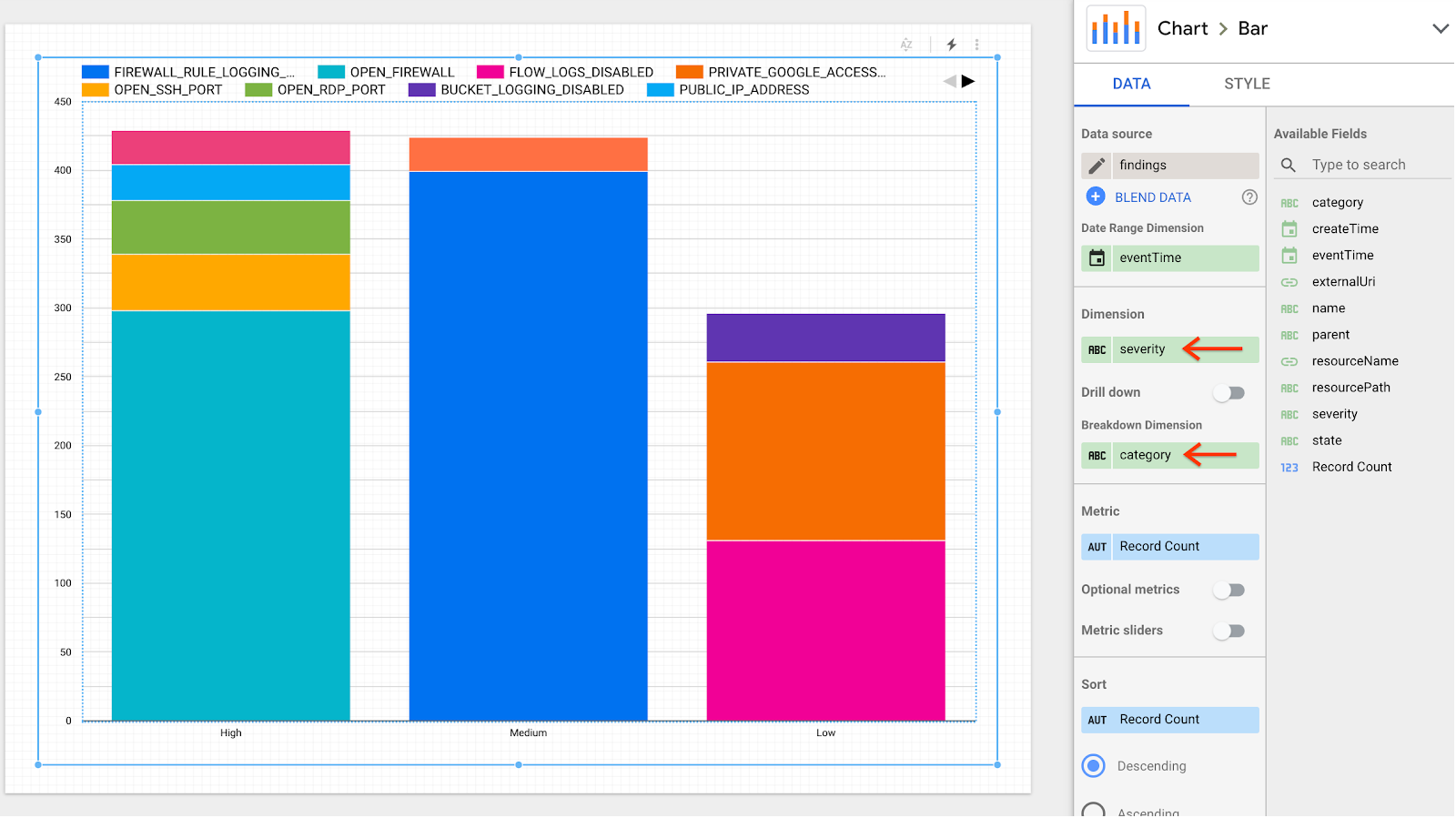

Di panel Chart > Bar, pada tab Data, tetapkan kolom berikut:

- Di kolom Dimensi, pilih finding.severity.

- Di kolom Breakdown Dimension, pilih finding.category.

Laporan diperbarui untuk menampilkan beberapa kolom dengan temuan yang dibagi berdasarkan tingkat keparahan dan kategori.

Langkah berikutnya

- Pelajari cara membuat ekspor massal ke BigQuery.

- Pelajari cara menjalankan kueri di BigQuery.