Cloud Composer 3 | Cloud Composer 2 | Cloud Composer 1

Nesta página, descrevemos como monitorar a integridade e o desempenho gerais do ambiente do Cloud Composer com as principais métricas no painel de monitoramento.

Introdução

Este tutorial se concentra nas principais métricas de monitoramento do Cloud Composer que podem fornecer uma boa visão geral da integridade e do desempenho no nível do ambiente.

O Cloud Composer oferece várias métricas que descrevem o estado geral do ambiente. As diretrizes de monitoramento neste tutorial são baseadas nas métricas expostas no painel de monitoramento do seu ambiente do Cloud Composer.

Neste tutorial, você vai aprender sobre as principais métricas que servem como indicadores principais de problemas com a performance e a integridade do seu ambiente, além das diretrizes para interpretar cada métrica em ações corretivas para manter o ambiente saudável. Você também vai configurar regras de alerta para cada métrica, executar o DAG de exemplo e usar essas métricas e alertas para otimizar a performance do seu ambiente.

Objetivos

Custos

Neste tutorial, usamos os seguintes componentes faturáveis do Google Cloud:

- Cloud Composer (consulte os custos adicionais).

- Cloud Monitoring

Ao concluir este tutorial, exclua os recursos criados para evitar o faturamento contínuo. Para mais detalhes, consulte Limpeza.

Antes de começar

Esta seção descreve as ações necessárias antes de iniciar o tutorial.

Criar e configurar um projeto

Para este tutorial, você precisa de um Google Cloud projeto. Configure o projeto da seguinte maneira:

No Google Cloud console, selecione ou crie um projeto:

Verifique se o faturamento foi ativado para o projeto. Saiba como verificar se o faturamento está ativado em um projeto.

Verifique se o Google Cloud usuário do projeto tem os seguintes papéis para criar os recursos necessários:

- Administrador de objetos do armazenamento e do ambiente

(

roles/composer.environmentAndStorageObjectAdmin) - Administrador do Compute (

roles/compute.admin) - Editor do Monitoring (

roles/monitoring.editor)

- Administrador de objetos do armazenamento e do ambiente

(

Ativar as APIs do projeto

Enable the Cloud Composer API.

Criar seu ambiente do Cloud Composer

Crie um ambiente do Cloud Composer 2.

Como parte deste procedimento,

você concede o papel Extensão do agente de serviço da API Cloud Composer v2

(roles/composer.ServiceAgentV2Ext) à conta do agente de serviço do Composer. O Cloud Composer usa essa conta para realizar operações

no projeto Google Cloud .

Analisar as principais métricas de integridade e desempenho do ambiente

Este tutorial se concentra nas principais métricas que podem fornecer uma boa visão geral da saúde e do desempenho geral do ambiente.

O Painel de monitoramento no consoleGoogle Cloud contém várias métricas e gráficos que permitem monitorar tendências no ambiente e identificar problemas com componentes do Airflow e recursos do Cloud Composer.

Cada ambiente do Cloud Composer tem seu próprio painel de monitoramento.

Familiarize-se com as métricas principais abaixo e localize cada uma delas no painel de monitoramento:

No console Google Cloud , acesse a página Ambientes.

Na lista de ambientes, clique no nome do seu ambiente. A página Detalhes do ambiente é aberta.

Acesse a guia Monitoramento.

Selecione a seção Visão geral, localize o item Visão geral do ambiente no painel e observe a métrica Integridade do ambiente (DAG de monitoramento do Airflow).

Esta linha do tempo mostra a integridade do ambiente do Cloud Composer. A cor verde da barra de integridade do ambiente indica que o ambiente está em bom estado, enquanto o status de ambiente não saudável é indicado com a cor vermelha.

A cada poucos minutos, o Cloud Composer executa um DAG de atividade chamado

airflow_monitoring. Se a execução do DAG de atividade for concluída, o status de integridade seráTrue. Se a execução do DAG de atividade falhar (por exemplo, por causa da remoção do pod, encerramento de processo externo ou manutenção), o status de integridade seráFalse.

Selecione a seção Banco de dados SQL, localize o item Integridade do banco de dados no painel e observe a métrica Integridade do banco de dados.

Esta linha do tempo mostra o status da conexão com a instância do Cloud SQL do seu ambiente. A barra de integridade do banco de dados verde indica conectividade, enquanto as falhas de conexão são indicadas com a cor vermelha.

O pod de monitoramento do Airflow dá um ping no banco de dados periodicamente e informa o status de integridade como

Truese uma conexão puder ser estabelecida ou comoFalsese não.

No item Saúde do banco de dados, observe as métricas Uso da CPU do banco de dados e Uso da memória do banco de dados.

O gráfico de uso da CPU do banco de dados indica o uso de núcleos de CPU pelas instâncias do banco de dados do Cloud SQL do seu ambiente em comparação com o limite total de CPU do banco de dados disponível.

O gráfico de uso da memória do banco de dados indica o uso da memória pelas instâncias do banco de dados do Cloud SQL do seu ambiente em comparação com o limite total de memória do banco de dados disponível.

Selecione a seção Programadores, localize o item Batimento cardíaco do programador no painel e observe a métrica Batimento cardíaco do programador.

Esta linha do tempo mostra a integridade do agendador do Airflow. Verifique se há áreas vermelhas para identificar problemas do agendador do Airflow. Se o ambiente tiver mais de um programador, o status do heartbeat será saudável, desde que pelo menos um deles esteja respondendo.

O programador é considerado não disponível se o último heartbeat foi recebido mais de 30 segundos (valor padrão) antes do horário atual.

Selecione a seção Estatísticas do DAG, localize o item Tarefas zumbi excluídas no painel e observe a métrica Tarefas zumbi excluídas.

O gráfico indica o número de tarefas zumbi eliminadas em um curto período de tempo. As tarefas zumbi geralmente são causadas pelo encerramento externo de processos do Airflow, como quando o processo de uma tarefa é encerrado.

O agendador do Airflow elimina tarefas zumbi periodicamente, o que é refletido neste gráfico.

Selecione a seção Workers, localize o item Worker container restarts no painel e observe a métrica Worker container restarts.

- Um gráfico indica o número total de reinicializações para contêineres de workers individuais. Muitas reinicializações de contêineres podem afetar a disponibilidade do seu serviço ou de outros serviços dependentes dele.

Conheça os comparativos de mercado e as possíveis ações corretivas para as principais métricas

A lista a seguir descreve valores de comparação que podem indicar problemas e fornece ações corretivas que podem ser usadas para resolver esses problemas.

Integridade do ambiente (DAG de monitoramento do Airflow)

Taxa de sucesso menor que 90% em uma janela de quatro horas

As falhas podem significar a remoção de pods ou a interrupção de workers porque o ambiente está sobrecarregado ou com mau funcionamento. As áreas vermelhas na linha do tempo de integridade do ambiente geralmente estão relacionadas a áreas vermelhas nas outras barras de integridade dos componentes individuais do ambiente. Identifique a causa raiz analisando outras métricas no painel de monitoramento.

Integridade do banco de dados

Taxa de sucesso menor que 95% em uma janela de quatro horas

As falhas indicam que há problemas de conectividade com o banco de dados do Airflow, o que pode ser resultado de uma falha ou inatividade do banco de dados porque ele está sobrecarregado (por exemplo, devido ao uso intenso de CPU ou memória ou latência mais alta ao se conectar ao banco de dados). Esses sintomas são mais frequentemente causados por DAGs subótimas, como quando elas usam muitas variáveis de ambiente ou do Airflow definidas globalmente. Identifique a causa raiz analisando as métricas de uso de recursos do banco de dados SQL. Também é possível inspecionar os registros do programador em busca de erros relacionados à conectividade do banco de dados.

Uso de CPU e memória do banco de dados

Mais de 80% no uso médio de CPU ou memória em um período de 12 horas

O banco de dados pode estar sobrecarregado. Analise a correlação entre as execuções de DAG e os picos no uso da CPU ou da memória do banco de dados.

É possível reduzir a carga do banco de dados com DAGs mais eficientes com consultas e conexões em execução otimizadas ou distribuindo a carga de maneira mais uniforme ao longo do tempo.

Como alternativa, aloque mais CPU ou memória para o banco de dados. Os recursos do banco de dados são controlados pela propriedade de tamanho do ambiente, e o ambiente precisa ser dimensionado para um tamanho maior.

Sinal de funcionamento do programador

Taxa de sucesso menor que 90% em uma janela de quatro horas

Atribua mais recursos ao programador ou aumente o número de programadores de 1 para 2 (recomendado).

Tarefas zumbi excluídas

Mais de uma tarefa zumbi a cada 24 horas

O motivo mais comum para tarefas zumbis é a falta de recursos de CPU ou memória no cluster do ambiente. Analise os gráficos de uso de recursos dos workers e atribua mais recursos a eles ou aumente o tempo limite das tarefas zumbis para que o programador aguarde mais tempo antes de considerar uma tarefa como zumbi.

Reinicializações do contêiner do worker

Mais de uma reinicialização a cada 24 horas

O motivo mais comum é a falta de memória ou armazenamento do worker. Analise o consumo de recursos do worker e aloque mais memória ou armazenamento aos workers. Se a falta de recursos não for o motivo, procure soluções para incidentes de reinicialização de workers e use Consultas de registro para descobrir os motivos das reinicializações.

Criar canais de notificação

Siga as instruções em Criar um canal de notificação para criar um canal de notificação por e-mail.

Para saber mais sobre canais de notificação, consulte Gerenciar canais de notificação.

Criar políticas de alerta

Crie políticas de alertas com base nos comparativos fornecidos nas seções anteriores deste tutorial para monitorar continuamente os valores das métricas e receber notificações quando elas violarem uma condição.

Console

É possível configurar alertas para cada métrica apresentada no painel de monitoramento clicando no ícone de sino no canto do item correspondente:

Encontre cada métrica que você quer monitorar no painel do Monitoring e clique no ícone de sino no canto do item da métrica. A página Criar política de alertas é aberta.

Na seção Transformar dados:

Configure a seção Within each time series conforme descrito na configuração das políticas de alerta para a métrica.

Clique em Próxima e configure a seção Configurar o acionador de alertas conforme descrito na configuração das políticas de alertas para a métrica.

Clique em Próxima.

Configure as notificações. Abra o menu Canais de notificação e selecione os canais de notificação que você criou na etapa anterior.

Clique em OK.

Na seção Nomear a política de alertas, preencha o campo Nome da política de alertas. Use um nome descritivo para cada uma das métricas. Use o valor "Nomeie a política de alerta", conforme descrito na configuração das políticas de alerta para a métrica.

Clique em Próxima.

Revise a política de alertas e clique em Criar política.

Métrica de integridade do ambiente (DAG de monitoramento do Airflow) - configurações da política de alertas

- Nome da métrica: ambiente do Cloud Composer: saudável

- API: composer.googleapis.com/environment/healthy

Filtros:

environment_name = [ENVIRONMENT_NAME] location = [CLUSTER_LOCATION]Transformar dados > Em cada série temporal:

- Janela contínua: personalizada

- Valor personalizado: 4

- Unidades personalizadas: hora(s)

- Função de janela contínua: fração verdadeira

Configurar o gatilho de alerta:

- Tipos de condição: limite

- Acionador de alerta: qualquer série temporal viola

- Posição do limite: abaixo do limite

- Valor do limite: 90

- Nome da condição: condição de integridade do ambiente

Configure notificações e finalize o alerta:

- Nomeie a política de alertas: "Saúde do ambiente do Airflow".

Métrica de integridade do banco de dados: configurações da política de alertas

- Nome da métrica: ambiente do Cloud Composer: integridade do banco de dados

- API: composer.googleapis.com/environment/database_health

Filtros:

environment_name = [ENVIRONMENT_NAME] location = [CLUSTER_LOCATION]Transformar dados > Em cada série temporal:

- Janela contínua: personalizada

- Valor personalizado: 4

- Unidades personalizadas: hora(s)

- Função de janela contínua: fração verdadeira

Configurar o gatilho de alerta:

- Tipos de condição: limite

- Acionador de alerta: qualquer série temporal viola

- Posição do limite: abaixo do limite

- Valor do limite: 95

- Nome da condição: condição de integridade do banco de dados

Configure notificações e finalize o alerta:

- Nomeie a política de alertas: "Saúde do banco de dados do Airflow"

Métrica de uso de CPU do banco de dados: configurações da política de alertas

- Nome da métrica: ambiente do Cloud Composer: utilização da CPU do banco de dados

- API: composer.googleapis.com/environment/database/cpu/utilization

Filtros:

environment_name = [ENVIRONMENT_NAME] location = [CLUSTER_LOCATION]Transformar dados > Em cada série temporal:

- Janela contínua: personalizada

- Valor personalizado: 12

- Unidades personalizadas: hora(s)

- Função de janela contínua: média

Configurar o gatilho de alerta:

- Tipos de condição: limite

- Acionador de alerta: qualquer série temporal viola

- Posição do limite: acima do limite

- Valor do limite: 80

- Nome da condição: condição de uso da CPU do banco de dados

Configure notificações e finalize o alerta:

- Nome da política de alertas: uso da CPU do banco de dados do Airflow

Métrica de uso de memória do banco de dados: configurações da política de alertas

- Nome da métrica: ambiente do Cloud Composer: utilização da memória do banco de dados

- API: composer.googleapis.com/environment/database/memory/utilization

Filtros:

environment_name = [ENVIRONMENT_NAME] location = [CLUSTER_LOCATION]Transformar dados > Em cada série temporal:

- Janela contínua: personalizada

- Valor personalizado: 12

- Unidades personalizadas: hora(s)

- Função de janela contínua: média

Configurar o gatilho de alerta:

- Tipos de condição: limite

- Acionador de alerta: qualquer série temporal viola

- Posição do limite: acima do limite

- Valor do limite: 80

- Nome da condição: condição de uso da memória do banco de dados

Configure notificações e finalize o alerta:

- Dê um nome à política de alertas: Uso de memória do banco de dados do Airflow

Métrica de batimentos do programador: configurações da política de alertas

- Nome da métrica: ambiente do Cloud Composer: batimentos do programador

- API: composer.googleapis.com/environment/scheduler_heartbeat_count

Filtros:

environment_name = [ENVIRONMENT_NAME] location = [CLUSTER_LOCATION]Transformar dados > Em cada série temporal:

- Janela contínua: personalizada

- Valor personalizado: 4

- Unidades personalizadas: hora(s)

- Função de janela contínua: contagem

Configurar o gatilho de alerta:

- Tipos de condição: limite

- Acionador de alerta: qualquer série temporal viola

- Posição do limite: abaixo do limite

Valor do limite: 216

- Para conferir esse número, execute uma consulta que agrega o valor

_scheduler_heartbeat_count_meanno Editor de consultas do Metrics Explorer.

- Para conferir esse número, execute uma consulta que agrega o valor

Nome da condição: condição de funcionamento do programador

Configure notificações e finalize o alerta:

- Nomeie a política de alertas: Sinal de funcionamento do programador do Airflow

Métrica "Tarefas zumbi eliminadas": configurações da política de alertas

- Nome da métrica: ambiente do Cloud Composer: tarefas zumbi excluídas

- API: composer.googleapis.com/environment/zombie_task_killed_count

Filtros:

environment_name = [ENVIRONMENT_NAME] location = [CLUSTER_LOCATION]Transformar dados > Em cada série temporal:

- Janela contínua: 1 dia

- Função de janela contínua: soma

Configurar o gatilho de alerta:

- Tipos de condição: limite

- Acionador de alerta: qualquer série temporal viola

- Posição do limite: acima do limite

- Valor do limite: 1

- Nome da condição: condição de tarefas zumbi

Configure notificações e finalize o alerta:

- Nomeie a política de alertas: "Tarefas zumbi do Airflow"

Métrica de reinicializações do contêiner do worker: configurações da política de alertas

- Nome da métrica: contêiner do Kubernetes: contagem de reinicializações

- API: kubernetes.io/container/restart_count

Filtros:

environment_name = [ENVIRONMENT_NAME] location = [CLUSTER_LOCATION] pod_name =~ airflow-worker-.*|airflow-k8s-worker-.* container_name =~ airflow-worker|base cluster_name = [CLUSTER_NAME]CLUSTER_NAMEé o nome do cluster do ambiente, que pode ser encontrado em Configurações do ambiente > Recursos > Cluster do GKE no Google Cloud console.Transformar dados > Em cada série temporal:

- Janela contínua: 1 dia

- Função de janela contínua: taxa

Configurar o gatilho de alerta:

- Tipos de condição: limite

- Acionador de alerta: qualquer série temporal viola

- Posição do limite: acima do limite

- Valor do limite: 1

- Nome da condição: condição de reinicialização do contêiner do worker

Configure notificações e finalize o alerta:

- Nomeie a política de alertas: reinicializações do worker do Airflow

Terraform

Execute um script do Terraform que cria um canal de notificação por e-mail e faz upload de políticas de alerta para as principais métricas fornecidas neste tutorial com base nos respectivos comparativos:

- Salve o arquivo de exemplo do Terraform no seu computador local.

Substitua:

PROJECT_ID: o ID do projeto. Por exemplo,example-project.EMAIL_ADDRESS: o endereço de e-mail que precisa ser notificado caso um alerta seja acionado.ENVIRONMENT_NAME: o nome do seu ambiente do Cloud Composer. Por exemplo,example-composer-environment.CLUSTER_NAME: o nome do cluster do ambiente, que pode ser encontrado em Configuração do ambiente > Recursos > cluster do GKE no Google Cloud console.

resource "google_monitoring_notification_channel" "basic" {

project = "PROJECT_ID"

display_name = "Test Notification Channel"

type = "email"

labels = {

email_address = "EMAIL_ADDRESS"

}

# force_delete = false

}

resource "google_monitoring_alert_policy" "environment_health_metric" {

project = "PROJECT_ID"

display_name = "Airflow Environment Health"

combiner = "OR"

notification_channels = [google_monitoring_notification_channel.basic.name] // To manually add a notification channel add it with the syntax "projects/[PROJECT_ID]/notificationChannels/[CHANNEL_ID]"

conditions {

display_name = "Environment health condition"

condition_threshold {

filter = "resource.type = \"cloud_composer_environment\" AND metric.type=\"composer.googleapis.com/environment/healthy\" AND resource.label.environment_name=\"ENVIRONMENT_NAME\""

duration = "60s"

comparison = "COMPARISON_LT"

threshold_value = 0.9

aggregations {

alignment_period = "14400s"

per_series_aligner = "ALIGN_FRACTION_TRUE"

}

}

}

}

resource "google_monitoring_alert_policy" "database_health_metric" {

project = "PROJECT_ID"

display_name = "Airflow Database Health"

combiner = "OR"

notification_channels = [google_monitoring_notification_channel.basic.name] // To manually add a notification channel add it with the syntax "projects/[PROJECT_ID]/notificationChannels/[CHANNEL_ID]"

conditions {

display_name = "Database health condition"

condition_threshold {

filter = "resource.type = \"cloud_composer_environment\" AND metric.type=\"composer.googleapis.com/environment/database_health\" AND resource.label.environment_name=\"ENVIRONMENT_NAME\""

duration = "60s"

comparison = "COMPARISON_LT"

threshold_value = 0.95

aggregations {

alignment_period = "14400s"

per_series_aligner = "ALIGN_FRACTION_TRUE"

}

}

}

}

resource "google_monitoring_alert_policy" "alert_database_cpu_usage" {

project = "PROJECT_ID"

display_name = "Airflow Database CPU Usage"

combiner = "OR"

notification_channels = [google_monitoring_notification_channel.basic.name] // To manually add a notification channel add it with the syntax "projects/[PROJECT_ID]/notificationChannels/[CHANNEL_ID]"

conditions {

display_name = "Database CPU usage condition"

condition_threshold {

filter = "resource.type = \"cloud_composer_environment\" AND metric.type=\"composer.googleapis.com/environment/database/cpu/utilization\" AND resource.label.environment_name=\"ENVIRONMENT_NAME\""

duration = "60s"

comparison = "COMPARISON_GT"

threshold_value = 80

aggregations {

alignment_period = "43200s"

per_series_aligner = "ALIGN_MEAN"

}

}

}

}

resource "google_monitoring_alert_policy" "alert_database_memory_usage" {

project = "PROJECT_ID"

display_name = "Airflow Database Memory Usage"

combiner = "OR"

notification_channels = [google_monitoring_notification_channel.basic.name] // To manually add a notification channel add it with the syntax "projects/[PROJECT_ID]/notificationChannels/[CHANNEL_ID]"

conditions {

display_name = "Database memory usage condition"

condition_threshold {

filter = "resource.type = \"cloud_composer_environment\" AND metric.type=\"composer.googleapis.com/environment/database/memory/utilization\" AND resource.label.environment_name=\"ENVIRONMENT_NAME\""

duration = "60s"

comparison = "COMPARISON_GT"

threshold_value = 80

aggregations {

alignment_period = "43200s"

per_series_aligner = "ALIGN_MEAN"

}

}

}

}

resource "google_monitoring_alert_policy" "alert_scheduler_heartbeat" {

project = "PROJECT_ID"

display_name = "Airflow Scheduler Heartbeat"

combiner = "OR"

notification_channels = [google_monitoring_notification_channel.basic.name] // To manually add a notification channel add it with the syntax "projects/[PROJECT_ID]/notificationChannels/[CHANNEL_ID]"

conditions {

display_name = "Scheduler heartbeat condition"

condition_threshold {

filter = "resource.type = \"cloud_composer_environment\" AND metric.type=\"composer.googleapis.com/environment/scheduler_heartbeat_count\" AND resource.label.environment_name=\"ENVIRONMENT_NAME\""

duration = "60s"

comparison = "COMPARISON_LT"

threshold_value = 216 // Threshold is 90% of the average for composer.googleapis.com/environment/scheduler_heartbeat_count metric in an idle environment

aggregations {

alignment_period = "14400s"

per_series_aligner = "ALIGN_COUNT"

}

}

}

}

resource "google_monitoring_alert_policy" "alert_zombie_task" {

project = "PROJECT_ID"

display_name = "Airflow Zombie Tasks"

combiner = "OR"

notification_channels = [google_monitoring_notification_channel.basic.name] // To manually add a notification channel add it with the syntax "projects/[PROJECT_ID]/notificationChannels/[CHANNEL_ID]"

conditions {

display_name = "Zombie tasks condition"

condition_threshold {

filter = "resource.type = \"cloud_composer_environment\" AND metric.type=\"composer.googleapis.com/environment/zombie_task_killed_count\" AND resource.label.environment_name=\"ENVIRONMENT_NAME\""

duration = "60s"

comparison = "COMPARISON_GT"

threshold_value = 1

aggregations {

alignment_period = "86400s"

per_series_aligner = "ALIGN_SUM"

}

}

}

}

resource "google_monitoring_alert_policy" "alert_worker_restarts" {

project = "PROJECT_ID"

display_name = "Airflow Worker Restarts"

combiner = "OR"

notification_channels = [google_monitoring_notification_channel.basic.name] // To manually add a notification channel add it with the syntax "projects/[PROJECT_ID]/notificationChannels/[CHANNEL_ID]"

conditions {

display_name = "Worker container restarts condition"

condition_threshold {

filter = "resource.type = \"k8s_container\" AND (resource.labels.cluster_name = \"CLUSTER_NAME\" AND resource.labels.container_name = monitoring.regex.full_match(\"airflow-worker|base\") AND resource.labels.pod_name = monitoring.regex.full_match(\"airflow-worker-.*|airflow-k8s-worker-.*\")) AND metric.type = \"kubernetes.io/container/restart_count\""

duration = "60s"

comparison = "COMPARISON_GT"

threshold_value = 1

aggregations {

alignment_period = "86400s"

per_series_aligner = "ALIGN_RATE"

}

}

}

}

Testar as políticas de alertas

Esta seção descreve como testar as políticas de alerta criadas e interpretar os resultados.

Fazer upload de um DAG de exemplo

O DAG memory_consumption_dag.py de exemplo fornecido neste tutorial imita

a utilização intensiva de memória do worker. O DAG contém quatro tarefas, cada uma delas

grava dados em uma string de amostra, consumindo 380 MB de memória. O DAG de exemplo é programado para ser executado a cada dois minutos e começa a ser executado automaticamente depois de ser enviado para o ambiente do Composer.

Faça upload do seguinte DAG de exemplo para o ambiente criado nas etapas anteriores:

from datetime import datetime

import sys

import time

from airflow import DAG

from airflow.operators.python import PythonOperator

def ram_function():

data = ""

start = time.time()

for i in range(38):

data += "a" * 10 * 1000**2

time.sleep(0.2)

print(f"{i}, {round(time.time() - start, 4)}, {sys.getsizeof(data) / (1000 ** 3)}")

print(f"Size={sys.getsizeof(data) / (1000 ** 3)}GB")

time.sleep(30 - (time.time() - start))

print(f"Complete in {round(time.time() - start, 2)} seconds!")

with DAG(

dag_id="memory_consumption_dag",

start_date=datetime(2023, 1, 1, 1, 1, 1),

schedule="1/2 * * * *",

catchup=False,

) as dag:

for i in range(4):

PythonOperator(

task_id=f"task_{i+1}",

python_callable=ram_function,

retries=0,

dag=dag,

)

Interpretar alertas e métricas no Monitoring

Aguarde cerca de 10 minutos depois que o DAG de exemplo começar a ser executado e avalie os resultados do teste:

Verifique se você recebeu uma notificação de Google Cloud Alerting com o assunto que começa com

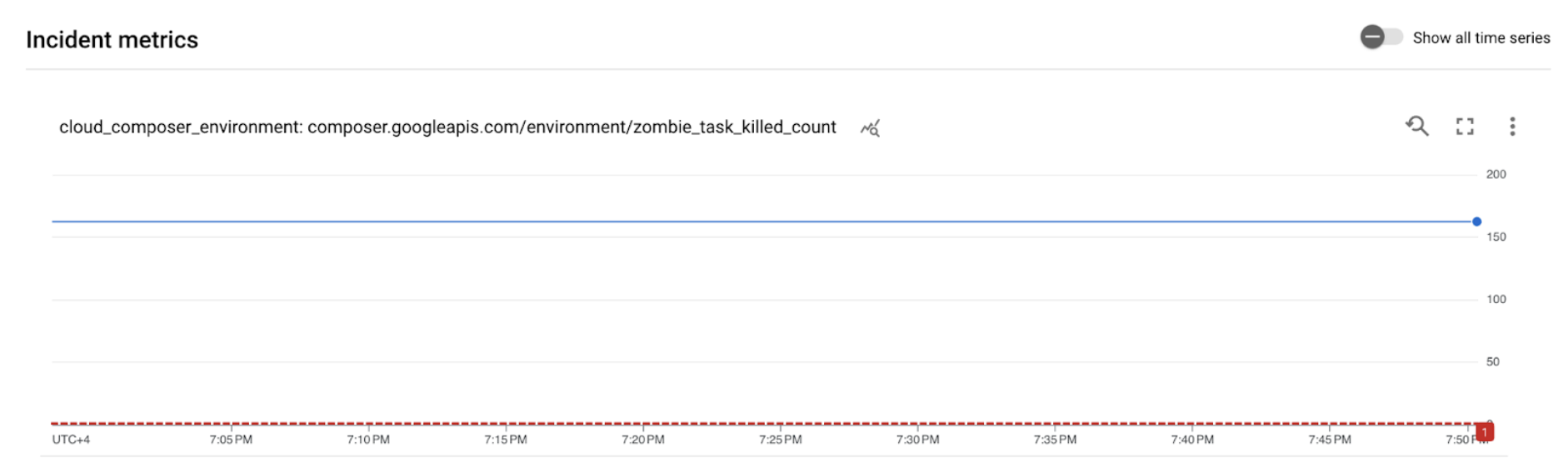

[ALERT]. O conteúdo desta mensagem contém os detalhes do incidente da política de alertas.Clique no botão Ver incidente na notificação por e-mail. Você será redirecionado para o Metrics Explorer. Revise os detalhes do incidente de alerta:

Figura 2. Detalhes do incidente de alerta (clique para ampliar) O gráfico de métricas de incidentes indica que as métricas criadas excederam o limite de 1, o que significa que o Airflow detectou e eliminou mais de uma tarefa zumbificada.

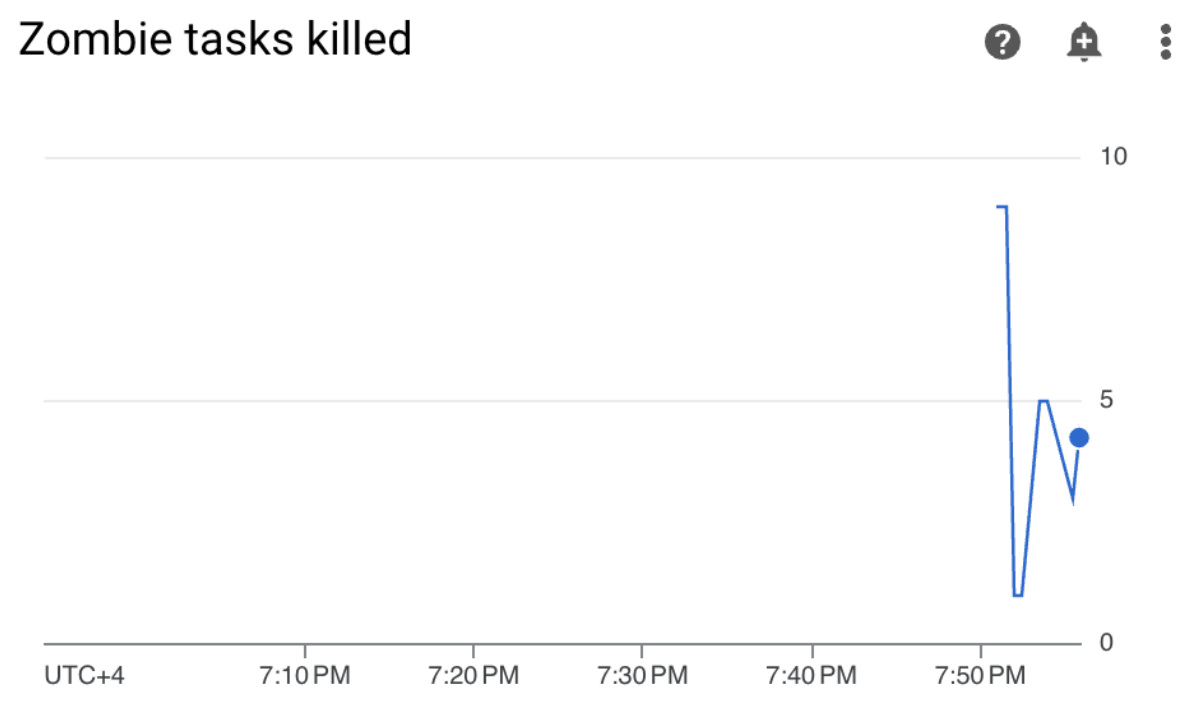

No ambiente do Cloud Composer, acesse a guia Monitoring, abra a seção DAG statistics e encontre o gráfico Zombie tasks killed:

Figura 3. Gráfico de tarefas zumbi (clique para ampliar) O gráfico indica que o Airflow eliminou cerca de 20 tarefas zumbi nos primeiros 10 minutos de execução do DAG de exemplo.

De acordo com os comparativos e as ações corretivas, o motivo mais comum para tarefas zumbis é a falta de memória ou CPU do worker. Identifique a causa raiz das tarefas zumbi analisando a utilização de recursos do worker.

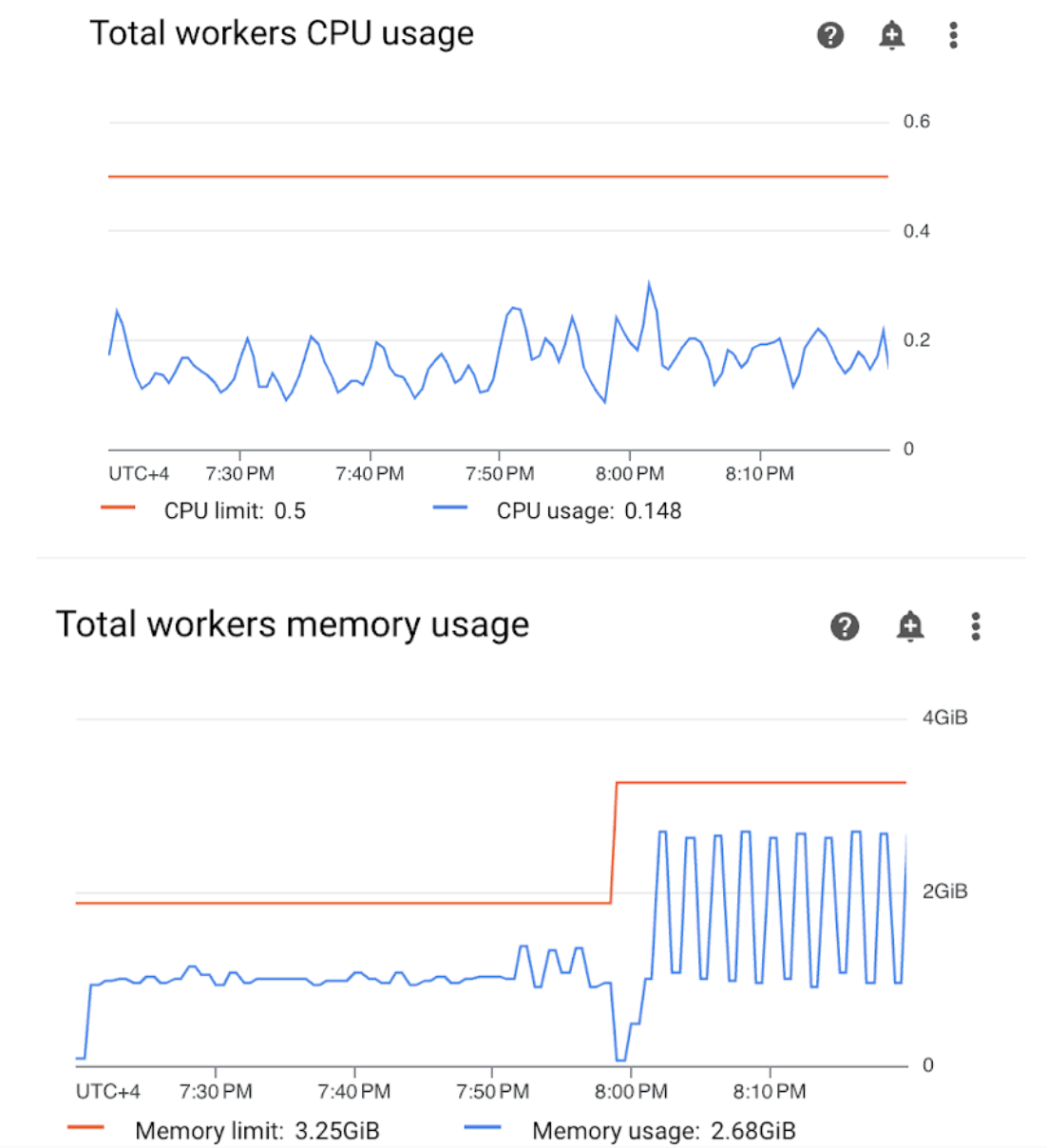

Abra a seção "Workers" no painel do Monitoring e revise as métricas de uso da CPU e da memória do worker:

Figura 4. Métricas de uso de CPU e memória do worker (clique para ampliar) O gráfico de uso da CPU dos workers total indica que o uso da CPU do worker estava abaixo de 50% do limite total disponível o tempo todo. Portanto, a CPU disponível é suficiente. O gráfico "Uso total de memória de workers" mostra que a execução do DAG de exemplo resultou em atingir o limite de memória alocável, que equivale a quase 75% do limite total de memória mostrado no gráfico. O GKE reserva 25% dos primeiros 4 GiB de memória e mais 100 MiB de memória em cada nó para lidar com a remoção de pods.

É possível concluir que os workers não têm os recursos de memória necessários para executar o DAG de exemplo.

Otimizar o ambiente e avaliar a performance

Com base na análise da utilização de recursos do worker, é necessário alocar mais memória para que todas as tarefas do DAG sejam concluídas.

No ambiente do Composer, abra a guia DAGs, clique no nome do DAG de exemplo (

memory_consumption_dag) e clique em Pause DAG.Aloque mais memória para o worker:

Na guia "Configuração do ambiente", encontre a configuração Recursos > Workloads e clique em Editar.

No item Worker, aumente o limite de Memória. Neste tutorial, use 3,25 GB.

Salve as alterações e aguarde alguns minutos para que o worker seja reiniciado.

Abra a guia "DAGs", clique no nome do DAG de exemplo (

memory_consumption_dag) e clique em Reativar DAG.

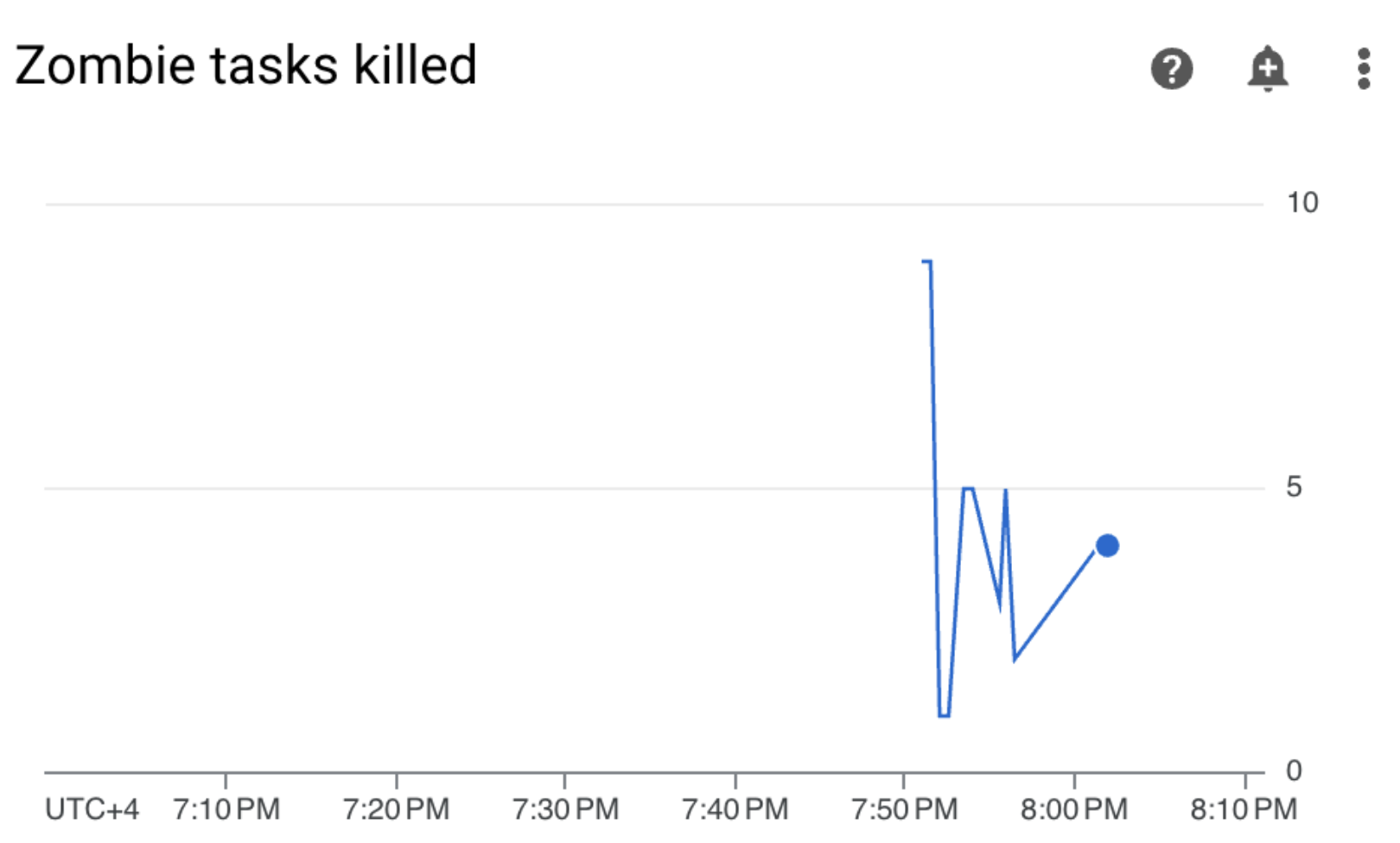

Acesse Monitoramento e verifique se nenhuma nova tarefa zumbi apareceu depois que você atualizou os limites de recursos do worker:

Resumo

Neste tutorial, você aprendeu sobre as principais métricas de integridade e desempenho no nível do ambiente, como configurar políticas de alerta para cada métrica e como interpretar cada métrica em ações corretivas. Em seguida, você executou um DAG de amostra, identificou a causa raiz dos problemas de integridade do ambiente com a ajuda de alertas e gráficos de monitoramento e otimizou seu ambiente alocando mais memória para os workers. No entanto, é recomendável otimizar seus DAGs para reduzir o consumo de recursos do worker, porque não é possível aumentar os recursos além de um determinado limite.

Limpar

Para evitar cobranças na sua conta do Google Cloud pelos recursos usados neste tutorial, exclua o projeto que contém os recursos ou mantenha o projeto e exclua os recursos individuais.

Excluir o projeto

- In the Google Cloud console, go to the Manage resources page.

- In the project list, select the project that you want to delete, and then click Delete.

- In the dialog, type the project ID, and then click Shut down to delete the project.

Excluir recursos individuais

Se você planeja ver vários tutoriais e guias de início rápido, a reutilização de projetos pode evitar que você exceda os limites da cota do projeto.

Console

- Exclua o ambiente do Cloud Composer. Você também exclui o bucket do ambiente durante esse procedimento.

- Exclua cada uma das políticas de alertas criadas no Cloud Monitoring.

Terraform

- Verifique se o script do Terraform não contém entradas para recursos que ainda são necessários para o projeto. Por exemplo, talvez você queira manter algumas APIs ativadas e as permissões do IAM ainda atribuídas (se você adicionou essas definições ao seu script do Terraform).

- Execute

terraform destroy. - Exclua manualmente o bucket do ambiente. O Cloud Composer não exclui automaticamente. É possível fazer isso no console Google Cloud ou na Google Cloud CLI.