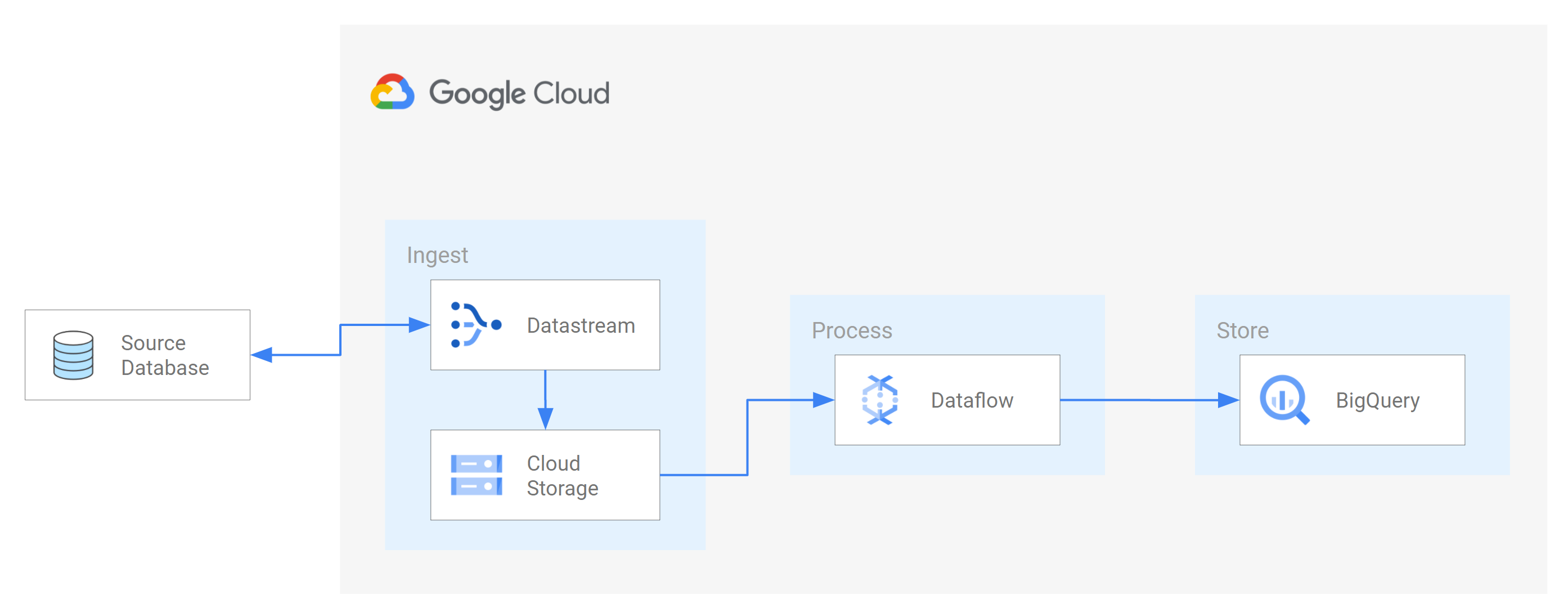

Datastream mendukung streaming data dari database Oracle, MySQL, dan PostgreSQL langsung ke set data BigQuery. Namun, jika Anda memerlukan kontrol lebih besar atas logika pemrosesan streaming, seperti transformasi data atau penetapan kunci utama logis secara manual, Anda dapat mengintegrasikan Datastream dengan template tugas Dataflow.

Tutorial ini menunjukkan cara Datastream terintegrasi dengan Dataflow dengan menggunakan template tugas Dataflow untuk melakukan streaming tampilan terwujud terbaru di BigQuery untuk analisis.

Untuk organisasi dengan banyak sumber data terisolasi, akses ke data perusahaan di seluruh organisasi, terutama secara real-time, dapat dibatasi dan lambat. Hal ini membatasi kemampuan organisasi untuk melakukan introspeksi.

Datastream memberikan akses hampir real-time ke data perubahan dari berbagai sumber data berbasis cloud dan lokal. Aliran data menyediakan pengalaman penyiapan yang tidak memerlukan banyak konfigurasi untuk streaming data; Datastream melakukannya untuk Anda. Datastream juga memiliki API penggunaan terpadu yang mendemokratisasi akses organisasi Anda ke data perusahaan terbaru yang tersedia untuk membangun skenario terintegrasi.

Salah satu skenarionya adalah mentransfer data dari database sumber ke layanan penyimpanan atau antrean pesan berbasis cloud. Setelah Datastream men-streaming data, data diubah menjadi bentuk yang dapat dibaca oleh aplikasi dan layanan lain. Dalam tutorial ini, Dataflow adalah layanan web yang berkomunikasi dengan layanan penyimpanan atau antrean pesan untuk mengambil dan memproses data di Google Cloud.

Anda akan mempelajari cara menggunakan Datastream untuk melakukan streaming perubahan (data yang disisipkan, diperbarui, atau dihapus) dari database MySQL sumber ke folder dalam bucket Cloud Storage. Kemudian, Anda mengonfigurasi bucket Cloud Storage untuk mengirim notifikasi yang digunakan Dataflow untuk mempelajari file baru yang berisi perubahan data yang di-streaming Datastream dari database sumber. Kemudian, tugas Dataflow akan memproses file dan mentransfer perubahan ke BigQuery.

Tujuan

Dalam tutorial ini, Anda telah:- Buat bucket di Cloud Storage. Ini adalah bucket tujuan tempat Datastream mengalirkan skema, tabel, dan data dari database MySQL sumber.

- Aktifkan notifikasi Pub/Sub untuk bucket Cloud Storage. Dengan melakukannya, Anda mengonfigurasi bucket untuk mengirim notifikasi yang digunakan Dataflow untuk mempelajari file baru yang siap diproses. File ini berisi perubahan pada data yang dialirkan Datastream dari database sumber ke dalam bucket.

- Buat set data di BigQuery. BigQuery menggunakan set data untuk berisi data yang diterimanya dari Dataflow. Data ini merepresentasikan perubahan dalam database sumber yang di-streaming Datastream ke bucket Cloud Storage.

- Buat dan kelola profil koneksi untuk database sumber dan bucket tujuan di Cloud Storage. Aliran data di Datastream menggunakan informasi dalam profil koneksi untuk mentransfer data dari database sumber ke dalam bucket.

- Buat dan mulai aliran data. Aliran ini mentransfer data, skema, dan tabel dari database sumber ke dalam bucket.

- Verifikasi bahwa Datastream mentransfer data dan tabel yang terkait dengan skema database sumber ke dalam bucket.

- Buat tugas di Dataflow. Setelah Datastream mengalirkan perubahan data dari database sumber ke bucket Cloud Storage, notifikasi akan dikirim ke Dataflow tentang file baru yang berisi perubahan. Tugas Dataflow memproses file dan mentransfer perubahan ke BigQuery.

- Verifikasi bahwa Dataflow memproses file yang berisi perubahan yang terkait dengan data ini, dan mentransfer perubahan ke BigQuery. Dengan demikian, Anda memiliki integrasi menyeluruh antara Datastream dan BigQuery.

- Bersihkan resource yang Anda buat di Datastream, Cloud Storage, Pub/Sub, Dataflow, dan BigQuery agar tidak menggunakan kuota dan Anda tidak ditagih untuk resource tersebut di masa mendatang.

Biaya

Dalam dokumen ini, Anda akan menggunakan komponen Google Cloudyang dapat ditagih berikut:

- Datastream

- Cloud Storage

- Pub/Sub

- Dataflow

- BigQuery

Untuk membuat perkiraan biaya berdasarkan proyeksi penggunaan Anda,

gunakan kalkulator harga.

Sebelum memulai

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

-

Verify that billing is enabled for your Google Cloud project.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

-

Verify that billing is enabled for your Google Cloud project.

- Aktifkan Datastream API.

- Pastikan Anda memiliki peran Admin Datastream yang diberikan ke akun pengguna Anda.

- Pastikan Anda memiliki database MySQL sumber yang dapat diakses Datastream. Selain itu, pastikan Anda memiliki data, tabel, dan skema dalam database.

- Konfigurasi database MySQL Anda untuk mengizinkan koneksi masuk dari alamat IP publik Datastream. Untuk mengetahui daftar semua region Datastream dan alamat IP publik terkait, lihat Daftar yang diberi akses dan region IP.

- Siapkan pengambilan data perubahan (CDC) untuk database sumber. Untuk mengetahui informasi selengkapnya, lihat Mengonfigurasi database MySQL sumber.

Pastikan Anda memenuhi semua prasyarat untuk mengaktifkan notifikasi Pub/Sub untuk Cloud Storage.

Dalam tutorial ini, Anda akan membuat bucket tujuan di Cloud Storage dan mengaktifkan notifikasi Pub/Sub untuk bucket tersebut. Dengan melakukannya, Dataflow dapat menerima notifikasi tentang file baru yang ditulis Datastream ke bucket. File ini berisi perubahan pada data yang dialirkan Datastream dari database sumber ke dalam bucket.

Persyaratan

Datastream menawarkan berbagai opsi sumber, opsi tujuan, dan metode konektivitas jaringan.

Untuk tutorial ini, kami mengasumsikan bahwa Anda menggunakan database MySQL mandiri dan layanan Cloud Storage tujuan. Untuk database sumber, Anda harus dapat mengonfigurasi jaringan untuk menambahkan aturan firewall masuk. Database sumber dapat berada di lokal atau di penyedia cloud. Untuk tujuan Cloud Storage, tidak ada konfigurasi konektivitas yang diperlukan.

Karena kami tidak dapat mengetahui secara spesifik lingkungan Anda, kami tidak dapat memberikan langkah-langkah mendetail mengenai konfigurasi jaringan Anda.

Untuk tutorial ini, Anda memilih IP allowlisting sebagai metode konektivitas jaringan. Daftar IP yang diizinkan adalah fitur keamanan yang sering digunakan untuk membatasi dan mengontrol akses ke data di database sumber Anda hanya untuk pengguna terpercaya. Anda dapat menggunakan daftar IP yang diizinkan untuk membuat daftar alamat IP atau rentang IP terpercaya yang dapat digunakan oleh pengguna dan layanan lain seperti Datastream untuk mengakses data ini. Google Cloud Untuk menggunakan daftar IP yang diizinkan, Anda harus membuka database sumber atau firewall ke koneksi masuk dari Datastream.

Membuat bucket di Cloud Storage

Buat bucket tujuan di Cloud Storage tempat Datastream mengalirkan skema, tabel, dan data dari database MySQL sumber.

Di konsol Google Cloud , buka halaman Browser untuk Cloud Storage.

Klik Create bucket. Halaman Buat bucket akan muncul.

Di kolom teks pada bagian Name your bucket, masukkan nama unik untuk bucket Anda, lalu klik Continue.

Terima setelan default untuk setiap wilayah halaman yang tersisa. Di akhir setiap wilayah, klik Lanjutkan.

Klik Buat.

Aktifkan notifikasi Pub/Sub untuk bucket Cloud Storage

Di bagian ini, Anda akan mengaktifkan notifikasi Pub/Sub untuk bucket Cloud Storage yang Anda buat. Dengan melakukannya, Anda mengonfigurasi bucket untuk memberi tahu Dataflow tentang file baru yang ditulis Datastream ke bucket. File ini berisi perubahan pada data yang di-streaming Datastream dari database MySQL sumber ke dalam bucket.

Akses bucket Cloud Storage yang Anda buat. Halaman Bucket details akan muncul.

Klik Activate Cloud Shell.

Pada perintah, masukkan perintah berikut:

gcloud storage buckets notifications create gs://bucket-name --topic=my_integration_notifs --payload-format=json --object-prefix=integration/tutorial/Opsional: Jika jendela Authorize Cloud Shell muncul, klik Authorize.

Verifikasi bahwa Anda melihat baris kode berikut:

Created Cloud Pub/Sub topic projects/project-name/topics/my_integration_notifs Created notification config projects/_/buckets/bucket-name/notificationConfigs/1

Di konsol Google Cloud , buka halaman Topics untuk Pub/Sub.

Klik topik my_integration_notifs yang Anda buat.

Di halaman my_integration_notifs, buka bagian bawah halaman. Pastikan tab Langganan aktif dan pesan Tidak ada langganan untuk ditampilkan muncul.

Klik Buat langganan.

Di menu yang muncul, pilih Buat langganan.

Di halaman Add subscription to topic:

- Di kolom Subscription ID, masukkan

my_integration_notifs_sub. - Tetapkan nilai Batas waktu konfirmasi ke

120detik. Hal ini memungkinkan Dataflow memiliki waktu yang cukup untuk mengonfirmasi file yang telah diproses, dan membantu meningkatkan performa keseluruhan tugas Dataflow. Untuk mengetahui informasi selengkapnya tentang properti langganan Pub/Sub, lihat Properti langganan. - Biarkan semua nilai default lainnya di halaman.

- Klik Buat.

- Di kolom Subscription ID, masukkan

Nanti dalam tutorial ini, Anda akan membuat tugas Dataflow. Sebagai bagian dari pembuatan tugas ini, Anda menetapkan Dataflow sebagai pelanggan langganan my_integration_notifs_sub. Dengan melakukannya, Dataflow dapat menerima notifikasi tentang file baru yang ditulis Datastream ke Cloud Storage, memproses file, dan mentransfer perubahan data ke BigQuery.

Membuat set data di BigQuery

Di bagian ini, Anda akan membuat set data di BigQuery. BigQuery menggunakan set data untuk berisi data yang diterimanya dari Dataflow. Data ini merepresentasikan perubahan dalam database MySQL sumber yang di-streaming Datastream ke bucket Cloud Storage Anda.

Buka halaman SQL workspace untuk BigQuery di konsol Google Cloud .

Di panel Explorer, di samping nama project Google Cloud Anda, klik View actions.

Di menu yang muncul, pilih Buat set data.

Di jendela Create dataset:

- Di kolom Dataset ID, masukkan ID untuk set data. Untuk tutorial ini, masukkan

My_integration_dataset_logdi kolom. - Biarkan semua nilai default lainnya di jendela.

- Klik Create dataset.

- Di kolom Dataset ID, masukkan ID untuk set data. Untuk tutorial ini, masukkan

Di panel Explorer, di samping nama project Google Cloud Anda, klik Expand node, lalu verifikasi bahwa Anda melihat set data yang Anda buat.

Gunakan langkah-langkah dalam prosedur ini untuk membuat set data kedua: My_integration_dataset_final.

Di samping setiap set data, luaskan Luaskan node.

Pastikan setiap set data kosong.

Setelah Datastream melakukan streaming perubahan data dari database sumber ke bucket Cloud Storage Anda, tugas Dataflow akan memproses file yang berisi perubahan dan mentransfer perubahan tersebut ke set data BigQuery.

Membuat profil koneksi di Datastream

Di bagian ini, Anda akan membuat profil koneksi di Datastream untuk database sumber dan tujuan. Sebagai bagian dari pembuatan profil koneksi, Anda memilih MySQL sebagai jenis profil untuk profil koneksi sumber dan Cloud Storage sebagai jenis profil untuk profil koneksi tujuan.

Datastream menggunakan informasi yang ditentukan dalam profil koneksi untuk terhubung ke sumber dan tujuan sehingga dapat melakukan streaming data dari database sumber ke bucket tujuan Anda di Cloud Storage.

Membuat profil koneksi sumber untuk database MySQL Anda

Di konsol Google Cloud , buka halaman Connection profiles untuk Datastream.

Klik Buat profil.

Untuk membuat profil koneksi sumber bagi database MySQL Anda, di halaman Create a connection profile, klik jenis profil MySQL.

Di bagian Define connection settings di halaman Create MySQL profile, berikan informasi berikut:

- Di kolom Nama profil koneksi, masukkan

My Source Connection Profile. - Biarkan Connection profile ID yang dibuat otomatis.

Pilih Region tempat Anda ingin menyimpan profil koneksi.

Masukkan Detail koneksi:

- Di kolom Nama host atau IP, masukkan nama host atau alamat IP publik yang dapat digunakan Datastream untuk terhubung ke database sumber. Anda memberikan alamat IP publik karena Anda menggunakan pemberian izin IP sebagai metode konektivitas jaringan untuk tutorial ini.

- Di kolom Port, masukkan nomor port yang dicadangkan untuk database sumber. Untuk database MySQL, port default biasanya adalah

3306. - Masukkan Nama Pengguna dan Sandi untuk mengautentikasi database sumber Anda.

- Di kolom Nama profil koneksi, masukkan

Di bagian Define connection settings, klik Continue. Bagian Amankan koneksi Anda ke sumber di halaman Buat profil MySQL aktif.

Dari menu Jenis enkripsi, pilih Tidak ada. Untuk mengetahui informasi selengkapnya tentang menu ini, lihat Membuat profil koneksi untuk database MySQL.

Di bagian Amankan koneksi Anda ke sumber, klik Lanjutkan. Bagian Tentukan metode konektivitas di halaman Buat profil MySQL akan aktif.

Di drop-down Metode konektivitas, pilih metode jaringan yang ingin Anda gunakan untuk membangun konektivitas antara Datastream dan database sumber. Untuk tutorial ini, pilih IP allowlisting sebagai metode konektivitas.

Konfigurasi database sumber Anda untuk mengizinkan koneksi masuk dari alamat IP publik Datastream yang muncul.

Di bagian Tentukan metode konektivitas, klik Lanjutkan. Bagian Uji profil koneksi di halaman Buat profil MySQL akan aktif.

Klik Run test untuk memverifikasi bahwa database sumber dan Datastream dapat saling berkomunikasi.

Pastikan Anda melihat status Test passed.

Klik Buat.

Membuat profil koneksi tujuan untuk Cloud Storage

Di konsol Google Cloud , buka halaman Connection profiles untuk Datastream.

Klik Buat profil.

Untuk membuat profil koneksi tujuan untuk Cloud Storage, di halaman Create a connection profile, klik jenis profil Cloud Storage.

Di halaman Create Cloud Storage profile, berikan informasi berikut:

- Di kolom Nama profil koneksi, masukkan

My Destination Connection Profile. - Biarkan Connection profile ID yang dibuat otomatis.

- Pilih Region tempat Anda ingin menyimpan profil koneksi.

Di panel Connection details, klik Browse untuk memilih bucket Cloud Storage yang Anda buat sebelumnya dalam tutorial ini. Ini adalah bucket tempat Datastream mentransfer data dari database sumber. Setelah memilih, klik Pilih.

Bucket Anda akan muncul di kolom Bucket name pada panel Connection details.

Di kolom Awalan jalur profil koneksi, berikan awalan untuk jalur yang ingin Anda tambahkan ke nama bucket saat Datastream melakukan streaming data ke tujuan. Pastikan Datastream menulis data ke jalur di dalam bucket, bukan ke folder root bucket. Untuk tutorial ini, gunakan jalur yang Anda tentukan saat mengonfigurasi notifikasi Pub/Sub. Masukkan

/integration/tutorialdi kolom.

- Di kolom Nama profil koneksi, masukkan

Klik Buat.

Setelah membuat profil koneksi sumber untuk database MySQL dan profil koneksi tujuan untuk Cloud Storage, Anda dapat menggunakannya untuk membuat aliran.

Membuat aliran di Datastream

Di bagian ini, Anda akan membuat aliran. Aliran ini menggunakan informasi dalam profil koneksi untuk mentransfer data dari database MySQL sumber ke bucket tujuan di Cloud Storage.

Menentukan setelan untuk streaming

Di konsol Google Cloud , buka halaman Streams untuk Datastream.

Klik Buat aliran.

Berikan informasi berikut di panel Define stream details pada halaman Create stream:

- Di kolom Nama aliran, masukkan

My Stream. - Pertahankan ID Aliran Data yang dibuat otomatis.

- Dari menu Region, pilih region tempat Anda membuat profil koneksi sumber dan tujuan.

- Dari menu Jenis sumber, pilih jenis profil MySQL.

- Dari menu Jenis tujuan, pilih jenis profil Cloud Storage.

- Di kolom Nama aliran, masukkan

Tinjau prasyarat yang diperlukan yang dibuat secara otomatis guna mencerminkan cara lingkungan Anda harus disiapkan untuk streaming. Prasyarat ini dapat mencakup cara mengonfigurasi database sumber dan cara menghubungkan Datastream ke bucket tujuan di Cloud Storage.

Klik Lanjutkan. Panel Define MySQL connection profile di halaman Create stream akan muncul.

Menentukan informasi tentang profil koneksi sumber

Di bagian ini, Anda memilih profil koneksi yang Anda buat untuk database sumber (profil koneksi sumber). Untuk tutorial ini, profil koneksi sumbernya adalah My Source Connection Profile.

Dari menu Profil koneksi sumber, pilih profil koneksi sumber untuk database MySQL.

Klik Run test untuk memverifikasi bahwa database sumber dan Datastream dapat saling berkomunikasi.

Jika pengujian gagal, masalah yang terkait dengan profil koneksi akan muncul. Lihat halaman Mendiagnosis masalah untuk mengetahui langkah-langkah pemecahan masalah. Lakukan perubahan yang diperlukan untuk memperbaiki masalah, lalu uji ulang.

Klik Lanjutkan. Panel Konfigurasi sumber aliran data di halaman Buat aliran data akan muncul.

Mengonfigurasi informasi tentang database sumber untuk aliran data

Di bagian ini, Anda mengonfigurasi informasi tentang database sumber untuk aliran data dengan menentukan tabel dan skema di database sumber yang akan:

- Dapat ditransfer ke tujuan.

- Dibatasi agar tidak ditransfer ke tujuan.

Anda juga menentukan apakah Datastream mengisi ulang data historis, serta mengalirkan perubahan yang sedang berlangsung ke tujuan, atau hanya mengalirkan perubahan pada data.

Gunakan menu Objek yang akan disertakan untuk menentukan tabel dan skema dalam database sumber yang dapat ditransfer Datastream ke dalam folder di bucket tujuan di Cloud Storage. Menu hanya dimuat jika database Anda memiliki hingga 5.000 objek.

Untuk tutorial ini, Anda ingin Datastream mentransfer semua tabel dan skema. Oleh karena itu, pilih Semua tabel dari semua skema dari menu.

Pastikan panel Select objects to exclude disetel ke None. Anda tidak ingin membatasi Datastream agar tidak mentransfer tabel dan skema apa pun di database sumber ke Cloud Storage.

Pastikan panel Pilih mode pengisian ulang untuk data historis disetel ke Otomatis. Datastream mengalirkan semua data yang ada, selain perubahan pada data, dari sumber ke tujuan.

Klik Lanjutkan. Panel Tentukan profil koneksi Cloud Storage di halaman Buat streaming akan muncul.

Pilih profil koneksi tujuan

Di bagian ini, Anda memilih profil koneksi yang Anda buat untuk Cloud Storage (profil koneksi tujuan). Untuk tutorial ini, profilnya adalah My Destination Connection Profile.

Dari menu Destination connection profile, pilih profil koneksi tujuan untuk Cloud Storage.

Klik Lanjutkan. Panel Konfigurasi tujuan aliran data di halaman Buat aliran data akan muncul.

Mengonfigurasi informasi tentang tujuan untuk aliran data

Di bagian ini, Anda akan mengonfigurasi informasi tentang bucket tujuan untuk streaming. Informasi ini mencakup:

- Format output file yang ditulis ke Cloud Storage.

- Folder bucket tujuan tempat Datastream mentransfer skema, tabel, dan data dari database sumber.

Di kolom Output format, pilih format file yang ditulis ke Cloud Storage. Datastream mendukung dua format output: Avro dan JSON. Untuk tutorial ini, Avro adalah format file-nya.

Klik Lanjutkan. Panel Tinjau detail aliran data dan buat di halaman Buat aliran data akan muncul.

Buat aliran data

Verifikasi detail tentang aliran data serta profil koneksi sumber dan tujuan yang digunakan aliran data untuk mentransfer data dari database MySQL sumber ke bucket tujuan di Cloud Storage.

Untuk memvalidasi aliran data, klik Jalankan validasi. Dengan memvalidasi aliran, Datastream akan memeriksa apakah sumber dikonfigurasi dengan benar, memvalidasi apakah aliran dapat terhubung ke sumber dan tujuan, serta memverifikasi konfigurasi end-to-end aliran.

Setelah semua pemeriksaan validasi lulus, klik Buat.

Dalam dialog Buat aliran?, klik Buat.

Mulai streaming

Untuk tutorial ini, Anda akan membuat dan memulai aliran secara terpisah jika proses pembuatan aliran menimbulkan peningkatan beban pada database sumber. Untuk menunda pemuatan tersebut, Anda membuat streaming tanpa memulainya, lalu memulai streaming saat database Anda dapat menangani beban.

Dengan memulai aliran data, Datastream dapat mentransfer data, skema, dan tabel dari database sumber ke tujuan.

Di konsol Google Cloud , buka halaman Streams untuk Datastream.

Centang kotak di samping aliran yang ingin Anda mulai. Untuk tutorial ini, nama ini adalah My Stream.

Klik Mulai.

Di dialog, klik Mulai. Status streaming berubah dari

Not startedmenjadiStarting, lalu menjadiRunning.

Setelah memulai aliran, Anda dapat memverifikasi bahwa Datastream mentransfer data dari database sumber ke tujuan.

Memverifikasi streaming

Di bagian ini, Anda mengonfirmasi bahwa Datastream mentransfer data dari semua tabel database MySQL sumber ke folder /integration/tutorial di bucket tujuan Cloud Storage Anda.

Di konsol Google Cloud , buka halaman Streams untuk Datastream.

Klik streaming yang Anda buat. Untuk tutorial ini, nama ini adalah My Stream.

Di halaman Detail streaming, klik link bucket-name/integration/tutorial, dengan bucket-name adalah nama yang Anda berikan untuk bucket Cloud Storage Anda. Link ini muncul setelah kolom Jalur tulis tujuan. Halaman Bucket details Cloud Storage akan terbuka di tab terpisah.

Pastikan Anda melihat folder yang merepresentasikan tabel database sumber.

Klik salah satu folder tabel, lalu klik setiap subfolder hingga Anda melihat data yang terkait dengan tabel.

Membuat tugas Dataflow

Di bagian ini, Anda akan membuat tugas di Dataflow. Setelah Datastream mengalirkan perubahan data dari database MySQL sumber ke bucket Cloud Storage Anda, Pub/Sub akan mengirimkan notifikasi ke Dataflow tentang file baru yang berisi perubahan tersebut. Tugas Dataflow memproses file dan mentransfer perubahan ke BigQuery.

Di konsol Google Cloud , buka halaman Jobs untuk Dataflow.

Klik Buat tugas dari template.

Di kolom Job name pada halaman Create job from template, masukkan nama untuk tugas Dataflow yang Anda buat. Untuk tutorial ini, masukkan

my-dataflow-integration-jobdi kolom.Dari menu Endpoint regional, pilih region tempat Anda ingin menyimpan tugas. Ini adalah region yang sama dengan yang Anda pilih untuk profil koneksi sumber, profil koneksi tujuan, dan aliran data yang Anda buat.

Dari menu Template Dataflow, pilih template yang Anda gunakan untuk membuat tugas. Untuk tutorial ini, pilih Datastream to BigQuery.

Setelah membuat pilihan ini, kolom tambahan yang terkait dengan template ini akan muncul.

Di kolom Lokasi file untuk output file Datastream di Cloud Storage., masukkan nama bucket Cloud Storage Anda menggunakan format berikut:

gs://bucket-name.Di kolom Langganan Pub/Sub yang digunakan dalam kebijakan notifikasi Cloud Storage., masukkan jalur yang berisi nama langganan Pub/Sub Anda. Untuk tutorial ini, masukkan

projects/project-name/subscriptions/my_integration_notifs_sub.Di kolom Datastream output file format (avro/json)., masukkan

avrokarena, untuk tutorial ini, Avro adalah format file yang ditulis Datastream ke Cloud Storage.Di kolom Name or template for the dataset to contain staging tables., masukkan

My_integration_dataset_logkarena Dataflow menggunakan set data ini untuk melakukan penahapan perubahan data yang diterimanya dari Datastream.Di kolom Template untuk set data yang akan berisi tabel replika., masukkan

My_integration_dataset_finalkarena ini adalah set data tempat perubahan yang dipentaskan di set data My_integration_dataset_log digabungkan untuk membuat replika satu-ke-satu dari tabel di database sumber.Di kolom Dead letter queue directory., masukkan jalur yang berisi nama bucket Cloud Storage Anda dan folder untuk antrean pesan yang tidak terkirim. Pastikan Anda tidak menggunakan jalur di folder root, dan jalur tersebut berbeda dengan jalur tempat Datastream menulis data. Setiap perubahan data yang gagal ditransfer Dataflow ke BigQuery akan disimpan dalam antrean. Anda dapat memperbaiki konten dalam antrean sehingga Dataflow dapat memproses ulang konten tersebut.

Untuk tutorial ini, masukkan

gs://bucket-name/dlqdi kolom Dead letter queue directory. (dengan bucket-name adalah nama bucket Anda dan dlq adalah folder untuk antrean pesan yang tidak terkirim).Klik Run job.

Memverifikasi integrasi

Di bagian Verify the stream dalam tutorial ini, Anda mengonfirmasi bahwa Datastream mentransfer data dari semua tabel database MySQL sumber ke folder /integration/tutorial di bucket tujuan Cloud Storage Anda.

Di bagian ini, Anda akan memverifikasi bahwa Dataflow memproses file yang berisi perubahan yang terkait dengan data ini, dan mentransfer perubahan tersebut ke BigQuery. Dengan demikian, Anda memiliki integrasi menyeluruh antara Datastream dan BigQuery.

Di konsol Google Cloud , buka halaman SQL workspace untuk BigQuery.

Di panel Explorer, luaskan node di samping nama project Google Cloud Anda.

Luaskan node di samping set data My_integration_dataset_log dan My_integration_dataset_final.

Pastikan setiap set data kini berisi data. Hal ini mengonfirmasi bahwa Dataflow memproses file yang berisi perubahan yang terkait dengan data yang di-streaming Datastream ke Cloud Storage, dan mentransfer perubahan ini ke BigQuery.

Pembersihan

Agar tidak menimbulkan biaya pada Google Cloud akun Anda untuk resource yang digunakan dalam tutorial ini, gunakan Google Cloud konsol untuk melakukan hal berikut:

- Hapus project, aliran Datastream, dan profil koneksi Datastream Anda.

- Hentikan tugas Dataflow.

- Hapus set data BigQuery, topik dan langganan Pub/Sub, serta bucket Cloud Storage.

Dengan menghapus resource yang Anda buat di Datastream, Dataflow, BigQuery, Pub/Sub, dan Cloud Storage, Anda mencegah resource tersebut menggunakan kuota dan Anda tidak akan ditagih untuk resource tersebut pada masa mendatang.

Menghapus project Anda

Cara termudah untuk menghilangkan penagihan adalah dengan menghapus project yang Anda buat untuk tutorial ini.

Di konsol Google Cloud , buka halaman Kelola resource.

Dalam daftar project, pilih project yang ingin Anda hapus, lalu klik Delete.

Untuk menghapus project, pada dialog, ketik project ID, lalu klik Shut down.

Menghapus aliran data

Di konsol Google Cloud , buka halaman Streams untuk Datastream.

Klik aliran yang ingin Anda hapus. Untuk tutorial ini, nama ini adalah My Stream.

Klik Jeda.

Pada dialog, klik Jeda.

Di panel Status aliran pada halaman Detail aliran, pastikan status aliran adalah

Paused.Klik Hapus.

Di dialog, pada kolom teks, masukkan

Delete, lalu klik Hapus.

Menghapus profil koneksi

Di konsol Google Cloud , buka halaman Connection profiles untuk Datastream.

Pilih kotak centang untuk setiap profil koneksi yang ingin Anda hapus: Profil Koneksi Sumber Saya dan Profil Koneksi Tujuan Saya.

Klik Hapus.

Pada dialog, klik Hapus.

Hentikan tugas Dataflow

Di konsol Google Cloud , buka halaman Jobs untuk Dataflow.

Klik tugas yang ingin Anda hentikan. Untuk tutorial ini, nama tugasnya adalah my-dataflow-integration-job.

Klik Stop.

Dalam dialog Stop job, pilih opsi Drain, lalu klik Stop job.

Menghapus set data BigQuery

Di konsol Google Cloud , buka halaman SQL workspace untuk BigQuery.

Di panel Explorer, luaskan node di samping nama project Google Cloud Anda.

Klik tombol Lihat tindakan di sebelah kanan salah satu set data yang Anda buat di Membuat set data di BigQuery. Tombol ini terlihat seperti elipsis vertikal.

Untuk tutorial ini, klik tombol View actions di sebelah kanan My_integration_dataset_log.

Pilih Hapus dari menu drop-down yang muncul.

Pada dialog Delete dataset?, masukkan

deletedi kolom teks, lalu klik Delete.Ulangi langkah-langkah dalam prosedur ini untuk menghapus set data kedua yang Anda buat: My_integration_dataset_final.

Menghapus langganan dan topik Pub/Sub

Di konsol Google Cloud , buka halaman Subscriptions untuk Pub/Sub.

Klik kotak centang di samping langganan yang ingin Anda hapus. Untuk tutorial ini, klik kotak centang di samping langganan my_integration_notifs_sub.

Klik Hapus.

Pada dialog Hapus langganan, klik Hapus.

Di konsol Google Cloud , buka halaman Topics untuk Pub/Sub.

Centang kotak di samping topik my_integration_notifs.

Klik Hapus.

Pada dialog Delete topic, masukkan

deletedi kolom teks, lalu klik Delete.

Menghapus bucket Cloud Storage

Di konsol Google Cloud , buka halaman Browser untuk Cloud Storage.

Pilih kotak centang di samping bucket Anda.

Klik Hapus.

Dalam dialog, masukkan

Deletedi kolom teks, lalu klik Hapus.

Langkah berikutnya

- Pelajari Datastream lebih lanjut.

- Gunakan API streaming lama untuk melakukan kemampuan lanjutan dengan streaming data ke BigQuery.

- Coba sendiri fitur Google Cloud lainnya. Lihat tutorial kami.