ステップ 1: ワークロードを確立する

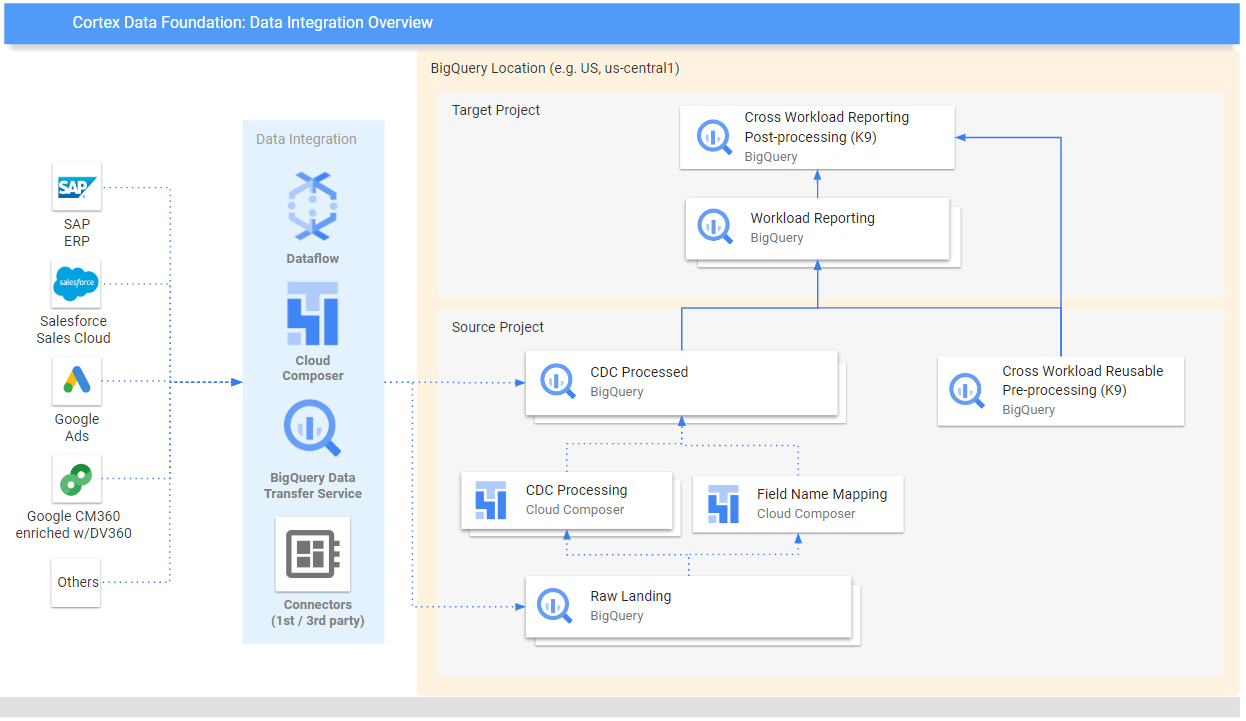

このページでは、Cortex Framework のコアであるデータ基盤の設定の最初のステップについて説明します。BigQuery ストレージ上に構築されたデータ基盤は、さまざまなソースから受信したデータを整理します。この整理されたデータにより、分析と AI 開発での応用が簡素化されます。

データ統合を設定する

まず、Cortex Framework 内でデータを効率的に整理して使用するためのブループリントとして機能する、いくつかのキーパラメータを定義します。これらのパラメータは、特定のワークロード、選択したデータフロー、統合メカニズムによって異なる場合があります。次の図は、Cortex Framework Data Foundation 内のデータ統合の概要を示しています。

Cortex Framework 内でデータを効率的かつ効果的に活用するために、デプロイ前に次のパラメータを定義します。

プロジェクト

- ソース プロジェクト: 生データが存在するプロジェクト。データを保存してデプロイ プロセスを実行するには、少なくとも 1 つの Google Cloud プロジェクトが必要です。

- ターゲット プロジェクト(省略可): Cortex Framework Data Foundation が処理済みデータモデルを保存するプロジェクト。これは、ニーズに応じて、ソース プロジェクトと同じにすることも、別のものにすることもできます。

ワークロードごとに別々のプロジェクトとデータセットのセット(たとえば、SAP 用のソース プロジェクトとターゲット プロジェクトのセットと、Salesforce 用のターゲット プロジェクトとソース プロジェクトの別のセット)が必要な場合は、ワークロードごとに別々のデプロイを実行します。詳細については、省略可能な手順のセクションにある異なるプロジェクトを使用してアクセスを分離するをご覧ください。

データモデル

- モデルのデプロイ: すべてのワークロードにモデルをデプロイする必要があるか、1 つのモデルセット(SAP、Salesforce、Meta など)のみをデプロイする必要があるかを選択します。詳細については、使用可能なデータソースとワークロードをご覧ください。

BigQuery データセット

- ソース データセット(未加工): ソースデータが複製されるか、テストデータが作成される BigQuery データセット。データソースごとに個別のデータセットを作成することをおすすめします。たとえば、SAP 用の生データセットと Google 広告用の生データセットです。このデータセットは移行元プロジェクトに属しています。

- CDC データセット: CDC 処理済みデータが最新の利用可能なレコードを格納する BigQuery データセット。一部のワークロードでは、フィールド名のマッピングが可能です。各ソースに個別の CDC データセットを用意することをおすすめします。たとえば、SAP 用の CDC データセットと Salesforce 用の CDC データセットを作成します。このデータセットは移行元プロジェクトに属しています。

- ターゲット レポート データセット: Data Foundation の事前定義されたデータモデルがデプロイされる BigQuery データセット。ソースごとに個別のレポート用データセットを用意することをおすすめします。たとえば、SAP 用のレポート データセットと Salesforce 用のレポート データセットを作成します。このデータセットは、存在しない場合はデプロイ時に自動的に作成されます。このデータセットは、ターゲット プロジェクトに属しています。

- K9 データセットの前処理:

timeディメンションなどのクロス ワークロードの再利用可能な DAG コンポーネントをデプロイできる BigQuery データセット。ワークロードは、変更されない限り、このデータセットに依存します。このデータセットは、存在しない場合はデプロイ時に自動的に作成されます。このデータセットは移行元プロジェクトに属しています。 - 後処理 K9 データセット: クロス ワークロード レポートと追加の外部ソース DAG(Google トレンドの取り込みなど)をデプロイできる BigQuery データセット。このデータセットは、存在しない場合はデプロイ時に自動的に作成されます。このデータセットは、ターゲット プロジェクトに属しています。

省略可: サンプルデータを生成する

Cortex Framework は、独自のデータにアクセスできない場合や、データを設定するためのレプリケーション ツールがない場合、または Cortex Framework の動作を確認したいだけの場合に、サンプルデータとテーブルを生成できます。ただし、CDC データセットと Raw データセットは事前に作成して識別する必要があります。

次の手順に沿って、データソースごとに生データと CDC の BigQuery データセットを作成します。

コンソール

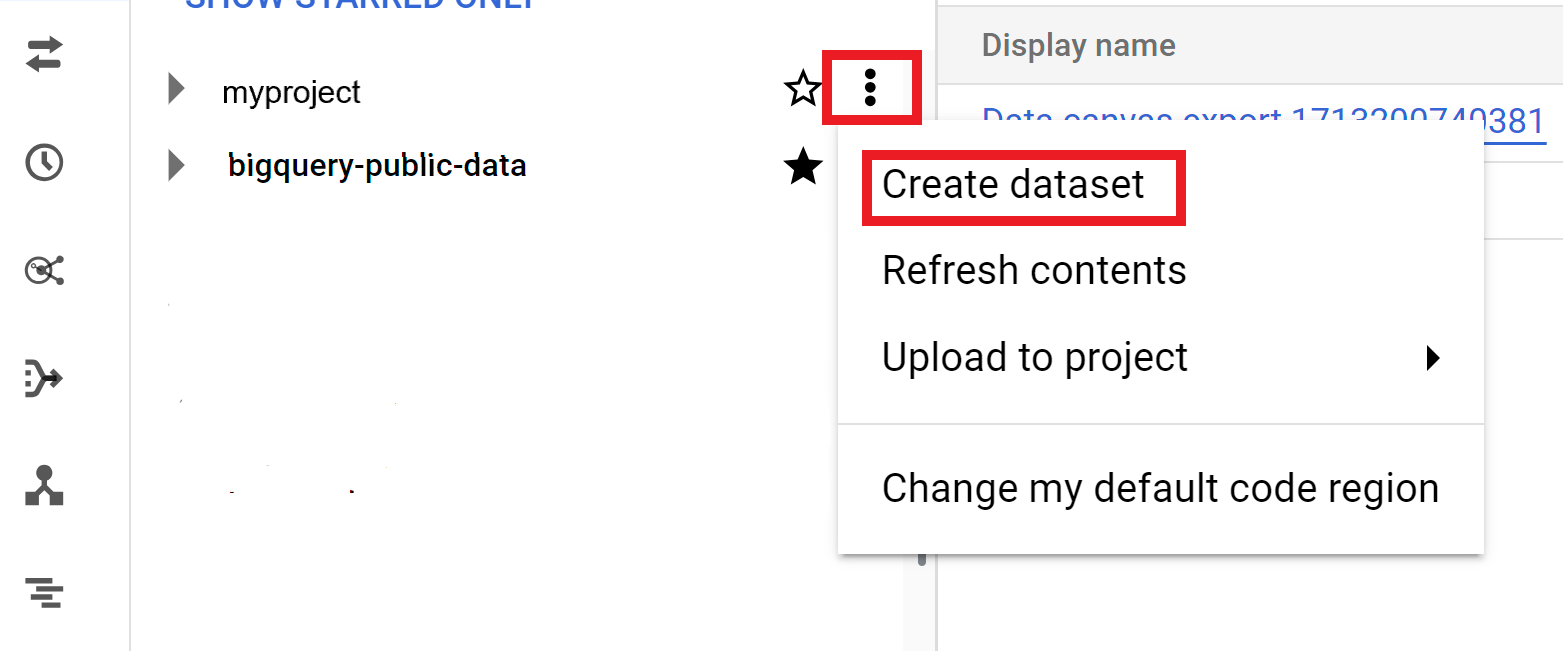

Google Cloud コンソールで [BigQuery] ページを開きます。

[エクスプローラ] パネルで、データセットを作成するプロジェクトを選択します。

[アクション] オプションを開いて、[データセットを作成] をクリックします。

[データセットを作成] ページで次の操作を行います。

- [データセット ID] に、データセットの一意の名前を入力します。

[ロケーション タイプ] で、データセットの地理的なロケーションを選択します。データセットの作成後はロケーションを変更できません。

(省略可)データセットのカスタマイズの詳細については、データセットの作成: コンソールをご覧ください。

[データセットを作成] をクリックします。

BigQuery

次のコマンドをコピーして、未加工データの新しいデータセットを作成します。

bq --location= LOCATION mk -d SOURCE_PROJECT: DATASET_RAW次のように置き換えます。

LOCATION: データセットのロケーション。SOURCE_PROJECTは、移行元プロジェクト ID に置き換えます。DATASET_RAWは、未加工データのデータセットの名前に置き換えます。例:CORTEX_SFDC_RAW

次のコマンドをコピーして、CDC データの新しいデータセットを作成します。

bq --location=LOCATION mk -d SOURCE_PROJECT: DATASET_CDC次のように置き換えます。

LOCATION: データセットのロケーション。SOURCE_PROJECTは、移行元プロジェクト ID に置き換えます。DATASET_CDCは、CDC データのデータセットの名前に置き換えます。例:CORTEX_SFDC_CDC

次のコマンドを使用して、データセットが作成されたことを確認します。

bq ls(省略可)データセットの作成の詳細については、データセットの作成をご覧ください。

次のステップ

このステップが完了したら、次のデプロイ手順に進みます。

- ワークロードを確立する(このページ)。

- リポジトリのクローンを作成する。

- 統合メカニズムを決定します。

- コンポーネントを設定する。

- デプロイを構成する。

- デプロイを実行します。