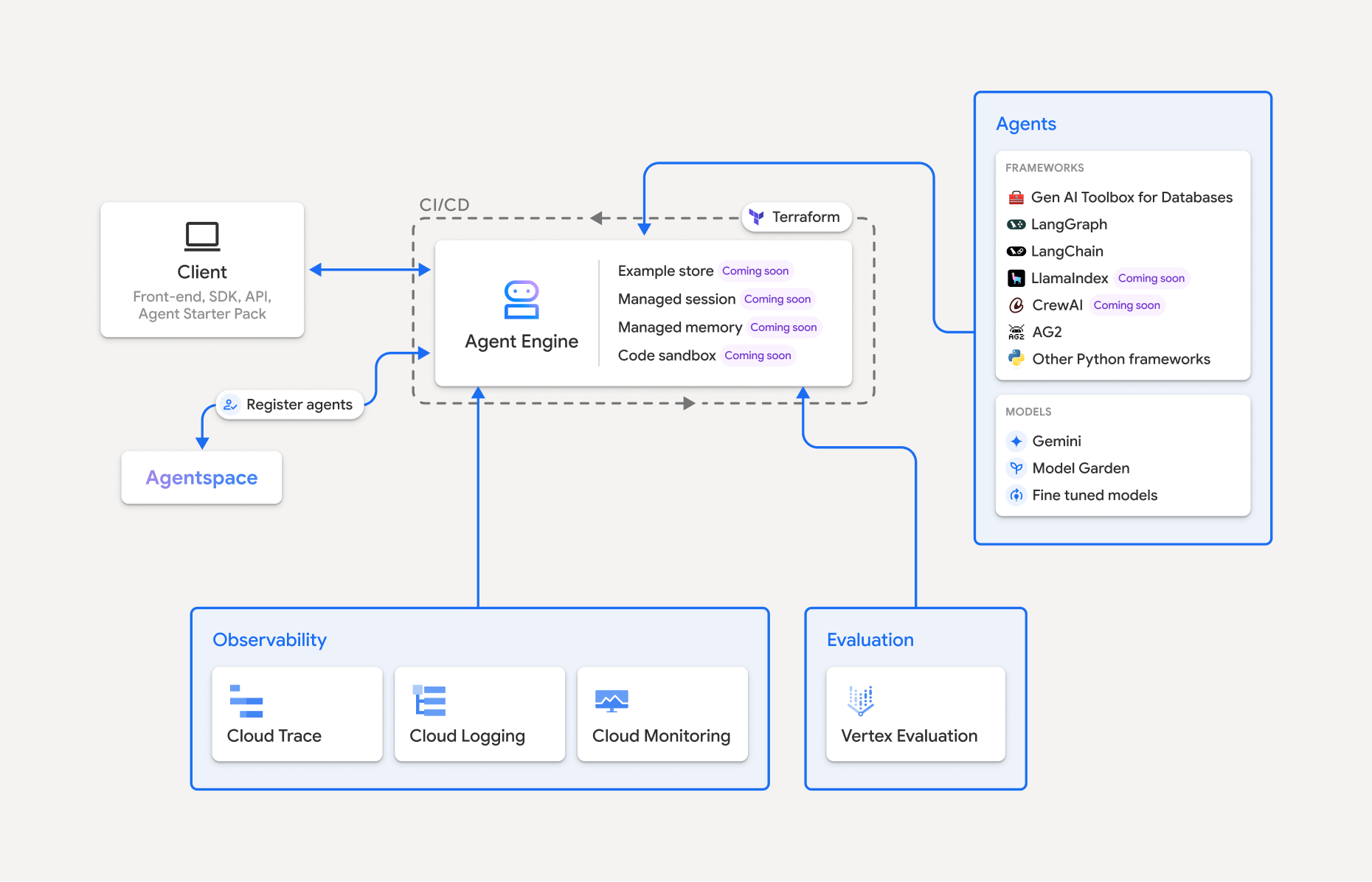

Vertex AI Agent Engine ist Teil der Vertex AI-Plattform und besteht aus einer Reihe von Diensten, mit denen Entwickler KI-Agenten in der Produktion bereitstellen, verwalten und skalieren können. Agent Engine verwaltet die Infrastruktur zum Skalieren von KI-Agenten in der Produktion, sodass Sie sich auf die Entwicklung von Anwendungen konzentrieren können. Vertex AI Agent Engine bietet die folgenden Dienste, die Sie einzeln oder in Kombination verwenden können:

Laufzeit:

- Agents bereitstellen und skalieren – mit einer verwalteten Runtime und End-to-End-Verwaltungsfunktionen.

- Passen Sie das Container-Image des Agents mit Installationsskripts für Systemabhängigkeiten zur Build-Zeit an.

- Sicherheitsfunktionen wie VPC SC-Compliance sowie die Konfiguration von Authentifizierung und IAM nutzen.

- Sie haben Zugriff auf Modelle und Tools wie Funktionsaufrufe.

- Stellen Sie Agents bereit, die mit verschiedenen Python-Frameworks und dem offenen Agent2Agent-Protokoll erstellt wurden.

- Verhalten des Agents mit Google Cloud Trace (Unterstützung von OpenTelemetry), Cloud Monitoring und Cloud Logging nachvollziehen

Qualität und Bewertung (Vorschau): Bewerten Sie die Qualität von Agents mit dem integrierten Gen AI Evaluation Service und optimieren Sie Agents mit Gemini-Modell-Trainingsläufen.

Example Store (Vorschau): Speichern und dynamisches Abrufen von Few-Shot-Beispielen zur Verbesserung der Agent-Leistung.

Sitzungen (Vorabversion): Mit Agent Engine Sessions können Sie einzelne Interaktionen zwischen Nutzern und Agenten speichern und so definitive Quellen für den Unterhaltungskontext bereitstellen.

Memory Bank (Vorabversion): Mit der Agent Engine Memory Bank können Sie Informationen aus Sitzungen speichern und abrufen, um Agent-Interaktionen zu personalisieren.

Codeausführung (Vorabversion): Mit der Agent Engine-Codeausführung kann Ihr Agent Code in einer sicheren, isolierten und verwalteten Sandbox-Umgebung ausführen.

Vertex AI Agent Engine ist Teil von Vertex AI Agent Builder, einer Reihe von Funktionen zum Entdecken, Erstellen und Bereitstellen von KI-Agents.

In Vertex AI Agent Engine erstellen und bereitstellen

Hinweis:Wenn Sie eine optimierte IDE-basierte Entwicklung und Bereitstellung mit Vertex AI Agent Engine wünschen, sollten Sie das Agent-Starter-Pack in Betracht ziehen. Sie bietet sofort einsatzbereite Vorlagen, eine integrierte Benutzeroberfläche für Tests und vereinfacht Bereitstellung, Betrieb, Bewertung, Anpassung und Beobachtbarkeit.

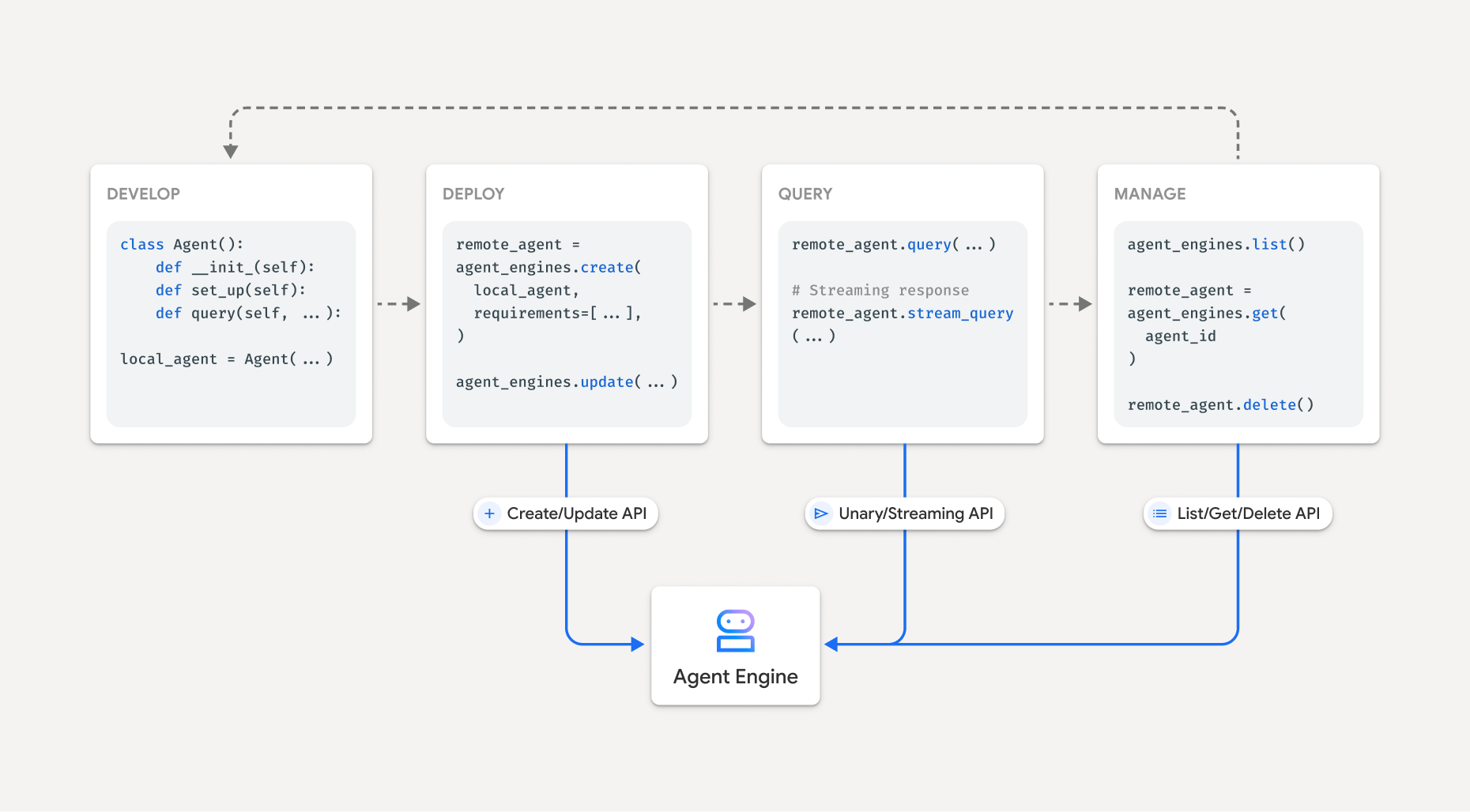

Der Workflow zum Erstellen eines KI-Agents in Vertex AI Agent Engine sieht so aus:

| Schritte | Beschreibung |

|---|---|

| 1. Umgebung einrichten | Richten Sie Ihr Google-Projekt ein und installieren Sie die neueste Version des Vertex AI SDK für Python. |

| 2. Agent entwickeln | Entwickeln Sie einen Agenten, der in Vertex AI Agent Engine bereitgestellt werden kann. |

| 3. Agent bereitstellen | Stellen Sie den Agent in der verwalteten Laufzeit von Vertex AI Agent Engine bereit. |

| 4. Agent verwenden | Senden Sie eine API-Anfrage, um den Agenten zu fragen. |

| 5. Bereitgestellten Agent verwalten | Verwalten und Löschen von Agents, die Sie in Vertex AI Agent Engine bereitgestellt haben |

Die Schritte werden im folgenden Diagramm veranschaulicht:

Unterstützte Frameworks

In der folgenden Tabelle wird der Grad der Unterstützung beschrieben, den Vertex AI Agent Engine für verschiedene Agent-Frameworks bietet:

| Supportstufe | Agent-Frameworks |

|---|---|

| Benutzerdefiniertes Template: Sie können ein benutzerdefiniertes Template anpassen, um die Bereitstellung in Vertex AI Agent Engine über Ihr Framework zu unterstützen. | CrewAI, benutzerdefinierte Frameworks |

| Vertex AI SDK-Integration: Vertex AI Agent Engine bietet verwaltete Vorlagen pro Framework im Vertex AI SDK und in der Dokumentation. | AG2, LlamaIndex |

| Vollständige Integration: Die Funktionen sind so integriert, dass sie im gesamten Framework, in Vertex AI Agent Engine und im gesamten Google Cloud Ökosystem funktionieren. | Agent Development Kit (ADK), LangChain, LangGraph |

Mit dem Agent Starter Pack in der Produktion bereitstellen

Das Agent Starter Pack ist eine Sammlung von produktionsbereiten Vorlagen für generative KI-Agents, die für Vertex AI Agent Engine entwickelt wurden. Das Agent Starter Pack bietet Folgendes:

- Vordefinierte Agent-Vorlagen:ReAct, RAG, Multi-Agent und andere Vorlagen.

- Interaktiver Playground: Hier können Sie Ihren Agenten testen und mit ihm interagieren.

- Automatisierte Infrastruktur: Nutzt Terraform für eine optimierte Ressourcenverwaltung.

- CI/CD-Pipelines: Automatisierte Bereitstellungsworkflows, die Cloud Build nutzen.

- Observability: Integrierte Unterstützung für Cloud Trace und Cloud Logging.

Erste Schritte finden Sie in der Kurzanleitung.

Anwendungsfälle

Weitere Informationen zu Vertex AI Agent Engine mit End-to-End-Beispielen finden Sie in den folgenden Ressourcen:

| Anwendungsfall | Beschreibung | Links |

|---|---|---|

| Agents erstellen, indem eine Verbindung zu öffentlichen APIs hergestellt wird | Währungen umrechnen. Erstellen Sie eine Funktion, die eine Verbindung zu einer Währungsaustauschanwendung herstellt, damit das Modell korrekte Antworten auf Anfragen wie „Wie hoch ist der Wechselkurs von Euro zu Dollar heute?“ liefert. |

Vertex AI SDK für Python-Notebook – Einführung in das Erstellen und Bereitstellen eines Agents mit Vertex AI Agent Engine |

| Design eines Solarprojekts für eine Gemeinde Potenzielle Standorte ermitteln, relevante Behörden und Lieferanten suchen sowie Satellitenbilder und das Solarpotenzial von Regionen und Gebäuden prüfen, um den optimalen Standort für die Installation Ihrer Solarmodule zu finden. |

Vertex AI SDK für Python-Notebook – Erstellen und Bereitstellen eines Google Maps API-Agents mit Vertex AI Agent Engine | |

| Agents erstellen, indem eine Verbindung zu Datenbanken hergestellt wird | Integration in AlloyDB und Cloud SQL for PostgreSQL | Blogpost – LangChain in Vertex AI für AlloyDB und Cloud SQL for PostgreSQL Vertex AI SDK für Python-Notebook – Bereitstellen einer RAG-Anwendung mit Cloud SQL for PostgreSQL in Vertex AI Agent Engine Vertex AI SDK für Python-Notebook – Bereitstellen einer RAG-Anwendung mit AlloyDB for PostgreSQL in Vertex AI Agent Engine |

| Agents mit Tools erstellen, die auf Daten in Ihrer Datenbank zugreifen | Vertex AI SDK für Python-Notebook – Bereitstellen eines Agents mit Vertex AI Agent Engine und MCP Toolbox for Databases | |

| Strukturierte Datenspeicher mit natürlicher Sprache abfragen und analysieren | Vertex AI SDK für Python-Notebook – Einen Conversational Search Agent mit Vertex AI Agent Engine und RAG in Vertex AI Search erstellen | |

| Grafikdatenbanken mit natürlicher Sprache abfragen und analysieren | Blogpost – GenAI GraphRAG and AI agents using Vertex AI Agent Engine with LangChain and Neo4j | |

| Vektorspeicher mit natürlicher Sprache abfragen und analysieren | Blogpost – Simplify GenAI RAG with MongoDB Atlas and Vertex AI Agent Engine | |

| Agents mit dem Agent Development Kit erstellen | Agenten mit dem Agent Development Kit erstellen und bereitstellen | Agent Development Kit – In Vertex AI Agent Engine bereitstellen |

| Kontext mit Vertex AI Agent Engine-Sitzungen und Memory Bank im Vertex AI-Expressmodus ohne Abrechnung verwalten. | Agent Development Kit – Vertex AI Agent Engine-Sitzungen und Speicherbank im Express-Modus von Vertex AI | |

| Agents mit OSS-Frameworks erstellen | Agents mit dem Open-Source-Framework OneTwo erstellen und bereitstellen | Blogpost – OneTwo und Vertex AI Agent Engine: Entwicklung fortschrittlicher KI-Agenten auf Google Cloud |

| Mit dem Open-Source-Framework LangGraph können Sie Agents erstellen und bereitstellen. | Vertex AI SDK für Python-Notebook – Erstellen und Bereitstellen einer LangGraph-Anwendung mit Vertex AI Agent Engine | |

| Agents debuggen und optimieren | Mit OpenTelemetry und Cloud Trace können Sie Agenten erstellen und für sie Tracing ausführen. | Vertex AI SDK für Python-Notebook – Debugging und Optimieren von Agents: Eine Anleitung zum Tracing in Vertex AI Agent Engine |

| Multi-Agent-Systeme mit A2A-Protokoll erstellen (Vorabversion) | Interoperable Agents erstellen, die unabhängig von ihrem Framework mit anderen Agents kommunizieren und zusammenarbeiten können. | Weitere Informationen finden Sie in der Dokumentation zum A2A-Protokoll. |

Unternehmenssicherheit

Vertex AI Agent Engine unterstützt mehrere Funktionen, mit denen Sie die Sicherheitsanforderungen von Unternehmen erfüllen, die Sicherheitsrichtlinien Ihrer Organisation einhalten und Best Practices für die Sicherheit befolgen können. Die folgenden Funktionen werden unterstützt:

Vom Kunden verwaltete Verschlüsselungsschlüssel (Customer-Managed Encryption Keys, CMEK): Vertex AI Agent Engine unterstützt CMEK, um Ihre Daten mit Ihren eigenen Verschlüsselungsschlüsseln zu schützen. So haben Sie die Inhaberschaft und vollständige Kontrolle über die Schlüssel, die Ihre ruhenden Daten in Google Cloudschützen. Weitere Informationen finden Sie unter CMEK für Agent Engine.

VPC Service Controls: Vertex AI Agent Engine unterstützt VPC Service Controls, um die Datensicherheit zu erhöhen und das Risiko einer Daten-Exfiltration zu verringern. Wenn VPC Service Controls konfiguriert ist, behält der bereitgestellte Agent den sicheren Zugriff auf Google-APIs und -Dienste wie die BigQuery API, die Cloud SQL Admin API und die Vertex AI API bei. So wird ein reibungsloser Betrieb innerhalb des von Ihnen definierten Perimeters gewährleistet. VPC Service Controls blockiert effektiv den gesamten öffentlichen Internetzugriff und beschränkt die Datenübertragung auf Ihre autorisierten Netzwerkbereiche. Dadurch wird die Sicherheit Ihres Unternehmens erheblich verbessert.

Datenstandort: Vertex AI Agent Engine unterstützt den Datenstandort, um sicherzustellen, dass alle Daten im inaktiven Zustand in der angegebenen Region gespeichert werden.

Private Service Connect-Schnittstelle: Über die PSC-I können Ihre Agents mit privat gehosteten Diensten in der VPC des Nutzers interagieren. Weitere Informationen finden Sie unter Private Service Connect-Schnittstelle mit Vertex AI Agent Engine verwenden.

HIPAA: Als Teil der Vertex AI Platform unterstützt Vertex AI Agent Engine HIPAA-Arbeitslasten.

Unterstützte Regionen

Die Vertex AI Agent Engine-Laufzeit, Agent Engine-Sitzungen und die Vertex AI Agent Engine-Speicherbank werden in den folgenden Regionen unterstützt:

| Region | Standort | Unterstützte Versionen |

|---|---|---|

us-central1 |

Iowa | v1 wird für allgemein verfügbare Funktionen unterstützt. v1beta1 wird für Vorschaufunktionen unterstützt. |

us-east4 |

Northern Virginia | v1 wird für allgemein verfügbare Funktionen unterstützt. v1beta1 wird für Vorschaufunktionen unterstützt. |

us-west1 |

Oregon | v1 wird für allgemein verfügbare Funktionen unterstützt. v1beta1 wird für Vorschaufunktionen unterstützt. |

europe-west1 |

Belgien | v1 wird für allgemein verfügbare Funktionen unterstützt. v1beta1 wird für Vorschaufunktionen unterstützt. |

europe-west2 |

London | v1 wird für allgemein verfügbare Funktionen unterstützt. v1beta1 wird für Vorschaufunktionen unterstützt. |

europe-west3 |

Frankfurt | v1 wird für allgemein verfügbare Funktionen unterstützt. v1beta1 wird für Vorschaufunktionen unterstützt. |

europe-west4 |

Niederlande | v1 wird für allgemein verfügbare Funktionen unterstützt. v1beta1 wird für Vorschaufunktionen unterstützt. |

europe-southwest1 |

Madrid | v1 wird für allgemein verfügbare Funktionen unterstützt. v1beta1 wird für Vorschaufunktionen unterstützt. |

asia-east1 |

Taiwan | v1 wird für allgemein verfügbare Funktionen unterstützt. v1beta1 wird für Vorschaufunktionen unterstützt. |

asia-northeast1 |

Tokio | v1 wird für allgemein verfügbare Funktionen unterstützt. v1beta1 wird für Vorschaufunktionen unterstützt. |

asia-south1 |

Mumbai | v1 wird für allgemein verfügbare Funktionen unterstützt. v1beta1 wird für Vorschaufunktionen unterstützt. |

asia-southeast1 |

Singapur | v1 wird für allgemein verfügbare Funktionen unterstützt. v1beta1 wird für Vorschaufunktionen unterstützt. |

australia-southeast2 |

Melbourne | v1 wird für allgemein verfügbare Funktionen unterstützt. v1beta1 wird für Vorschaufunktionen unterstützt. |

Für die Agent Engine-Codeausführung (Vorschau) werden die folgenden Regionen unterstützt.

| Region | Standort | Unterstützte Versionen |

|---|---|---|

us-central1 |

Iowa | Die Version v1beta1 wird unterstützt. |

Kontingent

Die folgenden Limits gelten für Vertex AI Agent Engine für ein bestimmtes Projekt in jeder Region:| Beschreibung | Limit |

|---|---|

| Vertex AI Agent Engine-Agents pro Minute erstellen, löschen oder aktualisieren | 10 |

| Vertex AI Agent Engine-Sitzungen pro Minute erstellen, löschen oder aktualisieren | 100 |

Query oder StreamQuery Vertex AI Agent Engine pro Minute |

90 |

| Ereignis an Vertex AI Agent Engine-Sitzungen pro Minute anhängen | 300 |

| Maximale Anzahl von Vertex AI Agent Engine-Ressourcen | 100 |

| Vertex AI Agent Engine-Speicherressourcen pro Minute erstellen, löschen oder aktualisieren | 100 |

| Abrufen, Auflisten oder Abrufen aus der Vertex AI Agent Engine Memory Bank pro Minute | 300 |

| Sandbox-Umgebung (Codeausführung): „execute“-Anfragen pro Minute | 1000 |

| Sandbox-Umgebung (Codeausführung) – Einheiten pro Region | 1000 |

A2A-Agent-Post-Anfragen wie sendMessage und cancelTask pro Minute |

60 |

A2A-Agent-Get-Anfragen wie getTask und getCard pro Minute |

600 |

Gleichzeitige bidirektionale Live-Verbindungen über die BidiStreamQuery API pro Minute |

10 |

Preise

Informationen zu den Preisen für die Agent Engine-Laufzeit finden Sie unter Vertex AI-Preise.

Migration zum clientbasierten SDK

Das Modul agent_engines im Vertex AI SDK for Python wird aus den folgenden wichtigen Gründen in ein clientbasiertes Design umgestaltet:

- Um die kanonischen Typdarstellungen des Google ADK und des Google Gen AI SDK zu vereinheitlichen. So wird eine einheitliche und standardisierte Darstellung von Datentypen in verschiedenen SDKs gewährleistet, was die Interoperabilität vereinfacht und den Konvertierungsaufwand reduziert.

- Für die Festlegung des Bereichs von Google Cloud Parametern auf Clientebene in Anwendungen mit mehreren Projekten und Standorten. So kann eine Anwendung Interaktionen mit Ressourcen in verschiedenen Google Cloud Projekten und geografischen Standorten verwalten, indem jede Clientinstanz mit den spezifischen Projekt- und Standorteinstellungen konfiguriert wird.

- Um die Auffindbarkeit und Kohäsion von Vertex AI Agent Engine-Diensten zu verbessern