Chirp è la nuova generazione di modelli di sintesi vocale di Google. Rappresentando il culmine di anni di ricerca, la prima versione di Chirp è ora disponibile per Speech-to-Text. Abbiamo intenzione di migliorare ed espandere Chirp ad altre lingue e domini. Per maggiori dettagli, consulta il nostro documento Google USM.

Abbiamo addestrato i modelli Chirp con un'architettura diversa da quella dei nostri attuali modelli vocali. Un unico modello unifica i dati di più lingue. Tuttavia, gli utenti specificano comunque la lingua in cui il modello deve riconoscere la voce. Chirp non supporta alcune delle funzionalità di Google Speech disponibili in altri modelli. Consulta Supporto e limitazioni delle funzionalità per un elenco completo.

Identificatori modello

Chirp è disponibile nell'API Speech-to-Text v2. Puoi utilizzarlo come qualsiasi altro modello.

L'identificatore del modello per Chirp è: chirp.

Puoi specificare questo modello nelle richieste di riconoscimento sincrone o batch.

Metodi API disponibili

Chirp elabora la voce in blocchi molto più grandi rispetto ad altri modelli. Ciò significa che potrebbe non essere adatto a un utilizzo in tempo reale. Chirp è disponibile tramite i seguenti metodi API:

v2Speech.Recognize(ideale per audio brevi < 1 minuto)v2Speech.BatchRecognize(ideale per audio lunghi da 1 minuto a 8 ore)

Chirp non è disponibile per i seguenti metodi API:

v2Speech.StreamingRecognizev1Speech.StreamingRecognizev1Speech.Recognizev1Speech.LongRunningRecognizev1p1beta1Speech.StreamingRecognizev1p1beta1Speech.Recognizev1p1beta1Speech.LongRunningRecognize

Regioni

Chirp è disponibile nelle seguenti regioni:

us-central1europe-west4asia-southeast1

Per ulteriori informazioni, consulta la pagina delle lingue.

Lingue

Puoi visualizzare le lingue supportate nell'elenco completo delle lingue.

Supporto e limitazioni delle funzionalità

Chirp non supporta alcune funzionalità dell'API STT:

- Punteggi di affidabilità: l'API restituisce un valore, ma non si tratta di un vero e proprio punteggio di affidabilità.

- Adattamento vocale: non sono supportate funzionalità di adattamento.

- Diarizzazione: la diarizzazione automatica non è supportata.

- Normalizzazione forzata: non supportata.

- Confidenza a livello di parola: non supportata.

- Rilevamento della lingua: non supportato.

Chirp supporta le seguenti funzionalità:

- Punteggiatura automatica: la punteggiatura viene prevista dal modello. può essere disattivata.

- Tempi delle parole: restituiti facoltativamente.

- Trascrizione audio indipendente dalla lingua: il modello deduce automaticamente la lingua parlata nel file audio e la aggiunge ai risultati.

Prima di iniziare

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Speech-to-Text APIs.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. -

Make sure that you have the following role or roles on the project: Cloud Speech Administrator

Check for the roles

-

In the Google Cloud console, go to the IAM page.

Go to IAM - Select the project.

-

In the Principal column, find all rows that identify you or a group that you're included in. To learn which groups you're included in, contact your administrator.

- For all rows that specify or include you, check the Role column to see whether the list of roles includes the required roles.

Grant the roles

-

In the Google Cloud console, go to the IAM page.

Vai a IAM - Seleziona il progetto.

- Fai clic su Concedi l'accesso.

-

Nel campo Nuove entità, inserisci il tuo identificatore dell'utente. In genere si tratta dell'indirizzo email di un Account Google.

- Nell'elenco Seleziona un ruolo, seleziona un ruolo.

- Per concedere altri ruoli, fai clic su Aggiungi un altro ruolo e aggiungi ogni ruolo aggiuntivo.

- Fai clic su Salva.

Install the Google Cloud CLI.

Se utilizzi un provider di identità (IdP) esterno, devi prima accedere a gcloud CLI con la tua identità federata.

Per inizializzare gcloud CLI, esegui questo comando:

gcloud init -

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Speech-to-Text APIs.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. -

Make sure that you have the following role or roles on the project: Cloud Speech Administrator

Check for the roles

-

In the Google Cloud console, go to the IAM page.

Go to IAM - Select the project.

-

In the Principal column, find all rows that identify you or a group that you're included in. To learn which groups you're included in, contact your administrator.

- For all rows that specify or include you, check the Role column to see whether the list of roles includes the required roles.

Grant the roles

-

In the Google Cloud console, go to the IAM page.

Vai a IAM - Seleziona il progetto.

- Fai clic su Concedi l'accesso.

-

Nel campo Nuove entità, inserisci il tuo identificatore dell'utente. In genere si tratta dell'indirizzo email di un Account Google.

- Nell'elenco Seleziona un ruolo, seleziona un ruolo.

- Per concedere altri ruoli, fai clic su Aggiungi un altro ruolo e aggiungi ogni ruolo aggiuntivo.

- Fai clic su Salva.

Install the Google Cloud CLI.

Se utilizzi un provider di identità (IdP) esterno, devi prima accedere a gcloud CLI con la tua identità federata.

Per inizializzare gcloud CLI, esegui questo comando:

gcloud init -

-

If you're using a local shell, then create local authentication credentials for your user account:

gcloud auth application-default login

You don't need to do this if you're using Cloud Shell.

If an authentication error is returned, and you are using an external identity provider (IdP), confirm that you have signed in to the gcloud CLI with your federated identity.

- Assicurati di aver creato un account Google Cloud e un progetto.

- Vai a Speech nella console Google Cloud .

- Abilita l'API se non è già abilitata.

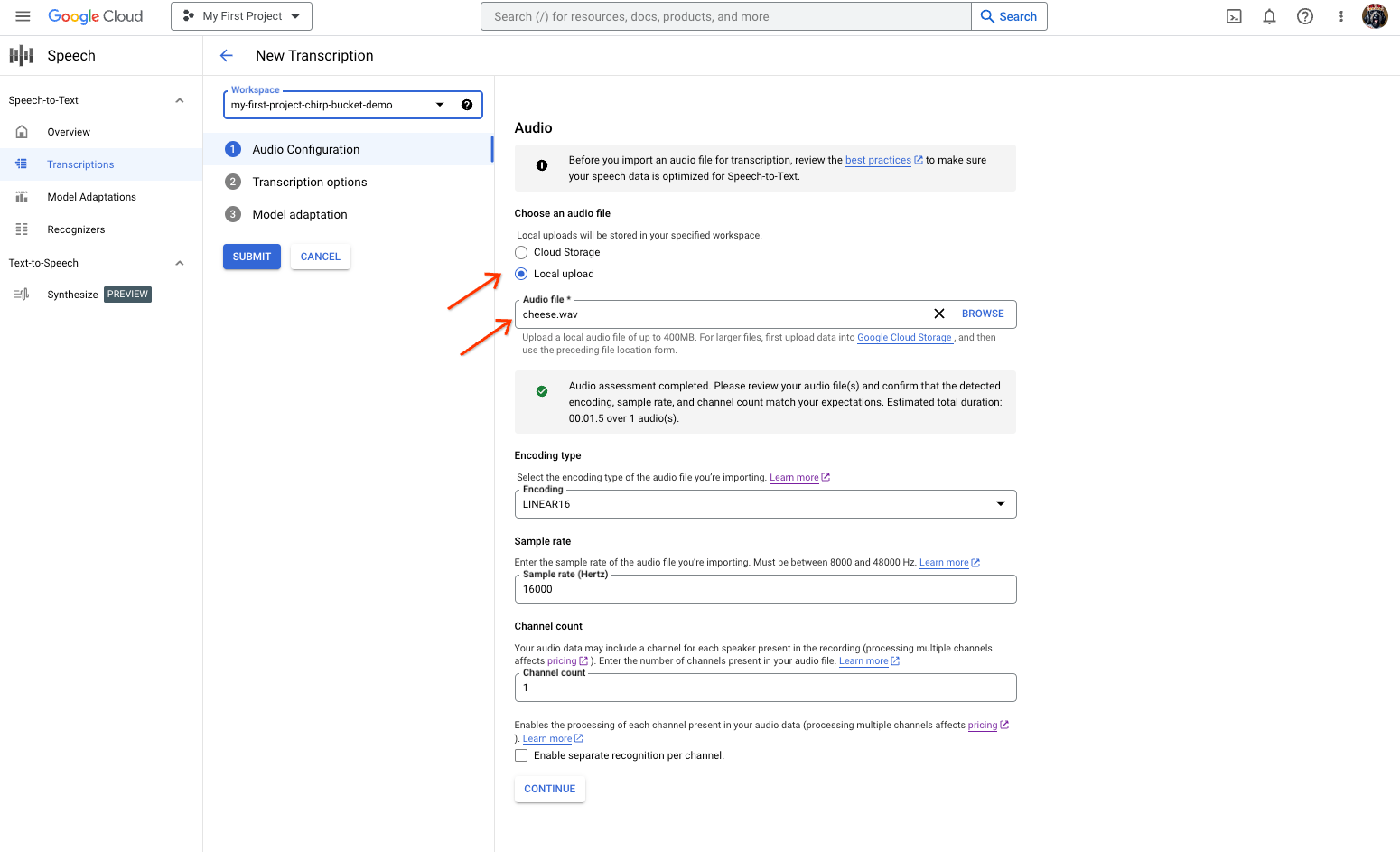

- Vai alla sottopagina Trascrizioni.

- Fai clic su Nuova trascrizione.

Assicurati di avere uno spazio di lavoro STT. Se non ne hai uno, creane uno.

Apri il menu a discesa Workspace e fai clic su Nuovo workspace.

Nella barra laterale di navigazione Crea un nuovo spazio di lavoro, fai clic su Sfoglia.

Fai clic per creare un bucket.

Inserisci un nome per il bucket e fai clic su Continua.

Fai clic su Crea.

Una volta creato il bucket, fai clic su Seleziona per selezionarlo.

Fai clic su Crea per completare la creazione dello spazio di lavoro per Speech-to-Text.

Esegui una trascrizione dell'audio.

- Nella pagina Nuova trascrizione, scegli un'opzione per selezionare il file audio:

- Carica facendo clic su Carica locale.

- Fai clic su Cloud Storage per specificare un file Cloud Storage esistente.

- Fai clic su Continua.

Nella sezione Opzioni di trascrizione, seleziona la lingua parlata che prevedi di utilizzare per il riconoscimento con Chirp dal riconoscitore creato in precedenza.

Nel menu a discesa Modello*, seleziona Chirp.

Nel menu a discesa Regione, seleziona una regione, ad esempio us-central1.

Fai clic su Continua.

Per eseguire la prima richiesta di riconoscimento utilizzando Chirp, nella sezione principale, fai clic su Invia.

- Nella pagina Nuova trascrizione, scegli un'opzione per selezionare il file audio:

Visualizza il risultato della trascrizione di Chirp.

Nella pagina Trascrizioni, fai clic sul nome della trascrizione.

Nella pagina Dettagli della trascrizione, visualizza il risultato della trascrizione e, se vuoi, riproduci l'audio nel browser.

-

Optional: Revoke the authentication credentials that you created, and delete the local credential file.

gcloud auth application-default revoke

-

Optional: Revoke credentials from the gcloud CLI.

gcloud auth revoke

- In the Google Cloud console, go to the Manage resources page.

- In the project list, select the project that you want to delete, and then click Delete.

- In the dialog, type the project ID, and then click Shut down to delete the project.

- In the Google Cloud console, go to the Manage resources page.

- In the project list, select the project that you want to delete, and then click Delete.

- In the dialog, type the project ID, and then click Shut down to delete the project.

- Esercitati a trascrivere file audio corti.

- Scopri come trascrivere l'audio in streaming.

- Scopri come trascrivere file audio lunghi.

- Per ottenere prestazioni e precisione ottimali e altri suggerimenti, consulta la documentazione sulle best practice.

Le librerie client possono utilizzare Credenziali predefinite dell'applicazione per autenticarsi facilmente con le API di Google e inviare richieste a queste API. Con Credenziali predefinite dell'applicazionee, puoi testare l'applicazione localmente ed eseguirne il deployment senza modificare il codice sottostante. Per maggiori informazioni, vedi Autenticarsi per utilizzare le librerie client.

Assicurati inoltre di aver installato la libreria client.

Eseguire il riconoscimento vocale sincrono con Chirp

Ecco un esempio di esecuzione del riconoscimento vocale sincrono su un file audio locale utilizzando Chirp:

Python

Eseguire una richiesta con la trascrizione indipendente dalla lingua attivata

I seguenti esempi di codice mostrano come effettuare una richiesta con la trascrizione indipendente dalla lingua attivata.

Python

Inizia a utilizzare Chirp nella Google Cloud console

Esegui la pulizia

Per evitare che al tuo account Google Cloud vengano addebitati costi relativi alle risorse utilizzate in questa pagina, segui questi passaggi.

Console

gcloud